Со стороны кажется, что новый дата-центр, построенный с нуля за полгода — это тривиальный проект. Но, во-первых, в дело вкрались всем известные события 2020-го. А во-вторых, Утконос ОНЛАЙН не нужен был просто дата-центр; им нужно было решение, на котором можно основать будущее компании. Эта статья о том, как мы создавали такое решение и почему в процессе создания вдруг почувствовали себя настоящими зодчими.

ЦОД: Начало

Утконос ОНЛАЙН решил оборудовать для себя новый дата-центр ещё в конце 2019 года. У онлайн-магазина уже был один современный ЦОД, и его мощностей пока хватало для обработки всех поступающих запросов. Но Утконос ОНЛАЙН уже смотрел в будущее: сфера e-commerce растёт, а значит, покупателей и заказов станет больше.

Вариант с колокейшеном отбросили сразу. Это удобно для сетевых сервисов — балансировщиков трафика, например, или VPN-эндпоинтов. А Утконос ОНЛАЙН нужен был полноценный дата-центр с развитой инфраструктурой: надёжный, защищённый, с мониторингом всех данных и без дополнительных оплат владельцам колокации за каждую мелочь.

А в нашей компании как раз есть целый бизнес-блок, который специализируется на кастомных дата-центрах: для каждого клиента индивидуальный проект. Запросов на подобные строительства поступает много: отечественному бизнесу гораздо удобнее иметь свой дата-центр, чем ютиться в колокейшене. И в конкурсе Утконос ОНЛАЙН мы, имея все нужные ресурсы и опыт, решили поучаствовать.

“

«На Западе существует крупная прослойка среднего бизнеса, у которого просто нет таких мощностей, чтобы загрузить крупный центр обработки данных. А ради оборудования на три-четыре стойки нет смысла создавать собственный ЦОД. Да и первоначального вложения на постройку дата-центра у них зачастую нет, поэтому они скорее готовы начинать в формате колокейшена. У нас такая прослойка гораздо тоньше, а крупные компании всегда, с самого зарождения IT-бизнеса в России, были склонны строить собственные центры. У нас формат колокации зачастую даже не рассматривается».

Возвращение в Папскую область

Уже в декабре мы начали готовить первый полноценный эскиз проекта. Дата-центр нужно было поставить в Южном Бутово, внутри существующего фулфилмент-центра Утконос ОНЛАЙН: там ежедневно оформляются тысячи заказов, там же их комплектуют и развозят по Москве. Пиковая загрузка — 15 тысяч заказов в день.

ЦОД, милый ЦОД…

Место для нас знакомое, даже ностальгическое. Мы уже обустраивали дата-центр в этом же комплексе в 2005 году, когда Утконос ОНЛАЙН начинал развиваться. Сейчас, конечно, этот ЦОД устарел. И нуждался не в обновлении. Нам надо было всё переделать с нуля и развернуть в местном складском городе-государстве из нескольких крупных корпусов новый компактный дата-центр, такую себе Сикстинскую капеллку — всего 100 квадратных метров плюс 75 метров на электрощитовую.

Местный парк папамобилей

Для Утконос ОНЛАЙН было важно, чтобы дата-центр был максимально надёжен и отказоустойчив, с полной интеграцией всего железа и софта. Чтобы когда мы закончим работу, сотрудники компании могли без проблем самостоятельно управлять этим центром. Компактность была особенно важна: всё-таки нужно было поставить 42 шкафа оборудования вместе с отдельно стоящими стойками. Ещё нас попросили обойтись без избыточности, но это и так было понятно: ЦОД делаем, не дворец, — барочные излишества тут ни к чему.

Ремонт во время чумы

Разработали проектный план, пришли на приёмку. Сразу появились вопросы с бюджетом: полностью вписаться в него оказалось сложновато. Хоть заказчик и выделил на инженерные и телекоммуникационные работы крупную по меркам строительства ЦОД сумму, требования по оборудованию и по софту были очень серьёзные.

Вот такой план по оборудованию у нас получился

Чтобы сократить расходы, мы отказались от части софтвера Huawei. Поняли, что это тоже, по сути, избыточная цифровая лепнина. Например, зачем небольшому ЦОДу дорогой онлайн-инструмент инвентаризации стоек? Ведь их же там не сотни стоят. И к чему открывать шкафы электронными карточками, если можно обойтись привычными ключами?

Изначально в бюджет заложили ещё и дизельную установку, которая должна была обеспечивать центр электроэнергией в аварийных ситуациях. Если дата-центр представить средневековым замком, то дизель — потайной колодец с чистой водой на случай осады. А осада всегда случается, рано или поздно. Но заказчик предложил всё же вычеркнуть дизель: город должен был дать новому ЦОДу два электроввода, к тому же в фулфилмент-центре уже стоял собственный газогенератор. На тот момент и нам показалось, что ещё одна линия защиты действительно будет лишней.

После сокращений по бюджету мы успешно прошли приёмку. Наши специалисты были готовы монтировать центр уже в марте, но на площадке работал сторонний подрядчик. Во всём центре у Утконос ОНЛАЙН шёл масштабный ремонт, и как раз в нужных нам помещениях строительная пыль стояла столбом, толкались рабочие, — словом, было вообще не до серверных стоек. Это не считая того, что там полностью сняли полы и оставили голый бетон.

Пока тут серо и немного неуютно, но скоро мы начнём роспись своей айтишной Сикстинской капеллы

Мы с Утконос ОНЛАЙН договорились, что установим дата-центр до конца осени. И тут же, как под заказ, началась пандемия. А с ней пришли локдаун и ограничения. Сроки сразу перестали казаться мягкими, но менять их тоже было поздно. Заказчику нужен был дата-центр уже в ноябре.

Понятное дело, простаивать было некогда. Связались с подрядчиком, который делал ремонт. Оказалось, он не разбирается в специфике строительства именно дата-центров. А для нас было очень важно, чтобы, например, при ремонте правильно подобрали и уложили силовой кабель. Поэтому, чтобы упростить работу подрядчика, да и свою тоже, мы отправились ему на помощь.

Сперва отношения с ремонтниками были довольно натянутые. Нам надо дело делать, а им неприятно, что мы лезем под руку. Так что возникали, скажем так, конфликты профессиональных интересов. К счастью, Утконос ОНЛАЙН прислал в качестве медиаторов своих технических специалистов — ведущего инженера эксплуатации IT-инфраструктуры и его помощников. Они помогли и договориться полюбовно с подрядчиком, и подготовить площадку под центр.

“

Это была самая сложная часть проекта. Именно строительство. Такая комплексная, филигранная работа, которая основывалась на очень хрупком и тонком сотрудничестве между IT-компанией «Инфосистемы Джет» и другими подрядчиками. По-другому я этот процесс описать не могу. Для меня удивительно, что коллеги успешно справились с испытаниями и всё отлично сделали на этом этапе.

*играет Survivor — Eye of the Tiger*

Уф, выдохнули. Положили чистовые полы поверх бетона. Сейчас, конечно, ими никого не удивишь. Ещё в Древнем Риме подобные делали. Но тут не баян, а классика: на бетоне до драгоценных стоек мгновенно добралась бы сырость. А теперь у нас был прохладный, но абсолютно сухой пол.

Возвращение тайного колодца

Вот мы втащили стойки в готовое помещение. И вдруг заказчик сообщил, что вместо двух электровводов от города у дата-центра будет всего один. Оказалось, как раз неподалёку в Бутово сейчас строят метро. Появились проблемы с нагрузками, и московские энергетические службы просто отказались давать больше одной линии питания.

А как же собственный газогенератор? А у него мощность всего-то один мегаватт. Вроде много, но в центре же ведь будут стоять гигантские холодильники с едой. И тут либо продуктам придётся протухать (конечно, нет), либо оборудованию в ЦОДе отключаться.

А если в Южном Бутово вырубится свет, то никаких вторых шансов у центра вообще не будет. Лягут все сервера, накроются все заказы, воцарятся хаос и безумие.

Тут-то заказчик и согласился установить тот самый многострадальный дизель, который мы предлагали на старте проекта. Да, бюджет вырос. Зато защита от перебоев с энергией надёжная.

Как раз закончился ремонт во всём фулфилмент-центре. И мы начали делать инфраструктуру параллельно с монтажом дата-центра. Проводили испытания, тесты систем гидроизоляции и защиты от пыли. ЦОД всё-таки будет располагаться там, где работает множество людей. Мало ли что может случиться?

На этой ступени работ мы сотрудничали с несколькими подрядчиками. Особенно старались соблюсти этапность, чтобы никто не сидел без дела и не тратил время. Чтобы сразу по мере монтажа центра можно было подключать его к общей инфраструктуре.

В итоге все инженерные работы закончили за три месяца: смонтировали силовые линии и оптический кабель по складу, поставили новые шкафы, установили edge-узлы по всей территории центра.

Правильно запитать всю обширную систему было непросто

Контрфорсы наголо

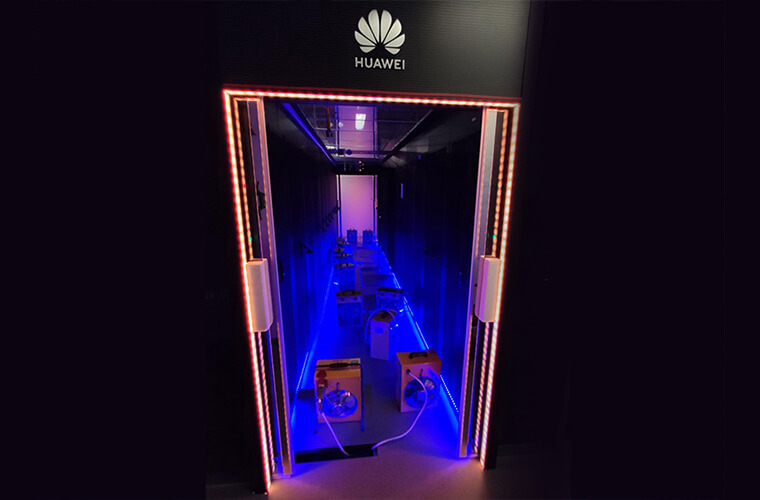

В итоге к ноябрю получилась современная цифровая крепость. На территории фулфилмент-центра стоит 42 телекоммуникационных шкафа. Внутри самого дата-центра в два ряда поставили, один к одному, 19 таких вот красавцев.

Начинают прорисовываться интерьеры будущего шедевра

Ещё часть шкафов разместили вне центра на территории самого склада. Это оконечные шкафы, в которых располагается основное сетевое оборудование уровня доступа. Место расположения шкафов и схемы коммутации продуманы заказчиком так, что обеспечивается полное резервирование покрытия Wi-Fi. Даже если кто-то случайно перережет какой-то важный кабель до одного из шкафов, то другой обеспечит сервис для всех складских процессов.

Пока ещё полая edge-стойка. «Нет ничего более сильного и созидательного, чем пустота, которую люди стремятся заполнить». (Лао-цзы)

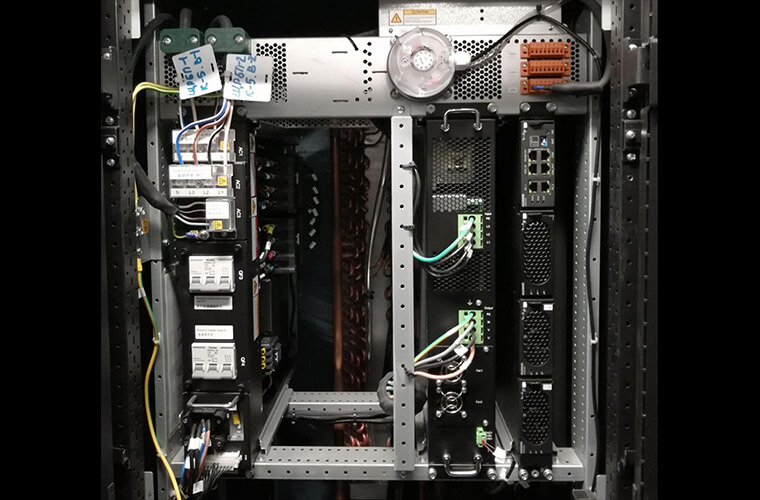

После проведённых тестов шкафы ЦОД как следует защитили от пыли и воды. Для каждого зарезервировали по два PDU. Сверху каждый шкаф обрамляют электропровода и кабельные трассы оптоволокна и меди. В обычной архитектуре, когда служебные трубы и кабели выведены наружу, это считается дурным тоном или, во всяком случае, авангардом. А для дата-центра это норма и стандарт. Тут утилитарная функциональность важнее эстетики.

Центр Помпиду, Париж

Божественный ветер и бесконечная энергия

Понятное дело, центру, который занят сложными вычислениями, всегда нужен свежий воздух. Иначе тонкое оборудование недолго проживёт.

Мы поставили стойки по классическому принципу горячего коридора. А между ними расположили пять крупных кондиционеров, каждый на 35 киловатт отвода тепла. Три из них всегда в работе и полностью снимают все теплопритоки внутри ЦОДа. Ещё два стоят в резерве, ждут своего часа на случай внезапного сбоя или резкого скачка в нагрузках. Система похожа на современную версию классического персидского бадгира, ловца ветра: из фронта кондеев в коридор идёт холодный воздух, охлаждающий шкафы. А когда он из-за этого нагревается и начинает подниматься, кондиционеры замечают и автоматически всасывают горячие воздушные потоки. Процесс повторяется раз за разом. Максимальная температура внутри коридора — 27 по цельсию, как в тёплый летний день.

Часть edge-узлов тоже скомпонована с собственным кондиционером с отводом до 5 киловатт тепла. Они скорее походят на классические модерновые вентиляционные шахты.

Воздух из них свеж, как весенний бриз

А охлаждением щитовой занимаются системы полупромышленного уровня. Могут и до -40 охладить, если понадобится. Распределительным щитам такое нужно: они всё-таки 800 ампер тока раскидывают по дата-центру.

А отсюда выходит воздух, скорее похожий на самум

От перебоев с энергией центр тоже надёжно защитили. У нас там выстроен настоящий Запретный город, которому до внешнего мира нет дела.

Сначала при отключении энергии врубится дизельный генератор. Но чтобы обеспечить электричеством весь дата-центр, ему самому надо набрать мощность. А пока он разгоняется, электроснабжение идёт от аккумуляторных батарей.

Не все герои носят плащи. Этот скромняга предпочитает красную краску

До полного включения дизеля в работу трудятся два полноценных блока бесперебойников и полки батарей. Они, конечно, серые, невзрачные и одинаковые, что жилые единицы от Ле Корбюзье. Но тут работоспособность снова важнее эстетики. А работают они на ура. Каждый бесперебойник мощностью до 300 киловатт, ведь соотношение «мощность/отказоустойчивость» инженеры могут выставлять по желанию на основе фактического потребления. Потом дизель выходит на свои рабочие характеристики, снабжение переходит на него, а ИБП в это время восстанавливают заряд аккумуляторов. Вместе эта команда полностью обеспечивает 100 % нагруженный дата-центр энергией на протяжении часа.

Сможете посчитать, сколько их?

“

Он надёжный, даже сверхнадёжный. Всегда выполняет свои функции. И это самая важная характеристика для любого ЦОДа. Хотя электроввод всего один, дата-центр рассчитан на постоянную бесперебойную работу. Если грянет катастрофа и во всей Москве отключится электричество, центр, а с ним и серверы заказчика, этого даже не заметят.

Великий цифровой наблюдатель

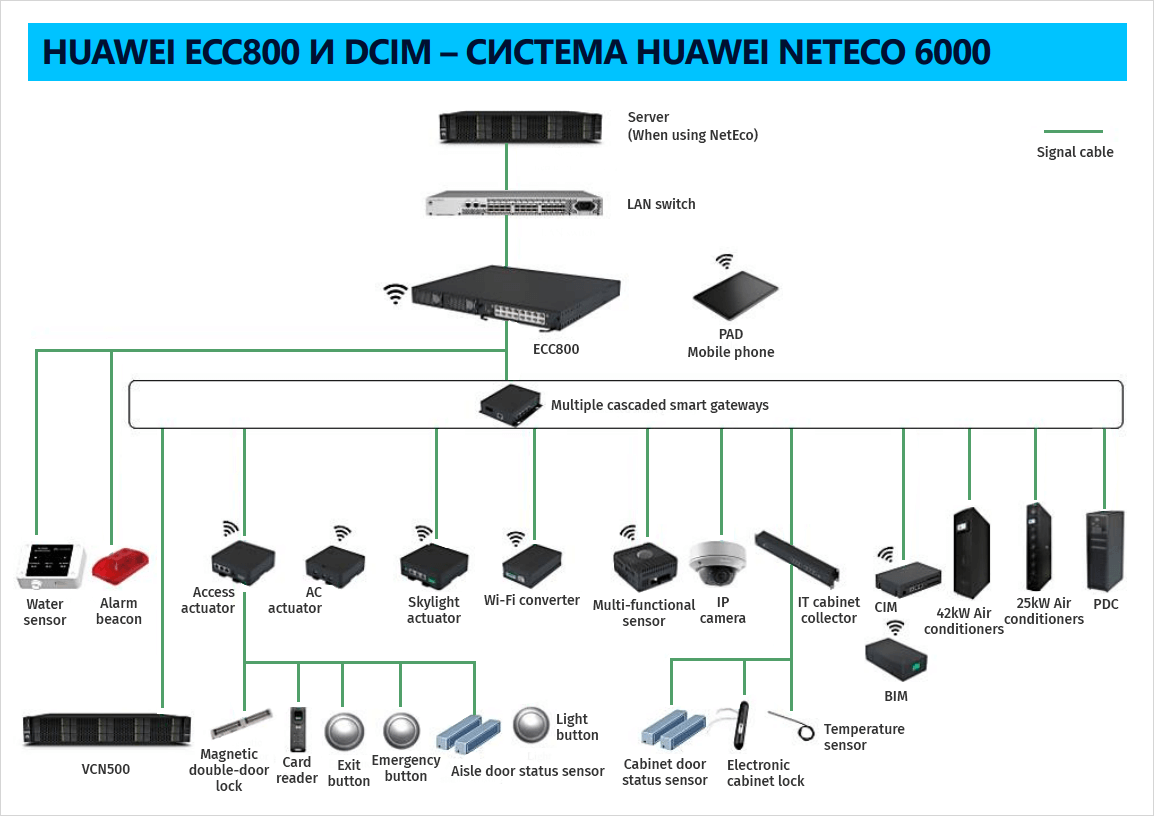

Баланс между компактностью и избыточностью мы нашли как раз благодаря Huawei. У них удобное оборудование: все решения унифицированы, интегрируются, плотно прилегают друг к другу и удобно заполняют стойку. Прямо классические квадратные и прямоугольные павильоны. Или тетрис, кому как больше нравится.

А их софт даёт заказчику полный контроль над дата-центром с одной машины, из одного окна. С Huawei NetEco дежурный сисадмин легко отследит и проанализирует все параметры центра и процессы внутри него. Как там оборудование? NetEco в курсе. Климат внутри центра? Всегда мониторится. Кто-то полез в серверный шкаф? Сообщит. Протечка? Моментальное реагирование. Даже с оборудованием от сторонних производителей эта система сработалась.

Ещё пары инженеров эксплуатации хватает, чтобы исправить возможные сбои в любых элементах дата-центра. Мы и сам ЦОД, и его edge-узлы, и всю инфраструктуру фулфилмент-центра подрубили к NetEco. Вышел настоящий паноптикум Бентама: один-единственный охранник из центра наблюдает за тысячами пакетов данных.

И даже окно небольшое — так, окошко у входа

Финальная система похожа, по словам заказчика, на Эйфелеву башню. Вроде бы лёгкая, почти невесомая конструкция, которая на деле держит огромный вес

Единственное, с чем NetEco интегрировался не идеально — некоторые дополнительные системы, например пожаротушение и клапаны вентиляции. Дело в том, что это оборудование поставляли третьи производители, и оно оказалось не готово к работе с айтишным инструментом. Так что с ним понадобилось немного повозиться.

Дата-центр мы сдали к ноябрю, он уже работает. Серьёзных замечаний у заказчика нет, разве что ребята перевесили кабели-органайзеры на другую сторону, чтобы был лёгкий доступ к портам стоек. В общем, неизбежные доработки для комфорта.

А вообще Утконос ОНЛАЙН сразу начал пользоваться новеньким ЦОДом на полную и даже подключил через него и фулфилмент-центр новенькую продвинутую систему складского менеджмента, которая отлично вписалась в обновлённую нами инфраструктуру.

“

Раньше мы управляли складами с помощью SAP EWM. Но поняли, что нам нужно разрабатывать заточенную под нашу бизнес-модель систему и привлекать молодых энергичных айтишников, а им язык ABAP просто неинтересен. И вообще складской менеджмент уже давно стал архаичной средой, здесь мало прогресса. Поэтому мы решили разработать для обновлённых бизнес-процессов центра новую WMS (Warehouse Management System). Наша WMS — это система, которая первой в мире решает задачу по управлению механизированными складами с продуктами питания. Назначение системы — координация сотрудников и механизации на складах для автоматизации бизнес-процессов, таких как приёмка и размещение товаров, комплектация и отгрузка заказов, обработка возвратов, инвентаризация. Архитектура основывается на микросервисных, event-driven-подходах и рассчитана на высокие нагрузки 24/7. Система имеет два фронтенда (сайт и мобильное приложение) и 15 сервисов на бэкенде. Стек реализован с помощью Java/Kotlin, Spring Boot, Camunda, PostgreSQL, Kafka, Hazelcast. В цифрах: САП, согласно историческим данным, мог обработать в штатном режиме до 12 тысяч заказов за день. Новая WMS, по нашим оценкам, легко справится с 40–50 тысячами.

Сейчас дата-центр загружен всего на 30 %. Но скоро к нему подключатся все сервисы и отделы заказчика: здесь будут работать службы распознавания лиц и видеоаналитики, храниться архивные видео. Производительность центра от этого не пострадает: он сможет полноценно отгружать около 18 тысяч заказов ежедневно — в два раза больше, чем раньше. Бутовский центр перестанет быть для Утконос ОНЛАЙН летней резиденцией. После нашей работы именно сюда постепенно переместится основная база компании.

А нас уже ждут новые непростые задачи. Сейчас колокейшены начали развиваться активно, но многим, как Утконосу ОНЛАЙН, нужны индивидуальные ЦОДы. Порой заказы приходят для весьма нетривиальных локаций: например, построить ЦОД для добытчиков на нефтяных и рудных месторождениях. Мы не пасуем и готовы такие неординарные инженерные решения воплощать в жизнь.