Comments 151

Это такой сервер стоит у вас 5000 рублей в месяц?

Расскажите пожалуйста, как происходит так, что в Европе аналогичный конфиг стоит в два раза дешевле?

Расскажите пожалуйста, как происходит так, что в Европе аналогичный конфиг стоит в два раза дешевле?

+13

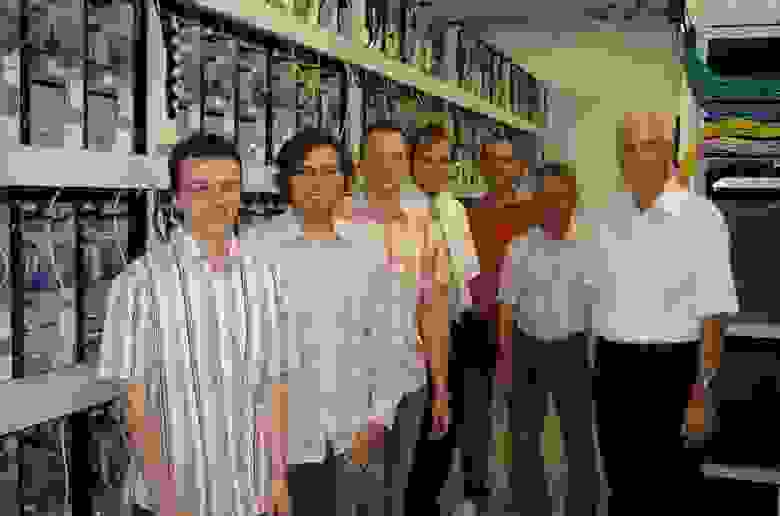

Потому что в тех местах в европе, где аналогичный конфиг стоит в 2 раза дешевле, это выглядит примерно так:

+20

www.leaseweb.com/en/dedicated-servers/quad-core-servers

Вот например, полноценный U1 сервер HP DL120G5 +10 евро за 4 гига оперативки или 30 за 8 гигов.

Всё равно получается 80 евро против 150 баксов у вас.

Вот например, полноценный U1 сервер HP DL120G5 +10 евро за 4 гига оперативки или 30 за 8 гигов.

Всё равно получается 80 евро против 150 баксов у вас.

+4

Не хочу спорить, дешевле, без вопросов.

Только 80 евро против 100 евро (ндс не забываем вычитать). И, судя по процессору, модель очень старая, из стоков.

А еще в той цене нет документов для бухгалтерии, панели на неограниченное число доменов, готового, заранее настроенного пакета софта для популярных CMS, автоматической миграции на более мощное оборудование при необходимости. Но кого это волнует ;)

Только 80 евро против 100 евро (ндс не забываем вычитать). И, судя по процессору, модель очень старая, из стоков.

А еще в той цене нет документов для бухгалтерии, панели на неограниченное число доменов, готового, заранее настроенного пакета софта для популярных CMS, автоматической миграции на более мощное оборудование при необходимости. Но кого это волнует ;)

+2

НДС в лизвебе не добавляется если ты не резидент евросоюза.

+3

Вот именно, это значит что на покупателях из РФ лизвеб заработает на N% больше, т.к. цена на сайте указана с VAT, но для нас она на размер VAT не снижается.

Понятно, что НДС в цене важен только для юр.лиц, т.к. они его могут зачесть. У нас примерно половина клиентов — корпоративные.

Если же Вы покупаете для себя как частное лицо, то Вам конечно же все-равно, есть в цене налог или нет. Все верно.

Понятно, что НДС в цене важен только для юр.лиц, т.к. они его могут зачесть. У нас примерно половина клиентов — корпоративные.

Если же Вы покупаете для себя как частное лицо, то Вам конечно же все-равно, есть в цене налог или нет. Все верно.

-4

На сайте цены указаны без VAT, в конце там такая галочка:

I declare that my business resides outside of the European Union and is thus not applicable to Dutch VAT. Please note that - in accordance with Dutch law - we will charge VAT if this box is not checked.+8

Хм, моя ошибка, каюсь. Плюс лизвебу в карму — далеко не все такие чистоплотные.

Натыкался на хитрость с VAT несколько раз у западных дискаунтеров и по инерции решил, что они все этим грешат.

Натыкался на хитрость с VAT несколько раз у западных дискаунтеров и по инерции решил, что они все этим грешат.

+1

Вообще-то, русские VAT не платят.

0

Если мне не нужна ни бухгалтерия, ни домены, ни софт, ни миграция, ни даже центр Москвы?

Зачем все ДЦ находятся в самом дорогом центре Москвы? Почему ни у кого не возникает желание поехать к немцам посмотреть как поживает сервер, и всем достаточного удалённого управления? Почему никто не построит в подмосковье, где дешёвая земля, большой просторный ДЦ с ценами как у немцов?

Зачем все ДЦ находятся в самом дорогом центре Москвы? Почему ни у кого не возникает желание поехать к немцам посмотреть как поживает сервер, и всем достаточного удалённого управления? Почему никто не построит в подмосковье, где дешёвая земля, большой просторный ДЦ с ценами как у немцов?

+4

Вот классный комментарий про электричество: habrahabr.ru/company/rusonyx/blog/145437/#comment_4886950

Есть примеры ДЦ в регионах. Например, известный в определенных кругах «деревянный ЦОД», построенный в лесу во Владимирской области. Но там отдельная история — электричество взяли от пансионата.

Есть также хорошие примеры ДЦ, построенных нашими компаниями зарубежом. Тут вам и Чехия, и Финляндия, и центральная Европа. Почему не в РФ — спросите себя, думаю знаете ответ.

Есть примеры ДЦ в регионах. Например, известный в определенных кругах «деревянный ЦОД», построенный в лесу во Владимирской области. Но там отдельная история — электричество взяли от пансионата.

Есть также хорошие примеры ДЦ, построенных нашими компаниями зарубежом. Тут вам и Чехия, и Финляндия, и центральная Европа. Почему не в РФ — спросите себя, думаю знаете ответ.

+2

Почему ни у кого не возникает желание поехать к немцам посмотреть как поживает сервер, и всем достаточного удалённого управления? Почему никто не построит в подмосковье, где дешёвая земля, большой просторный ДЦ с ценами как у немцов?

…

Построить — никаких проблем нет.

Только когда вы соберётесь подключать необходимую электрическую мощность

и канал связи, то поймёте, что немецкий ценник у вас будет только в мечтах…

…

Построить — никаких проблем нет.

Только когда вы соберётесь подключать необходимую электрическую мощность

и канал связи, то поймёте, что немецкий ценник у вас будет только в мечтах…

0

В любом случае получается наценка в пару тысяч рублей при том же или гораздо большем проценте эксцессов.

0

У лизвеба с трафиком беда — уж очень не бесплатный.

+3

cтруктурированные кабели, видно что полки расчитаны на определенный корпус, на каждом сервере подробная маркировка, виден kvm, все чисто и аккуратно. Что плохого на этой фотографии?

+8

В этой фотографии все прекрасно. Перед нами хороший образец аккуратного и тщательно выверенного до мелочей бизнеса.

Просто неправильно сравнивать компьютеры на стеллажах и серверы в шкафах. Это два разных решения для разных задач. И в 99% случаев, когда спрашивают, «а почему там дешевле» — имеют в виду именно такие решения.

Полноценные серверные решения на западе стоят гораздо дороже. Но нам в РФ они неизвестны — как раз по этой причине.

Взять, например, mediatemple.com/webhosting/nitro/

В Русониксе такое решение, построенное на аналогичной инфраструктуре и идентичном _лицензионном_ программном комплексе стоит в 2 раза дешевле. Но кому захочется равняться с МТ? Куда веселее сравнить с голым десктопом, установленным на стеллаже.

Просто неправильно сравнивать компьютеры на стеллажах и серверы в шкафах. Это два разных решения для разных задач. И в 99% случаев, когда спрашивают, «а почему там дешевле» — имеют в виду именно такие решения.

Полноценные серверные решения на западе стоят гораздо дороже. Но нам в РФ они неизвестны — как раз по этой причине.

Взять, например, mediatemple.com/webhosting/nitro/

В Русониксе такое решение, построенное на аналогичной инфраструктуре и идентичном _лицензионном_ программном комплексе стоит в 2 раза дешевле. Но кому захочется равняться с МТ? Куда веселее сравнить с голым десктопом, установленным на стеллаже.

+3

UFO just landed and posted this here

У дискаунтеров память без ECC. Устанавливая в десктоп такой объем памяти они сознательно идут на ухудшение работы сервера в угоду маркетингу, т.к. количество ошибок растет экспоненциально. При этом использовать эффективно такой объем памяти на десктопе практически невозможно.

В РФ хостингом командуют по большей части инженеры, нежели маркетологи. Они более ответственно и основательно подходят ко многим вопросам. Принципиальные люди. И таких пока еще много. Пока — потому что потихоньку вымирают.

В РФ хостингом командуют по большей части инженеры, нежели маркетологи. Они более ответственно и основательно подходят ко многим вопросам. Принципиальные люди. И таких пока еще много. Пока — потому что потихоньку вымирают.

+1

UFO just landed and posted this here

Xeon конечно же идут с ECC. Я про десктопные процессоры (i3,i5,i7 и проч. Core)

Про OVH я говорил, что они очень крутые и могу еще раз написать :) Очень уважаю OVH. Принимал участие в оценке их бизнеса 5-6 лет назад. С тех пор они стали просто мега-монстром с огромными финансовыми и техническими ресурсами.

Про OVH я говорил, что они очень крутые и могу еще раз написать :) Очень уважаю OVH. Принимал участие в оценке их бизнеса 5-6 лет назад. С тех пор они стали просто мега-монстром с огромными финансовыми и техническими ресурсами.

0

UFO just landed and posted this here

Виталий, я же Вас не отговариваю, а пытаюсь ответить на вопрос, почему так.

Изначально вопрос стоит так: почему вот тут дешевле, чем вот тут.

Ответ на картинке. Потому что для одного решения применяются одни подходы и технологии, а для другого — другие.

После этого возникает другой вопрос: если и там, и там работает примерно одинаково, то зачем платить больше?

Это очень похоже на вопрос почему черри тигго стоит дешевле тойоты рав4, хотя выглядят почти одинаково. И тот и другой нормально ездят по городу, места столько же. Колеса крутятся, фары светят, кондиционер дует. А стоит в 2 раза дешевле!

Попытаемся убедить: при аварии тигго скатается в калачик с начинкой из водителя и пассажиров. Но никто ведь не собирается попадать в аварию. Очень эффективно работает довод: «я уже третий год езжу на тигго и меня еще ни разу не закатало. и друзья тоже ездят на тигго, их тоже не закатало.».

А если начать говорить про надежность, то появляются такие железные доводы: «я так благодарен сервис-центру чери, они за год без вопросов заменили мне заднюю подвеску, рулевую рейку, перебрали движок! Все делают очень быстро и без доплаты! Рекомендую!»

Правильный ответ: каждый получает то, за что платит.

В таких обсуждениях обычно почему-то сравнивают ТТХ (чем больше, тем лучше) и не принимают во внимание, что есть много всего, чего в мегагерцы не обернешь. Тут и надежность, и готовое ПО, идущее вместе с сервером, и возможности автоматизации. Т.е. все то, что называется емким словом value.

Я в одном из комментариев приводил в пример mediatemple (тариф nitro). С ними почему-то никто не сравнивает, хотя у нас реализовано идентичное программно-аппаратное решение, адаптированное для российского рынка. И у нас оно стоит в 2 раза дешевле, чем у них. Но правда в том, что сравнивать некому. В РФ можно по пальцам пересчитать людей, пробовавших их решение — дорого.

Как-то длинно получилось. Это я все вот к чему. Мы не равняемся в своей работе на Хетцнер и других дискаунтеров. Ориентир для Русоникса — компании уровня Медиатемпл. Мы стараемся давать клиентам готовые комплексные решения для размещения сайтов и онлайн-сервисов. Поэтому делаем готовые наборы ПО для удобного использования неквалифицированными пользователями, даем панель управления, даем доп.сервис, чтобы клиенту не нужно было знать, что такое ssh.

Если же кому-то хочется потягаться с Хетцнером, то начинать нужно с расчета стеллажей под десктопы, а не с hi-end дата-центра в сердце Москвы.

Изначально вопрос стоит так: почему вот тут дешевле, чем вот тут.

Ответ на картинке. Потому что для одного решения применяются одни подходы и технологии, а для другого — другие.

После этого возникает другой вопрос: если и там, и там работает примерно одинаково, то зачем платить больше?

Это очень похоже на вопрос почему черри тигго стоит дешевле тойоты рав4, хотя выглядят почти одинаково. И тот и другой нормально ездят по городу, места столько же. Колеса крутятся, фары светят, кондиционер дует. А стоит в 2 раза дешевле!

Попытаемся убедить: при аварии тигго скатается в калачик с начинкой из водителя и пассажиров. Но никто ведь не собирается попадать в аварию. Очень эффективно работает довод: «я уже третий год езжу на тигго и меня еще ни разу не закатало. и друзья тоже ездят на тигго, их тоже не закатало.».

А если начать говорить про надежность, то появляются такие железные доводы: «я так благодарен сервис-центру чери, они за год без вопросов заменили мне заднюю подвеску, рулевую рейку, перебрали движок! Все делают очень быстро и без доплаты! Рекомендую!»

Правильный ответ: каждый получает то, за что платит.

В таких обсуждениях обычно почему-то сравнивают ТТХ (чем больше, тем лучше) и не принимают во внимание, что есть много всего, чего в мегагерцы не обернешь. Тут и надежность, и готовое ПО, идущее вместе с сервером, и возможности автоматизации. Т.е. все то, что называется емким словом value.

Я в одном из комментариев приводил в пример mediatemple (тариф nitro). С ними почему-то никто не сравнивает, хотя у нас реализовано идентичное программно-аппаратное решение, адаптированное для российского рынка. И у нас оно стоит в 2 раза дешевле, чем у них. Но правда в том, что сравнивать некому. В РФ можно по пальцам пересчитать людей, пробовавших их решение — дорого.

Как-то длинно получилось. Это я все вот к чему. Мы не равняемся в своей работе на Хетцнер и других дискаунтеров. Ориентир для Русоникса — компании уровня Медиатемпл. Мы стараемся давать клиентам готовые комплексные решения для размещения сайтов и онлайн-сервисов. Поэтому делаем готовые наборы ПО для удобного использования неквалифицированными пользователями, даем панель управления, даем доп.сервис, чтобы клиенту не нужно было знать, что такое ssh.

Если же кому-то хочется потягаться с Хетцнером, то начинать нужно с расчета стеллажей под десктопы, а не с hi-end дата-центра в сердце Москвы.

+2

Электричество и интернеты дешевле и доступнее. С электричеством вообще беда: оно либо дорого, ибо сеть уже нагружена почти до предела, либо не подведено и где брать — не ясно. Всё усугубляется монополией РАО ЕЭС. Так что претензии не к хостерам, а к тандему и ко.

+1

Про электричество — в точку.

Поэтому большинство ДЦ в РФ в зданиях бывших заводов и НИИ. Гораздо эффективнее строить под ДЦ новое здание, но в новом здании не будет электричества. Так и живем :)

Поэтому большинство ДЦ в РФ в зданиях бывших заводов и НИИ. Гораздо эффективнее строить под ДЦ новое здание, но в новом здании не будет электричества. Так и живем :)

+3

Это РАО ЕЭС из прошлого руки тянет?

И с электричеством беда и с интернетом беда и со всем так и останется беда, пока ДЦ будут строиться на территории бывших заводов в городе-герое.

И с электричеством беда и с интернетом беда и со всем так и останется беда, пока ДЦ будут строиться на территории бывших заводов в городе-герое.

0

UFO just landed and posted this here

Это серверы для сдачи в аренду. Они не используются для VPS, Jelastic, кластера и проч.

+3

Про архитектуру с централизованным хранилищем есть тут: habrahabr.ru/company/rusonyx/blog/130687/

0

Вот, вот это — хороший пост для хабра, вот так можно :) С удовольствием прочитал.

0

Скажите пожалуйста адрес помойки, в которую вы повыкидывали старьё. Спасибо.

+28

лучше бы пожертвовали википедии

+2

Боюсь википедии оно не надо. Старое железо менее мощное и при этом потребляет очень много электричества. У нас есть деллы, которым всего три года, а мы уже хотим их поменять на новые. Это тот случай, когда дешевле купить новое, чем эксплуатировать старое.

+1

а вот если серьезно — как решается вопрос утилизации?

+1

Продаем, отдаем, выкидываем.

+1

Ну как-как… Делается показательная фотка про выкидывание техники в помойку, а дальше см. комменты ниже :-)

+1

адрес помойки: изруквруки.ру наверное

+2

Его там уже нет :)

Но мы будем избавляться от старых серверов и дальше. Если интересно — напишите на u@rsnx.ru, запишу контакт и буду иметь в виду.

Но мы будем избавляться от старых серверов и дальше. Если интересно — напишите на u@rsnx.ru, запишу контакт и буду иметь в виду.

+3

OVH ставит 3-4 кастомных сервера с водяным охлаждением на 1U, выглядит вот так www.datacenterknowledge.com/archives/2012/04/30/european-giant-ovh-to-enter-us-hosting-market/

+2

Отличное решение. Только смутили два жёстких диска 3.5 перекрывающих поток воздуха. Хотя уверен, что температурный режим просчитан.

+1

Интересно, но почему такие компании существуют? Почему сами ДЦ не предоставляют сервера такого класса?

+2

Не все ДЦ умеют работать в розницу. Забот много, а выхлоп не очень большой.

Не случайно на рынке много примеров, когда компании, занимающиеся арендой серверов, строят свои ДЦ и почти ни одного примера, когда ДЦ запускает действительно успешный проект по сдаче в аренду.

Не случайно на рынке много примеров, когда компании, занимающиеся арендой серверов, строят свои ДЦ и почти ни одного примера, когда ДЦ запускает действительно успешный проект по сдаче в аренду.

+1

Потому что это разный бизнес. Один умеет доить корову, а другой — продавать на рынке. Один — программировать на пехапе, а другой — разговаривать с клиентами и знать чем отличется счет-фактура от платежного поручения.

Разделение труда это, на самом деле, большое достижение цивилизации.

Почему FoxConn делает сервера для HP, но не продает их на рынке сам, под своим именем?

Потому же.

Разделение труда это, на самом деле, большое достижение цивилизации.

Почему FoxConn делает сервера для HP, но не продает их на рынке сам, под своим именем?

Потому же.

+6

«Новые виртуальные серверы на ОС Windows временно не активируются.»

Когда планируете возобновить?

Когда планируете возобновить?

+1

А что там с ценами и дополнительными лицензиями?

+1

Извините, не понял вопрос. С лицензиями на что?

+1

Я просто не в курсе как у dell, но у HP например, Advanced ILo с нормальным kvm стоит отдельных денег.

Есть ли подобные ограничения в представленных серверах?

Есть ли подобные ограничения в представленных серверах?

+1

Нет, пока с дополнительными поборами у DELL не сталкивались :)

+1

Это радует)

Вы можете озвучить порядок цен например на C5220?

Вы можете озвучить порядок цен например на C5220?

+1

Цена в районе 0,5-1 млн рублей.

У нас давние и очень тесные отношения с DELL, поскольку мы используем только их оборудование. Цена может сильно отличаться.

Обратитесь к нашему дистрибьютору, он получит квоту для Вас и сообщит конечную цену.

У нас давние и очень тесные отношения с DELL, поскольку мы используем только их оборудование. Цена может сильно отличаться.

Обратитесь к нашему дистрибьютору, он получит квоту для Вас и сообщит конечную цену.

+2

У DELL есть разница в цене между обычным iDRAC и iDRAC Enterprise. В частности, в последнем есть Virtual Media, хранение образов на флешке и т.п.

Однако к C5220 это не относится — у них централизованное управление и без подобного функционала они были бы просто невыгодны. Основная их фишка — в снижении затрат, в т.ч. на администрирование.

Однако к C5220 это не относится — у них централизованное управление и без подобного функционала они были бы просто невыгодны. Основная их фишка — в снижении затрат, в т.ч. на администрирование.

+1

Интересный прорыв у DELL. А смотрели в сторону других производителей? Что у них в данный момент во флагманских линейках?

+1

В каждом сервере предусмотрены два сетевых интерфейса. Один мы используем для связи с внешним миром, а второй для бэкнета.

То есть аплинки не резервированы? А чем вызвано такое решение? Почему бы не сделать active/active тиминг до двух вышестоящих свитчей и средствами QoS резервировать полосу для «бэкнет VLAN»? Надежность будет выше, как и производительность.

И еще: в статье ни слова не было сказано про блейды. Например, мне как ламеру не совсем ясно, почему выбрана именно C series, а не какое-либо из блейд-шасси любого из производителей. Вопрос финансовый?

+1

При прочих равных блейды выйдут больше по размеру и, соответственно, менее плотнр и, в итоге, дороже.

+1

Ммм…

Ваше решение — 12 однопроцессорных следов на 3RU, по 32гб памяти.

А вот к примеру цискин UCS — шасси www.cisco.com/en/US/products/ps10279/index.html (6RU, 8 лезвий) и лезвия www.cisco.com/en/US/products/ps11583/index.html — 2 процессора, 512гб памяти и 20гб/с сеть.

Честно говоря, с точки зрения виртуализации UCS кладет IBM C Series на лопатки и добивает контрольным в голову.

Что UCS выйдет дороже — я даже не сомневаюсь, но вот по эффективности использования ограниченного места он явно лидирует. Вы ведь вроде опекс пытаетесь экономить, правильно?

Нет, серьезно, «32гб памяти на гипервизор» — нонсенс. Решение из топика годится исключительно для сервиса «физический сервер в аренду». Ничего «облачного» тут и в помине нет, и по факту транжирится впустую масса ресурсов. Да еще и сеть не резервирована…

Ваше решение — 12 однопроцессорных следов на 3RU, по 32гб памяти.

А вот к примеру цискин UCS — шасси www.cisco.com/en/US/products/ps10279/index.html (6RU, 8 лезвий) и лезвия www.cisco.com/en/US/products/ps11583/index.html — 2 процессора, 512гб памяти и 20гб/с сеть.

Честно говоря, с точки зрения виртуализации UCS кладет IBM C Series на лопатки и добивает контрольным в голову.

Что UCS выйдет дороже — я даже не сомневаюсь, но вот по эффективности использования ограниченного места он явно лидирует. Вы ведь вроде опекс пытаетесь экономить, правильно?

Нет, серьезно, «32гб памяти на гипервизор» — нонсенс. Решение из топика годится исключительно для сервиса «физический сервер в аренду». Ничего «облачного» тут и в помине нет, и по факту транжирится впустую масса ресурсов. Да еще и сеть не резервирована…

+1

Мы не используем гипервизоры в работе. Вы видимо вращаетесь в сфере внутри-корпоративного ИТ, где виртуализация используется для упаковки как можно большего количества разнородных и разноплатформенных служб в расчете на один погонный метр гермозоны.

Русоникс прежде всего хостинг провайдер. Для задач размещения сайтов ничего эффективнее PVC пока не изобретено (не хотелось бы ничего безапелляционно утверждать, но практика показывает, что это так).

Для гипервизора 32гб это действительно нонсенс. Вы не поверите, но на 32гб могут спокойно работать 100 контейнеров и при этом упираться они будут не в память и не в процессор, а в disk io. Причем спасают тут не инфинибэнды с полками(они как раз усугубляют ситуацию), а простое осознанное ограничение количества контейнеров на ноде + qos по диску.

Если же мы говорим об облаках, то каждый под облаками понимает свое, в зависимости от меры своей испорченности :) Например, описанные в статье серверы в сочетании с PVC превосходно подходят для горизонтально масштабируемых приложений. Фейсбук работает не на блейдах и гипервизорах, а на контейнерах и обычных серверах.

В общем, то о чем Вы пишете, справедливо для внутри-корпоративных применений, частных облаков. А у нас немного иные задачи.

Русоникс прежде всего хостинг провайдер. Для задач размещения сайтов ничего эффективнее PVC пока не изобретено (не хотелось бы ничего безапелляционно утверждать, но практика показывает, что это так).

Для гипервизора 32гб это действительно нонсенс. Вы не поверите, но на 32гб могут спокойно работать 100 контейнеров и при этом упираться они будут не в память и не в процессор, а в disk io. Причем спасают тут не инфинибэнды с полками(они как раз усугубляют ситуацию), а простое осознанное ограничение количества контейнеров на ноде + qos по диску.

Если же мы говорим об облаках, то каждый под облаками понимает свое, в зависимости от меры своей испорченности :) Например, описанные в статье серверы в сочетании с PVC превосходно подходят для горизонтально масштабируемых приложений. Фейсбук работает не на блейдах и гипервизорах, а на контейнерах и обычных серверах.

В общем, то о чем Вы пишете, справедливо для внутри-корпоративных применений, частных облаков. А у нас немного иные задачи.

+3

Так если все упирается в disk io может имеет смысл поставить 4 двухдюймовых диска? Еще лучше гибридных (готовые имеют встроенный 32GB SSD кэш на борту)? Суммарный объем HDD одного сервера уменьшится на 1Tb (25%( а скорость вырастет на 200%… Или я не прав??

+2

К сожалению, скорость не вырастет на 200%. Плюс стоимость решения будет сильно выше + лишние затраты на энергию и охлаждение. На практике для нашего сценария использования эффективнее взять два сервера попроще, чем наворотить один.

0

Гибридный диск стоит на $15 дороже обычного. За $130 получаете 750Gb гибридного… Питания он меньше кушает (гибридные от usb запитываются без пробелм, а значит и греются они меньше). По шпинделю, конечно, медленнее, но это за счет гибридности и не заметно. Опять же увеличивается число SATA-шин и за этот счет можно расширить поток еще немного.

DELL вообще разрешает чужие диски в себя ставить? Или там жесткие требования по гарантии???

DELL вообще разрешает чужие диски в себя ставить? Или там жесткие требования по гарантии???

0

Здесь нужно сравнивать не стоимость дисков относительно друг друга, а разницу в стоимости решения с 2 обычными 3,5 дисками и с 4 гибридными по 2,5.

И после этого сравнивать эффективность решения целиком. Важно прежде всего то, насколько больше удастся выжать из такой конфигурации. И тут все очень спорно. По скорости в разы разница не будет.

Плюс неясно как долго проживет ссд-кэш. Нужно проверять и тестировать.

Про потерю гарантии — надо уточнять. Мы этим принципиально не занимаемся. Серверы приходят сразу в нужной нам конфигурации. Если что-то нужно поменять — приезжает человек из DELL и привозит.

И после этого сравнивать эффективность решения целиком. Важно прежде всего то, насколько больше удастся выжать из такой конфигурации. И тут все очень спорно. По скорости в разы разница не будет.

Плюс неясно как долго проживет ссд-кэш. Нужно проверять и тестировать.

Про потерю гарантии — надо уточнять. Мы этим принципиально не занимаемся. Серверы приходят сразу в нужной нам конфигурации. Если что-то нужно поменять — приезжает человек из DELL и привозит.

+1

Интересно бы замерить… я просто размышлял в сторону disk io… SSD-кэш дает хороший прирост производительности, и увеличение шин, при правильной настройке, тоже… А вот насколько надежнее гибриды действительно, не ясно. Пока их для ноутов позиционируют (именно по причине скорости и потреблению), а это означают что их всетаки иногда выключают… :)

0

Это недорогое решение начального уровня для тех, кто по каким-то причинам не хочет брать виртуальный сервер или уже достаточно вырос.

Резервирование сетевых портов на разные свичи в данном случае — избыточно. В 8-следовые серверы можно поставить расширение до 2-х 10-гигабитных портов, вязать с полками, делать репликацию и т.д. Но это уже не будет стоить 4999 рублей в месяц.

Блейды очень дороги и избыточны для таких применений. Напомню, что эти серверы мы сдаем в аренду. Виртуальные серверы и прочие услуги работают на других решениях.

Т.е. Вы правы, все упирается в финансовые возможности клиентов. На каждый кошелек найдется свое решение.

Резервирование сетевых портов на разные свичи в данном случае — избыточно. В 8-следовые серверы можно поставить расширение до 2-х 10-гигабитных портов, вязать с полками, делать репликацию и т.д. Но это уже не будет стоить 4999 рублей в месяц.

Блейды очень дороги и избыточны для таких применений. Напомню, что эти серверы мы сдаем в аренду. Виртуальные серверы и прочие услуги работают на других решениях.

Т.е. Вы правы, все упирается в финансовые возможности клиентов. На каждый кошелек найдется свое решение.

+1

Ну тогда еще вопрос из любопытства. Каждый сервер строго индивидуален, или один клиент может заказывать услуги вида «20 серверов в изолированном VLANе, на выходе файрвол и балансировщик и т.д.»?

Ну и все-таки я так и не понял — почему сеть не резервируете? «Подключение к порту Cisco Catalyst 100/1000 Мбит/с Full Duplex» — это конечно очень круто с точки зрения клиентов, но и каталисты имеют свойство глючить…

Ну и все-таки я так и не понял — почему сеть не резервируете? «Подключение к порту Cisco Catalyst 100/1000 Мбит/с Full Duplex» — это конечно очень круто с точки зрения клиентов, но и каталисты имеют свойство глючить…

+1

Мы затачиваем все наши сервисы под массового пользователя. Т.е. такой сценарий как Вы описали вполне можем реализовать под конкретного клиента, но это будет индивидуальное решение с соотв. ценами. В стандартном предложении мы исходим из того, что клиент берет один-два-несколько серверов и использует их в своих целях без дополнительного участия наших инженеров. Т.е. заказать VLAN в автоматическом режиме на сайте сейчас не получится.

Честно — не представляю, что нужно сделать, чтобы начали глючить порты на каталисте. Зато легко могу представить как начинает глючить QoS и как мы не можем получить доступ к серверу из-за того, что оба порта забиты непонятно чем.

Эти серверы не предназначены для таких потоков данных. Если порт в принципе физически работает некорректно (было около 5 подобных случаев за 11 лет) — переткнули кабель в другой и весь разговор.

Честно — не представляю, что нужно сделать, чтобы начали глючить порты на каталисте. Зато легко могу представить как начинает глючить QoS и как мы не можем получить доступ к серверу из-за того, что оба порта забиты непонятно чем.

Эти серверы не предназначены для таких потоков данных. Если порт в принципе физически работает некорректно (было около 5 подобных случаев за 11 лет) — переткнули кабель в другой и весь разговор.

+1

не представляю, что нужно сделать, чтобы начали глючить порты на каталисте.

Вы слишком мало с ними работали :)

Ну например из недавнего. 6500-й каталист, пара супов 720-10G, все круто, все резервировано. По идее, при глюке на одном из супов управление сразу перейдет на другой. Правильно? А хрена лысого. На ровном месте адские потери, в логах:

17:43:49.575: %CONST_DIAG-SW1_SPSTBY-6-HM_TEST_RECOVERED: Module 1 TestSPRPInbandPing recovered after 8 consecutive failure(s)

17:48:17.169: %CONST_DIAG-SW1_SPSTBY-3-HM_TEST_FAIL: Module 1 TestSPRPInbandPing consecutive failure count:5

17:48:17.169: %CONST_DIAG-SW1_SPSTBY-4-HM_TEST_WARNING: Sup switchover will occur after 10 consecutive failures

17:49:22.977: %CONST_DIAG-SW1_SPSTBY-6-HM_TEST_RECOVERED: Module 1 TestSPRPInbandPing recovered after 8 consecutive failure(s)

17:51:05.259: %CONST_DIAG-SW1_SPSTBY-6-HM_TEST_RECOVERED: Module 1 TestSPRPInbandPing recovered after 5 consecutive failure(s)

17:53:41.331: %CONST_DIAG-SW1_SPSTBY-6-HM_TEST_RECOVERED: Module 1 TestSPRPInbandPing recovered after 5 consecutive failure(s)

18:00:50.337: %CONST_DIAG-SW1_SPSTBY-6-HM_TEST_RECOVERED: Module 1 TestSPRPInbandPing recovered after 5 consecutive failure(s)

Автоматический фейловер не произошел, ибо ошибок недостаточно много… Ладно, ручной фейловер — и все заработало как надо. TAC, конечно, на следующий день доставил новый суп, но осадочек остался…

Все еще не верите, что каталисты глючат? Почитайте это.

А вот с QoS на них никогда никаких проблем не было. Я точно знаю, у меня голос много где ходит.

+1

Нет, я охотно верю, но действительно не знаю чем их так можно нагрузить в нашем случае.

Вы похоже пишете про следующий уровень маршрутизации. В моем понимании такого плана оборудование применяется для связи с аплинками. Либо для очень быстрого обмена данными между серверами для каких-то специфических применений.

Но мы же не будем втыкать каждый сервер в отдельный порт на такой железяке (да еще и резервировать). Услуга получится золотая и никому не нужная. На уровне веб-приложений все сильно проще и нагрузки на сеть сильно меньше.

Вы похоже пишете про следующий уровень маршрутизации. В моем понимании такого плана оборудование применяется для связи с аплинками. Либо для очень быстрого обмена данными между серверами для каких-то специфических применений.

Но мы же не будем втыкать каждый сервер в отдельный порт на такой железяке (да еще и резервировать). Услуга получится золотая и никому не нужная. На уровне веб-приложений все сильно проще и нагрузки на сеть сильно меньше.

0

Но мы же не будем втыкать каждый сервер в отдельный порт на такой железяке

Это было бы оптимально… Только вот вопрос: на сайте сказано «каждый сервер воткнут в порт каталиста» — тогда про какой каталист идет речь? И как они вообще организованы? Неужели гора 2960-х?

Например, модуль cat6500 WS-X6548-GE-TX (48 гигабитных медных портов) стоит по GPL $12k. Я бы не сказал, что это прямо пипец как дорого…

Но каталист уже понемногу переходит в категорию «унылый отстой», когда мы говорим о ЦОДах. Есть куда более приятные нексусы. Либо линейка Nexus 7000 (дорого и классно), либо Nexus 5500 + Nexus 2200 (дешево, но вполне сердито). Судя по всему, вам требуется очень-очень много портов. 5500-е уже поддерживают fabricpath, и к каждому можно подключить пару десятков фексов (безмозглые «свитчи» например с 48 медными гигабитными портами и несколькими 10G аплинками). В итоге — классная сеть, надежная и производительная.

А на N7K уже можно предоставлять услугу «виртуальный ЦОД с физическими серверами». Выделить в отдельный контекст порты заказчика и дать ему полное управление этим контекстом. Ничего сломать для других заказчиков он не сможет (ну по крайней мере циска так обещает).

+1

Что до фейсбука — можно почитать www.quora.com/Why-do-facebook-google-and-amazon-prefer-1U-servers-to-blade-servers-in-their-data-centers к примеру. То есть от блейдов отказываются как раз из-за слишком высокой плотности размещения систем и вызванными этим проблемами с электроснабжением и охлаждением, а занимаемое пространство их мало заботит. Решение из топика, соответственно, тоже их не устроит.

Ну и никто не говорит, что из «блейд» обязательно следует «виртуализация»… Да, обычно на лезвиях работают гипервизоры, но далеко не всегда.

Ну и никто не говорит, что из «блейд» обязательно следует «виртуализация»… Да, обычно на лезвиях работают гипервизоры, но далеко не всегда.

+2

Прелесть этого решения в том, что оно потребляет неприлично мало электроэнергии. Т.е. три 1U сервера R610 потребляют гораздо больше, чем одна такая штучка.

+1

Все-таки чудес не бывает, и одноюнитовый сервер с начинкой, примерно идентичной таковой у следа, будет кушать примерно столько же энергии.

Только у него еще можно винты менять на горячую :)

Только у него еще можно винты менять на горячую :)

+1

Поздравляю, по запросу «оранжевый чувак выбрасывает сервер» этот пост на первом месте! :)

+7

А как у этого чуда с охлаждением и питанием? Как правило все решения такого уровня резко увеличивают нагрузку на линии питания и охлаждения.

+1

Шкафы и схема охлаждения в нашем ДЦ изначально расчитаны на потребление 10-15 квт. Поэтому никаких проблем с охлажден идем нет.

Кроме того эти серверы практически не греются — спасибо Intel за волшебные процессоры с низким энергопотреблением. Кроме того в них стоит память типа lv (low voltage). Она дороже, но это того стоит.

У процессоров tdp — 45Вт. Для сравнения у нас есть серверы трехлетней давности в которых установлено по два процессора с tdp 130Вт. Т.е. только за счет процессоров один старый сервер ест как 6 новых! А если приплюсовать сюда более эффективную схему охлаждения, менее энергоемкую память и современные диски, то получается 1:8-1:10.

Кроме того эти серверы практически не греются — спасибо Intel за волшебные процессоры с низким энергопотреблением. Кроме того в них стоит память типа lv (low voltage). Она дороже, но это того стоит.

У процессоров tdp — 45Вт. Для сравнения у нас есть серверы трехлетней давности в которых установлено по два процессора с tdp 130Вт. Т.е. только за счет процессоров один старый сервер ест как 6 новых! А если приплюсовать сюда более эффективную схему охлаждения, менее энергоемкую память и современные диски, то получается 1:8-1:10.

+3

Ээм… Даже не знаю как спросить.

На данный момент в хостинге Rusonyx эта технология используется?

На данный момент в хостинге Rusonyx эта технология используется?

+1

32 GB максимум — эх, не построишь серьезную молотилку!

+1

1) Нет 10G и возможности его воткнуть.

2) Лимит по памяти довольно жёсткий.

3) Хотсвап жёсктих дисков выглядит несколько грустно.

В остальном выглядит круто.

2) Лимит по памяти довольно жёсткий.

3) Хотсвап жёсктих дисков выглядит несколько грустно.

В остальном выглядит круто.

+1

1) Карта расширения с портами 10G есть в 8-следовой конфигурации. Как раз ждем такие.

2) Объем памяти — ограничение исходя из возможностей процессора (Xeon E3), а все вместе — следствие ограничений по энергопотреблению и теплоотводу. Тут пока никак :(

3) Да, хотсвапа нет. Зато в PVC доступна живая миграция, которая позволяет перенести клиента целиком с одного сервера на другой, причем без потери сессий и разрыва коннектов. Так что случись что с одним из дисков — клиент просто уезжает на любую свободную машину и проблемные запчасти меняются в рабочем порядке.

2) Объем памяти — ограничение исходя из возможностей процессора (Xeon E3), а все вместе — следствие ограничений по энергопотреблению и теплоотводу. Тут пока никак :(

3) Да, хотсвапа нет. Зато в PVC доступна живая миграция, которая позволяет перенести клиента целиком с одного сервера на другой, причем без потери сессий и разрыва коннектов. Так что случись что с одним из дисков — клиент просто уезжает на любую свободную машину и проблемные запчасти меняются в рабочем порядке.

+1

Пункт 3 — реально ли работает? Вот ни разу не встречал, чтобы все так легко и просто мегрировало при поломке. Обычно полный шатдаун и outage на час — полтора.

+1

Работает, лично проверял на интернет-магазине на 1с-битрикс под нагрузкой.

Если как в указанном примере вылетел один диск из зеркала, то Вы теоретически можете работать на оставшемся еще пару лет, пока и он в какой-то момент не сломается. Т.е. с момента выхода из строя одного из дисков у Вас как правило в запасе есть достаточно времени, чтобы миграция прошла успешно.

Если же вылетели оба диска или сервер в принципе перестал работать, то да, не повезло, будет большой даунтайм, т.к. мигрировать в такой ситуации нечего и неоткуда. Бэкапы никто не отменял :)

Если как в указанном примере вылетел один диск из зеркала, то Вы теоретически можете работать на оставшемся еще пару лет, пока и он в какой-то момент не сломается. Т.е. с момента выхода из строя одного из дисков у Вас как правило в запасе есть достаточно времени, чтобы миграция прошла успешно.

Если же вылетели оба диска или сервер в принципе перестал работать, то да, не повезло, будет большой даунтайм, т.к. мигрировать в такой ситуации нечего и неоткуда. Бэкапы никто не отменял :)

+1

Вы знаете, я бы не стал считать миграцию с хоста заменой хотсвапу. В реальной нагрузке сотня (или более) клиентов, крутящихся на узле, мигрировать с него будет целую вечность.

0

В данном конкретном случае на сервере находится только один клиент — арендатор железки. Соответственно и мигрирует только он один.

Полностью с Вами согласен, что садить на подобные серверы кучу клиентов не самое разумное решение. Поэтому мы так и не делаем ;)

Я очень хочу попробовать зеркалирование контейнеров в реальном времени на нескольких машинах. Дойдут руки — поэкспериментируем и если все будет ок — предложим клиентам. Думаю такая услуга была бы востребована, т.к. в этом случае в любой момент времени на отдельном сервере существует полная копия рабочего контейнера и если с ним случилась беда зеркало сможет мгновенно заменить его собой. Но это будет стоить уже совсем другие деньги, конечно.

Полностью с Вами согласен, что садить на подобные серверы кучу клиентов не самое разумное решение. Поэтому мы так и не делаем ;)

Я очень хочу попробовать зеркалирование контейнеров в реальном времени на нескольких машинах. Дойдут руки — поэкспериментируем и если все будет ок — предложим клиентам. Думаю такая услуга была бы востребована, т.к. в этом случае в любой момент времени на отдельном сервере существует полная копия рабочего контейнера и если с ним случилась беда зеркало сможет мгновенно заменить его собой. Но это будет стоить уже совсем другие деньги, конечно.

+1

Итого имеем 132 сервера по 4 ядра в каждом = 528 ядер на шкаф.

4 hp BladeCenter c7000 в таком же шкафу с лезвиями BL460Gen8 на процах E5 дадут 1024 ядра(с 8-микоровыми процами) или 768 ядер (с 6-тикоровыми), что как то поболее будет…

А для раздачи виртуалок кол-во ядер играет свою роль…

4 hp BladeCenter c7000 в таком же шкафу с лезвиями BL460Gen8 на процах E5 дадут 1024 ядра(с 8-микоровыми процами) или 768 ядер (с 6-тикоровыми), что как то поболее будет…

А для раздачи виртуалок кол-во ядер играет свою роль…

0

A статью прочитать и комментарии?

Не раз уже говорилось, что это железо не для vm'ок.

Не раз уже говорилось, что это железо не для vm'ок.

+2

Ох, ну и крутая же штука! Боюсь мы бы столько электричества на стойку не потянули. Если грубо прикинуть, то это все скушает как минимум 256*90 ватт = 25кВт на стойку. Видел такое вживую лишь однажды. Я грубо считаю по процам, т.к. есть еще память, диски и свичи, все это обслуживающие.

И для виртулизации, связанной с размещением сайтов и подобных приложений, процессоры совсем не важны. Одно дело когда у нас гипервизоры с windows, на которых крутятся vdi с офисными приложениями и совсем другое — *nix с веб-сервером и относительно легкими базами данных.

Чуть выше я уже отвечал, что гипервизоры + корпоративный мир и контейнеры + мир онлайн-сервисов — совсем разные. В первом случае нужно много памяти и процессоров, а во втором самое узкое место — диски.

Даже если бы такую штуку как Вы написали нам подарили бесплатно — боюсь она бы пылилась в углу за ненадобностью :)

И для виртулизации, связанной с размещением сайтов и подобных приложений, процессоры совсем не важны. Одно дело когда у нас гипервизоры с windows, на которых крутятся vdi с офисными приложениями и совсем другое — *nix с веб-сервером и относительно легкими базами данных.

Чуть выше я уже отвечал, что гипервизоры + корпоративный мир и контейнеры + мир онлайн-сервисов — совсем разные. В первом случае нужно много памяти и процессоров, а во втором самое узкое место — диски.

Даже если бы такую штуку как Вы написали нам подарили бесплатно — боюсь она бы пылилась в углу за ненадобностью :)

+1

Не очень соглашусь, ибо всё зависит от… строил я некоторое время назад корпоративное геораспределённое (англия, две точки в сша, спб и гонконг) облачко, гипервизоров так на пару сотен, там FAS3240 с трудом справлялись с нагрузками, а в какой-то момент ребятки из NetApp стали нам давать своё железо на «погонять» под нагрузками, которую генерили наши R&D, в боевые их новые разработки мы и сами уже боялись, да и они настоятельно не рекомендовали :)

Благо уже не NDA (история 2006-2007 годов), то позволю себе рассказать о том почему «уже боялись»: По сильно большой необходимости, один из вендоров, ПО которого мы предоставляли клиентам в нашем облачке, поддерживал работу своего приложения только на AMD процессорах. От SUN были получены энкложи, которые поддерживали работу 5 блейдов с AMD + 5 блейдов с Intel процами одновременно (тогда это был первый подобный опыт у кого-либо из вендоров). Но после 4,5 часового даунтайма одной из энклож при апгрейде BIOS'a с 0.2-alpha на 0.3-beta и, соот-но, ожиданием привоза нам подменной энкложи решили, что такие эксперименты нам не очень нравятся. Кстати энкложи эти получилась очень неплохими на тот момент времени и с релизом мы ей укомплектовались по полной.

Благо уже не NDA (история 2006-2007 годов), то позволю себе рассказать о том почему «уже боялись»: По сильно большой необходимости, один из вендоров, ПО которого мы предоставляли клиентам в нашем облачке, поддерживал работу своего приложения только на AMD процессорах. От SUN были получены энкложи, которые поддерживали работу 5 блейдов с AMD + 5 блейдов с Intel процами одновременно (тогда это был первый подобный опыт у кого-либо из вендоров). Но после 4,5 часового даунтайма одной из энклож при апгрейде BIOS'a с 0.2-alpha на 0.3-beta и, соот-но, ожиданием привоза нам подменной энкложи решили, что такие эксперименты нам не очень нравятся. Кстати энкложи эти получилась очень неплохими на тот момент времени и с релизом мы ей укомплектовались по полной.

+2

>там FAS3240 с трудом справлялись с нагрузками

Хм, вообще-то как бы и неудивительно, 3240 это довольно средненький midrange, а описываемая вами задача явно хочет уже чего-то из 6200.

Хм, вообще-то как бы и неудивительно, 3240 это довольно средненький midrange, а описываемая вами задача явно хочет уже чего-то из 6200.

+1

Интересный у Вас опыт, даже немного завидую масштабу и серьезности задач. И бюджету ;)

Однако мы решаем другие задачи для наших клиентов. У нас нет частных облаков, кастом-решений под конкретного клиента. Мы — массовый сервис. 99% того, что мы делаем, можно заказать прямо на сайте, оплатить и начать использовать без участия наших инженеров. В этом смысл нашей деятельности.

Однако мы решаем другие задачи для наших клиентов. У нас нет частных облаков, кастом-решений под конкретного клиента. Мы — массовый сервис. 99% того, что мы делаем, можно заказать прямо на сайте, оплатить и начать использовать без участия наших инженеров. В этом смысл нашей деятельности.

+1

а можете предоставить ваши цифры потребления на одну стойку? если грубо то 132*95Вт ~ 13кВт что с запасом + на винты и прочее почти к 15-17 кВт приближается?

за статью спасибо, интересные железки.

за статью спасибо, интересные железки.

+1

Реальное потребление с такими железкам там не выше 9 кВт на стойку.

Полностью набитый микроклоуд от супермикры жрет меньше 400 Вт.

Полностью набитый микроклоуд от супермикры жрет меньше 400 Вт.

+1

реальное то понятно меньше раза в полтора-два. но учитывая пики — можно и просесть.

откуда вопрос — редко где видел чтобы ДЦ давал больше 5-8 кВт на стойку.

откуда вопрос — редко где видел чтобы ДЦ давал больше 5-8 кВт на стойку.

+1

Как, интересно просесть на пиках? Если у дц нет запаса по чистому, то он плохой дц. Все остальное переживаемо, и кроме как жадностью дц ничем не объяснимо.

Опять же, так как железки не под одного клиента, одновременно пика там не будет никогда.

Опять же, так как железки не под одного клиента, одновременно пика там не будет никогда.

+2

У нас 10-15 кВт на стойку.

+1

А давать больше 6 кВт на стойку тупо не выгодно. Прежде всего из за охлаждения — оно тут же становится дороже раза в 2-3 (пример фейсбука приводили)

Так, 6 киловатную стойку можно найти и за 40 тр, а вот 10 киловатную дешевле 100 найти трудно, вполне по объективным причинам.

Да и реального спроса на высокую плотность мало.

Так, 6 киловатную стойку можно найти и за 40 тр, а вот 10 киловатную дешевле 100 найти трудно, вполне по объективным причинам.

Да и реального спроса на высокую плотность мало.

+1

Да, у нас та же история. Вы их у себя в химках ставите?

+1

Это уже очень серьезная задача — подвести столько электричества на стойку и отвести столько тепла. Фактически для таких дадач (и решений) проектируется и строится отдельный датацентр, и там куча возни с «подводом» и «отводом». Я знаю один такой датацентр, вот в точности как вы описываете, это датацентр для рендерфермы Weta Digital в Новой Зеландии, студии, которая рисовала Avatar, District 9, Lord of the Rings, и так далее.

Они строили под нее специальное здание и заказывали ритталовские стойки с водяным охлаждением, позволяющие такую уйму тепла отводить.

Кажется я даже писал когда-то про этот проект на Хабре.

Они строили под нее специальное здание и заказывали ритталовские стойки с водяным охлаждением, позволяющие такую уйму тепла отводить.

Кажется я даже писал когда-то про этот проект на Хабре.

+1

UFO just landed and posted this here

UFO just landed and posted this here

Сравнивать десктопы с профессиональными серверами как-то не очень корректно. Как выглядят стойки у хетзнера можете взглянуть на фотографии к первому комментарию здесь, там именно Hetzner. Надежность такого решения весьма сомнительна. Сам держу три сервера у хетзнер и последнее время при ддос атаках они стали тупо отключать айпи моих серверов в сети. И потом по полдня к ним не достучаться. Уж извините, такая «надежность» мне не нужна. Уже ищу другие решения на замену.

+1

UFO just landed and posted this here

Я у Hetzner уже 2 года. И мне раньше тоже ничего не лочили. Ддосов сильных на меня не бывает. Поэтому раньше справлялся фильтрованием атакующих айпи в файрволе прямо на сервере. Но за последние две недели Hetzner блокировал мои сервера два раза! Притом судя по логам, ддос были очень слабые. Я бы их отбил самостоятельно в файрволе. И когда лочили мои сервера, я по полдня не мог получить ответа от службы поддержки (обычно туда вообще не обращаюсь). Поэтому предположу, что Hetzner набрал слишком много клиентов, и тупо не справляется даже служба поддержки. Я лично планирую от них уходить. Такого кошмара, когда сервер недоступен и нельзя получить ответа от службы поддержки в течении несколько часов, я не встречал даже в Российских ДЦ, хотя перепробовал их много.

0

И насчет надежности. Уже было несколько ситуаций когда начинала глючить оперативная память. И была ситуация, когда ломался жесткий диск. Но к чести Hetzner могу сказать, что они меняли все комплектующие оперативно и без дополнительной оплаты.

0

UFO just landed and posted this here

А я вот не забыл, как keyweb (hetzner поступил бы так же) может просто выключить сервер за ссылки (!) на mp3, получив предписание установить личность (а не выключить сервер) от немецких органов, которые получили такой запрос от российских.

При этом в России та же nigma продолжает существовать, размещая яндекс.директ (РСЯ) по запросам «скачать мадонну» (что запрещено правилами директа и мне яндекс запретил делать), спокойно продолжают существовать настоящие пираты вроде zaycev.net

При этом в России та же nigma продолжает существовать, размещая яндекс.директ (РСЯ) по запросам «скачать мадонну» (что запрещено правилами директа и мне яндекс запретил делать), спокойно продолжают существовать настоящие пираты вроде zaycev.net

0

сколько вести такое удовольствие?

+1

> 8 или 12 серверов/следов (sled в терминологии DELL) уровня R210 в одном 3U корпусе.

Общепринятый термин «блейд» делловцы не используют, опасаясь HP?

Общепринятый термин «блейд» делловцы не используют, опасаясь HP?

+1

сам не пойму описанных восхищений, и упоминания о трудностях с одноюнитовыми Деллами. Мля ХП-шные корзины с блейдами, юзал еще 3-4 года назад, когда они появились не знаю.

+1

Блейд — решение совсем другого уровня. У DELL есть линейка блейдов и они именно так и называются: www.dell.com/us/business/p/poweredge-blade-servers

В комментариях уже несколько раз раскрывал разницу между корпоративными задачами и задачами веб-сервисов. Это два разных мира, которые почти не пересекаются.

Блейды для нас — жуткий оверхед и пустая трата денег. В то же время С-серия отлично подходит для решения наших задач.

В комментариях уже несколько раз раскрывал разницу между корпоративными задачами и задачами веб-сервисов. Это два разных мира, которые почти не пересекаются.

Блейды для нас — жуткий оверхед и пустая трата денег. В то же время С-серия отлично подходит для решения наших задач.

+1

Фотография _MG_4533_m.jpg сфокусирована не там, где хотелось бы — на разъёмах.

0

132 сервера в стойку — отличный результат.

Я бы предпочел таки лезвия, т.к. у меня есть требования изолированности и проектности. Но если массовая услуга — то вообще супер. Второй интерфейс им нафиг не нужен. Или за бабло. Не думаю что вы аггрегируете всю эту сифню L3 коммутаторами, оно вам не надо. 264 порта в стойке — это имба много. Это просто дохрена портов. Управлять таким количеством сети — это аллес. Если надо л2 виланить — нереальный гимор. Во что втыкаете 132*2 порта из стойки?

Я бы предпочел таки лезвия, т.к. у меня есть требования изолированности и проектности. Но если массовая услуга — то вообще супер. Второй интерфейс им нафиг не нужен. Или за бабло. Не думаю что вы аггрегируете всю эту сифню L3 коммутаторами, оно вам не надо. 264 порта в стойке — это имба много. Это просто дохрена портов. Управлять таким количеством сети — это аллес. Если надо л2 виланить — нереальный гимор. Во что втыкаете 132*2 порта из стойки?

0

Если бы не такое количество портов — влезло бы еще на 12 больше. Кабелей слишком много получается.

По конкретным моделям свичей сейчас не скажу, нужно уточнять. Для рабочих портов там что-то управляемое но относительно недорогое от cisco, а для бэкнета — что-то попроще, кажется linksys, т.к. он только для наших технических нужд.

По конкретным моделям свичей сейчас не скажу, нужно уточнять. Для рабочих портов там что-то управляемое но относительно недорогое от cisco, а для бэкнета — что-то попроще, кажется linksys, т.к. он только для наших технических нужд.

0

Реквестирую фотку коммутации, если у вас в зале можно снимать :)

0

Снимать, к сожалению, нельзя. Два года назад ради фотографий стойки мы брали специальное разрешение, а сейчас еще сложнее. т.к. рядом поставили электронные гос. аукционы.

0

Я и сам, признаться, не видел. Инженером не являюсь, допуска нет.

0

ну не иженеру наверное не так интересно. просто когда фигачишь столько проводов из готовых патчкордов начинаешь на ходу изобретать всякие хитрости для красивого и качественного монтажа (длина то разная, остаются излишки у слишком длинных). я когда в одной стойке свел 288 портов — это было имба, несколько дней на то чтобы все связать и уложить.

0

Мы кстати думали в сторону заказа патчкордов строго определенной длины. Самим обжимать — бред, а фабричных нестандартных размеров в свободной продаже не видел. Не знаете случаем, есть ли у кого заказать в РФ?

0

У кого заказать в рф не знаю, вся готовая кабельная продукция которая здесь продается это импорт. hyperline, panduit и т.п. Уверен что если доколупатся до какой нить маленькой фирмочки которые делают оптические патчи и т.п., то они обслужат вам большой заказ на нестандартные длины по приемлемой стоимости. Я при обвязке использую стандартные длины 3м, 2м, 1.5м. Чтобы небыло месива из лишних хвостов подбираю порты таким образом чтобы длина между ними максимально соответсвовала длине патча. При монтаже блейдов в аггрегирующий коммутатор в верху стойки — получается нормально и аккуратно. При монтаже кроссовых стоек — начинается веселуха, ибо там плотность высокая, решаю так же, только коммутатор ставлю в центре кросса, чтобы не использовать 3х метровые хвосты. Ну да и кросс я делал года три назад, сейчас от них отказались, вот как раз изза этих гемороев, и все делаем на лезвиях кроме серверов субд.

0

Попробуйте shop.nag.ru

Давно там закупаемся, да и не только мы. Хотя в Москве, наверное, найти поставщика будет не сложнее, имхо. Они просто под собственным брендом немало забавных полезностей предлагают. Уверен, что и под заказ изготовить сумеют.

Давно там закупаемся, да и не только мы. Хотя в Москве, наверное, найти поставщика будет не сложнее, имхо. Они просто под собственным брендом немало забавных полезностей предлагают. Уверен, что и под заказ изготовить сумеют.

0

Классные фотки.

0

Sign up to leave a comment.

132 сервера в стойке или как уплотниться и не лопнуть