Трафик приложений в сети предприятия постоянно растет, а с развитием виртуализации появляются новые решения и сервисы, для которых рекомендуемые скорости интерфейсов на оборудовании уже составляют 10Гбит/c. Для малого и среднего бизнеса на сегодняшний день выгодно использовать технологию Ethernet — как для подключения пользователей, серверов, телефонии и прочего, так и для подключения систем хранения, т.е. организации SAN. В данной статье представлен обзор коммутаторов с 24 10Gb оптическими портами. Для сравнения мы взяли 5 коммутаторов ведущих производителей:

Для подключения к коммутатору серверов, систем хранения и коммутаторов подсетей пользователей нам понадобятся оптические трансиверы, которые обеспечивают передачу на разные расстояния:

Помимо 24-х портовых устройств, которые мы собираемся задействовать, бывают также и 48-ми портовые модели. Стоимость трансиверов, может привышать стоимость самого устройства в несколько раз.

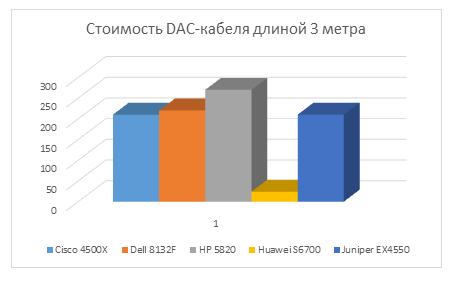

Если необходимо подключение на небольшие расстояния до 7 метров, например в пределах серверной комнаты или стойки, можно использовать DAC кабель (direct attach copper cable, так же известен как Twinax). Его стоимость на порядок ниже стоимости трансиверов:

Не стоит забывать о технической поддержке и гарантии:

A. Коммутатор Dell Power Connect 8132F обладает «джентльменским» набором, который позволяет внедрить большинство современных медиа-услуг:

Одно из многих достоинств коммутатора — возможность увеличения количества портов картами расширения с 24 до 32 портов 10Gbps или добавления карты с 2-мя интерфейсами по 40Gbps QSFP. Можно объединить до 6 коммутаторов в отказоустойчивый стек.

Отличительной особенностью серии коммутаторов 8100, наряду с поддержкой функционала DCB (data center bridging), является технология для оптимизации iSCSI, которая автоматически определяет и настраивает коммутатор при подключении систем хранения Dell EqualLogic. При покупке коммутатора Dell Power Connect 8132F техническая поддержка на 3 года уже входит в комплект поставки.

Кроме того существует модель с медными 10GbE портами Dell Power Connect 8132.

B. Коммутатор Cisco Catalyst 4500X традиционно имеет расширенный и гибкий функционал в области работы с QoS, средствами безопасности, мониторинга и управления, виртуализации сети, маршрутизации (в том числе мультикаст траффика) как правило, поддерживаемый исключительно на оборудовании Cisco. Коммутатор можно расширить с 24 до 32 портов 10Gb c помощью интерфейсной карты. Есть возможность объединения до 2 коммутаторов в стек по собственной технологии VSS. Поддерживаются такие протоколы как EIGRP, BGP, PBR, PIM. Решение больше подойдет для организации высокопроизводительного ядра сети с продвинутыми возможностями гибкого управления и мониторинга различного трафика на уровне приложений при поддержании повышенного уровня безопасности и отказоустойчивости. Если у вас какие-то особые функциональные требования, то вероятнее всего, что именно это оборудование справится с вашей задачей.

C. Коммутаторы Juniper часто сравнивают с Cisco. Juniper EX4550 так же имеет расширенный L2-функционал и поддержку протоколов OSPF, BGP, IS-IS, а так же DCB (data center bridging) и многое другое. Отличительной особенностью EX серии является технология стекирования Juniper Virtual Chassis, которая позволяет объединить в одно логическое устройство до 10 коммутаторов с помощью интерфейсных модулей 40Gbps QSFP или специальных модулей 128Gbps — при комбинации этих способов можно увеличить пропускную способность до 320Gbps. Коммутатор подойдет как для дата-центров, так и для создания высокопроизводительного ядра предприятия. Имеются так же модели с медными 10Gbps портами.

D. Коммутаторы HP 5820 располагают расширенным L2-функционалом и поддержкой протоколов OSPF, BGP, IS-IS, а так же DCB (data center bridging) с помощью дополнительных интерфейсных карт. С помощью собственной технологии Intelligent Resilient Framework (IRF) можно построить сетевую фабрику из 9 коммутаторов посредством объединения до 1024 портов 10GbE. Для централизованного управления всей фабрикой (как большим виртуальным коммутатором) HP предлагает графическую утилиту Intelligent Management Center (IMC). Стоит сказать, что в данной серии отсутствует поддержка интерфейсов 40Gbps QSFP.

E. Коммутаторы Huawei S6700 по заявленному функционалу тоже имеет расширенный L2-функционал и поддержку протоколов OSPF, BGP, IS-IS. Используя технологию iStack можно сформировать стек посредством объединения портов 10GbE. Плат расширения для данной серии не предусмотрено.

Нельзя однозначно сказать, что победитель один. Хотя в результате сравнения первое место можно отдать коммутатору Dell Power Connect 8132F за наиболее максимальный функционал, низкую цену, большой набор дополнительных функций, но нельзя забывать, что в конечном итоге все может измениться и идеальным вариантом может любой из выше сравниваемых моделей из-за следующих критериев:

• Задачи

• Количество требуемых коммутаторов

• Необходимая пропускная способность

• Возможность создания стека

• Допустимая производительность

Для подбора сетевого оборудования обратитесь к нашему инженеру Хисматуллину Вадиму. Он подберет наиболее оптимальный вариант оборудования в соответствии с вашими задачами и возможностями.

- Cisco Catalyst 4500X

- Dell 8132F

- HP 5820

- Huawei S6700

- Juniper EX4550

- Для начала оценим затраты на покупку коммутатора с двумя блоками питания, для обеспечения отказоустойчивости:

Для подключения к коммутатору серверов, систем хранения и коммутаторов подсетей пользователей нам понадобятся оптические трансиверы, которые обеспечивают передачу на разные расстояния:

Помимо 24-х портовых устройств, которые мы собираемся задействовать, бывают также и 48-ми портовые модели. Стоимость трансиверов, может привышать стоимость самого устройства в несколько раз.

Если необходимо подключение на небольшие расстояния до 7 метров, например в пределах серверной комнаты или стойки, можно использовать DAC кабель (direct attach copper cable, так же известен как Twinax). Его стоимость на порядок ниже стоимости трансиверов:

Не стоит забывать о технической поддержке и гарантии:

A. Коммутатор Dell Power Connect 8132F обладает «джентльменским» набором, который позволяет внедрить большинство современных медиа-услуг:

- поддержка большинства стандартных L2-протоколов и безопасности (spanning-tree, LACP, VRRP, Dynamic ARP Inspection, 802.1x и т. д.)

- поддержка маршрутизации — 512 IPv4 / 256 IPv6 статических маршрутов

- поддержка RIP и OSPF

- поддержка мультикаст-протоколов PIM-SM и PIM-DM

- поддержка средств QoS и управления

Одно из многих достоинств коммутатора — возможность увеличения количества портов картами расширения с 24 до 32 портов 10Gbps или добавления карты с 2-мя интерфейсами по 40Gbps QSFP. Можно объединить до 6 коммутаторов в отказоустойчивый стек.

Отличительной особенностью серии коммутаторов 8100, наряду с поддержкой функционала DCB (data center bridging), является технология для оптимизации iSCSI, которая автоматически определяет и настраивает коммутатор при подключении систем хранения Dell EqualLogic. При покупке коммутатора Dell Power Connect 8132F техническая поддержка на 3 года уже входит в комплект поставки.

Кроме того существует модель с медными 10GbE портами Dell Power Connect 8132.

B. Коммутатор Cisco Catalyst 4500X традиционно имеет расширенный и гибкий функционал в области работы с QoS, средствами безопасности, мониторинга и управления, виртуализации сети, маршрутизации (в том числе мультикаст траффика) как правило, поддерживаемый исключительно на оборудовании Cisco. Коммутатор можно расширить с 24 до 32 портов 10Gb c помощью интерфейсной карты. Есть возможность объединения до 2 коммутаторов в стек по собственной технологии VSS. Поддерживаются такие протоколы как EIGRP, BGP, PBR, PIM. Решение больше подойдет для организации высокопроизводительного ядра сети с продвинутыми возможностями гибкого управления и мониторинга различного трафика на уровне приложений при поддержании повышенного уровня безопасности и отказоустойчивости. Если у вас какие-то особые функциональные требования, то вероятнее всего, что именно это оборудование справится с вашей задачей.

C. Коммутаторы Juniper часто сравнивают с Cisco. Juniper EX4550 так же имеет расширенный L2-функционал и поддержку протоколов OSPF, BGP, IS-IS, а так же DCB (data center bridging) и многое другое. Отличительной особенностью EX серии является технология стекирования Juniper Virtual Chassis, которая позволяет объединить в одно логическое устройство до 10 коммутаторов с помощью интерфейсных модулей 40Gbps QSFP или специальных модулей 128Gbps — при комбинации этих способов можно увеличить пропускную способность до 320Gbps. Коммутатор подойдет как для дата-центров, так и для создания высокопроизводительного ядра предприятия. Имеются так же модели с медными 10Gbps портами.

D. Коммутаторы HP 5820 располагают расширенным L2-функционалом и поддержкой протоколов OSPF, BGP, IS-IS, а так же DCB (data center bridging) с помощью дополнительных интерфейсных карт. С помощью собственной технологии Intelligent Resilient Framework (IRF) можно построить сетевую фабрику из 9 коммутаторов посредством объединения до 1024 портов 10GbE. Для централизованного управления всей фабрикой (как большим виртуальным коммутатором) HP предлагает графическую утилиту Intelligent Management Center (IMC). Стоит сказать, что в данной серии отсутствует поддержка интерфейсов 40Gbps QSFP.

E. Коммутаторы Huawei S6700 по заявленному функционалу тоже имеет расширенный L2-функционал и поддержку протоколов OSPF, BGP, IS-IS. Используя технологию iStack можно сформировать стек посредством объединения портов 10GbE. Плат расширения для данной серии не предусмотрено.

Нельзя однозначно сказать, что победитель один. Хотя в результате сравнения первое место можно отдать коммутатору Dell Power Connect 8132F за наиболее максимальный функционал, низкую цену, большой набор дополнительных функций, но нельзя забывать, что в конечном итоге все может измениться и идеальным вариантом может любой из выше сравниваемых моделей из-за следующих критериев:

• Задачи

• Количество требуемых коммутаторов

• Необходимая пропускная способность

• Возможность создания стека

• Допустимая производительность

Для подбора сетевого оборудования обратитесь к нашему инженеру Хисматуллину Вадиму. Он подберет наиболее оптимальный вариант оборудования в соответствии с вашими задачами и возможностями.