После официального ввода в эксплуатацию ЦОДа «DataPro Тверь» его посетили гости — представители делового сообщества Твери, Санкт-Петербурга и Москвы, чтобы более детально познакомиться с объектом. Повышенный интерес к ЦОД вызвал стремительный выход компании DataPro на рынок дата-центров России, успешная реализация проекта, вписавшегося в заданные сроки и бюджет, а также уникальные инженерные решения, которые применены на этом объекте.

Дата-центр «DataPro Тверь» получил сертификат Uptime Institute уровня отказоустойчивости Tier III в категории Design. В ближайшее время планируется получение сертификата на сам объект строительства (Tier III Facility).

«DataPro Тверь» — это пример хорошо управляемого проекта, продуманного дизайна…

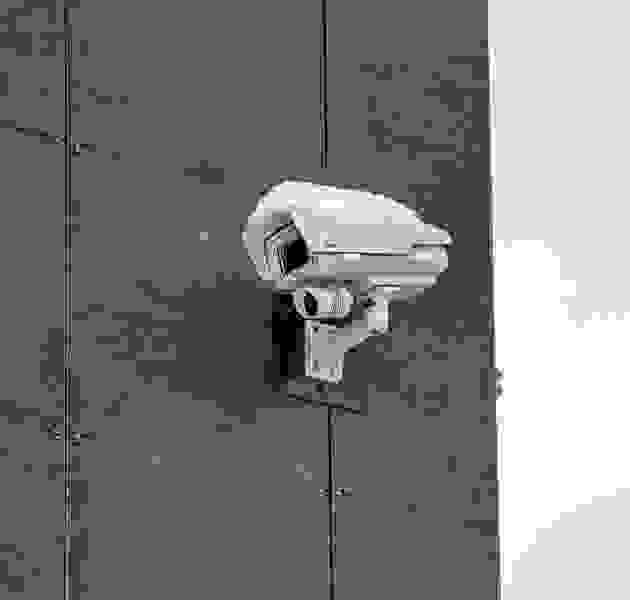

… а также хорошо охраняемого предприятия. В комплексную систему безопасности здания входят круглосуточный пост охраны, функции которого дополняет внешний и внутренний контур системы видеонаблюдения, а также СКУД с биометрическими терминалами. Благодаря этим мерам объект представляет собой неприступную крепость.

Доступ в ЦОД осуществляется с соблюдением всех строгих правил (в том числе с использованием биометрических терминалов), которые характерны для режимного объекта.

Для того чтобы сохранить в помещениях дата-центра идеальную чистоту, на входе гостям предлагают надеть традиционные бахилы или воспользоваться специальным аппаратом для надевания бахил.

Внешний фасад и полы внутри помещения облицованы качественной плиткой, рассчитанной на длительную эксплуатацию.

Подведенная к ЦОДу «DataPro Тверь» мощность составляет 4,5 МВт. Электропитание обеспечивают два независимых фидера от городских подстанций. Рабочая часть дата-центра состоит из четырех машинных залов, по 170 кв. м., в которых суммарно могут разместиться до 400 стоек. Общая площадь здания ЦОД «DataPro Тверь» — 2650 кв. м, фальшпола — 1000 кв. м.

Машинные залы полностью подготовлены для установки оборудования клиентов. Охлаждение организовано по принципу «горячих и холодных» коридоров.

В дата-центре установлено оборудование только от ведущих поставщиков. Все серверное и сетевое оборудование размещается в стандартных 19” запираемых шкафах APC by Schneider Electric.

Облачные сервисы реализованы на программно-аппратной платформе HP и VMware.

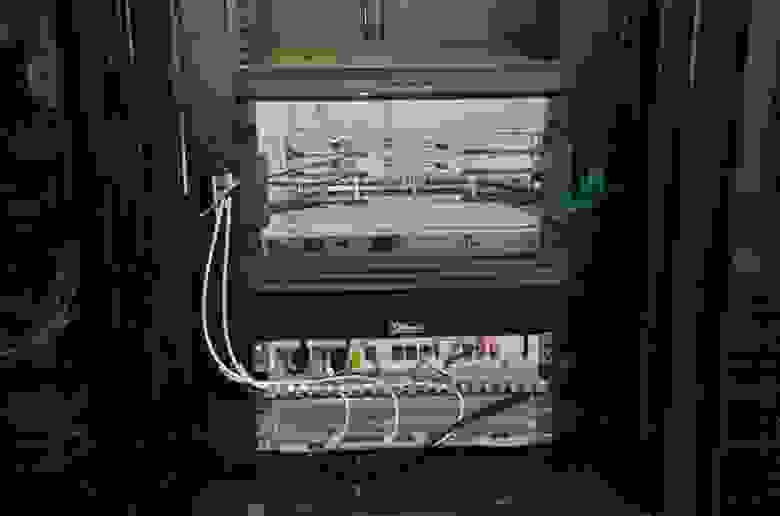

Для развертывания сети Ethernet в дата-центре инсталлирована структурированная кабельная система на базе пассивного сетевого оборудования TE Connectivity. Поставщиком активного сетевого оборудования стала компания Cisco Systems.

На первом этаже дата-центра расположены технические помещения, в которых установлены: главный распределительный щит (ГРЩ), кондиционеры, система адиабатического увлажнения, источники бесперебойного питания (ИБП) с батарейными полками.

В «DataPro Тверь» использованы эффективные и вместе с тем экономичные решения, которые со временем, возможно, возьмут на вооружение и другие проектировщики и строители ЦОДов. Инженерные решения реализованы таким образом, чтобы капиталовложения и мощность дата-центра можно было наращивать шаг за шагом.

К примеру, оригинально был решен вопрос с выбором схемы гарантированного электропитания нагрузки: реализована схема 3/2N («звезда»), которая успешно применяется во многих зарубежных ЦОДах.

Общее энергопотребление одного серверного помещения составляет 700 кВт. В каждом из трех помещений ИБП установлена группа из трех источников Galaxy 7000 производства Schneider Electric мощностью по 400 кВА. Каждая нагрузка в такой схеме подключена к двум активным входам. В число критичных нагрузок, также входит и система кондиционирования.

В нормальном, рабочем режиме все нагрузки защищены источниками бесперебойного питания. При пропадании одного из лучей работоспособность сохраняется: даже если произойдет авария на централизованной шине одной из групп ИБП, нагрузку подхватит от другого ввода соседняя группа ИБП. Количество ИБП в этой схеме меньше в сравнении со схемой 2N (3х400х4=4800), а следовательно, система дешевле: общая установленная мощность составляет 3600 кВА (3х400х3).

В таком варианте сохраняются все достоинства надежной схемы 2N. При этом ИБП загружены на 2/3 от номинала, а не на 50 %, как в схеме 2N. Поэтому и КПД выше, а счета за электричество меньше. Используемая на тверском объекте схема резервирования 3/2N впервые в России сертифицирована Uptime Institute.

Фотооэкскурсия в ЦОД «DataPro Тверь», Часть 2 — habrahabr.ru/company/datapro/blog/214495

Дата-центр «DataPro Тверь» получил сертификат Uptime Institute уровня отказоустойчивости Tier III в категории Design. В ближайшее время планируется получение сертификата на сам объект строительства (Tier III Facility).

«DataPro Тверь» — это пример хорошо управляемого проекта, продуманного дизайна…

… а также хорошо охраняемого предприятия. В комплексную систему безопасности здания входят круглосуточный пост охраны, функции которого дополняет внешний и внутренний контур системы видеонаблюдения, а также СКУД с биометрическими терминалами. Благодаря этим мерам объект представляет собой неприступную крепость.

Доступ в ЦОД осуществляется с соблюдением всех строгих правил (в том числе с использованием биометрических терминалов), которые характерны для режимного объекта.

Для того чтобы сохранить в помещениях дата-центра идеальную чистоту, на входе гостям предлагают надеть традиционные бахилы или воспользоваться специальным аппаратом для надевания бахил.

Внешний фасад и полы внутри помещения облицованы качественной плиткой, рассчитанной на длительную эксплуатацию.

Подведенная к ЦОДу «DataPro Тверь» мощность составляет 4,5 МВт. Электропитание обеспечивают два независимых фидера от городских подстанций. Рабочая часть дата-центра состоит из четырех машинных залов, по 170 кв. м., в которых суммарно могут разместиться до 400 стоек. Общая площадь здания ЦОД «DataPro Тверь» — 2650 кв. м, фальшпола — 1000 кв. м.

Машинные залы полностью подготовлены для установки оборудования клиентов. Охлаждение организовано по принципу «горячих и холодных» коридоров.

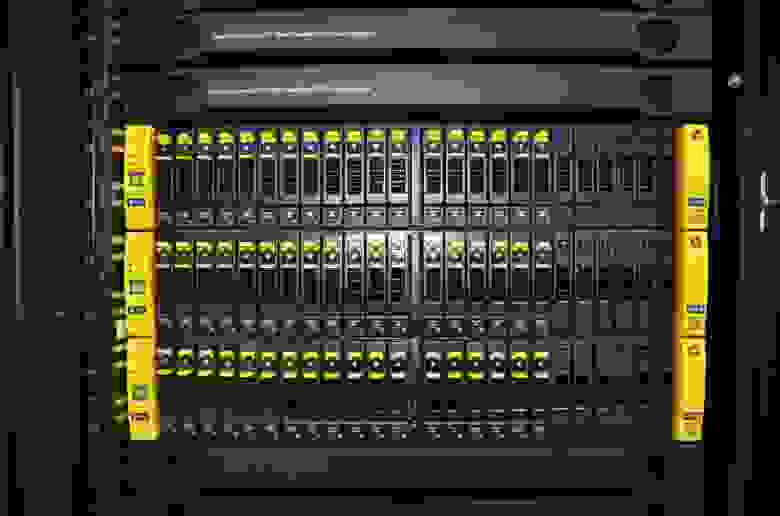

В дата-центре установлено оборудование только от ведущих поставщиков. Все серверное и сетевое оборудование размещается в стандартных 19” запираемых шкафах APC by Schneider Electric.

Облачные сервисы реализованы на программно-аппратной платформе HP и VMware.

Для развертывания сети Ethernet в дата-центре инсталлирована структурированная кабельная система на базе пассивного сетевого оборудования TE Connectivity. Поставщиком активного сетевого оборудования стала компания Cisco Systems.

На первом этаже дата-центра расположены технические помещения, в которых установлены: главный распределительный щит (ГРЩ), кондиционеры, система адиабатического увлажнения, источники бесперебойного питания (ИБП) с батарейными полками.

В «DataPro Тверь» использованы эффективные и вместе с тем экономичные решения, которые со временем, возможно, возьмут на вооружение и другие проектировщики и строители ЦОДов. Инженерные решения реализованы таким образом, чтобы капиталовложения и мощность дата-центра можно было наращивать шаг за шагом.

К примеру, оригинально был решен вопрос с выбором схемы гарантированного электропитания нагрузки: реализована схема 3/2N («звезда»), которая успешно применяется во многих зарубежных ЦОДах.

Общее энергопотребление одного серверного помещения составляет 700 кВт. В каждом из трех помещений ИБП установлена группа из трех источников Galaxy 7000 производства Schneider Electric мощностью по 400 кВА. Каждая нагрузка в такой схеме подключена к двум активным входам. В число критичных нагрузок, также входит и система кондиционирования.

В нормальном, рабочем режиме все нагрузки защищены источниками бесперебойного питания. При пропадании одного из лучей работоспособность сохраняется: даже если произойдет авария на централизованной шине одной из групп ИБП, нагрузку подхватит от другого ввода соседняя группа ИБП. Количество ИБП в этой схеме меньше в сравнении со схемой 2N (3х400х4=4800), а следовательно, система дешевле: общая установленная мощность составляет 3600 кВА (3х400х3).

В таком варианте сохраняются все достоинства надежной схемы 2N. При этом ИБП загружены на 2/3 от номинала, а не на 50 %, как в схеме 2N. Поэтому и КПД выше, а счета за электричество меньше. Используемая на тверском объекте схема резервирования 3/2N впервые в России сертифицирована Uptime Institute.

Фотооэкскурсия в ЦОД «DataPro Тверь», Часть 2 — habrahabr.ru/company/datapro/blog/214495