Comments 15

Когда два региона начинают сливаться, строится перегородка, чтобы предотвратить объединение областей

[...]

Получается, чтобы найти к какому из центров сгущения относится пиксель, надо шагать по градиенту для нахождения ближайшего локального максимума.

Будут ли различаться результаты этих двух методов, если применить их к одной и той же функции (например, в первом методе не строить перегородки, а идти по градиентам в сторону минимума)?

0

Результат работы MeanShift будет зависеть от выбранного радиуса сферы в пространстве признаков, так как при вычислении вектора среднего сдвига будут учитываться только те пиксели, которые попали в эту сферу. И в зависимости от выбранного радиуса может получится разное количество максимумов, соответственно число сегментов тоже будет меняться. Думаю на простых картинках результат получится одинаковым

0

Просто интересно, есть ли у вас алгоритмы которые смогут распознать одинаковые картинки (например контуры квадратов) разного размера как одно и тоже?

0

Хм, а разве для простых образов не отработает матчинг на основе Хью моментов?

0

первый раз слышу про такой метод, погуглил по запросу «Хью моменты computer vision», «hew moments computer vision», но описания контретного метода не встретил, не могли бы вы дать ссылку на статью про этот метод?

0

В документации к opencv есть описание того, как вычисляются такие моменты. На robocraft'е даже какие-то сэмплы есть.

+1

по идее такой метод должен неплохо распознавать текст в реальном времени, или для openCV это давно не проблема?

0

В contrib-расширениях к opencv есть модуль для работы с текстом, сам я его не пробовал, но вроде бы работает. Вот документация по нему.

0

Были на Хабре хорошие статьи от BigObfuscatorна эту тему, только, по-моему, он их поудалял зачем-то.

Оно работает, если у вас хорошая сегментация. Если нельзя грамотно сегментировать чистую фигуру символа, то нужно обучать ML алгоритмы. Собственно так гугл номера домов и ищет — habrahabr.ru/post/208330

А сожалению, в большинстве реальных применений (распознавание номеров, надписей) нереально корректно сегментировать буквы. Даже используя такие хитрые и сложные алгоритмы как описаны выше.

Чуть ниже приведён пример распознавания на базе Tesseract. Но там та же проблема. Если вы сегментировали — всё хорошо. Если нет, то тессеракт чушь выдаёт. К тому же, на мой вкус, куда проще нейронную сетку настроить, чем грамотно тессеракт сконфигурировать (у него в файле конфигурации где-то 400 малодокументированных параметров, не считая того, что под каждый шрифт обучать нужно).

Оно работает, если у вас хорошая сегментация. Если нельзя грамотно сегментировать чистую фигуру символа, то нужно обучать ML алгоритмы. Собственно так гугл номера домов и ищет — habrahabr.ru/post/208330

А сожалению, в большинстве реальных применений (распознавание номеров, надписей) нереально корректно сегментировать буквы. Даже используя такие хитрые и сложные алгоритмы как описаны выше.

Чуть ниже приведён пример распознавания на базе Tesseract. Но там та же проблема. Если вы сегментировали — всё хорошо. Если нет, то тессеракт чушь выдаёт. К тому же, на мой вкус, куда проще нейронную сетку настроить, чем грамотно тессеракт сконфигурировать (у него в файле конфигурации где-то 400 малодокументированных параметров, не считая того, что под каждый шрифт обучать нужно).

0

а в с помощью чего построено это изображение: https://habrastorage.org/files/215/c91/1a0/215c911a0f5149aa801ff6c277b68d41.jpg?

0

с помощью Mathematica

0

Спасибо за статью, могу еще подкинуть на эту тему статьи:

Region Adjacency Graphs Introduction RAG

Normalized Cuts on Region Adjacency Graphs NCUT

Насколько я понял, автор взял SLIC (Simple Linear Iterative Clustering) и улучшил его, избавив от пересегментации:

Region Adjacency Graphs Introduction RAG

Normalized Cuts on Region Adjacency Graphs NCUT

Насколько я понял, автор взял SLIC (Simple Linear Iterative Clustering) и улучшил его, избавив от пересегментации:

картинки

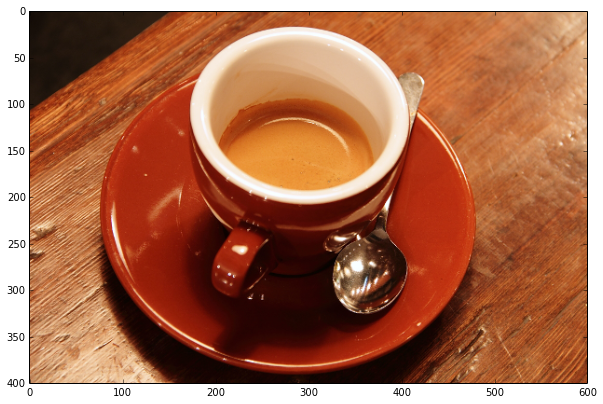

Original

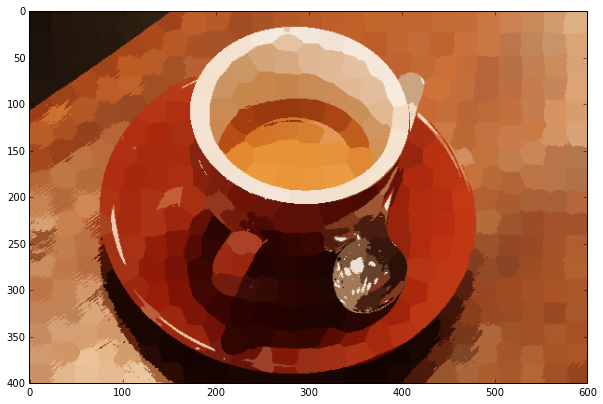

SLIC

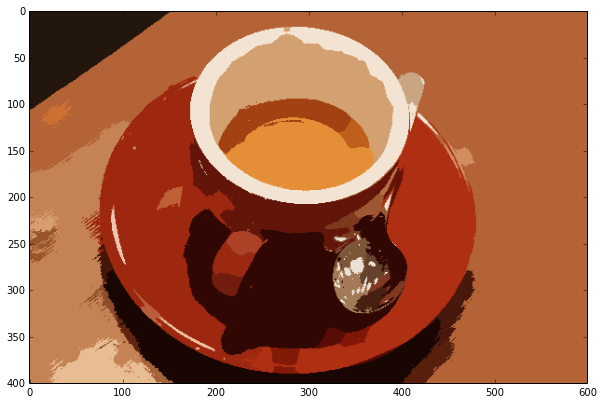

NCUT

SLIC

NCUT

+1

Огромное спасибо за статью и особенно за примеры кода! Как-раз сейчас работаю с OpenCV над изображениями.

0

Немного тяжелой артиллерии:

www.robots.ox.ac.uk/~szheng/crfasrnndemo

www.robots.ox.ac.uk/~szheng/crfasrnndemo

+1

Sign up to leave a comment.

Обзор алгоритмов сегментации