Comments 53

Поставил упомянутый ниже MP500 в рабочий ноутбук и теперь жалею — ниже 70 температура накопителя не падает практически никогда. Интенсивная запись/чтение почти мгновенно разогревают до 80 и выше.

Хотелось бы знать о таких сюрпризах заранее.

* настоящий — использующий синхронные записи с fsync или его аналогом.

А ещё ВСЕ ssd (включая ваш любимый hellfire) сосут страшно на пиковых latency. Они ведут себя хуже, чем какой-нибудь WD Green, демонстрируя десятки секунд задержки. И это не производитель плохой, это технология плохая.

Насколько я понимаю, у оптанов такой проблемы нет.

А можете написать реальный сценарий, когда можно увидеть такие значения (не 10, хотя бы 1-2с)? При испольховании каких программ? У меня к примеру в основном СУБД...

Любые критичные операции на файловой системе. Обновления ОС, установка ПО, транзакции в любую базу данных (почтовый клиент, браузер и т.д.). Если в этот момент диск решает, что ВАС ТУТ МНОГО А Я ОДНА, то соответствующее ПО застревает на операции на указанное время. Выглядит это как случайное подлагивание. Если у вас 1 из 10000 запросов так застревает, то это означает, что ваш компьютер ИНОГДА (достаточно иногда, чтобы вы этому никому не могли доказать) замирает без видимых причин в случайном месте.

В серверных же СУБД, это будет кусать постоянно. 99.9% запросов будет обслуживаться за 200мс, а вот оставшиеся 0.05% будут куковать десятками секунд или даже получать таймауты.

Как такое проверять? В линуксах — сделать файловую систему на устройство и запустить вот такой fio:

fio --name `hostname` --blocksize=4k --ioengine=libaio --iodepth=1 --direct=1 --buffered=0 --fsync=1 --rw=randwrite --filename=/mnt/something/bench --size 100GТест должен быть достаточно большим (size), чтобы занимать хотя бы 70% устройства, и достаточно долгим, т.к. у многих вендоров толстенные кеши, которые способны пережить первые пол-часа-час теста.

При iodepth=1 никаких разговоров про очередь быть не может, зато может быть вот такое:

Samsung MZ7LM480HCHP-00003: max = 84999 ms

INTEL DC S3610: max= 17922 ms

KINGSTON SEDC1000H800G (nvme): max = 8379 ms

Так что когда герои десктопов, увидевшие гигаиопсы в кеш считают, что ничего слаще нет, у меня есть для них плохая новость.

(более того, оно кусает даже чтение, до 300мс в пике, что вообще смертельный позор, я считаю).

И это (в меньшем масштабе) — общая проблема любых SSD. Так что я от оптанов ожидаю решения именно этой проблемы. Сам их я ещё не щупал, только ожидаю.

Ключевая проблема тут — в тормознутости flash-памяти.

В результате удалив крупный файл (после чего ОС автоматом пошлет контроллеру диска TRIM со списком освободившихся секторов) многие контроллеры можно почти полностью «повесить» на секунды-десятки секунд прежде чем они обработают следующие стоящие в очереди операции — пока он будет очищать не только очередной блок флэша (реально нужный в данный момент для записи), а вообще весь объем удаленного файла, скажем гигабайт 10-20 за раз.

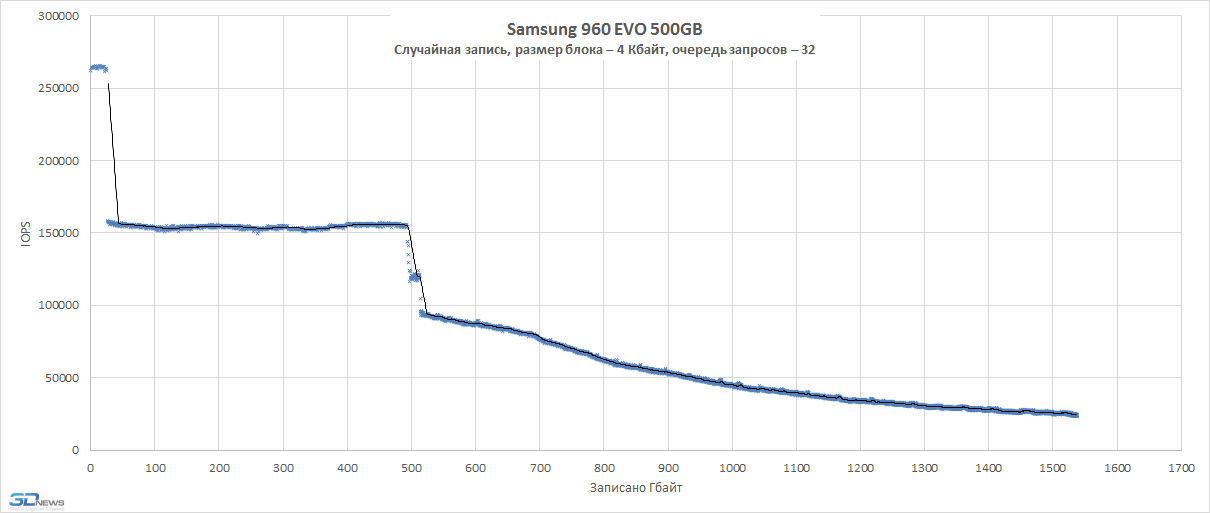

Хорошие контроллеры подобным маразмом не страдают и приоритеты расставляют правильно: в первую очередь — обработка запросов хоста, а все обслуживание идет в фоне, когда есть ресурсы или непосредственно перед записью но в минимально необходимом объеме (а все остальное так же откладывается «на потом» — когда будут свободные ресурсы). И как результат на них подобных аномальных задержек не возникает. Вот для примера непрерывная перезапись нескольких полных объемов диска на хорошем контроллере:

При таком объеме непрерывной записи никаких заранее подготовленных резервов и кэшей не хватает, под конец идет уже запись прямо в неподготовленный флэш с его затиранием «на лету», а не заранее. По ступенькам на графике это хорошо видно — 1 короткая полочка — это отрабатывают DRAM и SLC кэши, 2я длинная полка в объеме примерно равной общему объему накопителя — запись в «свежий» (заранее подготовленный) флэш, а дальше — «работа с колес», без предварительной подготовки, с перемещением данных и затиранием блоков непосредственно перед каждой очередной операцией записи.

Настоящий бенчмарк — это реальные сценарии работы.

У ссд на нанде проблемы только с записью поверх только что стертых данных. так что если я свой хелик форматну и пару часиков он постоит в компьютере с виндой включенный то я смогу его перепрошить всеми 240 гигами данных без запинки. рим свою черную работу сделает. но если стереть диск удалением виндовым и сразу же попытаться в него писать — естественно вы будете по 100 мсек ждать пока сотрутся 8 чипов nand памяти одновременно т.к. только что свободных чипов с подготовленными стертыми страницами небыло. но это крайне маловероятный сценарий работы обычной домашней станции, средства разработки программ и даже видеомонтажа. я например всем этим занимаюсь на компьютере с 3 тб сигейтом (выдает 300 мб/с чтения) и двумя ссд — один на 512 сата3 а второй системный хелик на 240 гб. там система и часть легковесных временных файлов. ни разу ни сталкивался с проблемой того что мне было некуда писать. занято у меня на хеле примерно 70 гиг. остальное свободно и это его спасительный плот. когда я много хочу писать — у меня есть 120 гиг чистого пространства. отдельный медленный ссд я храню для оперативных временных выходных файлов. стираю я его форматированием. так он делает сразу всем чипам всем страницам трим занимает 20 секунд и у меня снова 512 гиг с записью 480 мб/с есть. если надо больше — есть винт сигейт — пишет он 260 мб/с зато по меркам ссд — безлимитный по ёмкости.

оптан не пробовал у меня увы чипсет z170 а оптан вышел на месяц позже(сволочи) но менять проц мамку память ради оптана с заявленными(заметьте не протестированными в реальных тестах а заявленными) 700 метров в секунду записи — о чем можно ещё говорить? Я лично надеялся что будет лимит перезаписи в районе 10-15 петабайт но нет — все как у обычных nand накопителей… не понятно в чем преимущества.

Раскажите мне пожалуйста о них. и чтоб вы не думали что я мало пишу я покажу вам скрин моего вспомогательного ssd

www.dropbox.com/s/ttp09wwrzuwnsd9/%D0%A1%D0%BD%D0%B8%D0%BC%D0%BE%D0%BA%20%D1%8D%D0%BA%D1%80%D0%B0%D0%BD%D0%B0%20%281%29.png?dl=0

этому накопителю уже третий год пошел. как видите записано на него «рекордные» 40 терабайт. в пересчете на запись в день выходит всего 40 гигов в день. никаких проблем сожрать 40 гиг данных в день ни у одного ссд не будет. хоть единоразово хоть зазбито по кускам на весь день.

хелфайрик то вообще намного проще себя чувствует

www.dropbox.com/s/nrtpm3kvquxkzvq/%D0%A1%D0%BD%D0%B8%D0%BC%D0%BE%D0%BA%20%D1%8D%D0%BA%D1%80%D0%B0%D0%BD%D0%B0%20%281%29.png?dl=0

всего реальных 3 гига за почти год с момента приобретения.

ну и о тестах:

www.dropbox.com/s/ug2nsmricmpwp4g/%D0%A1%D0%BA%D1%80%D0%B8%D0%BD%D1%88%D0%BE%D1%82%202018-03-15%2016.01.46.png?dl=0

Во всех этих тестах (на картинках у вас) вы бенчмаркаете write-back кеш устройства. Это быстро и замечательно, и если там кондёр, то с этим можно жить.

Но если говорить про устоявшуюся производительность — нет. Я только что описал как это выглядит. Моменты, когда не должно тормозить, но тормозит.

кеш работает когда чистых страниц для моментальной записи на флешку уже нет. кэш вообще по другому работает и его мало. не 240 гиг увы. с обычными ссд типа эво там да там печаль после примерно 20 гиг записанного скорость падает до 200 мб/с это да. но это не касается хелфайра

Реальная тяжёлая нагрузка для SSD — непрерывное рандомное IO мелкими блоками с требованием persistent storge (т.е. запретом на использование writeback, а точнее, с требованием FLUSH). Такие операции требуют от SSD постоянно осуществлять переупорядочивание блоков, их чтение и т.д.

Если бы всё, что нужно было бы компьютерам, это линейная запись, то мы бы спокойно жили с жёсткими дисками (которые делают 150-200Мб/с без особых проблем).

Кроме того, я вам говорю про max latency, а вы мне в ответ — про поток данных в секунду.

Ближайшим аналогом будет очередь в супермаркете.

— Клиент А: я на кассе 40 минут ждал.

— Директор Б: У нас пропускная способность 20000 человек в час!

Каким образом клиенту А станет легче от того, что директор Б поднимет пропускную способность до 30000 человек в час, если в очереди надо будет ждать не 40 минут, а 50?

второе — нахрена такие частые флуши на винт если есть 64-128 гиг озу и отказоустойчивое питание? расскажите как раньше на винтах серверы работали а сичас на ссд даже консюмери внезапно зачали по 80 секунд тормозить? вы о чем? или раньше небыло серверов?

Хотите флушить 100500 раз в секунду все 240 гиг — пажалста купили 128 гиг оперативки ддр4 и вперед.

Я говорю что именно в хелфайре очень много самостоятельных флешек. 64 помоему. и потому у него операции стирания записи хорошо паралелятся… ну а переорганизация блоков рандомами конечно это беда если занято больше половины винта но так извините меня это я и сказал — панацея — взять ссд не в 90% требуемого места а 25% и тогда и с этим не будет никаких проблем. остальное компенсировать кэшем в оперативке. всеравно обьясните мне причем тут оптан если у него все те же проблемы + низкая пиковая пропускная способность шины контроллера? 3200 хелфайровских это ж почти потолок для 4х линий пцие(3900 помоему там теоретический предел) а у оптана всего 600? это что такое? вы о чем? Вы нашли где какое-то конкретное железо тормозит и кричите об этом? нормальные люди ищут сильные стороны железа и эксплуатируют их а слабые места обходят 10-й дорогой… но если цель обосрать нанд и продать оптан то конечно же да так делать можно… но только мы-то понимаем — чушь это все. ничего оптан за свои деньги не дает! ни скорости ни надежности ни долговечности ни ёмкости. так о чем разговор?

Я объяснил как устроена сегодняшняя ситация с SSD — они быстры 99.99% времени, а оставшееся — как получится, включая задержки больше, чем были на HDD. Остальное — ну, уверены, что ничего слаще консьюмерской SSD нет, так всё же замечально!

Я не поддерживаю оптаны, я их ни разу не щупал, но планирую. В этой ветке я описал что я ожидаю от оптанов (снижение max latency), и что очень плохо в текущей ситуации по индустрии с SSD.

Потом резко понадобятся.

и вот www.storagereview.com/intel_optane_800p_nvme_ssd_review

А 850 evo — ну у меня стоит в ноутбуке. хороший дешевый ssd. Но, изивините, 10к операций там не бывает в реальной жизни. Я не в курсе как получить QD64 для ее 300к, даже на тестах серверных так не получается.

я тестировал nvme корпоративного класа и 375gb optane, на softlayer. Разница прыгает от 5 до 10 раз для mysql для моей конкретной нагрузки.

Любой Optane заработает на любой системе с поддержкой NVME. Хотите вставить в AMD ZEN кеширующий оптан на 16-32 гига? Без проблем — система просто увидит его как ссд. Не нужен ссд, а нужен кеш — Primo Cache и прочие к Вашим услугам.

Так что не пугайтесь — Ваш Z170 подойдёт — только вот DMI — четыре линии pci express на все накопители и периферию, у ryzen хоть 4 дополнительные прямо в процессор есть.

Автоматическое кэширование данных с HDD (как в Optane Memory) могло бы стать такой фишкой. То есть система и всё что пользователь сам пожелал хранится на быстром SSD, а то, с чем он периодически работает и обычно хранится на HDD (например, вернулся к проекту энной давности) при необходимости «кэшируется» на SSD без участия юзера и апдейтится на HDD при завершениии работы. Таким образом мы имеем и экстремально-быструю загрузку всех приложений (плюс PCI-E SSD) и быструю работу со всей актуальной на данный момент информацией (плюс обычного SSD) и имеем большой объём хранилища занедорого (плюс HDD), и лишний бэкап последних открытых файлов.

При этом HDD при неактивности можно останавливать — раскручивать только перед выключением для бэкапа.

Т.е. есть прирост в производительности, но замечу ли я разницу?

Потому что разницу в 120 гб и 250 гб я точно замечу под систему, т.к. для бекапов места будет мало?

В основном это даёт существенный выигрыш на операциях с мелкими блоками в 1 поток.

При куче потоков или линейных операциях разницы конечно не заметить.

По моим представлениям — это типичная нагрузка в играх, при подгрузке ресурсов.

Другой вопрос — будет ли заметный эффект, т.к. современный SSD + RAM Cache итак неплохо справляются.

Не зря оптан позиционирют в первую очередь для корпоративного сегмента — различные бигдаты просто тащутся от оптана.

Сам обладаю и хочу понять, надо ли думать на счет более быстрых ssd.

Я на глаз не заметил разницы после установки 960 evo.

Это же не значит, что во всех оптанах стоит один и тот же 128 гиговый чип, программно ограниченный?

Широкий замах, но стыдный бросок.

Большей версии пока нету.

При цене в 2раза меньше наделал бы шороху на рынке.

В связи с этим вопрос: будет ли в дальнейшем выпущено продолжение линейки 800p с улучшенными характеристиками? На данный момент преимуществ у этого товара я не вижу, но при улучшении ситуации в будущем так же буду рассматривать вариант покупки. Мне представляется большая перспектива у этого типа памяти.

Intel Optane 800p — SSD под систему