Comments 110

Я правильно понимаю заголовок, что в каждом айфоне сегодня автолидары по 75к?

Кручу в руках свой аппарат (и это не 12про) — нет, не появился!

Тем более, если посмотреть на заголовок переводимого оригинала: «Lidar used to cost $75,000—here’s how Apple brought it to the iPhone».

Так вы бы и написали мне?

Считаю, что неудачный перевод (как и слабый пост, если это пост в корпблоге), стоит обсуждать вслух: это и другим поможет писать лучшие материалы, и автору дает возможность как-то участвовать в обсуждении. Личка хороша для опечаток, а здесь далеко не тот случай, здесь просто перевод «по мотивам» с осознанным отходом от оригинала.

Это же не какая-то интернет газетенка, а около-технический блог.

Редакторы Хабра задают тон, а компании его подхватывают.

Может хватит это терпеть и затыкать всем рот?

Это же не какая-то интернет газетенка, а около-технический блог.

Хабр, как кажется нам с вами — это мы. Но: и вы, и я ходим на Хабр, и читаем, и не ставим минусы «редакторам», а втягиваемся в обсуждение всякого и каждого желтого заголовка, создавая этим постам просмотры, а кто-то и плюсы ставит. Получается, про газетенку зря вы отпираетесь, мы все «играем короля» именно так.

Ну а владельцам — бабло капает, чего там.

Может хватит это терпеть и затыкать всем рот?

Как же тогда повесточку продвигать?

Без анонимных минусов тема 666 гендеров не взлетит.

Как в FaceID, только с большим разрешением.

Это совсем разные вещи как по цене, так и по назначению. Ничего кардинально нового Apple тут не ввела.

Как это не ввели?

А как же новый тренд в мобильных устройствах?

sarcasm

Теперь смартфон без лидара и не смартфон вовсе.

написано Технология LiDAR

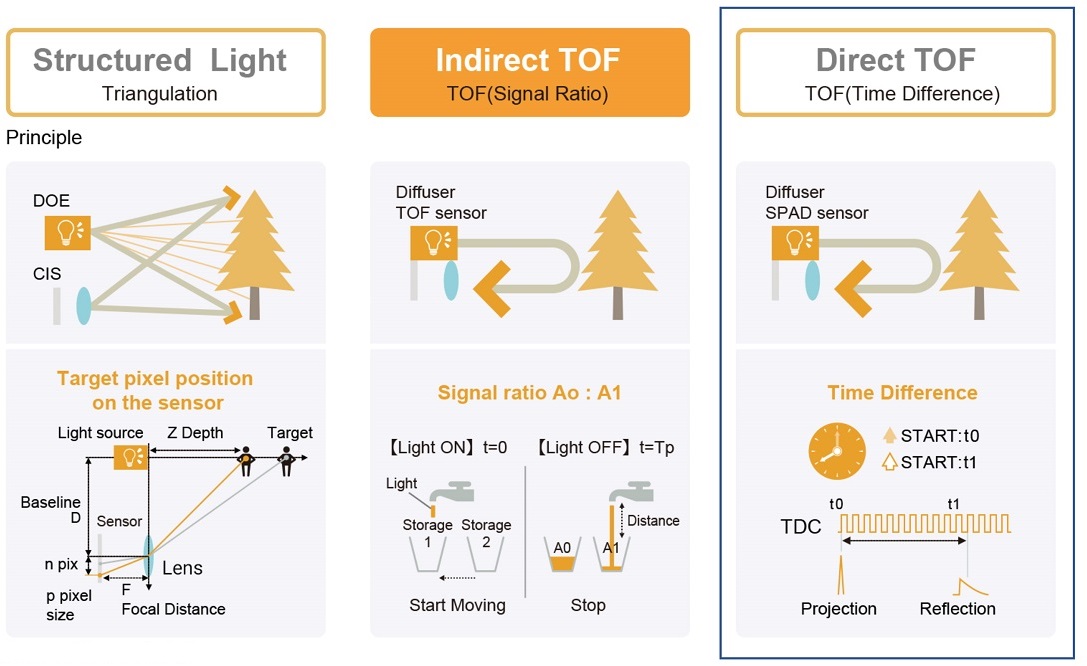

ToF это способ измерения, а не технология, любой несканирующий лидар использует ToF по определению, так что это не могут быть "разные вещи".

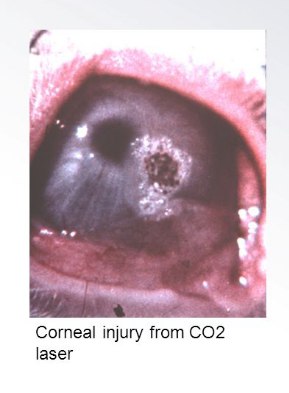

Вот интересно: насколько этот лазерный свет безопасен для сетчатки глаз?

Опасность может представлять мощность излучения, но она естественно на безопасном уровне.

arstechnica.com/cars/2019/01/man-says-ces-lidars-laser-was-so-powerful-it-wrecked-his-1998-camera

По ссылке

Cameras are up to 1000x more sensitive to lasers than eyeballs

Хм, из опыта с лазерами, помню, что хрусталик и роговица неплохо задерживают УФ, а ИК вроде бы проходит без проблем. И опасность ИК лазеров как раз в том, что излучение не видно глазу, то есть не срабатывает моргательный рефлекс, из-за чего возможны серьезные повреждения

Не знаю насчёт ИК, но получить повреждения сетчатки от УФ — проще простого. Снежная слепота, "зайчики", которые ловят сварщики без маски — это именно УФ.

Это где-то 1500 и выше, диапазон IR-B.

А как они планируют решать следующие проблемы:

- Работа в туман.

- Работа в снег и дождь

- Работа сотен лидаров в одном месте (в пробке)

Проблему множества лидаров частично можно решить: разными длинами волн (но выбор все-таки не велик, специфические лазеры дóроги); разной поляризаций (но поляризация порой может вращаться); и отловом коллизий импульсного сканирования (чтобы не принимать чужие импульсы за собственные с возникновением ошибки мнимого уменьшения дистанции — ложные данные опаснее отсутствующих).

Допустим, будет протокол, согласно которому предваряя сканирующий лидарный импульс излучается не используемый для сканирования, более длинный импульс-метка с данными (скорее всего мы не сможем передавать идентификационные данные в составе сканирующего импульса). Если система фиксирует чужой импульс-метку в пределах временного окна выполнения собственного сканирования, то данные отбрасываются, операция повторяется.

Причем, учитывая идентичность систем и хорошую стабильность частоты, время синхронного совпадения может быть продолжительное. Ошибка станет не просто дефектом, а ложным досрочным срабатыванием. Получим полноценную информацию о внезапно возникшем близком препятствии.

Различная частота опроса устранит синхронность совпадения, но резко повысит шанс разовых коллизий. Впрочем, наверное это хорошее решение.

Даже для устройств смотрящих на >500м время «экспозиции» после одного пульса — меньше 2 микросекунд. Достаточно добавить произвольную задержку перед началом каждого пульса с максимальной величиной больше оной «экспозиции» полностью уберет вероятность систематических помех от одиночными однотипными устройствами. Для расстояний ближе 100м, где это действительно критично, время экспозиции и вовсе меньше 500нс, кроме легкой просадки фреймрейта особого негатива не будет.

Во-вторых на обработке обычное отражение очень сильно отличается от «ослепления» чужим источником и легко выфильтровывается. Получается некоторая «слепая зона» на расстоянии до чужого источника, но из-за динамического характера сцены это тоже быстро устраняется и фильтруется.

2. п.1

3. «Маршрут перестроен, вы будете ехать вот этими зигзагами и поворотами, с периодической остановкой на несколько минут, что бы не создать пробку на развязке»

Производительность лидаров от Apple намного ниже, чем у топовых датчиков, производимых компаниями, специализирующимися на лидарах. Velodyne, компания выпустившая первый трехмерный лидар, утверждает, что их датчик может работать с дальностью в 200 метров, в то время как датчик от Apple работает с дальностью 5 метров.Такое впечатление, что автор пытается занизить достижение Apple. А по мне, исходя из физики, всё наоборот. Тот, кто оперирует дальностью порядка сотен метров, должен измерять запаздывание порядка наносекунд, что в общем-то не так уж сложно. А для измерителей единиц метров придётся точно измерять запаздывание в пикосекунды. Верно ли моё почерпнутое из курса вузовской физики представление, что второе гораздо сложнее? Я даже не понимаю, как в цифровом аппарате, работающем на предельно достижимых нынче частотах в гигагерцы (т.е. с характерными временами в наносекунды) удаётся точно измерять время на три порядка короче. Это какая-то технологическая магия, не иначе.

Верно ли моё почерпнутое из курса вузовской физики представление, что второе гораздо сложнее?

Скорее всего, там просто другой способ. Если отражаемый объект относительно недалеко и неподвижен, можно сделать так: лазер модулируется какой-то определённой длиной волны, и сравнивается фаза сигнала на лазерном диоде и на фотоприёмнике. Зная длину волны и разницу фаз, можно высчитать и расстояние.

В позиционировании внутри зданий по схеме TDoA (разница времени прибытия сигнала) приходится решать еще более сложные задачи — вроде синхронизации времени до пикосекунды на разнесенных в пространстве приемниках — и ничего, те же BLE и UWB-системы вполне работают.

Там единичный дальномер, а не массив оных.

Если кому интересно, у меня есть статья про такие лазерные рулетки: habr.com/ru/post/327642

Для коротких расстояний основной упор приходится делать на точность измерения времени( отклонение «часов») и подавление шума от своих собственных триггеров и начала эмиссии. Зато объекты близко и обычно дают достаточно интенсивный сигнал, потому можно намного меньше загоняться с SNR. И мерять такие системы должны обычно от 5 — 10см с точностью не ниже сантиметра.

При работе на сотни метров допустимая абсолютная точность может быть на уровне 15 — 20 см, близкое расстояние часто тоже обрезается. Зато в общем сигнале приходится выискивать те несколько фотонов, что вернулись вот от того куска угля за 200 метров от нас. Не самое тривиальное занятие.

Вообще же, для достижения нужных параметров приходится измерять сигнал на частотах от 1 до 5 ГГц. Строить хорошую PLL на такое дорого и сложно, поэтому, например, могут использоватся множественные сэмплеры, где разница во времени срабатывания достигается задержкой прохождения сигнала от оного источника.

Если использовать синхронный усилитель на приемнике, то на SNR можно вообще не смотреть (использование такой схемы позволяет провести измерения в условиях, когда на входе шум на порядки сильнее полезного сигнала)

для метода измерения с синхронным усилителем достаточно стабильности частоты, а в измерении лидаром частота модуляции светового потока излучаемого сигнала стабильна и известна, но неизвестна фаза отраженного сигнала, которая по сути и есть задержка сигнала, и, чтобы найти ее, двумя ключами (работающими с задержкой pi/2, за это время отраженный сигнал гарантированно придет хотя бы на один из ключей) и двумя интеграторами ищем амплитуды U_0 и U_pi/2, арктангенс отношения которых и даст сдвиг фазы принятого сигнала относительно излученного.

Я могу ошибаться, но кажется именно лазерные "дальномеры" стояли в телефонах LG лет десять назад.

Например.

Да вроде там нормальная развертка была. Я никак не хочу "унизить" Apple, возможно у них лидар полноценный, как 3Д сканнер. Но технологии то уже сто лет в обед...

Да бог с ней, с Apple. Пусть пиписьками меряются с кем хотят. Но это не отменяет факта того, что лидар был уже давным-давно установлен на телефон. И это не "прорыв", а просто "установка лидара".

Облако точек объекта, освещённого несколькими ToF-лидарами, начнёт серьёзно «расплываться».

Для телефона такое ещё может прокатить (особой опасности нет, если картинка получится не особо чёткой), а вот для автомобилей — там уже нужны дублирующие решения

Обзор LG G4: камера с лазерным прицелом

А это не то же самое но 5 лет назад?

получится ли модулировать частотой чтобы решить проблему взаимных помех если измеряется фаза? мне кажется нет, хотя я не физик

Промышленные лидары очень точные: riftek.com/ru/products/~show/sensors/2D-scanners (мэйд ин Белоруссия)

Для автомобилей миллиметры точности неважны, важна скорость измерения, расстояние и цена.

А для айфонов лидар вообще нужен???

Для AR может помочь в экономии ресурсов на обработку плоской картинки с камеры. Хотя, как я понял, это надо чтобы строить более честное боке и иметь более точный фокус на объекте. Но уверен что найдутся умельцы которые сделают приложение для сканирование объектов для последующей 3D печати :)

Уже есть вот такое:

https://play.google.com/store/apps/details?id=com.lvonasek.tofviewer

https://play.google.com/store/apps/details?id=com.lvonasek.arcore3dscannerpro

Для мелких объектов ToF сенсор не подойдет, насколько я понимаю.

Теперь обладатели айфонов с лидарами легко смогут найти чёрную кошку в темной комнате.

Цитата из прошлого: "мы говорим партия — подразумеваем Ленин. Мы говорим Ленин — подразумеваем партия".

И так было 70 лет. Говорили одно — подразумевали другое.

По теме: "Лида́р (транслитерация LIDAR англ. Light Detection and Ranging «обнаружение и определение дальности с помощью света») "

В телефоне — дальномер (лазерный). В машине — построитель окружения (почти объёмнный).

Божий дар и яичница. Найдите десять отличий.....

Там не дальномер, или такие фишки можно и на дальномере вытворять? — https://apps.apple.com/us/app/3d-scanner-app/id1419913995

По поводу аварий Тесла. Это связано с тем, что они в основном используют камеры с машинным обучением для координации в пространстве?

А чем лидар отличается от радара?

Да всем, в общем-то, только назначение частично пересекается. Радар — средство для обнаружения объектов с помощью отражённых/излучённых ими радиоволн (посему объекты должны уметь эти волны отражать или излучать), и могут находиться на любом доступном для радиоволн удалении, лидар — лазерный дальномер, или в более продвинутом варианте, сканирующий лазерный дальномер. Предназначен для определения расстояния до объектов в пределах прямой видимости.

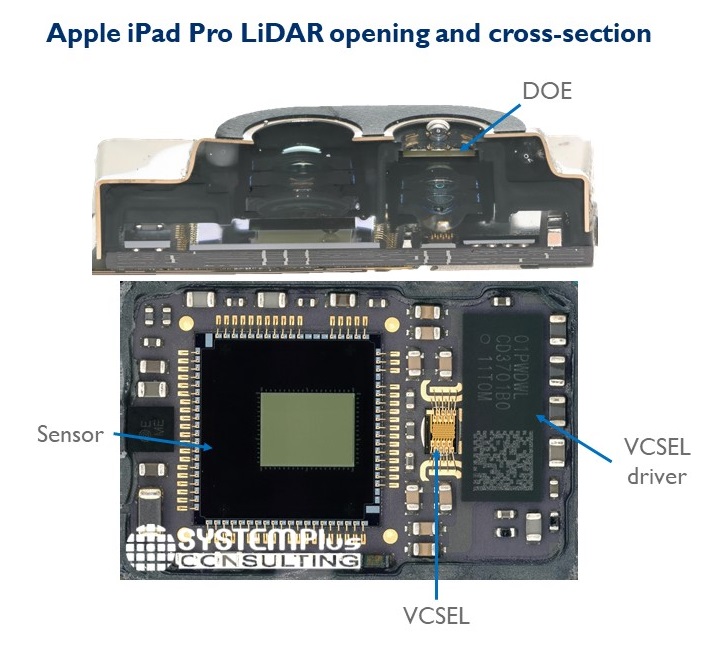

Или все же там используется некая развертка, когда одновременно работает один (или несколько) лазер. Тогда не ясно к чему «тысячи однофотонных диодов» ведь тогда по идее хватит одного (нескольких).

Один нужно как‐то перенацеливать. Перед массивом можно поставить оптику так, чтобы разные лазеры в результате стреляли в разные стороны. Второе работает намного быстрее и меньше изнашивается.

VCSEL состоит из большого количества вертикальных «каналов», через которые уходят фотоны. Каждый канал дает не полностью колимированный луч, но очень узкий пучек. Чтобы этим набором «точек» покрыть целевой сектор обзора перед диодом ставится оптика, проецирующая лучи как надо.

На стороне приемника почти обычная матрица, как в любой камере. Чем больше «пикселей» — тем выше разрешение с которым мы воспримем окружение.

Спасибо, то есть если более по простому. Лазер у на как-бы один, но проэцирующий некое облако точек (если сильно утрировать, это как фонариком через дуршлаг посветить). Так что можно считать что все лучи стартуют одновременно. А диоды типа как камера, но ловят не просто картинку, а время прибытия каждой точки облака.

Действительно элегантное решение.

А зачем там 3D? Оно же по плоскости катается.

Там скорее 2.5D нужно, чтобы оценить высоту препятствий на границах робота, когда к ним вплотную подъезжает. С этим вполне справится 1D-матрица с прецессией оси вращения

1.Определить высоту препятствия на предмет «заехать под», желательно с некоторого расстояния, чтоб спланировать траекторию.

2. Детекция мелких обьектов перед роботом, особенно висящих проводов, чтоб, например, телефон со стола не стягивать.

3. Детекция высоты низкого препятствия, порога, чтоб понять может ли робот через него переехать. Например особая гордост Электролюксов — способность опознать и переехать 3см порог.

4. Детекция пола перед роботом. Во-первых чтоб выбросить clif sensor(ступеньки), во-вторых чтоб определять края ковра. Ну и совсем в идеале — опознавать лежащие провода.

Для всех этих функций одним сенсором вертикальное поле зрение должно быть градусов 30 как минимум, я предлагал систему на 60-70. Прецессией оси вращения столько не наберешь.

А solid state LiDAR и ToF-камеры — это одно и то же или там разные принципы?

Пока пытался найти информацию, нашел это видео:

Here is iPad Pro’s LiDAR under infrared. pic.twitter.com/IZkum3nwRx

— Faruk ᴵᴾᴴᴼᴺᴱᴰᴼ (@iPhonedo) March 26, 2020

Выглядит похоже на structured light (aka первый Kinect и подобные).

«Еще больше усложняет ситуацию тот факт, что технология ToF теперь представлена в двух вариантах: iToF и dToF. iToF измеряет фазовый сдвиг, а dToF – непосредственное время полета.»

— Ковыряемся в лидаре iPad 11 Pro

«Внутрипиксельное соединение» — важное свойство. Компания Sony впервые интегрировала CMOS-датчик, используя 3D-стекинг для ToF-датчиков. Внутрипиксельное соединение позволило разместить CMOS-датчик изображения вместе с логической подложкой. Благодаря интегрированной логической матрице, датчик может производить простые вычисления расстояния между iPad и объектами, объяснил Халлеро.

— Ковыряемся в лидаре iPad 11 Pro

Весь вопрос в том, как принимается отраженный сигнал и как ведется обработка, в зависимости от этого получатся очень разные технологии с очень разными результатами с точки зрения точности и дальности.

лидары будут в каждом iPhone

Что-то я совсем не доверяю безопасности для глаз нонейм лидаров в китайских клонах айфона. :(

Сравнение странное, в iPhone ведь принципиально другое устройство камеры.

Лидары для автомобилей стоили $75.000, а теперь лидары будут в каждом iPhone