Comments 33

PCIe на оптике будите делать?

0

>бифуркации — разделения

>брейкаута — хмм…

>лэйнов — линий?

Колитесь что там уже цепляете, и зачем PCIe так далеко тащить.

>брейкаута — хмм…

>лэйнов — линий?

Колитесь что там уже цепляете, и зачем PCIe так далеко тащить.

+2

PCIe поддерживает идеологию подключения к другому PCIe, нулькабелем? тогда получается вполне дешевая 24-гигабитная линия (если я правильно понимаю, 24гигабита это на все PICe разъемы на материнской плате до одного процессора) на 10метров, это уже даже не в пределах стойки а целый ряд в датацентре.

0

Канального уровня мало. Необходимо чтобы весь стек передачи данных для примера IP поддерживал такие соединения. IP так сильно прирос к ethrnet что есть подозрения легче написать какой то эмулятор ethrnet — >pci-e чем городить нативный стек.

А по опыту IP over SCSI было фантастично во времена тупых ethrnet адаптеров и скоростей в 100 Мб/с.

А по опыту IP over SCSI было фантастично во времена тупых ethrnet адаптеров и скоростей в 100 Мб/с.

0

PCIe — это всегда точка-точка, причем одна из них хост, а другая — оконечное устройство. Два хоста «в лоб» соединять нельзя, но можно для этого использовать отображение памяти с применением механизма трансляции адресов непрозрачного моста в коммутаторе (NTB). И в принципе можно сделать драйвер виртуального NIC'а который будет использовать PCIe в качестве транспорта. В случае x16 скорость будет 128Gb (реальная по данным конечно чуть ниже выйдет).

Только в датацентрах соединения точка-точка мало кому интересны, а вот с коммутаторами на PCIe все совсем не так радужно, чтобы это имело смысл практического применения в качестве замены стандартным сетевым интерфейсам.

Только в датацентрах соединения точка-точка мало кому интересны, а вот с коммутаторами на PCIe все совсем не так радужно, чтобы это имело смысл практического применения в качестве замены стандартным сетевым интерфейсам.

+1

Вот какраз не для датацентра я был бы нереально рад дешевому соединению двух компьютеров в кластер, методом общего адресного пространства, никакой лишней прослойки из софта! 128гигабит это просто сказка.

Но меня интересовало именно 4 линии, один компьютер соединен с тремя соседними — получается сеть.

Но меня интересовало именно 4 линии, один компьютер соединен с тремя соседними — получается сеть.

0

Да, это конечно можно сделать. Только по x4 скорость-то будет всего около 30 гигабит на линк… Это конечно возможный вариант, но уж больно нишевый, мало кому это надо. Тем более если это надо в количестве 1 штука и для себя — проще на e-bay купить IB адаптеры какого-нибудь сильно предыдущего поколения (EDR — 40Gb) и на них все сделать.

0

UFO just landed and posted this here

Я бы даже сказал скорее не в commodity, а в consumer. Thunderbolt для наших целей не интересен совсем, там все грустно если в целом посмотреть, у него своя ниша.

Да, пожалуй во всякой встраиваемой требухе PCIe может и побольше уже будет, только у меня есть серьезные сомнения в том, что тот же Apple, например, принимает сколько-нибудь серьезное участие в развитии стандарта.

Да, пожалуй во всякой встраиваемой требухе PCIe может и побольше уже будет, только у меня есть серьезные сомнения в том, что тот же Apple, например, принимает сколько-нибудь серьезное участие в развитии стандарта.

0

А если есть информация, можно поинтересоваться разницой для end user между TB3 и PCIe3.0?

Кейс такой: проброс 4х линий на расстояние около метра с минимальными задержками и питанием около 60ватт. Не будет ли на TB каких-либо дополнительных задержек сильно влияющих на производительность?

Кейс такой: проброс 4х линий на расстояние около метра с минимальными задержками и питанием около 60ватт. Не будет ли на TB каких-либо дополнительных задержек сильно влияющих на производительность?

0

Я если честно TB детально не смотрел в плане задержки, поэтому не подскажу. На PCIe свиче задержка порядка 150нс добавляется, и для связи двух хостов достаточно одного свича с NTB. Для TB задержка вряд ли будет ниже, поскольку производится два раза конверсия — PCIe->TB и потом TB->PCIe.

Все же TB и PCIe over cable — решения для разных задач.

Все же TB и PCIe over cable — решения для разных задач.

0

1) Какая ориентировочная стоимость вашего адаптера?

2) Допустим я хочу получить максимальное количество портов x1 из порта x16. Существуют ли такие решения? Может подскажите где подобное можно найти?

2) Допустим я хочу получить максимальное количество портов x1 из порта x16. Существуют ли такие решения? Может подскажите где подобное можно найти?

0

1. Мы не планируем продавать адаптеры как самостоятельные изделия (пока), и даже стоимость его при нормальной серии толком не просчитывалась. Самое дорогое там — PCIe switch. Но порядок цены — несколько сотен долларов, до 500 где-то.

2. Если нужно именно х16 в качестве аплинка — то я такого не видел. А реально ли нужно х16 наверх? Что, все 16 штук х1 будут работать на полной скорости и одновременно? Объясню в чем проблема. PCIe свичи сейчас производят PLX и PMCS. И у обоих свичи с большим количеством лэйнов не подразумевают разбиение портов до х1, минимальная гранулярность у PMCS это х2, а у PLX для многих моделей вообще x16. Соответственно если делать именно то, что написали вы, то потребуется свич на 48 лэйнов (x16 наверх и 16 по х2, из которых реально будет задействован х1, вниз). Это все деньги. У нас есть плата (для другой нашей системы), у нее наверх х16, а вниз мы сделали восемь слотов, они могут быть или все х8, или крайние х8 могут объединяться чтобы получить один х16 вместо них.

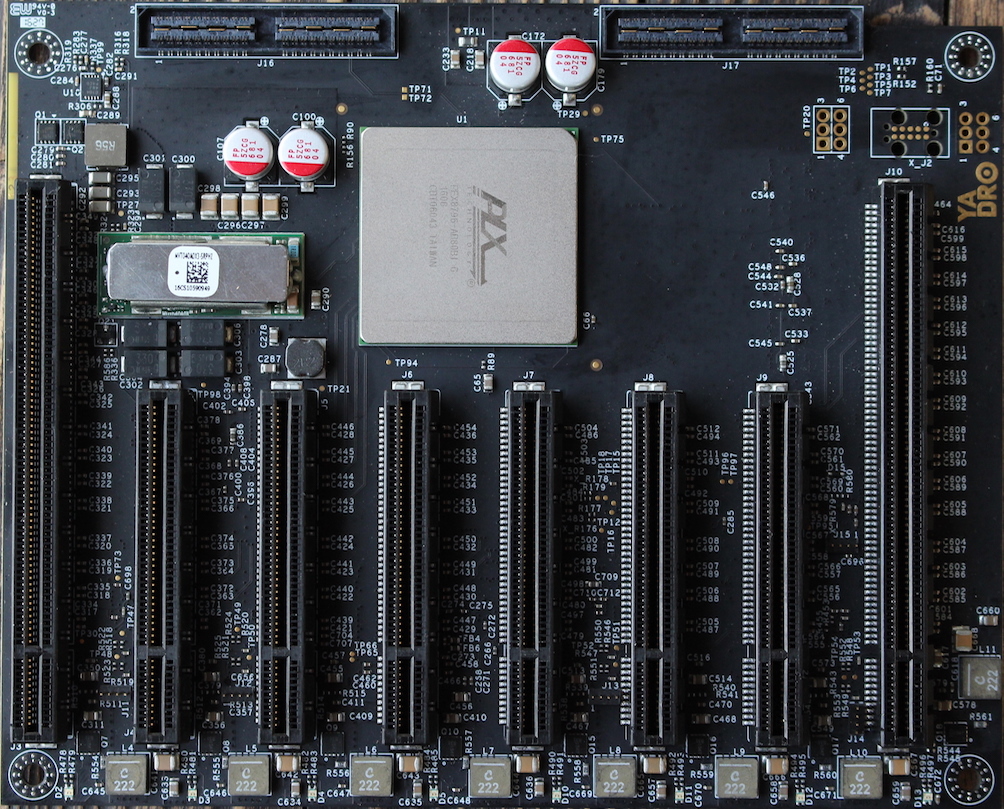

Фото платы:

2. Если нужно именно х16 в качестве аплинка — то я такого не видел. А реально ли нужно х16 наверх? Что, все 16 штук х1 будут работать на полной скорости и одновременно? Объясню в чем проблема. PCIe свичи сейчас производят PLX и PMCS. И у обоих свичи с большим количеством лэйнов не подразумевают разбиение портов до х1, минимальная гранулярность у PMCS это х2, а у PLX для многих моделей вообще x16. Соответственно если делать именно то, что написали вы, то потребуется свич на 48 лэйнов (x16 наверх и 16 по х2, из которых реально будет задействован х1, вниз). Это все деньги. У нас есть плата (для другой нашей системы), у нее наверх х16, а вниз мы сделали восемь слотов, они могут быть или все х8, или крайние х8 могут объединяться чтобы получить один х16 вместо них.

Фото платы:

+1

Прошу прощения, описался: «у PLX для многих моделей вообще x16» — естественно не x16, а x4.

0

- Много x1 нужно для организации головной станции IPTV. В порты x1 устанавливаются платы типа DD Max S8 или DD Octopus Duo CI. Через один x1 порт будет прокачиваться 20-900 Mbit/s. Идея была сделать корпус 3U в котором на передней панели, вместо дисковых корзин, можно было бы вставить 16 карт x1. Какая конфигурация(аплинки, лейны, свичи) будет самой дешевой для организации этой идеи? Существуют ли готовые компоненты в продаже? Я нашел в виде внешнего исполнения Magma ExpressBox 16 Basic, но с ценой $4500 ее использование лишено смысла, проще взять профессиональную головную станцию. Если бы уложится до $1000, было бы супер.

- Можно ли две ваши восьмипортовые платы повесить на один порт x16?

+1

Я думаю что из готовых решений вряд ли что-то будет дешевым, потому что все обычно ориентируются на порты x8, а это сильно дороже. Исходя из того, что потоки у ваших устройств достаточно маленькие, да и сами они работают только в Gen2, самым дешевым вариантом будет использовать коммутатор PEX8625 от Avago (24 линии с возможностью разбиения аж на 24 порта, PCIe Gen2). Итого 16 портов по x1 уходит к слотам, и x4 или x8 уходит наружу. Но все это актуально конечно только если вам нужна серия, потому что если вопрос одной-двух штук — берите любое готовое решение, разработка все равно дороже будет.

0

Игроманы будут в экстазе если можно будет ещё парочку видеокарт прикрутить. :) Ну или майнеры. Гы :)

0

Мне кажется майнеры уже давно на заказные ASIC'и переехали…

+1

Не все майнят биткойны, при наличии хорошего железа можно майнить валюты защищенные от асиков. Как раз думаю последний pcie x1 вывести под еще одну видюху. Не разбогатеешь, но месяцев за шесть отбивются gtx 1070. В общем, за год отобъешь ферму на ширпотребном железе. Другое дело — она не всем нужна, но при грамотном подходе майнинг на видюхах есть и в 2К16.

0

А каким образом можно защититься от асиков? Я просто не в теме, но искренне любопытно :)

0

Lyra2RE

0

Задействуй в алгоритме хешрования побольше оперативной памяти (многократное, случайное чтение и запись) и, пока, будешь защищен.

Альткоины на базе Cryptonote (например Monero или Aeon coin) на процессоре майнятся с той же скоростью что и на видеокарте (тот же порядок скоростей — сотни хешей в секунду).

Альткоины на базе Cryptonote (например Monero или Aeon coin) на процессоре майнятся с той же скоростью что и на видеокарте (тот же порядок скоростей — сотни хешей в секунду).

0

А что по поводу питания, на которое может рассчитывать железка — это прописано как-то в стандарте или тут всё на усмотрение производителя? Вопрос породила недавняя история с потреблением RX 480 более 75 ватт через PCIE и софтварный «хотфикс» от АМД.

0

Потребление PCIe устройств стандартизовано: 10/25/75W. Карты с большим потреблением требуют отдельного разъема по стандарту.

Данная карта находится в классе 25W.

Данная карта находится в классе 25W.

+2

UFO just landed and posted this here

К сожалению тут все немножко сложнее, чем просто разветвить — чтобы один порт x16 превратить в два по x8 надо ставить коммутатор на 32 лэйна, а это не сильно дешево. Либо, если процессор поддерживает нативно такое разбиение порта — можно просто развести его на два по х8, но при этом надо править BIOS чтобы там была включена правильная конфигурация портов в процессоре — тоже не для слабых духом задачка :)

0

-

0

Sign up to leave a comment.

PCI Express 4.0, кабели и все-все-все