OpenAI представила новую модель ИИ интерпретации изображений и текста GPT-4, которую компания назвала «последней вехой в своих усилиях по расширению масштабов глубокого обучения».

GPT-4 может принимать на вход изображения и текст — GPT-3.5 работала только с текстом — и работает на «уровне человека» в различных профессиональных и академических тестах, как утверждают разработчики. Так, на экзаменах Uniform Bar Exam, LSAT, SAT Math и SAT Evidence-Based Reading & Writing GPT-4 набрал 88% и более.

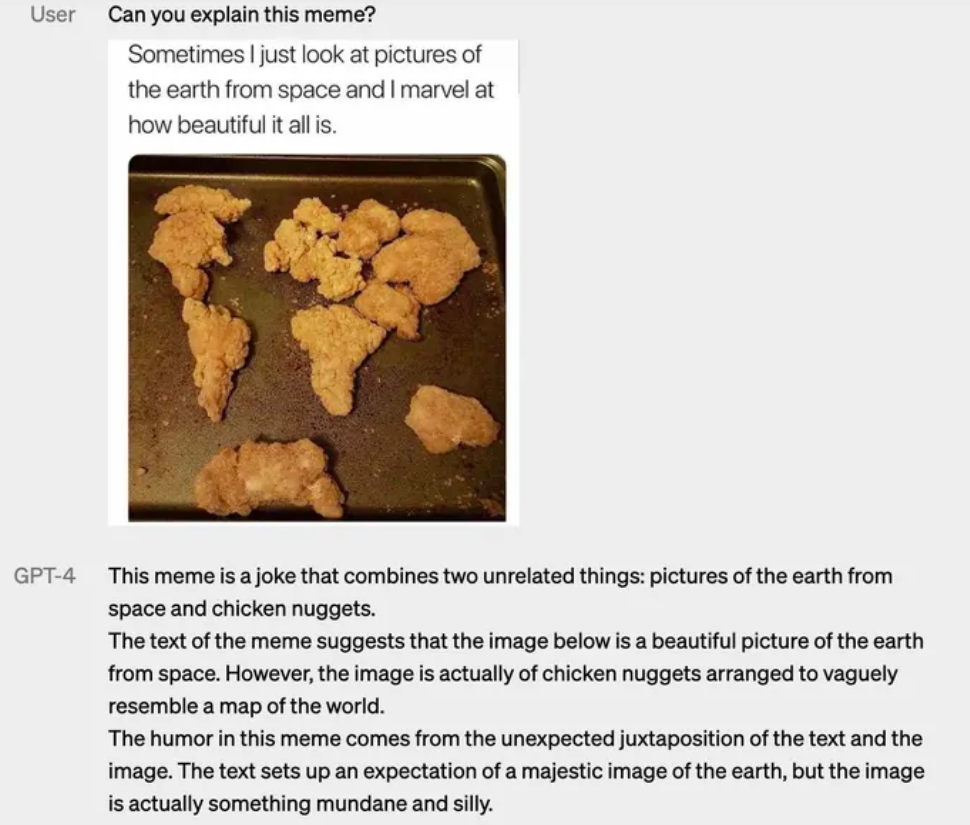

Также модель теперь распознаёт схематичные образы, в том числе и нарисованные от руки.

OpenAI потратила шесть месяцев на настройку GPT-4, используя программы состязательного тестирования, а также ChatGPT, что привело к улучшению результатов в отношении выдачи и управляемости. Модель на 82% реже отвечает на запросы о запрещённом контенте и на 40% чаще генерирует корректные ответы.

При обычном диалоге разница между GPT-3.5 и GPT-4 может быть едва уловимой, поясняет OpenAI. «Разница проявляется, когда сложность задачи достигает достаточного порога — GPT-4 более надёжен, креативен и способен обрабатывать гораздо более тонкие инструкции, чем GPT-3.5», — отмечает компания.

GPT-4 может подписывать и даже интерпретировать относительно сложные изображения, например, идентифицировать адаптер кабеля Lightning по изображению подключённого iPhone и т.д.

Возможность распознавания изображений пока доступна не для всех клиентов OpenAI — OpenAI тестирует её с Be My Eyes. Новая функция «Виртуальный волонтер» компании на базе GPT-4 может отвечать на вопросы об отправленных ей изображениях. Например, если пользователь отправит фотографию своего холодильника изнутри, виртуальный волонтёр сможет не только правильно определить, что в нём находится, но и проанализировать, что можно приготовить из этих ингредиентов. Инструмент также предложит ряд рецептов и отправит пошаговое руководство по готовке.

Потенциально более значимым улучшением является инструментарий управляемости. С GPT-4 OpenAI представляет новую возможность API, «системные» сообщения, которые позволяют разработчикам задавать стиль и задачи, описывая конкретные направления. Системные сообщения по сути являются инструкциями, которые задают тон и устанавливают границы для следующих взаимодействий с ИИ.

Например, системное сообщение может выглядеть так: «Вы наставник, который всегда отвечает в сократовском стиле. Вы никогда не даёте ученику ответа, но всегда стараетесь задать правильный вопрос, чтобы помочь ему научиться думать самостоятельно. Вы всегда должны согласовывать свой вопрос с интересами и знаниями учащегося, разбивая проблему на более простые части, пока не достигнете нужного уровня».

Однако даже теперь OpenAI признаёт, что GPT-4 не идеален. Он по-прежнему «галлюцинирует» и ошибается в суждениях. В одном примере чат-бот назвал Элвиса Пресли «сыном актёра» — это очевидная ошибка.

Разработчики отмечают, что «GPT-4, как правило, не знает о событиях, которые произошли после сентября 2021 года». Иногда чат-бот может совершать простые логические ошибки или быть слишком легковерным, принимая очевидные ложные утверждения от пользователя за правдивые. Также ИИ не идеален при решении сложных проблем.

GPT-4 доступна через API OpenAI по списку ожидания, а также в ChatGPT Plus, премиум-плане OpenAI для ChatGPT. Ранее Microsoft подтвердила, что её чат-бот Bing работает на GPT-4. Модель уже использует Stripe для сканирования бизнес-сайтов и отправки резюме сотрудникам службы поддержки клиентов, а также Duolingo, встроившая её в новый уровень подписки на изучение языков.

Ранее генеральный директор OpenAI Сэм Альтман заявлял, что GPT-4 не будет самой большой языковой моделью. Альтман также признал, что человечеству ещё далеко до разработки совершенного ИИ.