Comments 42

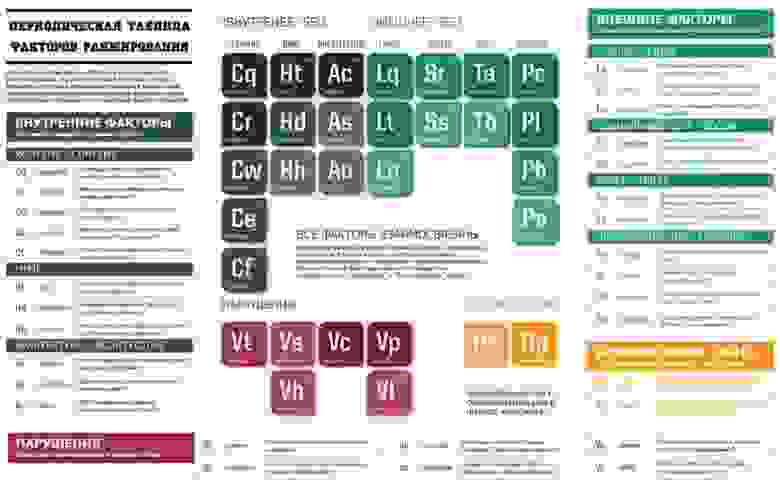

Есть очень хорошая «Периодическая таблица факторов ранжирования», которая впервые была представлена на searchengineland, а в последствии переведена блогером Алаичем. На ней также довольно-таки полно отображаются факторы ранжирования Google. У меня она долго стояла заставкой на рабочем столе так, что я всегда мог изучать ее и быстро найти ответ на вопрос «по теме».

+28

Спасибо за упоминание таблицы и моего перевода.

А мне стыдно, что я до сих пор перевел расширенное описание только для трех блоков таблицы (описания можно найти по ссылке на мой блог выше). А времени не хватает на перевод остальных :( Надо собраться с духом и довести дело до победного!

А мне стыдно, что я до сих пор перевел расширенное описание только для трех блоков таблицы (описания можно найти по ссылке на мой блог выше). А времени не хватает на перевод остальных :( Надо собраться с духом и довести дело до победного!

+4

Я что то подобное для клиентов компании «Мир рекламы» разработал, держите:

Если нужно описание в варианте «для клиентов», то на официальной странице компании в статье "Сбалансированные показатели сайтов". Версия аж от июня 2012 года, скоро с уточнениями и доработками сделаю, ну и в планах каждый из 6-ти факторов раскрыть максимально полно.

Если нужно описание в варианте «для клиентов», то на официальной странице компании в статье "Сбалансированные показатели сайтов". Версия аж от июня 2012 года, скоро с уточнениями и доработками сделаю, ну и в планах каждый из 6-ти факторов раскрыть максимально полно.

0

Давно натыкался на такую статью…

0

Стоит учесть, что это всего лишь догадки, основанные на косвенных признаках.

+17

В конце прошлого года в сеть попал мануал для ассесоров Google , на основе которого может быть построен данный список. Также этот список, наверное, составляли исходя из опыта, т.к. многие любят экспериментировать и анализировать, а потом в своих или профильных блогах делятся информацией.

Не думаю, что у нас сеошники учитывают даже половину из того что представлено выше. У нас по-прежнему продвигают ссылками. А вот в англоязычном гугле все посложнее будет, т.к. гугл наказывает за покупные ссылки и вебмастерам приходится уже, как говорится, «работать над сайтом, развивать его и делать сайты для людей».

Не думаю, что у нас сеошники учитывают даже половину из того что представлено выше. У нас по-прежнему продвигают ссылками. А вот в англоязычном гугле все посложнее будет, т.к. гугл наказывает за покупные ссылки и вебмастерам приходится уже, как говорится, «работать над сайтом, развивать его и делать сайты для людей».

+1

Не думаю, что у нас сеошники учитывают даже половину из того что представлено выше

Ну это только слабенькие сеошники. Нормальные (а тем более крупные студии продвижения) учитывают большинство из этих факторов (говорю не просто так, знаю по работе)

+2

Согласен. Не делают слабые сеошники и те, у которых висит 50 и более проектов. Обычно они делают все что должны или на крупных проектах или если работа построена так, что каждому уделяется достаточное время.

В крупных студиях, которые в топе, обычно конвеер. ТЗ написали, ссылок купили, выстрелил круто, не выстрелил, следующий.

В крупных студиях, которые в топе, обычно конвеер. ТЗ написали, ссылок купили, выстрелил круто, не выстрелил, следующий.

+1

В этой бумаге не видно например вот этих пунктов:

Размещение домена

IP домена

Размещение IP адреса / сервера

Насколько из этой бумаги ясно, локация страницы диктуется ее наполнением, а не адресом/положением/IP адресом

Размещение домена

IP домена

Размещение IP адреса / сервера

Насколько из этой бумаги ясно, локация страницы диктуется ее наполнением, а не адресом/положением/IP адресом

0

Покупные ссылки практикуются лишь в небольшом числе стран. И вовсе не потому, что Гугл наказывает. Гугл наказывает везде по одинаковым правилам, но если в US и EU под раздачу попадают сайты по ~1% запросов, то в РФ по ~10%. Просто-напросто отношение к самому бизнесу разное. У цивилизованных людей принято нормально развивать бизнес, улучшать качество и т.п., тогда и более-менее естественные ссылки появляются. Сайт постепенно поднимается в поиске, по запросам, которые интересуют пользователей и привлекают действительно целевую аудиторию. Надежно и долговременно, чтобы бизнес мог обеспечить безбедную старость. В РФ принято быстренько нагнать «трафика» на говно, напарить лохов и смыться.

Самое печальное, что ссылочным спамерством в рунете не гнушаются даже вполне солидные сайты, поэтому если «зарезать» вообще всех спамеров, то в результатах поиска будет практически девственно чисто, останутся одни странички васей пупкиных. Но, думаю, со временем, когда всё говно, похороненное под Пингвином, повылазит снова, можно будет гайки дальше закрутить и похоронить всплывшее с пользой для результатов поиска. Так, глядишь, и нормальные сайты в рунете появятся.

Самое печальное, что ссылочным спамерством в рунете не гнушаются даже вполне солидные сайты, поэтому если «зарезать» вообще всех спамеров, то в результатах поиска будет практически девственно чисто, останутся одни странички васей пупкиных. Но, думаю, со временем, когда всё говно, похороненное под Пингвином, повылазит снова, можно будет гайки дальше закрутить и похоронить всплывшее с пользой для результатов поиска. Так, глядишь, и нормальные сайты в рунете появятся.

0

Не думаю, что у нас сеошники учитывают даже половину из того что представлено выше. У нас по-прежнему продвигают ссылками.

Ссылки эффективны и вина в этом только лишь на поисковиках. Тем не менее без ссылок продвижение возможно, примеров масса, но требуется работа над сайтом тщательная (контент, дизайн, юзабилити). К сожалению, не все заказчики способны на такое и горе-сеошники вынуждены двигать их сайты исключительно ссылками. Я рекомендую сеошникам отказываться от таких клиентов, так и сам поступаю.

0

Есть студии, которые практикуют то, что вы написали. У них, как правило, клиентов мало, но профит с них достойный.

0

UFO just landed and posted this here

Неплохо было бы отсортировать по важности

0

UFO just landed and posted this here

>Ссылки с сайтов того же регистратора

Как это понять? Может быть, все-таки администратора (владельца)?

Как это понять? Может быть, все-таки администратора (владельца)?

0

Сейчас почти везде private person, так что наверное все-таки регистратора. Допустим человек создает сетку сайтов, и регистрирует 100 доменов у одного регистратора.

0

UFO just landed and posted this here

Тогда IMHO это сомнительный критерий. Например, в зоне ру регистраторов — пара десятков. Не такой уж большой выбор. Тем более, что в основном регистрируются у крупных — типа nic.ru и r01.ru.

А сетку сайтов все же логичнее детектить по IP.

А сетку сайтов все же логичнее детектить по IP.

-1

Мне также очень нравится таблица SEO-факторов здесь: www.webconfs.com/15-minute-seo.php

0

UFO just landed and posted this here

Google не наказывает за длинный title. Он просто учитывает первые 12 слов.

Хотя тут: topmarketing.by/web-analytics/skolko-slov-v-title-uchityvaetsya-pri-poiske-itogi-eksperimenta-3.html

утверждают что это ложь, и ПС используют весь title какой бы он длинны не был.

Хотя тут: topmarketing.by/web-analytics/skolko-slov-v-title-uchityvaetsya-pri-poiske-itogi-eksperimenta-3.html

утверждают что это ложь, и ПС используют весь title какой бы он длинны не был.

0

А вот и формула ранжирования выдачи в поисковой системе «Яндекс».

0

Если бы.

Давеча общался с ТП Яндекса по поводу как я понимаю бана (ограничения в поиске) домена одного из узконаправленного интернет-магазина.

Какой-то алгоритм Яши посчитал магазин с «шурупами и гайками» не очень информативным:

— После анализа и классификации страниц Вашего сайта наши алгоритмы приняли решение ограничить его в поиске. Обратите внимание, не все страницы, известные поиску Яндекса, включены в индекс и ранжируются высоко. Их включение и позиция зависят от качества сайта и его контента. В случае, если сайт не соответствует нашему пониманию качественного сайта, он может быть ограничен в поиске.

Однако google всё понял правильно и продолжает выдачу по ВЧ и СЧ, НЧ по тем же «шурупам»

«Шуруп» такой-то, производетель, номер/аналог, цена

Проверял у конкурентов — дела с информативностью обстоят куда хуже, но выдача в том же топ10.

Странное дело.

Давеча общался с ТП Яндекса по поводу как я понимаю бана (ограничения в поиске) домена одного из узконаправленного интернет-магазина.

Какой-то алгоритм Яши посчитал магазин с «шурупами и гайками» не очень информативным:

— После анализа и классификации страниц Вашего сайта наши алгоритмы приняли решение ограничить его в поиске. Обратите внимание, не все страницы, известные поиску Яндекса, включены в индекс и ранжируются высоко. Их включение и позиция зависят от качества сайта и его контента. В случае, если сайт не соответствует нашему пониманию качественного сайта, он может быть ограничен в поиске.

Однако google всё понял правильно и продолжает выдачу по ВЧ и СЧ, НЧ по тем же «шурупам»

«Шуруп» такой-то, производетель, номер/аналог, цена

Проверял у конкурентов — дела с информативностью обстоят куда хуже, но выдача в том же топ10.

Странное дело.

0

В принципе давно известные факторы. Но толку от них ноль если не умеешь из них «готовить».

То есть это как ингредиенты в кулинарном рецепте. Толку от продуктов будет ноль если не знаешьв каком соотношении нужно их использовать. Можно провести 3 часа у плиты, пересолить — и блюдо пойдет в мусорку.

Из своего опыта скажу, чего не нашел в списке — это количество страниц. Чем больше их — тем лучше. Гугль думает что чем больше страниц у сайта — тем он как бы «полезнее».

Ну и еще из личного — если вы живете в Америке, а строите сайт для России, то покупайте хостинг в России. Гугль в поиске старается показать сначало «близкие» по расстоянию к вам сайты.

Что касается Yandex — то для меня их робот загадка. С гугля может приходить 3000 юзеров, а с яндекса 2 =))

То есть это как ингредиенты в кулинарном рецепте. Толку от продуктов будет ноль если не знаешьв каком соотношении нужно их использовать. Можно провести 3 часа у плиты, пересолить — и блюдо пойдет в мусорку.

Из своего опыта скажу, чего не нашел в списке — это количество страниц. Чем больше их — тем лучше. Гугль думает что чем больше страниц у сайта — тем он как бы «полезнее».

Ну и еще из личного — если вы живете в Америке, а строите сайт для России, то покупайте хостинг в России. Гугль в поиске старается показать сначало «близкие» по расстоянию к вам сайты.

Что касается Yandex — то для меня их робот загадка. С гугля может приходить 3000 юзеров, а с яндекса 2 =))

0

Гугль в поиске старается показать сначало «близкие» по расстоянию к вам сайты.Правда что-ль? А когда это у Википедии хостинг в России появился? Через один запрос вылазит в результатах.

0

У википедии нет альтернативы (конкурента). + Это один из факторов, но далеко не решающий.

+ На результаты выдачи влияет еще и ваш адрес.

То есть например вы сидя в Америке сделали сайт для России. Вводите ключевое слово в гугле и видите что ваш сайт на 10ой странице. Прежде чем вырывать волосы на голове убедитесь что сайт находится на той же позицие у тех кто живет в России.

Потому как выдача по одному и тому же ключевому слову будет разная для людей живущих в разных регионах (странах).

Опять же — все это личные наблюдения… нельзя утверждать все на 100%.

+ На результаты выдачи влияет еще и ваш адрес.

То есть например вы сидя в Америке сделали сайт для России. Вводите ключевое слово в гугле и видите что ваш сайт на 10ой странице. Прежде чем вырывать волосы на голове убедитесь что сайт находится на той же позицие у тех кто живет в России.

Потому как выдача по одному и тому же ключевому слову будет разная для людей живущих в разных регионах (странах).

Опять же — все это личные наблюдения… нельзя утверждать все на 100%.

0

У википедии невероятно много естественных ссылок и траст у нее огроменный. Она по разным запросам и на разных языках находится часто в топе по информационным запросам. У Гугла насколько я знаю пока еще нет региональной привязки(внутри страны). Влияет в какой зоне находится домен и, как уже говорилось, адрес. Хостинг не думаю, что является важным фактором.

Если у сайта будет 100500 страниц в индексе гугла это не факт, что он будет иметь приоритет. Дубли и пустые страницы и всякие не полезные страницы не имеют и не передают никакого веса.

Если у сайта будет 100500 страниц в индексе гугла это не факт, что он будет иметь приоритет. Дубли и пустые страницы и всякие не полезные страницы не имеют и не передают никакого веса.

0

Да, выдача разная в разных регионах по некоторым запросам.

— Гугл умеет, во многих случаях, извлекать адрес компании, если он написан на сайте. И «расстояние» до пользователя будет зависеть только от настроек пользователя. Если пользователь из Нижнеурюпинска укажет в настройках, что он из Вашингтона, то ему будут показывать сайты, «близкие» к Вашингтону, а не к Нижнеурюпинску.

— Результаты поиска зависят от языковых настроек: пользователю, желающему русскоязычные результаты, покажут не то же самое, что пользователю, желающему англоязычные.

— google.ru показывает чуть другие результаты, чем google.com — более подходящие для РФ.

Вы все эти факторы учли, когда делали личные наблюдения, касающиеся расположения хостинга?

— Гугл умеет, во многих случаях, извлекать адрес компании, если он написан на сайте. И «расстояние» до пользователя будет зависеть только от настроек пользователя. Если пользователь из Нижнеурюпинска укажет в настройках, что он из Вашингтона, то ему будут показывать сайты, «близкие» к Вашингтону, а не к Нижнеурюпинску.

— Результаты поиска зависят от языковых настроек: пользователю, желающему русскоязычные результаты, покажут не то же самое, что пользователю, желающему англоязычные.

— google.ru показывает чуть другие результаты, чем google.com — более подходящие для РФ.

Вы все эти факторы учли, когда делали личные наблюдения, касающиеся расположения хостинга?

0

Про кнопку g+1 ничего не упомянули(

0

воспользуюсь случаем спрошу у господ СЕОшников о том, что меня довно мучает. АнтиСЕО. Если гугль вводит санкции за мусорные ссылки с внешних ресурсов, это ведь можно использовать против хорошо раскрученного конкурента? запустить хрумер с сылками на него и готово дело или я что-то упускаю?

0

Совершенно верно. Только это не приобрело еще массовости. Да и те кто плотно занимается продвижением своих ресурсов заметят подозрительную активность и сразу напишут в поддержку поисковиков.

И на последней конференции в Казани представителям поисковиков задавали

И на последней конференции в Казани представителям поисковиков задавали

этот вопрос

(с)взято с сёрча.Зал: — Вопрос к поисковым системам. Не кажется ли вам, что бан за вещи, которые не зависят от веб-мастера, открывают темный ящик Пандоры по завалу конкурентов, пойдут заказы на черное SEO и так далее. А именно к этому и приведет возможность фильтрации за внешние факторы. И что получается – конкуренты тебя выбили из выдачи, а потом повыситься в Яндексе – тоже невозможно, т.к. годами получаешь письма типа – работайте над своим сайтом и проч.

Сергей Людкевич: — Я в этом вижу большую проблему. Действительно, есть такие случаи, когда люди пытаются выбить особо ненавистных конкурентов из топа, ставят трэшовые ссылки, накручивают ПФ, а потом сами же на это дело стучат и т.д.

Я считаю, что поисковые системы пока на этом не заморачивается в виду небольшого количества случаев. Когда это станет более массовым, тогда заинтересуются и займутся. А тем, кого это коснулось – конечно, обидно.

Михаил Сливинский: — Эту проблему можно решить введением авторизации, когда человек будет подтверждать свои поступки, демонстрируя свою принадлежность к продвигаемому ресурсу.

Сергей Людкевич: — Это будет эффективно против тех, кто хочет просто побаловаться, но не против тех, кто серьезно в этом заинтересован.

Михаил Сливинский: — Но все равно, большую часть проблем создание таких сервисов авторизации принадлежности к домену решит. Надо просто сеошникам решить, хотят ли они сами, чтобы исчезла эта маленькая возможность оправдаться перед поисковыми системами, сказав, в случае чего – это не я на себя такую кучу ссылок купил, это конкуренты.

Владимир Офицеров: — На самом деле я считаю, что проблема сильно преувеличена. Мы с Марией проводили клинику сайтов, и там те сайты, которые покупали ссылки, так и говорили – да, мы их покупаем. Они не боялись это признавать.

Кирилл Николаев: — Да, у нас некоторые факторы ранжирования в совокупности с другими факторами могут давать некоторый минус, но эта возможность настолько мала, что справиться с ней очень просто, обратившись в саппорт. Ошибки всегда могут быть. Часто бывает так, что внутренние структуры сайтов вдруг оказались похожи, или временно похожи, на те структуры, которые искусственно делаются релевантными, все решается обращением в саппорт.

Константин Леонович: — На мой взгляд, если говорить о сервисах, которые будут валить конкурентов, то гораздо продуктивней создавать сервисы вроде – Затролльконкурента.ру. Там реально будет наниматься человек, который будет всячески гадить конкуренту в социальных сетях, взорвет ему саппорт и прочая. Но создавать технологии, которые будут автоматически это делать – смысла нет.

Сергей Людкевич: — Я в этом вижу большую проблему. Действительно, есть такие случаи, когда люди пытаются выбить особо ненавистных конкурентов из топа, ставят трэшовые ссылки, накручивают ПФ, а потом сами же на это дело стучат и т.д.

Я считаю, что поисковые системы пока на этом не заморачивается в виду небольшого количества случаев. Когда это станет более массовым, тогда заинтересуются и займутся. А тем, кого это коснулось – конечно, обидно.

Михаил Сливинский: — Эту проблему можно решить введением авторизации, когда человек будет подтверждать свои поступки, демонстрируя свою принадлежность к продвигаемому ресурсу.

Сергей Людкевич: — Это будет эффективно против тех, кто хочет просто побаловаться, но не против тех, кто серьезно в этом заинтересован.

Михаил Сливинский: — Но все равно, большую часть проблем создание таких сервисов авторизации принадлежности к домену решит. Надо просто сеошникам решить, хотят ли они сами, чтобы исчезла эта маленькая возможность оправдаться перед поисковыми системами, сказав, в случае чего – это не я на себя такую кучу ссылок купил, это конкуренты.

Владимир Офицеров: — На самом деле я считаю, что проблема сильно преувеличена. Мы с Марией проводили клинику сайтов, и там те сайты, которые покупали ссылки, так и говорили – да, мы их покупаем. Они не боялись это признавать.

Кирилл Николаев: — Да, у нас некоторые факторы ранжирования в совокупности с другими факторами могут давать некоторый минус, но эта возможность настолько мала, что справиться с ней очень просто, обратившись в саппорт. Ошибки всегда могут быть. Часто бывает так, что внутренние структуры сайтов вдруг оказались похожи, или временно похожи, на те структуры, которые искусственно делаются релевантными, все решается обращением в саппорт.

Константин Леонович: — На мой взгляд, если говорить о сервисах, которые будут валить конкурентов, то гораздо продуктивней создавать сервисы вроде – Затролльконкурента.ру. Там реально будет наниматься человек, который будет всячески гадить конкуренту в социальных сетях, взорвет ему саппорт и прочая. Но создавать технологии, которые будут автоматически это делать – смысла нет.

+1

заметят подозрительную активность это если из примера с хрумером, но ведь есть варианты. первое, что приходит в голову — можно наделать дорвеев видимых только поисковикам, со стоп словами, а то и малварой. трафика не будет, но будет индексация, а затем и санкции. а после санкций даже если обратиться в суппорт время будет потеряно. В общем согласен с мнением про ящик Пандоры и немного удивлён тем, что представители поисковиков спокойно к этому относятся, даже не озвучив планов на этот счёт.

0

Кластер ссылок

Уникальность адреса класса C (для меня загадка)

Я так понимаю это уникальность ссылки с домена в пределах айпи адреса С-класса, т.е. А.В.С.Д = 192.168.ТУТ.0

0

обновленная таблица факторов ранжирования, перевели и адаптировали в seo компании topodin.com

topodin.com/topodin-faktori-ranjirovaniya.php

topodin.com/topodin-faktori-ranjirovaniya.php

topodin.com/topodin-faktori-ranjirovaniya.php

topodin.com/topodin-faktori-ranjirovaniya.php0

Sign up to leave a comment.

Факторы поискового ранжирования Google