Comments 88

Круто :) Вообще по ведущим игрокам рынка ситуация примерно такая:

Juniper — XFP

Extreme — SFP+ (но встречается XFP)

D-Link — SFP+

Проблемы встают когда нужно слинковать два свитча с разными технологиями. Например, SFP+/XFP, в случае оптики и идентичных характеристик модулей по длине волны и мощности — проблем обычно не возникает. У нас в продакшене несколько таких линков.

Juniper — XFP

Extreme — SFP+ (но встречается XFP)

D-Link — SFP+

Проблемы встают когда нужно слинковать два свитча с разными технологиями. Например, SFP+/XFP, в случае оптики и идентичных характеристик модулей по длине волны и мощности — проблем обычно не возникает. У нас в продакшене несколько таких линков.

+2

Да у всех разные есть. Просто XFP реально больше подходит для прострела на дальние дистанции (>100км), SFP+ используются там, где нужна большая плотность портов, X2 — типа дорогая универсальная замена XENPAK.

+1

Честно говоря, XenPak ни разу вживую не видел :( Проблемы тут возникнут, если все это дело надо собрать в одной стойке, линковаться оптикой на таком расстоянии дороговато, а DAC кабелей XFP-SFP+ не встречалось.

0

Ну так это, пофапать на 40G надо же…

QSFP.

По двум волокнам:

По куче волокон одним коннектором:

Если хочется последний случай разбить на 4x10G, есть breakout кабели:

Пример CFP:

Если хочется один 40G CFP превратить в 4x10G SFP+:

.

.

Этот переходник — одна из причин, по которым ни в коем случае ни при каких обстоятельствах не надо покупать для Catalyst 6500 устаревшие карты WS-X6816-10G-2T, только WS-X6904-40G-2T, даже если 40G прямо сейчас не нужен.

Скоро выйдет трансивер, подключающийся к четырем 10G SFP+ и выдающий 40G, вроде даже по одной паре волокон (конечно, не всякая линейная карта так может).

40G очень любит превращаться в 10G и обратно, потому что с точки зрения чипов 40G обычно и есть 4x10G, там идет внутренняя агрегация.

В случае 1G/10G ни разу не сталкивался. SFP прекрасно дружит с GBIC, SFP+ с X2 и т.д. Только именно технология (см. SX, LR и так далее) должна совпадать. Формфактор трансивера несущественен.

QSFP.

По двум волокнам:

По куче волокон одним коннектором:

Если хочется последний случай разбить на 4x10G, есть breakout кабели:

Пример CFP:

Если хочется один 40G CFP превратить в 4x10G SFP+:

.

. Этот переходник — одна из причин, по которым ни в коем случае ни при каких обстоятельствах не надо покупать для Catalyst 6500 устаревшие карты WS-X6816-10G-2T, только WS-X6904-40G-2T, даже если 40G прямо сейчас не нужен.

Скоро выйдет трансивер, подключающийся к четырем 10G SFP+ и выдающий 40G, вроде даже по одной паре волокон (конечно, не всякая линейная карта так может).

40G очень любит превращаться в 10G и обратно, потому что с точки зрения чипов 40G обычно и есть 4x10G, там идет внутренняя агрегация.

Проблемы встают когда нужно слинковать два свитча с разными технологиями.

В случае 1G/10G ни разу не сталкивался. SFP прекрасно дружит с GBIC, SFP+ с X2 и т.д. Только именно технология (см. SX, LR и так далее) должна совпадать. Формфактор трансивера несущественен.

+13

Мой опыт подсказывает, что такие модули в современных реалиях нужны если только для подключения серверов в ЦОДах. Для всего остального есть 10GE или DWDM

0

Нет, не серверов. Аплинков сетевого оборудования.

Для серверов сейчас обычно 10G хорошо (хотя что скрывать — большинство серверов и на 1G ни в чем себе не отказывает). А вот если аплинк от свитча уровня доступа с десятками 10G серверов до ядра тоже будет состоять из 10G (с любой агрегацией) — при тяжелых потоках будет недоутилизация одних линков и переутилизация других, в результате неэффективность бандла.

Для серверов сейчас обычно 10G хорошо (хотя что скрывать — большинство серверов и на 1G ни в чем себе не отказывает). А вот если аплинк от свитча уровня доступа с десятками 10G серверов до ядра тоже будет состоять из 10G (с любой агрегацией) — при тяжелых потоках будет недоутилизация одних линков и переутилизация других, в результате неэффективность бандла.

0

Если хочется последний случай разбить на 4x10G, есть breakout кабели:

Как это работает? Как я понял, с одной стороны нужен 40GE интерфейс, а с другой 4x10GE?

0

В свитче это видится как 4 независимых 10G интерфейса вместо одного 40G интерфейса. С ними можно делать что угодно, хоть в port-channel собрать, если хочется извращений, хоть раздельно настроить и в разное оборудование подключить.

Картинка попонятнее:

Эти хвосты втыкаются в патч-панель.

Картинка попонятнее:

Эти хвосты втыкаются в патч-панель.

0

Эти хвосты втыкаются в патч-панель.

только в оптический кросс.

В свитче это видится как 4 независимых 10G интерфейса вместо одного 40G интерфейса

А с другой-то стороны что? 40GE интерфейс? То есть делается на одной железке PortChannel из 4-х портов, а на другой просто обычный интерфейс?

0

А с другой-то стороны что?

10G на любом числе железок. Порты независимые.

То есть делается на одной железке PortChannel из 4-х портов, а на другой просто обычный интерфейс?

Не… Прелесть breakout кабеля в том, что один и тот же интерфейс на линейной карте можно использовать и как честный 40G, и как четыре обыкновенных независимых (с разной конфигурацией) 10G, подключаемых куда угодно.

Port-channel — просто более высокоуровневый вид агрегации. Если с одной стороны port-channel, а с другой — независимые интерфейсы, то результат будет обычным — или бандл не поднимется, или поднимется, но будут теряться пакеты.

0

Ну тогда заодно :)

Cisco 100GBASE CFP Modules

Cisco 100GBASE CFP Modules

+1

Кстати — а у кого-нибудь уже встречается? Стоимость порта там, конечно, чуть безумная.

0

Москва-Ебург, работает с год примерно.

+2

Круть. На ONS?

0

А расскажите, как такие расстояния простреливают? Какие-то пассивные усилители?

0

Там немного хитро. DWDM сеть с установленными когерентными транспондерами, которые передают 100гбит/с на одной длине волны. Пробивают 4000 км без промежуточных узлов регенерации.

+2

Вот нашел пресс-релиз. На западе уже больше года есть развернутые сети.

0

+2

UFO just landed and posted this here

Что касается длин волн, то надо понимать, что на модуле указывается длина волны передатчика, а диапазон ресивера довольно широкий (обычно 1260-1620 нм). Таким образом, можно поднять линк между обычным модулем (с длиной волны 1310 или 1550 нм) и CWDM модулем с другой длиной волны. Кстати, в качестве эксперимента пробовали поднять линк через CWDM мультиплексор, используя для длины волны 1550 нм обычный (не CWDM) модуль — не поднялось

Тоже самое произойдет и с 1310нм. Причина — неточные лазеры. Хотя и приемник на любой SFP-шке широкополосный, CWDM-обрежет ту часть спектра, на котором передается сигнал.

Зато можно попробовать стрельнуть модулем например 1410нм, а принять на 1430. Как и в радиоволнах, часть каналов накладывается.

0

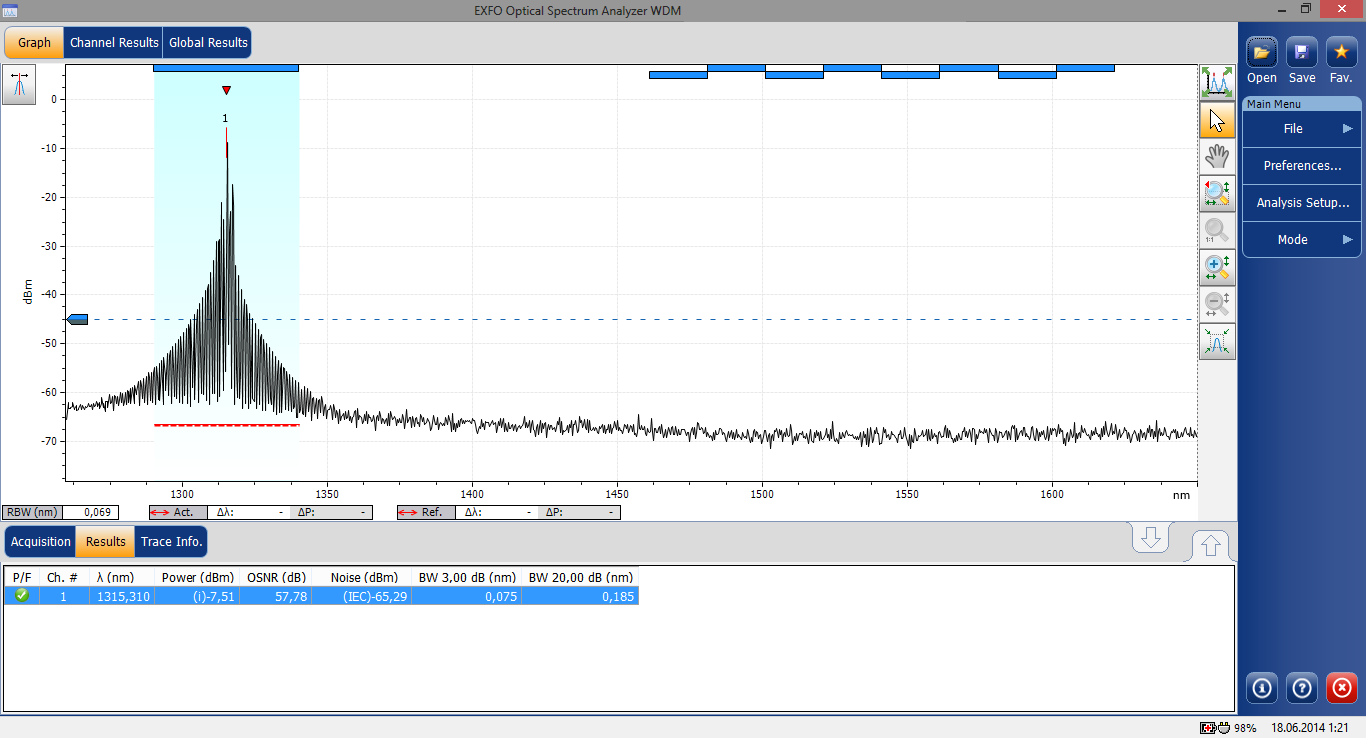

Раз заговорили про работу не-cwdm модулей через cwdm, то хочу показать пару спектрограмм:

Кстати, надо проверить, как будет выглядеть не CWDM сигнал, пропущенный через CWDM-мультиплексор.

Ну и до кучи спектрограмма линейного сигнала на выходе 6-ти канальной системы (6 каналов трафика плюс канал управления на длине волны 1310).

Gigalite GP-3124-L2CD, 1310 20 км не CWDM

Gigalite GPC-3124-04CD, 1310 40 км CWDM

Кстати, надо проверить, как будет выглядеть не CWDM сигнал, пропущенный через CWDM-мультиплексор.

Ну и до кучи спектрограмма линейного сигнала на выходе 6-ти канальной системы (6 каналов трафика плюс канал управления на длине волны 1310).

0

Возможно вопрос не совсем по теме, но очень хотелось бы получить ответ. На сколько хорошо совместимы между собой SFP+ порты на коммутаторах и сетевых картах при подключении через твин аксиальный кабель? Будут ли работать конфигурации: сетевая картасетевая карта, сетевая картакоммутатор, коммутаторкоммутатор? Конкретнее по моделям intel X520-DA2 и dlink DGS-3420-28TC.

0

А причем здесь твинаксиальный кабель?

+1

А вот сложный вопрос. Twinax — это активное устройство. Потому если один и тот же кабель не указан как поддерживаемый для обеих сетевых карт, то никто ничего не обещает. В этом сложность по сравнению с раздельными трансиверами, где отдельно для каждой стороны выбирается поддерживаемое (лишь бы стандарт был общий).

0

Бывают еще медные патч корды на 10Gbps с интерфейсом SFP+(или 1G SFP), причем есть даже некоторые сетевые PCI-e карты рассчитанные только на такие патч корды.

вот такого вида:

вот такого вида:

+2

Это обычный twinax. Дешево и сердито, если в пределах стойки. Внутри него может быть медь или оптика, пользователя это заботить не должно.

0

Очень толсто. Если таких линков мало, то ок (один линк до «Главного Сервера»), если линков много, то такими штуками 48 портов не развести.

0

Сравнимо с витой парой по толщине. Ее же как-то разводят.

0

Бывают и толще и по опыту могу сказать, что разводить их сложнее, чем витую пару, так как гибкость у них хуже, а значит и все радиусы изгибов больше. В итоге, такая разводка раза в 2-3 больше места занимает, чем витая пара.

+1

А бывают гигабитные SFP WDM модули под многомод?

0

Я сомневаюсь в целесообразности таких решений, но здесь что-то есть.

0

Немного не понимаю вопроса.

Вы имеете ввиду CWDM модули например как по ссылке, которые позволяют по одному волокну поднимать несколько линков в разных длиннах волн?

Для их использования необходим сам CWDM, т.е. делитель с каждой из сторон.

Мы отказались какое-то время назад, так как очень чувствительно к качеству самого волокна и работает не всегда стабильно(часть диапазонов может не работать), проще проложить более плотный кабель, однако вариант вполне рабочий.

Вы имеете ввиду CWDM модули например как по ссылке, которые позволяют по одному волокну поднимать несколько линков в разных длиннах волн?

Для их использования необходим сам CWDM, т.е. делитель с каждой из сторон.

Мы отказались какое-то время назад, так как очень чувствительно к качеству самого волокна и работает не всегда стабильно(часть диапазонов может не работать), проще проложить более плотный кабель, однако вариант вполне рабочий.

0

HeX хочет 1000BaseBX10-D/1000BaseBX10-U на многомоде.

0

Статья интересная. Спасибо.

Но я сходил по линке [1] «Хорошая статья на наге о внутренностях модулей» а там… Рискну быть заминусованным, но там же глупости написаны! И, что интересно, только один человек в комментариях заметил это.

Но я сходил по линке [1] «Хорошая статья на наге о внутренностях модулей» а там… Рискну быть заминусованным, но там же глупости написаны! И, что интересно, только один человек в комментариях заметил это.

+1

Расскажите, когда ждать 10GBASE-T для бедных?

0

Отличная и познавательная статья, спасибо.

+1

А можно небольшой оффтоп от человека, который максимум медь обжимает? Новостройка, в ближайшие годы планируется ремонт. Оптику дома смысла нет делать вроде, остается медь. Что класть с заделом на будущее? Я как-то к 10G 7a категории склонился. Пусть будет. А то раньше телевизор подключать было странно, 100 мегабит были нереальной скоростью…

0

Оптику? В доме? Это скорее непривычно чем бессмысленно.

Цена за погонный метр у оптического кабеля будет явно ниже чем у меди 7-й категории. При соблюдении несложных правил прокладки, оптика меньше подвержена внешним помехам и вполне способна прожить дольше меди без потери качества сигнала (здесь конечно важно кто производил эту медь и оптику. а то всякое бывает).

Модули SPF, конвертеры медь-оптика уровня SOHO по стоимости, на мой взгляд, недороги даже для частного применения.

А вот на счет 10G для квартиры я сильно сомневаюсь. Избыточно это.

Цена за погонный метр у оптического кабеля будет явно ниже чем у меди 7-й категории. При соблюдении несложных правил прокладки, оптика меньше подвержена внешним помехам и вполне способна прожить дольше меди без потери качества сигнала (здесь конечно важно кто производил эту медь и оптику. а то всякое бывает).

Модули SPF, конвертеры медь-оптика уровня SOHO по стоимости, на мой взгляд, недороги даже для частного применения.

А вот на счет 10G для квартиры я сильно сомневаюсь. Избыточно это.

0

И основной вопрос мне непонятный: при наличии десятков беспроводных сетевых устройств какой смысл в разворачивании СКС в отдельно взятой квартире? Расстояния минимальны. Нужна ли постоянная доступность 10G в ванной комнате, туалете, кухне, детской, кладовке, лоджии?

Единственный ответ, приходящий в голову — желание разместить шумяще-греющийся медиасервер подальше в кладовку-бытовку-антресоль и пробросить толстый канал от него до фактически единственного потребителя плазмы-проектора в гостинной.

Единственный ответ, приходящий в голову — желание разместить шумяще-греющийся медиасервер подальше в кладовку-бытовку-антресоль и пробросить толстый канал от него до фактически единственного потребителя плазмы-проектора в гостинной.

0

При наличии десятков беспроводных сетевых устройств у себя и у всех соседей, а также капитальных стен, проводная сеть как раз становится обязательной :) Странички в браузере открывать — одно. Передавать папку с фильмами с одного компьютера на другой — совсем иное дело.

Витая пара предсказуема, радиоэфир — нет.

Витая пара предсказуема, радиоэфир — нет.

0

Я не спорю, я скорее указываю на сложившуюся ситуацию. Планшеты, смарты, ноутбуки, тут даже гадать не надо, они однозначно уже есть в семье любого посетителя хабра. Большинство этих устройств не имеет на борту проводных сетевых разъемов. Их мобильность является скорее плюсом, чем минусом и использование этих устройств, как показывает практика, в быту превалирует. А вот потребитель канала шириной хотя бы в 1G в квартире (снова выделяю жирным) чаще всего только один.

0

Запас на будущее хочется. Пока действительно избыточно, но недавно с домашнего сервера переливал по сети 3 Ты на чистый винт. Понял, что гигабит это всего-то скорость чтения с одного винта.

Потенциально эти кабели будут использоваться для построения умного дома с кучей датчиков помимо локальной сети. Я насчитал 18 точек на 3 комнаты. Большая часть — запас.

Потенциально эти кабели будут использоваться для построения умного дома с кучей датчиков помимо локальной сети. Я насчитал 18 точек на 3 комнаты. Большая часть — запас.

0

Ну раз вы планируете гетерогенную среду с неясными перспективами развития, то на мой взгляд, проще и дешевле закопать в стену пару килограмм стекла, чем пару килограмм высококачественной меди.

Вы ведь правда не собираетесь использовать 7-ю категорию как физический транспорт для каких-нибудь 1-wire датчиков? ;-)

Вы ведь правда не собираетесь использовать 7-ю категорию как физический транспорт для каких-нибудь 1-wire датчиков? ;-)

0

Странно звучит, согласен) но в масштабах квартиры это не так много и дорого. Расстояния небольшие. А в чем проблема использовать как транспорт помимо стрельбы по комарам тактическими ядерными боеприпасами?

0

С этим стеклом ценник приличный выйдет. Сама оптика дороже плюс разварка (а медь в розетке самостоятельно обжимается) плюс стоимость порта, трансиверов и сетевой карты. А еще у коннекторов обычно весьма ограниченный ресурс по втыканию-вытыканию. А еще в далеко не чистой комнате проще простого поймать пылинку на волокно.

А медь копейки стоит. Про 7-ю категорию человек, конечно, загнул, 6-й хватит более чем под 10G. Она весьма дешевая.

А медь копейки стоит. Про 7-ю категорию человек, конечно, загнул, 6-й хватит более чем под 10G. Она весьма дешевая.

0

На короткие расстояния 6-я категория 10G должна корректно работать при наличии соответствующих сетевых карт? И по производителям что-то посоветуете? А то формально две катушки, обе 5е категории. Но одна голимый алюминий, а вторая качественная медь.

0

Под «коротким расстоянием» понимается «100 метров».

Я посоветую, если есть острое желание, закопать 6-ю категорию, но сейчас использовать гигабит, или агрегировать два гигабита. Сейчас 10G для домашнего пользователя стоит нецелесообразно дорого.

Я посоветую, если есть острое желание, закопать 6-ю категорию, но сейчас использовать гигабит, или агрегировать два гигабита. Сейчас 10G для домашнего пользователя стоит нецелесообразно дорого.

+1

В ближайшем ко мне прайсе вижу цена метра патчкордового оптического кабеля 6 рублей. Цена метра 6-кат 13 рублей. Во всем остальном спорить не буду.

Так как развели мы тут уже объемный оффтоп, предлагаю закруглиться.

В целом, чтобы не сложилось ошибочного мнения, я не агитировал за решение на оптике. Скорее пытался как «адвокат дьявола» найти конструктивные зерна в этом варианте.

Так как развели мы тут уже объемный оффтоп, предлагаю закруглиться.

В целом, чтобы не сложилось ошибочного мнения, я не агитировал за решение на оптике. Скорее пытался как «адвокат дьявола» найти конструктивные зерна в этом варианте.

+1

У меня оптика в доме, никаких особых сложностей по сравнению с медью не наблюдаю. Заводим с улицы внешний кабель в бокс, там развариваем на кабель для внутренних работ без брони и троса, он достаточно мягкий, если в узлы не вязать все отлично работает, как вариант завести сразу в гигабитный свич, а по дому уже медью, но не вижу ни одного преимущества меди, разве что коннектор стандартный. С оптикой в разы меньше возни да и апгрейдить сеть проще, если не хватает гигабита, просто втыкаем 10, по тому же кабелю. Тянуть дорогущий кабель 7а — то еще удовольствие, толстый, плохо гнется, нужны спец коннекторы, в стандартные запихнуть можно, но не будет заземления, мороки много уж очень.

0

Вот как это выглядит в живую, мое домашнее рабочее место, прошу прощения за качество, телефон.

Фото тумбы рабочего стола.

0

Смотрится замечательно. Основной минус оптики — оборудование для сварки недоступно обычно. Медь я обожму сам безо всяких проблем.

0

А вы прямо своему провайдеру позвоните и попробуйте договориться о вызове сварщика. Шанс получить желаемое довольно высок. Конечно если ваш провайдер не магистрал, не зажрался и тд. Многие сварщики в небольших компаниях подрабатывают. Не знаю какие расценки у вас, но у нас во Владивостоке цена колеблется в районе 500 рублей за одно соединение.

0

Можно подумать для магистралей между комнатами. Типа три волокна. Тут проблема, что оптику я не воткну ни в один из потребителей напрямую. 15+ конвертеров это громоздко и негуманно по цене. Провайдер у меня магистрал. МТС.

0

15 конвертеров это не только громоздко и негуманно, но и в SOHO-классе они будут периодически дохнуть и требовать замены.

Зато, чисто эмпирически, приходит в голову решение вашей проблемы с розетками большой плотности. Установка свича малой емкости с оптическим портом прямо рядом телевизором.

Долго искать неуправлямую модель маститого вендора я не стал, но надеюсь, мысль будет ясна и на примере оборудования которое стоит у меня дома.

Зато, чисто эмпирически, приходит в голову решение вашей проблемы с розетками большой плотности. Установка свича малой емкости с оптическим портом прямо рядом телевизором.

Долго искать неуправлямую модель маститого вендора я не стал, но надеюсь, мысль будет ясна и на примере оборудования которое стоит у меня дома.

0

Можно сделать соединение на файберлоках, без спец.инструмента. Если попотеть, вероятно, даже без скалывателя всё заработает. В девяностые так строили даже большие сети, потому что нормального оборудования не было: разделывали обычным ножом, скалывали волокна бритвой, вместо оптических муфт — пластиковые бутылки и фитинги и т.п… Конечно, качество таких соединений будет ужасное и затухания на соединениях велики, но для маленьких расстояний не критично. А если ещё и есть микроскоп для контроля такого импровизированного скола — то при должном терпении сделать нормальное соединение получится 100%.

0

У меня сварено 6 точек, сварщики-фрилансеры взяли по 5$ за точку, еще 150$ обошлись 4 бокса, 3 оптических патчкорда, 6 SFP модулей. Сварка дешево, быстро, не вижу сложностей т.к. стоит вменяемых денег. Медиаконвертора категорически не советую, ибо говно в большей своей части, там где много точек лучше всего ставить гигабитный свич с модулями как под SFP так и под медь (есть микротики по 100$, еще и вайфай сразу раздают, есть много маленьких свичей L2 на 10 портов с 2-мя SFP, цена вопроса тоже в районе 100-150$ ). Мне вся гигабитная сетка обошлась меньше чем в 1000$ строил 3 года назад, ни каких проблем, особенно радуюсь во время весенних гроз, показывая средний палец всем молниям и наводкам, ибо кабель идет с крыши, на меди очень жалко технику.

0

Зачем 7-я категория? Кладите Cat6a. 100м. для 10G обещают. Это будет задел на будущее.

0

Наверное вы правы. Кстати, никто не видел розеток на 2-4 RJ-45? Все что в продаже — под один вход. Патч-панель это понятно, а заканчивать чем в комнатах? Часто нужно по 4 штуки выводить (телевизор, ресивер, медиа-сервер, запасной)

0

На 2 сетевых разъёма точно бывает, я такие монтировал ещё году в 2008м. Больше не видел, если надо больше — просто ставили рядом несколько.

0

Прошу не считать рекламой, 2 минуты гугления — www.hyperline.ru/catalog/plugs/sb-gtf-5e.shtml

0

Спасибо, очень полезно. В архив шпаргалок.

0

Спасибо за статью!

А можно так же подробно про оптически бюджеты и прочее?

А можно так же подробно про оптически бюджеты и прочее?

0

Если cisco стала лояльнее относиться к не родным sfp-модулям, то HP в оптических свичах Brocade для SAN наоборот ужесточила требования. Доходит до того, что sfp-модули от предыдущего поколения не работают на новом, а наоборот — запросто.

0

Есть следующий вопросик, если в 100Base-FX порты коммутаторов вставить 1000Base-LX модули, они заработают?

0

Sign up to leave a comment.

Наглядный обзор оптических передатчиков