Comments 73

Да, теперь, если организация адекватна, у многих нервишки зашевелятся в отношении корректности работы ИБП на участках с этими железками.

0

Правильно ли я понимаю, что для исправления Cisco'й производственного брака пользователь в обязательном порядке должен оплачивать сервис-контракт или Cisco все-же более адекватны и исправляют такой брак в любом случае?

0

Поговорите с аккаунт-менеджером. Он обладает небольшой властью над TAC. Мне не удалось получить однозначного ответа на этот вопрос, скорее всего каждый случай рассматривается индивидуально.

Ну и надо понимать, что даже если удастся оформить RMA — замены может не быть на складе, и надо будет ждать. Долго ждать. Неделю-две, если повезет.

Ну и надо понимать, что даже если удастся оформить RMA — замены может не быть на складе, и надо будет ждать. Долго ждать. Неделю-две, если повезет.

0

оформляйте сервисные контракты с быстрой доставкой

А какой срок замены оборудования у базового смартнета?

0

Есть NBD (Next Business Day, если до 16:00 оформление, иначе будет еще через день). Наверное, это и есть «базовый». Есть 4 часа. Есть 2 часа (не уверен, что в России можно).

+2

Да, спасибо. В последнем заказе было именно он:

CON-SNT-A15K8, Cisco SMARTnet — Extended service agreement — replacement — 8x5 — NBD

CON-SNT-A15K8, Cisco SMARTnet — Extended service agreement — replacement — 8x5 — NBD

0

Хочу уточнить. NBD — это не значит, что вы получите замену на следующий день. Это означает, что она отгрузиться со склада Cisco на следующий день. Обычно это одно и тоже. Особенно если находитесь там же, где есть склад. Но если Вы, скажем, в Усинске, то время доставки будет зависеть от работы курьеров.

С премиум доставкой все обстоит как ожидается. В течении 4-х часов, после оформления RMA, замена будет у вас.

С премиум доставкой все обстоит как ожидается. В течении 4-х часов, после оформления RMA, замена будет у вас.

0

В таком случае у них странная трактовка NDB. Я сам работаю в сервисной организации и для нас NBD означает доставку устройства клиенту до конца следующего рабочего дня, причём cut-off — конец текущего бизнес-дня. Т.е. надо быть готовым принять заявку в 16:55 (у нас обычно 8:30-17:00), обработать/отгрузить вечером и до 22:00 отдать курьерам для доставки.

0

Ни чего удивительно впрочем как и странного. Чаще всего пользуются контрактом 8x5 NBD. Описанное вами уже не 8х5. Поэтому нет смысла сравнивать изначально разные сервисы. Кому реально надо покупает премиум контракт и получает доставку в течении 4-х часов. Кому не надо — NBD и в большинстве случаев получает замену на следующий день. О масштабах России тоже не стоит забывать, это не UK.

У всех свои правила. Если кто-то что-то себе придумал, не снимает с него ответсвенности прочитать контракт и понять как на самом деле.

У всех свои правила. Если кто-то что-то себе придумал, не снимает с него ответсвенности прочитать контракт и понять как на самом деле.

0

Теперь-то неназванный производитель вполне назван. STEC стоит в подавляющем большинстве устройств Cisco…

0

+7

А что мешает самостоятельно заменить память? Такую память вполне реально даже сейчас купить, хоть и ecc она.

0

Я описал это среди рекомендаций.

Но:

1) Многие железки очень привередливы по отношению к SPD, даже если характеристики памяти совпадают. Например, тот же 2800 будет упорно писать в консоль «bad RAM». Потому не надо думать, что «сдох роутер => выну такую же планку из сервера», она вряд ли заработает, надо заранее озаботиться вопросом и протестировать.

2) На как минимум половине устройств из списка для замены памяти потребуется паяльник…

3) Где будете искать совместимую память посреди ночи, если к утру оборудованию неплохо бы заработать?

Но:

1) Многие железки очень привередливы по отношению к SPD, даже если характеристики памяти совпадают. Например, тот же 2800 будет упорно писать в консоль «bad RAM». Потому не надо думать, что «сдох роутер => выну такую же планку из сервера», она вряд ли заработает, надо заранее озаботиться вопросом и протестировать.

2) На как минимум половине устройств из списка для замены памяти потребуется паяльник…

3) Где будете искать совместимую память посреди ночи, если к утру оборудованию неплохо бы заработать?

0

В 28хх, без проблем любой Kingston заводится, включая HyperX.

0

Нет никакого «Kingston». Есть конкретные партнамберы памяти плюс маркировка чипов (потому что в рамках одного партнамбера запросто могут ставить разные чипы). Возможно, вам сходу удалось найти память, к которой 2800-й нормально относится. Через меня же прошел десяток-два разнообразных модулей, из них только один не был отторгнут.

0

100% работает кингстон с чипами кингстон и хиникс.

0

Левая память в 2811

Dimm 0 SPD data :

Size of dimm = 256 Megabytes

Memory Type = 0x7

Row Addresses = 0xD

Column Address = 0xA

Module Rows = 0x1

Data Width = 0x40

Voltage Interface = 0x4

Cycle Time = 0x50

Access Time = 0x65

Configuration Type = 0x0

Refresh Rate/Type = 0x82

Primary Width = 0x8

Error Width = 0x0

Minimum Clock Delay = 0x1

Burst Lengths = 0xE

Number of Banks = 0x4

Cas Latencies = 0x18

Write Latency = 0x2

Module Attributes = 0x20

General Attributes = 0xC0

Min Cycle Time, CAS of 2 = 0x60

Access Clock Cycle, CAS of 2 = 0x70

Min Cycle Time, CAS of 1 = 0x0

Access Clock Cycle, CAS of 2 = 0x0

Row Precharge = 0x3C

Row Active to Row Active = 0x28

RAS CAS Delay = 0x3C

Ras Pulse Width = 0x28

Row Density = 0x40

Vendor Id = 7F7F7F0B00000000

Module Part Number = NT256D64S88C0G-5T

Module Revision Code = 2000

SPD contents (hex):

0x00: 80 08 07 0D 0A 01 40 00 04 50 65 00 82 08 00 01

0x10: 0E 04 18 01 02 20 C0 60 70 00 00 3C 28 3C 28 40

0x20: 60 60 40 40 00 00 00 00 00 37 46 30 28 50 00 01

0x30: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 10 86

0x40: 7F 7F 7F 0B 00 00 00 00 0F 4E 54 32 35 36 44 36

0x50: 34 53 38 38 43 30 47 2D 35 54 20 20 00 05 39 BC

0x60: 13 2A 80 88 00 00 00 00 00 00 00 00 00 00 00 00

0x70: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00

Dimm 1 SPD data :

Size of dimm = 512 Megabytes

Memory Type = 0x7

Row Addresses = 0xD

Column Address = 0xA

Module Rows = 0x2

Data Width = 0x40

Voltage Interface = 0x4

Cycle Time = 0x60

Access Time = 0x70

Configuration Type = 0x0

Refresh Rate/Type = 0x82

Primary Width = 0x8

Error Width = 0x0

Minimum Clock Delay = 0x1

Burst Lengths = 0xE

Number of Banks = 0x4

Cas Latencies = 0xC

Write Latency = 0x2

Module Attributes = 0x20

General Attributes = 0xC0

Min Cycle Time, CAS of 2 = 0x75

Access Clock Cycle, CAS of 2 = 0x70

Min Cycle Time, CAS of 1 = 0x0

Access Clock Cycle, CAS of 2 = 0x0

Row Precharge = 0x48

Row Active to Row Active = 0x30

RAS CAS Delay = 0x48

Ras Pulse Width = 0x2A

Row Density = 0x40

Vendor Id = CE00000000000000

Module Part Number = M3 68L6423ETN-CB3

Module Revision Code = 4E45

SPD contents (hex):

0x00: 80 08 07 0D 0A 02 40 00 04 60 70 00 82 08 00 01

0x10: 0E 04 0C 01 02 20 C0 75 70 00 00 48 30 48 2A 40

0x20: 80 80 45 45 00 00 00 00 00 3C 48 30 2D 55 00 00

0x30: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 10 27

0x40: CE 00 00 00 00 00 00 00 01 4D 33 20 36 38 4C 36

0x50: 34 32 33 45 54 4E 2D 43 42 33 20 4E 45 03 26 F5

0x60: 08 9A A2 00 43 42 44 30 41 30 4C 00 00 00 00 00

0x70: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00

0

1. Не во всех компонентах её можно заменить. В некоторых 720-х супервизорах, память распаяна.

2. Если ставите аналоги, то про гарантию/поддержку можно забыть. Но работать скорее всего будет.

2. Если ставите аналоги, то про гарантию/поддержку можно забыть. Но работать скорее всего будет.

0

Это оно habrahabr.ru/post/211685/?

+1

Может быть. А может быть, и нет. Что тут скажешь?

Однако, всё ваше умершее оборудование содержится в списке смертников, и триггер совпадает, так что скорее «оно», чем «не оно».

Однако, всё ваше умершее оборудование содержится в списке смертников, и триггер совпадает, так что скорее «оно», чем «не оно».

+1

UFO just landed and posted this here

Крайне похоже на мой случай.

0

Лишний аргумент в пользу «ни при каких обстоятельствах не класть вторую ноду кластера, не убедившись, что первая полностью работоспособна»…

В комментариях к упомянутому в топике блоге один товарищ наступил на те же грабли:

Еще кто-то здравые мысли излагает:

В комментариях к упомянутому в топике блоге один товарищ наступил на те же грабли:

This past weekend, we had scheduled maintenance to perform memory reallocation on a set of redundant FWSM’s that are at the heart of a production datacenter. This kind of work required both units in a redundant pair to be rebooted at the same time, so we had scheduled a two hour outage, however both units went down hard due to this issue, and we lost a production datacenter for 10 hours, causing us to miss customer SLAs.

Еще кто-то здравые мысли излагает:

It is now policy that when we reboot an ASA for updates we do so with RAM and a screwdriver with the tech just in case.

+1

Оно, но тогда об этом говорить было еще нельзя.

+1

Мой случай, две платы RSP720-3CXL-10GE загружаются один раз из 10-100, могут месяц работать, а могут через час упасть и больше не загрузится.

0

Да, увы, мы тоже нарвались на такое (Catalyst 6506+SUP720) года полтора назад. Заменили по смартнету.

Очень хорошо, что Cisco посчитала возможным сообщить о причинах. Среди профессионалов репутация ее от этого точно не пострадает, даже наоборот.

Очень хорошо, что Cisco посчитала возможным сообщить о причинах. Среди профессионалов репутация ее от этого точно не пострадает, даже наоборот.

+3

Оценивайте риски, оформляйте сервисные контракты с быстрой доставкой, заранее находите или закупайте память на замену, меняйте само железо на более новое.

Вы случайно не в Cisco работаете? =)

Вы случайно не в Cisco работаете? =)

+1

Зачем так пессимистично, если все равно «тэги никто не читает»? :)

+1

Это мерзкое чувство, когда почти всё твое важное железо упомянуто в списке приговоренных…

+4

… и несколько железок уже упало при очень похожих обстоятельствах и симптомами :(

0

… несколько десятков железок. Уже давно составлены планы реагирования на пропадание из сети, скажем, удаленных 2800-х роутеров. Первым шагом диагностики (после проверки доступности PE снаружи) является «спросить, не мигал ли недавно свет», а в случае утвердительного ответа пропускаются шаги диагностики вроде «подключиться консолью», к роутеру выезжает человек с памятью или запасным роутером, на слух определяет, загружается ли железка или падает в процессе (ага, вот такие крутые у нас местные IT специалисты), а дальше осуществляет замену.

ИЧСХ, этот подход ни разу не подводил.

Но когда была официально опубликована эта информация, я отложил некоторое количество кирпичей. Не ожидал таких масштабов.

ИЧСХ, этот подход ни разу не подводил.

Но когда была официально опубликована эта информация, я отложил некоторое количество кирпичей. Не ожидал таких масштабов.

0

сочувствую

я пока продолжаю откладывать, т.к. жду ряд важных решений по дальнейшему реагированию. В числе которых возможна смена вендора :(

я пока продолжаю откладывать, т.к. жду ряд важных решений по дальнейшему реагированию. В числе которых возможна смена вендора :(

0

Проблема касается всех (или многих) вендоров. И на новое железо она не распространяется.

Из 2900-х железок еще ни одна не умерла, а у нас их сотни. 2800-е с замененной памятью тоже живее всех живых. Есть линейные карты и много другого дорогого железа, в котором нельзя поменять память, но там надо думать, что выгоднее.

Из 2900-х железок еще ни одна не умерла, а у нас их сотни. 2800-е с замененной памятью тоже живее всех живых. Есть линейные карты и много другого дорогого железа, в котором нельзя поменять память, но там надо думать, что выгоднее.

0

Имеем аналогичную проблему. Обратились к поставщику, пока ждём ответа.

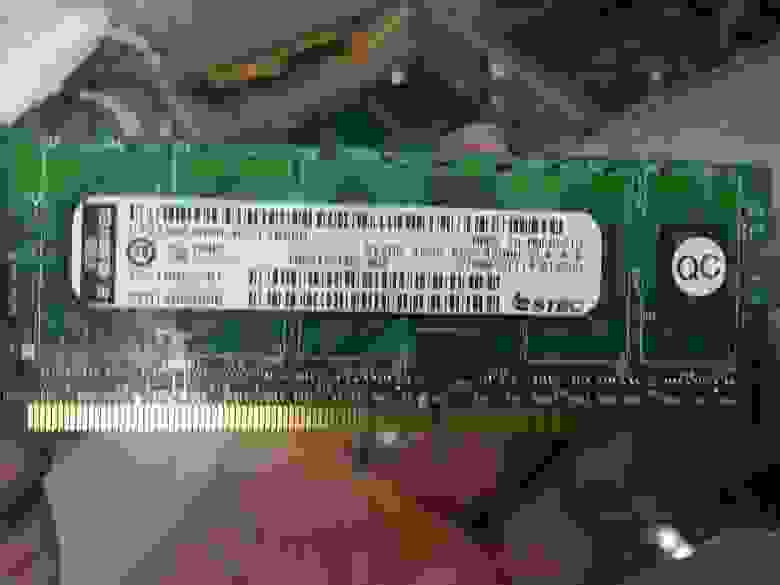

Фотография

0

Итак, благодаря этому посту воскресили ACE20 вот с такой ошибкой:

Проблема была в модуле памяти нетворк процессоров. Вендор плашки SMART.

Configuring NP 1 Memory

Configuring NP 2 Memory

.............................

Waiting for NP 1 SRAM memory to clear...success

Downloading NP 1 Image

.............................

Waiting for NP 2 SRAM memory to clear...success

Downloading NP 2 Image

..... 0x4b1204 (4919812) bytes downloaded

..... 0x4b1204 (4919812) bytes downloaded

Loading Nitrox driver.

Writing register at address 3838 with e00

size = 8108

Ctx memory range(0x0000000-0x10000000)

Cleared 262144 1024-byte blocks in 5 requests.

N2SetupMicrocode: failed; error code 3

Writing register at address 3898 with 1

N2LoadMicrocode: failed; error code 3

Проблема была в модуле памяти нетворк процессоров. Вендор плашки SMART.

+1

Вендор плашки не слишком интересен. Куда интереснее производитель чипов памяти.

Кстати, soar, аналогично. На той фотографии разглядеть маркировку невозможно. Может, сзади будут незаклеенные чипы?

Напомню, что указанный в статье брак подразумевает конкретный триггер отказа — перезагрузку или включение питания. Если железка после долгого аптайма взяла и упала в процессе работы, то это другая проблема (возможно, тоже с памятью — она и без всякого брака может умирать).

Кстати, soar, аналогично. На той фотографии разглядеть маркировку невозможно. Может, сзади будут незаклеенные чипы?

Напомню, что указанный в статье брак подразумевает конкретный триггер отказа — перезагрузку или включение питания. Если железка после долгого аптайма взяла и упала в процессе работы, то это другая проблема (возможно, тоже с памятью — она и без всякого брака может умирать).

0

У нас эйс помер как раз после апдета софта и ребута. Так-что похоже у нас как раз этот случай.

0

Ну собственно мои подозрения по поводу виновника торжества подтверждаются, причем с точностью до буквы. См. мою фотографию под спойлером. Спасибо!

0

Кстати первый раз вижу чипы с маркировкой MT. Хотя гугл говорит, что это старый, добрый Micron.

0

Да… Когда-то, во времена DDR2, «микроновская память» значило «покупаешь бюджетную плашку и практически гарантированно разгоняешь ее раза в полтора, обгоняя многую стоящую в разы больше экстремальную память, при этом почти не греясь». Это в контексте десктопных компьютеров, разумеется. Хорошие они делали чипы.

0

0

Не… blogs.wsj.com/digits/2014/02/13/microns-name-emerges-in-cisco-memory-flap/

Но мы окончательно это доказали — вроде больше никто не догадался просто сравнить маркировку чипов, как ни странно :)

Но мы окончательно это доказали — вроде больше никто не догадался просто сравнить маркировку чипов, как ни странно :)

0

так вот в чем причина смерти 3-х железок.

И чем дальше в список, тем больше там боли.

И чем дальше в список, тем больше там боли.

0

Это объясняет неожиданные смерти 5505 и 1801.

0

Это неловкое чувство когда 80% критичного оборудования в списке, аптайм более 3х лет и из-за политической ситуации возможны долговременные перебои со светом, пойду отложу пару кирпичей и проверю запас топлива на ДГУ.

+1

Как вариант, можно строить резервированные схемы на оборудовании разных вендоров.

В статье Gartner говорилось об использовании нескольких сетевых вендоров в одной сети и связанное с этим снижение стоимости владения оборудованием (TCO).

Для большей надежности такой подход мы стараемся практиковать у клиентов.

В статье Gartner говорилось об использовании нескольких сетевых вендоров в одной сети и связанное с этим снижение стоимости владения оборудованием (TCO).

Для большей надежности такой подход мы стараемся практиковать у клиентов.

0

Это надежнее. Однако:

1) Сопровождать такую сеть будет сложнее. Администраторам надо будет знать много специфики по каждому из вендоров. Возможно увеличение затрат на обучение.

2) Некоторые инструменты, ориентированные на продукцию одного вендора, может потребоваться выкинуть в пользу менее навороченных. К примеру, прощай, Prime.

3) В некоторых случаях придется отказаться от проприетарных, но очень вкусных технологий. Есть причина, по которой Cisco такие деньги дерет за свое железо и софт — там много интересного. И у Juniper тоже, и они тоже стоят дорого. В Huawei вкусного мало, стоят дешево, по качеству работы (исходя из мнений тех, кто с ними сталкивался) полностью соответствуют своей стоимости. Коллеги, без обид :)

Это, разумеется, в случае архитектур вроде «из двух резервирующих друг друга маршрутизаторов один Cisco, другой Juniper». Если мы говорим о «все роутеры циски, все свитчи аристы», то я как-то не вижу особого повышения надежности. При описанном дефекте у вас все равно отъезжает целый слой топологии.

1) Сопровождать такую сеть будет сложнее. Администраторам надо будет знать много специфики по каждому из вендоров. Возможно увеличение затрат на обучение.

2) Некоторые инструменты, ориентированные на продукцию одного вендора, может потребоваться выкинуть в пользу менее навороченных. К примеру, прощай, Prime.

3) В некоторых случаях придется отказаться от проприетарных, но очень вкусных технологий. Есть причина, по которой Cisco такие деньги дерет за свое железо и софт — там много интересного. И у Juniper тоже, и они тоже стоят дорого. В Huawei вкусного мало, стоят дешево, по качеству работы (исходя из мнений тех, кто с ними сталкивался) полностью соответствуют своей стоимости. Коллеги, без обид :)

Это, разумеется, в случае архитектур вроде «из двух резервирующих друг друга маршрутизаторов один Cisco, другой Juniper». Если мы говорим о «все роутеры циски, все свитчи аристы», то я как-то не вижу особого повышения надежности. При описанном дефекте у вас все равно отъезжает целый слой топологии.

+1

Вдоволь помучавшись с гетерогенными/мультивендорными сетями, в свое время пришел к выводу, что это зло. Гартнер конено же авторитетные товарищи, но я все же посмотрел оригинал. Исследование высасоно из пальца. Ни одного факта. И сплошной батхерт.

Некоторые цитаты:

CCIE в основном прячутся по партнерам и огромным корпорациям. Далеко не все организации, могут себе из позволить. Поэтому их ни так уж и много. Вот данные Cisco «Today, CCIE certification holders represent less than 3% of all certified Cisco professionals and less than 1% of the networking professionals worldwide.»

Все же организациям прийдется раскошелиться еще и на специалистов по другим вендорам…

Говорят, что миф. Я могу сказать, что не миф. Особенно, если поддержка только от одного вендора с которой «не угадали». Говорю это т.к. часто мы решаю проблемы, которые другие вендоры решить не могут.

В примере сложности приводят примеры бардака, который развели организации… И считают, что это вендор сложный. Бред…

Сложный пункт. Тут двояко. Если каждый уровень сети дублировать вторым вендором, то конечно потребуется больше персонала. Если разделять вендоров на разные уровни, то нет. Я бы кстати задумался, что вы хотите делать у своих заказчиков. Полность параллельно две сети на разных вендорах? В моем понимании это ад… Хотя конечно есть компании которые так живут. Не по своей воли в большинстве случаев, а по причине поглащения/слияния.

Хорошее заявление на успех. Давайте купим лажовую поддержку у вендора, который её не предоставляет… За-то дешево.

Соглашусь. Миф. Но только, если нет изначальной заточки на вендоре. В противном случае попадаем на расходы по внедрению новой системы.

Мои выводы:

1.Если разделяете вендоров на разных уровнях, то все хорошо. Главное чтобы устраивал функционал и производительность. И чтобы этот вендор был Cisco :)

2. Если используете для обеспечения отказоустойчивости на одном уровне, то будут огромные расходы на проектирование. Ведь начать надо будет с лаборатории 1-в-1.

3. Если разные вендоры для обеспечения отказоустойчивости в параллельных сетях, то по большей части повторяет пункт 2 + доп расходы на обеспечение отказоустойчивости внутри каждой сети.

И все это выводы только для тех сетей, которые будут строиться с нуля. При модернизации уже имеющихся, затраты всегда больше.

Я бы все же не отказывался от проприетарных технологий обеспечения отказоустойчивости. В большинтсве случаев будет намного лучше чем в мультивендорной сети. Главное правильный дизайн.

Некоторые цитаты:

Training and Talent Myth: The market is filled with Cisco Certified Internetwork Expert (CCIE)

and other Cisco accredited network professionals, while finding certified staff for other vendors is

much more difficult.

CCIE в основном прячутся по партнерам и огромным корпорациям. Далеко не все организации, могут себе из позволить. Поэтому их ни так уж и много. Вот данные Cisco «Today, CCIE certification holders represent less than 3% of all certified Cisco professionals and less than 1% of the networking professionals worldwide.»

Все же организациям прийдется раскошелиться еще и на специалистов по другим вендорам…

Interoperability Myth: It's impossible to get two vendors' products reliably working together in a

network.

Говорят, что миф. Я могу сказать, что не миф. Особенно, если поддержка только от одного вендора с которой «не угадали». Говорю это т.к. часто мы решаю проблемы, которые другие вендоры решить не могут.

Complexity Myth: Adding another network infrastructure vendor more than doubles the

complexity of the architecture.

В примере сложности приводят примеры бардака, который развели организации… И считают, что это вендор сложный. Бред…

Staffing Myth: Double the number of network infrastructure vendors means increasing the

number of network staff.

Сложный пункт. Тут двояко. Если каждый уровень сети дублировать вторым вендором, то конечно потребуется больше персонала. Если разделять вендоров на разные уровни, то нет. Я бы кстати задумался, что вы хотите делать у своих заказчиков. Полность параллельно две сети на разных вендорах? В моем понимании это ад… Хотя конечно есть компании которые так живут. Не по своей воли в большинстве случаев, а по причине поглащения/слияния.

Equipment and Maintenance Cost Myth: Loyalty to the incumbent vendor provides an

opportunity to negotiate the best deals and keep costs under control.

Хорошее заявление на успех. Давайте купим лажовую поддержку у вендора, который её не предоставляет… За-то дешево.

Network Management Myth: Adding a second vendor will require the purchase of a lot of extra

management tools.

Соглашусь. Миф. Но только, если нет изначальной заточки на вендоре. В противном случае попадаем на расходы по внедрению новой системы.

Мои выводы:

1.Если разделяете вендоров на разных уровнях, то все хорошо. Главное чтобы устраивал функционал и производительность. И чтобы этот вендор был Cisco :)

2. Если используете для обеспечения отказоустойчивости на одном уровне, то будут огромные расходы на проектирование. Ведь начать надо будет с лаборатории 1-в-1.

3. Если разные вендоры для обеспечения отказоустойчивости в параллельных сетях, то по большей части повторяет пункт 2 + доп расходы на обеспечение отказоустойчивости внутри каждой сети.

И все это выводы только для тех сетей, которые будут строиться с нуля. При модернизации уже имеющихся, затраты всегда больше.

Я бы все же не отказывался от проприетарных технологий обеспечения отказоустойчивости. В большинтсве случаев будет намного лучше чем в мультивендорной сети. Главное правильный дизайн.

0

..

0

Кстати, а распаянная на платах (1841) память тоже подвержена данному деффекту?

0

Там более чем на половине устройств из списка память распаяна. Проблема-то с самими чипами. Какая разница, на чем они висят? А вот администратору сложнее заменить при поломке, это да.

0

Ага, тут написано открывать RMA для всей железки.

Ещё в FAQ написано следующее:

Я правильно понимаю, что в России покупатели остались наедине с проблемой? LLHW у нас не действует, так что без Смартнета даже при действующей гарантии заяку не открыть.

Ещё в FAQ написано следующее:

In other circumstances (eg. out of warranty or out or contract), we'd encourage you to raise your concern directly with your Cisco account team.

Я правильно понимаю, что в России покупатели остались наедине с проблемой? LLHW у нас не действует, так что без Смартнета даже при действующей гарантии заяку не открыть.

0

Ага, тут написано открывать RMA для всей железки.

18XX — да. 28ХХ — можно только память махнуть.

Я правильно понимаю, что в России покупатели остались наедине с проблемой?

Так и у русских клиентов есть аккаунт тим, с которым можно обсудить вопрос. Как я писал выше — вопрос явно решается в индивидуальном порядке. Не исключаю, что можно договориться и на замену памяти до аварии, без RMA.

Что до гарантии — так ведь это аппаратная поломка. Продавец (не циска, именно продавец) обязан принять железку, никуда он не денется. Но скорость получения замены будет далеко не смартнетовской.

0

Так и у русских клиентов есть аккаунт тим, с которым можно обсудить вопрос.

Имеется ввиду ентерпрайз?

Что до гарантии — так ведь это аппаратная поломка. Продавец (не циска, именно продавец) обязан принять железку, никуда он не денется. Но скорость получения замены будет далеко не смартнетовской.

У большинства продавцов циски идут с 90 дневной гарантией.

0

Имеется ввиду ентерпрайз?

Провайдеры наверняка тоже. Предположу, что у любого клиента циски есть контакт, с которым можно обсудить такие вопросы. А SOHO вряд ли покупают смартнеты, у них вроде принято у интеграторов поддерживаться.

У большинства продавцов циски идут с 90 дневной гарантией.

Ну я слабо в этом разбираюсь, так как обычно сходу беру со смартнетами… Однако, даже 2-летняя гарантия при описанной проблеме не факт что помогла бы. Дефект такой, что прямо мечта производителя любого бытового железа: таймбомба, которая наверняка переживет гарантийный срок, но не очень надолго, и клиент побежит покупать новое устройство :)

0

ТОЛЬКО ЧТО сдохли две платы WS-F6700-DFC-3B как и положено ОДНОВРЕМЕННО. Сами «противни» WS-X67xx исправны, вылетела именно «дочка» DFC. Временно поставили старенькие CFC и быстро-быстро купили DFC-шки у nag.ru (это не реклама если что, просто им спасибо),

Там стоят чипы памяти Samsung в BGA и Micron в LCC, в принципе ремонтники ноутбуков могут перекинуть если найти чипы. Судя по картинке автора поста — дохлые чипы именно микроновские. «Неназванный производитель памяти», хехе

Там стоят чипы памяти Samsung в BGA и Micron в LCC, в принципе ремонтники ноутбуков могут перекинуть если найти чипы. Судя по картинке автора поста — дохлые чипы именно микроновские. «Неназванный производитель памяти», хехе

0

Как временный воркараунд можно использовать старые SO-DIMM из ноутбуков. Только разумеется в TAC об этом сообщать не следует.

0

Sign up to leave a comment.

«Memory Component Issue», или масштабный брак сетевого оборудования