Comments 100

Осталось дождаться 1080Ти и старшую Вегу — посмотреть, что за монстров выкатят на этот раз.

0

Сам жду с нетерпением. Само собой, это не мэйнстримовое железо, и оно мало кому доступно, но безумно интересно, что там будет. У 1080Ti, ожидаемо, 10 Гб памяти, отключат пару-тройку кластеров в GP 100 и, скорее всего, будет GDDR5X, а не HBM 2. А вот что нарисует AMD — пока полная загадка. Впрочем, так даже лучше — больше интрига, приятнее потенциальный сюрприз от красных. Надеюсь, у них получится достойный флагман.

0

Копипастить с 4PDA (4pda.ru/2016/12/19/331868) — это явно не то, чего ожидают читатели Geektimes.

-1

Ещё бы Ризен у АМД удался и Оптан у Интела — и тогда 2017 вообще лютый по железу год будет.

Да ещё и в конце года будет инфа по Вольте…

Да ещё и в конце года будет инфа по Вольте…

+2

А можно вопрос?

и далее, по описанию — обычный Tripple buffer, который был кажись в риве тнт, если не раньше и он наоборот увеличивал задержку. В чем новшество?

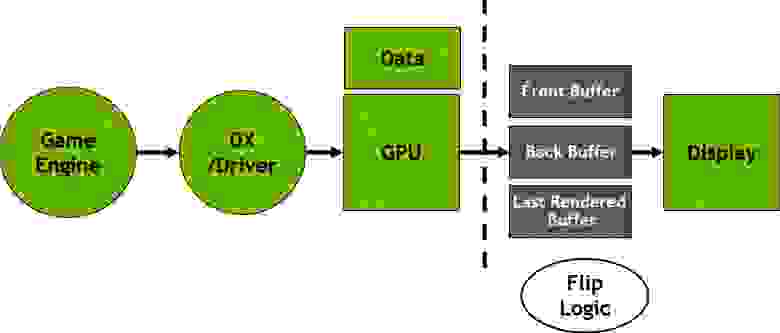

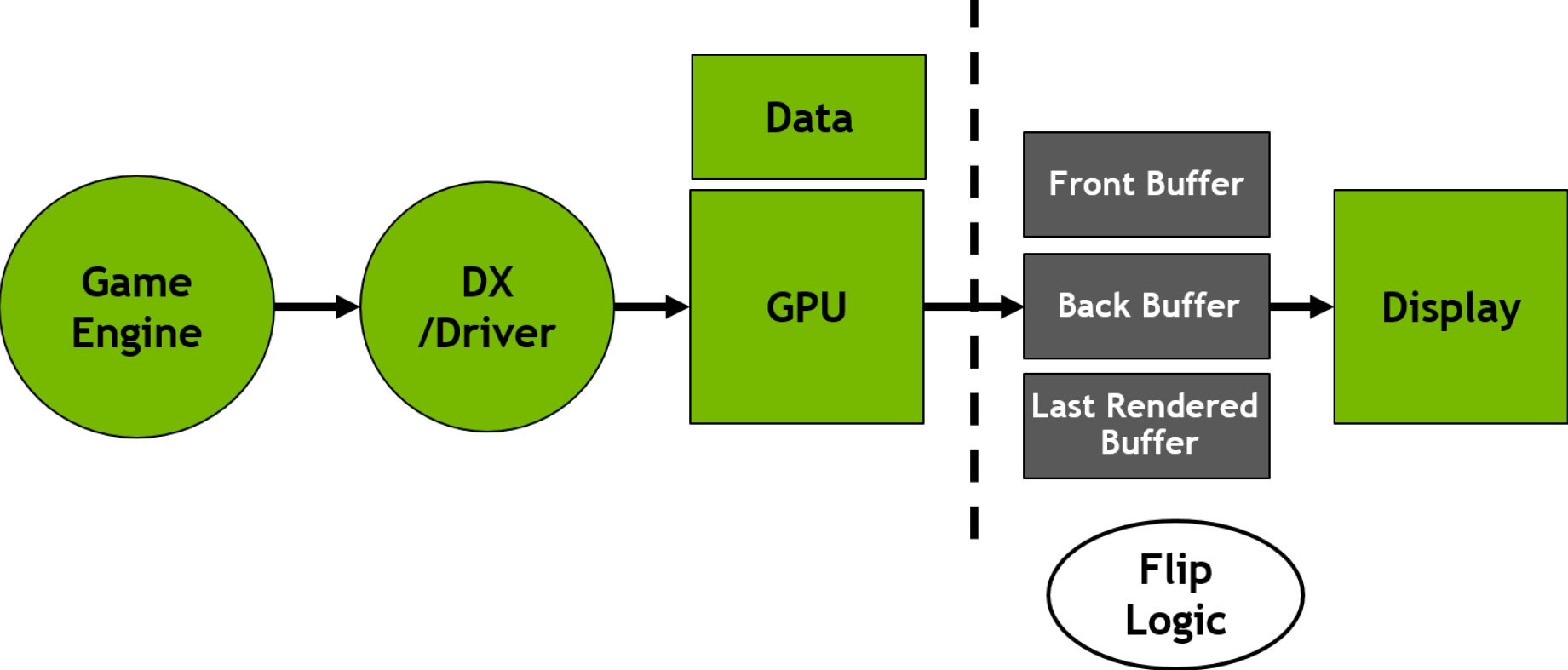

Самая главная фишка Pascal’я — тройной буфер для вывода кадров

и далее, по описанию — обычный Tripple buffer, который был кажись в риве тнт, если не раньше и он наоборот увеличивал задержку. В чем новшество?

+1

В том, что тройная буфферизация уменьшает артефакты изображения, но не убирает полностью разрывы. В буфферы копируются кадры вне зависимости от их состояния, и если ваша видеокарта выдаёт условных 90 кадров в секунду, а монитор умеет показывать только 60, то читать монитор будет полтора кадра. При включённом FastSync в буфер попадают только полностью отрисованные кадры, и монитор при превышении кадровой частоты будет получать только полные кадры. Да, кое-какие задержки появляются, но они намноооооооооого меньше тех, которые выдаёт V-Sync.

0

Спасибо за обращение внимания на этот момент. Так бы и не знал. Недавно как раз купил 1060 на замену старенькой 570 (а в прошлом году хотел было взять 970, но в связи со скачками курса и определенными личными обстоятельствами решил что это не обосновано). В этом году все же купил, но уровнем пониже — 1060. Кстати сказать, 570 — предтоп в свое время покупался «всего» за 13 тыс., а мейнстрим 1060 (6 гиговая) нынче вышел в «всего» 17,5 тыс (это еще с учетом бонусов от предыдущих покупок в 1,5 тыс), а полная цена от 19 (ну есть чуть дешевле, но более тоскливые варианты), а 1070, которую я в общем-то и хотел приобрести (т.к. монитор у меня 2560х1440), стоит от 27, что более чем в 2 раза дороже чем 570 и для меня не приемлемо. Понятно что дело в очередном одревянивании рубля, а не в удорожании видиокарт, но зарплата-то не выросла в 2 раза, а плясать как ни крути, приходится от неё. Это я так, к слову «всего» применительно к цене.

А в настройках драйвера к сожалению нет такого пункта «fastsync». Перевели слишком усердно — пункт в самом низу списка выглядит как просто «быстро»! Вот надмозги! Включил одновременно её и тройной буфер. Надо только сравнить с предыдущим вариантом «адаптивная синхронизация», которая включает синхру при высокой частоте кадров и отключает, если видюха не справляется и дает частоту меньше монитора. Тоже неплохой был вариант. Буду ждать развернутого сравнения, как обещано.

А еще хотелось бы все таки увидеть какие-то рекомендации о том, где именно можно увидеть всё это новое богатство. Предложенный набор игрушек лично меня ни сколько не вдохновляет — это уж дело вкуса… А еще хотелось бы увидеть разбор перспектив многокарточных конфигов. nV сделала легкий взмах серпом пояй… контактам sli в семействе младших карт, чтобы не оказалось что две 1060 в одном компе так же быстры и при том дешевле одной 1080. Однако в DX12, я знаю, есть возможность использовать мульти-гпу режим и его собственными средствами (причем эффективнее чем слай-кросфайр -суррогатами). Где-то это есть или ожидается? Это я к тому, что на мои 1440р через год-два где-то может и не хватить одной 1060, но купить вторую к тому времени будет не просто а очень просто и дешево. Дешевле чем обновить до тогдашних вариантов. Я думал что может выпустят какую-нибудь 1060ti, с контактами, но не случилось. Вот интересно, есть ли перспективы у моих ожиданий?..

А в настройках драйвера к сожалению нет такого пункта «fastsync». Перевели слишком усердно — пункт в самом низу списка выглядит как просто «быстро»! Вот надмозги! Включил одновременно её и тройной буфер. Надо только сравнить с предыдущим вариантом «адаптивная синхронизация», которая включает синхру при высокой частоте кадров и отключает, если видюха не справляется и дает частоту меньше монитора. Тоже неплохой был вариант. Буду ждать развернутого сравнения, как обещано.

А еще хотелось бы все таки увидеть какие-то рекомендации о том, где именно можно увидеть всё это новое богатство. Предложенный набор игрушек лично меня ни сколько не вдохновляет — это уж дело вкуса… А еще хотелось бы увидеть разбор перспектив многокарточных конфигов. nV сделала легкий взмах серпом по

0

Как будто никому не интересно, ну ладно… Проверил на fallout 4. На входе в даймонд сити при отключенном vsync частота кадров около 57-59 к/сек (во всех других местах 80 и более). Если подвигать мышью видны разрывы на изображении. Включил freeesync+triple buffer. Частота осталось той же самой, но разрывы пропали. Правда выпадения кадров естественно никуда не делись — если быстро повернуться на месте — видно подергивание движения там где видюха не успела сформировать кадр. В общем, работает отлично, но для идеальной плавности надо чтобы частота кадров не падала ниже мониторной.

0

Долго маялся выбирая из 1060 зеленых и 480 й красных. Выбрал последнюю и надо сказать не разочаровала.

0

AMD разочаровывает в последствии, когда не выпускает драйверы под новые оси, в то время как NVidia поддерживает драйверы даже для очень старых карт под новые ОС, не задействует возможности карт для современных нужд, как например декодирования 4k не появилось на ряде прошлых, даже очень мощных, моделей AMD, в то время как NVidia в этом плане выжала из своих карт все возможное.

0

в то время как NVidia поддерживает драйверы даже для очень старых карт

Просто замечательно они их поддерживают. С каждым новым обновлением ждёшь, какая игра перестанет нормально работать следующей? Уж не знаю, связано это с их попыткой исправлять кривые руки разработчиков игр или просто с желанием «урезать» функционал старых моделей, чтобы лучше покупали новые, но с каждым обновлением драйверов начинаются проблемы с играми которые раньше работали нормально. Уже доходило до того, что у меня был набор из четырёх разных версий драйверов, с каждой из которых нормально шла только одна игра. Это вот так они поддерживают старые карты? (GTX 690).

0

Бред.

Да бывают багнутые релизы, но зачастую сразу же выходят фиксы. И никто вам не мешает откатиться. В то время как AMD действительно кидает поддержку. Как на WIN так и на linux. Например под 4000 серию уже нет дров, в то время как нвидиа 8000 спокойно работает.

Да бывают багнутые релизы, но зачастую сразу же выходят фиксы. И никто вам не мешает откатиться. В то время как AMD действительно кидает поддержку. Как на WIN так и на linux. Например под 4000 серию уже нет дров, в то время как нвидиа 8000 спокойно работает.

+1

Вот и откатываюсь. Только откатываться приходится не чтобы подождать фикса, а чтобы вообще поиграть. pCARS, нормально работает только на версии которую качал два месяца назад. Чтобы поиграть в Planetside2 мне придётся ставить драйвер годичной давности, на новых 15 кадров в секунду. И они не собираются это исправлять.

0

> так и на linux

А вот не надо, пожалуйста. Поддержку проприетарного драйвера действительно прекращают, но он, тем более на старых картах, собственно и нафиг не нужен. То, что в Windows требует бубна и шаманств (читай — правильных версий драйверов, и неочевидной процедуры установки) а в частности, гибридные конфигурации Intel iGPU + Radeon dGPU, в Linux просто работает сразу из коробки со свободными драйверами, достаточно лишь вписать «DRI_PRIME=1 steam» в ярлык Стима. И это при том, что пары GPU, в которых хотя бы один из двух GPU не работает в Win10, в Win10 вообще не завести. В прошлом аналогичная ситуация была с ноутбуками HP, у которых интеграшка 42xx, а дискретка из шеститысячных — со свободными драйверами в Linux пахало, а проприетарные в Windows только древние с сайта вендора (в которых ещё не выкинули поддержку pre-Evergreen карт).

А вот не надо, пожалуйста. Поддержку проприетарного драйвера действительно прекращают, но он, тем более на старых картах, собственно и нафиг не нужен. То, что в Windows требует бубна и шаманств (читай — правильных версий драйверов, и неочевидной процедуры установки) а в частности, гибридные конфигурации Intel iGPU + Radeon dGPU, в Linux просто работает сразу из коробки со свободными драйверами, достаточно лишь вписать «DRI_PRIME=1 steam» в ярлык Стима. И это при том, что пары GPU, в которых хотя бы один из двух GPU не работает в Win10, в Win10 вообще не завести. В прошлом аналогичная ситуация была с ноутбуками HP, у которых интеграшка 42xx, а дискретка из шеститысячных — со свободными драйверами в Linux пахало, а проприетарные в Windows только древние с сайта вендора (в которых ещё не выкинули поддержку pre-Evergreen карт).

0

> 690

Двухчип же. Все, кто покупают двухчип, принимают оферту: мне настолько не хватает флагманского одночипа, что готов на любые проблемы.

Проблемы возникают даже когда карта актуальна. Одни ждуны SLI-профайлов чего стоят

Двухчип же. Все, кто покупают двухчип, принимают оферту: мне настолько не хватает флагманского одночипа, что готов на любые проблемы.

Проблемы возникают даже когда карта актуальна. Одни ждуны SLI-профайлов чего стоят

0

Когда у меня возникают проблемы в режиме SLI, я молчу в тряпочку, я знал на что иду (хоть и не подозревал что будет всё настолько плохо). Проблемы остаются и при использовании только одного ядра. Хотя вопроса об обновлении драйверов это всё же не снимает. Зачем ломать то, что уже работало? От секты мучеников CrossFireX я слышал о проблемах, но адепты уверяют что с каждым обновлением часть проблем уходит, а не добавляются новые. Что не так с NVidia?

0

Что за чушь? Я только неделю как сменил свою старую 570 и никаких засад с драйверами никогда не видел. Правда я не игроман — не играю во все новые распиаренные игрухи. Может в каких-то из них что-то такое и было. Но вряд ли. Опыт показывает, что винда у активных пользователей (которые постоянно что-то устанавливают, удаляют, переустанавливают..) со временем портится. Какие-то файлы или ключи реестра или еще что-то говняются и начинаются странные спотыкания на ровном месте. Сам недавно всё снес из-за странностей работы с видеокамерой. Но у меня -то винда стояла с тех самых пор как вышла 7--ка после висты, так что давно пора было. И такие примеры наблюдаются регулярно. У знакомого перестала одна игруха запускаться… Все «очистки системы» не помогли. Переставили винду (а была она порядком засрана) — куда что делось! Так что прежде чем гнать волну на такую злобную nv, надо бы разобраться в чем действительно причина.

0

Посмотрел тесты и не понял чем же она Вас не разочаровала…

0

А по тестам как раз и видно чем: Джифорс быстрее примерно на 10%, но дороже примерно на 25%

0

А по новым тестам 1060 уже и не впереди.

Да и у AMD есть FreeSync. С ней еще большая экономия($100-200) на мониторе.

Да и у AMD есть FreeSync. С ней еще большая экономия($100-200) на мониторе.

0

Заодно RX горячее

0

А я долго маялся выбирая из 1060 зеленых и 480 й красных. Выбрал первую и надо сказать не разочаровала ;)

+3

GTX 1050(Ti) для HTPC — идеальный вариант: маленькая, холодная, производительная и не требует доп.питания.

0

А куда делся Titan X Pascal?

0

Говорим «давай, до свиданья» всяким 780 Ti, R9 390X и прочим прошлогодним 980-м, особенно если хотим играть в высоком разрешении.Вот блин, купил её сдуру год назад… Впрочем, видюшка до сих пор радует на Full HD, ни лагов, ни багов, дровишки свежие выходят каждый месяц. Думаю, ещё пару лет протянет, и потом куплю какой-нибудь GTX 1280 Ti SubZero Edition…

0

Я приобрёл 1070 и, сказать честно, просто в восторге. Возможно, конечно, что это у меня на контрасте такие радости (была 760я), но карточка просто огонь. В 1080р я просто не задумываюсь о настройках графики, просто на максимум выкручиваешь и всё, если уже очень хочется. А если не хочется, то карточка почти и не греется (зимой теперь проблема — в небольшой комнате компьютер имел стратегическое значение для отопления). Теперь, наверное, нужно будет взять 1440р монитор с G-Sync и посмотреть, как это будет выглядеть.

+1

Как ни странно, GTA V на максимально возможных настройках графики в 1080p ставит на колени мою GTX1080. Так что задумываться все же иногда нужно ;)

0

Что-то не так с конфигом, я выжимал больше 60 FPS на 1080р в 4k. Проц? Память? Что-то ещё? А, ну и вопрос настроек Motion Blur'а / DoF'а, они в GTA на колени поставят кого угодно. :(

0

Как ниже уже написали, проверьте antialiasing и его версию. Очень рекомендую разобраться, там теперь зоопарк из разных версий.

0

Теперь представь, как себя чувствую я, купив 1070 после 9600 GT и Intel HD Graphics 530.

0

Раз уж тут тема про видеокарты, закину и я свой вопрос: взял palit 1060 3Gb на замену GT640. И получил нестабильную систему. FPS в среднем вырос, но через каждый 15-120 секунд случаются просадки на 1-3сек с комфортных 70-80fps до неприемлемых 5-15fps. С чем это связано уже второй месяц бьюсь в поисках. C GT640 такого не было, даже позволяла на второй монитор фильмы одновременно выводить, и на большинстве игр это не отражалось. Драйвера ставил, менял, сносил все, пробовал 3 разные версии из последних. Думал что БП не тянет (китай 800W), но смена не помогла тяжелый Zalman 600 даёт тот же эффект. Система FX8350+16RAM+SSD+WIN7. Носил карту к другу с похожей, но чуть слабее системой но win10 — работает без нареканий. Может кто сталкивался? где копать? ТП в группе вконтакте только руками разводят.

0

UFO just landed and posted this here

в небольшой комнате компьютер имел стратегическое значение для отопления

Это божественно! У меня 2х560. Топка обогревает всю комнату.

0

Можно пару вопросов?

Имеет ли смысл сейчас менять 980ti и если да то на что? Даст ли 1070 заметный скачок в производительности или для этого надо 1080?

И как именно и почему умирает SLI?

Имеет ли смысл сейчас менять 980ti и если да то на что? Даст ли 1070 заметный скачок в производительности или для этого надо 1080?

И как именно и почему умирает SLI?

0

980Ti менять смысла особого не вижу, разница с 1080 есть, но не такая, чтоб сломя голову нестись в магазин. Если вам не критично играть на ультра-фигультра настройках со всеми-всеми доп. плюшками — я б подождал годик.

SLI умирает (как и все многочиповые конфиги) из-за всё более и более активного применения в играх темпоральных техник (использования информации с прошлого кадра), что сильно бьёт по производительности, скажем, при работе в режиме чередования кадров. У видеокарты просто нет предыдущего кадра, есть пред-предыдущий. А значит надо предыдущий запросить у сестрицы по SLI-мосту, или не использовать эту фичу. NVIDIA вроде как дала разработчикам возможность вручную управлять SLI-производительностью в новых API, параллелить нагрузку и всё такое, но судите сами: много у кого стоят две видеокарты? Будут разработчики активно тратить человеко-часы на интеграцию новых фич, отладку, полировку, оптимизацию? Или этим должна заниматься NVIDIA в других играх? Ну и Legacy-костыли самой технологии потихоньку дают о себе знать.

SLI умирает (как и все многочиповые конфиги) из-за всё более и более активного применения в играх темпоральных техник (использования информации с прошлого кадра), что сильно бьёт по производительности, скажем, при работе в режиме чередования кадров. У видеокарты просто нет предыдущего кадра, есть пред-предыдущий. А значит надо предыдущий запросить у сестрицы по SLI-мосту, или не использовать эту фичу. NVIDIA вроде как дала разработчикам возможность вручную управлять SLI-производительностью в новых API, параллелить нагрузку и всё такое, но судите сами: много у кого стоят две видеокарты? Будут разработчики активно тратить человеко-часы на интеграцию новых фич, отладку, полировку, оптимизацию? Или этим должна заниматься NVIDIA в других играх? Ну и Legacy-костыли самой технологии потихоньку дают о себе знать.

+1

То есть нет смысла строить SLI/CrossFire-систему?

0

UFO just landed and posted this here

Ну я так понял, что для тех, которые прям совсем не поддерживают, можно одну карточку временно отключать?

0

Имеет ли смысл сейчас менять 980ti и если да то на что? Даст ли 1070 заметный скачок в производительности или для этого надо 1080?980ti и 1070 имеют примерно равную производительность, да и 1080 не сильно оторвалась, не стоит овчинка выделенки

+1

Коротко: половина (а может и больше) игр его не поддерживает. А половина оставшихся безбожно глючит.

0

я почему то всегда считал что поддержка SLI в играх — это просто оптимизация. а так игровая графика распределяется по картам на уровне драйверов, прозрачно для игр.

0

Во-первых, если nvidia не протестировала игру со SLI и не пометила игру, как совместимую, то он там просто не включится. А таких игр много. И даже если включить насильно, во многих играх это просто нормально не заработает. Будут дерганья, визуальные глюки, черный экран и прочее. Иногда FPS вырастает вдвое, но фактически просто по два раза показывается один и тот же кадр.

Даже «поддерживаемые» игры зачастую глючат. Например, в WarThunder на земле появляются черные мерцающие квадраты.

В общем, я решил, что SLI больше никогда не поставлю.

Даже «поддерживаемые» игры зачастую глючат. Например, в WarThunder на земле появляются черные мерцающие квадраты.

В общем, я решил, что SLI больше никогда не поставлю.

0

блин, а вот это реально интересно. я про такое ни разу не слышал вообще. может быть напишете статью про текущую ситуацию со SLI? с неким обзором современных игр с официальной поддержкой и без.

0

Может кто, разбирающийся — напишет статью про производительность CUDA? А то, что-то не очень понятно. Например вроде как например GTX 580 при ее 512 ядрах CUDA будет производительней (или также) при рендеринге видео чем более старший собрат GTX 660 с 960 ядер куда.

Есть какая-то таблица реальной производительности может?

Есть какая-то таблица реальной производительности может?

0

Странно, звук почему-то совершенно не объёмный на демо-ролике про новую возможность симуляции отражений звука. Возможно источник является моно-записью и реверберация работает с ним как с моно-сигналом, такой же эффект наблюдается при работе с таким звуком в аудио-редакторах.

0

UFO just landed and posted this here

Потому что источник звука совмещен с камерой. В момент когда его отсоединяют можно уловить разницу между ушами. Правда объемность при этом заметить сложно.

0

UFO just landed and posted this here

Совмещение с камерой всё же я думаю не должно реверберацию тоже превращать в моно-эффект. Думаю всё же, что источник мог быть моно-записью и обработка реверберацией повела себя с ним именно как с моно-записью. В аудиоредакторах, например, для создания стерео-реверберации — монозапись надо заведомо переопределить как стереозвук — и тогда реверберация становится объёмной. Здесь же явно все отражения собраны посередине, что в таком помещении как на видео не должно происходить. Временами здесь звук перемещается влево и вправо, но это простой Panning

0

UFO just landed and posted this here

Забыли уточнить, что мобильные версии видеокарт теперь не имеют приставку «М» и отличаются производительностью лишь на 5-10% от десктопной версиии. Как было ранее — 960М имела уровень производительности 760 и тд. Лишь некоторые монстры, например GX700, имел в себе полноценную 980 без приставки «М». Сейчас все гораздо лучше, купить ноутбук с 1060, ты получаешь 1060, без всяких недомолвок)

0

Жду свой EVGA ASC Gaming GTX 1080. Все никак не привезут. Спасибо за статью, очень интересная!

+1

Удивительно, что новая 1080 founders edition еще и тихая. В простое тише моего ныне покойного hdd из серии WD Green. И електричества ест мало — комп с i7-6700 потребляет 50 Вт, опять же в простое.

0

Замечательная производительность, отлично. Но посмотрим сколько будут жить эти видеокарты на новом техпроцессе, учитывая, что их ещё и «буст» гонит до 2000. Охх чувствую лететь они будут массово…

Если и на 28-нм чипы отслаивались от посадочной пластины довольно часто и далеко не всегда из-за любителей разгона, то теперь по логике это должно происходить раза в 4 чаще. Только если они не изменили способ изготовления чипов для продления их жизненного цикла…

Если и на 28-нм чипы отслаивались от посадочной пластины довольно часто и далеко не всегда из-за любителей разгона, то теперь по логике это должно происходить раза в 4 чаще. Только если они не изменили способ изготовления чипов для продления их жизненного цикла…

-1

А как насчет OpenCL?

Хочется чего-то бюджетного чтоб быстро считать гидродинамику на решетках Больцмана. (на Линуксе)

Чего порекомендуете?

Хочется чего-то бюджетного чтоб быстро считать гидродинамику на решетках Больцмана. (на Линуксе)

Чего порекомендуете?

0

Вы думаете, что для гидродинамики именно на решётках Больцмана что-то подходит больше? Вряд ли nvidia сделали специализированную версию железа для какого-то выделенного класса алгоритмов.

0

Я спрашивал про OpenCL.

Про алгоритм просто упомянул, для ясности.

(Для решетки Больцмана есть разные реализации, и на OpenCL, и на Cuda, и для обычных ЦПУ.

Просто, я думаю, OpenCL самое стандартное для такого типа задач, которое должно работать на всем, и на красном и на зеленом. А Cuda пропраитарное, только для зеленых.)

Про алгоритм просто упомянул, для ясности.

(Для решетки Больцмана есть разные реализации, и на OpenCL, и на Cuda, и для обычных ЦПУ.

Просто, я думаю, OpenCL самое стандартное для такого типа задач, которое должно работать на всем, и на красном и на зеленом. А Cuda пропраитарное, только для зеленых.)

0

Вычислительный шейдер в OpenGL — ещё более «стандартное» решение. Там достаточно просто чтобы меса реализовывала версию 4.3

0

Если писать именно на OpenCL и это решено, то лучше свежие карты красных (RX 460/470/480 в зависимости от желаемого уровня бюджетности). NV все усилия направляет на продвижение собственной CUDA платформs и оптимизацию драйверов и библиотек приоритетно ведет для нее. А OpenCL по остаточному принципу — работает и ладно. В результате в расчетных задачах на OpenCL чаще всего проигрывают картам AMD аналогичного класса, бывает раза в 1.5.

Ну или если б/у то сейчас недорого 7970 сливают обновляющиеся — горячие, но знатные числодробилки.

Ну или если б/у то сейчас недорого 7970 сливают обновляющиеся — горячие, но знатные числодробилки.

0

UFO just landed and posted this here

По какому принципу в NVIDIA выбирают учёных для кодовых названий?

0

UFO just landed and posted this here

Не так давно померла моя GTX 580, сейчас смотрю на что ее можно поменять — б/у GTX 770 (6-7к) или новая 1050Ti.

0

Ощущение, что этот Pascal вышел весь проблемным.

Сначала проблемы с GTX 1070 и памятью Micron, где нужно аж прошить bios!

Теперь ещё зашквар в виде DPC Latency во всей линейке Pascal.

Проходняк какой-то, а не новая архитектура, сплошной бета тест за мои же $.

Я сам хотел брать gtx 1080, но теперь думаю, придётся ждать Volta, может хоть там не будет таких жёстких багов.

Сначала проблемы с GTX 1070 и памятью Micron, где нужно аж прошить bios!

Теперь ещё зашквар в виде DPC Latency во всей линейке Pascal.

Проходняк какой-то, а не новая архитектура, сплошной бета тест за мои же $.

Я сам хотел брать gtx 1080, но теперь думаю, придётся ждать Volta, может хоть там не будет таких жёстких багов.

-1

Поменял 970, сначала на 980, потом на 1080. Вобщем, для всех этих видеокарт нужны игры, которые используют многопоточность на полную, ну и современные API — DX12, Vulkan. Самое смешное, что 1080 покупалась для DCS World. В итоге — на 970 загрузка видеокарты 60%, на 980 — 40%, на 1080 — 20%. Такая же ситуация с X-Plane. При этом FPS никак не меняется, иногда даже меньше на пару кадров на 1080. При загрузке фактически одного ядра на 70%. Ужасные однопоточные игры… В Rise of the Tomb Rider DX12 — загрузка процессора 100%, все 8 потоков, видеокарты 100%. Эх, больше бы таких хорошо оптимизированных игр… Ну и все же справедливости ради надо заметить, что 1080 — это не 4k карта всё еще. Поэтому ждем Volta, правда похоже еще год ждать.

0

Как и многие здесь, долго маялся с выбором в октябре, в итоге взял 750Ti…

Серьезно.

При условно неограниченном бюджете на апдейт.

Если бы производителем не была обрублена возможность ставить их в SLI, обновил бы материнку, и поставил две.

Вот так выглядит мое мнение о новинках NVIDIA и их соотношении цена/производительность/энергопотребление.

Серьезно.

При условно неограниченном бюджете на апдейт.

Если бы производителем не была обрублена возможность ставить их в SLI, обновил бы материнку, и поставил две.

Вот так выглядит мое мнение о новинках NVIDIA и их соотношении цена/производительность/энергопотребление.

0

Sign up to leave a comment.

Гайд по Pascal: разбираемся в видеокартах NVIDIA 2016 года