7 марта 2001

Анализ истории техники показывает, что количество технологических изменений возрастает экспоненциально, хотя интуитивно, с точки зрения «здравого смысла», кажется, что развитие происходит линейно. То есть, развитие за 100 календарных лет 21-го века будет приблизительно соответствовать 20000 годам развития при сегодняшнем его темпе. Отдача, или результаты прогресса, такие, как скорость чипов или соотношение цена-эффективность, также растут экспоненциально. Иногда, даже сама скорость экспоненциального роста растёт экспоненциально. В течение нескольких десятилетий машинный интеллект превзойдёт человеческий, что приведёт к Сингулярности — технологическим изменениям столь быстрым и глубоким, что они разорвут саму ткань человеческой истории. Среди последствий будут слияние биологического и небиологического интеллекта, бессмертные люди, существующие в виде программного обеспечения, и интеллект чрезвычайно высокого уровня, распространяющийся по вселенной со скоростью света.

Вы получите 40 триллионов долларов, просто прочитав это эссе и поняв, о чём в нём идёт речь. Для получения полной информации, смотрите ниже. (Да, зачастую авторы идут на любые ухищрения, чтобы завладеть вашим вниманием, но я совершенно серьёзен насчёт этого утверждения. Однако, пока я не вернулся к дальнейшему повествованию, внимательно прочтите первое предложение этого абзаца).

Теперь вернёмся к будущему: большинство представляет его себе неправильно. Наши предки полагали, что будущее будет очень похоже на их настоящее, которое, в свою очередь, было очень похоже на их прошлое. Хотя экспоненциальные тренды существовали тысячи лет назад, они были в той, самой ранней, стадии, когда экспоненциальный тренд настолько плоский, что выглядит, как всякое отсутствие трендов. Таким образом, их предположения, по большей части, оправдывались. И сегодня, руководствуясь житейской мудростью, все ожидают постепенного технического прогресса и соответствующих социальных последствий. Но будущее будет гораздо более удивительным, чем большинство наблюдателей себе представляют: лишь немногие из них действительно осознали тот факт, что ускоряется сама скорость изменений.

Интуитивно-линейный взгляд против историко-экспоненциального взгляда

Большинство долгосрочных прогнозов технической осуществимости в будущие периоды времени драматически недооценивают мощь технологий будущего, поскольку были основаны на том, что я называю «интуитивно-линейным» взглядом на технический прогресс, а не на «историко-экспоненциальном» взгляде. Другими словами, это не тот случай, когда от двадцать первого века стоит ожидать ста лет прогресса, скорее, мы станем свидетелями двадцати тысяч лет прогресса (если иметь в виду прогресс при сегодняшнем его темпе).

Это несоответствие в представлениях о перспективе происходит часто и в различных ситуациях, например, при обсуждении этических вопросов, которые Билл Джой (Bill Joy) поднял в своей неоднозначной статье в WIRED «Почему мы не нужны будущему». Мы с Биллом часто пересекаемся на разных встречах, играя роль оптимиста и пессимиста соответственно. И хотя от меня ожидают критики позиции Билла, и я действительно вижу изъяны в предлагаемой им концепции «отказа», тем не менее я, как правило, в конечном итоге, защищаю Джоя по ключевому вопросу об осуществимости. Недавно, один из выступавших, лауреат Нобелевской Премии, отверг опасения Билла, заявив, что «мы не ожидаем увидеть самовоспроизводящиеся наноинженерные объекты ещё сотню лет». Я заметил, что 100 лет — это действительно разумная оценка времени, необходимого техническому прогрессу для достижения этой конкретной цели, при сегодняшней скорости его развития. Но поскольку темп прогресса удваивается каждые десять лет, мы увидим век прогресса на сегодняшней его скорости всего за 25 календарных лет.

Когда люди думают о будущем времени, они интуитивно предполагают, что нынешняя скорость прогресса сохранится и в будущем. Однако, внимательное рассмотрение темпов развития технологии показывает, что скорость прогресса не является постоянной, а человеку свойственно адаптироваться к изменяющемуся темпу таким образом, что интуитивно кажется, будто темп будет оставаться постоянным. Даже для тех из нас, кто пожил достаточно долго, чтобы ощутить, как ускоряется темп с течением времени, наша природная интуиция, тем не менее, создаёт впечатление, что прогресс идёт с такой же скоростью, какую мы ощущали последнее время. С точки зрения математика, основной причиной этого является то, что экспонента на коротких участках аппроксимируется прямой линией. Так, даже при том, что темпы прогресса в самом недавнем прошлом (например, в прошлом году) были намного больше, чем это было десять лет назад (не говоря уже про сто или тысячу лет назад), наш недавний опыт доминирует над воспоминаниями. Поэтому, совершенно обычное дело, когда даже искушённые комментаторы, рассуждая о будущем, в качестве основы своих ожиданий, экстраполируют нынешние темпы изменений на следующие 10 или 100 лет. Вот почему я называю такой вид взглядов на будущее — «интуитивно-линейным» взглядом.

А серьёзная оценка истории техники показывает, что технологические изменения экспоненциальны. При экспоненциальном росте мы обнаруживаем, что ключевой показатель, такой, как вычислительная мощность, умножается на постоянный коэффициент за каждую единицу времени (например, удваивается каждый год), а не просто увеличивается на некоторую величину. Экспоненциальный рост является характерной чертой любого эволюционного процесса, и развитие технологий может служить наглядным примером.

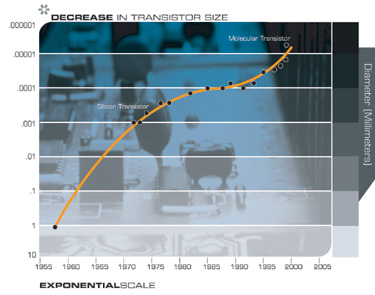

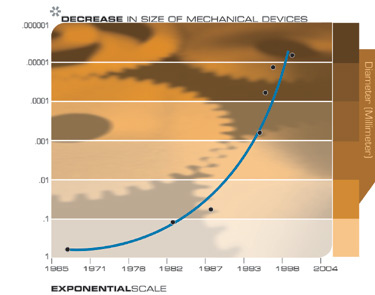

Можно по-разному оценивать данные, на разных временных масштабах, и для широкого спектра технологий, от электронных до биологических, наблюдается ускорение прогресса и скорости его роста. На самом деле, мы обнаруживаем не просто экспоненциальный рост, а «двойной» экспоненциальный рост, то есть скорость экспоненциального роста сама растёт в геометрической прогрессии. Эти наблюдения не относятся только к предположению о продолжении действия закона Мура (т.е. экспоненциальном сокращении размеров транзисторов в интегральной схеме), а основаны на представительной модели разнообразных технологических процессов. Это ясно показывает, что техника, и, в особенности, темп технологических изменений, ускоряется в (по крайней мере) геометрической прогрессии, а не линейно, и так происходит с самого момента возникновения техники и технологии, а на самом деле, с момента появления эволюции на Земле.

Я подчёркиваю этот момент, потому что тут совершают свою самую грандиозную ошибку прогнозисты, рассматривающие будущие тренды, и рассуждающие о возможном будущем. Большинство технологических прогнозов вообще игнорируют «историко-экспоненциальный» вид технического прогресса. Вот почему люди склонны переоценивать то, что может быть достигнуто в краткосрочной перспективе (потому как мы склонны отбрасывать необходимые детали), но недооценивать то, что может быть достигнуто в долгосрочной перспективе (потому как игнорируется экспоненциальный рост).

Закон ускоряющейся отдачи

Мы можем организовать эти наблюдения в то, что я называю законом ускоряющейся отдачи, следующим образом:

- Эволюция использует положительную обратную связь таким образом, что более эффективные методы, являющиеся результатом одной стадии эволюционного прогресса, используются для создания следующей стадии. В результате,

- скорость развития эволюционного процесса экспоненциально увеличивается с течением времени. Со временем, «порядок» информации, включённой в эволюционный процесс (т.е. мера того, насколько хорошо эта информация соответствует цели, каковой в процессе эволюции является выживание) возрастает.

- Соответственно, «отдача» эволюционного процесса (например, скорость, эффективность затрат, или общая «мощность» процесса) растёт экспоненциально с течением времени.

- В другой цепи положительной обратной связи, по мере того, как конкретный эволюционный процесс (например, вычисление) становится более эффективным (например, экономически эффективным), всё большие ресурсы выделяются для дальнейшего развития этого процесса. Это приводит ко второму уровню экспоненциального роста (то есть, скорость экспоненциального роста сама растёт экспоненциально).

- Биологическая эволюция является одним из таких эволюционных процессов.

- Технологическая эволюция — другой такой эволюционный процесс. Действительно, возникновение первого вида, создающего технологии, привело к новому эволюционному процессу технологии. Таким образом, технологическая эволюция является порождением и продолжением эволюции биологической.

- Конкретная парадигма (метод или подход к решению задачи, например, сокращение площади транзистора на интегральной схеме, как подход к созданию более мощных компьютеров) обеспечивает экспоненциальный рост до тех пор, пока метод не исчерпывает свой потенциал. Когда это случается, происходит смена парадигмы (то есть, фундаментальное изменение подхода), что позволяет продолжиться экспоненциальному росту.

Если мы применим эти принципы на высшем уровне эволюции на Земле, то первый шаг, создание клеток, ввёл парадигму биологии. Последующее появление ДНК обеспечило цифровой способ записи результатов эволюционных экспериментов. Затем, эволюция вида, который сочетал рациональное мышление с противопоставленным (т.е. большим) пальцем, вызвала фундаментальный сдвиг парадигмы от биологии к технологии. Грядущая смена главной парадигмы будет от биологического мышления к гибридному, сочетающему биологическое и небиологическое мышление. Этот гибрид будет включать в себя «метабиологические» процессы, полученные в результате реконструкции и копирования принципов работы биологического мозга.

Изучая сроки прохождения этих этапов, мы видим, что процесс непрерывно ускоряется. Эволюции форм жизни потребовались миллиарды лет для первых шагов (например, на простейшие клетки); в дальнейшем прогресс ускорился. Во время Кембрийского Взрыва, изменения основных парадигм занимали всего несколько десятков миллионов лет. Позднее, Гуманоиды развились за несколько миллионов лет, а Человек Разумный — всего за несколько сот тысяч.

С появлением вида, создающего технологии, экспоненциальный темп стал слишком быстрым для эволюции через ДНК-управляемый синтез белка и перешёл на технологии, созданные человеком. Технология выходит за рамки простого изготовления инструментов; это процесс создания всё более мощных технологий, использующих инструменты предыдущего раунда инноваций. В этом смысле, человеческая технология отличается от производства орудий труда у других видов. Каждый этап развития технологии фиксируется, и служит основой для следующего этапа.

Первые технологические шаги (каменные орудия, огонь, колесо), отняли десятки тысяч лет. Для людей, живших в ту эпоху, технологические изменения даже за тысячи лет были едва заметны. К 1000 году нашей эры, прогресс пошёл гораздо быстрее, и смена парадигмы происходила всего за одно или два столетия. В девятнадцатом веке, мы увидели больше технологических изменений, чем за девять веков, ему предшествовавших. Затем, в первые двадцать лет двадцатого века, мы увидели более значительное развитие, чем за весь девятнадцатый век. Сейчас смена парадигмы происходит всего за несколько лет. Всемирной паутины, в её нынешнем виде, не существовало всего несколько лет назад, а десять лет назад её не было вообще.

Скорость смены парадигмы (т.е. общая скорость технического прогресса) в настоящее время удваивается (примерно) каждое десятилетие; то есть, время на смену парадигмы уполовинивается каждые десять лет (а сама скорость роста растёт в геометрической прогрессии). Таким образом, технический прогресс в ХХI веке будет эквивалентен тому, на что потребовалось бы (в линейном представлении) порядка 200 веков. Напротив, двадцатый век прошёл лишь около 25 лет прогресса (опять-таки, в пересчёте на сегодняшний его темп), из-за увеличения его скорости до текущей. Таким образом, двадцать первый век станет свидетелем почти в тысячу раз больших технологических изменений, чем его предшественник.

Сингулярность близко

Для того, чтобы оценить природу и значимость грядущей «Сингулярности», важно осмыслить природу экспоненциального роста. С этой целью, я люблю рассказывать историю про изобретателя шахмат и его покровителя, императора Китая. В ответ на предложение императора самому назначить награду за свою новую любимую игру, изобретатель попросил одно зерно риса положить на первый квадрат шахматной доски, два на второй квадрат, четыре на третий, и так далее. Император быстро согласился с этой, казалось бы, простой и скромной просьбой. По одной из версий этой истории император разорился, так как 63 удвоения, в конечном счёте, составляют 18 миллионов триллионов зёрен риса. Учитывая, что десять зёрен риса закрывают квадратный дюйм, такое количество риса требует рисовых полей, охватывающих два раза всю площадь поверхности Земли, включая океаны. В другой версии этой истории изобретатель лишился своей головы.

Следует отметить, что, по мере того, как император и изобретатель заполняли первую половину шахматной доски, всё шло вполне нормально. Изобретателю отсыпали ложки риса, затем миски риса, затем бочки. К концу первой половины шахматной доски, у изобретателя было уже большое поле риса (4 миллиарда зёрен), а император заметил неладное. Когда они перешли ко второй половине шахматной доски, ситуация начала быстро ухудшаться. Кстати, по поводу удвоения вычислений, — с момента изобретения первых программируемых компьютеров в конце Второй Мировой Войны, на текущий момент мы прошли как раз чуть более тридцати двух удвоений их производительности.

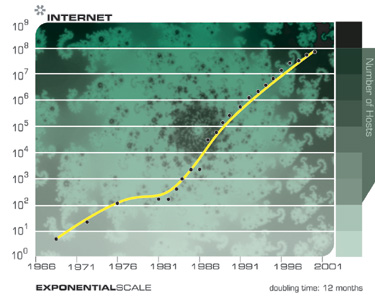

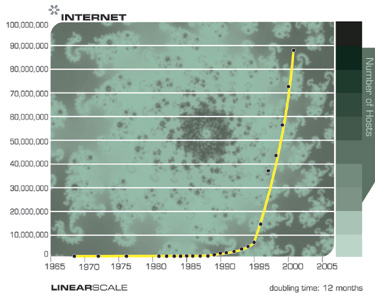

Такова природа экспоненциального роста. Хотя технологии растут экспоненциально, мы, люди, живём в линейном мире. Из-за этого технологические тренды не выглядят для нас как начальные шаги процесса постоянного удвоения технологической мощи. Затем, казалось бы, из ниоткуда, технология показывает взрывной рост. Например, когда Интернет прошёл путь от 20000 до 80000 узлов в течение двух лет в 1980-х годах, этот прогресс оставался скрытым от широкой публики. Десять лет спустя, когда он вырос с 20 миллионов до 80 миллионов узлов за тот же период времени, влияние уже было вполне заметным.

Поскольку экспоненциальный рост продолжает ускоряться в первой половине двадцать первого века, у нас будет ощущение взрыва в бесконечность, по крайней мере, с точки зрения современных людей, ограниченных линейной перспективой. Прогресс, в конечном счёте, станет происходить настолько быстро, что это приведёт к разрушению нашей способности за ним успевать. Он в буквальном смысле выйдет из-под нашего контроля. Иллюзия, что мы можем «дёрнуть рубильник» будет развеяна.

Может ли технический прогресс продолжать ускоряться до бесконечности? Существует ли момент, когда люди не в состоянии будут думать настолько быстро, чтобы не отставать от него? Что касается обычных людей, — это очевидно, так. Однако, чего может достичь тысяча учёных, каждый из которых в тысячу раз умнее, чем учёный сегодняшний, и каждый из которых действует в тысячу раз быстрее, чем современные люди (потому что обработка информации в их, главным образом небиологических, мозгах быстрее)? Один год сможет равняться тысячелетию. Что бы они придумали?

Ну, во-первых, они бы придумали технологию, чтобы стать ещё более умными (поскольку их интеллект больше не ограничен в мощности). Они бы стали менять свои собственные процессы мышления, чтобы думать ещё быстрее. Когда учёные разовьются так, чтобы быть в миллион раз умнее и работать в миллион раз быстрее, их час будет эквивалентен целому веку прогресса (по нынешним меркам).

Это и будет Сингулярностью. Сингулярность — это технологические изменения настолько быстрые и настолько глубокие, что они разрывают саму ткань человеческой истории. Некоторые скажут, что невозможно постичь Сингулярность, по крайней мере, с нашим текущим уровнем понимания, и, следовательно, невозможно заглянуть за её «горизонт событий», и понять, что будет после.

Моё мнение таково, что, несмотря на серьёзные ограничения мышления, накладываемые нашим биологическим мозгом, имеющим всего сотню триллионов межнейронных связей, мы, тем не менее, обладаем достаточной силой абстрактного мышления, чтобы сделать значимые выводы о характере жизни после Сингулярности. Самое главное, с моей точки зрения, — возникающий интеллект будет продолжать представлять человеческую цивилизацию, которая уже является человеко-машинной. Это будет следующим шагом в эволюции, следующей высокоуровневой сменой парадигмы.

Для того, чтобы оценить понятие Сингулярности в перспективе, давайте рассмотрим историю самого этого слова. Сингулярность — известное слово, означающее уникальное событие с серьёзными последствиями. В математике этот термин подразумевает бесконечность, взрывной рост значения, который происходит при делении постоянной на число, стремящееся к нулю. В физике, аналогично, Сингулярность обозначает событие или местоположение бесконечной мощности. В центре чёрной дыры материя настолько плотная, что сила её притяжения бесконечна. Близлежащие материя и энергия втягиваются в чёрную дыру, а горизонт событий отделяет остальную Вселенную от этой области, которая, по сути, представляет собой разрыв в ткани пространства и времени. Считается, что сама Вселенная началась с такой Сингулярности.

В 1950-х Джону фон Нейману (John Von Neumann) приписывали высказывание, что «постоянно ускоряющийся прогресс технологий… создаёт впечатление о приближении некой существенной Сингулярности в истории человеческого развития, после которой человеческая деятельность, как мы её знаем, не сможет более продолжаться.» В 1960-е годы, Ирвинг Джон Гуд (Irving John Good) писал об «интеллектуальном взрыве», происходящем в результате того, что интеллектуальные машины разрабатывают своё следующее поколение без вмешательства человека. В 1986 году, Вернор Виндж (Vernor Vinge), математик и кибернетик из Университета Сан-Диего (San Diego State University), писал о быстро приближающейся технологической «Сингулярности» в своём научно-фантастическом романе Брошенные в реальном времени. Затем, в 1993 году, Виндж, на организованном НАСА симпозиуме, представил доклад, в котором описал Сингулярность как надвигающееся событие, вызываемое, в первую очередь, появлением «сущностей с интеллектом, превосходящим человеческий», что Виндж считал предвестником феномена убегания.

С моей точки зрения, Сингулярность многогранна. Она представляет собой почти вертикальную фазу экспоненциального роста, где темпы роста настолько велики, что кажется, что технологии развиваются с бесконечной скоростью. Конечно, с математической точки зрения, нет никакого разрыва, и темпы роста остаются конечными, хотя и чрезвычайно большими. Но сегодня, с нашей ограниченной точки зрения, это неизбежное событие представляется как острый и резкий разрыв в непрерывности прогресса. Однако, я выделяю оговорку «сегодня» потому, что одним из важных последствий Сингулярности будет изменение в самой природе нашей способности к пониманию. Другими словами, мы станем гораздо умнее, когда сольёмся с нашими технологиями.

Когда, в 1980-е я писал свою первую книгу, «Век интеллектуальных машин», я закончил её образом возникновения машинного интеллекта более мощного, чем человеческий, но понял, как трудно заглянуть за этот горизонт событий. На протяжении последних 20 лет я размышлял о последствиях этого события, события, которое преобразует все сферы человеческой жизни, и сегодня я чувствую, что мы действительно способны понять многие его аспекты.

Рассмотрим несколько примеров таких последствий. Большая часть нашего опыта перейдёт из реальной действительности в виртуальную реальность. Большая часть интеллекта нашей цивилизации в конечном счёте будет небиологической, и к концу этого века станет в триллионы триллионов раз мощнее человеческого интеллекта. Однако (отвечая на часто высказываемую озабоченность) это не означает конец биологического интеллекта, даже если он будет сброшен со своего положения эволюционного превосходства. Более того, важно отметить, что небиологические формы будет производными по дизайну от биологической. Другими словами, наша цивилизация будет оставаться человеческой, а во многих отношениях даже более человеческой, чем мы считаем сегодня, хотя наше понимание этого термина будет выходить за рамки его строго биологического происхождения.

Многие наблюдатели, тем не менее, выразили тревогу в связи с появлением форм небиологического интеллекта, превосходящих человеческий разум. Возможность нарастить наш собственный интеллект через тесную связь с другими мыслительными средами не снимает беспокойства, так как некоторые люди выразили желание остаться «неулучшенными» и, в то же время, сохранить своё место на вершине интеллектуальной пищевой цепи. Мне кажется, что наиболее вероятный результат будет заключается в следующем: с одной стороны, с точки зрения биологического человечества, этот сверхчеловеческий интеллект будет, по-видимому, выполнять роль трансцендентного слуги, удовлетворяющего его потребности и желания. С другой стороны, исполнение желаний уважаемых биологических предков человечества будет занимать лишь мизерную долю интеллектуальной мощи, которую принесёт Сингулярность.

Излишне говорить, что Сингулярность преобразит все аспекты нашей жизни, социальные, сексуальные и экономические, рассмотрению чего и посвящено настоящее эссе.

Происхождение Закона Мура

Прежде чем рассматривать далее последствия Сингулярности, давайте рассмотрим широкий спектр технологий, которые подчиняются Закону ускоряющейся отдачи. Экспоненциальный тренд, который получил наибольшее общественное признание, известен как «Закон Мура». Гордон Мур, один из изобретателей интегральных схем, впоследствии возглавивший Intel, в середине 1970-х годов заметил, что мы можем увеличивать количество транзисторов на единицу площади в интегральных схемах вдвое каждые 24 месяца. Учитывая, что у электронов при этом сокращается расстояние, на которое они путешествуют, микросхемы при этом и ускоряются вдвое, обеспечивая в целом учетверение вычислительной мощности.

После шестидесяти лет преданного служения, закон Мура умрёт достойной смертью не позднее 2019 года. К тому времени, элементы транзисторов будут размером всего в несколько атомов, и использование даже самой тонкой фотолитографии подойдёт к своему пределу. И что, будет ли это концом экспоненциального роста вычислительной мощности?

Не рассчитывайте на это.

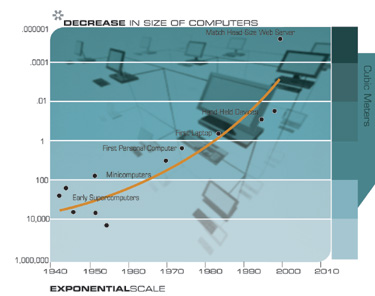

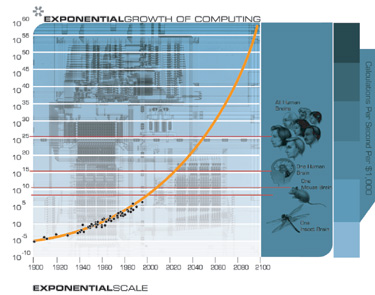

Если мы построим график скорости вычислений (в инструкциях в секунду) доступных за $1000 (в постоянных долларах) для 49 известных калькуляторов и компьютеров, охватывающих весь ХХ век, мы можем сделать некоторые интересные наблюдения.

Закон Мура был не первой, а пятой, парадигмой, обеспечивавшей экспоненциальный рост вычислительной техники.

Каждый раз, когда одна парадигма выдыхается, другая набирает темп.

Важно отметить, что закон Мура для интегральных схем был не первой, а пятой парадигмой, обеспечивавшей ускорение роста соотношения цена-производительность. Вычислительные устройства постоянно умножали свою мощность (за единицу времени), от механических счётных устройств, использовавшихся при переписи населения США 1890 года, к Тьюринговской машине «Robinson», выполненной на электромеханических реле, и взламывавшей секретные нацистские коды, к ламповому компьютеру CBS, предсказавшему избрание Эйзенхауэра, к машинам на основе транзисторов, использовавшихся для первых космических запусков, к персональному компьютеру на основе интегральных микросхем, который я использовал, чтобы диктовать (и автоматически транскрибировать) это эссе.

Но я заметил ещё кое-что удивительное. Когда я нанёс 49 машин на экспоненциальный график (где прямая линия означает экспоненциальный рост), я не получил прямой линии. То, что я получил, было другой экспоненциальной кривой. Другими словами, это экспоненциальный рост скорости экспоненциального роста. Скорость компьютеров (на единицу стоимости) удваивалась каждые три года в период с 1910 по 1950 год, удваивалась каждые два года в период между 1950 и 1966 годами, а в настоящее время удваивается каждый год.

Но откуда же берётся Закон Мура? Что стоит за этим удивительно предсказуемым явлением? Я встретил довольно мало работ о первоисточнике этой тенденции. Является ли она просто «набором отраслевых целей и ожиданий», как утверждает Рэнди Исаак (Randy Isaac), глава фундаментальной науки в IBM? Или происходит что-то более глубинное?

На мой взгляд, это одно (среди многих) из проявлений экспоненциального роста эволюционного процесса, которым является развитие технологий. Экспоненциальный рост вычислительной техники является изумительным исчислимым примером экспоненциально увеличивающейся отдачи от эволюционного процесса. Мы также можем выразить экспоненциальный рост вычислительной техники в терминах ускоряющегося темпа развития: потребовалось девяносто лет, чтобы достичь первого MIPS-а (миллиона инструкций в секунду) на тысячу долларов, а теперь мы добавляем по MIPS-у на тысячу долларов каждый день.

Закон Мура в узком смысле относится к числу транзисторов на интегральной схеме фиксированного размера, и иногда выражался ещё более узко, в терминах размера элемента транзистора. Но вместо размера элемента (который является лишь одним из влияющих факторов), или даже количества транзисторов, я думаю, что наиболее подходящей для отслеживания мерой является отношение скорости вычислений к стоимости вычислительного модуля. При этом учитывается множество уровней «совершенства» (то есть, инноваций, которые, суть, и есть технологическая эволюция). В дополнение ко всем инновациям в интегральных схемах, есть несколько уровней инноваций в компьютерном дизайне, таких, как конвейерная обработка, параллельная обработка, предварительная выборка команд, кэширование инструкций и данных, и многое другое.

Из приведённого выше графика мы видим, что экспоненциальный рост вычислительной техники начался не с интегральных схем (около 1958 года), или даже транзисторов (около 1947 года), а восходит к электромеханическим калькуляторам, использовавшимся в переписи населения США в 1890 и 1900 годах. Эта диаграмма охватывает по меньшей мере пять различных парадигм вычислений, из которых закон Мура имеет отношение только к последней.

Очевидно, какой будет шестая парадигма после того, как закон Мура выдохнется во втором десятилетии нынешнего века. Чипы сегодня плоские (хотя и требуется до 20 слоёв материала, чтобы произвести один слой схемы). В отличие от этого, наш мозг организован в трёх измерениях. Мы живём в трёхмерном мире, почему бы не использовать третье измерение? Человеческий мозг на самом деле использует очень неэффективный электрохимический аналоговый вычислительный процесс с цифровым управлением. Основная часть расчётов осуществляется в межнейронных соединениях со скоростью всего около 200 операций в секунду (на каждом соединении), что примерно в десять миллионов раз медленнее, чем у современных электронных схем. Но мозг получает свою умопомрачительную мощность от своей высоко-параллельной организации в трёх измерениях. На подходе уже есть множество технологий, которые работают в трёх измерениях. Например, нанотрубки, с которыми уже работают в лабораториях, строят схемы из пентагональных массивов углеродных атомов. Схема из пятнадцати кубических сантиметров нанотрубок будет в миллион раз более мощной, чем человеческий мозг. В настоящее время исследуется более чем достаточно новых компьютерных технологий, в том числе трёхмерные кремниевые чипы, оптические вычисления, кристаллические вычисления, вычисления на основе ДНК и квантовые вычисления, чтобы сохранить действие закона ускоряющейся отдачи, применительно к вычислительной технике, на длительное время.

Таким образом, (двойной) экспоненциальный рост вычислительной техники шире, чем закон Мура, который относится только к одной из парадигм этого роста. И это ускорение развития вычислительной техники, в свою очередь, является частью ещё более широкого явления ускорения темпов любого эволюционного процесса. Критики спешат заметить, что экстраполяция экспоненциального тренда ограничивается исчерпанием «ресурсов». Классическим примером является следующая ситуация: когда вид появляется в новом ареале обитания (например, кролики в Австралии), численность вида некоторое время растёт в геометрической прогрессии, но затем, когда заканчиваются ресурсы, такие, как место и продукты питания, численность упирается в предел роста.

Но ресурсы, лежащие в основе экспоненциального роста эволюционного процесса, относительно неограничены:

- Порядок (постоянно растущий) самого эволюционного процесса. Каждый этап эволюции предоставляет более мощные инструменты для следующего. В биологической эволюции, появление ДНК дало основу для более мощных и быстрых эволюционных «экспериментов». Позднее, возникновение разнообразных «конструкций» организмов во время Кембрийского взрыва открыло путь к быстрому эволюционному развитию других органов тела, таких как мозг. Или взять более свежий пример, появление компьютерных инструментов проектирования позволяет ускорить создание следующего поколения компьютеров.

- «Хаос» окружающей среды, в которой происходит эволюционный процесс и который предоставляет варианты ещё большего разнообразия. В биологической эволюции, разнообразие вступает в процесс в виде мутаций и постоянно изменяющихся условий окружающей среды. В технологической эволюции, поддержка процесса инноваций происходит за счёт человеческой изобретательности в сочетании с постоянно меняющимися рыночными условиями.

Реальной проблемой является максимальный потенциал материи и энергии, в котором функционируют интеллектуальные процессы. Но, согласно моим моделям, мы не подойдём к их пределам в течение текущего столетия (но это, однако, станет проблемой в следующие пару столетий).

Нам также нужно различать «S-образную кривую» («S» растянутую вправо, включающую в себя очень медленный, практически незаметный рост с последующим очень быстрым ростом, а затем его уплощение, по мере того, как процесс приближается к асимптоте), которая характерна для какой-либо конкретной технологической парадигмы, и продолжающийся экспоненциальный рост, характерный для продолжающегося эволюционного развития технологии. Конкретные парадигмы, такие как закон Мура, в конце концов достигают уровней, при которых экспоненциальный рост уже не представляется возможным. Таким образом, закон Мура является S-образной кривой. Однако, рост вычислительной мощности является непрерывным экспоненциальным процессом (по крайней мере, пока мы не «насытим» Вселенную интеллектом нашей человеческого-машинной цивилизации, но это не станет ограничением в наступающем столетии). В соответствии с законом ускоряющейся отдачи, смена парадигмы, называемая также инновацией, превращает S-образную кривую какой-либо конкретной парадигмы в продолжение экспоненциального роста. Новая парадигма (например, трёхмерные схемы) начинает превалировать, когда старая парадигма приближается к своему естественному пределу. В истории вычислений так происходило уже, по крайней мере, четыре раза. Эта особенность также отличает изготовление орудий труда у других видов животных, у которых навык изготовления (или использования) орудия труда у каждого конкретного животного характеризуется резко заканчивающейся S-образной кривой обучения, от технологий, созданных человеком, которые имеют экспоненциальный характер скорости роста с момента своего создания.

Секвенирование ДНК, память, связь, интернет и миниатюризация

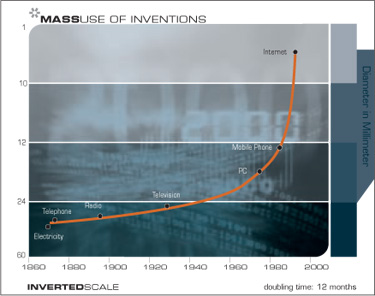

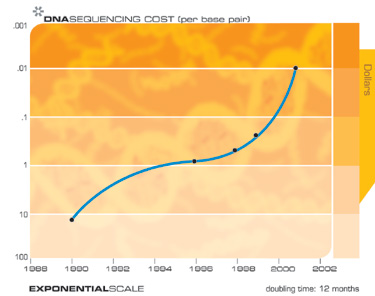

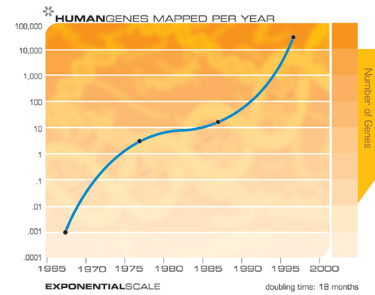

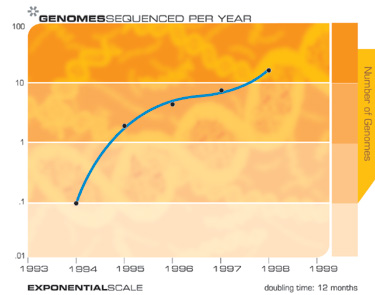

«Закон ускоряющейся отдачи» применим к любым технологиям, к любому по-настоящему эволюционному процессу, и может быть измерен с поразительной точностью для технологий информационных. Есть очень много примеров экспоненциального роста, вытекающего из Закона ускоряющейся отдачи, в таких разнообразных технологически областях, как секвенирование ДНК, скорость связи, электроника всех видов, и даже в быстро сокращающихся характерных технологических размерах. Сингулярность возникает не из одного экспоненциального взрыва скорости вычислений, а, скорее, из взаимодействия и синергии, являющихся следствием многообразного переплетения различных технологических революций. Также нужно иметь в виду, что каждая точка на кривых экспоненциального роста, лежащих в основе этого арсенала технологий (см. графики ниже) представляет собой серьёзную людскую драму внедрения новшеств и конкуренции. Удивительно, что эти хаотические процессы приводят к такой гладкой и предсказуемой экспоненциальной зависимости.

Например, когда четырнадцать лет назад началось секвенирование генома человека, критики полагали, что, учитывая скорость секвенирования, которая тогда была доступна, на завершение проекта может потребоваться несколько тысяч лет. Тем не менее, на пятнадцатый год проект был завершён, немного раньше намеченного срока.

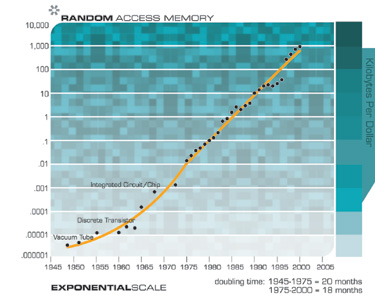

Конечно, мы ожидаем увидеть экспоненциальный рост в технологии электронных запоминающих устройств, таких как RAM (оперативная память произвольного доступа).

Обратите внимание, как экспоненциальный рост продолжался при смене парадигмы от вакуумных трубок к дискретным транзисторам и далее, к интегральным микросхемам.

Развитие технологий магнитной памяти на связано напрямую с Законом Мура, а опирается на достижения в области механических и электромагнитных систем.

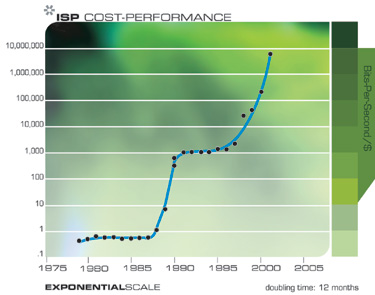

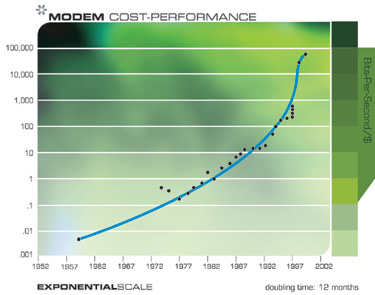

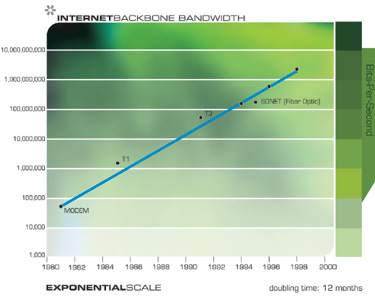

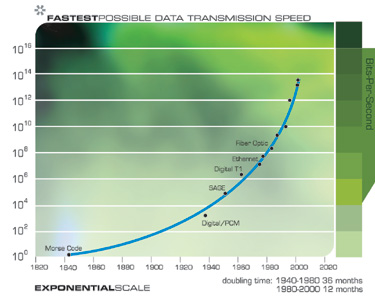

Экспоненциальный рост в области коммуникационных технологий был ещё более взрывным, чем в области вычислений, и не менее значителен по своим последствиям. Опять же, это ускорение имеет гораздо более широкую базу, чем просто уменьшение размера транзисторов на кристалле, и включает в себя ускоряющийся прогресс в области волоконной оптики, оптической коммутации, электромагнитных технологиях и многом другом.

Обратите внимание на каскад небольших «S-образных» кривых

Обратите внимание, что на этих двух графиках мы можем реально увидеть прогрессирование «S-образных» кривых: ускорение, обусловленное новой парадигмой, затем стабилизация, по мере того, как парадигма выдыхается, и последующее возобновление быстрого роста после смены парадигмы.

Следующие две диаграммы показывают общий рост Интернета, выраженный в количестве сайтов. Эти два графика построены на одних и тех же данных, но один из них в экспоненциальном масштабе, а другой является линейным. Как я отмечал ранее, технология, прогрессирующая с экспоненциальным темпом, кажется нам развивающейся линейно. Таким образом, большинству наблюдателей будет казаться, что до середины 1990-х годов, когда, казалось бы, из ниоткуда, стремительно возникли всемирная паутина и электронная почта, ничего не происходило. Но превращение Интернета во всемирное явление было легко предсказуемо гораздо раньше, на основе данных экспоненциального тренда.

Обратите внимание на то, каким сюрпризом выглядит взрывной рост Интернета на линейном графике, и как он предсказуем на графике экспоненциальном.

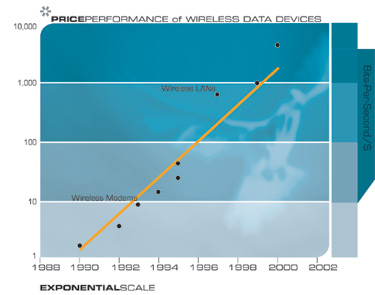

В конце концов мы уйдём от путаницы проводов в наших городах и в нашей жизни к беспроводной связи, производительность которой удваивается каждые 10-11 месяцев.

Ещё одна технология, которая будет иметь далеко идущие последствия для двадцать первого века, — это повсеместная тенденция делать вещи меньше, то есть миниатюризация. Характерные размеры элементов широкого спектра технологий, как электронных, так и механических, сокращаются, и также с удвоенной экспоненциальной скоростью. В настоящее время уменьшение линейных размеров по каждому измерению происходит с коэффициентом примерно 5,6 за каждое десятилетие.

Вернёмся к экспоненциальному росту вычислений

Если мы рассматриваем экспоненциальный рост вычислений в правильной перспективе, в качестве одного из примеров широкой распространённости экспоненциального роста, основанного на информационных технологиях, что и является одним из множества примеров Закона ускоряющейся отдачи, то мы можем с уверенностью предсказать его продолжение.

В сопроводительной врезке, я даю упрощённую математическую модель Закона ускоряющейся отдачи, поскольку она имеет отношение к (двойному) экспоненциальному росту вычислительной мощности. Из формул, приведённых ниже, следует приведённый выше график непрерывного роста скорости вычислений. Этот график соответствует имеющимся данным для двадцатого века, проходит через все пять смен парадигм, и даёт прогноз на век двадцать первый. Обратите внимание, что скорость роста увеличивается медленно, но всё-таки в геометрической прогрессии.

Закон ускоряющейся отдачи применительно к росту вычислений

Ниже приводится краткий обзор Закона ускоряющейся отдачи на примере двойного экспоненциального роста скорости вычислений. Эта модель рассматривает влияние растущей мощности технологии в качестве стимула для развития своего собственного следующего поколения. Например, с более мощными компьютерами, и связанными с ними технологиями, мы получаем инструменты и знания, чтобы разработать ещё более мощные компьютеры, и сделать это ещё быстрее.

Обратите внимание, что данные за 2000 год и последующие периоды, представляют вычисления в нейронных сетях, поскольку ожидается, что именно этот вид расчётов, в конечном счёте, будет доминировать, особенно при эмуляции функций мозга человека. Этот тип расчётов является менее затратным, чем обычные (например, для Pentium III / IV) расчёты, с коэффициентом по меньшей мере 100 (особенно, в случае их реализации с использованием цифро-аналоговой электроники, которая будет хорошо соответствовать цифро-аналоговым электрохимическим процессам мозга). Коэффициент 100 соответствует примерно шести годам сегодня, и менее чем шести годам далее в двадцать первом веке.

Моя оценка производительности мозга составляет 100 миллиардов нейронов умножить на, в среднем, 1000 соединений на нейрон (вычисления происходят, в основном, в соединениях), и умножить на 200 операций в секунду. Конечно, эти оценки консервативно высоки, можно найти и более высокие и более низкие оценки. Тем не менее, даже гораздо более (или менее) высокие по порядку величины оценки, смещают прогноз всего на относительно небольшое число лет.

Некоторые из наиболее значимых дат этого анализа:

- Мы достигаем способностей одного человеческого мозга (2×1016 CPS (вычислений в секунду)) за $1000 около 2023 года.

- Мы достигаем способностей одного человеческого мозга (2×1016 CPS) за один цент около 2037 года.

- Мы достигаем способностей всей человеческой расы (2×1026 CPS) за $1000 около 2049 года.

- Мы достигаем способностей всей человеческой расы (2×1026 CPS) за один цент около 2059 года.

Модель имеет следующие переменные:

- V: Скорость (т.е. производительность) вычислений (измеряется в вычислениях в секунду отнесённых к их стоимости)

- W: Мировые знания применительно к проектированию и созданию вычислительных устройств

- t: Время

В модели предполагается, что:

Другими словами, мощность компьютеров является линейной функцией от знания о том, как их создавать. На самом деле, это консервативное предположение. Обычно, инновации улучшают V (производительность компьютера) в разы, а не на фиксированную величину. Независимые инновации умножают эффект друг друга. Например, новая технология полупроводников, такая, как CMOS, более эффективная методика разводки интегральных схем, и улучшение архитектуры процессора, такое, как конвейерная обработка, независимо и кратно увеличивают V.

Другими словами, W (знание) является кумулятивным, и мгновенное приращение знаний пропорционально V.

Это даёт нам:

Упрощая константы получаем:

Таким образом, это формула для «ускоряющегося» (то есть, растущего в геометрической прогрессии), результата, фактически «обычный закон Мура».

Как я уже упоминал выше, данные показывают экспоненциальный рост скорости экспоненциального роста. (Мы удваивали вычислительные мощности каждые три года в начале двадцатого века, каждые два года в середине века, и почти каждый год в течение 1990-х гг.)

Давайте рассмотрим другое экспоненциальное явление, которым является рост вычислительных ресурсов. Мало того, что каждое из вычислительных устройств (одинаковой стоимости) становится всё более мощным, как функция от W, но и их количество, используемое для вычислений, также растёт экспоненциально.

Таким образом, мы имеем:

- N: Расходы на вычисления

(как и раньше)

(расходы на вычисления растут со своей собственной экспоненциальной скоростью)

Как и прежде, мировые знания накапливаются, и мгновенное приращение пропорционально количеству вычислений, которые равны ресурсам, используемым для вычислений (N) умноженным на мощность каждого устройства (при его постоянной стоимости).

Это даёт нам:

Упрощая константы, получаем:

Это двойная экспоненциальная кривая, в ней скорость экспоненциального роста растёт со своей экспоненциальной скоростью.

Теперь давайте рассмотрим реальные данные. Возьмём параметры реальных вычислительных устройств и компьютеров в двадцатом веке:

- CPS / \$1K: вычислений в секунду за \$1000

Данные по вычислительным устройствам двадцатого века соответствуют:

- CPS / \$1K =

Мы можем определить темпы роста в течение определённого периода времени:

- Скорость роста =

- Человеческий мозг = 100 млрд (1011) нейронов × 1000 (103) соединений на нейрон × 200 (2×102) вычислений в секунду на одно соединение = 2×1016 вычислений в секунду

- Человеческая раса = 10 млрд (1010) человек = 2×1026 вычислений в секунду

Эти формулы и дают приведённые выше графики.

Уже сейчас ожидается, что суперкомпьютер от IBM «Blue Gene», создание которого планируется завершить к 2005 году, будет, по прогнозам, способен выполнять 1 миллион миллиардов операций в секунду (т.е. один миллиард мегафлопсов или один петафлопс). Это уже одна двадцатая производительности человеческого мозга, которую я консервативно оцениваю в 20 миллионов миллиардов операций в секунду (100 миллиардов нейронов на 1000 соединений в нейроне на 200 вычислений в секунду на одно соединение). В соответствии с моими предыдущими прогнозами, суперкомпьютеры достигнут мощности одного человеческого мозга к 2010 году, а персональные компьютеры сделают это примерно к 2020 году. К 2030 году потребуется уже небольшое поселение (около тысячи человек), чтобы соответствовать вычислительной мощности, доступной за \$1000. К 2050 году, за \$1000 можно будет получить вычислительные мощности, эквивалентные разуму всех людей на Земле. Конечно, это включает в себя только те мозги, которые всё ещё используют нейроны на основе углерода. Хотя человеческие нейроны, по сути, дивные творения, нам не стоит (да мы и не будем) их просто копировать при разработке новых компьютерных систем. Наши электронные схемы уже в десятки миллионов раз быстрее, чем электрохимические процессы нейрона. Большая часть сложности человеческого нейрона используется для поддержания его функций жизнеобеспечения, а не на возможности по обработке информации. В конечном счёте, мы должны перенести наши психические процессы на более подходящую вычислительную основу. Тогда нашим умам не нужно будет оставаться настолько маленькими, будучи ограниченным, как они ограничены сегодня, всего лишь ста триллионами нейронных связей, каждая из которых работает с медлительностью в 200 цифро-аналоговых вычислений в секунду.

Программное обеспечение интеллекта

До сих пор я говорил об аппаратном обеспечении вычислительной техники. Программное обеспечение ещё более показательно. Одним из основных допущений, лежащих в основе предсказания Сингулярности, является способность небиологических сред воспроизводить богатство, тонкость и глубину человеческого мышления. Достижение вычислительной мощности одного человеческого мозга, или даже поселения или нации, не будет автоматически давать уровень возможностей человека. Под человеческим уровнем я понимаю все разнообразные и изощрённые пути проявления человеческого интеллекта, в том числе музыкальные и художественные способности, творчество, способность физически перемещаться в пространстве, понимание, и адекватную реакцию на эмоции. Соответствующая мощность аппаратных средств является необходимым, но не достаточным условием. Организация и содержимое этих ресурсов — программное обеспечение интеллекта, также имеет решающее значение.

Прежде чем рассматривать этот вопрос, важно отметить, что, как только компьютер достигнет человеческого уровня интеллекта, он обязательно его перешагнёт. Ключевым преимуществом небиологического интеллекта является то, что машины могут легко делиться своими знаниями. Если я учу французский, или читаю Войну и мир, я не могу легко загрузить то, что узнал сам, вам. Вы должны получить эти знания тем же кропотливым путём, как это сделал я. Мои знания, встроенные в огромную структуру концентраций нейромедиаторов и нейронных связей, не могут быть быстро извлечены или переданы. Но мы не упустим возможности создания быстрых каналов передачи данных в наших небиологических эквивалентах кластеров человеческих нейронов. Когда один компьютер обучается навыку или приходит к пониманию чего-либо, он может немедленно разделить эту мудрость с миллиардами других машин.

В качестве современного примера — мы потратили годы обучения одного исследовательского компьютера на распознавание слитной человеческой речи. Мы пропустили через него тысячи часов записанной речи, исправляли его ошибки, и терпеливо улучшали его показатели. Наконец, он стал весьма искусными в распознавании (я продиктовал ему большую часть своей, недавно вышедшей, книги). Теперь, если вы хотите, чтобы ваш собственный персональный компьютер распознавал речь, его не нужно пропускать через тот же процесс заново; вы можете просто загрузить полностью подготовленные шаблоны за считанные секунды. В конечном итоге, миллиарды небиологических сущностей могут быть главным хранилищем всех знаний, приобретённых людьми и машинами.

Кроме того, компьютеры потенциально в миллионы раз быстрее, чем нейронные цепи человека. Компьютер также может точно запомнить миллиарды или даже триллионы фактов, в то время как мы с трудом запоминаем несколько телефонных номеров. Сочетание в машине интеллекта человеческого уровня со свойственным компьютерам превосходством в скорости, точности и совместном использовании знаний будет грандиозным.

Существует целый ряд убедительных сценариев достижения более высоких уровней интеллекта в наших компьютерах, в конечном итоге, приближающихся к уровню человека, и превосходящих его. Мы сможем развивать и обучать систему, комбинируя нейронные сети с массовым параллелизмом с другими парадигмами для того, чтобы понимать язык и строить модели знаний, в том числе уметь извлекать эти знания из письменных документов. В отличие от многих современных компьютерных «нейронных сетей», которые используют математически упрощённые модели человеческих нейронов, некоторые современные нейронные сети уже используют высоко детализированные модели человеческих нейронов, включающие точные функции нелинейной аналоговой активации и другие подобные детали. Хотя способность современных компьютеров к извлечению знаний и обучению на документах на естественных языках ограничена, их возможности в этой области быстро улучшаются. Компьютеры смогут самостоятельно читать, понимая и моделируя то, что они прочли, во втором десятилетии двадцать первого века. Затем мы сможем дать нашим компьютерам прочитать всю существующую в мире литературу — книги, журналы, научные издания, и другие материалы. В конце концов, машины будут собирать знания самостоятельно, роясь в Интернете, или даже в физическом мире, извлекая информацию из всего спектра средств массовой информации и информационных услуг, и обмениваясь знаниями друг с другом (что машины смогут делать гораздо легче, чем их создатели — люди).

Реконструируя работу мозга

Наиболее привлекательный сценарий для разработки программного обеспечения искусственного интеллекта — это «заглянуть в чертежи» лучшей мыслящей машины, до которой мы только можем добраться. Не существует никаких причин, по которым бы мы не смогли понять работу человеческого мозга, и скопировать основные принципы его устройства. Хотя создателю и пришлось затратить несколько миллиардов лет на разработку, нам мозг легко доступен, и (пока ещё) не защищён авторским правом. Несмотря на то, что мозг окружён черепом, он не скрыт от нашего взгляда.

Наиболее прямой и грубый способ для достижения этой цели — деструктивное сканирование: взять замороженный мозг, предпочтительно замороженный за мгновение до того момента, как он неизбежно умрёт, и исследовать его слой за слоем, срезая очень тонкие ломтики. Мы сможем легко увидеть каждый нейрон, каждое соединение и все концентрации нейромедиаторов в каждом синапсе каждого тонкого слоя.

Сканирование человеческого мозга уже началась. Приговорённый убийца позволил сосканировать его мозг и тело, и вы можете получить доступ ко всем его 10 миллиардам байт в Интернете http://www.nlm.nih.gov/research/visible/visible_human.html.

На этом же сайте у него есть также 25 миллиардов байт компаньона — женщины, на тот случай, если ему станет одиноко. Эти сканы не имеют достаточно высокой для наших целей детализации, но это может быть и хорошо, поскольку мы не хотим, чтобы наши шаблоны машинного интеллекта основывались на мозге осуждённого убийцы.

Хотя сканирование замороженного мозга и осуществимо сегодня, ему не достаёт скорости и пропускной способности, но опять же, Закон ускоряющейся отдачи обеспечит необходимую скорость сканирования, так же, как он сделал это для сканирования человеческого генома. Андреас Новатсюк (Andreas Nowatzyk) из Университета Карнеги-Меллон (Carnegie Mellon University) планирует сканировать нервную систему мозга и тела мыши с детализацией менее 200 нм, что уже очень близко к детализации, необходимой для реконструкции работы мозга.

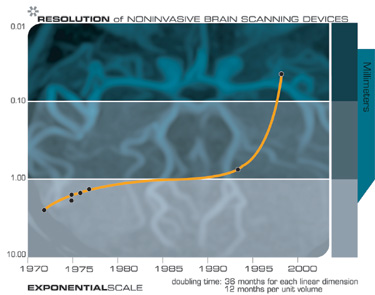

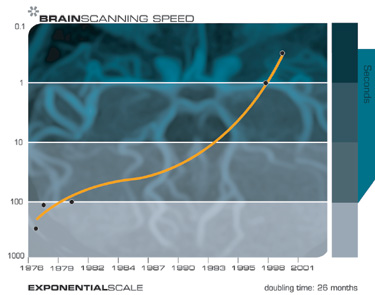

У нас сегодня есть также и неинвазивные методы сканирования, в том числе магнитно-резонансная томография (МРТ) высокого разрешения, сканирование оптических изображений, сканирование в ближней инфракрасной области, и других технологии, которые способны в некоторых случаях различать индивидуальные клетки сомы, или нейронов. Технологии сканирования мозга также увеличивают свою разрешающую способность с каждым новым поколением, — как раз то, чего можно было бы ожидать от закона ускоряющейся отдачи. Будущие поколения техники позволят нам определять связи между нейронами, заглядывать внутрь синапсов и записывать концентрацию нейромедиаторов.

Сегодня мы можем заглянуть внутрь человеческого мозга с помощью неинвазивных сканеров, которые увеличивают свою разрешающую способность с каждым новым поколением этой технологии. На пути неинвазивного сканирования есть целый ряд технических проблем, таких, как достижение необходимого разрешения, производительности, отсутствия вибрации, безопасности. По ряду причин, легче сканировать мозг недавно умершего человека, чем живого. Например, покойника легче заставить сидеть неподвижно. Однако, неинвазивное сканирование живого мозга в конечном счёте станет возможным, поскольку МРТ, оптические и другие технологии сканирования продолжают прогрессировать, увеличивая свою разрешающую способность и скорость.

Сканирование изнутри

Хотя неинвазивные способы сканирования мозга извне черепа быстро улучшаются, наиболее практичный подход к фиксации каждой значимой нейронной детали мозга — это сканирование изнутри. К 2030 году технологии «наноботов» (то есть нано роботов) станут жизнеспособными, и сканирование мозга будет для этих технологий наиболее многообещающим применением. Наноботы — это роботы, размеры которых сопоставимы с размером клеток крови человека, или даже меньше. Миллиарды таких роботов смогут проходить через каждый капилляр мозга и сканировать все существенные детали с близкого расстояния. Используя высокоскоростную беспроводную связь, нанороботы будут взаимодействовать друг с другом, а также с другими компьютерами, создающими базу данных сканируемого мозга (другими словами, все нанороботы будут общаться по беспроводной локальной сети).

Этот сценарий включает в себя только те возможности, которые мы можем ощутить и почувствовать сегодня. У нас уже есть технология, способная производить сканирование с очень высоким разрешением, при условии, что сканер физически находится на близком расстоянии от сканируемого объекта. Также, уже сегодня доступны основные методы вычислений и коммуникации. Не практичными пока остаются размеры наноботов и стоимость соответствующих технологий. Как говорилось выше, мы можем ожидать экспоненциального снижения стоимости вычислений, а также быстрого снижения характерных размеров электронных и механических технологий. Таким образом, можно дать консервативную оценку времени появления необходимых технологий наноботов к, примерно, 2030 году. Из-за своей способности поместить каждый сканер в непосредственной физической близости к каждой нейронной структуре, сканирование мозга на основе наноботов будет более практичным, чем сканирование мозга извне.

Как использовать результаты сканирования своего мозга

Как мы будем использовать тысячи триллионов байт информации, полученной от каждого сканирования мозга? Один из подходов заключается в использовании результатов для разработки более интеллектуальных параллельных алгоритмов для наших машин, в особенности тех, которые основаны на одной из парадигм нейронных сетей. При таком подходе нам не нужно копировать каждое отдельное соединение. В любой области мозга существует множество повторов и избыточности. Хотя для размещения информации, содержащейся в человеческом мозге, требуются тысячи триллионов байт информации (порядка 100 миллиардов нейронов, каждый из которых имеет порядка 1000 соединений, каждое из которых характеризуется различными концентрациями нейротрансмиттеров и других параметров), конструкция мозга, заданная в человеческом геноме, требует всего лишь около миллиарда байт.

Кроме того, большая часть генома является избыточной, так что исходный проект мозга описывается примерно ста миллионами байт, т.е. он размером с исполняемый файл Microsoft Word. Конечно, сложность нашего мозга значительно увеличивается по мере того, как мы взаимодействуем с миром (более чем в десять миллионов раз). Поскольку в каждой области мозга часто встречаются очень похожие структуры, для воссоздания его основных цифро-аналоговых алгоритмов нет необходимости подробно исследовать все его детали. Используя эту информацию, можно сконструировать искусственную сеть, работающую аналогично. Уже предпринимается множество попыток по сканированию человеческого мозга, и применению полученных идей при разработке интеллектуальных машин.

Темп воссоздания работы мозга лишь немного отстаёт от скорости поступления информации от сканирования мозга и структуры нейронов. В качестве актуального примера можно привести всеобъемлющую модель значительной части подсистемы нашего мозга, отвечающей за обработку звуковой информации, которую Лойд Уоттс (Lloyd Watts — www.lloydwatts.com) разработал на основе нейробиологических исследований специфических типов нейронов, и информации о межнейронных соединениях в мозге. Модель Уоттса состоит из пяти параллельных путей и включает в себя фактические промежуточные представления звуковой информации на каждом этапе нейронной обработки. Уоттс реализовал свою модель в виде программы реального времени, которая может определять положение и идентифицировать звуки, обладая многими свойствами, сходными со свойствами человеческого слуха. Несмотря на то, что эта работа ещё не завершена, она иллюстрирует возможность преобразования нейробиологических моделей и данных о межнейронных соединениях мозга в работающие компьютерные модели. Кроме того, как предположили Ганс Моравец (Hans Moravec) и другие исследователи, подобные эффективные модели требуют примерно в 1000 раз меньше вычислений, чем прямое воссоздание теоретический модели соответствующих биологических нейронов.

Воссоздание человеческого мозга: пять параллельных путей звука

Диаграмма Лойда Уоттса

Улитка (Cochlea): Чувствительный орган слуха. 30000 волокон преобразуют движение стремечка в спектрально-временное представление звука.

Многополярные клетки. (MC — Multipolar Cells): Измеряют спектральную энергию.

Сферические кустистые клетки. (GBC — Globular Bushy Cells): Передают импульсы от слухового нерва к верхнему Оливарному Комплексу.

Оливарный комплекс (Olivary Complex) (включает Верхние Латеральную и Медиальную Оливы (LSO и MSO)). Кодирует время и амплитуду сигналов для бинаурального сравнения уровня звука.

Шарообразные кустистые клетки. (SBC — Spherical Bushy Cells): Обеспечивают выделение времени поступления сигнала, в качестве предварительной обработки, для расчёта разности интераурального времени.

Октопусные клетки. (OC — Octopus Cells): Выделяют переходные процессы.

Дорсальное кохлеарное ядро. (DCN — Dorsal Cochlear Nucleus): Обнаруживает границы спектра и калибруют уровень шума.

Вентральное Ядро Трапециевидного Тела (VNTB — Ventral Nucleus of the Trapezoid Body): Генерирует сигналы обратной связи, модулирующие функцию внешних волосковых клеток в улитке.

Вентральное Ядро Латерального Лемниска, Периоливарные ядра (VNLL — Ventral Nucleus of the Lateral Lemniscus, PON — Peri-Olivary Nuclei): Выполняют промежуточную обработку сигналов октопусных клеток.

Медиальная Верхняя Оолива (MSO — Medial Superior Olive): Вычисляет интерауральную разницу времени (разница во времени прихода сигнала от двух ушей, используется, чтобы определить направление на источник звука).

Латеральная Верхняя Олива (LSO — Lateral Superior Olive): Также участвует в вычислении интерауральной разницы уровней.

Центральное Ядро Нижнего Бугорка (ICC — Central Nucleus of the Inferior Colliculus): Основное место слияния нескольких представлений звука.

Внешнее Ядро Нижнего Бугорка (ICX — Exterior Nucleus of the Inferior Colliculus): Дальнейшее уточнение локализации звука.

Верхний Бугорок (SC — Superior Colliculus): Место слияния звуковых и зрительных сигналов.

Медиальное Коленчатое Тело (MGB — Medial Geniculate Body): Слуховая часть таламуса

Лимбическая Система (LS — Limbic System): Состоит из множества структур, связанных с эмоциями, памятью, территорией и т.д.

Слуховая Кора (AC — Auditory Cortex)

Мозг — это не одна огромная «Tabula Rasa» (то есть однородный чистый лист), а скорее замысловатое хитросплетение сотен специализированных участков. Процесс «очистки лука», постепенных углубляющихся исследований этих хитросплетений, идёт полным ходом. Когда появятся все необходимые модели нейронов и данные о взаимосвязи разных областей мозга, будут разработаны подробные и пригодные к воплощению модели всех отделов головного мозга, такие как приведённая выше модель слуха.

После того, как поняты алгоритмы работы какой-либо области, они могут быть уточнены и улучшены, перед тем как создавать её синтетический нейронный эквивалент. Помимо этого, они могут быть запущены в вычислительной среде, которая уже сейчас более чем в десять миллионов раз быстрее, чем биологические нейронные системы. И при этом мы также можем использовать те методы построения интеллектуальных машин, которые мы уже понимаем.

Загрузка человеческого мозга

Более спорным сценарием, чем сканирование-мозга-для-понимания-как он-работает, является сканирование-мозга-для-его-загрузки. В этом случае мы сканируем чей-либо мозг, чтобы определить точное расположение, соединения и состав всех тканей, аксонов, дендритов, пресинаптических пузырьков, концентрации нейромедиаторов и других нервных компонентов и уровней. Всё это в комплексе, включая содержимое памяти, может затем быть воссоздано на нейрокомпьютере достаточной мощности.

Для достижения этой цели нам не обязательно понимать все процессы высших уровней, достаточно понять локальные мозговые процессы. Сканирование мозга достаточно подробное для его загрузки может показаться устрашающе сложным, но то же самое происходило и со сканированием генома человека. Все основные технологии уже существуют сегодня, просто у них нет необходимой скорости, точности и стоимости, однако это те характеристики, которые улучшаются дважды экспоненциальными темпами.

Вычислительные аспекты отдельных нейронов сложны, но, безусловно, не выходят за рамки нашей способности их точно смоделировать. Например, Тед Бергер (Ted Berger) и его коллеги из Hedco Neurosciences создали интегральные схемы, которые точно соответствуют цифровым и аналоговым характеристикам обработки информации нейронами, в том числе кластерами с сотнями нейронов. Карвер Мид (Carver Mead) и его коллеги из Калифорнийского технологического института (CalTech) создали множество интегральных схем, имитирующих цифро-аналоговые характеристики нейронных цепей млекопитающих.

Недавний эксперимент в Институте Нелинейной Науки Сан-Диего (San Diego’s Institute for Nonlinear Science) демонстрирует потенциал электронных нейронов точно имитировать нейроны биологические. Нейроны (биологические или какие-либо другие) являются ярким примером того, что часто называют «хаотичными вычислениями». Каждый нейрон действует, по сути, непредсказуемым образом. Когда сеть нейронов получает входные данные (из внешнего мира или от других сетей нейронов), возникающий среди них обмен сигналами кажется, на первый взгляд, совершенно хаотичным. По истечении некоторого времени, как правило, нескольких долей секунды или около того, хаотическое взаимодействие нейронов стихает, и возникает устойчивый «рисунок». Эта «рисунок» представляет собой «решение» нейронной сети. Если нейронная сеть выполняет задачу распознавания образов (которая, между прочим, составляет основную часть активности в человеческом мозге), то возникающий «рисунок» представляет собой результат соответствующего распознавания.

Таким образом, вопрос исследователей Сан-Диего заключался в том, могут ли электронные нейроны участвовать в этом хаотическом танце наряду с биологическими. Они связали свои искусственные нейроны и нейроны лангуста в одну сеть, и их гибридная биолого-небиологическая сеть вела себя таким же образом (то есть, начинала с хаотического взаимодействия и приходила к возникновению устойчивого «рисунка») и с теми же результатами, что и сеть, полностью состоящая из биологических нейронов. По сути, биологические нейроны приняли своих электронных двойников. Это свидетельствует, что математическая модель искусственных нейронов была достаточно точной.

В мире существует множество проектов, создающих небиологические устройства, которые в мельчайших деталях воссоздают функциональность кластеров нейронов человека. Точность и масштаб этих искусственных кластеров нейронов быстро растёт. Мы начали с воссоздания функционально эквивалентных одиночных нейронов, затем кластеров из десятков, затем сотен, а теперь и тысяч нейронов. Масштабирование технических процессов с экспоненциальной скоростью — это как раз то, в чём хороши технологии.

По мере того, как будет становиться доступной вычислительная мощность для эмуляции человеческого мозга (пока ещё её не хватает, но она появится в течении пары десятков лет) уже осуществляемые проекты по сканированию человеческого мозга будут ускорены, имея в виду цели как понять человеческий мозг в целом, так и получить подробное описание устройства и содержания его конкретных экземпляров. К третьей декаде двадцать первого века мы сможем создать очень подробные и полные карты всех необходимых характеристик всех нейронов, нейронных связей и синапсов в мозге человека, всех деталей, которые играют роль в поведении и функционировании мозга, и воссоздать всё это в достаточно совершенных нейронных компьютерах.

Отличается ли человеческий мозг от компьютера?

Отличается ли человеческий мозг от компьютера?

Ответ зависит от того, что мы подразумеваем под словом «компьютер». Конечно, мозг использует принципы, сильно отличающие его от обычных современных компьютеров. Большинство современных компьютеров являются цифровыми и выполняют одно (или, возможно, несколько) вычислений за одну единицу времени с чрезвычайно высокой скоростью. Напротив, человеческий мозг сочетает цифровые и аналоговые методы, причём большинство вычислений выполняется в аналоговой форме. Мозг использует массовый параллелизм, выполняя порядка ста триллионов вычислений одновременно, но с чрезвычайно низкой скоростью.

Что касается цифровых вычислений по отношению к аналоговым, мы знаем, что цифровые вычисления могут быть функционально эквивалентны аналоговым вычислениям (хотя обратное неверно), поэтому мы можем реализовать все возможности гибридной цифроаналоговой сети используя полностью цифровой компьютер. С другой стороны, аналоговые схемы имеют конструктивное преимущество — аналоговые вычисления, потенциально, в тысячи раз эффективнее. Аналоговое вычисление может быть выполнено на нескольких транзисторах или, в случае нейронов млекопитающих, специфическими электрохимическими процессами. Цифровые вычисления, напротив, требуют тысячи или десятки тысяч транзисторов. Таким образом, эмуляция аналоговых методов мозга даст существенное конструктивное преимущество.

Массовый параллелизм человеческого мозга является ключом к его способностям по распознаванию образов, которое отражает силу человеческого мышления. Как я уже описывал выше, нейроны млекопитающих участвуют в хаотическом танце, и если нейронная сеть хорошо усвоила свои уроки, то в результате появляется стабильный «рисунок», отражающий решение сети. Нет никаких причин, по которым наши небиологические функционально эквивалентные аналоги биологических нейронных сетей не могут быть построены с использованием этих же принципов, и на самом деле, во всём мире существуют десятки проектов, которые добились в этом успеха. Моя собственная область деятельности — распознавание образов, и проекты, в которых я принимал участие на протяжении более чем тридцати лет, используют эту форму хаотических вычислений. Особенно успешными примерами являются нейронные чипы, созданные Карвером Мидом, которые являются высокопараллельными, используют аналогово-цифровые вычисления с цифровым управлением и предназначены для воссоздания функционально аналогичных биологических нейронных сетей.

Объективное и субъективное

Сингулярность предполагает появление похожих на человека интеллектуальных сущностей удивительного разнообразия и возможностей. Хотя эти сущности будут способны пройти «тест Тьюринга» (т.е. будут способны выдать себя за людей перед другими людьми), возникает вопрос о том, являются ли эти «люди» сознательными или просто кажутся такими. Чтобы получить некоторое представление о том, почему это чрезвычайно тонкий вопрос (хотя и чрезвычайно важный), полезно рассмотреть некоторые парадоксы, возникающие из концепции загрузки какого-либо конкретного человеческого мозга.

Хотя я ожидаю, что наиболее распространённым применением знаний, полученных в результате реконструкции человеческого мозга, будет создание более интеллектуальных машин, которые совсем не обязательно воспроизведут конкретных биологических людей, сценарий сканирования и воссоздания всех нейронных деталей конкретного человека ставит самые серьёзные вопросы идентичности. Давайте рассмотрим вопрос о том, с чем мы столкнёмся, когда сделаем это.

Мы должны рассмотреть этот вопрос как на объективном, так и на субъективном уровнях. «Объективный» тут означает всё, кроме меня, так что давайте начнём с него. Объективно, когда мы сканируем чей-то мозг и воссоздаём его разум в подходящей вычислительной среде, сей возникший «человек» будет казаться другим наблюдателям практически той же самой личностью, с той же историей и памятью, что и человек, мозг которого сосканировали. Именно так, как только соответствующая технология будет создана и доведена до совершенства. Как и любая новая технология, поначалу она не будет идеальной. Но, в конечном итоге, сканирование и воссоздание станут очень точными и реалистичными.

Взаимодействие с воссозданным человеком будет восприниматься как взаимодействие с исходным человеком. Новый человек будет претендовать на то, чтобы быть тем же самым исходным человеком, и будет иметь память о том, что он был им. Новый человек будет иметь набор знаний, навыков и личность оригинала. Мы уже способны создавать функционально эквивалентные модели нейронов и их кластеров с точностью достаточной, чтобы биологические нейроны принимали свои небиологические эквиваленты и работали с ними, как если бы они были биологическими. Нет никаких естественных ограничений, которые мешают нам делать то же самое с сотнями миллиардов кластеров нейронов, которые мы называем человеческим мозгом.

Субъективно, эта проблема является более тонкой и глубокой, но сначала мы должны задуматься над одним дополнительным объективным вопросом: нашим физическим Я.

Насколько важно иметь тело

Подумайте, сколько наших мыслей и внимания направлено на наше тело и его выживание, безопасность, питание и внешний вид, не говоря уже о привязанности, сексуальности и воспроизводстве. Многие, если не большинство, целей, которые мы пытаемся достичь, используя наш мозг, связаны с нашим телом: защищать его, снабжать топливом, делать привлекательным, обеспечивать комфорт, удовлетворять его бесчисленные потребности и желания. Некоторые философы утверждают, что достижение человеческого уровня интеллекта невозможно без тела. Если мы собираемся перенести разум человека в новую вычислительную среду, нам хорошо бы предоставить ему тело. Бестелесный ум быстро впадёт в депрессию.

Мы предоставим нашим машинам множество разных тел, и множество они создадут себе сами: тела, построенные с помощью нанотехнологий (т.е. построенные атом за атомом очень сложные физические системы), виртуальные тела (которые существуют только в виртуальной реальности), тела, состоящие из стай наноботов и т.п.

Распространённым сценарием будет усиление биологического мозга человека тесной связью с небиологическим интеллектом. В этом случае тело остаётся старым добрым человеческим организмом с которым мы знакомы, хотя и он также значительно улучшится благодаря биотехнологиям (усиление и замена генов), а затем и благодаря нанотехнологиям. Подробное исследование тел двадцать первого века выходит за рамки этого эссе, но воссоздание и улучшение наших тел будет (и было) более лёгкой задачей, чем воссоздание нашего разума.

Так кто же эти люди?

Чтобы вернуться к вопросу субъективности, подумайте: является ли восстановленный разум тем же сознанием, что и человек, которого мы только что отсканировали? Являются ли вообще эти «люди» сознательными? Это разум или просто мозг?

Сознание в наших машинах двадцать первого века будет критически важной проблемой. Но её нелегко решить или даже хотя бы понять. Люди склонны иметь твёрдые убеждения на этот счёт, и, как правило, они просто не могут понять, как кто-то ещё может увидеть эту проблему с другой точки зрения. Марвин Мински (Marvin Minsky) заметил, что «есть что-то странное в описании сознания. Что бы люди ни хотели сказать, они просто не могут сделать это ясно и чётко».

Мы не беспокоимся, по крайней мере пока, о причинении боли и страданий нашим компьютерным программам. А в какой момент мы считаем сущность или процесс сознательным, способным ощущать боль и дискомфорт, иметь собственные намерения, свою свободную волю? Как мы определяем, является ли сущность сознательной, имеет ли она субъективные ощущения? Как мы отличаем процесс, который является сознательным, от процесса, который действует так, как если бы он был сознательным?

Мы не можем просто спросить об этом. Если он говорит «Эй, я в сознании», это решает проблему? Нет, уже сегодня у нас есть компьютерные игры, которые, по сути, делают это, и они не очень убедительны.

Что, если некая сущность действительно очень убедительно и реалистично говорит: «Я одинока, пожалуйста, составь мне компанию.» Это решает проблему?

Если мы заглянем внутрь её схем и увидим, по существу, идентичные виды петель обратной связи и другие механизмы, такие же, какие мы видим в человеческом мозге (хотя и реализованные с использованием небиологических эквивалентов), решает ли это проблему?

И вообще, кто эти люди в машине? Ответ будет зависеть от того, кого вы спрашиваете. Если вы спросите людей в машине, они будут упорно претендовать на то, что они и есть оригинальные люди. Например, если мы сканируем — скажем, меня — и записываем точное состояние, уровень и положение каждого нейротрансмиттера, синапса, нервной связи и всех других соответствующих деталей, а затем восстанавливаем этот огромный массив информации (который я оцениваю в тысячи триллионов байт) в нейронный компьютер достаточной ёмкости, человек, который при этом появится в машине, будет думать, что «он» — есть (и был) я, или, по крайней мере, он будет действовать таким образом. Он скажет: «Я вырос в Квинсе, Нью-Йорк, учился в колледже в Массачусетском технологическом институте, остался в районе Бостона, основал и продал несколько компаний, занимающихся искусственным интеллектом, зашёл там в сканер и проснулся здесь в машине. Эй, эта технология действительно работает.

Погодите-ка!

Это действительно я? С одной стороны, старый биологический Рэй (то есть я) всё ещё существует. Я всё ещё буду здесь, в моём мозге на основе углеродных клеток. А с другой, мне придётся сидеть и смотреть, как новый Рэй добьётся успеха в начинаниях, о которых я мог только мечтать.

Продолжение тут