Победителем этого конкурса стал наш соотечественник Селим Сефербеков, проживающий сейчас в Минске.

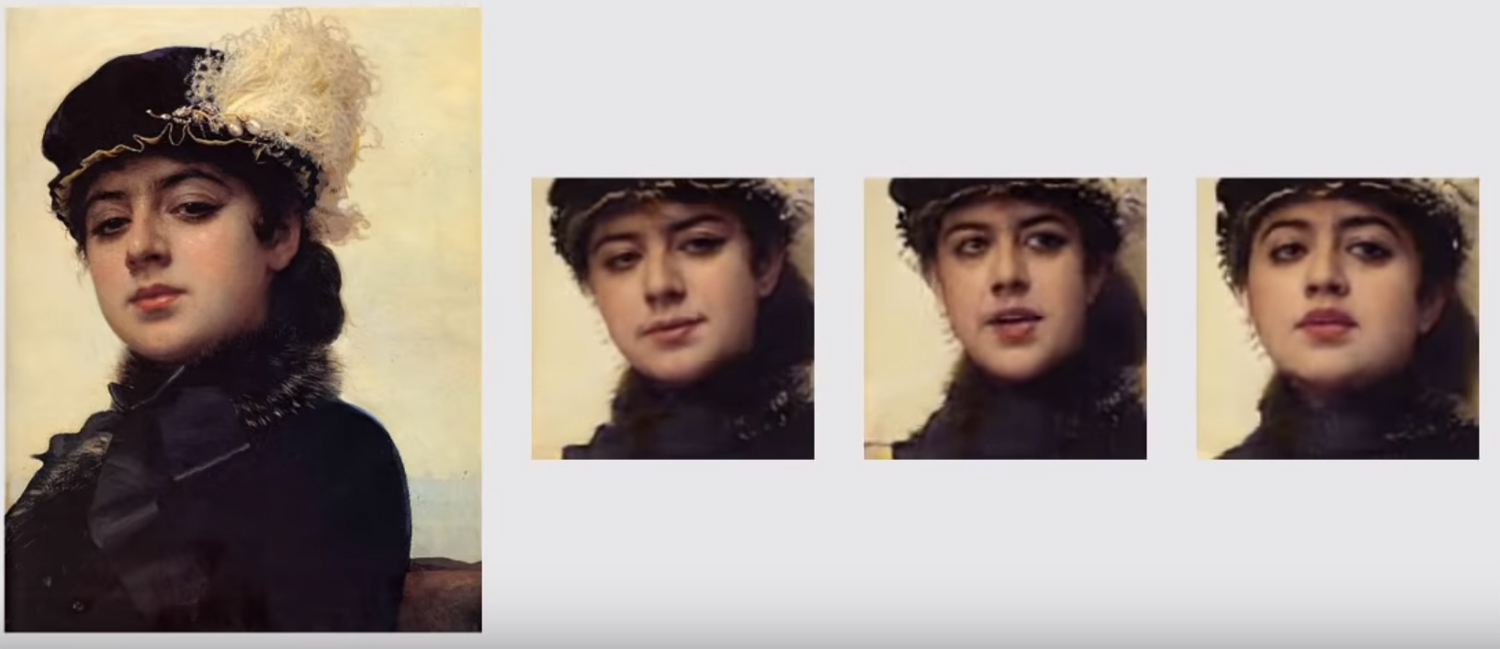

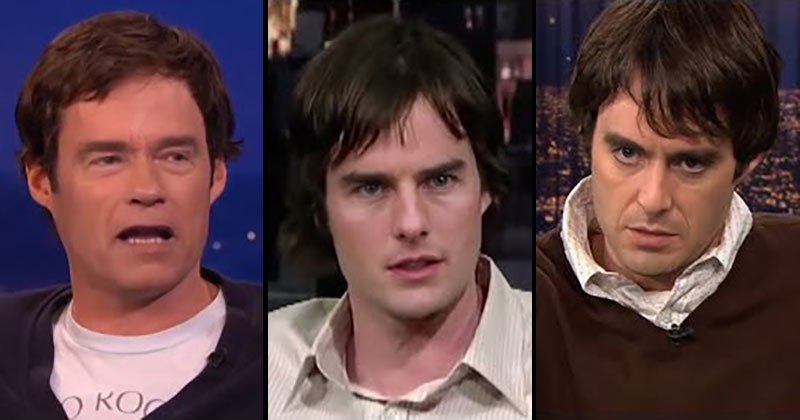

На Youtube опубликовано видео интервью, в котором Селим рассказывает о том что позволило ему победить других участников.

Победа не достаётся легко, особенно если борешься в одиночку.

Нет тренера или коллег, которые смогут поделиться опытом, идеями, наблюдениями.

Салиму пришлось бороться с такими крупными командами, как NTechLab (заняла 3-е место) или ID R&D (заняла восьмое место), решение ID R&D имеет сертификат первого и второго уровня по выявлению обмана лицевой биометрии от лаборатории iBeta (лаборатория iBeta сертифицирована NIST – Национальный институт стандартов и технологий США).