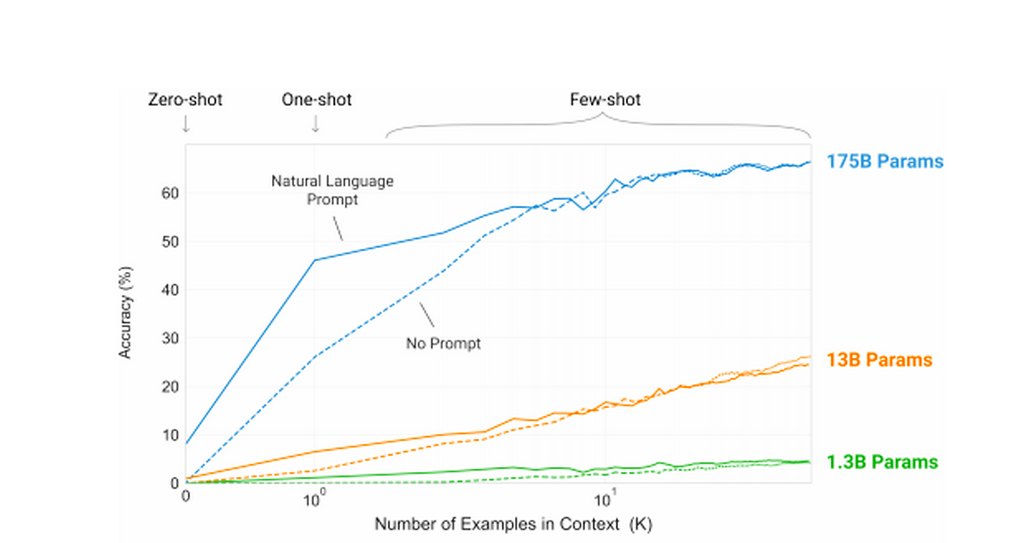

Специалисты из OpenAI опубликовали исследование, в котором описали, как при помощи языковой модели GPT-4 они пытались объяснить работу нейронов её предшественницы, GPT-2. Сейчас разработчики компании стремятся продвинуться в «интерпретируемости» нейросетей и понять, почему те создают именно тот контент, который мы получаем.

В первом же предложении своей статьи авторы из OpenAI признаются: «Языковые модели стали более функциональными и более распространёнными, но мы не понимаем, как они работают». Но в будущем наличие интерпретируемой модели ИИ помогло бы достичь глобальной цели, которую называют «согласование ИИ». В этом случае у нас появились бы гарантии, что системы ИИ будут вести себя так, как задумано, и отражать человеческие ценности.