В этой статье мы рассмотрим ряд необязательных, но полезных настроек:

Эта статья — продолжение, начало см. oVirt за 2 часа Часть 1 и часть 2.

- использование дополнительных имен для менеджера;

- подключение аутентификации через Active Directory;

- Mutlipathing;

- управление питанием;

- замена SSL сертификата;

- архивация;

- менеджмент-интерфейс хостов (cockpit);

- VLANs;

- специфичное для HPE.

Эта статья — продолжение, начало см. oVirt за 2 часа Часть 1 и часть 2.

Статьи

- Введение

- Установка менеджера (ovirt-engine) и гипервизоров (hosts)

- Дополнительные настройки — Мы здесь

- Базовые операции

В преддверии выхода новых моделей дисковых массивов P6000 EVA, я хочу показать насколько просты и эффективны эти массивы в работе.

В преддверии выхода новых моделей дисковых массивов P6000 EVA, я хочу показать насколько просты и эффективны эти массивы в работе.

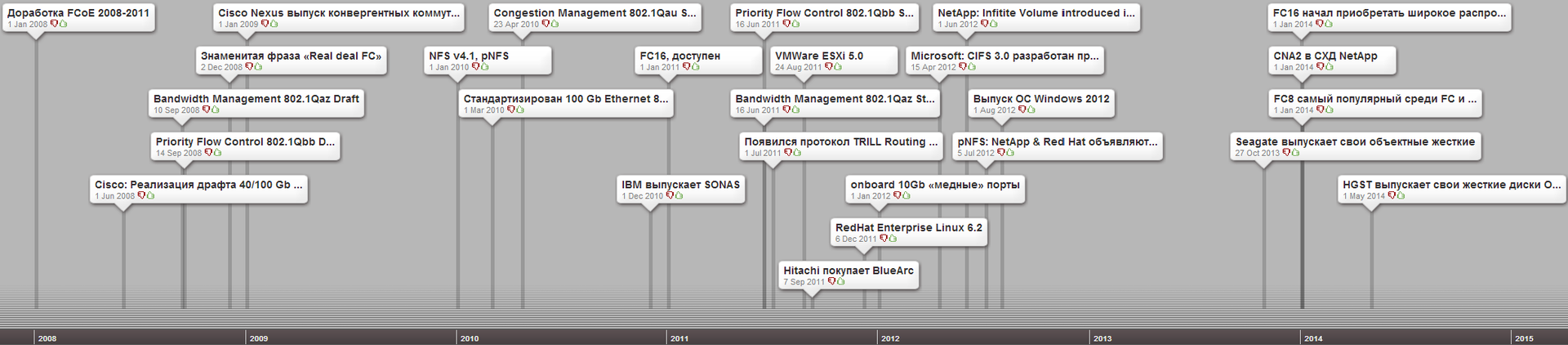

Про грядущую смерть Fibre Channel говорят разве что чуть меньше, чем про смерть ленточных накопителей. Еще когда скорость была ограничена 4 Гбит, уже тогда на смену FC прочили новомодный iSCSI (пусть вменяемый бюджет только на 1 Гбит вариант, но 10 где-то уже совсем рядом). Время шло, а 10Гбит ethernet оставался слишком дорогим удовольствием и к тому же не мог обеспечить низкую латентность. ISCSI в качестве протокола общения серверов с дисковыми системами хоть и получил значительное распространение, но полностью вытеснить FC так и не смог.

Про грядущую смерть Fibre Channel говорят разве что чуть меньше, чем про смерть ленточных накопителей. Еще когда скорость была ограничена 4 Гбит, уже тогда на смену FC прочили новомодный iSCSI (пусть вменяемый бюджет только на 1 Гбит вариант, но 10 где-то уже совсем рядом). Время шло, а 10Гбит ethernet оставался слишком дорогим удовольствием и к тому же не мог обеспечить низкую латентность. ISCSI в качестве протокола общения серверов с дисковыми системами хоть и получил значительное распространение, но полностью вытеснить FC так и не смог.