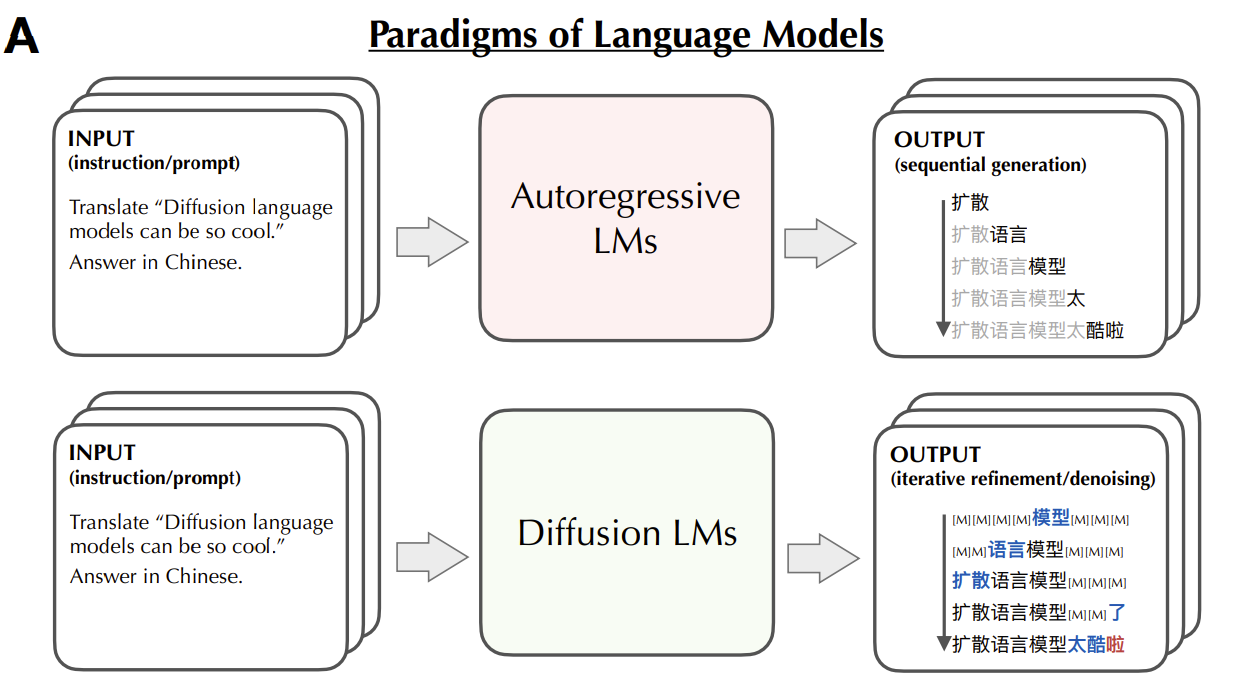

Как работает ваш мозг, когда вы говорите на иностранном языке? Сначала переводит внутри на родной или сразу понимает и формулирует фразы на иностранном? Скорее всего, каждый человек ответит на это по-своему, а ответ будет зависеть и от уровня владения языком, и от того, по какой методике вас этому языку учили, и от особенностей мышления и речи вообще. Тем интереснее понять, как с этим обстоят дела у больших языковых моделей. Их обучают преимущественно на английских текстах, но как-то невзначай они вдруг начинают неплохо говорить и на других языках. Да, похуже, чем на английском, но всё-таки вполне достойно. Так что закономерно, что на общей волне интереса к интерпретируемости AI возникает запрос разобраться с этой мультиязычностью моделей.

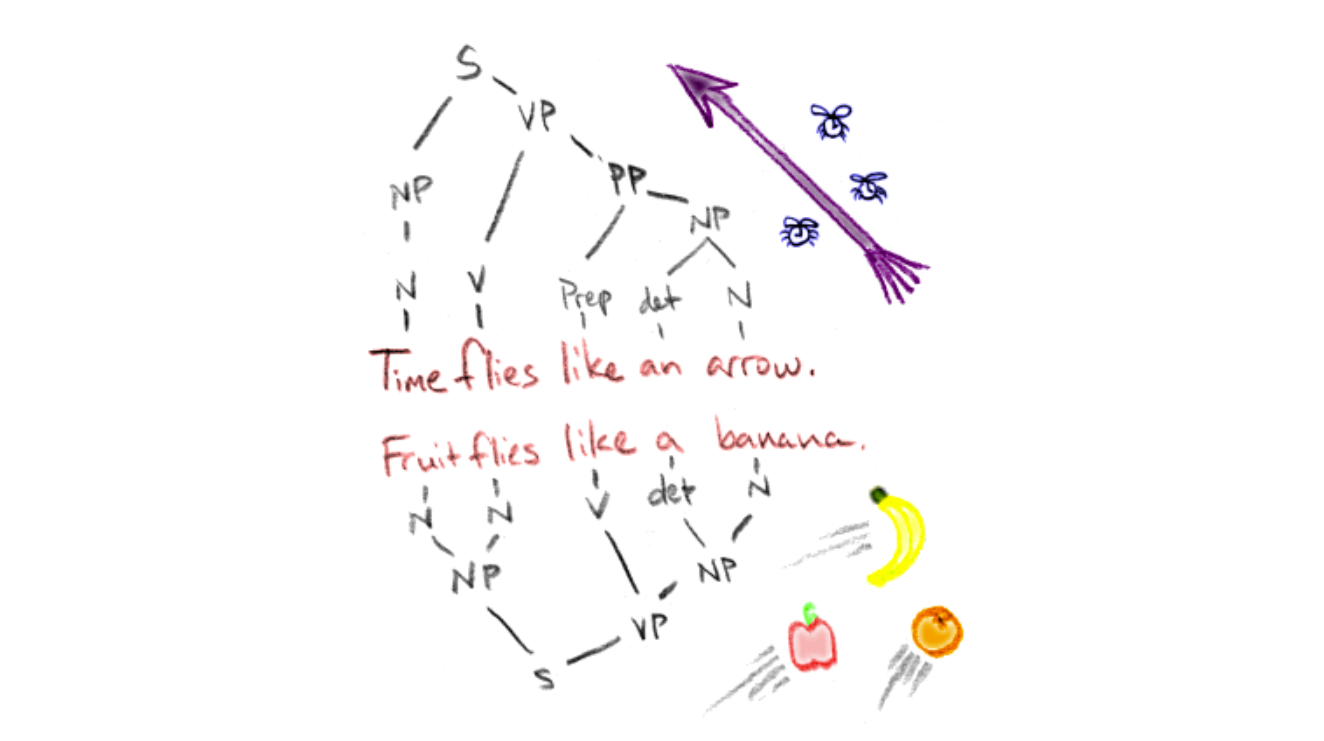

Интуитивно (а вообще просто по аналогии с человеком) кажется, что раз модель обучалась на английском, то он должен быть ее “родным” языком. То есть когда мы спрашиваем GPT на русском, он внутри сначала переводит на английский, там же формулирует ответ, а затем переводит обратно на русский. Если это действительно верно, то это означает, что у модели есть некоторый уклон не только к англоязычной грамматике и лексике, но отсюда и к соответствующим метафорам, логике, поведению. То есть, к менталитету англоязычного мира. А если это неверно? Тогда еще хуже — тогда совершенно непонятно, как модель достигает такого хорошего результата на таком скромном объеме обучающих данных.