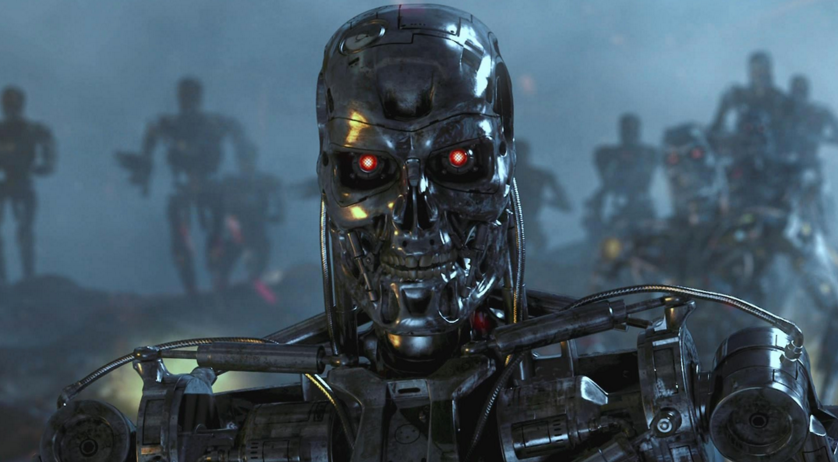

Как бы намекает

Бывший сотрудник Пентагона, который участвовал в разработке стратегии применения автономного вооружения утверждает, что в реальных условиях оно может быть неуправляемым и существует возможность взлома, подмены и манипуляций со стороны противника.

В последнее время недорогие датчики и новые технологии искусственного интеллекта стали более практичными, что сделало возможным их использование в разработках автономных систем вооружения. Призрак так называемых «роботов-убийц» уже спровоцировал международное движение протеста и дискуссии в ООН об ограничении разработки и внедрения таких систем, сообщает nytimes.com.

Доклад был написан Полом Шерри, который руководит программой по разработке приемов ведения «войны будущего» в Центре Новой Американской Безопасности (Вашингтон, Колумбия). С 2008 по 2013 годы Шерри работал в кабинете министра обороны США, где помог разработать стратегию применения автономного оружия. В 2012 году он стал одним из авторов директивы Министерства обороны, которая устанавливала военную политику по использованию подобных систем.

В докладе «Автономное оружие и операционный риск», который был опубликован в понедельник, Шерри предупреждает о ряде реальных рисков, связанных с оружейными системами, являющимися полностью автономными. Он противопоставляет полностью автоматизированные системы, которые могут убивать без вмешательства человека, оружию, которое «держит людей в курсе» в процессе выбора и поражения цели (т.е. используется оператор).

Шерри, который служил в армии США рейнджером и участвовал в операциях в Ираке и Афганистане, фокусируется на потенциальных видах ошибок, которые могут возникнуть в полностью автоматизированных системах. Чтобы подчеркнуть военные последствия, в докладе перечисляются неудачи, которые произошли в армейских и коммерческих системах с высокой степенью автоматизации.

«Любой, кто когда-либо разочаровывался в автоматизированной телефонной поддержке телефона доверия, будильнике, ошибочно установленном на „вечер“ вместо „утро“ и так далее, испытал проблему „хрупкости“, которая присутствует в автоматизированных системах», пишет Шерри.

Основой его доклада является то, что автономным системам вооружения не хватает «гибкости», т.е. в процессе выполнения такой системой задания могут возникнуть ошибки, которых люди смогли бы избежать.

Полностью автономное оружие начинает появляться в военных арсеналах различных государств. Например, Южная Корея установила автоматическую турель вдоль демилитаризованной зоны с Северной Кореей, а в Израиле стоит на вооружении беспилотный летательный аппарат, который запрограммирован атаковать радиолокационные системы противника при их обнаружении.

Военные США не используют автономное оружие. Тем не менее, в этом году Министерство обороны запросило почти $1 млрд для производства оружия корпорацией Lockheed Martin Long Range Anti-Ship Missile, которое описывается как «полуавтономное». Хотя оператор и будет сначала выбирать цель, но вне контакта с человеком оно автоматически будет идентифицировать и атаковать вражеские войска.

Основное внимание уделяется ряду неожиданностей в поведении компьютерных систем, таких как сбои и ошибки, а также непредвиденные взаимодействия с окружающей средой.

«Во время своего первого испытания над Тихим океаном в восьми истребителях F-22 полностью отказала система компьютера Y2K, так как они пересекли линию перемены даты», говорится в докладе. «Все бортовые компьютерные системы отказали, и результат был почти катастрофическим — потеря самолета. Хотя существование линии перемены дат давно известно, результат взаимодействия с программным обеспечением не был целиком протестирован».

В качестве альтернативы полностью автономному оружию, в докладе ратуют за то, что называется «Centaur Warfighting» (Комбинированное вооружение? По сути, непереводимая игра слов прим.). Термин «centaur» стал применяться для описания систем, в которых тесно интегрируют работу людей и компьютеров. В шахматах, например, команды, которые используют и людей, и программы искусственного интеллекта доминируют в соревнованиях против команд, которые используют только искусственный интеллект.

Тем не менее, в телефонном интервью Шерри признал, что просто оператора, «нажимающего на кнопки», мало. «Наличие просто „оповещенного“ о действиях машины человека недостаточно», сказал он. «Они (люди) не могут быть просто частью алгоритма работы системы. Человек должен активно участвовать в принятии решений».