Привет, HABR! В постоянно меняющемся мире сфера IT как одна из самых молодых пытается держаться на переднем плане. И мы, системные инженеры, должны учитывать все факторы окружающей среды, чтобы оставаться на плаву в этом неспокойном море.

Быт инженера госкорпорации ознаменован девизом «Импортозамещение – наше всё!»,

и это диктует свои правила адаптации. В этом материале мы посмотрим на ДОМашний ландшафт IT-решений, а конкретно – на системы хранения данных российского производства.

Будучи избалованными крупными иностранными IT-игроками, продукция которых десятилетиями выковывалась на наковальнях «магического квадранта Гартнера» и потому предлагает многообразие фич, мы столкнулись с рядом сложностей при выборе систем хранения данных.

Непредсказуемыми IOPS-ами и устойчивостью при длительном использовании во времена тотальной дифференциации по цвету штанов уже никого не удивить, но вернуться во времена легендарных первых поколений EMC CLARiiON и HP MSA, пожалуй, было несколько неожиданно.

Что сейчас

На запрос «СХД российского производства» мы получаем постоянно растущий список производителей:

АЭРОДИСК

Норси Транс

BAUM

Bitblaze

DEPO

ICL Техно

RCNTEC

RAIDIX

YADRO

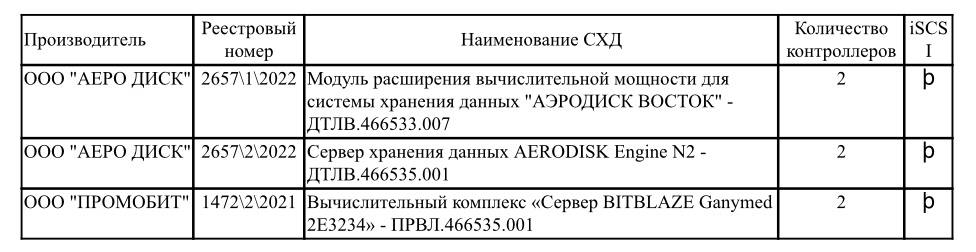

В контексте импортозамещения обязательным условием для нас является нахождение рассматриваемого продукта в реестрах Минпромторга. Отметим, что российским с точки зрения постановления Правительства РФ от 3/12/2020 №2013 признаётся товар, включенный: в реестр промышленной продукции, произведенной на территории РФ, или в единый реестр российской радиоэлектронной продукции.

Теперь оценим СХД со стороны сисадмина, который спокойно спит по ночам:

Два контроллера, имеющих одновременный доступ ко всем данным СХД;

Подключение к серверам по протоколу iSCSI (отечественного оборудования коммутации по протоколу FC ещё не завезли);

Отказоустойчивое подключение каждого контроллера к независимым сетевым фабрикам;

Доступная 24/7 и квалифицированная техническая поддержка.

В целевых реестрах представлены и другие продукты из мира хранения данных, удовлетворяющие нашим ожиданиям, но не влияющие на достижение КПЭ в классе СХД.

Получаем список претендентов на премию «внедрение года»:

АЭРОДИСК ВОСТОК БИТБЛЭЙЗ E3113HL сертификат РЭ-4650/22 действителен

до 31.03.2023;АЭРОДИСК ВОСТОК 2Э8СВ сертификат РЭ-7047/22 действителен до 05.06.2025;

YADRO TATLIN.UNIFIED сертификат РЭ-713/21 действителен до 31.03.2023.

Наши участники от мала до велика

Оговорочка – вся использованная в данном разделе информация получена из открытых источников.

АЭРОДИСК ВОСТОК БИТБЛЕЙЗ E3113LH

Источники:

Шасси СХД BITBLAZE Sirius 3113LH/3123LH (1)

Новость 2021 года о том, что компании «Аэродиск» и «Промобит» представили совместную разработку — двухконтроллерную СХД «Аэродиск Восток Битблейз», построенную на базе процессоров «Эльбрус-8СВ» (2)

Эталонная материнская плата МЦСТ на базе ЦПУ Эльбрус 8СВ – 1Э8СВ-uATX (3)

Список совместимой с Эльбрус 8СВ ОЗУ (4)

Спецификация производителя:

Узлы контроллерной пары соединяются между собой с помощью интерфейса 10 Гбит/с Ethernet;

2 процессора Эльбрус 8СВ архитектура E2Kv5, 16 ядер на контроллерную пару;

Оперативная память 8 планок, суммарно до 512 ГБ на контроллерную пару;

Front-end адаптер Ethernet 4x25Gb/s SFP28;

24 слота LFF 3.5” SAS3 с подключением к двум контроллерам в одном корпусе с контроллерами СХД;

До 304 штук NL-SAS 3.5” HDD;

До 304 штук SAS3 2.5” SSD

Наблюдения и выводы инженеров ДОМ.РФ:

Позиционирование – СХД начального уровня;

Все компоненты стандартные и могут быть найдены на открытом рынке;

Использование с HDD не даёт преимуществ перед размещением дисков внутри серверов;

Для раскрытия потенциал ПО АЭРОДИСК ВОСТОК необходимо применение двухканальных твердотельных ПЗУ класса Read Intensive ёмкостью 7.68 ТБ (7 ТиБ) в количестве не менее 16 шт.;

Для максимального использования полосы системных шин рекомендовано применение сетевых интерфейсов со скоростью менее 25 Гбит/с в режиме RoCEv2;

Учитывая расширение номенклатуры модулей оперативной памяти, поддерживаемых процессорами Эльбрус 8СВ, рекомендуется перейти на модули 64 ГБ для достижения общей ёмкости ОЗУ в 512 ГБ, что должно положительно сказаться на работе механизма дедупликации;

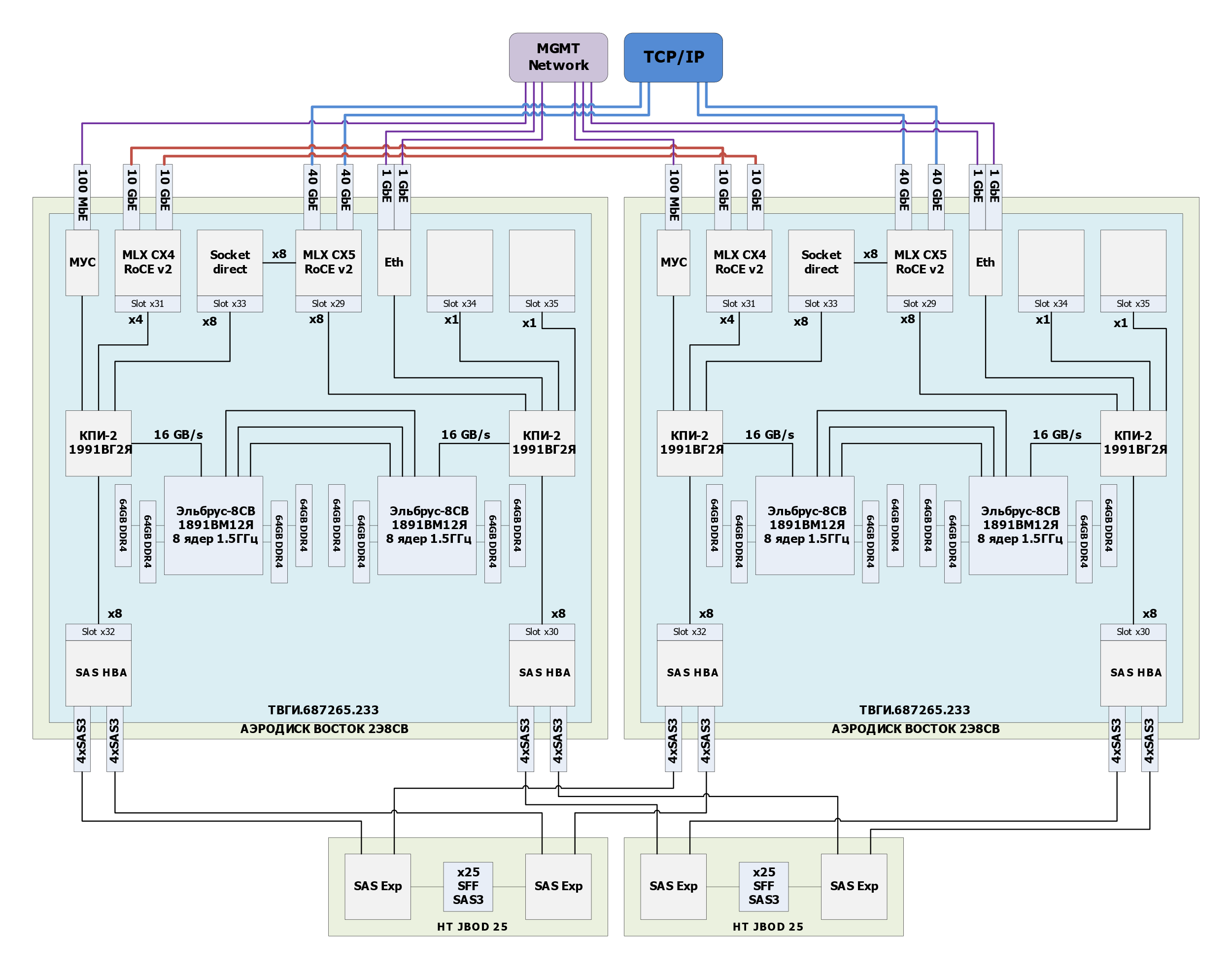

Структурная схема системы хранения данных согласно «идеалу инженеров ДОМ.РФ»:

АЭРОДИСК ВОСТОК 2Э8СВ

Источники:

Эталонная материнская плата на базе 2 процессоров Эльбрус 2СВ – 2Э8СВ-EATX (9)

Список совместимой с Эльбрус 8СВ ОЗУ (4)

Описание дисковой полки НТ JBOD 25 (10)

Спецификация производителя:

Узлы контроллерной пары соединяются между собой с помощью SAS Beck-End через SAS Expander и кластерный интерфейс 10 Гбит/с Ethernet

4 процессора Эльбрус 8СВ архитектура E2Kv5, 32 ядра на контроллерную пару

Оперативная память 16 планок, суммарно до 1024 ГБ на контроллерную пару

Front-end адаптер Ethernet 4x25Gb/s SFP28

Модуль расширения дисковой емкости 4U на 108 HDD 3,5” SAS 3.0 (не в реестре)

Модуль расширения дисковой емкости 4U на 72 HDD 2,5” SAS 3.0 (не в реестре)

Модуль расширения дисковой емкости 4U на 60 HDD 3,5” SAS 3.0 (не в реестре)

Модуль расширения дисковой емкости 4U на 24 HDD 3,5” SAS 3.0 (не в реестре)

Модуль расширения дисковой емкости 2U на 12 HDD 3,5” SAS 3.0 (не в реестре)

Модуль расширения дисковой емкости 2U на 24 SSD 2,5 SAS 3.0 (не в реестре)

До 608 штук NL-SAS 3.5” HDD

До 608 штук SAS3 2.5” SSD

Наблюдения и выводы инженеров ДОМ.РФ:

Позиционирование – СХД среднего уровня;

Все компоненты стандартные и могут быть найдены на открытом рынке;

Для создания полностью реестровой СХД в классе ОКПД 26.20.2 необходимо использовать официально неподдерживаемый модуль расширения дисковой емкости «НТ» JBOD-25» - 2U на 25 SFF 2,5” SAS3 (сертификат РЭ- 4333/22 действителен до 31.03.2023);

Использование HDD целесообразно в количестве от 160 штук с равномерным распределением на две дисковые полки на 108 HDD (не реестровая конфигурация),

что позволяет эффективно утилизировать шины данных в сценариях чтения с внутренних дорожек дисковых накопителей;Для раскрытия потенциала ПО АЭРОДИСК ВОСТОК необходимо применение двухканальных твердотельных ПЗУ класса Read Intensive ёмкостью 7.68 ТБ (7 ТиБ) или более в количестве не менее 32 шт.;

Для максимального использования полосы системных шин рекомендовано применение сетевых интерфейсов со скоростью не менее 40 Гбит/с и двухсокетной топологией сетевого адаптера в режиме RoCEv2;

Учитывая расширение номенклатуры модулей оперативной памяти, поддерживаемых процессорами Эльбрус 8СВ, рекомендуется перейти на модули 64 ГБ для достижения общей ёмкости ОЗУ в 1ТБ, что должно положительно сказаться на работе механизма дедупликации;

Структурная схема системы хранения данных согласно «идеалу инженеров ДОМ.РФ»:

YADRO Tatlin.Unified

Источники:

Спецификация производителя:

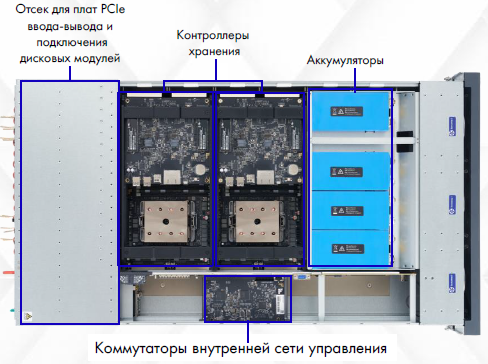

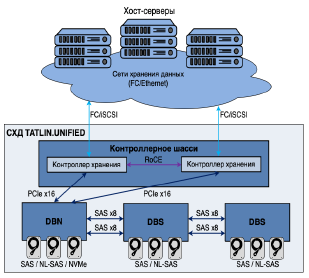

Узлы контроллерной пары соединяются между собой с помощью RDMA-NTB 2х100 Гбит/с RoCEv2;

4 процессора RISC архитектуры, 64 ядра на контроллерную пару;

Оперативная память 32 планки по 32 ГБ, суммарно 1024 ГБ на контроллерную пару;

Front-end адаптер Ethernet 20 x 25ГБ/с SFP28;

Дисковая полка расширения DBN (70 3.5” SAS3 + 34 U.2 NVMe + 2 U.2 NVMe для Метаданных)

Дисковая полка расширения DBS (96 3.5” SAS3)

До 550 штук NL-SAS 3.5” HDD

До 550 штук SAS3 2.5” SSD

До 34 штук U.2 NVMe SSD

Наблюдения и выводы инженеров ДОМ.РФ:

Позиционирование: СХД верхнего уровня;

Все компоненты модифицированы и не могут быть найдены на открытом рынке;

Использование HDD целесообразно в количестве от 160 штук с использованием дисковых полок DBN и DBS), что позволяет эффективно утилизировать шины данных в сценариях чтения с внутренних дорожек дисковых накопителей;

Для раскрытия потенциал СХД необходимо применение двухканальных твердотельных ПЗУ класса Read Intensive ёмкостью 7.68 ТБ (7 ТиБ) или более в максимальном для этой системы количестве 34 шт.;

Для максимального использования полосы системных шин рекомендовано применение сетевых интерфейсов со скоростью не менее 25 Гбит/с в режиме RoCEv2;

Структурная схема системы хранения данных согласно «идеалу инженеров ДОМ.РФ»:

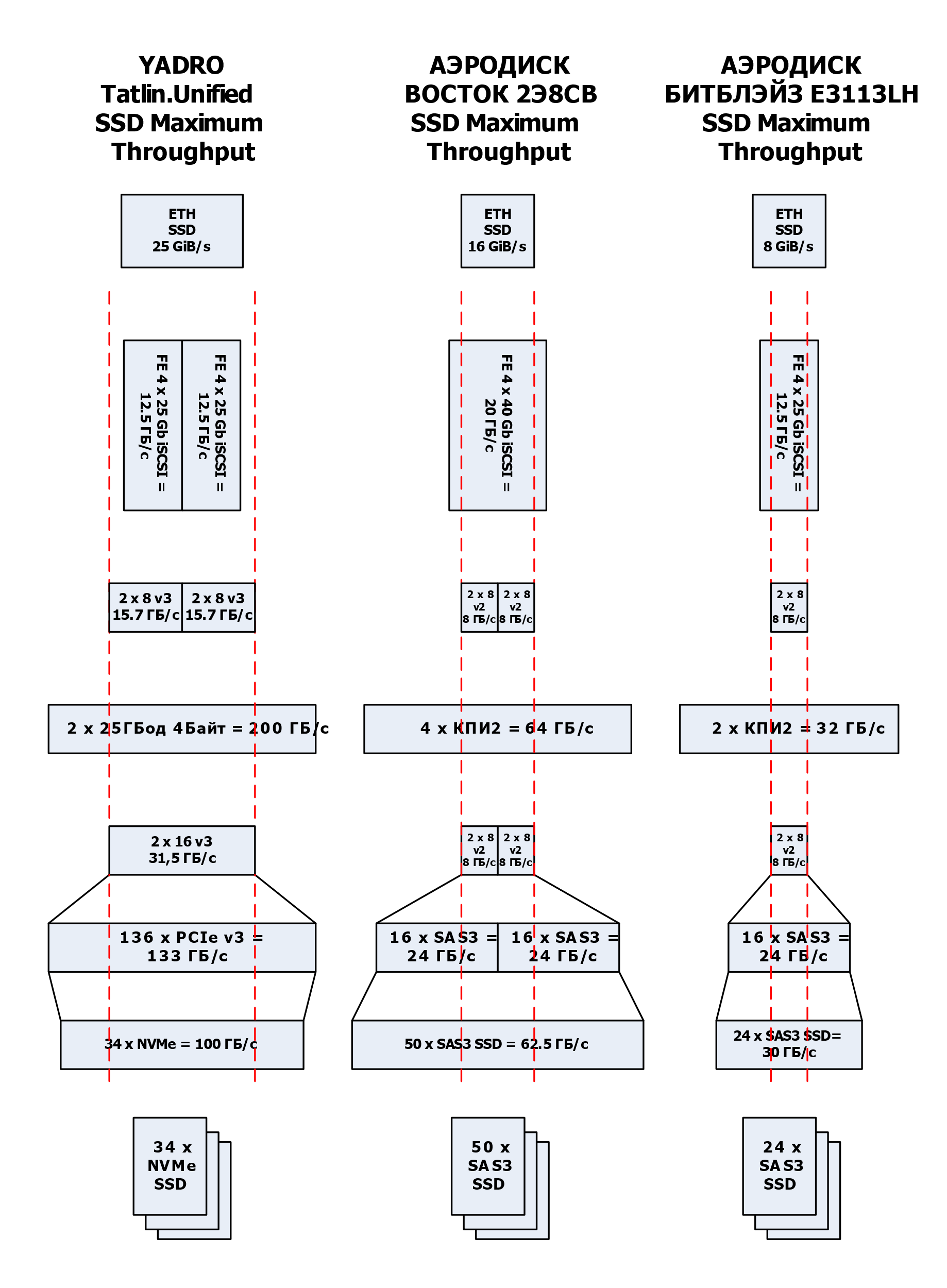

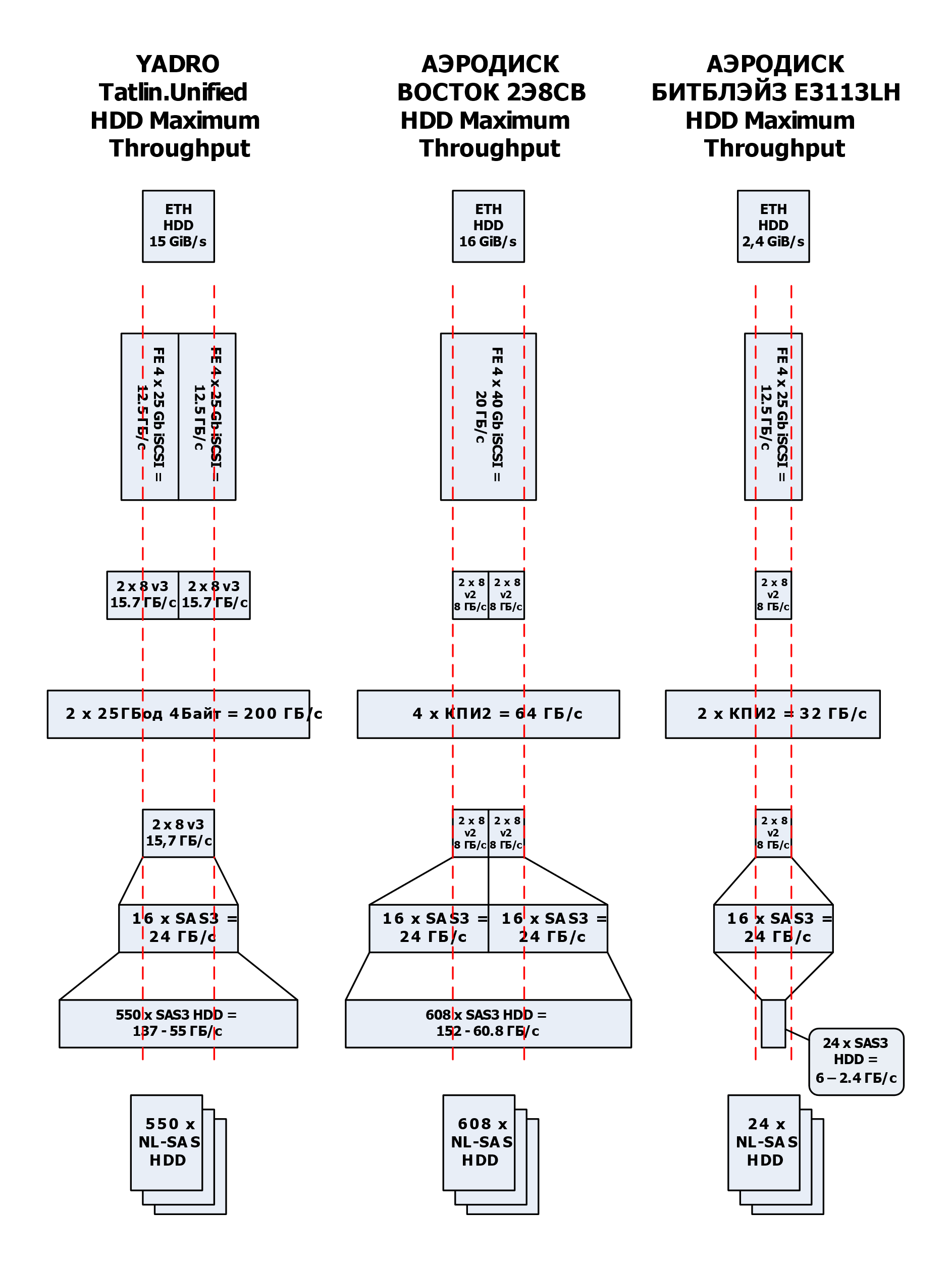

Сравнение несравнимого

Измерение длины удава (читай - суммарной задержки ввода-вывода от Front-End до Back-End) в СХД из трёх абсолютно разных миров – задача не исполнимая. Но у цилиндрического удава в вакууме российской радиоэлектронной отрасли остаётся ещё одно измерение – толщина, и измеряется она во всех понятных гигабайтах в секунду. Таким образом задача сводится к поиску бутылочного горлышка или ремня, который всегда предлагается затянуть потуже.

СХД АЭРОДИСК ВОСТОК БИТБЛЕЙЗ E3113LH с первых строк спецификации КПИ-2 (микросхема южного моста 1991ВГ2Я — контроллер ввода-вывода 2-го поколения собственной разработки МЦСТ) заявляет об использовании суперстабильной шины PCIe версии 2 с количеством линий - целых 20 единиц. Это весь бюджет полосы пропускания, отведённый как на работу с ПЗУ, так и на работу с сетевыми интерфейсами. В результате чего мы имеем два интерфейса PCIe 2.0 х8 (4Гбайт/с). Замечаем, что дуплексный режим двух таких интерфейсов равен 16ГБ/с и, о чудо, ширина канала между КПИ2 и ЦПУ Эльбрус 8СВ как раз 16 ГБ/с. Выдохнули, математика сошлась. Остальное отдаём на откуп программистам АЭРОДИСК.

В случае СХД АЭРОДИСК ВОСТОК 2Э8СВ мы получаем удвоение всех основных компонент: целых два процессора Эльбрус 8СВ и два чипа КПИ2 на каждый контроллер, что даёт нам удвоение максимальной пропускной полосы от Fron-End до Back-End. Но есть нюанс. На материнских платах с процессорами 8СВ разработчики избавились от такого пережитка, как переключение режимов интерфейсов PCIe из двух портов x8 в один x16, что отменяет использование HBA и сетевых карт расширенного формата. Здесь стоит отметить, что «панели» на базе ЦПУ поколения 8С таким функционалом обладают.

Наконец, перейдем к рассматриванию под нашим субъективным микроскопом СХД Yadro Tatlin Unified. Здесь всё сделано «по-большому». В наличии: аккумуляторы для завершения работы при обрыве питания, системная шина с поддержкой PCIe поколения 4, функционирующая в режиме совместимости с поколением 3. Первая дисковая полка подключается напрямую к шине PCIe, что сразу же удваивает полосу пропускания для - внимание! - только твердотельных ПЗУ. Для обычных вертушек по-прежнему доступны только порты PCIe шириной x8.

Давайте посмотрим на наших удавов с двумя головами в режимах SSD и HDD. Смешивать,

как это принято, не рекомендуется во избежание непредсказуемых последствий.

От теории к практике, или «что и как нам удалось потрогать…»

В продолжение нашего разговора об «идеальных цилиндрических СХД в российском вакууме» хотелось бы поделиться с вами нашим «особенным» опытом использования систем хранения данных Yadro Tatlin Unified.

На текущий момент весь наш опыт сводится лишь к инсталляции, настройке и проведению тестирований функционального и на отказоустойчивость. Но и такого опыта оказалось достаточно для написания целой статьи.

Итак.

Инсталляция

Здесь, пожалуй, самая простая часть.

Хотелось бы обратить внимание на несколько нюансов/деталей:

1. Производитель во всех материалах рекомендует использование шкафов глубиной 1200 мм, но это не всегда возможно в существующих ЦОД. При монтаже в стойку глубиной 1070 мм, похожей на APC AR3100, придётся попотеть и вызвать специалиста YADRO, обладающего этим видом кунг-фу.

2. Минимальный набор для запуска в работу СХД Yadro Tatlin Unified – это контроллерное шасси (3U) + дисковая полка расширения DBN (4U) с возможностью установки до 34 дисков NVMe и до 70 дисков SAS/NLSAS

Минимальное (7U) количество свободных юнитов необходимо запланировать заранее. Важно запланировать расширение для подключения дополнительных дисковых полок DBS (4U min и 20U max, до 5 полок, до 96 дисков SAS/NLSAS каждая) и один свободный юнит под cable management.

3. Накопители NVMe, размещенные на задней стороне полки DBN

4. Отсеки под накопители SAS/NLSAS, как в случае полки DBN, так и полки DBS, расположены сверху

Поэтому при установке и подключении дисковых полок расширения необходимо учитывать тот факт, что для замены накопителей потребуется эти полки выдвигать.

5. СХД прилично шумит. Находиться долго рядом с ней некомфортно. Скорее всего,

это связано с заботой о прохладной жизни всех компонент системы (контроллеры, аккумуляторы, накопители) и по-настоящему большим вентиляторам, установленным с лицевой стороны. Приходится работать на полных оборотах постоянно.

6. FE порты карт расширения (Eth, FC) ввода/вывода для подключения к фабрикам (NAS, SAN) настраиваются и работают в парах (симметричные порты с обоих контроллеров).

Этот нюанс необходимо учитывать при реализации корректного отказоустойчивого подключения.

7. Контроллерное шасси не содержит накопителей. Первая полка DBN, которая подключается к контроллерному шасси по интерфейсу PCIe 3.0, входит в минимальный комплект поставки. Все последующие полки DBS (максимум 5) подключаются цепочкой к полке DBN по интерфейсу SAS3.

8. Внешнее межконтроллерное соединение 100 GbE RoCE.

9. И самый главный нюанс – все инсталляционные работы проводятся ТОЛЬКО руками инженеров компании YADRO: и ремонтные работы, и сбор расширенных логов и т.д. Настоящий all-inclusive.

C инсталляцией и подключением более или менее понятно. Перейдем к «основному блюду» нашей СХДшной кухни – настройке.

Настройка

Опустим шаги первоначальной настройки, которые практически идентичны у разных вендоров. Отметим лишь нюансы.

1. Интерфейс.

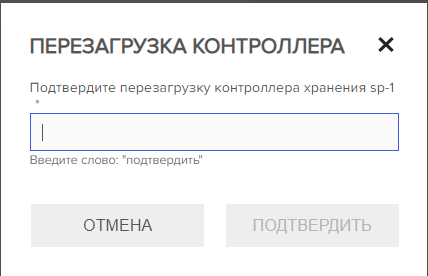

Попав в Tatlin WEBUI, первое, на что обращаешь внимание — это, конечно же, родной русский язык. И тут, действительно, приходит осознание всей глубины импортозамещения. Такой глубины, что даже для выполнения некоторых операций (удаление, перезагрузка, выключение) требуется набрать слово ПОДТВЕРДИТЬ. Английский тоже возможен, но зачем? В наличии пара-тройка непривычных названий (например, LUN – ресурс), но к ним быстро привыкаешь. Сам интерфейс достаточно понятный.

Управление и настройку возможно осуществлять и через Tatlin CLI (все подробности в документации на сайте поддержки YADRO).

2. Службы, оповещения, журналы событий.

При настройке NTP невозможно указать временную зону. При включенном оповещении по SMTP система раз в сутки посылает уведомление о своем состоянии. Отключить это невозможно, поэтому почтовый ящик администратора будет нуждаться в периодической чистке. Производитель уже разработал шаблоны для zabbix. Журнал событий присутствует, но он не показывает ничего, кроме заголовка ошибки. Не хватает детальной информации об ошибках на главном экране. В некоторых случаях на главном экране высвечиваются желтым логические объекты. Нажимаешь на иконку, попадаешь в закладку “Логические объекты”, а они все горят зеленым, никаких ошибок по ним нет. По итогу диагностики оказывается, что на порту, привязанному к логическому ресурсу, отсоединили оптический кабель. В этом направлении вендору предстоит пройти долгий и тернистый путь.

3. Пулы.

Пулы могут быть созданы лишь из дисков одного типа (нет тиринга). Администратор сам может выбирать необходимую схему защиты. В качестве технологии защиты данных

при отказе диска СХД использует собственную разработку «T-RAID», основанную на кодах Рида-Соломона. Напомним, что это корректирующие коды с избыточностью, работающие по схеме K+M+S, где K – число блоков исходной информации, M – число избыточных блоков, а S – число блоков, зарезервированных под восстановление данных (spare). Доступны схемы 1+1, 2+1, 2+2, 4+1, 4+2, 4+3, 4+4, 8+1, 8+2, 8+3, 8+4, 8+5, 8+6, 8+7, 8+8. Таким образом пул может быть защищен от выхода из строя до 8 дисков. При создании пула можно выбрать число накопителей в пуле или объем пула. Во втором случае СХД сама определит необходимое число накопителей. Все жесткие диски в пуле делятся на секции. Размер секции зависит от числа дисков в пуле и равен 16 МБ, если число дисков в пуле меньше или равно 60, и 32 МБ – если число дисков в пуле больше 60.

На базе подобных блоков и строятся логические тома (ресурсы), подобная гранулярность позволяет оптимально утилизировать пространство логического пула.

Также при создании пула можно выбрать размер страйпа: от 4 KB до 2 MB в зависимости от схемы защиты данных.

Например, при схеме защиты 4+1 и размере страйпа 32к – с каждого накопителя будет взят блок 8к. Итого - 40к.

В случае изменения даже байта в одном блоке 8к произойдёт:

5 чтений блоков по 8к с каждого диска, чтобы пересчитать парити;

2 записи по 4к на каждый из 5 дисков, чтобы записать новый страйп и парити.

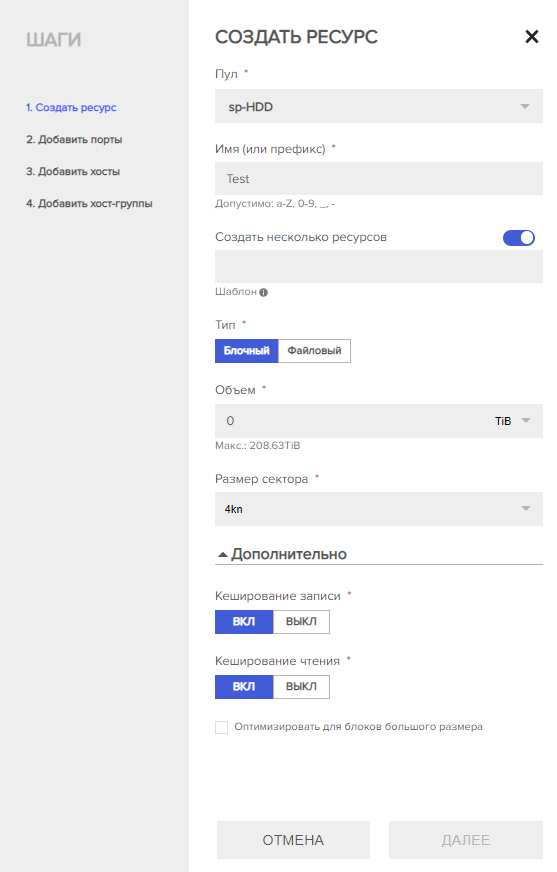

4. Ресурсы (или всем хорошо известные LUNы).

Блочные или файловые, толстые или тонкие (в зависимости от типа пула), с кэш на запись/чтение или без него, с размером сектора 512e или 4kn, оптимизированные для блоков большого размера или нет, в TiB, GiB или MiB, один или несколько. Вроде бы, тут все понятно. Есть только несколько моментов: луновых групп пока не существует, возможность увеличения файлового ресурса отсутствует, для подключения ресурса к хостам VMware 6.7 при его создании необходимо выбрать размер сектора 512e, удалить ресурс можно, даже если он подключен к хостам, не отображается занятое место на файловом ресурсе (web-интерфейсе ресурс отображается всегда размером 0 B), для файлового доступа нет интеграции с AD, только LDAP. Файловый ресурс доступен на чтение/запись только под одним пользователем, под которым он был примонтирован. При этом стоит вспомнить, что производитель поддержку файлового доступа под VMware официально не заявил. Всегда помним, что ситуация может измениться с выходом очередной версии ПО.

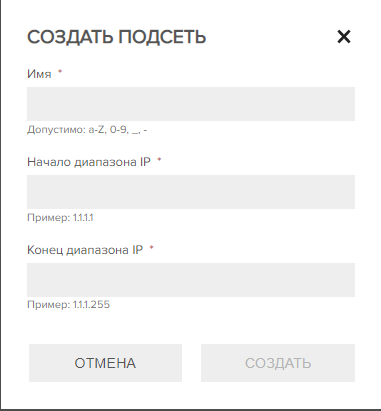

5. Подсети (это не то, что вы могли подумать).

Подсети используются для ограничения доступа к файловым ресурсам. При создании подсетей вы лишь можете указать IP-адрес или диапазоны IP-адресов, для которых доступ будет разрешен. СХД не поддерживает тегированные VLAN-ы.

6. Хосты.

Подключение хостов к СХД возможно по протоколам FC и iSCSI. В случае FC после настройки зонинга инициаторы хостов (а в интерфейсе Tatlin они называются порты) в списке появляются автоматически, а вот в случае iSCSI iqn-имена пришлось вбивать руками. Хостовые группы существуют, но со стороны хоста не видно, в какой группе он состоит, это видно, лишь если зайти в саму группу. Зато есть дерево всех объектов, с помощью которого можно понять родственные связи пула с ресурсом или ресурса с хостом. При добавлении ресурса хосту необходимо использовать кнопку в виде шестерёнки, а не «+», как логичнее было бы предположить. В данном случае «+» означает создание нового ресурса. Также существуют нюансы при настройке подключения на стороне ОС хоста. Не поленитесь, почитайте руководство по настройке РС и платформ виртуализации от Yadro Tatlin, и особенно обратите внимание на мелкий шрифт, сноски, ограничения и выделения другим цветом.

Минимальная настройка завершена, и теперь мы являемся счастливыми обладателями некоего объема пространства СХД YADRO Tatlin Unified, которое мы смогли примапить хостам и увидеть со стороны ОС.

На «десерт» у нас функциональное тестирование и тестирование на отказоустойчивость.

Тестирование

Перед тем как приступить к проведению приемосдаточных испытаний мы прошли долгий путь длиной практически в 6 месяцев. Но об этом лучше рассказать при неформальном общении в кругу инженеров вендора и совместно сложить эпос «Через тернии к Ядрам».

Сразу хотим уточнить, что мы не будем приводить конкретных цифр по производительности, ведь СХД всегда подбирается под конкретную задачу конкретного заказчика. Мы лишь укажем разницу, полученную при тех или иных испытаниях. Поэтому все персонажи являются вымышленными, и любое совпадение с реально живущими или когда-либо жившими случайно.

СХД Yadro Tatlin.Unified:

70 NL-SAS HDD в пуле, собранные по схеме 8 data+2 parity и 4/70 пространства зарезервировано под hot spare. Полезный объем оказался в районе 600 ТБ. Размер страйпа 32 KB. Для тестов создан один ресурс (том) размером 10 ТБ, поданный по iSCSI.

Версия ПО 2.5.10 NVMe SSD RI в пуле, собранные по схеме 1 data +1 parity и 1/10 пространства зарезервирована под hot spare. Полезный объем оказался в районе 30 ТБ. Размер страйпа 4 KB. Для тестов создан один ресурс (том) размером 10 ТБ, поданный по iSCSI.

Версия ПО 2.5.

Хосты Vmware:

4 сервера c ЦПУ Intel Xeon Gold 6226, ОЗУ 256 GB RDIMM, 2x10Gb/s Eth. Гипервизор

VMware 7.0.3.

Ниже мы приведем результаты тестирования, показавшиеся нам достойными упоминания.

Все показатели производительности были получены с пула NL-SAS на профиле нагрузки – случайное чтение и запись в пропорции 50 / 50 блоком 4к.

Функциональное тестирование:

1. Прозрачное увеличение пула.

При увеличении пула с 60 до 70 дисков происходит падение производительности

на 50% на время менее 5 с. Производительность упала с 6000 IOPS до 3000 IOPS,

при этом логический том был доступен, и Vmware пути к нему не потеряла.

2. Прозрачное увеличение логического тома (ресурса).

При увеличении размера логического тома происходит падение производительности на 66% на время до 10 с. Производительность упала с 6000 IOPS до 2000 IOPS, при этом логический том был доступен, и Vmware пути к нему не потеряла.

Тестирование на отказоустойчивость

При извлечении жесткого диска сообщение в почте администратора появляется только через 30 минут. Не стоит удивляться, это так и задумано производителем, чтобы оградить нас от временных капризов отдельных накопителей.

Выключение или перезагрузка одного из контроллеров в нашем случае временно привели к уменьшению производительности в 6 раз с 9000 IOPS до 1500 IOPS на период в 30 секунд (цифры указаны приблизительные).

Выключение кэша на запись уменьшает производительность на 30-35% (IOPS) в нашем случае. Выключение кэша на чтение уменьшает производительность на 15% (IOPS) в нашем случае.

Отключение 1 из 8 кабелей PCIe между контроллерами и дисковой полкой привело к выключению СХД.

Инженеры производителя собрали необходимые логи и ушли править бэклог следующей версии ПО. В результате нами были заменены системные диски, обновлено ПО до версии 2.6, заменены платы коммутации PCIe с установкой новой версией ПО внутри них. Тут мы прочувствовали, зачем нужна служба поддержки вендора, доступная 24/7.

Во втором раунде испытаний:

Выключение одного из четырех iSCSI портов приводит к остановке IOPS на время до 5 секунд. При этом логический том остается доступен хостам.

При схеме защиты 8+2 ребилд двух дисков уменьшает производительность СХД на нашем профиле нагрузки на 30%.

Выключение или перезагрузка одного из контроллеров приводит к приостановке IOPS на время до 5 секунд. При этом ресурс остается доступен хостам.

Вывод: система показала себя достаточно стабильной, но ждём дальнейших улучшений.

И напоследок

По мнению системных инженеров ДОМ.РФ система находится на стадии совершенствования. Администраторам, которым, как и нам, доведётся работать с СХД YADRO, придётся подождать появления привычных опций: тиринг, дедупликация, сжатие, снапшоты, репликация и метрокластер. Будем ждать новых функций в следующих версиях ПО. Функционал синхронной репликацию на блочном уровне обещан в следующей мажорной версии ПО 2.7.

К чести производителя надо отметить, что реакция на возникающие проблемы быстра, а поддержка старается максимально оперативно решить возникающие трудности.

Очень ждём возможности поработать и с другими решениями строителей российских СХД.

Автор: Виктор Круглов, директор по ИТ-инфраструктуре ДОМ.РФ