Комментарии 61

Двоякое впечатление. С одной стороны - все хорошо, но я б в продакшен сервер с приклееным скотчем БП не отдавал. Для тестов - да, для пионеров под *крафт - тоже да.

Если блок питания при этом надёжно фиксируется на месте (как например существенная часть компонентов в ноутбуках и прочей современной электроники), то на скорость и надёжность это не влияет. Влияет на последующую замену, тут чуть менее удобно его потом отдирать оттуда.

Ну убивает идею хотсвапа на корню. Так у тебя сдох один PSU, сервак работает на втором. Заехал в ЦОД, махнул сдохший БП на рабочий и все это без остановки работы сервера. С вклейкой на изоленту, резервирование продолжает работать, а вот бесшовный ремонт уже нет (

Сильно зависит от персонала. С синей изолентой просто порог вхождения чуть выше.

Я тоже не вижу особых проблем с эксплуатацией в таком виде. Тем более, это позитивно отражается на тарифах для клиентов. Это именно то, что они сами хотят.

У меня самого есть опыт колхозинга на проде с паяльником и дрелью, поэтому осуждать такой подход морального права не имею, но несколько конструктивных замечаний есть.

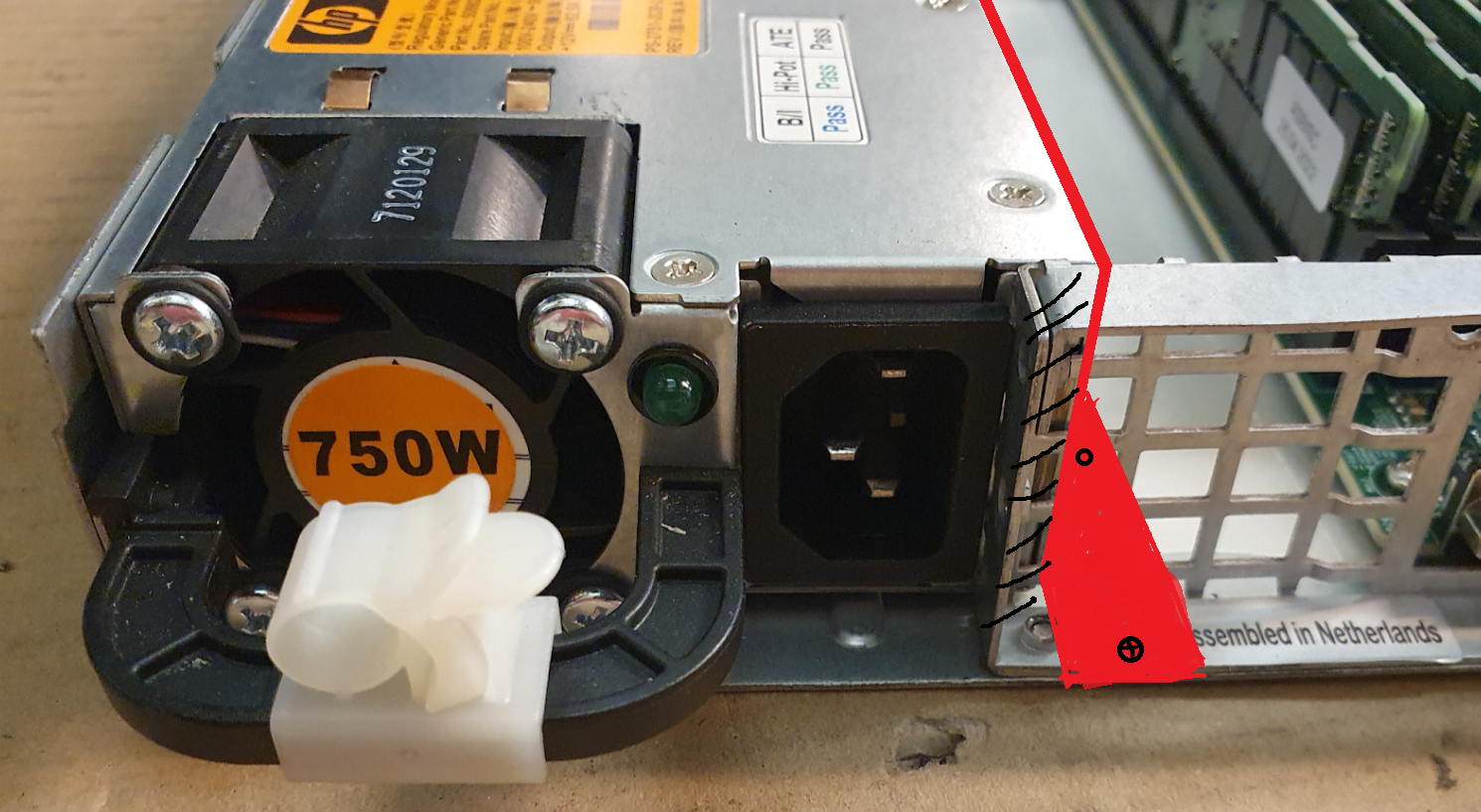

По тому что на фотках - сдохший БП невозможно вытащить из корпуса из-за перекрытия этим самим корпусом. Только через снятие крышки. Крышку снимать в ситуации когда у сервака в стойке свеху и снизу соседи - без вытаскивания из стойки тоже невозможно. Воспаленное воображение конечно подсказывает мне что при наличии 5метровых питалок и патчкордов - такой фокус можно провернуть и полноценно оперировать пациента в холодном коридоре без экскоммуникации, нагорячую. Но такое =( на n-ной итерации винт таки сорвется с отвертки и прилетит прямиком в материнку под напругой

Hidden text

Как бы я доработал

1) Прикрепил их распределительную плату не только на двусторонний скотч, но и на винты. ЧСХ отверстия под них ребята сделали, а вот пользоваться не стали

2) Откусил бы блокирующую БП часть задней панели, а по длине БП приклепал/привинтил алюминиевый уголок 20х20 из ближайшего Леруа.

Таким образом бы осталась и жесткость конструкции и нормальная фиксация и возможность обслуживания без разбора всего сервака

Так вроде и так очевидно, что надо вытаскивать сервак для обслуживания блока питания. Это цена, которой надо платить.

В нормальном сервере есть ещё много компонентов, которые требует полного вынимания севера из стойки.

Конечно, такие вещи обычно вынимают на холодное, а не горячее.

Ну с учётом того что часть статьи описывает преимущества использования 2х БП - то абсолютно не очевидно. По крайней мере я БП в несколькобпшных серверах обслуживаю без выключения. Увидел алерт в мониторинге, взял бп из зипа, съездил в морозильник, махнул тот который горит жёлтой лампочкой на новый. Нагорячую. Удостоверился что лампочка и мониторинг позеленели. Да и не так часто БП и дохнут, в отличие от винтов, а то когда их количество начинает измеряться тысячами штук - в морозилку я катаюсь каждую пятницу, с прилично тяжёлым рюкзаком.

Увидел алерт в мониторинге, взял бп из зипа, съездил в морозильник, махнул тот который горит жёлтой лампочкой на новый. Нагорячую.

заменить так память в большинстве серверов не получится. а выходит она из строя примерно так же часто, как и бп. а ещё есть материнские платы, которые тоже ломаются. вот дохлый серверный процессор в последний раз видел, наверное, ещё слотовый (хотя говорят, что и они ломаются). ещё есть pdu, бэкплейны и т. п.

я веду к тому, что механизм вывода сервера из прода для обслуживания нужен. а если он есть (а я уверен, что у хостинг-провайдера с многими стойками серверов он есть) и он удобный, то нет никакого резона заниматься играми с заменами бп на горячую.

Ну да, возможность вывести сервер на ТО без прерывания работы сервисов должна быть всегда. Мигрированием ли сервисов на другие мощности, или выводом мощностей в офф через перераспределение нагрузки - само собой разумеющееся. У меня часть супермикр вообще в 1бпшном исполнении, сдох и сдох, кластер перераспределяется автоматически, только алертами заморгал. Но если у тебя дедик в 1 сервак - такой функционал уже неприменим и работы по обслуге на горячую становятся необходимыми.

PS из личного опыта эксплуатации, 95% замен - дохлые винты, 2% - бп, 2% - i/o в СХД. 1% - прочая. Видяхи было дохли. Матерей, процов, памяти, сдохших в процессе почти не встречал. Память бывает битая, но отбраковывается на стадии доэксплуатоционных тестов, а не в процессе.

У меня часть супермикр вообще в 1бпшном исполнении, сдох и сдох

в статье правильно написано, 2 бп (и две независимые линии на стойку) ценны не только/не столько отказоустойчивостью серверов в плане поломок самих бд, а возможностью резервирования ИБП/АВР/прочей электрики.

Память бывает битая, но отбраковывается на стадии доэксплуатоционных тестов, а не в процессе.

странно, у меня как раз обычно в процессе проявляется, особенно на «пожилых» серверах.

95% замен — дохлые винты

а насколько активно они у вас применяются?

вокруг меня в серверах доля hdd всё меньше и меньше, дисков же до 10 ТБ можно сказать, что не осталось.

И матери дохнут, и процессоры и память. Не так часто, но ящик с дохлыми матерями регулярно обновляется.

Какой объем зоопарка? У меня около пары сотен физики, но сдохших матерей/процов в процессе не припоминаю. Было что не заводилось со старта, находили термопасту в ламелях памяти, были загнутые пины сокета, была битая память, но тоже на старте. Были даже подгоревшие пины (шины) питания в блейдах. Реально сдохших процов, в эксплуатации, ни разу не встречал (может и к счастью).

Тысяч 5 примерно на круг в стойках и рядом

Серьезный объем. При таком масштабе уже пора задумываться о своем цоде, с резервированием АВР не на уровне стойки, а централизованном. И о hotswape )

Не, плохая идея. Очень плохая. Построить приличный ЦОД потребует минимум 15000 евро на стойку без учёта стоимости недвижимости. С учётом стоимости денег только проценты по затратам на цод из 100 стоек составят 150000 в год. На круг выйдет что-то типа 300-400 евро на стойку в месяц без электричества. Но в обычном коммерческом крупном ЦОД без розницы можно взять стойко-место за те же деньги. И вся это возня с обслуживанием больше не твой головняк :)

добавлю, что цоды тоже иногда падают. и иметь сервера в нескольких цодах явно предпочтительнее с точки зрения отказоустойчивости.

5к физических серверов, это больше 100 стоек, это объем неплохого заделк для контейнеро-модульного цода, с гарантиями

А так очень дорого. Надо все свое делать и кучу rnd изобретать. Плавали - знаем :) проще найти уже отбившийся цод и в нем взять машзал или корридор. Плюс-минус те же косты и никакого обслуживания с нашей стороны. Подобные решения себе разве что хетзнер и ovh могут позволить, порог входа тысяч 100 машин в одной точке что бы это имело осознанный смысл. Грубо- вы уже не можете найти себе ЦОД, вам в любом случае его строить.

2 БП это больше для того, что бы можно было поменять дохлый экземпляр "на расслабоне" во время запланированного простоя, а не бежать в горячем поту, так как клиенты орут и начальство отвешивает пинки.

Это не обязательно про горячую замену.

Я предложил конструктивную доработку стоимостью в 100р и +30мин времени, позволяющую, добавить функционал hotswap для БП, по мне так здравая цена за такую возможность. Выбор разумеется за эксплуатантами.

Не, это что бы вы могли поставить сервер в приличный ЦОД без использования стоечного АВР. Иначе при первом же переключении сервер ребутнется, а замена блока по выходу из строя это очень редкое происшествие. Оно обычно происходит при включении машины, иногда при этом выбивает всю ПДУ или весь распредилительный щиток, если не повезет

Приличный ЦОД не требует установки стоечных АВР, а даёт пару действительно независимых лучей питания в стойку, через свои "профессиональные" АВР и ИБП, с ДГУ на страже

даёт пару действительно независимых лучей питания в стойку

вот именно поэтому и нужно 2 бп.

Неа. В ЦОД по стандарту Тиер3 лучи питания не должны нигде пересекаться кроме ввода. Это приводит к тому что ЦОД не гарантирует что электричество будет на обеих вводах, но на круг это даёт .999 в год. А хоть что-то стоящее в разрезе при сгорании сразу хорошо если .9 за год получится.

Если там так устроено, то да. Но не везде это именно так.

Например, у меня один сервер стоит в ЦОДе лет эдак 10 с одним БП. Точнее, там их два, но подключен только один.

ЦОДы бывают разные.

Ну, как минимум можно перевести за время работы на резервном бп виртуальные машины на другие сервера и чинить уже "на холодную"

Но такое =( на n-ной итерации винт таки сорвется с отвертки и прилетит прямиком в материнку под напругой

если это не дедик, арендуемый клиентом, то нет особого смысла в обслуживании «на горячую». мигрировали задачи на соседние сервера, выключили, обслужили, включили.

это надёжнее и безопаснее.

меня в этой картинке смущает другое, существенная часть статьи посвящена тому как полезно иметь 2 бп в сервере (и я с этим согласен). но на фотке-то мы видим единственный бп )))

rimecode, объясните?

Потому что что бы использовать два таких блока питания придётся сделать корпус самостоятельно. Проблема в том, что пролёт стойки в 450мм и ширина АТХ матери делают установку двух таких блоков рядом невозможной. У нас есть 2Ю конструктивы на 2 матери и ГПУ сервера в которые ставятся два таких блока, но про это я напишу в другой раз. Переходник очень простой, два раза гнутая железка с парой вырезов.

Там все хотсвопное, не надо придираться к этой супермикро - так она пошла работать дальше, а не отправилась в металлолом.

да я верю, но к чему был тогда весь этот пассаж про 2 бп?

после его чтения возникает ощущение, что у вас везде такое, и вы делитесь своими best practices, а оказывается…

Приходит мужичок в магазин. Смотрит — на прилавке что-то красивое, воздушное, легкое. Он подходит к продавщице и спрашивает:

- Скажите, а что это у вас там такое красивое, легкое, воздушное?

- Да это ж йогурт!

- А-а-а! (мечтательно) Йогурт!.. Две бутылки водки, пожалуйста.

Там ставится пластинка с двумя гибами, приклепывается к корпусу снизу и фиксирует хвостовик у сервера. Я сомневаюсь что кто-то из уважаемых читателей будет этим заниматься.

Ссылка заблочена :(

https://www.mini-box.com/picoPSU-150-XT

Access Denied

You don't have permission to access "http://www.mini-box.com/picoPSU-150-XT" on this server.

Reference #18.2dfc733e.1657089653.7699e8b9

Нормальный вариант. Немного колхозно и требует ручной работы напильником, но функциональности не мешает. HP серверов тех поколений налепило лет на 30 вперед, всем хватит.

Когда-то давно выгорел на интеловском сервере блок питания. Сервак к тому времени уже не поддерживался производителем, а заказать на алике б/у тогда было еще нельзя. Так просто заменил на подходящий по мощности блок от PC, заменив кое-какие разъемы. Корпус правда при этом не закрывался, но сервак вполне себе отработал несколько лет.

У меня есть БП от HP и Dell.

Я думаю использовать их для питания освещения... будет ли это работать?

А потом приходится пару недель доказывать что у сервера проблемы именно по питанию и удивляться что на своих серверах бп никогда не глючат. За инфу спасибо, многое стало понятней.

уточню, у вас это реальный опыт или просто предположение?

Реальный, и пару недель это сильное преуменьшение. На хостинге время от времени перезагружался сервак, без проблем в логах. Следили, искали косяки. Потом настояли на замене бп - проблему как рукой сняло. Удивило что сервер супермикро без хотсвап бп. Сейчас предполагаю что там возможно так же оптимизированы бп на двухстороннем скотче.

ну то есть всё-таки речь про другого хостера (и система с одним БП, как я понял)

Я и не писал что у этого хостера.

Система с 2 бп

Бывает. Это все сложная электроника, её работа не зависит от владельца - найти путем последовательной замены дающий сбой компонент обычно можно. Мы не делаем это на сданном сервере, даём замену и потом инженеры инфраструктуры разбираются что это было.

:) а время простоя при переезде с одного железа на подменное ваших заказчиков не тревожит?

А что делать-то? Сервера ломаются и наши и ibm и hp и dell и все другие. Сложная электроника, ничего не поделаешь. Хорошо что это происходит редко.

Обычно клиенту ничего делать не надо, максимум МАС адреса в конфиге поправить и убедиться что все завелась. Именно в этом центральный повод аренды, все это не головняк клиента.

Проект сам переезжает на подменное железо?

Диски выпускают щупальцы и ползут в подменный сервер. Там в него заползают и присасываются изнутри

а в случае с райдами как быть? было пару раз таскали в другой сервак, но с родным контроллером

да так же, import foreign config. Если повезет, то все заводится. Но серверов с аппаратным рэйд и их зоопарком все меньше и меньше. у нас остались только Megaraid в эксплуатации, но заказов новых почти нет - прошла, закончилась эпоха.

Сколько серваков нам не давали там постоянно какая-то гадость была в виде LSI или ещё чего со своим шлейфом в корзине, чтобы просто получить диск в системе постоянно нужно было подпрыгивать и конфигурить контроллер чтобы он каждый диск отдавал райдом, если винт сгорел - квест, сейчас серваки уже умеют ну хотя бы штук 4-8 отдавать как обычные винты?

Не очень понятно.

Серверные БП надёжны, работают десятилетиями, из строя выходит один-два в год, и при этом откуда-то берутся платформы без БП в которые вы это вот все колхозите. Причем ведь речь о сотнях штук....

Откуда ?

На парке в 5000+ активных особей с возрастом от 0 до 12 лет и общем поголовье прошедшем через наши руки тысяч в 10 - на складе скапливается много тушек. Иногда штатный блок слишком слабый, его проще заменить на более мощный. Иногда на нем недостаточно выходов питания. Не знаю как у других коллег по цеху, а у нас есть целый стеллаж с такими корпусами.

Реанимируем старые серверные корпуса с блоками питания HP Common Slot