Привет, ХАБР. В настоящее время для каждой компании стает ребром вопрос информационной безопасности. С одной стороны растет количество кибер-атак, с другой растет ответственность компаний за сохранность информации, тех же персональных данных. Как говорится, ставки со всех сторон растут и поэтому наличие в штате сотрудников, осуществляющих инфобез уже не является вопросом, а скорее аксиомой. В этом статье, на основе своего профессионального опыта я расскажу, как можно защищать внешние информационные ресурсы компании, через их регулярный пентест и почему важно пентестить на регулярной основе.

Для простого понимания сути темы, отвечу на типичные вопросы:

Что такое Пентест?

Если кратко, то это такой метод оценки безопасности системы, который представляет собой моделирования действий кибер-преступника (хакера), которые он может провести с вашими информационными ресурсами, однако при такой методике есть незыблемое правило. Не доводить действия до деструктивных последствий. Иначе говоря, пентестер по своей сути тестировщик, применяющий инструментарий хакеров.

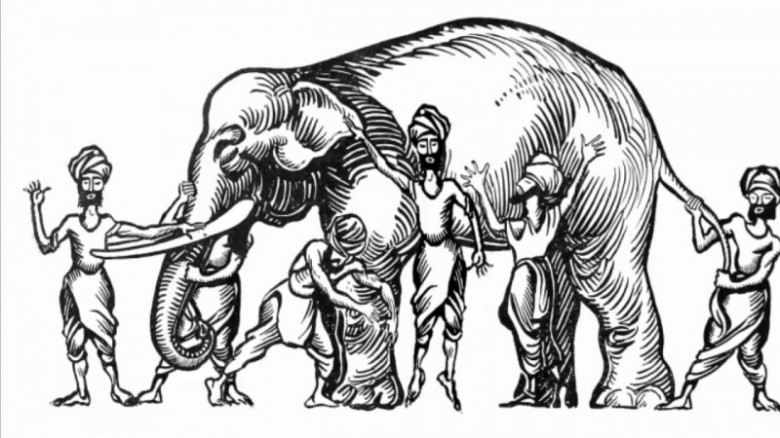

Почему безопасностью должен заниматься отдельный сотрудник, не отвечающий за настройку/работу сервиса?

Потому, что ни один, даже самый профессиональный сисадмин не сможет оценивать свой сервис не предвзято, да и у него основная задача другая – стабильная работа сервиса, за который он отвечает, а безопасность, скорее, дополнительная обязанность.

Я слышал, что есть основное разделение инфобезопасников на защищающихся (blue team) и атакующих (red team). Так чем этот подход плох?