Очередной семинар про работу с СУБД PostgreSQL. Сегодня расскажу, как суровую прагматику требований бизнеса перенести на разработку высоконагруженных сервисов, как бороться с конкурентным доступом к данным, как это все аккуратно обходить и при этом не «отстрелить себе ногу».

Сегодня мы поговорим про расчет себестоимости в СБИС:

- наша методика расчета

что такое «себестоимость» вообще, зачем она нужна, и как ее считаем именно мы - алгоритмические задачи

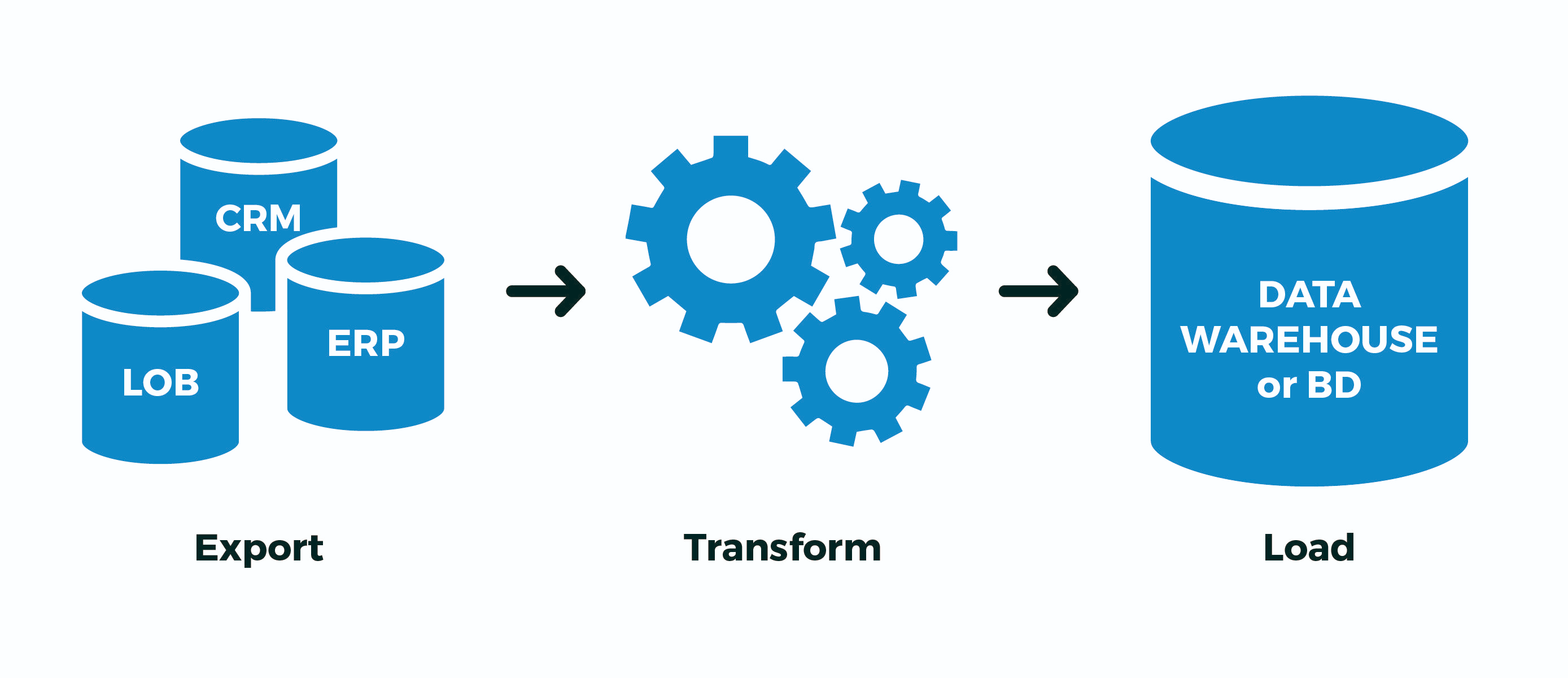

концептуальные приемы при построении архитектуры решения «под алгоритм» - технические приемы

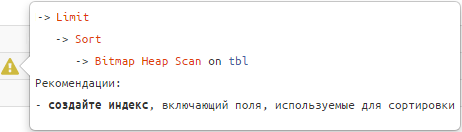

зачем и как применять упорядочение операций, делать транзакции короткими и быстрыми, организовать высококонкурентную очередь в БД и другие подходы к оптимизации нагрузки