С каждым годом популярность Big Data продолжает увеличиваться. Аналитические отчеты показывают рост процентного соотношения компаний, которые активно применяют «большие данные» в тех или иных бизнес-процессах.

Сегодня мы поговорим о том, как этот новомодный термин зачастую вводит в заблуждение и не позволяет в полной мере оценить положительные стороны того, что под ним подразумевается в действительности.

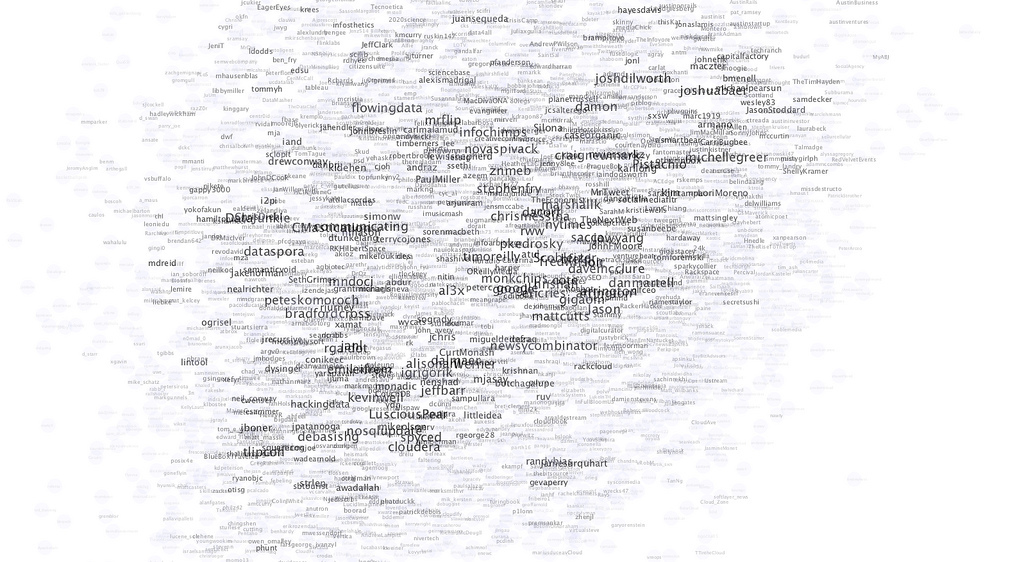

/ фото Philip Kromer CC

Сама технология, если так можно выразиться, уже используется практически повсеместно. Огромные объемы данных, которые оказываются в распоряжении компаний, предоставляющих пользователям поисковые сервисы или социальные сети, поражают даже самое смелое воображение. Было бы странно оставлять их храниться в полном спокойствии — бизнес пытается извлечь дополнительную выгоду из тех знаний, которые можно получить на основе анализа уже имеющихся данных о пользователях и их предпочтениях.

Здесь можно провести параллели с любыми сферами деятельности: от медицины до дорожного движения. Смысл в анализе данных, которые должны в достаточной степени удовлетворять требованиям, и тогда их уже можно относить к тем самым «большим данным».

Что дает анализ — возможность понять закономерности и на их основе прогнозировать развитие событий в ближайшем будущем. Но как и любой новый инструмент, Big Data требует аккуратной работы и внимательного отношения к качеству проводимых исследований.

Иногда получается так, что исследователи уходят в построение определенных зависимостей, которые не всегда соответствуют базовой логике. Один из таких примеров — проверка текста на соответствие некоторым требованиям «качества». Здесь все зависит от адекватности предустановленных параметров и их соответствия действительному качеству материала.

В некоторых случаях работы с оценкой текста получается так, что алгоритм выделяет в длинные предложения как значимые или «качественные», но все мы знаем, что с таким подходом в вопросах оценки какого-либо художественной произведения далеко не уйти. Подобные алгоритмы оценки достаточно легко обойти, понимая логику их работы.

Другой пример — проект Flu Trends, который запустила компания Google. Получилось так, что он должен был предсказывать вспышки болезней, но так и не смог превзойти официальные службы, которые профессионально занимались этими вопросами.

Основная причина, по которой те или иные виды «больших данных» не работают заключается в элементарном отсутствии какой-либо минимально выстроенной системы сбора этих данных. Любая подобная затея потребует значительных подготовительных работ, что ведет к дополнительным издержкам на планирование и проектирование.

Помимо понимания самих процессов сбора и систематизации данных стоит оценивать и необходимость наращивания ИТ-инфраструктуры, которая будет обслуживать эти процессы. Сегодня любая ИТ-комания так или иначе сталкивается с этими вопросами — объемы данных, которые нужно обрабатывать растут, а вместе с этим увеличивается и значимость инвестиций в технологии, связанные с Big Data.

Сейчас уже мало просто собрать очень много данных — для получения даже промежуточных выводов необходимо уметь правильно сформулировать гипотезы, на основе которых и будет произведен анализ. Этот вопрос требует привлечения профильных специалистов, которые занимаются непосредственными вопросами анализа данных.

P.S. Мы стараемся делиться не только собственным опытом работы над сервисом по предоставлению виртуальной инфраструктуры 1cloud, но и рассказывать о смежных областях знаний в нашем блоге на Хабре. Не забывайте подписываться на обновления, друзья!

Сегодня мы поговорим о том, как этот новомодный термин зачастую вводит в заблуждение и не позволяет в полной мере оценить положительные стороны того, что под ним подразумевается в действительности.

/ фото Philip Kromer CC

Сама технология, если так можно выразиться, уже используется практически повсеместно. Огромные объемы данных, которые оказываются в распоряжении компаний, предоставляющих пользователям поисковые сервисы или социальные сети, поражают даже самое смелое воображение. Было бы странно оставлять их храниться в полном спокойствии — бизнес пытается извлечь дополнительную выгоду из тех знаний, которые можно получить на основе анализа уже имеющихся данных о пользователях и их предпочтениях.

Здесь можно провести параллели с любыми сферами деятельности: от медицины до дорожного движения. Смысл в анализе данных, которые должны в достаточной степени удовлетворять требованиям, и тогда их уже можно относить к тем самым «большим данным».

В чем проблема

Что дает анализ — возможность понять закономерности и на их основе прогнозировать развитие событий в ближайшем будущем. Но как и любой новый инструмент, Big Data требует аккуратной работы и внимательного отношения к качеству проводимых исследований.

Иногда получается так, что исследователи уходят в построение определенных зависимостей, которые не всегда соответствуют базовой логике. Один из таких примеров — проверка текста на соответствие некоторым требованиям «качества». Здесь все зависит от адекватности предустановленных параметров и их соответствия действительному качеству материала.

В некоторых случаях работы с оценкой текста получается так, что алгоритм выделяет в длинные предложения как значимые или «качественные», но все мы знаем, что с таким подходом в вопросах оценки какого-либо художественной произведения далеко не уйти. Подобные алгоритмы оценки достаточно легко обойти, понимая логику их работы.

Другой пример — проект Flu Trends, который запустила компания Google. Получилось так, что он должен был предсказывать вспышки болезней, но так и не смог превзойти официальные службы, которые профессионально занимались этими вопросами.

Что делать на практике

Основная причина, по которой те или иные виды «больших данных» не работают заключается в элементарном отсутствии какой-либо минимально выстроенной системы сбора этих данных. Любая подобная затея потребует значительных подготовительных работ, что ведет к дополнительным издержкам на планирование и проектирование.

Помимо понимания самих процессов сбора и систематизации данных стоит оценивать и необходимость наращивания ИТ-инфраструктуры, которая будет обслуживать эти процессы. Сегодня любая ИТ-комания так или иначе сталкивается с этими вопросами — объемы данных, которые нужно обрабатывать растут, а вместе с этим увеличивается и значимость инвестиций в технологии, связанные с Big Data.

Сейчас уже мало просто собрать очень много данных — для получения даже промежуточных выводов необходимо уметь правильно сформулировать гипотезы, на основе которых и будет произведен анализ. Этот вопрос требует привлечения профильных специалистов, которые занимаются непосредственными вопросами анализа данных.

P.S. Мы стараемся делиться не только собственным опытом работы над сервисом по предоставлению виртуальной инфраструктуры 1cloud, но и рассказывать о смежных областях знаний в нашем блоге на Хабре. Не забывайте подписываться на обновления, друзья!