— Да этот ЦОД можно развернуть и настроить, пока ты пиццу заказываешь!

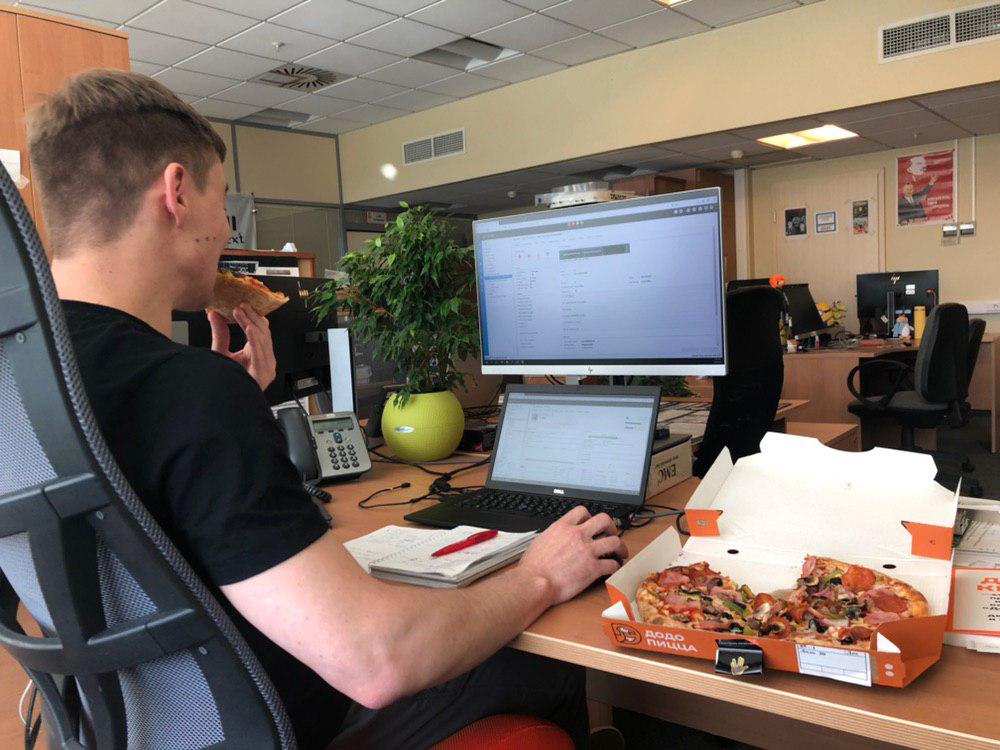

Я бросил эти слова на совещании, и расплата пришла немедленно. Коллега предложила заказать пиццу. Оплачивает проигравший: если я успеваю собрать ЦОД — то она, если не успеваю — то я.

Чёрт!

В общем, встречайте стресс-тест: гиперконвергентное решение от Cisco с простой настройкой против приготовления пиццы.

Что это такое

К нам на тест пришло гиперконвергентное решение от Cisco. Вот прошлый пост с самим тестом и деталями по железу.

Что имеем:

- Четыре ноды хранения Cisco UCS HXAF240 M4.

- Два Cisco UCS Fabric Interconnect 6248UP.

- Существующий vCenter для добавления туда кластера.

- Коммутатор с портами, работающими на скорости 10 Гбит/с (в проде, пожалуйста, используйте два коммутатора для отказоустойчивости).

Начнём.

12:28

Я замонтировал и скоммутировал железки заранее. Серверы подключаем в FI, пару FI подключаем в 10G-коммутатор.

Примерно в это время моя коллега Марина установила приложение и разобралась с заказом.

12:35

Пошёл обратный отсчёт заказа. У вендора SLA — один час на доставку, и мне этого должно хватить. Пошёл инициализировать кластер FI.

Кластер можно проинициализировать из web-консольки, если у вас есть DHCP в сети, или подключиться к COM-порту FI и ввести все данные. Я предпочитаю старый надёжный способ через консольку (скорость стандартная — 9 600).

Для инициализации первого FI вводим IP управления и кластерный IP, пароль для админской учётки и параметры DNS при желании.

Enter the configuration method. (console/gui) ? console

Enter the setup mode; setup newly or restore from backup. (setup/restore) ? setup

You have chosen to setup a new Fabric interconnect. Continue? (y/n): y

Enforce strong password? (y/n) [y]: n

Enter the password for "admin":

Confirm the password for "admin":

Is this Fabric interconnect part of a cluster(select 'no' for standalone)? (yes/no) [n]: yes

Enter the switch fabric (A/B) []: A

Enter the system name: HX

Physical Switch Mgmt0 IP address : XXX.XXX.XXX.XXX

Physical Switch Mgmt0 IPv4 netmask : XXX.XXX.XXX.XXX

IPv4 address of the default gateway : XXX.XXX.XXX.XXX

Cluster IPv4 address : XXX.XXX.XXX.XXX

Configure the DNS Server IP address? (yes/no) [n]:

Configure the default domain name? (yes/no) [n]:

Join centralized management environment (UCS Central)? (yes/no) [n]:

Following configurations will be applied:

Switch Fabric=A

System Name=HX

Enforced Strong Password=no

Physical Switch Mgmt0 IP Address= XXX.XXX.XXX.XXX

Physical Switch Mgmt0 IP Netmask= XXX.XXX.XXX.XXX

Default Gateway= XXX.XXX.XXX.XXX

Ipv6 value=0

Cluster Enabled=yes

Cluster IP Address= XXX.XXX.XXX.XXX

NOTE: Cluster IP will be configured only after both Fabric Interconnects are initialized

Apply and save the configuration (select 'no' if you want to re-enter)? (yes/no): yes

Applying configuration. Please wait.

Configuration file - Ok

Cisco UCS 6200 Series Fabric Interconnect Enter the configuration method. (console/gui) ? console

Installer has detected the presence of a peer Fabric interconnect. This Fabric interconnect will be added to the cluster. Continue (y/n) ? y

Enter the admin password of the peer Fabric interconnect:

Connecting to peer Fabric interconnect... done

Retrieving config from peer Fabric interconnect... done

Peer Fabric interconnect Mgmt0 IPv4 Address: XXX.XXX.XXX.XXX

Peer Fabric interconnect Mgmt0 IPv4 Netmask: XXX.XXX.XXX.XXX

Cluster IPv4 address : XXX.XXX.XXX.XXX

Peer FI is IPv4 Cluster enabled. Please Provide Local Fabric Interconnect Mgmt0 IPv4 Address

Physical Switch Mgmt0 IP address : XXX.XXX.XXX.XXX

Apply and save the configuration (select 'no' if you want to re-enter)? (yes/no): yes

Applying configuration. Please wait.

Configuration file - Ok

Cisco UCS 6200 Series Fabric Interconnect

12:41. Настройка кластера FI

Большую часть настроек выполнит установщик HyperFlex, нам же нужно указать роли портов у FI (в установщик ещё не внедрили ИИ, и угадать, что и куда мы подключили, он пока не может). В нашем случае нужно указать порты, куда подключены серверы (Server Port), и указать аплинки до вышестоящего коммутатора (Uplink Port).

После поднятия серверных портов UCSM (Cisco UCS Manager — управлялка FI и серверами, крутится на FI) найдёт за ними наши серверы и начнёт их инициализировать. Это займёт какое-то время.

В это время:

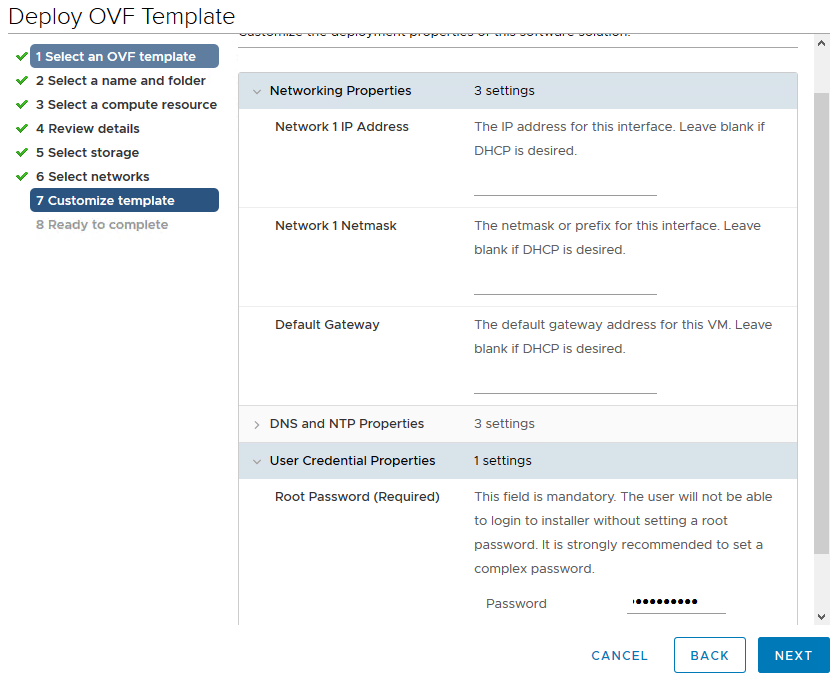

12:45. Разливка установщика HyperFlex

Установщик HyperFlex поставляется в виде шаблона. Тут ничего интересного: разливаем OVA-шаблон, попутно внося данные об IP и пароле для доступа в инсталлятор. Я ленив, поэтому отдал всё на откуп DHCP и пару раз ввёл пароль. ВМ нужна только при создании кластера и таких операциях, как добавление нод в кластер, создание Metro-кластера или его обновление. Поэтому её можно будет отключить и не тратить ресурсы.

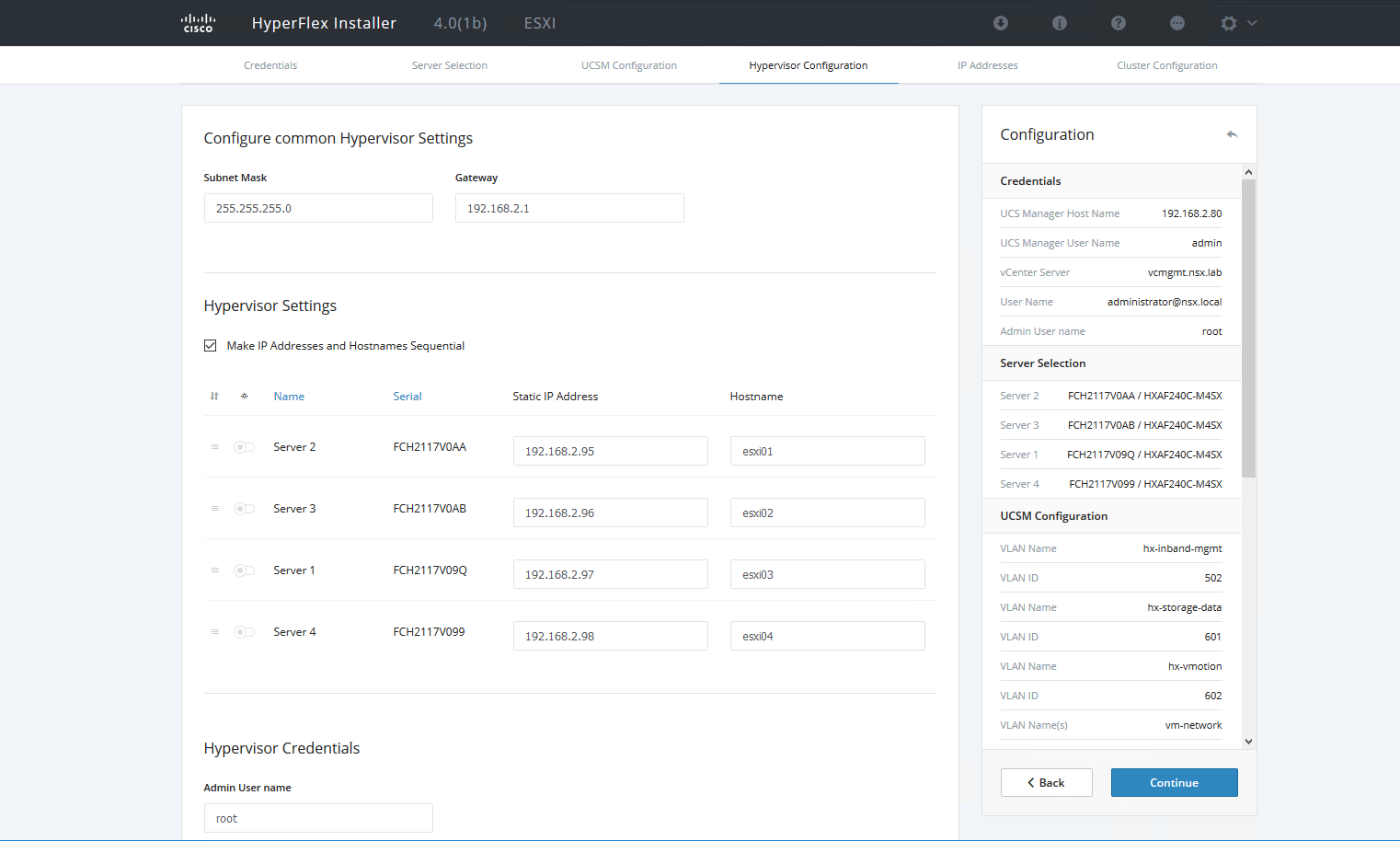

13:05. Настройка кластера HyperFlex

UCSM нашёл наши серверы, определил конфигурацию и готов действовать дальше.

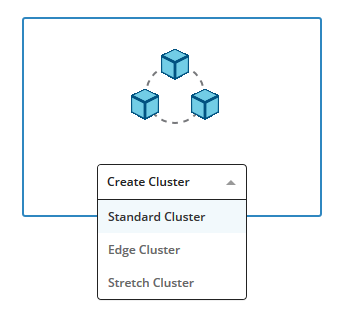

Смотрим адрес установщика и подключаемся на его WEB-интерфейс, выбираем пункт создания стандартного кластера.

Вводим IP и учётные данные от UCSM и vCenter.

Выбираем серверы для добавления в кластер.

Далее нам нужно указать VLAN и адресацию для сети управления, vMotion, сети синхронизации данных между нодами и сети для размещения виртуальных машин.

Выбираем серверы, которые хотим добавить в кластер, указываем адресацию для гипервизоров и новый пароль от рута.

Жмём пару раз Next и идём пить чай.

Это самый длительный этап, потому что установщик создаёт профили для серверов в UCSM, подключается к гипервизору и вносит все заданные настройки, разливает сервисную ВМ на каждом хосте, добавляет серверы в vCenter.

При этом установщик рапортует о текущем шаге и о возникших ошибках. Если некорректно ввели пароль или VLAN, то будет предложено скорректировать данные и начать с последнего успешного этапа.

Пицца приехала!

Чёртова пицца доставлена существенно быстрее, чем мне бы хотелось. Это первый раз, когда я жалею, что её привезли раньше.

13:55. Создание датасторов

Установщик выполнил свою работу, и кластер фактически готов. Для полноценной работы нам не хватает датасторов. Идём на вебку контроллера управления HyperFlex и выбираем раздел Datastores.

По умолчанию серверы создаются со стандартными коммутаторами (vSwitch) и одним VLAN для сетей ВМ. Но можно создать и распределённый коммутатор (все сервисные сети остаются на стандартном) и дополнительно нарезать новые VLAN, проблем не будет. К тому же у UCS есть возможность интеграции с Cisco ACI, что тоже не будет лишним для владельцев SDN от Cisco.

Всё. Общее время настройки ЦОДа — полтора часа. Доставка пиццы — чуть меньше 40 минут при SLA в один час. Ладно, по крайней мере, это было сравнимо. Итог: 1 час 30 минут, я успел развернуть кластер и поесть.

Ссылки

- Тесты решения

- Моя почта — StGeneralov@croc.ru.