Привет, Хабр! Сегодня мы расскажем о нашем опыте тестирования серверов GAGAR>N. Интерес к этим решениям, построенным на российской платформе сегодня достаточно высокий. И, договорившись с производителем, мы решили проверить, на что способны эти серверы, действительно ли они нормально работают с современным софтом, а главное — определить, когда имеет смысл запускать GAGAR>N в свой ЦОД. Чтобы было интереснее мы взяли на тест сразу пару штук в немного различающихся конфигурациях. Что из этого вышло — читайте под катом.

Если вы только слышали о таком производителе как GAGAR>N (или даже не слышали), под спойлером — небольшой экскурс в архитектуру и особенности их платформы.

Спойлер: немного о самих серверах и платформе

GAGAR>N — достаточно молодой российский производитель серверов. Ребята начали выпускать свою продукцию буквально в прошлом году и использовали для этого платформу Open Compute Project (OCP). Тут можно почитать подробнее о том, как устроены серверы на базе OCP, а также системы хранения. Но если говорить вкратце, то мы имеем дело с реформированием содержимого серверной стойки. Компания разрабатывает собственную концепцию шкафов на базе открытых стандартов и получаются стойки стандартных габаритов, но с совершенно другой начинкой. В числе основных отличий:

Сами серверные модули чуть больше в высоту, чем стандартные серверы

Они не содержат блоков питания, потому что электроснабжение идет через общий для стойки модуль.

Системы хранения также монтируются в стойку и каждая полка с дисками подключается к серверам как DAS.

Таким образом, используя общие компоненты, в случае с GAGAR>N можно нафаршировать стойку двухпроцессорными серверами, которые работают на стандартных процессорах Intel. Например, нам на тест достались модели с Intel Xeon Gold.

В определенном смысле система является заменой для blade-серверов, закупка которых в России стала очень сложной процедурой. С архитектурной точки зрения серверы GAGAR>N позволяют добиться высокой плотности размещения вычислительных мощностей при потреблении каждой стойки вплоть до 27 кВт. Таким образом мы имеем заявку на высокую плотность размещения серверов в одной стойке.

Российское железо…

Логичный и справедливый вопрос в данном случае: чем же эти серверы российские? Российская в них сама платформа, включая дизайн топологии и схемотехники материнской платы, дисковые и PCI корзины, код BIOS/UEFI, код контроллера удаленного управления BMC, а также шкафы и инфраструктура питания.

Во всем этом есть поводы одновременно для радости, и для дополнительного анализа. Радоваться нужно тому, что решения GAGAR>N по определению получаются санкционно независимыми (если учитывать, что процессоры и накопители в страну все равно продолжают привозить самыми разными способами). А вот дополнительно подготовиться к использованию GAGAR>N стоит потому, что производитель еще достаточно молодой. А если вспомнить историю тех же HP, Dell, Huawei и прочих, то мы можем предположить, что для GAGAR>N пока еще улажены не все нюансы с прошивками, проверена работоспособность не всех ОС, систем виртуализации и компонентов и так далее.

Но предположения предположениями, а результаты тестов — самое интересное. Поэтому мы решили протестировать GAGAR>N на предмет совместимости и эффективности работы с наиболее востребованными (по крайней мере среди наших заказчиков) платформами.

Тестовая конфигурация

Мы заказали на тестирование пару серверов GAGAR>N V1. Их начинка была представлена следующими компонентами:

- процессор Intel(R) Xeon(R) Gold 6240R – 2 шт.;

- модули памяти SAMSUNG 3200 DDR4 64GB – 12 шт.;

- накопитель SATA SSD 960Gb – 4 шт.;

- сетевой адаптер PCI 2x25GbE – 1 шт.;

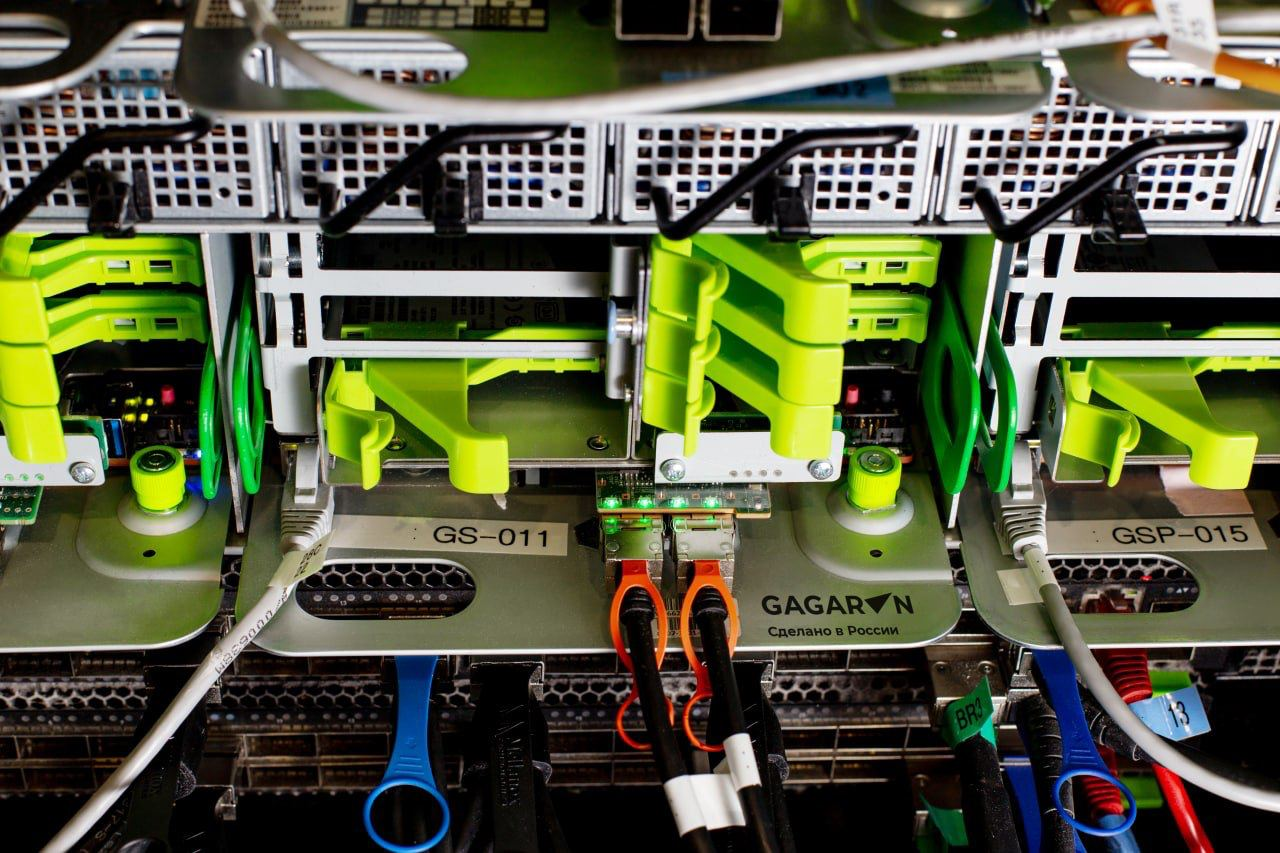

Серверы были установлены в стойку Open Rack v2.0:

- серверная стойка 21” – 1 шт.;

- модуль электропитания (с 6 блоками питания) – 2 шт.;

- шина электропитания– 1 шт.;

- шасси для установки серверов – 1 шт.;

- патч-корд медный 5e RJ-45 – 10 шт.;

- коммутатор Ethernet 24х1Гбит/с– 1 шт.

Стоит отметить, что эта стойка позволяет устанавливать и стандартные серверы, но для этого необходим переходник. Не уверен, имеет ли это смысл, но если у вас есть пара 1U-серваков. а в “гагаринской” стойке осталось место…почему бы и нет?

По любому серверу, конечно, хочется получить максимум информации, и большинство данных по моделям GAGAR>N имеются. В открытом доступе нашлась документация, реакция службы техподдержки составляет до 3 часов (а можно даже до 1 часа, если взять более дорогой пакет), списки компонентов горячей замены опубликованы, а также имеются данные по поддержке систем VDI, гипервизоров, видеоускорителей, сетевых карт и так далее.

Вопросы вызвало только отсутствие матрицы совместимости — она предоставляется лишь по запросу. Но пугаться этого не стоит, потому что производитель активно работает над ее расширением, и новые пункты появляются в ней регулярно.

Конечно, для этих серверов есть ограничения. Например, на момент нашего тестирования из числа систем виртуальных рабочих столов сертификат совместимости только Tionix VDI. Но, как отмечает производитель, по запросу возможно провести тестирование совместимости необходимого решения, а также проверить совместимость дополнительных ОС.

Вообще полезен сервисный портал (https://sd.gagarin.me). Там можно загрузить актуальные обновления микрокода, а также постоянно обновляемую документацию по оборудованию. Но доступ на него предоставляется после покупки серверов. Нам в рамках тестирования, его открыли по запросу. А чтобы полистать, что там есть на сервере, нужно будет сделать заявку вендору и получить доступ — это тоже нужно учитывать.

В сервере GAGAR>N V1 использован российский BIOS и микрокод BMC разработки GAGAR>N. Используется BMC контроллер, поддерживающий протоколы IPMI v2.0, RedFish, SNMP, WebUI. В BMC можно посмотреть статус физических компонентов сервера, данные с различных датчиков и сенсоров.

Однако функционал по просмотру метрик по производительности отсутствует…по крайней мере пока. Есть дополнительное ПО BergenEMS, которое обеспечивает централизованное управление, мониторинг и обновление микрокодов оборудования. Система обладает достаточно широким функционалом и, на мой взгляд, напоминает своими возможностями HPE OneView. Например, через него можно разливать операционки прямо на серверы даже в удаленном режиме. Решение совместимо, но оно не входит в пакет и приобретается отдельно.

Сборка и установка

Экосистема OCP позволяет легко собирать свою вычислительную систему из подходящих узлов. На данный момент шасси поддерживает установку до трех вычислительных узлов. Помимо серверных узлов в стойке GAGAR>N могут размещаться дисковые системы с накопителями HDD, SSD или NVMe, также выполненные в модульном форм-факторе.

Сервер поставляется в сборе, в соответствии с выбранной конфигурацией. Он устанавливается в специальное шасси форм-фактора 2OU и закрепляется в отсеке шасси фиксацией винта, установленного в передней части сервера. Вес сервера по оценке около шести кг, свободно устанавливается и фиксируется в шасси. Люфт направляющих и защелок отсутствует, сервер имеет открытый тип корпуса для свободного прохождения воздушного потока. В задней части сервера установлено 2 FAN модуля.

Тут свои плюсы проявляет стандарт OCP. Он дает простоту обслуживания без отверток и с одной стороны (из холодного коридора). Поставляется все в собранном и промаркированном виде. Доп. компоненты (коммутаторы или ИБП) также могут быть установлены в стойки при необходимости.

В сами серверы можно добавить:

Карты расширения PCIe 3.0 формата low profile. Они устанавливаются в специальный модуль (райзер), который свободно отсоединяется и фиксируется в серверном лезвии. Ориентация портов подключения карт расширения – передняя часть сервера.

Видеокарты и графические адаптеры — тоже поддерживаются в формате low-profile и устанавливаются тоже в райзер.

Накопители SFF с возможностью горячей замены. Накопители для установки в сервер сначала требуется закрепить в направляющих, а затем подключить в сервер с его передней стороны. Накопители устанавливаются надежно, люфт отсутствует. Для извлечения накопителя необходимо нажать на защелку направляющих и вытащить направляющие. Направляющие с накопителями установлены в передней части сервера.

Совместимость с ПО

Мы проверили, как на новых серверах работают функции мониторинга и управления, насколько хорошо реализован процесс создания RAID и попробовали развернуть разные ОС.

IPMI показал стабильную работу, монтированию образов происходит без каких-либо проблем.

В GUI доступен анализ состояния компонентов сервера с показаниями расположенных на них датчиков и сенсоров. Выглядит достаточно информативно.

Имеется встроенное решение VROC для настройки RAID-группы. Пока нет возможности настроить массив через BMC, но это доступно через BIOS/UEFI. Интерфейс понятный и удобный, проблем с удалением, созданием и конфигурацией массива не наблюдалось. Функционал по созданию RAID-группы доступен в полном объёме. Также возможна установка аппаратного RAID-контроллера.

Что интересно, при первичном развертывании системы мы столкнулись с рядом ошибок, которые были вызваны некорректным взаимодействием датчиков с системой мониторинга. Об этом сообщили вендору, получили самую свежую прошивку — и все заработало хорошо. Вывод — контактировать с вендором нужно на каждом этапе.

В общей сложности мы проверили работу со следующими ОС

РЕД ОС 7.3 — установилась вообще без проблем

CentOS 7 — установилась вообще без проблем

Windows Server (2019) — тоже установилась без проблем

AstraLinux — с отключением из блэк-листа модуля AST. Но это никак не связано с аппаратной частью, а обуславливается ограничениями самой ОС

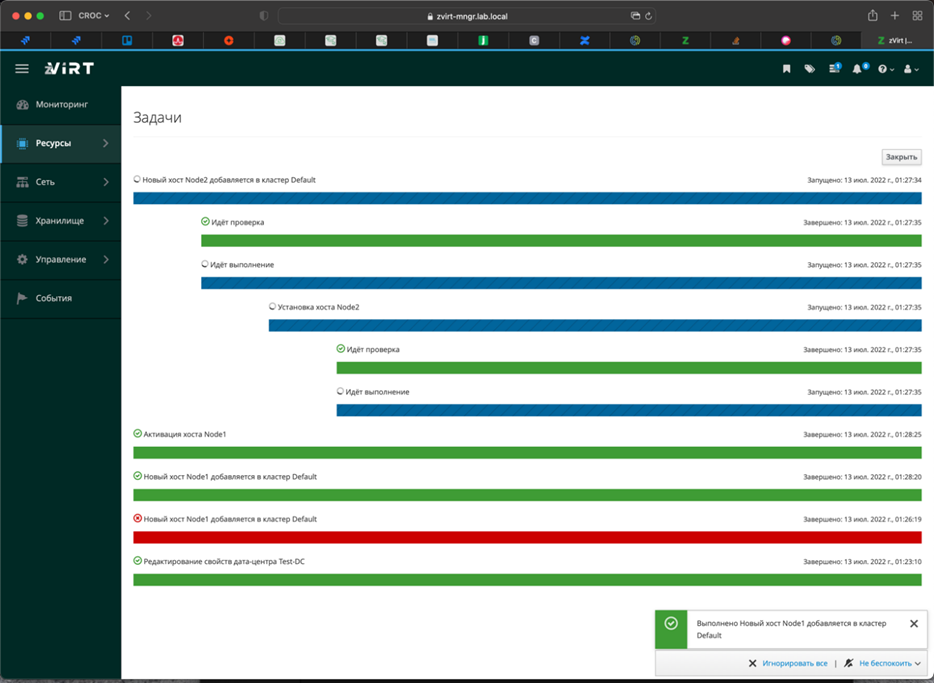

Тест системы виртуализации zVirt оставил очень приятные впечатления. Мы проверили практически все основные сценарии и получили положительные результаты:

Установка и настройка системы виртуализации zVirt

Установлена и настроена СУВ zVirt в виде Standalone-engine.

Создание и настройка дата-центра

Создание и настройка кластера

Добавление дополнительного хоста в кластер

Создание логической сети, интеграция хостов с ней

Создание хранилища и домена хранения с использованием протокола NFS

Создание BM и живой миграции в рамках кластера.

Для тестирования zVirt с плотным размещением для одного из крупных заказчиков был создан кластер 3 узлов и с подключенной SDS. Опять же все это запустилось c zVirt как по маслу.

Отказоустойчивость и производительность

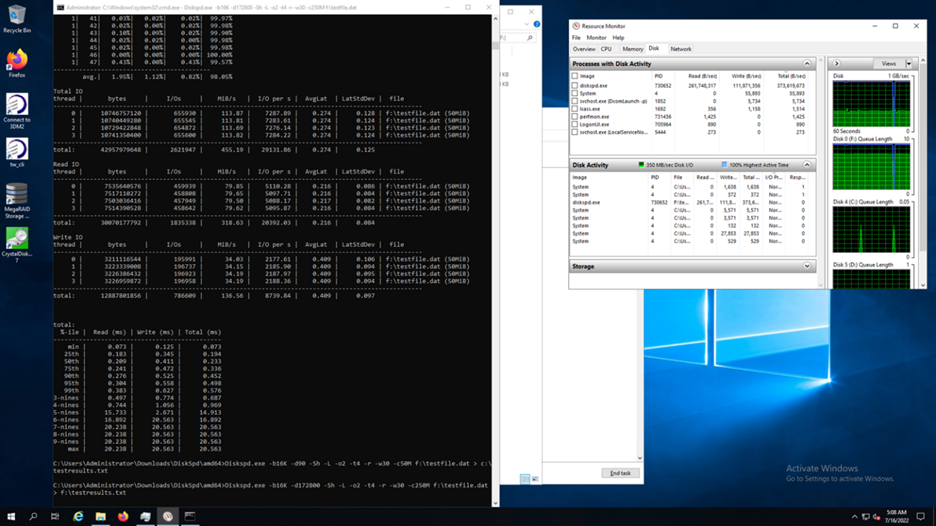

Здесь мы прогнали несколько тестов и получили следующие результаты:

Стресс тест (более 48 часов, в частности 61 час) прошёл успешно – оборудование выдержало нагрузку. Это говорит о том, что система действительно готова работать с интенсивными нагрузками.

Стресс тест дисковой подсистемы тоже прошёл успешно.

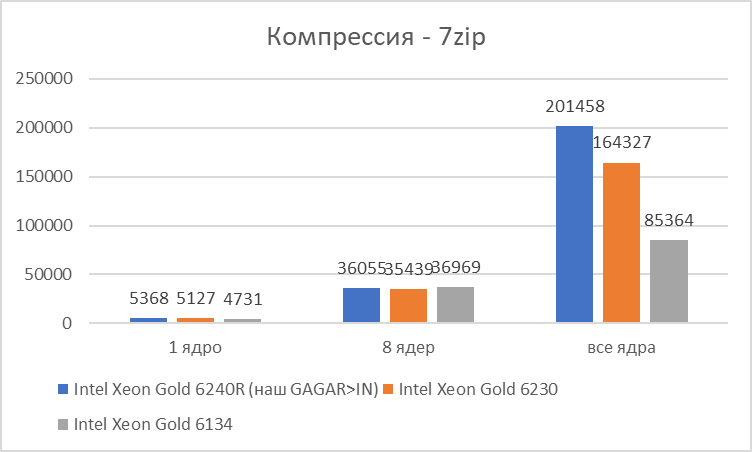

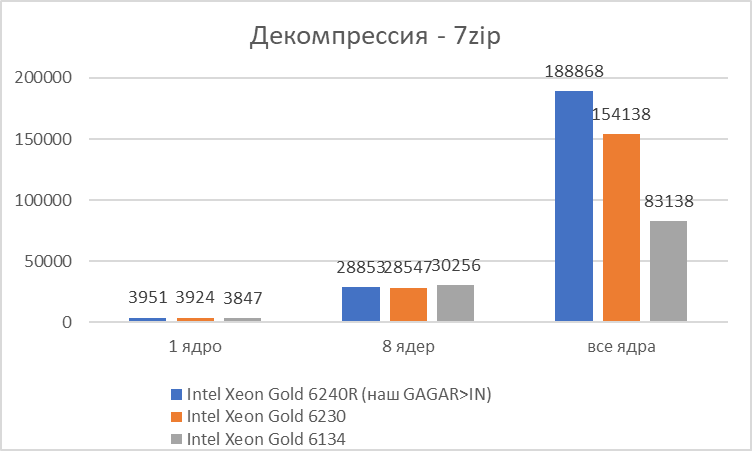

Тестирование методом компрессии и декомпрессии в 7zip также показало, что сервер раскрывает вычислительный потенциал процессора Intel(R) Xeon(R) Gold 6240R CPU @ 2.40GHz.

Анализ приведенных результатов показывает, что в синтетических тестах производительность исследуемого сервера на базе процессора Intel(R) Xeon(R) Gold 6240R CPU @ 2.40GHz в среднем на 11% лучше серверов «базовой архитектуры», результаты которых приведены на сайте.https://www.7-cpu.com/

Впрочем, мы провели как стандартный синтетический текст, так и дополнительные тесты сжатия файлов. В качестве тестовых примеров с помощью генератора случайных чисел были созданы 2 файла по 1ГБ каждый. Такой размер выбран для того, чтобы операции компрессии/декомпрессии занимали ощутимое время, но при этом не испытывали значительного влияния дисковой подсистемы.

Первый файл полностью заполнен генератором случайных чисел, поэтому практически несжимаемый. Второй же файл сформирован из 1024 одинаковых файлов размером 1МБ, таким образом архиватор может его сжать примерно в 1000 раз. Результаты работы серверов в этой задаче тоже оказались очень приличными. На диаграммах — сводные результаты для сервера в сравнении с примерами, которые мы взяли с официального сайта теста.

Заключение

На сегодняшний день серверы GAGAR>N являются интересной альтернативой для компаний, которые или должны закупать только российские решения, или не хотят рисковать с возможными блокировками импортных систем, или не готовы ждать поставку из-за рубежа, которая “то ли будет, то ли нет”, или не готовы переплачивать за параллельный импорт.

Платформа интересна сама по себе. Ведь это не китайский OEM, и производитель находится рядом. Он готов подключиться к решению сложных вопросов, поработать над совместимостью. К тому же серверы GAGAR>N – это все-таки системы архитектуры x86 с индустриально-стандартными чипами ввода-вывода, поэтому каких-то серьезных проблем с совместимостью с различным прикладным и системным ПО быть не должно. В принципе мы в этом убедились в ходе нашего тестирования.

Если же вы хотите проверить уровень производительности в ваших задачах, по запросу вендор предоставляет доступ к нужной конфигурации и позволяет ее протестировать, как через партнера-интегратора, так и напрямую. Каждую конфигурацию можно проверить на работоспособность, совместимость и производительность. А если возникают какие-то вопросы, стоит задать их вендору и посмотреть, какие улучшения принесет новый микрокод, который может быть выпущен по запросу буквально через несколько дней.

Кстати, сам процесс тестирования оставил у нас позитивные впечатления. Ребята быстро собирают стенд под запрос, помогают в настройках и приглашают к себе пощупать руками те самые серверы, с которыми вы работаете. Например, нам нужно было добавить в конфигурацию коммутатор для тестирования работы облачной платформы, и это было сделано за один рабочий день.

Вообще, если для вашей инфраструктуры актуально плотное размещение большого количества вычислительных узлов (с точки зрения стоимости решения новинка имеет смысл, если вам нужно хотя бы 12 серверов), тестирование инфраструктуры GAGAR>N показало совместимость и хорошую производительность, эти серверы вполне можно рассматривать.

Заходите в наш уютный Telegram-канал и чат-бот мероприятий