Комментарии 61

Эх… теория… картинки… а в реале все гораздо интересней!!!

+2

> Но нельзя без ложки дегтя. Один из главных недостатков SAN – это цена. Оставим цифры маркетологам, отметим только что SAN могут себе позволить далеко не все.

А NAS (Celerra, например), надо полагать, может позволить себе любой голодранец?

Да-а, я ожидал более серьезного подхода к вопросу от коллег из EMC. :-}

А NAS (Celerra, например), надо полагать, может позволить себе любой голодранец?

Да-а, я ожидал более серьезного подхода к вопросу от коллег из EMC. :-}

+3

Я могу прямо сейчас собрать — воткнуть винт и память в валяющийся P4, загрузить ось и расшарить винт по сетке. Или в модем с роутером usb-флэшку воткнуть, она автоматом расшарится. Это разве будет не NAS по определению? Я думал просто шара, а оказывается NAS :)

-3

а при чем здесь Celerra? в начале статьи я указал, что не буду упоминать названий продуктов, а в конце еще раз отметил, что цены — это область маркетинга. но если вы настаиваете: начнем с того, что NAS — это не Celerra, а решение, цена которого сильно зависит от вендора и возможностей. более того, если говорить именно про Celerra — это семейство продуктов, среди которых есть решения и для среднего бизнеса, стоимость которых не идет в сравнение с тем же Symmetrix.

так что мимо. странно, ожидал от коллег из нетап комментариев по существу.

так что мимо. странно, ожидал от коллег из нетап комментариев по существу.

0

Ну Celerra же NAS, не так ли? :) Тогда к чему это разделение на «SAN, который дорогой (и, читай „для взрослых“), и это… как его… ну это… NAS» ;)

Позвольте, я дам очень простое определение тому, что такое SAN, и что такое NAS, и где они раздляются, а вы со мной, уверен, согласитесь.

Все очень просто: все зависит от того, на какой стороне образуется файловая система. Если на стороне стораджа, то это NAS. Если на стороне хоста — SAN.

И нет никакого разделения на «дешевое» и «дорогое». Может быть наколенный «SAN» на iSCSI, и может быть сверхдорогой NAS, в виде какого-нибудь Isilon (специально, как вы понимаете, подбираю из вашей области названия;)

Вообще, позвольте, по дружески, по коллежьему, вообще поклевать печень. Ну что это вообще такое? Перестраиваться уже надо, новое мЫшление должно быть, в связи с закапыванием Clariion и курсом на VNX. :)

> В основном это связано с базовым для NAS принципом. Сама по себе избыточность TCP/IP как протокола доступа к данным приводит к накладным расходам.

Выше я уже показал, что нет никакого «базового принципа NAS, связанного с TCP/IP». iSCSI не становится меньше SAN-протоколом, оттого, что ходит поверх «избыточного TCP/IP».

> Высокая нагрузка на сеть с довольно ограниченной пропускной способностью увеличивает время отклика.

Снова укажу пальцем. Высокая нагрузка на сеть с ограниченной пропускной способностью _не_ есть свойство NAS. Это просто кривая сеть. Используйте сеть с высокой пропускной способностью и с низкой нагрузкой, и этой проблемы не будет. Следовательно — это не проблема NAS, а проблема сети.

> Производительность системы в целом зависит не только от NAS, но и от качества работы коммутирующих устройств сети.

Из этого можно сделать вывод, что SAN полностью свободна от негативного влияния низкого качества коммутирующих устройств в сети? ;)

> Кроме того, без правильного resource allocation, клиент, запрашивающий слишком большие объемы файлов, может влиять на скорость работы других клиентов

Снова это не о NAS, а о настройке сети.

Да, в отношении NAS есть такой нелепый предрассудок, что если мы расшариваем интернет через дэлинки и реалтеки, то и для NAS они пойдут, «чо там, эзернет же», что и порождает глубоко укоренившееся заблуждение, что NAS это «фаловая помойка», «торренты качать, пока ноутбук выключен» и ни на что другое он не пригоден «то ли дело SAN!» (произносится с завистливым придыханием). Выше я постарался показать, что причина вовсе не в NAS или SAN.

Равно как и нельзя делить «дешевый NAS» и «дорогой SAN». Сторадж дешевый и дорогой не оттого, кто делает файловую систему. Любой сторадж, и NAS, и SAN может быть и дешевым и дорогим.

Согласны ли вы со мной?

Позвольте, я дам очень простое определение тому, что такое SAN, и что такое NAS, и где они раздляются, а вы со мной, уверен, согласитесь.

Все очень просто: все зависит от того, на какой стороне образуется файловая система. Если на стороне стораджа, то это NAS. Если на стороне хоста — SAN.

И нет никакого разделения на «дешевое» и «дорогое». Может быть наколенный «SAN» на iSCSI, и может быть сверхдорогой NAS, в виде какого-нибудь Isilon (специально, как вы понимаете, подбираю из вашей области названия;)

Вообще, позвольте, по дружески, по коллежьему, вообще поклевать печень. Ну что это вообще такое? Перестраиваться уже надо, новое мЫшление должно быть, в связи с закапыванием Clariion и курсом на VNX. :)

> В основном это связано с базовым для NAS принципом. Сама по себе избыточность TCP/IP как протокола доступа к данным приводит к накладным расходам.

Выше я уже показал, что нет никакого «базового принципа NAS, связанного с TCP/IP». iSCSI не становится меньше SAN-протоколом, оттого, что ходит поверх «избыточного TCP/IP».

> Высокая нагрузка на сеть с довольно ограниченной пропускной способностью увеличивает время отклика.

Снова укажу пальцем. Высокая нагрузка на сеть с ограниченной пропускной способностью _не_ есть свойство NAS. Это просто кривая сеть. Используйте сеть с высокой пропускной способностью и с низкой нагрузкой, и этой проблемы не будет. Следовательно — это не проблема NAS, а проблема сети.

> Производительность системы в целом зависит не только от NAS, но и от качества работы коммутирующих устройств сети.

Из этого можно сделать вывод, что SAN полностью свободна от негативного влияния низкого качества коммутирующих устройств в сети? ;)

> Кроме того, без правильного resource allocation, клиент, запрашивающий слишком большие объемы файлов, может влиять на скорость работы других клиентов

Снова это не о NAS, а о настройке сети.

Да, в отношении NAS есть такой нелепый предрассудок, что если мы расшариваем интернет через дэлинки и реалтеки, то и для NAS они пойдут, «чо там, эзернет же», что и порождает глубоко укоренившееся заблуждение, что NAS это «фаловая помойка», «торренты качать, пока ноутбук выключен» и ни на что другое он не пригоден «то ли дело SAN!» (произносится с завистливым придыханием). Выше я постарался показать, что причина вовсе не в NAS или SAN.

Равно как и нельзя делить «дешевый NAS» и «дорогой SAN». Сторадж дешевый и дорогой не оттого, кто делает файловую систему. Любой сторадж, и NAS, и SAN может быть и дешевым и дорогим.

Согласны ли вы со мной?

+5

я с вами практически полностью согласен, благодарю за развернутый комментарий :)

по определению SAN-NAS можно спорить, но в целом идея верная.

да, Isilon — это дорого. очень. пожалуй, тут вы действительно правы, сравнение цен SAN и NAS как таковых некорректно.

iSCSI не становится меньше SAN-протоколом, оттого, что ходит поверх «избыточного TCP/IP».

говоря об избыточности, я имел ввиду накладные расходы на синхронизацию канала и малый размер пакета, и, как следствие, расходы на обработку малых пакетов. по этой причине разрабатываются новые протоколы (с бОльшим размером пакета) и в ряде случаев предпочтение отдается FibreChannel

Из этого можно сделать вывод, что SAN полностью свободна от негативного влияния низкого качества коммутирующих устройств в сети? ;)

нет, но здесь следует иметь ввиду, что мы говорим о выделенном и специализированном сетевом оборудовании — естественно, сам по себе SAN еще ничего не обещает. да, все зависит от оборудования и настройки, однако, разделять понятия «NAS» и «сеть» в данном случае некорректно.

по определению SAN-NAS можно спорить, но в целом идея верная.

да, Isilon — это дорого. очень. пожалуй, тут вы действительно правы, сравнение цен SAN и NAS как таковых некорректно.

iSCSI не становится меньше SAN-протоколом, оттого, что ходит поверх «избыточного TCP/IP».

говоря об избыточности, я имел ввиду накладные расходы на синхронизацию канала и малый размер пакета, и, как следствие, расходы на обработку малых пакетов. по этой причине разрабатываются новые протоколы (с бОльшим размером пакета) и в ряде случаев предпочтение отдается FibreChannel

Из этого можно сделать вывод, что SAN полностью свободна от негативного влияния низкого качества коммутирующих устройств в сети? ;)

нет, но здесь следует иметь ввиду, что мы говорим о выделенном и специализированном сетевом оборудовании — естественно, сам по себе SAN еще ничего не обещает. да, все зависит от оборудования и настройки, однако, разделять понятия «NAS» и «сеть» в данном случае некорректно.

0

Как раз такой теории в интернете полно, хотелось бы более конкретных статей про системы хранения! Конечно это чисто мое мнение.

0

отчасти с вами согласен. отчасти, т.к. внятный материал на русском есть пожалуй что по SAN, а на хабре данная тема развита слабо. в любом случае — это начало, базис, на котором далее можно будет говорить более предметно.

0

Тогда выскажу свои пожелания, мне бы интересно было бы почитать как раз о выборе системы хранения, когда уже стандартных возможностей железного райда становиться мало или скорее всего хочется чего-то более производительного. Например: Имеется пару серверов(debian) c виртуализацией(kvm+openVZ) сервисов, хотелось бы общее хранилище с достаточной производительностью например по FC(все находиться рядом), тут как раз встает выбор SAN хранилища и FC адаптеров, хотелось бы как раз примеров(возможно даже описания настроек) реализаций таких систем. Именно это не понятно системным администраторам которые переходят из SMB сектора в более высокий эшелон, так как не всегда есть возможность потрогать технологии до покупки, а после бывает возникает много вопросов совместимости или не правильного выбора. На сайтах производителей в основном лишь промо материал, который не дает решения конечной цели.

0

спасибо за ваш комментарий. одна из основных целей данной статьи — выявить предметную заинтересованность в области хранения данных. ваше пожелание будет адресовано в отдел прикладных решений, думаю, что в рамках NDA мы сможем опубликовать несколько примеров с блекджеком и графиками.

0

Заинтересованность есть офигительно какая. Могли бы и так спросить. Нужно: дёшево, опенсорсно, надёжно, с сетевой репликацией и защитой от split-brain.

Пока я наткнулся на основную проблему: нет адекватных производителей SAS HBA на рынке. HP пытался что-то предложить, но слился, LSI поддерживает только rpm (RHEL/SUSE), на адаптек без слёз смотреть невозможно.

Что там ещё есть-то?

Пока я наткнулся на основную проблему: нет адекватных производителей SAS HBA на рынке. HP пытался что-то предложить, но слился, LSI поддерживает только rpm (RHEL/SUSE), на адаптек без слёз смотреть невозможно.

Что там ещё есть-то?

0

Когда чего-то на рынке нет, для меня это первый признак, что, хотя этого, вы «хотите странного».

Я не сторонник теории заговоров, что Adaptec, LSI и десятки нонеймов втайне сговорились, чтобы «зажимать» технологии и лишать себя прибыли.

Может быть это просто не нужно никому, потому и нет?

Я не сторонник теории заговоров, что Adaptec, LSI и десятки нонеймов втайне сговорились, чтобы «зажимать» технологии и лишать себя прибыли.

Может быть это просто не нужно никому, потому и нет?

0

> так как не всегда есть возможность потрогать технологии до покупки, а после бывает возникает много вопросов совместимости или не правильного выбора.

Я бы на вашем месте вообще не рассматривал вендоров, которые не дают пощупать оборудование в триал.

> мне бы интересно было бы почитать как раз о выборе системы хранения, когда уже стандартных возможностей железного райда становиться мало или скорее всего хочется чего-то более производительного. Например: Имеется пару серверов(debian) c виртуализацией(kvm+openVZ) сервисов,

Кстати, в блог NetApp заходите сегодня днем, там будет новая статья именно про это. :)

Я бы на вашем месте вообще не рассматривал вендоров, которые не дают пощупать оборудование в триал.

> мне бы интересно было бы почитать как раз о выборе системы хранения, когда уже стандартных возможностей железного райда становиться мало или скорее всего хочется чего-то более производительного. Например: Имеется пару серверов(debian) c виртуализацией(kvm+openVZ) сервисов,

Кстати, в блог NetApp заходите сегодня днем, там будет новая статья именно про это. :)

0

>Кстати, в блог NetApp заходите сегодня днем, там будет новая статья именно про это

Буду весь день мониторить блок, может как раз будет что нужно начинающим пользоватям систем хранения

>Я бы на вашем месте вообще не рассматривал вендоров, которые не дают пощупать оборудование в триал

Вообщем может быть и в МСК нету с этим особых проблем, а вот на урале обычно с этим проблемы, так как все привозиться под заказ.

Буду весь день мониторить блок, может как раз будет что нужно начинающим пользоватям систем хранения

>Я бы на вашем месте вообще не рассматривал вендоров, которые не дают пощупать оборудование в триал

Вообщем может быть и в МСК нету с этим особых проблем, а вот на урале обычно с этим проблемы, так как все привозиться под заказ.

0

Ох, да, извините, сам ненавижу этот пресловутый московский центропупкизм :(

Увы, есть такая беда с «немосквой». :(

С другой стороны… Вы платите только за транспортировку взятого в Москве стораджа в два конца. Это может быть совсем немного, если прикинуть к цене покупки?

Почем у нас стоит доставить на Урал автотранспортом 30 килограмм?

Увы, есть такая беда с «немосквой». :(

С другой стороны… Вы платите только за транспортировку взятого в Москве стораджа в два конца. Это может быть совсем немного, если прикинуть к цене покупки?

Почем у нас стоит доставить на Урал автотранспортом 30 килограмм?

+2

Да конечно это вариант, думаю окло 2к в одну сторону стоит, хотя такой способ прибавляет много лишней головной боли(бумаги+обьяснить руководтсву зачем нам тратить деньги на пересылку туда обратно, без возможного коненчого результата). И если компания продавец готова на такое, то думаю это для нее большой + для нее!

0

Кстати, в блог NetApp заходите сегодня днем, там будет новая статья именно про это. :)

какая дерзкая реклама в блоге EMC однако :)…

какая дерзкая реклама в блоге EMC однако :)…

0

Чорт, меня заметили. :)

На самом деле, с тех пор, как корпоративные блоги «выпилили» из дефолтной выдачи на главной, все эти блоги, и NetApp, и EMC, потеряли кучу читателей, которые могут просто не знать о появлении новой статьи, если не переключатся на режим отображения «Все».

Хотите, я буду также рекламировать вас? Все же в одном корыте мы тут все, против всяких самодельных «хоронилищ данных»на трехтерабайтных дисках в RAID-6, в корпусе из упаковочного картона. :)

На самом деле, с тех пор, как корпоративные блоги «выпилили» из дефолтной выдачи на главной, все эти блоги, и NetApp, и EMC, потеряли кучу читателей, которые могут просто не знать о появлении новой статьи, если не переключатся на режим отображения «Все».

Хотите, я буду также рекламировать вас? Все же в одном корыте мы тут все, против всяких самодельных «хоронилищ данных»на трехтерабайтных дисках в RAID-6, в корпусе из упаковочного картона. :)

+2

Вы бы цифры привели (а в идеале еще и какие-нибудь абстрактные цены), а то непонятно, за что переплачивать при установке всех этих NAS. Не проще ли просто сервер с 4 хорошими HDD + 1/10 Гб канал до него поставить? Так же, хорошо бы обосновать такое утверждение:

> Сама по себе избыточность TCP/IP как протокола доступа к данным приводит к накладным расходам.

Это как? Пропускная способность дисковой системы выше пропускной способности сети? Цифр не хватает.

Плюс, где-то было упомянуто использование кеширования дисковых операций в сторадже. Операции записи тоже кешируются в ОЗУ? А надежно ли это?

Также, не освещена проблема восстановления данных при отказе устройства хранения.

В общем, без цифр это все выглядит неаргументированно, и впечатления не производит, а просто смотристя как статья в стиле «наши системы хорошие и дорогие, так что покупайте у нас». Товарищи, мы же все-таки на Хабре. Тут словами «гигабит в секунду» никого не испугаешь.

> Сама по себе избыточность TCP/IP как протокола доступа к данным приводит к накладным расходам.

Это как? Пропускная способность дисковой системы выше пропускной способности сети? Цифр не хватает.

Плюс, где-то было упомянуто использование кеширования дисковых операций в сторадже. Операции записи тоже кешируются в ОЗУ? А надежно ли это?

Также, не освещена проблема восстановления данных при отказе устройства хранения.

В общем, без цифр это все выглядит неаргументированно, и впечатления не производит, а просто смотристя как статья в стиле «наши системы хорошие и дорогие, так что покупайте у нас». Товарищи, мы же все-таки на Хабре. Тут словами «гигабит в секунду» никого не испугаешь.

-2

о цифрах говорить имеет смысл, когда есть конкретная задача и конкретные требования. в ряде случаев действительно нет никакого смысла переплачивать, если можно обойтись 1 сервером с «хорошими» HDD. абстрактно можно лишь сказать, что например NAS ускоряет операции файловой системы в разы.

хорошо бы обосновать такое утверждение

см. выше.

Операции записи тоже кешируются в ОЗУ? А надежно ли это?

да, операции записи тоже кешируются, т.е. записанные вами данные могут вообще до диска не дойти, если были помечены на удаление раньше. здесь кроется опасность: что произойдет с данным в кеше, если возникнут проблемы с электричеством? На этот случай, как правило, предусмотрен автономный источник питания, позволяющий в аварийном режиме сбросить весь кеш на диск. Но и с этим источником могут начаться проблемы, в конце концов, его заряда может просто не хватить до устранения проблем. Можно использовать резервный ИБП, но и он не лишен перечисленных проблем, поэтому без использования внешних инструментов обеспечить целостность данных невозможно. О том, как из такой ситуации выйти при помощи внешних инструментов, речь пойдет в следующей статье.

хорошо бы обосновать такое утверждение

см. выше.

Операции записи тоже кешируются в ОЗУ? А надежно ли это?

да, операции записи тоже кешируются, т.е. записанные вами данные могут вообще до диска не дойти, если были помечены на удаление раньше. здесь кроется опасность: что произойдет с данным в кеше, если возникнут проблемы с электричеством? На этот случай, как правило, предусмотрен автономный источник питания, позволяющий в аварийном режиме сбросить весь кеш на диск. Но и с этим источником могут начаться проблемы, в конце концов, его заряда может просто не хватить до устранения проблем. Можно использовать резервный ИБП, но и он не лишен перечисленных проблем, поэтому без использования внешних инструментов обеспечить целостность данных невозможно. О том, как из такой ситуации выйти при помощи внешних инструментов, речь пойдет в следующей статье.

+1

> Не проще ли просто сервер с 4 хорошими HDD + 1/10 Гб канал до него поставить?

Кастомеры, которым уже мало стораджа, допустим, на пару сотен дисков, читают ваше «сервер с 4 хорошими HDD» со смесью ностальгии и зависти :)

> Это как? Пропускная способность дисковой системы выше пропускной способности сети?

Запросто. Что вас удивляет?

> Операции записи тоже кешируются в ОЗУ? А надежно ли это?

Настолько, насколько надежна вообще операция записи в память.

Кастомеры, которым уже мало стораджа, допустим, на пару сотен дисков, читают ваше «сервер с 4 хорошими HDD» со смесью ностальгии и зависти :)

> Это как? Пропускная способность дисковой системы выше пропускной способности сети?

Запросто. Что вас удивляет?

> Операции записи тоже кешируются в ОЗУ? А надежно ли это?

Настолько, насколько надежна вообще операция записи в память.

+3

Хм, думаю что подобного рода инфу любой желающий найдет в вики.

А вот чего нет — так это типовых решений: video streaming storage, db server, static server.

Точнее лично мне было бы интересно что появилось новое — дешевое или продвинутое за последние 2-3 года.

Вот в свое время анонсировались некие NFS blade сервера, типа быстро и дешево для баз данных или статики.

Ну или как поставить дома видео стриммер на гиг :)

А вот чего нет — так это типовых решений: video streaming storage, db server, static server.

Точнее лично мне было бы интересно что появилось новое — дешевое или продвинутое за последние 2-3 года.

Вот в свое время анонсировались некие NFS blade сервера, типа быстро и дешево для баз данных или статики.

Ну или как поставить дома видео стриммер на гиг :)

0

Вы определитесь, либо «дёшего», либо «fc». Они взаимно исключающие.

+2

я разве говорил 'fc'?

но «дешево» бывает разное и FC тоже бывает недорогой.

вообще без задачи и цифр разговор «в пользу бедных»

но «дешево» бывает разное и FC тоже бывает недорогой.

вообще без задачи и цифр разговор «в пользу бедных»

0

Ок, даю бюджет дешёвого iscsi:

любой сервер с шестью-восмью sata'шными дырками. (пусть, 8). 8 SATA'шных винтов RE/NS серии, или рапторы.

Линк по двум гигабитным портам в multipath.

Расходы:

сервер: сколько не жалко, допустим $1500

Диски: примерно $1200

Гигабиты — в комплекте с сервером — $0

Два гигабитных порта на любых свичах, можно даже неуправляемых — около $20 (по $10) на каждый.

Лицензии на mdadm: $0

Лицензии на iscsi-target: $0

Лицензии на iscsi-initiator: $0

Лицензии на multipathd: $0

Ваш вариант? Заметим, указанный выше вариант легко скейлится до 10G и любого числа винтов.

любой сервер с шестью-восмью sata'шными дырками. (пусть, 8). 8 SATA'шных винтов RE/NS серии, или рапторы.

Линк по двум гигабитным портам в multipath.

Расходы:

сервер: сколько не жалко, допустим $1500

Диски: примерно $1200

Гигабиты — в комплекте с сервером — $0

Два гигабитных порта на любых свичах, можно даже неуправляемых — около $20 (по $10) на каждый.

Лицензии на mdadm: $0

Лицензии на iscsi-target: $0

Лицензии на iscsi-initiator: $0

Лицензии на multipathd: $0

Ваш вариант? Заметим, указанный выше вариант легко скейлится до 10G и любого числа винтов.

+2

Зарплату amarao и его сменщика забыли приплюсовать к цене решения ;)

+1

Предполагается, что купив fiber channel меня можно увольнять, а работать оно будет святым духом? Нет. Значит, в данном случае это константа не влияющая на цену решения.

0

Константа, но совсем другого порядка.

В непрофильных компаниях системы хранения эксплуатируют, зачастую, совсем не специалисты, чаще всего умеющие, главным образом, поднять кейс в вендорском саппорте, и сделать что напишут. И ничего, работают компании.

В непрофильных компаниях системы хранения эксплуатируют, зачастую, совсем не специалисты, чаще всего умеющие, главным образом, поднять кейс в вендорском саппорте, и сделать что напишут. И ничего, работают компании.

0

Ага. Тут недавно один из наших клиентов, доверившийся такому саппорту, клиентов больше 12 часов лежал. Вместо того, чтобы за пол-часа всё сделать.

0

А сколько ваших конкурентов, доверившихся такому саппорту, не лежало, их не больше ли будет?

0

Не знаю. Извините, статистики нет. Но я исхожу из принципа, что компании, в которых работают сотрудники, не понимающие как используемые ими технологии работают, проигрывают тем, в которых работают те, кто понимает.

Возможно, я ошибаюсь, и офисный плантон может работать лучше толковых специалистов.

Возможно, я ошибаюсь, и офисный плантон может работать лучше толковых специалистов.

0

> Не знаю. Извините, статистики нет.

Ну просто из соображений здравого смысла? ;)

> Возможно, я ошибаюсь, и офисный плантон может работать лучше

В своей области — безусловно да. Просто вы впадаете в обычный IT-шный центропупкизм. _Не все_ компании в мире, использующие системы хранения данных, это IT-компании. Я бы даже сказал, что IT-компаний среди них меньшинство.

Ну просто из соображений здравого смысла? ;)

> Возможно, я ошибаюсь, и офисный плантон может работать лучше

В своей области — безусловно да. Просто вы впадаете в обычный IT-шный центропупкизм. _Не все_ компании в мире, использующие системы хранения данных, это IT-компании. Я бы даже сказал, что IT-компаний среди них меньшинство.

0

Пардон, «один из наших конкурентов».

0

Вы вообще читать умеете?

Где задачи, где цифры производительности?

Сторадж — это вам не тумбочка что бы оценивать по красоте.

«легко скейлиться до 10G» — означает что вы его даже не пробовали нагрузить на 1G полноценно.

Где задачи, где цифры производительности?

Сторадж — это вам не тумбочка что бы оценивать по красоте.

«легко скейлиться до 10G» — означает что вы его даже не пробовали нагрузить на 1G полноценно.

0

Фантастически дорого.

И ни слова про iscsi over 10G, заметим… А ведь стоимость 10G инфраструктуры (а местами там даже 1G достаточно) просто смехотворная на фоне FC — при вполне сравнимых результатах.

всё, что может предложить FC — уже в iscsi есть. Местами «из коробки», местами с помощью тривиального допиливания через multipathd.

И ни слова про iscsi over 10G, заметим… А ведь стоимость 10G инфраструктуры (а местами там даже 1G достаточно) просто смехотворная на фоне FC — при вполне сравнимых результатах.

всё, что может предложить FC — уже в iscsi есть. Местами «из коробки», местами с помощью тривиального допиливания через multipathd.

+1

EMC-NTAP срач! ура-ура (+

+3

К слову о DAS. Стоят у нас полочки Promise VessJBOD 1730 в паре с контроллером Promise Supertrak EX8658 и HP MSA 60 c HP P411/1Gb. Вполне бюджетные, надёжные, и во многих случаях достаточные решения. И кстати это не «SCSI и FC», а вполне даже SAS. Соединение между полками и контроллерами по MiniSAS кабелю (SFF8088).

0

Ключевое слово «достаточные решения».

Когда задача — перевезти на сто метров полтора десятка кирпичей не нужно не только покупать самосвал, но и вообще автомобиль, вполне достаточно ручной тачки.

Но это не значит, что ручная тачка это подходящее решение для замены автомобиля (в любой ситуации).

Когда задача — перевезти на сто метров полтора десятка кирпичей не нужно не только покупать самосвал, но и вообще автомобиль, вполне достаточно ручной тачки.

Но это не значит, что ручная тачка это подходящее решение для замены автомобиля (в любой ситуации).

0

Так я и написал «во многих случаях». Есть много контор, у которых нету денег, а полтора десятка кирпичей как раз валяются. Просто в самой статье информация о DAS предоставлена в ключе «старое, убогое, медленное — короче проехали». ИМХО рановато хоронить DAS.

0

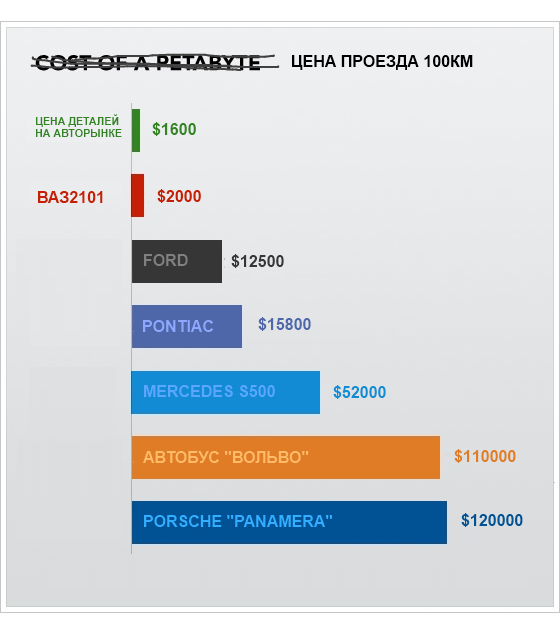

Как выглядит сферический клиент в вакууме, которому могут понадобится описанные в статье решения? Если не брать уж очень крупных. На ум сразу вспоминается картинка

За что люди платят деньги, покупая столь дорогие решения?

За что люди платят деньги, покупая столь дорогие решения?

+1

За спокойный сон.

PS. Предлагаю этой картинке уже присвоить почетное наименование «IT-баян».

PS. Предлагаю этой картинке уже присвоить почетное наименование «IT-баян».

0

<img src=" " alt=«image»/>

" alt=«image»/>

Извините, не сдержался. :)

" alt=«image»/>

" alt=«image»/>Извините, не сдержался. :)

0

Во-первых неправильно, цена проезда на автобусе на единицу человека/груза будет меньше.

Во-вторых именно по этой причине возят на газелях, а не на S500.

Во-вторых именно по этой причине возят на газелях, а не на S500.

+1

Да если бы там, в этой картинке (в оригинале), только эта нелепость была…

0

Аргументов так и не привел ни кто конкретных. Вы знаете о чем речь, а я пока нет.

0

А каких вам еще аргументов не хватает?

Ответьте на вопрос самому себе, отчего сто километров можно проехать на Порше Панамера, автобусе Volvo и самосвале Камаз, а также в сто раз дешевле перечисленного на ВАЗ-«копейке», но все равно есть люди, которые покупают Порш, автобус или самосвал, затем поменяйте «автомобиль» на «систему хранения» и получите ответ для системы хранения.

Ответьте на вопрос самому себе, отчего сто километров можно проехать на Порше Панамера, автобусе Volvo и самосвале Камаз, а также в сто раз дешевле перечисленного на ВАЗ-«копейке», но все равно есть люди, которые покупают Порш, автобус или самосвал, затем поменяйте «автомобиль» на «систему хранения» и получите ответ для системы хранения.

0

Предположим мне нужно ехать на 1500км в тайгу, где болото и нет дороги. Я покупаю внеорожник, подгатавливаю его к этому и еду. Внедорожник и подготовка меняем на OpenSource software. Я лишь дважды сталкивался с людьми, которые покупали СХД и все они были чем-то не довольны.

0

Ничего удивительного, люди вообще всегда чем-нибудь да недовольны, некоторые даже недовольны всегда и всем.

0

ЗЫ.

> Я лишь дважды сталкивался с людьми, которые покупали СХД

Даже не знаю как прокомментировать. Это очень серьезная выборка для того, чтобы сделать вывод :)

> Я лишь дважды сталкивался с людьми, которые покупали СХД

Даже не знаю как прокомментировать. Это очень серьезная выборка для того, чтобы сделать вывод :)

+1

Зарегистрируйтесь на Хабре, чтобы оставить комментарий

Введение в системы хранения данных