На Хабре было уже достаточно много топиков на тему ЦОД и вычислительных кластеров, но интересно ли Вам, на каком оборудовании работает гигант facebook или, например, Московский Internet Exchange? Что лежит в основе СКИФ—МГУ «Чебышёв» и какие «железки» в своей сети использует Большой адронный коллайдер? Добро пожаловать под кат, как говорится!

Осторожно! Много картинок и текста.

Своим названием — «Force10»— компания, прежде всего, обязана одному из своих основателей — Сому Сикдару, который, будучи заядлым яхтсменом и любителем больших волн, увековечил свое уважение к ветру силой в 10 баллов по шкале Бофорта. По сути, это очень сильный шторм. С момента основания компания специализировалась на решениях для высокопроизводительных вычислительных кластеров и корпоративных Центрах Обработки Данных (ЦОД). «Биография» длиной всего чуть больше 10 лет, но в ней можно насчитать полтора десятка событий, ставших знаковыми явлениями для мировой сетевой индустрии: первый 5 Тбит/с пассивный backplane, первый мультипроцессорный коммутатор, первый стоечный гигабитный коммутатор для ЦОД, первый модульный коммутатор с 1260 x GE портами, первая фабрика 10/40 GE на основе открытых стандартов, первый коммутатор ядра сети 2,5 Тбит/с размером 2RU.

Среди клиентов, использующих коммутаторы Force10, крупные интернет- компании, например, соцсеть facebook, и точки обмена интернет-трафиком (немецкий DE-CIX и московский MSK-IX). Отдельный сегмент потребителей Force10 — кластеры высокопроизводительных вычислений, в частности, суперкомпьютерная отрасль. По данным аналитиков, 30% из списка Top40 суперкомпьютеров мира используют оборудование Force10. В частности, в рамках суперкомпьютерной программы «СКИФ-ГРИД» Союзного государства России и Беларуси и национального проекта «Образование» с использованием технологий Force10 был создан суперкомпьютер СКИФ—МГУ «Чебышёв». Эта совместная разработка МГУ, Института Программных Систем РАН и компании «Т-Платформы» осенью 2009 года заняла вторую строчку в списке Тор50 самых мощных компьютеров СНГ. Вообще, «Т-Платформы» — постоянный партнер команды Force10, использующий эти решения высокопроизводительной коммутации во многих своих проектах.

Кроме того, на продуктах Force10 построены многие корпоративные сети, требующие высокопроизводительной коммутации. Яркий пример — сеть европейского ядерного центра CERN. Эксперименты в 27-километровом туннеле Большого адронного коллайдера, где разгоняются протоны, порождают ежегодно приблизительно 15 Петабайт данных. Все они немедленно распределяются по компьютерным лабораториям, включая приблизительно 500 научных институтов и университетов разных стран мира. Магистраль лабораторного кампуса CERN функционирует на базе ядра, построенного с использованием 10 GE коммутаторов Force10 E-серии.

В августе 2011 года компанию приобрела корпорация Dell, и соответствующая линейка продуктов получила название Dell Force10, что сделало Dell лидером мирового рынка в передовом сегменте сетей 40 GE. Нынешнее рыночное позиционирование решений Dell Force10, полученное в результате слияния технологий Dell и Force10, можно охарактеризовать следующим образом: высокопроизводительные открытые решения для ЦОДов, достигающие максимальной функциональности, гибкости, масштабируемости и показателей бесперебойной работы любых ЦОДов, независимо от того, обслуживают они небольшую рабочую группу или крупнейший поисковый сайт интернета.

В определении рыночной ниши продуктов Dell Force10 есть два ключевых слова: «высокопроизводительный» и «открытый». Продукты семейства Dell Force10 представляют собой именно открытые решения высокопроизводительной коммутации для ЦОДов, созданные на основе открытой архитектуры. Она подразумевает поддержку открытых стандартов, возможность интеграции с оборудованием других производителей, обеспечивая тем самым защиту инвестиций заказчика.

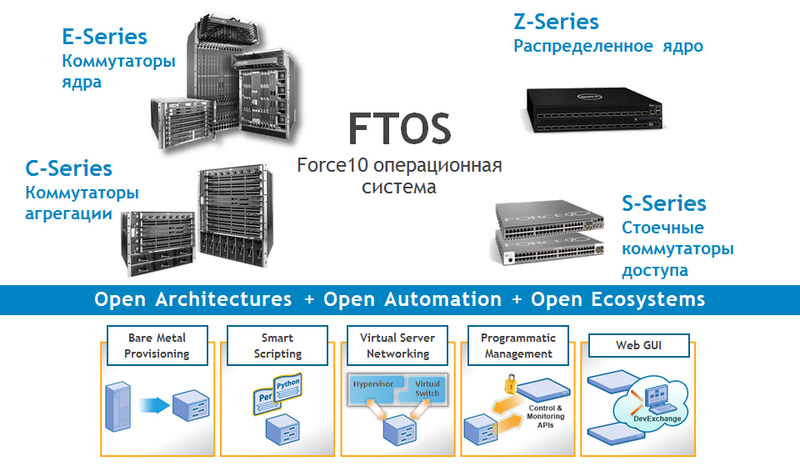

Все коммутаторы Dell Force10 работают под управлением одной модульной операционной системы FTOS (Force Ten Operating System), поддерживающей коммутацию на втором и третьем уровне (Layer 2 и Layer 3), с высокими показателями производительности и отказоустойчивости. В ней реализован уровень абстракции оборудования, который позволяет запускать одни и те же приложения на разных продуктах семейства Force10. Иными словами, есть возможность неоднократно использовать один и тот же код, что ускоряет развертывание приложений и функционала системы.

ПО FTOS разработано на базе NetBSD, бесплатной ОС с открытым кодом, построенной по модульному принципу, которая отличается высокой гибкостью, надежностью, портируемостью и эффективностью. FTOS — это операционная система операторского класса, работающая даже на самой младшей модели коммутаторов линейки Dell Force10.

Для управления сетевыми решениями Dell используется Dell OpenManage Network Manager с графическим интерфейсом пользователя. Кроме того, в больших инсталляциях и виртуализированных средах функциональность FTOS дополняется отличным ПО автоматизации операций в ЦОДе под названием Open Automation, что упрощает управление всей системой и повышает ее эффективность.

С растущим распространением виртуализации ЦОДы должны быстрее реагировать на изменения. Однако при этом задачи управления становятся все более сложными: IT менеджерам приходится иметь дело с сотнями и тысячами виртуальных машин с соответствующими ресурсами хранения и сетями. Инфраструктура ЦОД должна быстро адаптироваться к требованиям приложений, реагировать на них. Кроме того, серверами, системами хранения данных и сетями более нельзя управлять раздельно — нужна единая динамичная среда. Собственно, Open Automation и нацелена на решение этих задач.

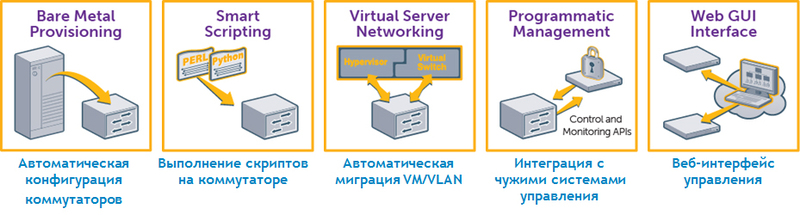

По сути, Open Automation представляет собой набор связанных между собой инструментов сетевого управления, которые можно использовать совместно или по отдельности:

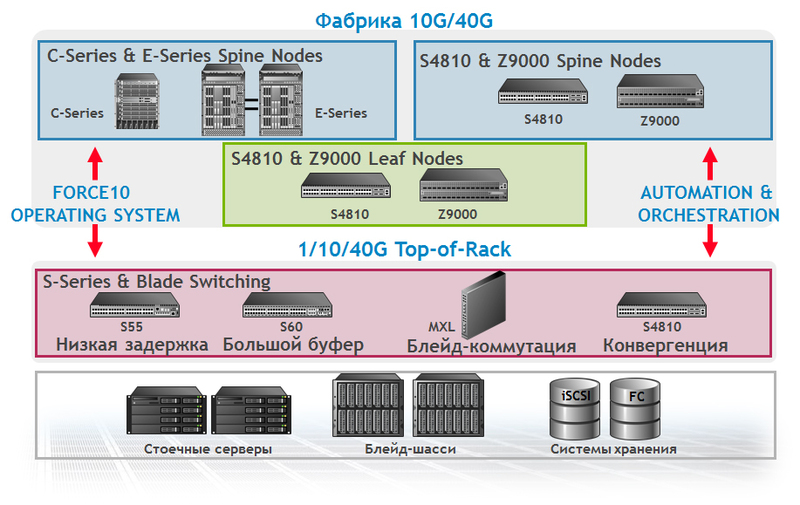

Линейка продуктов Dell Force10 состоит из четырех основных категорий (серий):

1) модульные коммутаторы E-серии;

2) модульные коммутаторы C-серии;

3) стоечные Top-of-Rack коммутаторы S-серии;

4) Z-серия для построения распределенного ядра.

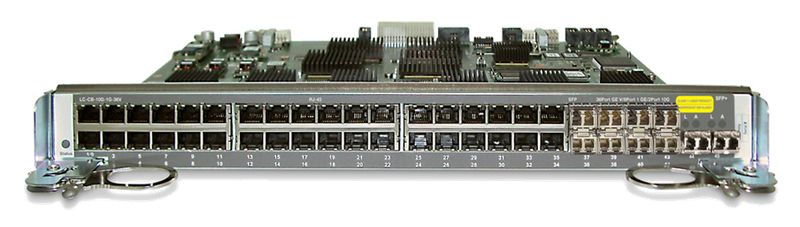

В состав E-серии входят модульные коммутаторы уровня High End, которые включают до 140 портов 10 GE без переподписки или 560 10GE с переподпиской 4:1. Примечательно, что в одном шасси можно обеспечить 1260 портов GE — это уникальная цифра в индустрии по масштабированию для модульных коммутаторов. Благодаря высокой плотности портов 10 GE, эти коммутаторы отлично подходят для работы в качестве ядра ЦОД.

Модульное шасси коммутаторов E-серии ExaScale E1200i в форм-факторе 24RU включает:

Отказоустойчивость шасси обеспечивается резервированием источников питания и вентиляторов, резервированием процессорных модулей (1+1), резервными модулями фабрики коммутации ( 9+1).

Шасси построено на базе распределенной архитектуры, предполагающей распределенную обработку на интерфейсных картах, а также отдельные процессоры для протоколов Layer 2, Layer 3 и управления.

Модульное шасси ExaScale E600i в форм-факторе 16RU обеспечивает пассивный Backplane 2,7 Тбит/с, имеет 7 слотов для интерфейсных карт (125 Гбит/с на слот). Резервируются модули фабрики коммутации (4+1 1,75 Тбит/с), процессорные модули (1+1), блоки питания (3+1 AC).

C-серия — это модульные шасси для агрегации ЦОД и ядра корпоративной сети. Для них характерна низкая стоимость в расчете на один порт. Способны поддерживать до 64 портов 10 GE и 384 GE без переподписки. Клиенты прозвали этот коммутатор трактором: включили, один раз настроили, и он «пашет», как трактор.

Модели C150 и C300 имеют пассивный медный backplane, четыре или восемь слотов для интерфейсных карт (96 Гбит/с на слот). Пропускная способность составляет, соответственно, 768 Гбит/с и 1,536 Тбит/с. Резервируются источники питания, процессорные модули с интегрированной фабрикой коммутации, вентиляторы.

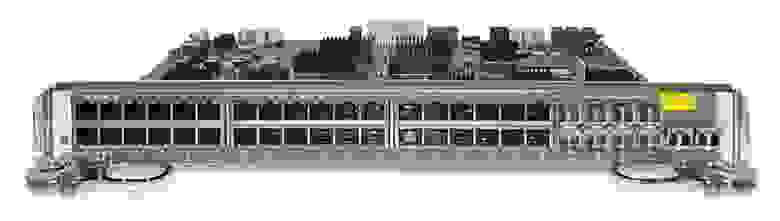

В списке интерфейсных карт для C-серии есть интересный вариант карты FlexMedia с разными типами портов, расположенных на одной карте: 36 портов 10/100/1000, 8 портов GE SFP и 2 порта 10GE SFP+.

Модульные коммутаторы C-серии прекрасно подходят для использования в ЦОДах в качестве End-of-Row коммутатора и для целей агрегирования. Поскольку все коммутационные системы C-серии поддерживают технологию Power over Ethernet, их можно развертывать в кампусных сетях и коммутационных шкафах.

S-серию составляют коммутаторы Top-of-Rack с возможностью стекирования, обеспечивающие подключения серверов по каналам Gigabit Ethernet и 10GE.

Линейка продуктов S-серии состоит из систем фиксированной конфигурации 1/10/40 GE, предназначенных в основном для использования в качестве Top-of-Rack коммутаторов уровня доступа ЦОДа. В составе линейки: модель S55 с 44 портами 10/100/1000Base-T и низкой задержкой коммутации, модель S60 с увеличенным пакетным буфером, а также S4810, ориентированная на обеспечение наивысшей плотности портов коммутатора 1/10 GE Top-of-Rack и поддерживающая 40 GE.

Модели S55 и S60 — гигабитные коммутаторы Top-of-Rack — имеют 44 медных порта 10/100/1000 для подключения серверов и до 4 портов 10 GE. Модели S55 и S60 поддерживают функционал Open Automation.

Размер пакетного буфера коммутатора S60 составляет 1,25 Гб — это уникальный показатель для стоечных гигабитных коммутаторов для всей отрасли сетевой индустрии. Коммутатор с такими возможностями особенно хорошо подходит для приложений, которые, с одной стороны, характеризуются большими всплесками трафика, а с другой, критичны к потерям пакетов, как, например, видео, iSCSI, Memcache, Hadoop.

Стоечный Top-of-Rack коммутатор S4810 c неблокируемой архитектурой обеспечивает пропускную способность 640 Гбит/с (full-duplex) и низкую задержку 700 нс, снабжен 48 портами 10 GE для подключения серверов и 4 портами 40 GE. С помощью кабелей разветвителей порт 40 GE может быть превращен в 4 порта 10 GE, и тогда у коммутатора оказывается 64 порта 10 GE, работающих на полной скорости и без переподписки. Поддерживает 128K MAC-адресов, обеспечивает коммутацию на уровнях Layer 2 и Layer 3, маршрутизацию протоколов IPv4 и IPv6. Реализована встроенная поддержка автоматизации и виртуализации (Open Automation), а также поддержка конвергенции сетей SAN и LAN (DCB, FCoE).

Коммутаторы S4810 возможно объединить в стек с помощью портов 10 или 40 GE (максимальная полоса пропускания для стекирования — 160 Гбит/с). Поддерживается объединения до 6 коммутаторов в стеке. При этом не требуются специальные стековые модули.

Поддерживается также технология Virtual Link Trunking (VLT), которая позволяет подключить серверы и коммутаторы с помощью агрегированных каналов к двум коммутаторам S4810, обеспечив тем самым отказоустойчивость и балансировку трафика по всем каналам в сети.

Блейд-коммутатор Dell Force10 MXL для блейд-шасси Dell PowerEdge M1000e, анонсированный в конце апреля и впервые показанный на выставке Interop 2012 в Лас-Вегасе, — первый в индустрии коммутатор с портами 40 GE, выполненный в блейд-формате. Он создан как составная часть виртуальной сетевой архитектуры, исходя из требований высокой производительности и высокой плотности, и способен поддерживать современные нагрузки как в традиционных, так и в виртуальных сетевых структурах, а также в публичных и частных облачных средах.

Dell Force10 MXL отличает высокая плотность портов в едином устройстве: 32 порта 1/10 GE для подключения блейд-серверов при условии неблокируемой локальной коммутации для всех блейд-серверов, подключенных к коммутатору. Он масштабируется до шести внешних 40 GE портов или до 24 внешних портов 10GE.

Коммутатор Dell Force10 MXL поддерживает стекирование, допуская подключение в стек до шести коммутаторов, которые управляются через единый IP-адрес. Для стекирования используются порты 40 GE.

Кроме того, коммутатор MXL можно легко наращивать с помощью интерфейсных модулей расширения, добавляя порты 40 GE QSFP+, 10 GE SFP+ или 10GBase-T. Использование блейд-коммутатора Dell Force10 MXL — хороший способ построения конвергентной сети SAN/LAN. Он полностью поддерживает конвергентные решения хранения данных на базе DCB и FCoE. Коммутатор MXL доступен к заказу уже сейчас.

Коммутатор Z9000 предназначен для построения распределенного ядра. При размере 2RU он способен вместить 32 порта 40 GE или с помощью кабелей-разветвителей — 128 портов 10 GE. Неблокируемая фабрика способна обеспечить пропускную способность 2,5 Тбит/с при задержке менее 3 мкс.

При этом коммутатор потребляет очень мало энергии — до 800 Вт, что составляет 6,25 Вт на один порт 10 GE. Он представляет собой типовой строительный блок для новой архитектуры распределенного ядра (Distributed Core), разработанной корпорацией Dell.

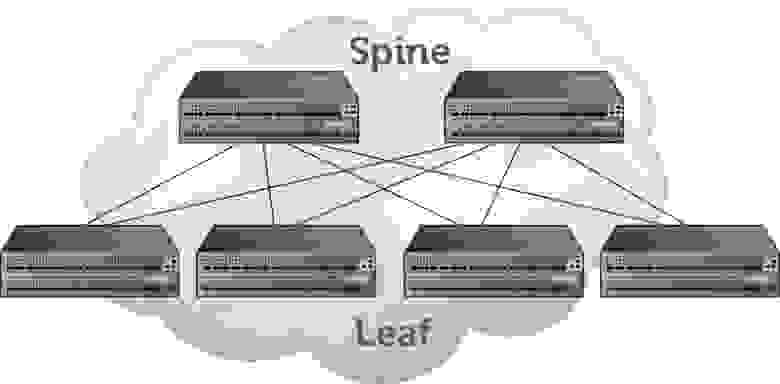

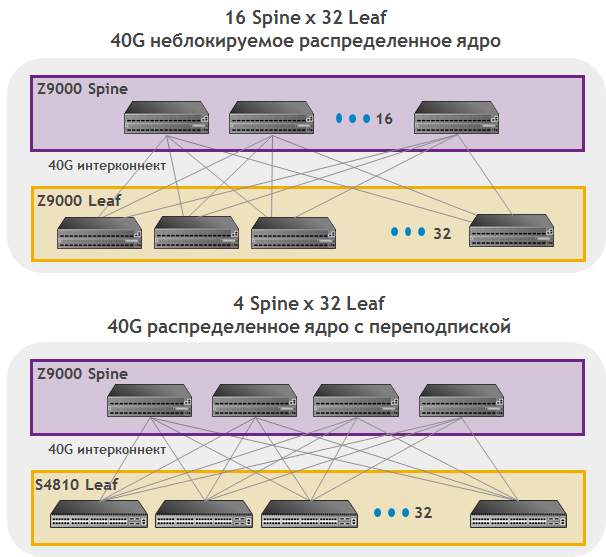

Архитектура распределенного ядра состоит из двух уровней: Spine (тот, что вверху) и Leaf (тот, что снизу). Можно провести аналогию с модульным шасси — представить распределенное ядро в виде большого модульного шасси, у которого роль фабрики коммутации выполняют коммутаторы Spine, роль интерфейсных карт выполняют коммутаторы Leaf.

Подключения между Spine и Leaf коммутаторами выполняются интерфейсами 40 GE, причем можно использовать и 10 GE с помощью кабелей-разветвителей. Протокол управления этого модульного шасси «живет» на каждом из коммутаторов: и Spine, и Leaf, то есть он является распределенным. Все коммутаторы общаются и взаимодействуют между собой на основе открытых стандартов. Масштабирование происходит путем добавления в фабрику коммутаторов Spine и Leaf по принципу plug-and-play. С использованием распределенного ядра можно построить фабрику Layer 3 на основе протоколов маршрутизации OSPF, BGP и механизма балансировки трафика по нескольким путям ECMP (Equal Cost Multipathing). Таким образом удается задействовать все каналы в фабрике. В будущем планируется также поддержка протокола TRILL (Transparent Interconnection of Lots of Links), который позволит создать Layer 2 фабрику с балансировкой по всем доступным каналам в фабрике.

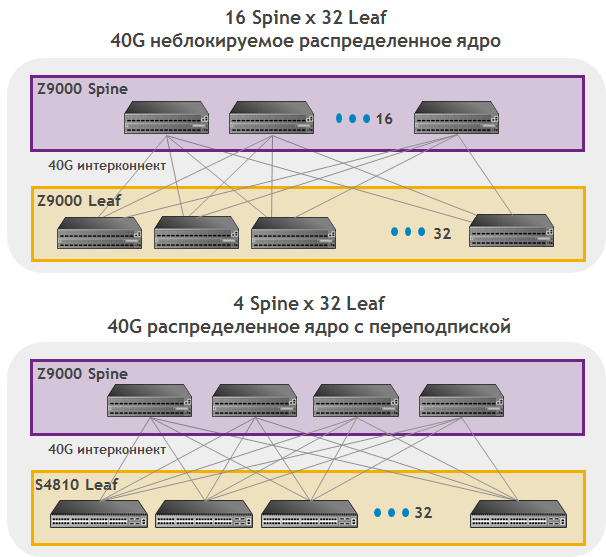

В зависимости от задач, стоящих при проектировании фабрики, можно построить распределенное ядро без переподписки и с переподпиской.

Такая архитектура обеспечивает высокую надежность. Через каждый узел Spine проходит 100/n процентов полосы пропускания (где n — количество коммутаторов Spine). Значит, для 16 узлов Spine в случае отказа одного из них доступно 93,75% полосы пропускания, по сравнению с 50% для традиционного дизайна, состоящего из двух модульных коммутаторов.

Кроме того, становится возможным масштабировать систему по мере роста: начать с минимального числа узлов Spine и Leaf и затем добавлять по мере необходимости (до 8192 портов доступа 10 GE без переподписки в фабрике). По сравнению с сетью, построенной на модульных шасси, распределенное ядро имеет меньше энергопотребление и занимает меньше места в стойках.

Для того чтобы упростить создание распределенного ядра, корпорация Dell разработала специальное ПО Dell Fabric Manager. Оно помогает проектировать и создавать распределенное ядро, а также управлять им. В частности, автоматизируется ряд трудоемких функций, как, например, разработка схемы кабельной разводки для соединения портов между коммутаторами фабрики или конфигурирование системы из множества коммутаторов. Dell Fabric Manager поддерживает также удаленный мониторинг коммутаторов распределенного ядра, используя наглядное графическое представление топологии сети.

Таким образом, архитектура распределенного ядра обеспечивает сверхмасштабируемую фабрику Leaf-Spine для ЦОДа с минимальной задержкой коммутации на скорости до 160 Тбит/с при умеренных размерах, требованиях по мощности и цене.

Очевидно, что тенденция виртуализации теперь распространяется и на сети: в гипервизорные среды начинают встраивать сетевые возможности для виртуальных машин. Первым шагом в реализации этой тенденции стало появление встроенных виртуальных коммутаторов vSwitch (таких, как, например, vDS для VMware ESX). Компания Dell включила поддержку виртуализации в состав своего ПО автоматизации управления ЦОДом Open Automation. Следующий логический шаг в сторону более глубокого внедрения возможностей виртуализации в сеть и поддержки виртуализации между ЦОДами связан с технологиями VxLAN (Virtual Extensible Local Area Network) и NVGRE (Network Virtualization using Generic Routing Encapsulation).

В августе прошлого года группа компаний, возглавляемая VMware, анонсировала в рамках IETF проект RFC для VxLAN — виртуальных расширяемых локальных сетей. Фактически это предложение стандарта виртуализации, который позволит перемещать виртуальные машины через границы Layer 3, используя абстракцию идентификаторов второго уровня (Layer 2 ID). В сентябре другая группа компаний, возглавляемая Microsoft, анонсировала еще один проект — IETF RFC для NVGRE. Предлагаемая в рамках NVGRE среда виртуализации сети поддерживает безопасный режим использования общих ресурсов (multi-tenancy) и мобильность виртуальных машин в частных и публичных облаках с помощью протокола инкапсуляции Generic Routing Encapsulation (GRE).

Корпорация Dell намерена поддерживать обе спецификации: VxLAN и NVGRE — и работает над поддержкой соответствующих технологий в своих продуктах Dell Force10. В таком случае заказчики продукции Dell смогут применять те гипервизоры, к которым они привыкли. Более того, Dell предполагает тесно сотрудничать с ведущими вендорами гипервизоров и ОС для дальнейшего совершенствования спецификаций VxLAN и NVGRE.

Мы считаем, что в дополнение к виртуальным сетям в гипервизорной среде сама физическая сеть также должна эволюционировать в направлении открытых и основанных на стандартах сетей Software Defined Networking (SDN). Сетевая архитектура программно-конфигурируемых сетей SDN основывается на двух фундаментальных архитектурных принципах: (1) разделения уровня управления (control plane) и уровня передачи данных (data plane) и (2) совместимости с виртуальными сетями в гипервизорных средах следующего поколения. Будущая сетевая архитектура, в которой функционируют «знающие» о сети приложения, работает в виртуализированной среде и при необходимости динамически создает логические сети. Эти логические сети являются наложенными, то есть работают поверх программно-управляемой физической сетевой инфраструктуры, и разработаны для того, чтобы доставлять все необходимые данные и приложения, а также дополнительные сервисы любому пользователю, независимо от того, является среда физической или виртуальной.

В Dell такую архитектуру называют Virtual Network Architecture (VNA) и разрабатывают продукты и решения в соответствии с приоритетным для нашей компании направлением к сетям SDN.

Что ж, если вам интересно, как коммутаторы Dell Force10 могут помочь в вашем бизнесе, — обращайтесь. Наши специалисты могут и проконсультировать, и выехать к вам посмотреть «что к чему», и вместе с вами подумать о внедрении Force10 для решения ваших задач. Все вопросы вы можете адресовать напрямую Марату Ракаеву из Dell: marat_rakaev@dell.com.

UPDATE!!! Вся информация в статье полностью актуальна.

Осторожно! Много картинок и текста.

Небольшое исторически-лирическое отступление

Своим названием — «Force10»— компания, прежде всего, обязана одному из своих основателей — Сому Сикдару, который, будучи заядлым яхтсменом и любителем больших волн, увековечил свое уважение к ветру силой в 10 баллов по шкале Бофорта. По сути, это очень сильный шторм. С момента основания компания специализировалась на решениях для высокопроизводительных вычислительных кластеров и корпоративных Центрах Обработки Данных (ЦОД). «Биография» длиной всего чуть больше 10 лет, но в ней можно насчитать полтора десятка событий, ставших знаковыми явлениями для мировой сетевой индустрии: первый 5 Тбит/с пассивный backplane, первый мультипроцессорный коммутатор, первый стоечный гигабитный коммутатор для ЦОД, первый модульный коммутатор с 1260 x GE портами, первая фабрика 10/40 GE на основе открытых стандартов, первый коммутатор ядра сети 2,5 Тбит/с размером 2RU.

Среди клиентов, использующих коммутаторы Force10, крупные интернет- компании, например, соцсеть facebook, и точки обмена интернет-трафиком (немецкий DE-CIX и московский MSK-IX). Отдельный сегмент потребителей Force10 — кластеры высокопроизводительных вычислений, в частности, суперкомпьютерная отрасль. По данным аналитиков, 30% из списка Top40 суперкомпьютеров мира используют оборудование Force10. В частности, в рамках суперкомпьютерной программы «СКИФ-ГРИД» Союзного государства России и Беларуси и национального проекта «Образование» с использованием технологий Force10 был создан суперкомпьютер СКИФ—МГУ «Чебышёв». Эта совместная разработка МГУ, Института Программных Систем РАН и компании «Т-Платформы» осенью 2009 года заняла вторую строчку в списке Тор50 самых мощных компьютеров СНГ. Вообще, «Т-Платформы» — постоянный партнер команды Force10, использующий эти решения высокопроизводительной коммутации во многих своих проектах.

Кроме того, на продуктах Force10 построены многие корпоративные сети, требующие высокопроизводительной коммутации. Яркий пример — сеть европейского ядерного центра CERN. Эксперименты в 27-километровом туннеле Большого адронного коллайдера, где разгоняются протоны, порождают ежегодно приблизительно 15 Петабайт данных. Все они немедленно распределяются по компьютерным лабораториям, включая приблизительно 500 научных институтов и университетов разных стран мира. Магистраль лабораторного кампуса CERN функционирует на базе ядра, построенного с использованием 10 GE коммутаторов Force10 E-серии.

В августе 2011 года компанию приобрела корпорация Dell, и соответствующая линейка продуктов получила название Dell Force10, что сделало Dell лидером мирового рынка в передовом сегменте сетей 40 GE. Нынешнее рыночное позиционирование решений Dell Force10, полученное в результате слияния технологий Dell и Force10, можно охарактеризовать следующим образом: высокопроизводительные открытые решения для ЦОДов, достигающие максимальной функциональности, гибкости, масштабируемости и показателей бесперебойной работы любых ЦОДов, независимо от того, обслуживают они небольшую рабочую группу или крупнейший поисковый сайт интернета.

Открытые решения и архитектура «шторма»

В определении рыночной ниши продуктов Dell Force10 есть два ключевых слова: «высокопроизводительный» и «открытый». Продукты семейства Dell Force10 представляют собой именно открытые решения высокопроизводительной коммутации для ЦОДов, созданные на основе открытой архитектуры. Она подразумевает поддержку открытых стандартов, возможность интеграции с оборудованием других производителей, обеспечивая тем самым защиту инвестиций заказчика.

Все коммутаторы Dell Force10 работают под управлением одной модульной операционной системы FTOS (Force Ten Operating System), поддерживающей коммутацию на втором и третьем уровне (Layer 2 и Layer 3), с высокими показателями производительности и отказоустойчивости. В ней реализован уровень абстракции оборудования, который позволяет запускать одни и те же приложения на разных продуктах семейства Force10. Иными словами, есть возможность неоднократно использовать один и тот же код, что ускоряет развертывание приложений и функционала системы.

ПО FTOS разработано на базе NetBSD, бесплатной ОС с открытым кодом, построенной по модульному принципу, которая отличается высокой гибкостью, надежностью, портируемостью и эффективностью. FTOS — это операционная система операторского класса, работающая даже на самой младшей модели коммутаторов линейки Dell Force10.

Для управления сетевыми решениями Dell используется Dell OpenManage Network Manager с графическим интерфейсом пользователя. Кроме того, в больших инсталляциях и виртуализированных средах функциональность FTOS дополняется отличным ПО автоматизации операций в ЦОДе под названием Open Automation, что упрощает управление всей системой и повышает ее эффективность.

С растущим распространением виртуализации ЦОДы должны быстрее реагировать на изменения. Однако при этом задачи управления становятся все более сложными: IT менеджерам приходится иметь дело с сотнями и тысячами виртуальных машин с соответствующими ресурсами хранения и сетями. Инфраструктура ЦОД должна быстро адаптироваться к требованиям приложений, реагировать на них. Кроме того, серверами, системами хранения данных и сетями более нельзя управлять раздельно — нужна единая динамичная среда. Собственно, Open Automation и нацелена на решение этих задач.

По сути, Open Automation представляет собой набор связанных между собой инструментов сетевого управления, которые можно использовать совместно или по отдельности:

- Автоматическая конфигурация коммутаторов (Bare Metal Provisioning ) — сокращает время инсталляции, устраняет ошибки конфигурирования и стандартизирует конфигурации за счет автоматической настройки сетевых коммутаторов.

- Выполнение скриптов на коммутаторе (Smart Scripting) — улучшает мониторинг и управление сетью с помощью мощной среды скриптов Perl/Python .

- Автоматическая миграция VM/VLAN (Virtual Server Networking) — упрощает управление сетью в виртуализированной среде, обеспечивая автоматическую миграцию виртуальных локальных сетей (VLAN) вместе с виртуальными машинами (VM).

- Интеграция с системами управления (Programmatic Management) — управление коммутаторами с помощью инструментов сторонних производителей и поддержка стандартных интерфейсов управления.

Линейка продуктов Dell Force10

Линейка продуктов Dell Force10 состоит из четырех основных категорий (серий):

1) модульные коммутаторы E-серии;

2) модульные коммутаторы C-серии;

3) стоечные Top-of-Rack коммутаторы S-серии;

4) Z-серия для построения распределенного ядра.

E-серия коммутаторов Dell Force10

В состав E-серии входят модульные коммутаторы уровня High End, которые включают до 140 портов 10 GE без переподписки или 560 10GE с переподпиской 4:1. Примечательно, что в одном шасси можно обеспечить 1260 портов GE — это уникальная цифра в индустрии по масштабированию для модульных коммутаторов. Благодаря высокой плотности портов 10 GE, эти коммутаторы отлично подходят для работы в качестве ядра ЦОД.

Модульное шасси коммутаторов E-серии ExaScale E1200i в форм-факторе 24RU включает:

- Пассивный медный backplane 5 Тбит/с.

- Модульную фабрику коммутации 3,5 Тбит/с.

- 14 слотов для интерфейсных карт, 125 Гбит/с на слот.

- 6 блоков питания AC.

Отказоустойчивость шасси обеспечивается резервированием источников питания и вентиляторов, резервированием процессорных модулей (1+1), резервными модулями фабрики коммутации ( 9+1).

Шасси построено на базе распределенной архитектуры, предполагающей распределенную обработку на интерфейсных картах, а также отдельные процессоры для протоколов Layer 2, Layer 3 и управления.

Модульное шасси ExaScale E600i в форм-факторе 16RU обеспечивает пассивный Backplane 2,7 Тбит/с, имеет 7 слотов для интерфейсных карт (125 Гбит/с на слот). Резервируются модули фабрики коммутации (4+1 1,75 Тбит/с), процессорные модули (1+1), блоки питания (3+1 AC).

C-серия коммутаторов Dell Force10

C-серия — это модульные шасси для агрегации ЦОД и ядра корпоративной сети. Для них характерна низкая стоимость в расчете на один порт. Способны поддерживать до 64 портов 10 GE и 384 GE без переподписки. Клиенты прозвали этот коммутатор трактором: включили, один раз настроили, и он «пашет», как трактор.

Модели C150 и C300 имеют пассивный медный backplane, четыре или восемь слотов для интерфейсных карт (96 Гбит/с на слот). Пропускная способность составляет, соответственно, 768 Гбит/с и 1,536 Тбит/с. Резервируются источники питания, процессорные модули с интегрированной фабрикой коммутации, вентиляторы.

В списке интерфейсных карт для C-серии есть интересный вариант карты FlexMedia с разными типами портов, расположенных на одной карте: 36 портов 10/100/1000, 8 портов GE SFP и 2 порта 10GE SFP+.

Модульные коммутаторы C-серии прекрасно подходят для использования в ЦОДах в качестве End-of-Row коммутатора и для целей агрегирования. Поскольку все коммутационные системы C-серии поддерживают технологию Power over Ethernet, их можно развертывать в кампусных сетях и коммутационных шкафах.

S-серия коммутаторов Dell Force10

S-серию составляют коммутаторы Top-of-Rack с возможностью стекирования, обеспечивающие подключения серверов по каналам Gigabit Ethernet и 10GE.

Линейка продуктов S-серии состоит из систем фиксированной конфигурации 1/10/40 GE, предназначенных в основном для использования в качестве Top-of-Rack коммутаторов уровня доступа ЦОДа. В составе линейки: модель S55 с 44 портами 10/100/1000Base-T и низкой задержкой коммутации, модель S60 с увеличенным пакетным буфером, а также S4810, ориентированная на обеспечение наивысшей плотности портов коммутатора 1/10 GE Top-of-Rack и поддерживающая 40 GE.

Модели S55 и S60 — гигабитные коммутаторы Top-of-Rack — имеют 44 медных порта 10/100/1000 для подключения серверов и до 4 портов 10 GE. Модели S55 и S60 поддерживают функционал Open Automation.

Размер пакетного буфера коммутатора S60 составляет 1,25 Гб — это уникальный показатель для стоечных гигабитных коммутаторов для всей отрасли сетевой индустрии. Коммутатор с такими возможностями особенно хорошо подходит для приложений, которые, с одной стороны, характеризуются большими всплесками трафика, а с другой, критичны к потерям пакетов, как, например, видео, iSCSI, Memcache, Hadoop.

Стоечный Top-of-Rack коммутатор S4810 c неблокируемой архитектурой обеспечивает пропускную способность 640 Гбит/с (full-duplex) и низкую задержку 700 нс, снабжен 48 портами 10 GE для подключения серверов и 4 портами 40 GE. С помощью кабелей разветвителей порт 40 GE может быть превращен в 4 порта 10 GE, и тогда у коммутатора оказывается 64 порта 10 GE, работающих на полной скорости и без переподписки. Поддерживает 128K MAC-адресов, обеспечивает коммутацию на уровнях Layer 2 и Layer 3, маршрутизацию протоколов IPv4 и IPv6. Реализована встроенная поддержка автоматизации и виртуализации (Open Automation), а также поддержка конвергенции сетей SAN и LAN (DCB, FCoE).

Коммутаторы S4810 возможно объединить в стек с помощью портов 10 или 40 GE (максимальная полоса пропускания для стекирования — 160 Гбит/с). Поддерживается объединения до 6 коммутаторов в стеке. При этом не требуются специальные стековые модули.

Поддерживается также технология Virtual Link Trunking (VLT), которая позволяет подключить серверы и коммутаторы с помощью агрегированных каналов к двум коммутаторам S4810, обеспечив тем самым отказоустойчивость и балансировку трафика по всем каналам в сети.

Блейд-коммутатор Dell Force10 MXL для блейд-шасси Dell PowerEdge M1000e, анонсированный в конце апреля и впервые показанный на выставке Interop 2012 в Лас-Вегасе, — первый в индустрии коммутатор с портами 40 GE, выполненный в блейд-формате. Он создан как составная часть виртуальной сетевой архитектуры, исходя из требований высокой производительности и высокой плотности, и способен поддерживать современные нагрузки как в традиционных, так и в виртуальных сетевых структурах, а также в публичных и частных облачных средах.

Dell Force10 MXL отличает высокая плотность портов в едином устройстве: 32 порта 1/10 GE для подключения блейд-серверов при условии неблокируемой локальной коммутации для всех блейд-серверов, подключенных к коммутатору. Он масштабируется до шести внешних 40 GE портов или до 24 внешних портов 10GE.

Коммутатор Dell Force10 MXL поддерживает стекирование, допуская подключение в стек до шести коммутаторов, которые управляются через единый IP-адрес. Для стекирования используются порты 40 GE.

Кроме того, коммутатор MXL можно легко наращивать с помощью интерфейсных модулей расширения, добавляя порты 40 GE QSFP+, 10 GE SFP+ или 10GBase-T. Использование блейд-коммутатора Dell Force10 MXL — хороший способ построения конвергентной сети SAN/LAN. Он полностью поддерживает конвергентные решения хранения данных на базе DCB и FCoE. Коммутатор MXL доступен к заказу уже сейчас.

Z-серия коммутаторов Dell Force10

Коммутатор Z9000 предназначен для построения распределенного ядра. При размере 2RU он способен вместить 32 порта 40 GE или с помощью кабелей-разветвителей — 128 портов 10 GE. Неблокируемая фабрика способна обеспечить пропускную способность 2,5 Тбит/с при задержке менее 3 мкс.

При этом коммутатор потребляет очень мало энергии — до 800 Вт, что составляет 6,25 Вт на один порт 10 GE. Он представляет собой типовой строительный блок для новой архитектуры распределенного ядра (Distributed Core), разработанной корпорацией Dell.

Распределенное ядро

Архитектура распределенного ядра состоит из двух уровней: Spine (тот, что вверху) и Leaf (тот, что снизу). Можно провести аналогию с модульным шасси — представить распределенное ядро в виде большого модульного шасси, у которого роль фабрики коммутации выполняют коммутаторы Spine, роль интерфейсных карт выполняют коммутаторы Leaf.

Подключения между Spine и Leaf коммутаторами выполняются интерфейсами 40 GE, причем можно использовать и 10 GE с помощью кабелей-разветвителей. Протокол управления этого модульного шасси «живет» на каждом из коммутаторов: и Spine, и Leaf, то есть он является распределенным. Все коммутаторы общаются и взаимодействуют между собой на основе открытых стандартов. Масштабирование происходит путем добавления в фабрику коммутаторов Spine и Leaf по принципу plug-and-play. С использованием распределенного ядра можно построить фабрику Layer 3 на основе протоколов маршрутизации OSPF, BGP и механизма балансировки трафика по нескольким путям ECMP (Equal Cost Multipathing). Таким образом удается задействовать все каналы в фабрике. В будущем планируется также поддержка протокола TRILL (Transparent Interconnection of Lots of Links), который позволит создать Layer 2 фабрику с балансировкой по всем доступным каналам в фабрике.

В зависимости от задач, стоящих при проектировании фабрики, можно построить распределенное ядро без переподписки и с переподпиской.

Фабрика для ЦОД любого размера

| Размер фабрики | Маленькая | Средняя | Большая |

|---|---|---|---|

| Узлы Spine | S4810 | Z9000 | Z9000 |

| Узлы Leaf | S4810 | S4810 | Z9000 |

| Число узлов | 4 spine/12 leaf | 4 spine/32 leaf | 16 spine/32 leaf |

| Интерконнект фабрики | 10 GbE | 40 GbE | 40 GbE |

| Производительность фабрики | 3.84 Тбит/с | 10.24 Тбит/с | 40.96 Тбит/с |

| Доступных портов 10GbE | 576 с переподпиской 3:1 | 1,536 с переподпиской 3:1 | 2,048 неблокируемых |

Такая архитектура обеспечивает высокую надежность. Через каждый узел Spine проходит 100/n процентов полосы пропускания (где n — количество коммутаторов Spine). Значит, для 16 узлов Spine в случае отказа одного из них доступно 93,75% полосы пропускания, по сравнению с 50% для традиционного дизайна, состоящего из двух модульных коммутаторов.

Кроме того, становится возможным масштабировать систему по мере роста: начать с минимального числа узлов Spine и Leaf и затем добавлять по мере необходимости (до 8192 портов доступа 10 GE без переподписки в фабрике). По сравнению с сетью, построенной на модульных шасси, распределенное ядро имеет меньше энергопотребление и занимает меньше места в стойках.

Для того чтобы упростить создание распределенного ядра, корпорация Dell разработала специальное ПО Dell Fabric Manager. Оно помогает проектировать и создавать распределенное ядро, а также управлять им. В частности, автоматизируется ряд трудоемких функций, как, например, разработка схемы кабельной разводки для соединения портов между коммутаторами фабрики или конфигурирование системы из множества коммутаторов. Dell Fabric Manager поддерживает также удаленный мониторинг коммутаторов распределенного ядра, используя наглядное графическое представление топологии сети.

Таким образом, архитектура распределенного ядра обеспечивает сверхмасштабируемую фабрику Leaf-Spine для ЦОДа с минимальной задержкой коммутации на скорости до 160 Тбит/с при умеренных размерах, требованиях по мощности и цене.

Что будет дальше?

Очевидно, что тенденция виртуализации теперь распространяется и на сети: в гипервизорные среды начинают встраивать сетевые возможности для виртуальных машин. Первым шагом в реализации этой тенденции стало появление встроенных виртуальных коммутаторов vSwitch (таких, как, например, vDS для VMware ESX). Компания Dell включила поддержку виртуализации в состав своего ПО автоматизации управления ЦОДом Open Automation. Следующий логический шаг в сторону более глубокого внедрения возможностей виртуализации в сеть и поддержки виртуализации между ЦОДами связан с технологиями VxLAN (Virtual Extensible Local Area Network) и NVGRE (Network Virtualization using Generic Routing Encapsulation).

В августе прошлого года группа компаний, возглавляемая VMware, анонсировала в рамках IETF проект RFC для VxLAN — виртуальных расширяемых локальных сетей. Фактически это предложение стандарта виртуализации, который позволит перемещать виртуальные машины через границы Layer 3, используя абстракцию идентификаторов второго уровня (Layer 2 ID). В сентябре другая группа компаний, возглавляемая Microsoft, анонсировала еще один проект — IETF RFC для NVGRE. Предлагаемая в рамках NVGRE среда виртуализации сети поддерживает безопасный режим использования общих ресурсов (multi-tenancy) и мобильность виртуальных машин в частных и публичных облаках с помощью протокола инкапсуляции Generic Routing Encapsulation (GRE).

Корпорация Dell намерена поддерживать обе спецификации: VxLAN и NVGRE — и работает над поддержкой соответствующих технологий в своих продуктах Dell Force10. В таком случае заказчики продукции Dell смогут применять те гипервизоры, к которым они привыкли. Более того, Dell предполагает тесно сотрудничать с ведущими вендорами гипервизоров и ОС для дальнейшего совершенствования спецификаций VxLAN и NVGRE.

Мы считаем, что в дополнение к виртуальным сетям в гипервизорной среде сама физическая сеть также должна эволюционировать в направлении открытых и основанных на стандартах сетей Software Defined Networking (SDN). Сетевая архитектура программно-конфигурируемых сетей SDN основывается на двух фундаментальных архитектурных принципах: (1) разделения уровня управления (control plane) и уровня передачи данных (data plane) и (2) совместимости с виртуальными сетями в гипервизорных средах следующего поколения. Будущая сетевая архитектура, в которой функционируют «знающие» о сети приложения, работает в виртуализированной среде и при необходимости динамически создает логические сети. Эти логические сети являются наложенными, то есть работают поверх программно-управляемой физической сетевой инфраструктуры, и разработаны для того, чтобы доставлять все необходимые данные и приложения, а также дополнительные сервисы любому пользователю, независимо от того, является среда физической или виртуальной.

В Dell такую архитектуру называют Virtual Network Architecture (VNA) и разрабатывают продукты и решения в соответствии с приоритетным для нашей компании направлением к сетям SDN.

Что ж, если вам интересно, как коммутаторы Dell Force10 могут помочь в вашем бизнесе, — обращайтесь. Наши специалисты могут и проконсультировать, и выехать к вам посмотреть «что к чему», и вместе с вами подумать о внедрении Force10 для решения ваших задач. Все вопросы вы можете адресовать напрямую Марату Ракаеву из Dell: marat_rakaev@dell.com.

UPDATE!!! Вся информация в статье полностью актуальна.