Рассчитать движение пары триллионов молекул, чтобы ты не забыл взять утром зонтик, или смоделировать работу настоящего сердца.

Суперкомпьютеры уже давно влияют на нашу жизнь способами, о которых большинство из нас даже не догадываются. Результаты, получаемые с помощью высокопроизводительных вычислений, используются в каждодневной рутине любого человека — прогноз погоды, просмотр фильмов, управление онлайн-банкингом и множество других, казалось бы, обыденных действий.

Суперкомпьютеры, или как их еще называют «Супер-ЭВМ», используются для решения довольно специфических задач вроде моделирования сложных природных явлений или технических прототипов для предсказания поведения исследуемой системы.

Благодаря тому, что современные компьютеры представляют собой совокупность большого количество кластеров, они имеют колоссальную производительность — квадриллионы операций в секунду. По сути, это достигается подключением к кластеру обычных блейд-серверов до тех пор, пока не будет получена требуемая мощность.

Ученые и корпорации используют этих электронных зверей для решения множества прикладных задач. Такие машины, как Sierra от компании Lawrence Livermore Lab, проверяют степень безопасности хранения ядерного оружия в правительственных арсеналах, рассчитывая радиус взрыва термоядерных боеголовок.

Хотя большая часть вычислительной мощности (125 квадриллионов операций в секунду) Sierra используется для научной работы — например, прогнозирования последствий рака, построения моделей человеческого сердца или картирования черепно-мозговых травм.

Прогноз погоды

Прогноз погоды уходит корнями к работам норвежского физика Вильгельма Бьеркнеса, которого считают отцом современной метеорологии. В 1904 году он опубликовал статью, в которой предположил, что можно прогнозировать погоду, решая систему нелинейных дифференциальных уравнений в частных производных.

Бьеркнес выделил пять основных составляющих прогноза погоды: атмосферное давление, температура, плотность воздуха, влажность и скорость воздушных потоков по осям XYZ. Хотя сегодня известно, что на атмосферу влияет гораздо больше сил — солнечная радиация, городская застройка и даже молекулярный состав самого воздуха.

Британский математик Льюис Фрай Ричардсон потратил три года на разработку методов и процедур для решения этих уравнений. Работая на полях сражений Первой мировой войны во Франции, где он был членом бригады скорой помощи, Ричардсон пытался вычислить прогноз изменения давления в одной точке пространства — на расчет ушло шесть недель, но предсказания оказалось совершенно нереалистичным.

Впрочем, позже Ричардсон предрекал существование «фабрики прогнозов», полагая, что тысячи компьютеров, каждый из которых будет отвечать за небольшую часть планеты, будут регулярно предсказывать погодные условия. И в целом он оказался прав — вместо тысячи компьютеров один большой и мощный.

Уже к 1954 году возможности моделирования и мощности компьютеров достигли такого уровня, что Европа и Соединенные Штаты стали активно рассматривать возможность численного прогноза погоды в реальном времени.

В те годы использовался компьютер IBM 701, дважды в день выпускающий прогнозы. Хотя, правды ради, эти прогнозы еще не могли конкурировать с теми, что были составлены вручную. Но необходимый стимул был уже заложен — к 1958 году производимые прогнозы стали демонстрировать неуклонно возрастающую точность.

Прогнозы строились на численной модели, отчего, собственно, и назывались «численными». По сути, это компьютерная программа, в основе которой лежат системы математических уравнений гидромеханики Эйлера, описывающие аэро-, гидро- и термодинамические процессы в атмосфере и связывающие такие параметры, как плотность, скорость, давление и температура, в единое целое.

В качестве исходных данных для моделей используются данные метеозондов, метеоспутников и наземных метеостанций.

Кстати, у каждой страны есть своя сеть метеоспутников: Meteosat у Европы, GOES у США, MTSAT у Японии, Fengyun у Китая, GOMS у России, KALPANA у Индии. Конечно, все они делятся между собой информацией, но по большей части работают на внутренний «рынок».

Правильная модель позволяет экстраполировать поведение атмосферы на ближайшее будущее и получать прогнозы. Хотя модели необязательно быть глобальной, покрывая всю Землю, — она может описывать изменение воздушного пространства и в более локальных участках планеты.

Чем больше в расчетах используется точек пространства, тем выше точность модели, но и тем выше требования к мощностям вычислительных устройств.

Например, до недавнего времени Британское метеорологическое бюро (Met Office) использовало суперкомпьютер Cray XC40 от компании Cray стоимостью 120 миллионов долларов.

Суперкомпьютер состоял из трех основных систем. Первые две обеспечивали высокую отказоустойчивость для выполнения срочных прогнозов погоды, тогда как третья использовалась в долгосрочных исследованиях, разработках и совместной работе.

Устройство выполняло более 14 000 триллионов операций в секунду, содержало 2 петабайта оперативной памяти, информация с которых обрабатывалась 460 000 вычислительными ядрами. При этом общее хранилище равнялось 24 петабайтам — этого достаточно для воспроизведения HD-фильмов длительностью более чем 100 лет.

Эти характеристики позволяли метеобюро каждый день обрабатывать свыше 200 миллиардов эмпирических данных со спутников, метеорологических станций, зондов и буев в океане.

Однако, в 2020 году бюро приступило к обновлению используемого оборудования, стремясь увеличить мощность (и точность прогнозов) примерно в 6 раз — для этого был подписан 10-летний контракт с компанией Microsoft на сумму более 1,6 миллиарда долларов.

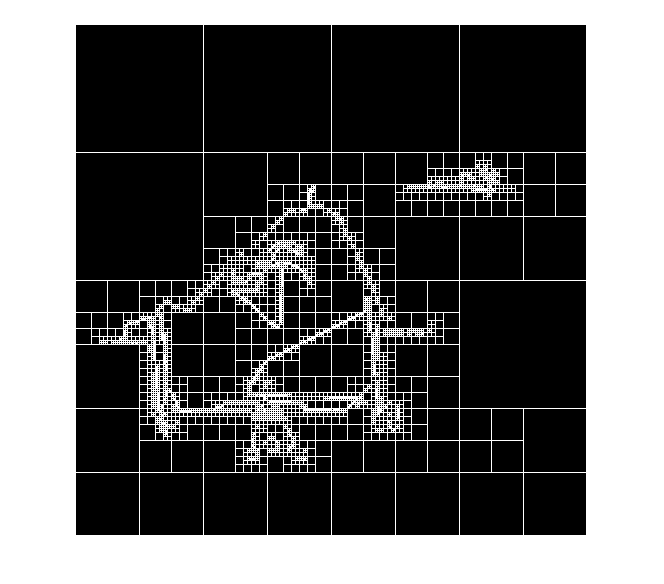

Как было сказано выше, виртуальный земной шар в моделях прогнозирования разделен на квадраты (или квадраНты), представляя собой квадродерево. Увеличение мощности позволяет уменьшать сторону этих квадратов, конкретизируя модель и увеличивая точность.

При этом точность прогнозирования (размер квадратов) может меняться в зависимости от конкретной территории. Например, сторона квадрата на территории Соединенного Королевства составляла около 1,5 км, а непосредственно над Лондоном — всего 300 метров. Благодаря этому метеослужба, например, может точнее предсказывать состояние воздушного пространства над аэропортами.

Кстати, в отечественном Росгидромете стоит аналогичный британскому бюро суперкомпьютер Cray XC40-LC производительностью 1,2 петафлопс — внутри 936 вычислительных узлов с процессорами Intel Xeon и 128 ГБ оперативной памяти на каждый узел.

В это время в Национальном центре экологического прогнозирования (NCEP) США используется похожее оборудование — два суперкомпьютера от IBM и HPE Cray размером с комнату.

Впрочем, существует глобальная централизованная инициатива предсказания погоды от IBM — Global High-Resolution Atmospheric Forecasting System (GRAF), суть которой заключается, как заявляет компания, в демократизации прогнозов погоды для свободного доступа со стороны людей, предприятий и правительств в независимости от их местонахождения.

Модель прогнозирования имеет разрешение детализации до 2 миль в ширину, выпуская до 12 триллионов данных о погоде каждый день. Для сравнения, точность метеослужб за пределами Европы, США и Японии составляет 6–9 миль.

Для этих целей IBM использует суперкомпьютер DYEUS, названный в честь древнего бога, правившего дневным небом. DYEUS построен на процессорах IBM Power 9, которые также есть и в другом суперкомпьютере IBM — Summit.

Кроме того, DYEUS использует графические процессоры аналогичные тем, на которых геймеры запускают видеоигры, что позволяет значительно ускорить обработку визуального вывода.

Однако система GRAF не ограничивается классическими для синоптиков сборщиками атмосферной информации — система может собирать данные с датчиков самолетов и даже смартфонов, которые обладают возможностью измерять температуру и давление.

Исследование 2015 года, проведенное Питером Бауэром, Аланом Торпом и Гилбертом Брюнетом, показывает, что точность современного пятидневного прогноза сравнима с точностью трехдневного прогноза около 20 лет назад. По сути, каждое десятилетие человечество увеличивает эффективный срок прогнозирования примерно на один день.

Но будет ли этот рост навыков продолжаться в будущем? Это зависит от того, какого прогресса можно добиться с помощью суперкомпьютерных технологий. Более быстрые вычислительные машины позволят запускать модели с более высоким разрешением, что приведет к улучшению навыков прогнозирования.

Однако, несмотря на закон Мура, указывающий на удвоение вычислительной мощности компьютерных систем каждые два года, в последнее время рост замедляется — с большей вероятностью в будущем потребуются другие методы повышения эффективности вычислительных устройств.

Поэтому предсказать погоду со 100% точностью попросту невозможно — в атмосфере существует около 2×10⁴⁴ (200 000 000 000 000 000 000 000 000 000 000 000 000 000 000) молекул, каждая из которых находится в случайном движении. Попытка просчитать их всех физически непостижима.

Такая хаотическая и дисперсная природа погоды означает, что метеорологи вынуждены аппроксимировать реальный атмосферный процесс до более тривиальных компонентов, делая упрощенные предположения о протекающих явлениях. Поэтому модель всегда может ошибаться.

Автопилот, бензин и батареи

Сколько существует вычислительная техника, столько она помогает автомобилям становится быстрее, безопаснее и энергоэффективнее. Как правило, основные задачи связаны с моделированием различных ситуаций, проектированием новых конструкций техники и автоматизацией многокомпонентного роботизированного производства.

Например, Mazda использовала суперкомпьютер Cray Y-MP2E стоимостью 8 миллионов долларов для разработки крыши Aero-Wave в спорткаре RX-7 1993 года выпуска.

Несмотря на то, что стиль автомобиля придумали дизайнерские студии Mazda в Японии (Йокогаме) и Калифорнии (Ирвин), аэродинамика рассчитывалась на одном из двух суперкомпьютеров от компании Cray.

Столь точное трехмерное компьютерное моделирование позволило сократить сопротивление ветра за счет продольной складки на крыше, а общий коэффициент сопротивления оказался крайне низким и составил всего 0,29.

Исследование, выполненное суперкомпьютером, показало, что корпус крыши должен быть намного жестче как на изгиб, так и на скручивание, чем у предыдущей модели. Тогда Mazda называла этот дизайн «космическим монококом», который экономил порядка 200 фунтов веса, будучи при этом на 20 процентов жестче, чем его предшественник.

Вообще, надо сказать, японские производители в 90-е годы довольно активно применяли компьютеры Cray в проектировании новых моделей.

Например, Honda стала седьмой японской компанией, купившей Cray за 7 миллионов долларов — Cray был запущен в автомобильном центре исследований и разработок Honda. Хотя основными конкурентами по производству суперкомпьютеров у Cray тогда были Fujitsu и Hitachi — они тоже намеревались нарастить поставки оборудования автомобильным гигантам.

Компания Nissan использовала оборудование Cray в разработке новейшего для того времени заднеприводного Nissan 240SX с объемом двигателя 2,4 литра.

В новой системе подвески были устранены проблемы с избыточной поворачиваемостью, характерные для предыдущих моделей, — каждое заднее колесо управлялось сложными движениями четырех рычагов. Инженеры Nissan утверждали, что длину и расположение этих рычагов было невозможно определить с помощью стандартных расчетов, поэтому для этого использовались вычислительные мощности суперкомпьютеров Cray.

Поэтому хорошая производительность, превосходная управляемость и низкая цена позволили 240SX стать фаворитом среди водителей-энтузиастов.

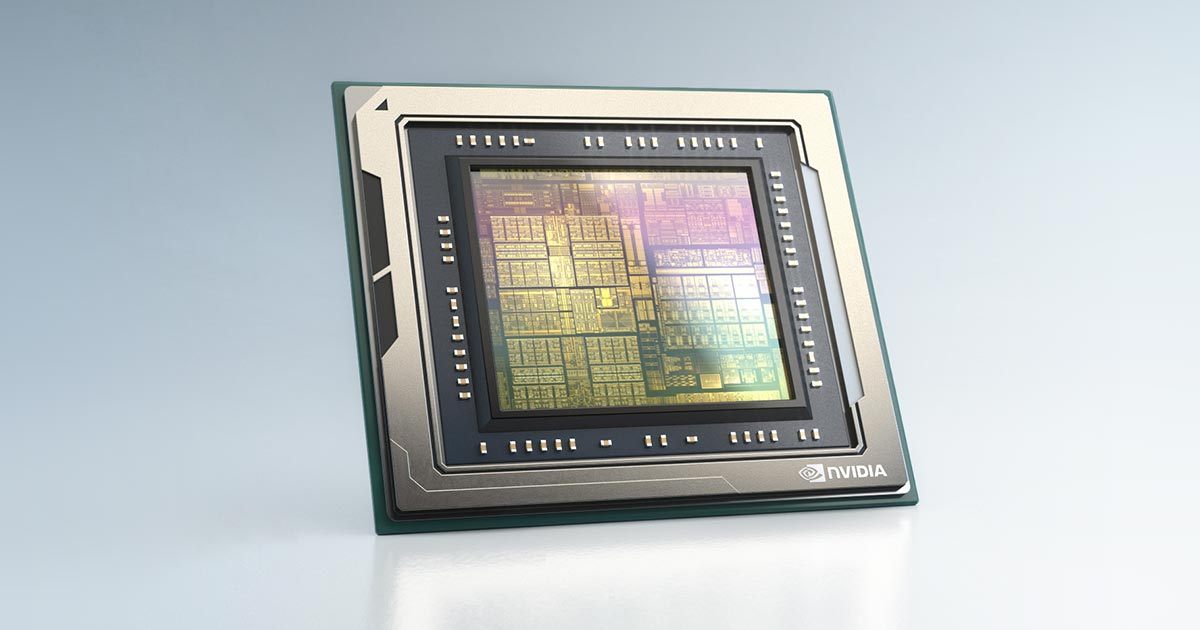

С 2020 года Mercedes-Benz объединился с Nvidia для разработки автомобильной вычислительной платформы следующего поколения.

Nvidia, будучи одним из самых известных в мире производителей графических карт, уже несколько лет участвует в рискованном начинании по созданию «мозгов», которые управляют беспилотными автомобилями, в надежде продать их крупным авто-гигантам.

Платформа NVIDIA DRIVE Hyperion обрабатывает данные с камер, радаров и лидарных датчиков, анализируя окружающую среду, после чего локализует автомобиль на карте и прокладывает безопасный путь. Среди прочих функций платформы: автономное вождение, управление салоном, мониторинг водителя и дополнительные функции безопасности — все помещается в компактный корпус.

Система Nvidia Drive может отслеживать голову, положение глаз и частоту моргания водителя, оценивая степень его внимания по отношению к дороге и уровень сонливости.

В случае обнаружения нестандартной ситуации система предупреждает водителя с помощью звуковых, визуальных или тактильных предупреждений, побуждая его сосредоточиться на дороге. Например, если водитель собирается выйти из автомобиля, не заметив приближающегося велосипедиста, Nvidia сперва подаст предупреждение, а в крайнем случае физически предотвратит открытие двери.

Внутри NVIDIA DRIVE использует систему на кристалле (SoC) Orin с пиковой мощностью 254 триллиона операций в секунду (TOPS). По сути, это центральный компонент системы Hyperion.

Помимо прочего, он поддерживает функции автопилота, подобно Tesla или Super Cruise от Cadillac, а также систему парковки без водителя или вызова автомобиля, вроде Smart Summon от той же Tesla.

Конечно, надвигающаяся эра автономных автомобилей позволит суперкомпьютерам занять основную роль в обучении и управлении ИИ автопилота.

Сегодня принято считать, что в авангарде «программно-определяемых транспортных средств» находится Tesla. Однако важно помнить, что, помимо разработки ПО, компания также производит и аппаратное обеспечение.

Одна из основных задач, которой занимается компания — «автомаркировка», добавляющая метки к необработанным видеоданным, чтобы они могли стать частью системы принятия решений ИИ. Ведь большая часть процесса распознавания окружения вокруг автомобиля связана с подгонкой данных датчиков к предварительно обработанным ситуациям. Подобно людям, умеющим распознавать дорожные условия по прошлому опыту, автономный автомобиль опирается на опыт вождения предварительно обученного ИИ автопилота.

Набор данных для обучения просто огромен — 1 000 000 десяти секундных видеороликов с каждой из восьми камер Tesla, работающих со скоростью 36 кадров в секунду. В сумме все видеоролики содержат 6 миллиардов меток дорожных объектов (данные о глубине и скорости) общим объемом в 1,5 петабайта. Все это нужно, чтобы вносить нестандартные сценарии в память ИИ.

Ранее старший директор по искусственному интеллекту в Tesla Андрей Карпати в одном из своих выступлений показывал кластер из 720 узлов, каждый из которых оснащен восемью графическими процессорами Nvidia A100 с 80 гб видеопамяти — в общей сумме 5760 видеокарт.

Из его слов, вся эта мощность дополнялась 10-ю петабайтами NVMe хранилища — скорость передачи составляла около 1,6 терабайта в секунду. Карпати называл эту систему «одной из самых быстрых файловых систем в мире» и «примерно пятым суперкомпьютером на планете»

Однако в середине 2022 года Tesla рассказала о новом суперкомпьютере Dojo, построенном на собственных чипах компании. Во время конференции AI Day компания заявила, что 4 шкафа с системами Dojo могут выполнять ту же работу, что и 4000 графических процессоров Nvidia A100, используемых ранее.

Реализация Dojo отличается от общепринятых подходов — вместо объединения мелких чипов в единое целое, процессоры Tesla представляют собой один большой чип с 354 ядрами, специально предназначенный для машинного обучения. В каждом шкафу под 12 чипов — в сумме 4 248 ядер. А 10 шкафов, объединенных в кластер, который компания называет «эксаподом», имеет 42 480 ядер.

Такая компоновка позволяет уместить максимальное количество ядер в одном и том же физическом пространстве. Да, графические процессоры имеют гораздо больше ядер, чем обычные процессоры, но, поскольку Dojo специально оптимизирован для машинного обучения, он на несколько порядков быстрее, чем любая другая архитектура на основе видеокарт.

Хотя, из-за коммерческой тайны оборудование Tesla не входит в таблицу лучших суперкомпьютеров мира TOP500. Кто знает, сколько в мире существует похожих закрытых корпоративных систем, обладающих мощностью мирового уровня?

С другой стороны, электромобили (впрочем, как и автопилот) все еще остаются экзотикой для автолюбителей. Среднестатистический человек по прежнему использует старый добрый бензин. Производство топлива, которым заправляют подавляющее большинство автомобилей, в современных реалиях тоже нуждается в помощи суперкомпьютеров.

Нефтегазовые компании, наряду с другими промышленными группами, все больше полагаются на мощное оборудования для более быстрой обработки сложных данных. Это позволяет им сокращать расходы, одновременно повышая производительность и успешность проектов.

Например, французская нефтяная группа Total использует специальные компьютеры Pangea III, разработанные IBM, для увеличения эффективности поиска нефтяных месторождений.

Total использует суперкомпьютеры с 2013 года — за 10 лет вычислительная мощность компании была увеличена с 2,3 до 31,7 петафлопс, что эквивалентно 170 000 ноутбуков вместе взятых. Такая большая мощность позволила ускорить обработку собранных сейсмических данных в 10 раз.

И надо сказать, оборудование Total не просто какой-то локально установленный мощный компьютер — Pangea III занимает первое место среди суперкомпьютеров в нефтегазовом секторе, а в 2019 году находился на 11-й строчке в таблице TOP500. При этом в списке общемировой энергоэффективности Green500 он занимает 6-е место.

Хотя, глобальный переход на возобновляемые источники побуждает высокопроизводительные машины фокусироваться на отрасли альтернативной энергетики.

Например, британские исследователи из Лондонского University College London «приспособили» суперкомпьютер, названный Michael в честь британского ученого Майкла Фарадея, для ускорения исследований в области аккумуляторных батарей.

Конечно, его мощность и стоимость гораздо скромнее оборудования Total — 265 терафлопс за 2 миллиона долларов — но этого вполне достаточно для работы над одними из самых сложных проблем в области хранения энергии.

Моделирование с задействованием виртуальных вычислений в первую очередь позволяет сократить огромные затраты на производство многочисленных прототипов, каждый из которых используется для тестирования как новых материалов, так и новых конфигураций элементов.

Используемые в вычислениях модели, вроде публично доступных PyBaMM или DandeLiion, позволяют прогнозировать работу аккумуляторов, начиная с атомного масштаба и заканчивая размерами целого батарейного блока. При этом происходящие во время симуляции процессы можно наблюдать с точностью от наносекунд до нескольких лет — обычно столько служит среднестатистический автомобильный аккумулятор.

Биомоделирование

Органическая материя в своем устройстве и поведении, пожалуй, самая сложная структура во вселенной.

Поэтому моделирование биологических систем можно считать единственной в мире задачей, которая способна раскрыть весь потенциал высокопроизводительных устройств.

Центральным местом использования суперкомпьютеров в био-исследованиях является концепция цифровых двойников. И хотя она изначально возникла в области машиностроения, где требовались точные виртуальные расчеты разрабатываемых технических устройств, она нашла свое место и в медицине.

Цифровой двойник — это виртуальная копия материального объекта (двигателя, человека, сердца, подшипника от трактора) или нематериальной системы (производственного процесса или маркетинговой системы), которую можно анализировать независимо от ее реального аналога.

В недавнем будущем использовались похожие подходы, но без виртуализации. Например, NASA держало физические копии космических кораблей на Земле, в то время как настоящие находились в открытом космосе — инженеры на Земле могли определить проблему и найти решение, используя те же ресурсы, что и астронавты в космосе.

Впоследствии с развитием компьютеров физические копии уступили цифровым. Компьютерную симуляцию стали называть испытаниями «in silico», то есть на кремние, на чипе.

Например, суперкомпьютер HPE SGI 8600 от Hewlett Packard Enterprise уже долгое время помогает проекту EPFL Blue Brain реконструировать и моделировать цифровые модели мозга млекопитающих, чтобы улучшить понимание человечества мозга.

Моделирование отдельного нейрона требует решения примерно 20 000 обыкновенных дифференциальных уравнений, а для целых областей мозга потребуется около 100 миллиардов уравнений, решаемых одновременно в режиме реального времени.

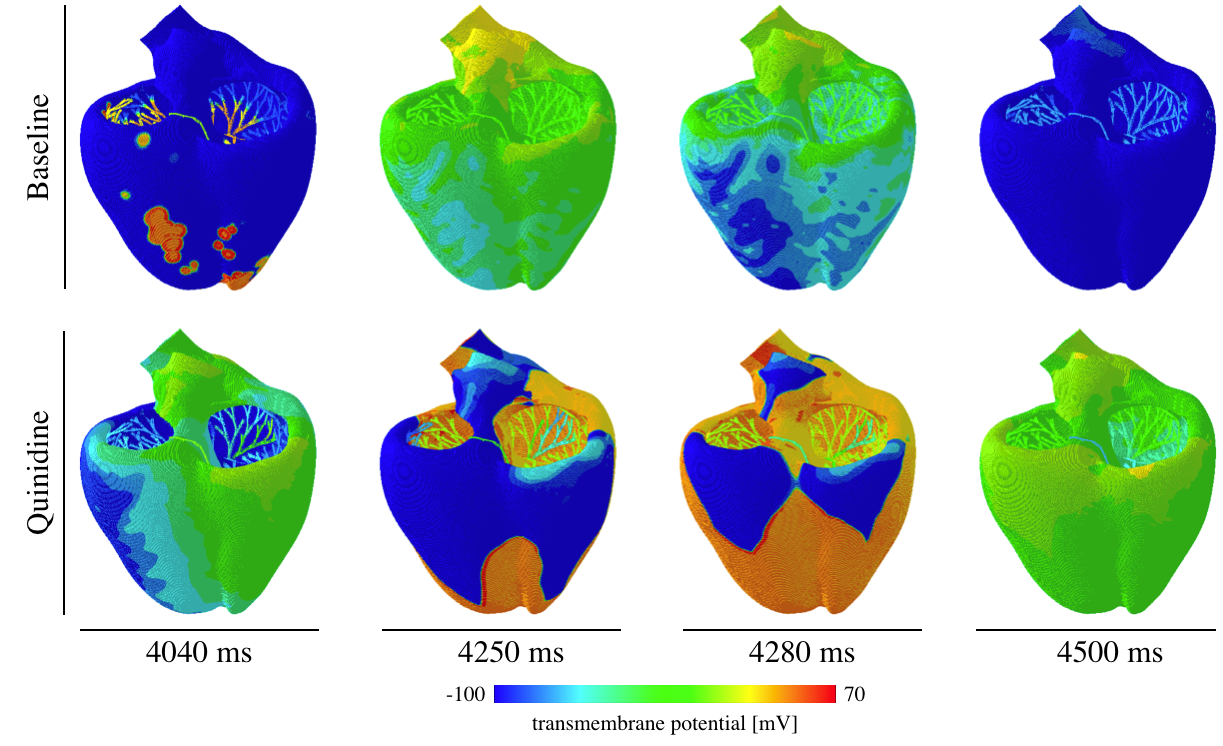

В это время команда из Стэнфорда совместно с SIMULIA разработала масштабную трехмерную модель сердца, которая может предсказать риск летальной аритмии, вызванной лекарствами.

Виртуальное сердце состоит из различных типов высокодетализированных клеточных моделей, позволяя вычислять электрокардиограммы (ЭКГ) во время виртуального приема лекарств.

Такой инструмент помогает быстро и недорого оценить реакцию новых химических соединений, тем самым ускоряя выход на рынок рабочих и безопасных лекарств и предотвращая появление на полках аптек плохо проверенных препаратов.

В проекте использовалась публичная облачная платформа UberCloud. На начальных этапах модель калибровалась для достижения правильной реакции виртуального сердца на здоровый случай употребления лекарства, после чего она использовалась для тестирования других нестандартных химических соединений.

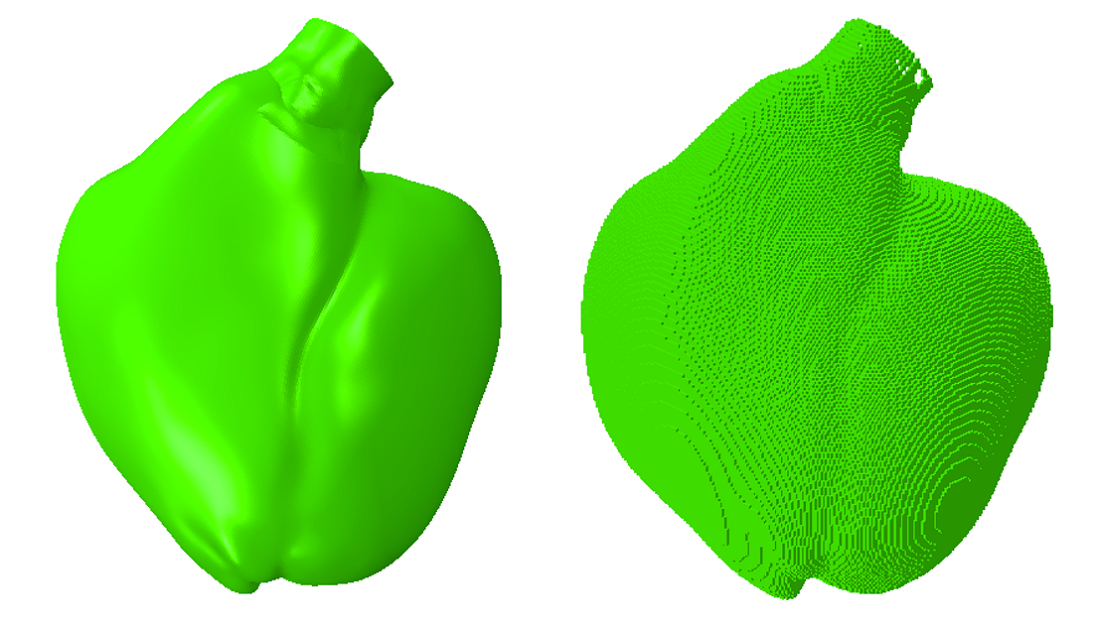

Изначально планировалось использовать аппроксимирующую сетку, на основе которой выполняются вычисления, которая состоит из тетраэдрических элементов в количестве около 5 миллионов штук.

Однако такая сложная геометрия не позволила масштабировать модель — временной шаг симуляции составлял 0,0012 мс при общем необходимом времени моделирования 5000 мс, что довольно медленно.

Поэтому тетраэдрическую сетку заменили на кубическую. Гладкость поверхности сердца была потеряна, но количество рассчитываемых элементов упало в 10 раз — быстрая модель проще калибруется и проще записывается с помощью электрокардиограммы, которая и резюмирует итоговые результаты симуляции.

В конечном счете ожидается, что высокопроизводительные вычисления вкупе с концепцией цифровых двойников откроют новую эру персонализированной медицины, в которой индивидуальное лечение настраивается в соответствии с генетическим строением конкретного человека и списка его хронических заболеваний.

Мультфильмы и CGI

Многие продакшн-студии, работающие над кино и мультфильмами, имеют собственные центры обработки данных. Например, в далеком 2013 году у Pixar было 2000 серверов с общим числом ядер более 24 000.

Обычно для рендеринга 1 кадра требуется не менее 24 часов, при этом одна секунда фильма — это 24 кадра. Классический 100-минутный мультфильм потребует около 400 лет машинного времени. Однако за счет использования суперкомпьютера на рендеринг Университета монстров ушло всего 2 года — да, 2 года перманентного рендеринга.

А Weta Digital, приложившая свои флопсы к «Аватару», «Планете обезьян» , трилогии «Властелина колец», «Хоббиту», «Мстителям» и другим известным кинокартинам, в своем время использовала множество суперкомпьютеров, каждый из которых занимал 190-195 позиции в списке TOP500.

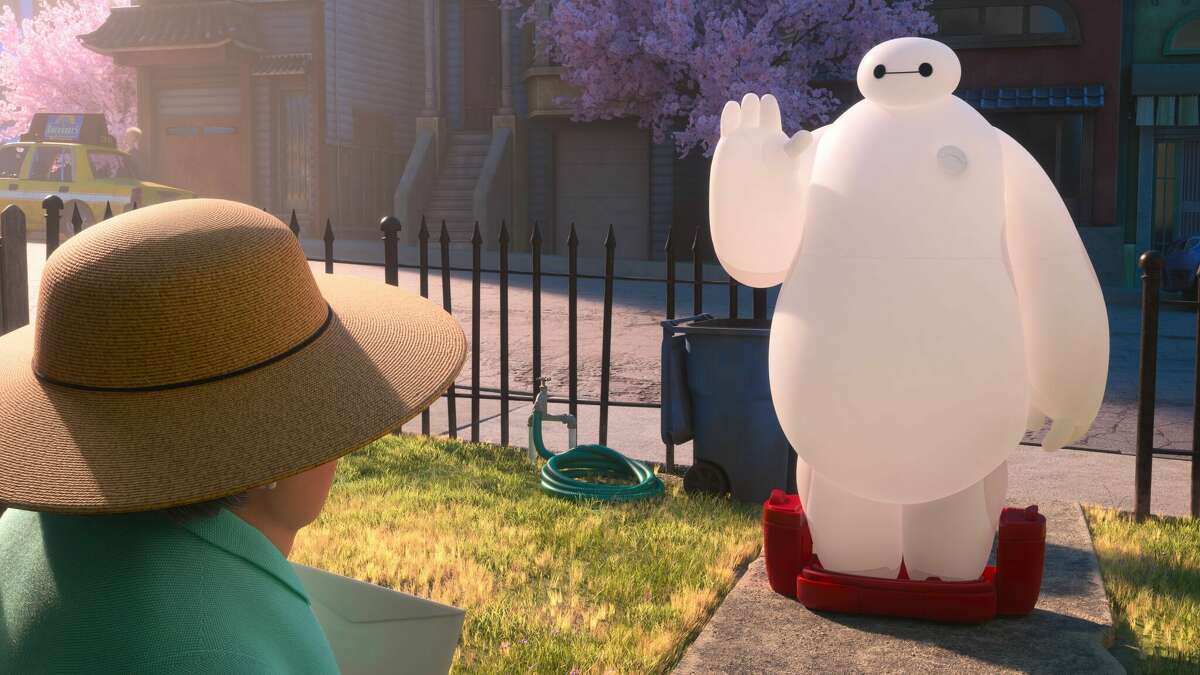

Рыхлый белый робот-помощник Baymax, будучи главным героем диснеевского мультфильма «Город героев 6», был визуализирован с использованием суперкомпьютера с 55 000 ядер — для идеальной картинки он рассчитывал 10 миллиардов лучей света, отражающихся от каждого объекта вокруг.

Анимационный фильм был создан с использованием внутренней разработки Disney — рендерера и трассировщика путей Hyperion. На его создание ушло два года и 200 миллионов вычислительных часов.

Hyperion — это то, что позволяет смешать кинематографическое качество с мультипликационными карикатурными образами в единую картинку. До этого Disney никогда раньше не мог использовать свет таким образом.

Сложные световые расчеты придают Бэймаксу особый эффект прозрачности, позволяя свету отражаться внутри него.

Огромное количество рассчитываемых лучей света придает некоторую мягкость и глубину теням от объектов, которые практически отсутствуют в игровых рендерерах реального времени. Однако для получения такой картинки нужны колоссальные вычислительные ресурсы и достаточное количество времени на рендер.

Три фермы рендеринга Disney в Лос-Анджелесе и еще одна в Сан-Франциско были разобраны на части, после чего собраны в единый суперкомпьютерный кластер из почти 4600 компьютеров с 55 000 ядер. Для сравнения, «Холодное сердце» использовало только 26 000 ядер.

С такой мощностью художники могут увидеть созданные в течение рабочего дня кадры уже на следующее утро, а рендеринг всего фильма занимает всего 5 месяцев, а не долгие 2-3 года.

В общем, делать сложные расчеты, с которыми обычный настольный ПК справился бы за столетия, если бы вообще справился — задача как раз под стать современным суперкомпьютерным кластерам.

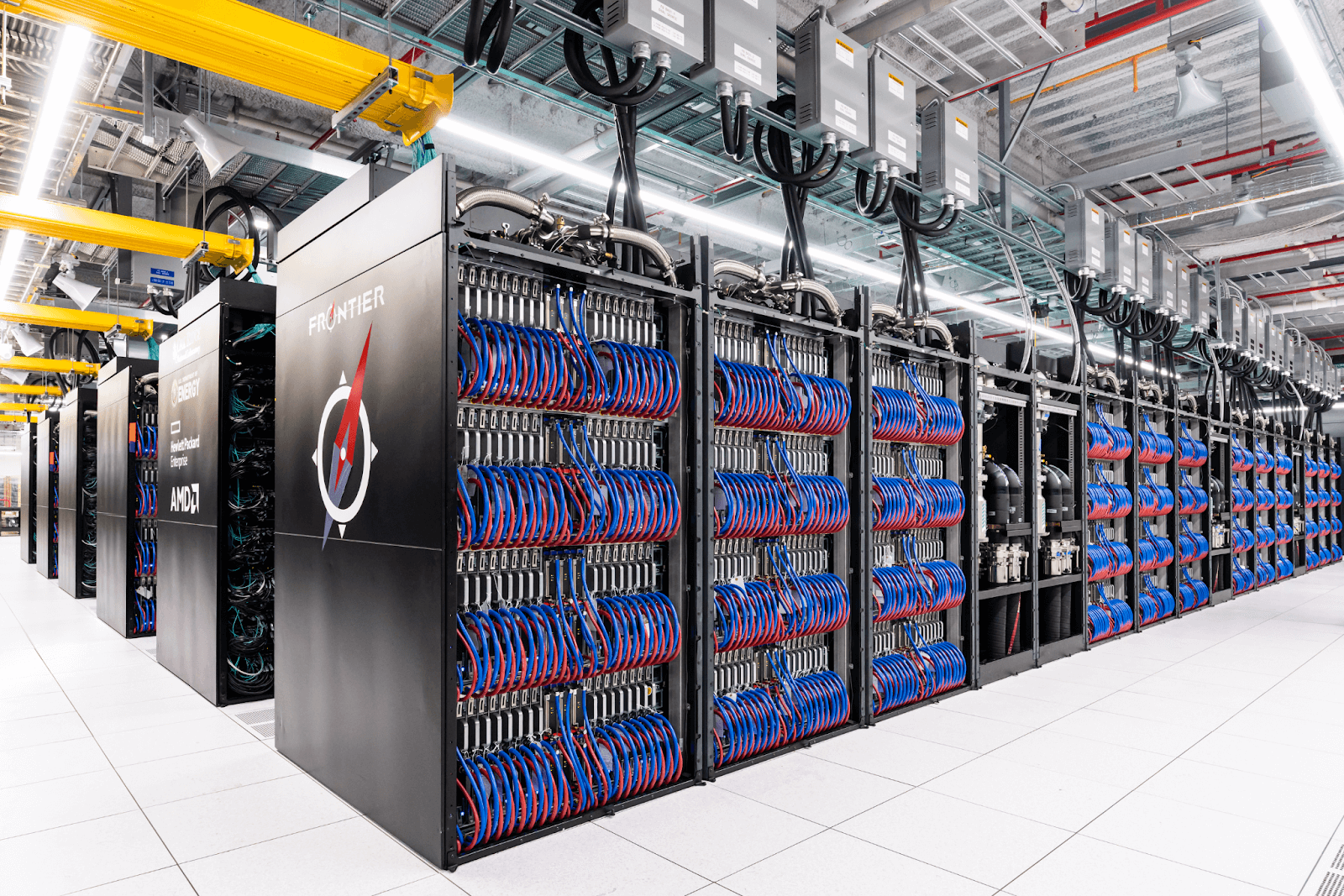

А с новой эрой экзафлопсных вычислений, которую совсем недавно открыл суперкомпьютер Frontier, высокопроизводительные операции обещают стать еще быстрее.

С другой стороны, пресловутый закон Блинна утверждает, что время рендеринга имеет тенденцию оставаться постоянным, даже когда компьютеры становятся быстрее.

Поэтому, скорее всего, вслед за художниками и аниматорами, предпочитающими наращивать качество рисуемых сцен, ученые и инженеры продолжат улучшать свои продукты с помощью все более сложных алгоритмов, отправляющих нас в совсем близкое будущее точных прогнозов, идеально рассчитанных конструкций транспортных средств, гениального ИИ и продвинутой медицины, спасающей миллионы людей по всему миру.

НЛО прилетело и оставило здесь промокод для читателей нашего блога:— 15% на все тарифы VDS (кроме тарифа Прогрев) — HABRFIRSTVDS