Некоторые люди полагаются на зрение для распознавания личности собеседника. Это крайне ненадёжный подход, если можно подделать картинку на экране. В эпоху цифровой видеосвязи внешность, голос и поведение человека перестали выполнять функцию надёжной идентификации.

За последние годы разработано несколько эффективных инструментов для подделки видеопотока, в том числе Avatarify Desktop и Deepfake Offensive Toolkit. Таким образом, у злоумышленников появились все возможности, чтобы подделать лицо и голос произвольного человека во время звонка. Специалисты по безопасности и пользователи должны понимать, насколько элементарно выполняется такая операция.

Avatarify Desktop

Одним из первых опенсорсных инструментов для видеоспуфинга стала программа Avatarify Desktop в 2020 году. Для работы требуется Windows 10, рекомендуется видеокарта GeForce 1070 или выше и веб-камера (текущая версия программы 0.10, 897 МБ).

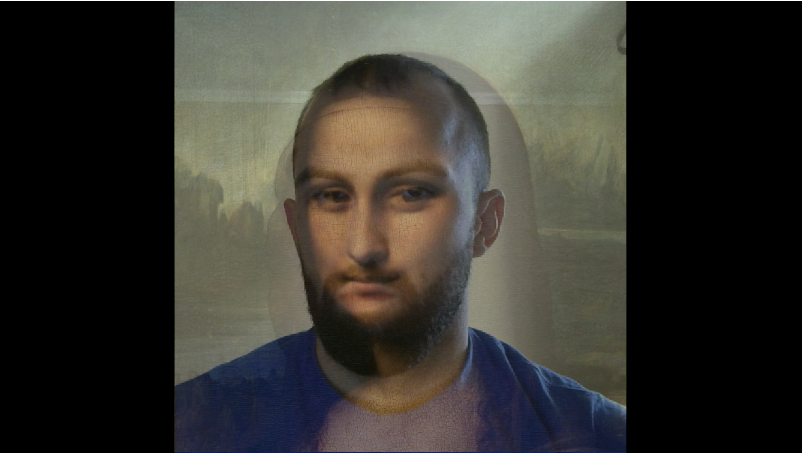

После установки программы её нужно настроить, подключив веб-камеру и расположив своё лицо в центре кадра, а потом выбрав подходящий аватар из набора внизу: Эйнштейн, Стив Джобс, Мона Лиза и т. д.

Спуфинг конференцсвязи выполняется через виртуальную камеру. В настройках Zoom или другой программы для видеокнференций в качестве источника видеосигнала следует указать Avatarify Camera.

В программу можно загрузить произвольный аватар, то есть фотографию любого человека. Разработчик поясняет, что спуфинг выглядит наиболее реалистично, если поза на фотографии совпадает с реальной. Для совмещения источника с аватаром предназначен слайдер Overlay, регулирующий прозрачность накладываемых слоёв (на КДПВ).

Deepfake Offensive Toolkit

В июне 2022 года на Github опубликован более продвинутый инструмент Deepfake Offensive Toolkit (DOT), разработанный компанией Sensity, которая специализируется на пентестинге видеосистем KYC.

Программа тоже работает через виртуальную камеру, которая генерирует интегрированный видеопоток, получая вход с веб-камеры и вставляя туда результат генерации дипфейков.

Нейросеть уже обучена. Дополнительное обучение не требуется. Результат генерируется на лету по фотографии объекта.

В данный момент поддерживается несколько методов генерации: OpenCV (низкое качество), FOMM (First Order Motion Model), а также SimSwap, в том числе с опцией повышенного разрешения (через GPEN).

Для работы программы под Windows требуется OBS Studio с плагином VirtualCam. Сначала виртуальная камера настраивается в OBS Studio, а затем уже в Zoom или другой программе для видеоконференцсвязи появляется новый источник сигнала

OBS-Camera.Идентификация по видео — ненадёжный вариант

Главная проблема заключается не в самом факте разработки доступных опенсорсных инструментов, которыми легко пользоваться. Это было вполне предсказуемо.

На самом деле корень проблемы в чрезмерном доверии к видеосвязи. Недавнее исследование Deepfakes vs Biometric KYC Verification от компании Sensity выявило уязвимости для спуфинга в десятках современных систем проверки личности по видеосвязи (KYC).

Вышеупомянутый DOT разработан именно для тестирования таких систем, чтобы выявить уязвимости в процессе проверки ID. В рамках эксперимента разработчики проверили пять систем KYC. Инструмент обманул пять тестов active liveness (проверка живого человека в кадре), пять тестов на проверку ID, а также четыре из пяти тестов passive liveness и четыре системы полной проверки личности (KYC).

Различные научные группы последовательно предлагают методы детектирования дипфейков на видео. Вот задача для анализа с конкурса Deepfake Detection Challenge:

Но эти методы распознавания включаются в обучение моделей для генерации дипфейков следующего поколения, так что подобный подход нельзя считать кардинальным решением проблемы.

Спуфинг видеосвязи уже используют в реальных преступлениях. Предположительно, с помощью сложных дипфейков в 2021 году была взломана государственная система распознавания лиц в Китае. Украденные биометрические данные использовались для подписи поддельных налоговых деклараций на 500 млн юаней ($76,2 млн).

Недавно в США тоже зарегистрирован случай социальной инженерии с использованием высокотехнологичных дипфейков.

Авторы отчёта Deepfakes vs Biometric KYC Verification оставляют открытым вопрос, насколько распространён этот метод атаки и насколько легко использовать дипфейки в режиме реального времени. Но следует чётко понимать, что сейчас спуфинг видеосвязи — элементарный приём, доступный каждому.

Чтобы гарантировать аутентичность картинки, вероятно, придётся внедрить дополнительные меры защиты. Например, это может быть цифровая подпись фреймов сертификатом конкретной видеокамеры.