Современная волна ИИ хайпа началась с вполне конкретного события: победы ИИ над чемпионом мира в игре в Го. Это вызвало шквал интереса к обучению с подкреплением и привело к запуску работ над созданием ИИ для других более сложных игр (Starcraft, Dota и.т.п.). Однако, с появлением трансформеров, фокус сместился на генеративные модели. Каждый месяц выходит новая модель вроде ChatGPT, поражающая своими возможностями и собирает на себе всё внимание. Однако, и в этих условиях, исследования ИИ с помощью игр продолжается. Каждая новая игра это упрощенная среда, все более сложная и близкая к реальному миру (обычно). В этой статье сделан обзор успехов и прогресса в этом направлении в 2022 году. С важным исключением, сюда включены только работы на настоящих играх (настольных и видеоиграх), но не на играх, созданных специально для тестирования ИИ агентов.

Игры в которые играют теперь не только люди

Gran turismo sport

О чем игра: Гоночки с огромным количеством параметров влияющих на движение автомобилей по гоночным трассам.

Результаты: Единственный в этом году результат с демонстрацией абсолютного превосходства. Агент Sophy обгоняет киберспортсменов как в индивидуальных, так и в командных гонках в Gran turismo sport. Последнее требовало учитывать не только правила гонки, но и поведение противников и товарищей по команде. Аналог матча с чемпионом мира можно посмотреть здесь. Сейчас компания работает над внедрением Sophy в последнюю часть серии Gran turismo 7.

Используемые методы: Незначительно модифицированная версия известного RL алгоритма Soft Actor-Critic и тысяча PS4 для обучения.

Stratego

О чем игра: Настольная пошаговая стратегическая игра с неполной информацией и бесконечно огромным числом возможных позиций. Состоит из 2 этапов. Расстановки фигур и самого матча.

Результаты: Стратегическое мышление и способность непредсказуемо блефовать принесла алгоритму место в топ-3 лучших игроков на платформе для игры в Stratego. Посмотреть пример игры с человеком можно тут

Используемые методы: Созданный специально для этой задачи алгоритм Deepnash. В него входит обучение с подкреплением (тот же actor-critic), матчи с самим собой и специальный метод для приближения к равновесию Нэша, напоминающий те что использовались для обучения алгоритмов игре в Скотланд-ярд, а до этого в Покер.

Hanabi

О чем игра: Карточная игра на 4 игроков с необходимостью кооперации и специфической версией неполной информации (игрок не видит свои карты, а видит чужие).

Результаты: В отдельной работе в 2019 году Hanabi была объявлена в качестве следующего фронтира для ИИ. В этом году ресерчеры из Meta добились паритета в уровне игры с людьми экспертами и показали способность к эффективной кооперации с людьми

Используемые методы: Достаточно замороченный способ обучения включающий в себя имитационное обучение на датасете игр людей с сайта BoardGameArena, а потом обучение с подкреплением на играх с самим собой.

Diplomacy

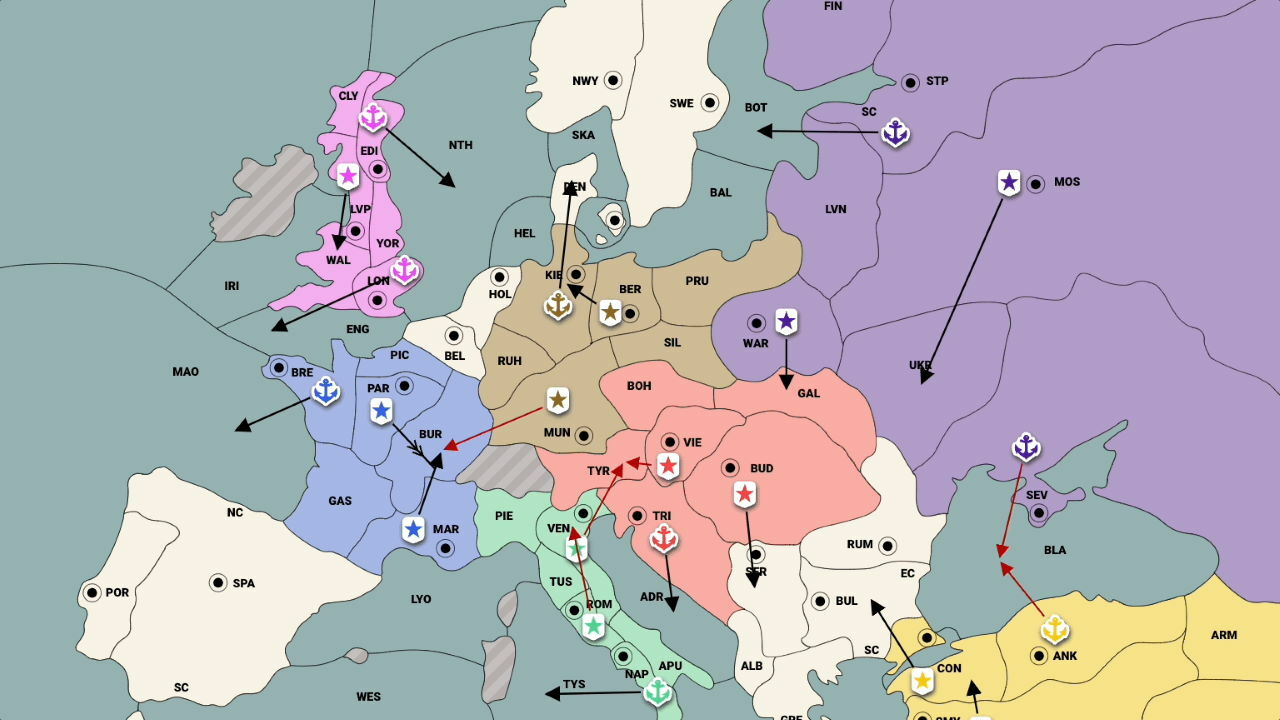

О чем игра: На карте Европы 20-го века века нужно принимать решения о том куда вторгнуться или переместить войска, кооперируясь и конфликтуя при этом с 7 другими игроками. Существует в двух версиях: с коммуникацией между игроками на каждом ходу и без коммуникации.

Результаты: Игра года по мнению AI исследователей в 2022 это Diplomacy. Наибольшего прогресса снова добилась Meta, реализовавшая почти непобедимого агента Diplodocus в ограниченном варианте Дипломатии - No press diplomacy. После этого компания создала Cicero, способного играть в полную версию игры, в которой необходимо вступать в коммуникации с другими игроками на естественном языке. Играет Cicero на уровне чуть выше среднего человеческого и противникам не удается отличить её от людей. Хорошее описание устройства Cicero представлено здесь, а вот тут можно посмотреть матч с экспертом, с комментариями.

Используемые методы: Имитационное обучение по играм людей в Дипломатию (включая диалоги, историю и состояние игры) и затем обучение с подкреплением для улучшения уровня игры. Для Cicero планируемые действия на карте с помощью языковой модели переводятся в сообщения в чате для людей

Minecraft

О чем игра: Это Minecraft, нужно крафтить вещи из кубов. Самая популярная из игр в которых были достигнуты значительные успехи в этом году

Результаты: OpenAI добилась создания агента, способного пройти долгий путь, полный целенаправленных действий (добыча дерева, крафтинг, копание земли и.т.д) для того чтобы в итоге найти Бриллиант. И сделать из него бриллиантовый топор. Нахождение бриллианта, это конечно не прохождение Minecraft, но значительное достижение, к этому специалисты шли много лет.

Используемые методы: Сначала нанятыми людьми было собрано 2000 часов видео игры в Minecraft с маппингом действий, то есть того что люди нажимали на клавиатуре выполняя те или иные действия. Потом имитационное обучение на датасете из 70000 часов видео. Затем обучение подкреплением с помощью незначительно модифицированного алгоритма Proximal Policy Optimization. Впоследствии также было проведено соревнование и выпущен новый датасет.

Бридж

О чем игра: Бридж популярная карточная игра. Одна из последних карточных игр в которые компьютеры не умели хорошо играть.

Результаты: Самый странный и даже подозрительный сетап. Вместо прямой игры с людьми, агент играл 80 партий с самым продвинутым на сегодняшний день скриптовым ботом для игры в Бридж. Люди (8 чемпионов по игре в Бридж) тоже играли с этим ботом. В итоге, агент выиграл больше матчей у бота чем чемпионы. Из этого делается вывод, что агент играет лучше людей, но вопросы остаются. С одной стороны, у этого события есть все знакомые признаки - 10 часов прямого эфира матчей (на французском), готовящаяся документалка и статьи в популярной прессе. С другой, не было выпущено научной статьи с описанием методов и не было игр с людьми напрямую, а автором является малоизвестный французский стартап NukkAI. Возможно вопросы снимет грядущий чемпионата по компьютерному бриджу в 2023 году.

Используемые методы: Ничего неизвестно, кроме общих описаний от разработчиков

Ты пытался

Не у всех есть безграничные вычислительные ресурсы как у фейсбука и гугла, чтоб создавать сверхразум для конкретных игр. Но люди пытаются. Вот 11 проектов которые в этом году многого добились, хоть и не достигли сверхчеловеческого уровня.

1) PerfectDou - ИИ для китайской карточной игры для трех игроков Dou dizhu (англ. Against the landlord) далеко не так совершенен, как подразумевает название. Он даже не пытается сравниваться людьми, но способен обыграть всех других ботов для этой игры. Зато теперь с ним можно сыграть здесь

2) В другой карточной игре Legends of Runeterra отметилась компания Riot games. Их агент научился играть на среднем уровне и потом его обучение было прекращено, чтобы с ним было интересно играть игрокам, а не все время терпеть от него поражение.

3) При этом такой вариант не смутил разработчиков steam версии карточной игры Dominion. Их Hard AI основанный на идеях AlphaZero, почти непобедим даже для опытных игроков.

4) Для популярной настолки Колонизаторы, требующей кооперации и сложного менеджмента ресурсов, энтузиаст сделал агента, способного играть на уровне немного ниже среднего. Весь путь описан не хуже чем в академических работах.

5) Примерно того же результата в радикально другой игре Super Smash Bros (файтинге, где персонажи вселенной Марио сражаются друг с другом в смертельной битве) добился другой энтузиаст. Его агент может иногда побеждать скриптового бота или не умеющих играть людей. Он также подробно описал свой подход и записал 4 часа матчей агента на Twitch.

6) В пошаговой ролевой игре Nethack, в которой в прошлом году обучающиеся алгоритмы провалились, проиграв скриптовым ботам, Meta сделала новый датасет и улучшила прошлогодний лучший результат на 400 пунктов. Все равно хуже скриптовых ботов (и людей) и для прохождения этой сложной игры явно понадобиться новый подход.

7) Древнейшая настолка Royal Game of Ur, первые доски для которой были сделаны в древней Месопотамии 3000 до н.э. обзавелась своим RL агентом. Сама игра достаточно проста, но методы, используемые для ИИ настолько примитивны, что достигают минимальных результатов и пока неспособны соревноваться с людьми и скриптовыми алгоритмами.

8) Один из наиболее красочных агентов был создан в этом году для игры Rocket League (футбол на автомобилях огромными мячами). Уровень развития сложно оценить, до человеческого пока далеко, но многочасовые трансляции обучения можно смотреть на твиче.

9) Teamfight Tactics это видеоигра в появившемся всего 5 лет назад жанре auto chess. Проект по созданию минимально работающего агента для этой игры на основе MuZero появился совсем недавно. Описание достаточно туманное, но разработчик пообщал мне сделать видео с описанием на ютубе.

10) Ведётся разработка AI и для популярной дуэльной игры 7 Wonders: Duel. На данный момент реализованы разные подходы, в том числе imitation learning основанный на партиях людей сыгранных на онлайн платформах, а так же MCTS, AlphaGoZero и AlphaZero. Imitation learning агент без просчёта ходов имеет winrate около 30% на онлайн платформе 7wd.io. AlphaGoZero реализация играет на равных с опытными игроками, но пока нестабильна, порой допускает грубые ошибки. Проект находится в активной разработке

11) Наконец, мой персональный фаворит - ИИ агент для Elden ring у которого одна цель: победить Tree Sentinel в самом начале игры. Попытки сделать это снова и снова и снова, и снова можно наблюдать на твиче. Действия агента не кажутся особо разумными. Но можешь ли ТЫ победить Tree Sentinel не прокаченным персонажем? То-то же!

Подводим итог

Итак, каких то крупных прорывов с появлением агентов, способных прямо сейчас играть во все игры не появилось. Но инкрементальный прогресс приводит к тому, что скоро почти в каждой популярной игре можно будет поиграть с сверхчеловеческим оппонентом. Ведущие исследователи занимаются играми с неполной информацией и с необходимостью кооперации с людьми. Но разработанные ими методы пока не обобщаются на все игры такого типа. Так как AlphaZero обобщался на все игры с нулевой суммой и с полной информацией, а не только умел играть в Го.

Самым крупным достижением наверняка можно назвать агента Cicero для Дипломатии. Он в чем то похож на ChatGPT в том плане что Cicero это RL модель к которой приделана языковая модель, а ChatGPT это языковая модель к которой приделан RL. Скорее всего, будущее за большей интеграцией этих двух подходов. И это даже не моя идея, а Андрея Карпати. А он как то давно сделал сверхчеловеческого агента для Pong, знает о чем говорит.