Заказчиком этого проекта стал московский институт МФТИ. Выполнять для легендарного Физтеха большой и ответственный проект очень почетно, но и ответственность ложится серьезная.

Работы предстояли в дата-центре института, расположенном в Долгопрудном Московской области. Это сердце всех информационных систем МФТИ. Здесь собраны вычислительные мощности, которые используют как для научной и учебной работы (моделирование, расчеты) так для служебных целей (почта и коммуникации, бухгалтерия и т.п.)

Со временем мощностей ЦОДа стало не хватать. Кроме того, многие факультеты и кафедры имели собственные серверы, которые поддерживали своими силами. Руководство института приняло решение консолидировать вычислительные мощности в модернизированном и расширенном дата-центре, рассчитанном на установку более мощного (а значит более энергоемкого) IT-оборудования. Новый ЦОД должен был соответствовать современными требованиями с точки зрения мощности, надежности и отказоустойчивости.

Наша задача состояла в подготовке систем, относящихся к инженерной инфраструктуре, а именно:

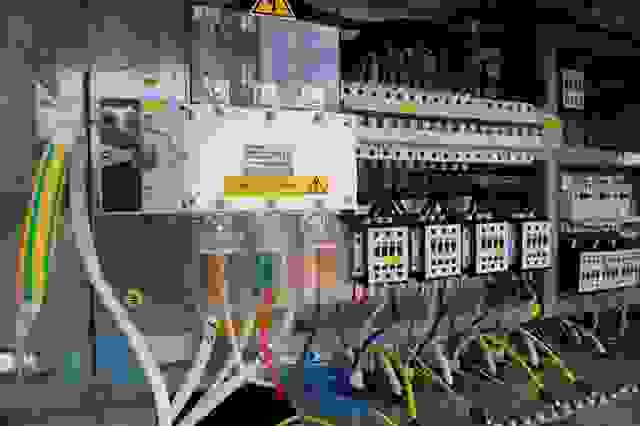

• система распределения электропитания и бесперебойного электроснабжения;

• система кондиционирования;

• структурированная кабельная система;

• автоматизированная система диспетчерского управления всем этим хозяйством.

Техническое решение, предложенное нами, было признано лучшим среди других предложений, конкурс мы выиграли, можно было приступать к делу.

Начать пришлось с демонтажа и утилизации устаревшего оборудования, а это была практически вся старая система кондиционирования, электроснабжения и СКС. Из старого оборудования осталось только четыре кондиционера.

На крыше здания мы демонтировали две градирни, которые использовались для охлаждения ранее. Затем спроектировали, изготовили и установили на крыше металлоконструкции для установки новых внешних блоков системы охлаждения.

Далее подготовили к монтажу нового оборудования сам машинный зал и помещение для размещения распределительного узла (баки, насосы, теплообменники).

Для защиты оборудования от протечек при авариях водопровода и отопления в расположенных выше помещениях мы предусмотрели систему отвода воды из пространства над натяжным потолком по уклону плоскости натяжного потолка и последующий дренаж.

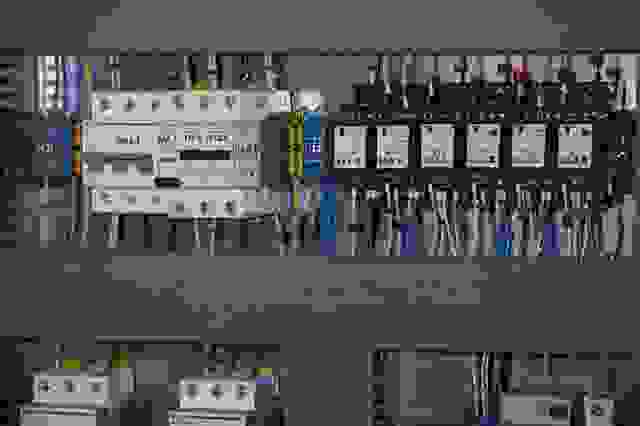

Новый ЦОД рассчитан на потребление 180 кВт. Электропитание вычислительного и инженерного оборудования выполнено раздельно. На вычислительное оборудование (16 серверных шкафов и 2 коммутационных шкафов) приходится 141 кВт.

Для вычислительного оборудования мы реализовали уровень резервирования электропитания 2N (N + N). Здесь задействовано два модульных ИБП производства APC by Schneider Electric Symmetra PX 160 кВт.

Уровень резервирования для инженерного обеспечения (здесь основные потребители это циркуляционные насосы чиллеров и насосы водяного контура) – N+1. Электропитание осуществляется с помощью модульного ИБП производства APC by Schneider Electric MGE Galaxy 3500 20 кВт.

Время автономной работы источников бесперебойного питания при пропадании питающего напряжения составляет не менее 15 минут, этого с запасом хватает для запуска и выхода резервного источника питания на нагрузку.

Вся система бесперебойного электроснабжения спроектирована так, чтобы была возможность обслуживания и модернизации на ходу, без вывода всего комплекса из работы.

Температура воздуха 20-25°C, относительная влажность 40-65% — вот такой микроклимат нужно постоянно поддерживать в машинном зале и в помещении ИБП. Это нужно для защиты оборудования не только от перегрева, но и выхода из строя по причине выпадения конденсата или статического разряда.

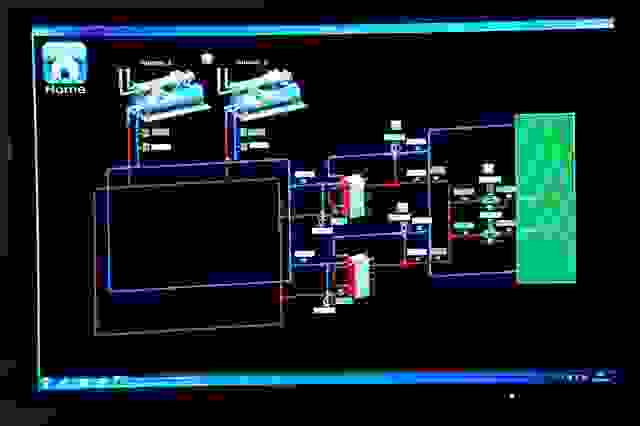

Новую систему кондиционирования решили делать двухконтурной. В качестве теплоносителя внутреннего контура используется вода, а во внешнем контуре циркулирует 40%-ный раствор этиленгликоля. Такая схема исключает две неприятности: замерзание теплоносителя в трубопроводах снаружи здания и использование опасного для здоровья этиленгликоля в пределах машинного зала.

Начнем с внутреннего контура. Он состоит из двух подсистем:

• система межрядного кондиционирования для серверных стоек,

• система кондиционирования помещения ИБП.

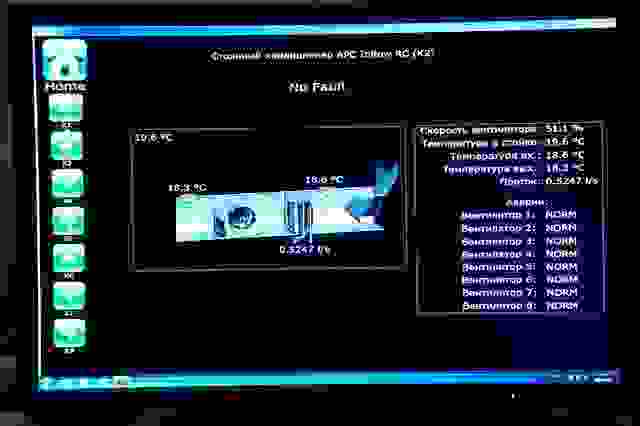

В машинном зале установлено два ряда из 18 серверных стоек, обращенных спиной друг к другу. Между ними мы построили «горячий коридор», изолированный от внешней среды дверями и панелями. Установленные в «горячем коридоре» 8 межрядных кондиционеров APC InRow RС забирают тепло из этого коридора и выдувают охлажденный воздух во внешнее помещение, за пределы коридора. Здесь он под статическим давлением подаётся к лицевой стороне стоек и снова прогоняется сквозь стойки.

В помещении ИБП было установлено два канальных фанкойла Carrier, которые подают холодный воздух и забирают горячий. Третий фанкойл находится в резерве.

Внешний контур системы кондиционирования обеспечивает холодильная машина — чиллер. Два чиллера производства компании Uniflair by Schneider Electric (один основной, другой резервный) холодопроизводительностью 185 кВт каждый, были скомплектованны изготовителем специально для данного проекта и установлены на крыше на специально подготовленных металлоконструкциях.

При температуре воздуха +5 ̊С и ниже чиллеры переходят в режим свободного охлаждения (free cooling): теплоноситель охлаждается за счет наружного воздуха, что снижает потребление электроэнергии.

Для обеспечения работы кондиционеров при низких температурах предусмотрены зимний пуск и обогрев дренажных отверстий при сливе конденсата за пределы здания.

Установлены устройства дегазации гидравлического контура. Запорная арматура установлена во всех местах, где предполагается гидравлическое отключение компонентов системы от сети для обслуживания и ремонта.

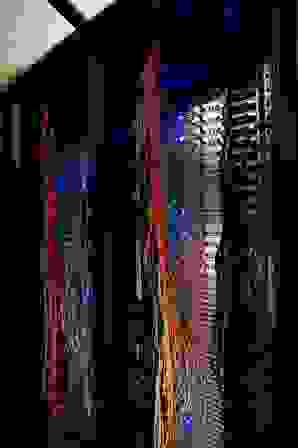

Под вновь устанавливаемые шкафы была создана новая структурированная кабельная система для передачи цифровых и аналоговых данных, состоящая из медной и оптической частей. Ее архитектура и параметры производительности соответствуют ряду международных стандартов ANSI и российского ГОСТ Р 53346-2008.

Медная подсистема построена на кабелях F/FTP категории 6A. В каждый серверный шкаф установлено по одной 24-портовой патч-панели с органайзерами, от каждого нового шкафа до каждого кроссового шкафа проведено по 24 кабеля F/FTP. Подсистема выполнена на базе модульной кабельной системы компании Huber+Suhner серии LiSA Solutions, продажи которой начались только в конце 2013 года. Это первая инсталляция системы в России!

Оптическая подсистема. Каждый новый шкаф соединен с главными оптическими кроссами с помощью двух претерминированных 12-волоконных многомодовых кабелей. В каждый новый шкаф установлена оптическая кассета. Оптоволоконное оборудование – также производства компании Huber+Suhner.

Система предназначена для рабочего места оператора. Позволяет вести мониторинг инженерных систем и дистанционно управлять ими в реальном времени. Имеет возможности для предупреждение персонала в случае аварийных ситуаций (например, протечек), ведет архив технологической информации и позволяет формировать отчеты. Система выполнена на модульных контроллерах компании Delta Controls и имеет трехуровневую архитектуру.

Датчики и исполнительные механизмы образуют нижний уровень системы. Здесь происходит сбор первичной информации с датчиков (температура, давление, расход, электрические параметры) и непосредственное управление оборудованием (клапаны, задвижки, реле).

На среднем уровне работают контроллеры, принимающие информацию с нижнего уровня, передающие ее на верхний уровень. Также контроллеры формируют управляющий сигнал для исполнительных механизмов в соответствии с заложенной программой.

Верхний уровень системы отвечает за конечную обработку данных и взаимодействие с пользователями. На этом уровне происходит агрегация и обработка всех данных, регистрация всех событий в системе, в том числе и действий пользователей. Верхний уровень включает серверное оборудование и программное обеспечение для опроса, хранения и визуализации данных (SCADA). Пользовательский интерфейс показывает параметры оборудования и средств управления ими в наглядной, интуитивно-понятной форме. Система визуализации организована с помощью программного обеспечения ORCAview.

Мы взяли на себя обязательства по пятилетнему гарантийному и сервисному обслуживанию. Причем договор касается не только нового оборудования, установленного в рамках проекта, но и четырех имевшихся у заказчика ранее кондиционеров APC.

Регламент гарантийного обслуживания включает выезд сервисного инженера для диагностики, поставку комплектующих и материалов и выполнение ремонтно-восстановительных работ. Сервисное обслуживание включает проведение не реже чем два раза в год планово-профилактических работ, включая необходимые комплектующие и расходные материалы.

Параллельно с работами по проектированию, поставке оборудования и монтажу, шла разработка подробной документации, составленной в соответствии с требованиями ГОСТа. Здесь была подробно описана система, правила и нормы ее эксплуатации.

Среди подготовленных документов была и «Программа и методика испытаний», на основании которой прошли тестовые испытания системы. Проверка прошла в условиях, максимально приближенных к боевым. Например, для испытаний системы охлаждения в отсутствие реальных серверов, в машинный зал привезли тепловую пушку. Все испытания прошли успешно и позволили протестировать работоспособность всех подсистем и убедиться в их полном соответствии требованиям.

После передачи ЦОДа заказчик заполнил его серверным, коммуникационным и другим необходимым оборудованием и запустил в промышленную эксплуатацию. Работа в реальных условиях показала, что ЦОД отвечает всем необходимым требованиям с точки зрения мощности, надежности и отказоустойчивости.

Лучшие энергосберегающие технологии, использованные в проекте, обеспечивают высокую энергоэффективность ЦОДа:

• создание изолированного «горячего» коридора — самая эффективная система охлаждения серверного оборудования из всех известных по соотношению цена/качество.

• система охлаждения на чиллерах Uniflair by Schneider Electric с функцией фрикулинга позволяет экономить до 30% годового энергопотребления.

По предварительной оценке показатель Power Usage Effectiveness (PUE) дата-центра МФТИ по итогам модернизации составляет 1.5, что свидетельствует о высоком уровне энергоэффективности площадки.

ЦОД МФТИ соответствует уровню надежности (TIER 3) по международному стандарту TIA-942 на инфраструктуру Центров Обработки Данных, а показатель бесперебойной работы составляет 99,982%.

Softline team

Работы предстояли в дата-центре института, расположенном в Долгопрудном Московской области. Это сердце всех информационных систем МФТИ. Здесь собраны вычислительные мощности, которые используют как для научной и учебной работы (моделирование, расчеты) так для служебных целей (почта и коммуникации, бухгалтерия и т.п.)

Объект

Со временем мощностей ЦОДа стало не хватать. Кроме того, многие факультеты и кафедры имели собственные серверы, которые поддерживали своими силами. Руководство института приняло решение консолидировать вычислительные мощности в модернизированном и расширенном дата-центре, рассчитанном на установку более мощного (а значит более энергоемкого) IT-оборудования. Новый ЦОД должен был соответствовать современными требованиями с точки зрения мощности, надежности и отказоустойчивости.

Наша задача состояла в подготовке систем, относящихся к инженерной инфраструктуре, а именно:

• система распределения электропитания и бесперебойного электроснабжения;

• система кондиционирования;

• структурированная кабельная система;

• автоматизированная система диспетчерского управления всем этим хозяйством.

Техническое решение, предложенное нами, было признано лучшим среди других предложений, конкурс мы выиграли, можно было приступать к делу.

Общестроительная подготовка

Начать пришлось с демонтажа и утилизации устаревшего оборудования, а это была практически вся старая система кондиционирования, электроснабжения и СКС. Из старого оборудования осталось только четыре кондиционера.

На крыше здания мы демонтировали две градирни, которые использовались для охлаждения ранее. Затем спроектировали, изготовили и установили на крыше металлоконструкции для установки новых внешних блоков системы охлаждения.

Далее подготовили к монтажу нового оборудования сам машинный зал и помещение для размещения распределительного узла (баки, насосы, теплообменники).

Для защиты оборудования от протечек при авариях водопровода и отопления в расположенных выше помещениях мы предусмотрели систему отвода воды из пространства над натяжным потолком по уклону плоскости натяжного потолка и последующий дренаж.

Бесперебойное электроснабжение и распределение электропитания

Новый ЦОД рассчитан на потребление 180 кВт. Электропитание вычислительного и инженерного оборудования выполнено раздельно. На вычислительное оборудование (16 серверных шкафов и 2 коммутационных шкафов) приходится 141 кВт.

Для вычислительного оборудования мы реализовали уровень резервирования электропитания 2N (N + N). Здесь задействовано два модульных ИБП производства APC by Schneider Electric Symmetra PX 160 кВт.

Уровень резервирования для инженерного обеспечения (здесь основные потребители это циркуляционные насосы чиллеров и насосы водяного контура) – N+1. Электропитание осуществляется с помощью модульного ИБП производства APC by Schneider Electric MGE Galaxy 3500 20 кВт.

Время автономной работы источников бесперебойного питания при пропадании питающего напряжения составляет не менее 15 минут, этого с запасом хватает для запуска и выхода резервного источника питания на нагрузку.

Вся система бесперебойного электроснабжения спроектирована так, чтобы была возможность обслуживания и модернизации на ходу, без вывода всего комплекса из работы.

Кондиционирование и вентиляция

Температура воздуха 20-25°C, относительная влажность 40-65% — вот такой микроклимат нужно постоянно поддерживать в машинном зале и в помещении ИБП. Это нужно для защиты оборудования не только от перегрева, но и выхода из строя по причине выпадения конденсата или статического разряда.

Новую систему кондиционирования решили делать двухконтурной. В качестве теплоносителя внутреннего контура используется вода, а во внешнем контуре циркулирует 40%-ный раствор этиленгликоля. Такая схема исключает две неприятности: замерзание теплоносителя в трубопроводах снаружи здания и использование опасного для здоровья этиленгликоля в пределах машинного зала.

Начнем с внутреннего контура. Он состоит из двух подсистем:

• система межрядного кондиционирования для серверных стоек,

• система кондиционирования помещения ИБП.

В машинном зале установлено два ряда из 18 серверных стоек, обращенных спиной друг к другу. Между ними мы построили «горячий коридор», изолированный от внешней среды дверями и панелями. Установленные в «горячем коридоре» 8 межрядных кондиционеров APC InRow RС забирают тепло из этого коридора и выдувают охлажденный воздух во внешнее помещение, за пределы коридора. Здесь он под статическим давлением подаётся к лицевой стороне стоек и снова прогоняется сквозь стойки.

В помещении ИБП было установлено два канальных фанкойла Carrier, которые подают холодный воздух и забирают горячий. Третий фанкойл находится в резерве.

Внешний контур системы кондиционирования обеспечивает холодильная машина — чиллер. Два чиллера производства компании Uniflair by Schneider Electric (один основной, другой резервный) холодопроизводительностью 185 кВт каждый, были скомплектованны изготовителем специально для данного проекта и установлены на крыше на специально подготовленных металлоконструкциях.

При температуре воздуха +5 ̊С и ниже чиллеры переходят в режим свободного охлаждения (free cooling): теплоноситель охлаждается за счет наружного воздуха, что снижает потребление электроэнергии.

Для обеспечения работы кондиционеров при низких температурах предусмотрены зимний пуск и обогрев дренажных отверстий при сливе конденсата за пределы здания.

Установлены устройства дегазации гидравлического контура. Запорная арматура установлена во всех местах, где предполагается гидравлическое отключение компонентов системы от сети для обслуживания и ремонта.

Структурированная кабельная система

Под вновь устанавливаемые шкафы была создана новая структурированная кабельная система для передачи цифровых и аналоговых данных, состоящая из медной и оптической частей. Ее архитектура и параметры производительности соответствуют ряду международных стандартов ANSI и российского ГОСТ Р 53346-2008.

Медная подсистема построена на кабелях F/FTP категории 6A. В каждый серверный шкаф установлено по одной 24-портовой патч-панели с органайзерами, от каждого нового шкафа до каждого кроссового шкафа проведено по 24 кабеля F/FTP. Подсистема выполнена на базе модульной кабельной системы компании Huber+Suhner серии LiSA Solutions, продажи которой начались только в конце 2013 года. Это первая инсталляция системы в России!

Оптическая подсистема. Каждый новый шкаф соединен с главными оптическими кроссами с помощью двух претерминированных 12-волоконных многомодовых кабелей. В каждый новый шкаф установлена оптическая кассета. Оптоволоконное оборудование – также производства компании Huber+Suhner.

Автоматизированная система диспетчерского управления

Система предназначена для рабочего места оператора. Позволяет вести мониторинг инженерных систем и дистанционно управлять ими в реальном времени. Имеет возможности для предупреждение персонала в случае аварийных ситуаций (например, протечек), ведет архив технологической информации и позволяет формировать отчеты. Система выполнена на модульных контроллерах компании Delta Controls и имеет трехуровневую архитектуру.

Датчики и исполнительные механизмы образуют нижний уровень системы. Здесь происходит сбор первичной информации с датчиков (температура, давление, расход, электрические параметры) и непосредственное управление оборудованием (клапаны, задвижки, реле).

На среднем уровне работают контроллеры, принимающие информацию с нижнего уровня, передающие ее на верхний уровень. Также контроллеры формируют управляющий сигнал для исполнительных механизмов в соответствии с заложенной программой.

Верхний уровень системы отвечает за конечную обработку данных и взаимодействие с пользователями. На этом уровне происходит агрегация и обработка всех данных, регистрация всех событий в системе, в том числе и действий пользователей. Верхний уровень включает серверное оборудование и программное обеспечение для опроса, хранения и визуализации данных (SCADA). Пользовательский интерфейс показывает параметры оборудования и средств управления ими в наглядной, интуитивно-понятной форме. Система визуализации организована с помощью программного обеспечения ORCAview.

Гарантийное и сервисное обслуживание

Мы взяли на себя обязательства по пятилетнему гарантийному и сервисному обслуживанию. Причем договор касается не только нового оборудования, установленного в рамках проекта, но и четырех имевшихся у заказчика ранее кондиционеров APC.

Регламент гарантийного обслуживания включает выезд сервисного инженера для диагностики, поставку комплектующих и материалов и выполнение ремонтно-восстановительных работ. Сервисное обслуживание включает проведение не реже чем два раза в год планово-профилактических работ, включая необходимые комплектующие и расходные материалы.

Итоги и результаты

Параллельно с работами по проектированию, поставке оборудования и монтажу, шла разработка подробной документации, составленной в соответствии с требованиями ГОСТа. Здесь была подробно описана система, правила и нормы ее эксплуатации.

Среди подготовленных документов была и «Программа и методика испытаний», на основании которой прошли тестовые испытания системы. Проверка прошла в условиях, максимально приближенных к боевым. Например, для испытаний системы охлаждения в отсутствие реальных серверов, в машинный зал привезли тепловую пушку. Все испытания прошли успешно и позволили протестировать работоспособность всех подсистем и убедиться в их полном соответствии требованиям.

После передачи ЦОДа заказчик заполнил его серверным, коммуникационным и другим необходимым оборудованием и запустил в промышленную эксплуатацию. Работа в реальных условиях показала, что ЦОД отвечает всем необходимым требованиям с точки зрения мощности, надежности и отказоустойчивости.

Лучшие энергосберегающие технологии, использованные в проекте, обеспечивают высокую энергоэффективность ЦОДа:

• создание изолированного «горячего» коридора — самая эффективная система охлаждения серверного оборудования из всех известных по соотношению цена/качество.

• система охлаждения на чиллерах Uniflair by Schneider Electric с функцией фрикулинга позволяет экономить до 30% годового энергопотребления.

По предварительной оценке показатель Power Usage Effectiveness (PUE) дата-центра МФТИ по итогам модернизации составляет 1.5, что свидетельствует о высоком уровне энергоэффективности площадки.

ЦОД МФТИ соответствует уровню надежности (TIER 3) по международному стандарту TIA-942 на инфраструктуру Центров Обработки Данных, а показатель бесперебойной работы составляет 99,982%.

Softline team