Комментарии 64

Спасибо за интересную статью. Создается впечатление, что очень плотненькая конструкция и ее будет тяжело охлаждать. Производился ли расчет теплового режима, если да, то какие инструменты вы используете, если не секрет?

0

Да, конструкция конечно плотная. Моделирование по теплу для этой системы не делали, а в прошлом для этих целей обычно пользовались SolidWorks Flow Simulation.

Насчет охлаждения — сдували и больше, к тому же тут на нас работает то, что все источники тепла очень равномерно распределены по объему шасси. Пока верхняя оценка реального потребления где-то порядка 800Вт на 1U (1.6кВт на систему).

Насчет охлаждения — сдували и больше, к тому же тут на нас работает то, что все источники тепла очень равномерно распределены по объему шасси. Пока верхняя оценка реального потребления где-то порядка 800Вт на 1U (1.6кВт на систему).

0

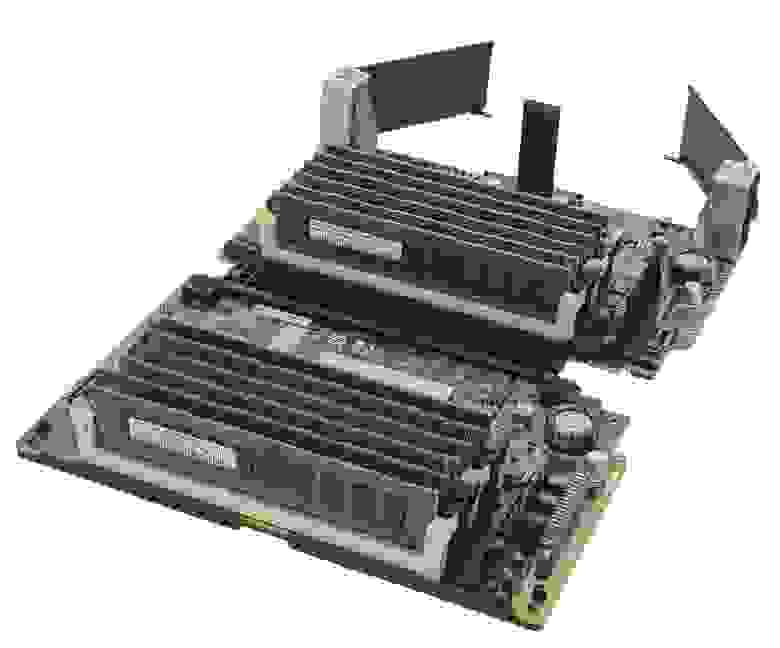

обслуживание моделировали? тк то что я вижу модули памяти висят на коннекторе

дальний блок памяти он не сгорит от перегрева?

блок PCIe — тоже не понятно что вы туда предлагаете ставить? 10G/40G/100G платы? а охлаждение то хватит на них? а питания? просто там ОЧЕНЬ узко и например FPGA или SSD там будут жарится — и да вы туда доп. питание заложили?

на плате есть возможность подключение дополнительных нагрузок(5v и 12v)?

Радиатор Процессора — продувка «поперек» термотрубок?(последняя пара будет работать хуже первой из-за другой «дельты») я бы повернул и сделал термотрубки разного диаметра ну или сильно увеличил «теплорассеиватель»прилегающий к процессору.

дальний блок памяти он не сгорит от перегрева?

блок PCIe — тоже не понятно что вы туда предлагаете ставить? 10G/40G/100G платы? а охлаждение то хватит на них? а питания? просто там ОЧЕНЬ узко и например FPGA или SSD там будут жарится — и да вы туда доп. питание заложили?

на плате есть возможность подключение дополнительных нагрузок(5v и 12v)?

Радиатор Процессора — продувка «поперек» термотрубок?(последняя пара будет работать хуже первой из-за другой «дельты») я бы повернул и сделал термотрубки разного диаметра ну или сильно увеличил «теплорассеиватель»прилегающий к процессору.

+1

Модули не висят на коннекторах, у них есть опора на дно полки (сразу же скажу, что дно провисать не будет — есть силовые элементы к которым оно крепится). От перегрева ничего не сгорит, хотя конечно дальний блок памяти действительно будет иметь режим гораздо хуже, чем передний.

В PCIe предполагаются адаптеры, ограниченные 25Вт мощности — сетевые контроллеры, SAS HBA/RAID или наш собственный адаптер для вывода PCIe через кабель (про него наверное отдельно напишем статью вскорости, там много интересных заморочек).

Нет, плата не предполагает подключение дополнительных нагрузок — сервер рассчитан на вполне определенный спектр применений, и GPU туда ставить никто не будет конечно же.

Для радиатора такое расположение, как на иллюстрации, является штатным, более того, на 90 градусов его разворачивать просто нельзя — боковые поверхности у него закрыты.

В PCIe предполагаются адаптеры, ограниченные 25Вт мощности — сетевые контроллеры, SAS HBA/RAID или наш собственный адаптер для вывода PCIe через кабель (про него наверное отдельно напишем статью вскорости, там много интересных заморочек).

Нет, плата не предполагает подключение дополнительных нагрузок — сервер рассчитан на вполне определенный спектр применений, и GPU туда ставить никто не будет конечно же.

Для радиатора такое расположение, как на иллюстрации, является штатным, более того, на 90 градусов его разворачивать просто нельзя — боковые поверхности у него закрыты.

+1

в этот сервак так и просятся FPGA типа таких http://www.nallatech.com/solutions/fpga-cards/

да и сетевки и RAID сейчас ОЧЕНЬ не плохо греются

да и сетевки и RAID сейчас ОЧЕНЬ не плохо греются

0

Карты на FPGA можно ставить, просто надо тесты проводить, и, возможно, придется ставить на них пассивные радиаторы двойной высоты (занимая тем самым одной картой два слота). Встроенные в полку вентиляторы позволяют обеспечить приличный продув, мы надеемся что не потребуется разгонять их на 100% (шумно очень будет).

0

не свосем правильное предложение, но что в нем есть:

1. разделить пару блоков питания и разнести на разные стороны сервера

2. сместить «задний» блок памяти к середине сервера

3. разделить блок PCIe на два блока по три слоат и поставить посторонам от блока памяти

просто вот мне так кажется что с теплом будет у вас проблема… просто представляю эту гирлянду из проводов состороны PCI-e — даже при ОЧЕНЬ аккуратном монтаже продувка сильно осложнится.

может и наоборот стоит сделать PCI-e в середину им не так критично — память «побокам»…

1. разделить пару блоков питания и разнести на разные стороны сервера

2. сместить «задний» блок памяти к середине сервера

3. разделить блок PCIe на два блока по три слоат и поставить посторонам от блока памяти

просто вот мне так кажется что с теплом будет у вас проблема… просто представляю эту гирлянду из проводов состороны PCI-e — даже при ОЧЕНЬ аккуратном монтаже продувка сильно осложнится.

может и наоборот стоит сделать PCI-e в середину им не так критично — память «побокам»…

0

На самом деле такой вариант можно сразу же отклонить по одной причине — блоки питания в шасси лежат горизонтально и ширина каждого меньше чем удвоенная высота, то есть с точки зрения использования объема разделять их и ставить вертикально по сторонам шасси не имеет смысла (если даже не брать все остальные неприятности которые это вызовет).

Кстати, а что за гирлянда из проводов, пардон?

Кстати, а что за гирлянда из проводов, пардон?

0

Контроллер(плату) SAS HBA/RAID свою делать будите или готовое решение?

0

Свою (если мы про внутренние диски) — готовое там сложно уложить. Но приоритет за NVMe, так что SAS чуть позже.

0

Под «Закон Яровой» делаете? ;-)

-3

Это же сколько времени память тестировать, даже если она ECC? Сколько «взлетает» сервер?

0

Разминулись с Вами в комментариях на несколько минут — чуть выше написал только что. In-Memory вычисления и базы данных — очень актуальная и полезная тема. :) На Хабре про них довольно много писали.

+1

Долго :) А еще можно прикинуть например сколько база такого объема будет подниматься в память — и сразу становится понятно, почему мы так активно за NVMe. Есть такие базы, у людей есть реальная потребность. Можно например посмотреть презентации с In-Memory Computing Summit этого года.

0

И я так понимаю, что спрашивать о стоимости полностью нафаршированного оперативкой и SSD сервера будет неприлично? Ну порядок хотя бы намекните — чтобы пооблизываться, не покупать. :)

0

Мне кажется это должно стоить несколько килоденег в любой валюте, ибо такое количество SSD и оперативы дешевым не бывает.

0

Что бы освободить 6-й слот PCI вынесите всякий USBm BMC и прочие разъёмы на выносную планку (жестко закреплённую) позади заднего юлока памяти. Хоть поперёк. И да, прямо за пределы корпуса сервера.

Или же можно сдвинуть пару слотов память поглубже внутрь и разместить на ними но уже внутри корпуса.

Enjoy!

Или же можно сдвинуть пару слотов память поглубже внутрь и разместить на ними но уже внутри корпуса.

Enjoy!

0

Мы много вариантов рассматривали, предложенный плох тем, что во-первых мы будем иметь проблемы с подключением (для подключения этого райзера требуется приличное количество сигналов), и во-вторых — будет портить продуваемость всей конструкции.

На самом деле все проще — шестой слот нам ставить смысла нет поскольку даже с пятью все возможности процессоров по PCIe уже утилизированы на 100%. Для шестого слота пришлось бы ставить PCIe-свич где-то, чего совсем не хочется (да и места откровенно нет).

На самом деле все проще — шестой слот нам ставить смысла нет поскольку даже с пятью все возможности процессоров по PCIe уже утилизированы на 100%. Для шестого слота пришлось бы ставить PCIe-свич где-то, чего совсем не хочется (да и места откровенно нет).

0

использование слота не всегда означает его утилизацию на 100%

для нормальной отказоустойчивости все платы в PCI должны дублироваться.

итого вы можете разместить только 2 типа плат (FC + Ethernet, например) и 1 слот останется свободным.

а если вам нужно FC + Ethernet оптический + медный, то нужно уже 6 слотов.

для нормальной отказоустойчивости все платы в PCI должны дублироваться.

итого вы можете разместить только 2 типа плат (FC + Ethernet, например) и 1 слот останется свободным.

а если вам нужно FC + Ethernet оптический + медный, то нужно уже 6 слотов.

0

На самом деле для случая когда надо подключить много всего и с полным дублированием у нас тоже есть решение, про него позже будем рассказывать.

Ну и невозможно же объять необъятное, т.е. сделать совершенно универсальную машину. По PCIe мы сильно ограничены возможностями по бифуркации портов которые есть у процессоров — и там в общем-то небогато очень, или два порта x16 или один x16 + два x8 на каждый сокет.

Ну и невозможно же объять необъятное, т.е. сделать совершенно универсальную машину. По PCIe мы сильно ограничены возможностями по бифуркации портов которые есть у процессоров — и там в общем-то небогато очень, или два порта x16 или один x16 + два x8 на каждый сокет.

0

Дублирование обычно делают на уровне серверов а не плат в шасси. Это более рационально, так как вероятность падежа целого шасси намного выше отказа какой-то конкретной PCIe платы расширения (который как правило тоже приводит к падежу системы).

+1

Как будет реализована плата менеджмента? Интересует аппаратное и протокольное решение.

0

В текущий момент (я думаю вопрос же именно про BMC, а не про то, какой именно там GBE или USB контроллер будет стоять) там стоит AST2400 плюс FW стек на базе OpenBMC, который будем сильно допиливать (и коммитить в OpenBMC по мере реализации интересного функционала).

0

Да, речь о BMC.

Какие функции на него будут возложены, если не секрет?

Какие функции на него будут возложены, если не секрет?

0

Все достаточно стандартно для серверов — мониторинг всего и всея, менеджмент системы (управление питанием, системой охлаждения и т.п.), ведение логов, консольный доступ к системе.

Более детально мог бы подсказать мой коллега, но он в отпуске в ближайшие две недели.

Вас какие-то конкретные вещи интересуют? Думаю на конкретные вопросы будет проще ответить, чем в целом описывать весь функционал.

Более детально мог бы подсказать мой коллега, но он в отпуске в ближайшие две недели.

Вас какие-то конкретные вещи интересуют? Думаю на конкретные вопросы будет проще ответить, чем в целом описывать весь функционал.

0

Непонятно, какое отношение мы имеем к той теме :)

Есть целый ворох интерфейсов, и SMBUS/I2C в том числе. LPC вообще не используется. Для вычитывания данных из процессоров и буферов памяти используется шина FSI (IBM'овская проприетарщина).

Есть целый ворох интерфейсов, и SMBUS/I2C в том числе. LPC вообще не используется. Для вычитывания данных из процессоров и буферов памяти используется шина FSI (IBM'овская проприетарщина).

0

К той теме не имеете. Моя ошибка.

А зачем тогда LPC заводите? Если я не ошибаюсь, то в x16 вообще нет LPC.

А зачем тогда LPC заводите? Если я не ошибаюсь, то в x16 вообще нет LPC.

0

стерто

0

А, тут все просто. FSI аппартно не поддерживается AST2400, так что приходится делать конверсию FSI<->LPC в CPLD, размещенной на материнке. В стандартной распиновке PCIe слота вообще много чего нет, что нужно для менеджмента — поэтому мы используем x16 коннектор с нестандартной распиновкой, развернув его на 180 градусов и сдвинув на плате, чтобы не было соблазна воткнуть в него стандартную карту.

0

С какой итерации планируете запуститься в серию?

0

В текущий график три ревизии заложено.

0

Спасибо.

Следующая статья о чем будет?

Следующая статья о чем будет?

0

Надо бы по-хорошему собраться и описать все то безобразие, что мы делаем на базе PCI Express, но там сильно много, все никак времени выделить не получается, так что не знаю даже пока… Сильно часто писать все равно не получится, мы же просто про жизнь пишем, а в работе какие-то ощутимые подвижки происходят довольно медленно, объем работ большой.

0

Интересный способ организации модулей памяти применен в пятьсот восьмидесятых пролиантах. Там используются

картриджи

+2

Жаль что IBM не делает дескопные чипы.

Думаю интелу бы нес утёрли.

Ведь у них вроде уже вышел 9 чип (IBM POWER8)?

Думаю интелу бы нес утёрли.

Ведь у них вроде уже вышел 9 чип (IBM POWER8)?

0

Если не секрет, кто будет заниматься мануфактурингом и как прошел процесс согласования поставок IBM процессоров?

0

Сервер состоит из множества компонентов (шасси, шины питания, несколько типов плат, стандартные компоненты — блоки питания, вентиляторы и т.п.) — соответственно и контрактных производителей много. Даже разные платы будут делаться в разных местах (обусловлено ценой, нет смысла просить фабрику которая качественно делает материнские платы произвести примитив типа PDB или fan midplane). Сборка — в РФ.

С поставками процессоров в рамках OpenPOWER нет никаких проблем.

С поставками процессоров в рамках OpenPOWER нет никаких проблем.

0

С чем связан выбор именно такого поля действий — openPOWER, сборка в РФ и контрактники за пределами страны по всему миру? Как достигается бизнес-превосходство? Это что-то для внутреннего потребителя?

0

В РФ тяжело собирать сложные платы. Во-первых, сами PCB нужного качества у нас пока не делают за вменяемые деньги, во-вторых, никто не держит стоки тех компонентов что нам нужны, а это значит закупку под каждый заказ, в третьих — монтаж плат это не просто станок для установки компонентов и печка, это еще и тулинг для специфических компонентов, пайка в азотной среде и т.п. Это к вопросу почему пока не все делается у нас. Кстати, простые платы вполне может быть и здесь будем собирать.

Превосходство достигается техническими преимуществами решения, которые в свою очередь дают коммерческие преимущества перед аналогичными решениями.

Превосходство достигается техническими преимуществами решения, которые в свою очередь дают коммерческие преимущества перед аналогичными решениями.

+1

Что касается бизнеса, откуда ноги растут? Вы раньше занимались контрактной разработкой, а теперь хотите попробовать стать вендором? Мне очень нравится то, что вы пишете и как делаете. Есть ли шанс просто пересечься в Москве и поговорить? Стройте свое дело вокруг политики и желаю попасть вам под крыло влиятельной компании, если хотите продавать тут. На вашем пути груда бюрократии, несправедливости, которую если проигнорить, она затмит то, что собираетесь делать.

То, что описано здесь, очень дорого в малых партиях, скорее всего все завязано на серию от 1000 штук и выше. Было бы интересно узнать, какой уровень цен соответствует выпуску именно прототипа.

То, что описано здесь, очень дорого в малых партиях, скорее всего все завязано на серию от 1000 штук и выше. Было бы интересно узнать, какой уровень цен соответствует выпуску именно прототипа.

0

Мы среди прочих тем отдельно расскажем про компанию некоторое время спустя (ближайшие несколько недель многие ключевые сотрудники будут в разъездах, и писать будем менее регулярно, скорее всего). А чтобы это лучше соответствовало специфике Хабра, заодно расскажем и про приход в OpenPOWER, и придём к определению требований к серверу (с которых и начали эту статью). Тем более, что эти вопросы связаны между собой.

Насчёт возможности встретиться и поговорить — можно будет посмотреть где-то ближе к началу октября, когда упомянутый период разъездов будет позади. А Вы на решении каких задач специализируетесь?

Насчёт возможности встретиться и поговорить — можно будет посмотреть где-то ближе к началу октября, когда упомянутый период разъездов будет позади. А Вы на решении каких задач специализируетесь?

0

В своем вопросе я больше имел в виду, где вас можно увидеть физически, выставка, выступление — в этом плане.

Мы занимаемся робототехникой, но мои вопросы не связаны с нашей деятельностью. Мне было интересно понять, как у вас планируется организация продаж здесь, ведь судя по бизнес-плану, вы хотите как-то хитро решить задачу появления тут альтернативного серверного оборудования, которое будучи локализованным по сборке тут, будет дешевле в силу планируемого повышения пошлин. Если у вас нет политических тылов и вы хотите из R&D вендором победить с помощью технологий, особенно в этой стране, ваш ждет глубочайшее в жизни разочарование.

Мы занимаемся робототехникой, но мои вопросы не связаны с нашей деятельностью. Мне было интересно понять, как у вас планируется организация продаж здесь, ведь судя по бизнес-плану, вы хотите как-то хитро решить задачу появления тут альтернативного серверного оборудования, которое будучи локализованным по сборке тут, будет дешевле в силу планируемого повышения пошлин. Если у вас нет политических тылов и вы хотите из R&D вендором победить с помощью технологий, особенно в этой стране, ваш ждет глубочайшее в жизни разочарование.

0

Я упрощу остальным и дам сразу ссылку, откуда ноги растут:

www.ncc.ru

www.ncc.ru

0

Как в этой большой конструкции будет происходить соединение шасси и сигнальной «земли»?

0

Скорее всего также как и в любой другой компьютерной технике — монтажными винтами и рамками плат расширения.

0

Есть две религии. Первая говорит соединять шасси только с PE и нигде гальванически не соединять с низковольтным питанием внутри. Вторая же за обратное — соединять с сигнальной землей везде, где только можно. Мы адепты второго пути — начиная с PDB везде где только можно шасси соединяется с сигнальной землей, в основном конечно через винты и пэды на платах. Соединение с PE реализуется естественным образом через контакт корпусов источников питания с корпусом.

0

-

0

Зарегистрируйтесь на Хабре, чтобы оставить комментарий

О процессе создания сервера – от идеи к деталям