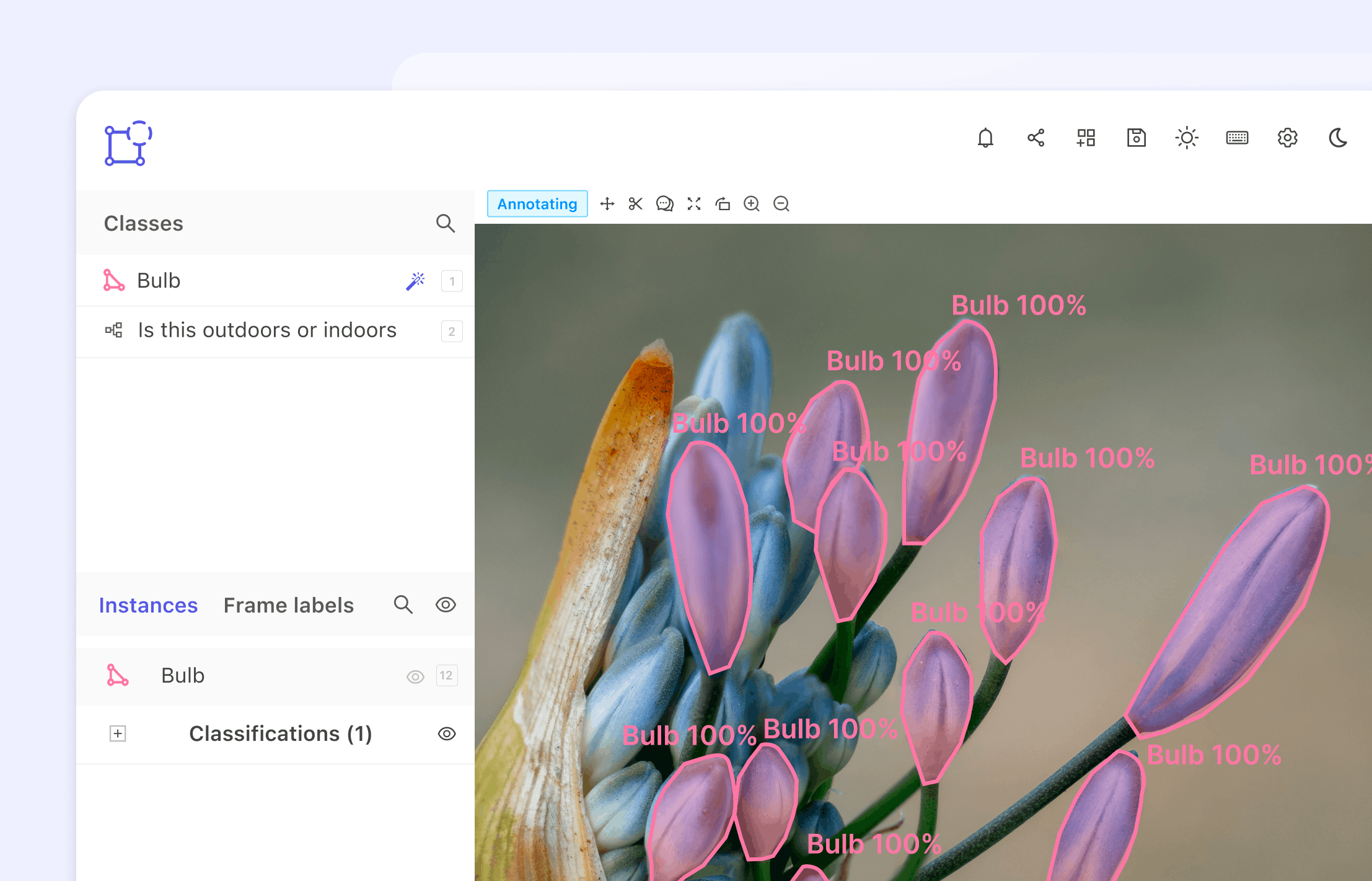

С развитием сферы искусственного интеллекта (AI) увеличивается и спрос на высококачественные инструменты аннотирования изображений. Аннотирование изображений — это процесс добавления в изображения метаданных, например, меток или тэгов, чтобы их было проще распознавать и выполнять по ним поиск машинам. Этот процесс критически важен для обучения моделей ИИ, чтобы они могли точно распознавать и классифицировать изображения.

При таком большом количестве имеющихся инструментов аннотирования изображений может быть сложно понять, какие из них лучше подходят под ваши потребности. Чтобы помочь вам сделать более обоснованное решение, мы составили список двенадцати лучших инструментов аннотирования изображений на 2023 год.

В этой статье мы обсудим критерии, использованные для оценки этих инструментов, их плюсы и минусы, а также сравним их между собой. Также мы приведём отзывы и рейтинги пользователей, варианты цен и тарифов и информацию об интеграции с другим ПО и платформами.