Представьте себе, что компания одновременно закупает буровую вышку и ручки с карандашами в офис. На все заявки вне зависимости от стоимости есть KPI на сроки рассмотрения, допустим, 15 дней. Процесс идёт по одному и тому же пути — 15 шагов, а в финале — согласование у главного бухгалтера. KPI соблюдаются, в отчётах всё ОК.

По идее, для ручек это должно происходить легче и быстрее, чем для буровой установки. В данном же случае получается, что для компании это одно и то же и процессы одинаковые. Но вот их цена в пересчёте на эффект разная. И нужно понять, как оптимизировать процессы, чтобы убрать лишние расходы.

То, что главный бухгалтер согласовывает закупку ручек, — дороговато для процесса, и его можно разгрузить. А в сложных закупках к тем пятнадцати уникальным шагам могут добавиться зацикливания, пересогласования, то есть получится намного больше повторных действий, чем при согласовании ручек. Возможно, каждый сотрудник участвует по два-три раза в этой крупной сделке. Это увеличивает нагрузку на процесс. А финальный KPI (15 дней) — тот же самый, только цена того, что происходит посередине, намного больше. Это как раз то, что с помощью обычной отчётности не выявляется.

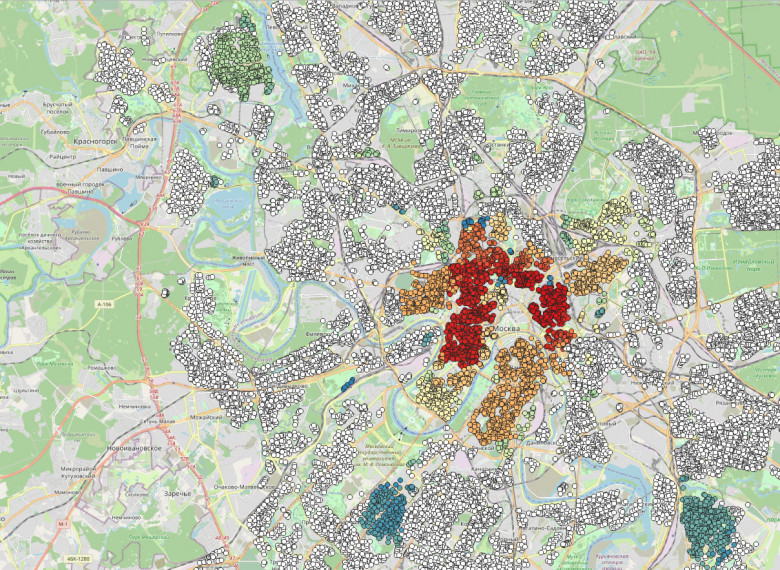

Получается, что для разного типа закупок стоимость процессов в пересчёте на эффект имеет очень сильное расхождение. При этом каждый процесс может где-то сбоить и зацикливаться.

Важно выявить, в каком месте это происходит и какую на этом можно получить экономию.

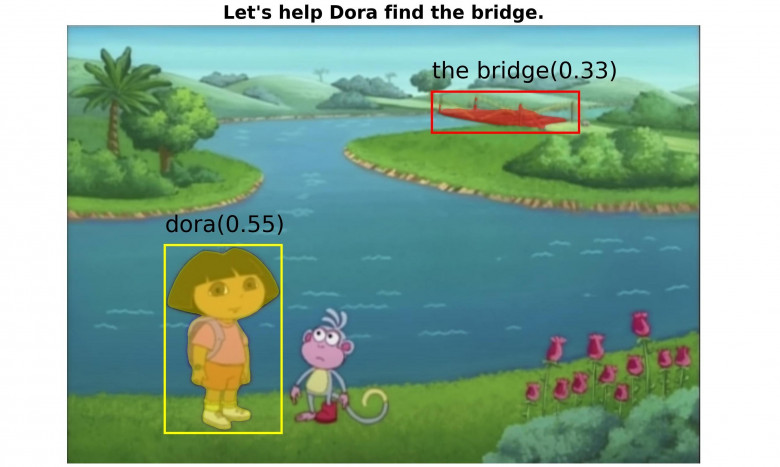

Process Mining помогает очень быстро увидеть взаимосвязь между событиями и показать, между какими этапами происходит зависание. В большинстве случаев в результате получается весьма ощутимый финансовый эффект.