Исследователи «Сколтеха» и Института искусственного интеллекта AIRI представили метод визуализации, способный делать сложные биомедицинские, финансовые и иные данные доступными человеку при сохранении многомерной структуры датасета, рассказали Хабру в пресс-службе «Сколтеха». Потеря топологии датасета не позволяет делать полезные выводы из представленных данных. Исследование опубликовано в числе проектов, представленных на мероприятии уровня A* — Международной конференции по обучению представлений ICLR 2023.

Аналитики компаний и учёные часто имеют дело с базами данных, в которых каждый элемент наделён признаками сразу во многих измерениях. Например, банк может использовать широкий круг показателей для описания поведения каждого клиента. Биологи могут сравнивать клетки разных типов с точки зрения того, насколько в них активен каждый из длинного списка генов. Данные по погоде тоже отличаются большим количеством измерений, потому что значения многих параметров фиксируются или предсказываются для множества моментов времени и точек пространства.

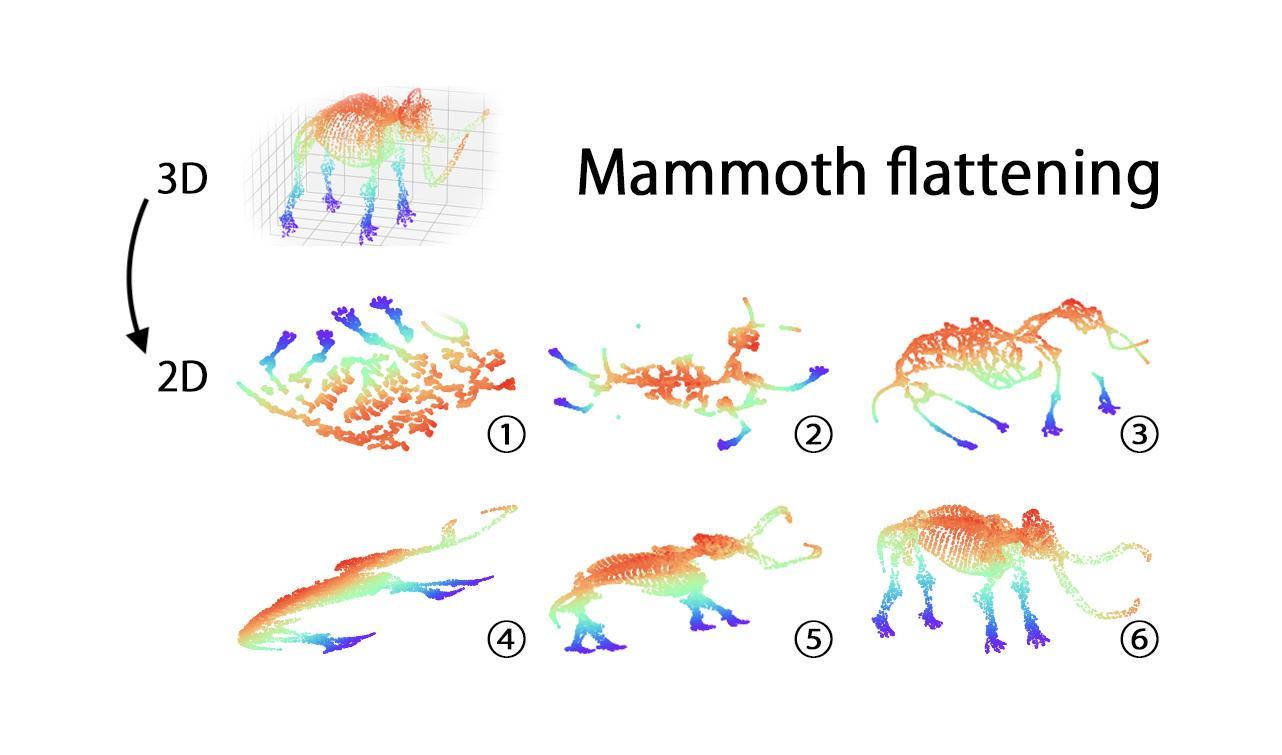

При этом людям непривычно мыслить в многомерном пространстве, и если не снизить размерность датасета и не получить его удобное двух- или трёхмерное представление, то может быть крайне трудно обнаружить в данных важные закономерности или выдвинуть на основе них продуктивную гипотезу.

«Если данные визуализировать, то они станут интуитивно доступными, осязаемыми, но мы необязательно увидим их реальную „форму“: ведь у датасета может быть структура большого масштаба, с кластерами, пустотами, петлями и т. п., и хотелось бы, чтобы всё это нашло отражение и в представлении пониженной размерности. Тогда физик увидит на визуализации сигналы отдельных частиц, маркетолог — разные группы потребителей, а климатолог — начало и конец интересующего его процесса. Наш метод снижения размерности отличается от аналогов как раз тем, что не жертвует глобальной структурой данных», — поясняет один из авторов исследования, выпускник Сколтеха и сотрудник AIRI Даниил Чернявский.

Существуют разные подходы к снижению размерности данных. Некоторые из них используют автоэнкодеры — нейросети, создающие представления данных в меньшем количестве измерений.

«Проблема в том, что большинство методов, в том числе с автоэнкодерами, работают, что называется, локально. То есть учитывают положение каждой точки относительно ближайших соседей, но в целом игнорируют крупномасштабную структуру датасета, — добавляет Чернявский. — Мы же снабдили автоэнкодер дополнительной новой функцией лосса, которая служит тому, чтобы свести к минимуму различие в топологии между исходным датасетом и его представлением сниженной размерности. Когда лосс равен нулю, „форма“ визуализации гарантированно совпадает с исходной».

Учёные с использованием нескольких метрик оценили, насколько хорошо предложенный метод воспроизводит топологию датасета по сравнению с другими популярными методами снижения размерности данных. Для проверки использовались датасеты разного наполнения и метрики, которые отражают сохранение взаимного расположения точек в целом, а не только тех, что находятся в непосредственной близости друг от друга. Метод авторов исследования повторил исходную «форму» данных лучше всего.

«Топологический анализ обретает всё большую популярность как инструмент исследования многомерных данных. Мы рассчитываем, что скоро предложенный нами и другие подобные методы станут признанным стандартом», — считает соавтор исследования профессор Евгений Бурнаев из Центра прикладного искусственного интеллекта «Сколтеха» и AIRI.