Комментарии 207

стандартный вопрос — а в чем его смысл дома сейчас?

+8

Не люблю ждать несколько дней когда перелив.

+3

А какая дисковая система дома не покрывается, скажем, гигабитом?

Эм… рейд на ссд?

Эм… рейд на ссд?

+3

Два отдельных винта выдают 2 гигабита с небольшим и это не покрывается гигабитом.

Рейд на ссд предположительно выдает скорости около 100 гигабитные, а это уже другой эшелон.

Рейд на ссд предположительно выдает скорости около 100 гигабитные, а это уже другой эшелон.

+3

Так покажите фотки с подтверждением (копирование на скорости 2Гбита или хотя-бы существенно больше гигабита), а не 150 фоток кабеля и коннекторов.

+3

+6

Спасибо.

Как раз думал о относительно бюджетном решении.

Собака — бассет хаунд?

Как раз думал о относительно бюджетном решении.

Собака — бассет хаунд?

+1

Обидно будет если выгорет во время грозы )))

-2

10-гигабитная сеть отлично подойдёт для вашей домашней 90-терабайтной файлопомойки. Можно будет смотреть фильмы и сериалы в прекрасном качестве на ваших семидесятидюймовых мониторах со полукиловаттным звуком, попивая кофе из вашей двухлитровой кружки вместе с миской поп-корна из вашей полуторакубовой микроволновки.

Прошу вас, расставьте запятые.

Прошу вас, расставьте запятые.

+77

А откуда вы знаете про телевизор?

+18

Да. С запятыми недобор, а с «самым вкусным — фотками» перебор.

+3

У вас ошибка — вместо «с миской» нужно «с тазом»

+1

Не грози южному централу, попивая кофе из двухлитровой кружки

+1

блин, мне срочно нужна 10гигабитная сетевуха О_о

0

Простите, я не понял, о какой технологии идет речь. Можно ссылки на плату, кабель и собсна саму технологию? (В душе мне кажется что это сундербольт, но как то размыто начато)

0

Вся статья в ссылках, на что конкретно вам нужно?

В линуксе линк определяется как оптический на деле медный по твинаксиалу, тундерболта тут нет.

В линуксе линк определяется как оптический на деле медный по твинаксиалу, тундерболта тут нет.

0

Обычный 10G Ethernet.

0

Спасибо, просто ни разу не интересовался темой глубже названия. Думал что он по обычному CAT5e идет так же

0

На самом деле, витуха — совсем необязательный атрибут Ethernet.

Варианты навскидку: витуха (куда ж без нее-то), оптика (тысячи разных вариантов, начиная от обычных линков на двух жилах с LC на концах и заканчивая сложными конфигурациями CWDM), коаксиал (ставим терминаторы и считаем длину кабеля!), Wi-Fi (это тоже Ethernet!), *DSL (и это тоже DSL!), всяческие радиорелейки и так далее.

Варианты навскидку: витуха (куда ж без нее-то), оптика (тысячи разных вариантов, начиная от обычных линков на двух жилах с LC на концах и заканчивая сложными конфигурациями CWDM), коаксиал (ставим терминаторы и считаем длину кабеля!), Wi-Fi (это тоже Ethernet!), *DSL (и это тоже DSL!), всяческие радиорелейки и так далее.

+1

Я не о том :-) Я думал, что британские ученые научились пускать по классической меди CAT5e 10G, а, оказывается, для этого еще нужно кардинально увеличивать помехозащищенность.

Я так понимаю, что стандарт мало где используется, и потому он непопулярен (вывод сделал лишь по тому, что мало о нем слышал)

Я так понимаю, что стандарт мало где используется, и потому он непопулярен (вывод сделал лишь по тому, что мало о нем слышал)

0

Стандарт довольно популярен, но только в виде оптики.

Например, среднему домашнему провайдеру уже одного 1G линка в мир мало, а два по 1G — проблемно (если LACP/trunk/bond — может не сбалансироваться, если BGP — вообще свои проблемы, и так далее), а если четыре, да еще и каждое волокно денег стоит (например, арендованное)?.. Вот и получается, что 10G использовать дешевле и проще. Кстати, я сегодня как раз строил LACP из двух 1G и уже сам о десятке задумался.

Например, среднему домашнему провайдеру уже одного 1G линка в мир мало, а два по 1G — проблемно (если LACP/trunk/bond — может не сбалансироваться, если BGP — вообще свои проблемы, и так далее), а если четыре, да еще и каждое волокно денег стоит (например, арендованное)?.. Вот и получается, что 10G использовать дешевле и проще. Кстати, я сегодня как раз строил LACP из двух 1G и уже сам о десятке задумался.

0

Не подскажете, как пересекаются xDSL и Ethernet? Все виденные ADSL и VDSL модемы требовали при конфигурации значений VPI/VCI, что как бы намекает на Ethernet over ATM.

Wi-Fi от Ethernet отличаются уже на канальном уровне (CSMA/CA vs CSMA/CD). Вы вводите людей в заблуждение.

Wi-Fi от Ethernet отличаются уже на канальном уровне (CSMA/CA vs CSMA/CD). Вы вводите людей в заблуждение.

+3

Либо я неправильно выразился, либо Вы неправильно поняли.

Пересекаются они тем, что xDSL & Wi-Fi инкапсулируют Ethernet. Он хоть сегодня и стандарт де-факто, но далеко не единственный протокол второго уровня.

Пересекаются они тем, что xDSL & Wi-Fi инкапсулируют Ethernet. Он хоть сегодня и стандарт де-факто, но далеко не единственный протокол второго уровня.

0

Выше выложили карточку с двумя линками, там utp 6 или 7 категории используется, но стоимость там в разы больше.

0

Карточка сильно греется? Или радиатор для солидности?

0

Не могли бы вы ещё выложить фотографий кабеля, плохо видно.

+31

Второй конец кабеля можно воткнуть во второй порт и сделать 10 Гбит/с мост

0

Я жутко недоволен 1гбит линками, бро. От жуткого качества 1080p remux-ов уже глаза вытекают, 9.1 звуковая система давно сломала мне слух.

Можешь что-нибудь посоветовать для домашнего кинотеатра, чтобы начать полноценно наслаждаться фильмами?

Можешь что-нибудь посоветовать для домашнего кинотеатра, чтобы начать полноценно наслаждаться фильмами?

+5

> Все кому не жалко скиньте денег на еду:

> Приму в дар хороший фотоаппарат, высокотехнологичное железо для обзоров, интересные штуки(предлагайте сами), тему для обзора или освещения.

> Не жалеем карму и плюсы.

Выглядит несколько самонадеянно.

На сетку за €1000 хватило, а кушать стало нечего?

Последнюю строку не буду комментировать — тут это не принято.

> Приму в дар хороший фотоаппарат, высокотехнологичное железо для обзоров, интересные штуки(предлагайте сами), тему для обзора или освещения.

> Не жалеем карму и плюсы.

Выглядит несколько самонадеянно.

На сетку за €1000 хватило, а кушать стало нечего?

Последнюю строку не буду комментировать — тут это не принято.

+17

За последний месяц я испытывал голод чаще чем за три года до этого.

Так что фразу скиньте денег на еду нужно понимать буквально.

Так что фразу скиньте денег на еду нужно понимать буквально.

+1

У меня есть друг такой, покупает всякие интересные штуки, а потом жрать нечего. Так что гикам это простительно.

+1

фоток мало! особенно проводов

+2

linix <-> freebsd + link aggregation какую скорость покажет или в диск упрется?

-1

Упрется в процессор.

0

Не упрется в процессор, линк агрегатион в данном тесте не поможет, думаю выжать почти 10г вполне можно.

0

Не упрётся он в процессор по той простой причине, что попросту работать не будет. Link Aggregation балансирует трафик на базе алгоритмов второго (MAC), третьего(IP) или максимум четвёртого (TCP/UDP-порты) уровня, создавая из них hash и направляя трафик в тот или иной канал на базе их отличия. Между двумя домашними машинами же балансировать попросту нечего — что NFS, что SMB открывают по одному соединению на машину, так что не будут менятся ни MAC'и, ни IP, ни порты.

0

можно больше фоток? собаку плохо видно

+2

НЛО прилетело и опубликовало эту надпись здесь

А какие ограничения на длину кабеля?

+1

Обычная 10g SFP+ карта.

В обзоре (?) не описаны: драйвера, которые использовались (подозреваю igbx?), процессор, с которым это всё работало, как распределялись прерывания, и так далее. Без тюнинга всего этого даже нормальная гигабитная карта — всего лишь офигенно дорогой кусок текстолита и кремния.

Дальше:

Неа. Это потому, что чипсет умеет два порта. И глупо было бы второй не использовать, тогда как цена PHY-зика (в случае SFP+) — копеечная.

Читайте статью перед отправкой.

,,,,,,,,,,,,,,,…

Вот, держите. Кончатся — обращайтесь, у меня еще есть.

Да, есть пожелание. Прочтите правила Хабрахабра.

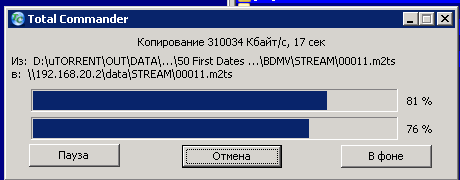

По просьбе в комментариях прикладываю скрин копирования с тотала(скорость будет выше в тестах на линуксе).

Во-первых, производительность карт меряется в пакетах в секунду, а не в битах. Тем более не в байтах.

Во-вторых, почему в Linux будет быстрее (я-то знаю, но в статье неплохо бы указать)?

В обзоре (?) не описаны: драйвера, которые использовались (подозреваю igbx?), процессор, с которым это всё работало, как распределялись прерывания, и так далее. Без тюнинга всего этого даже нормальная гигабитная карта — всего лишь офигенно дорогой кусок текстолита и кремния.

Дальше:

Сетевая карта Intel X520 DA2 предназначена для систем виртуализации поэтому в ней два порта.

Неа. Это потому, что чипсет умеет два порта. И глупо было бы второй не использовать, тогда как цена PHY-зика (в случае SFP+) — копеечная.

Я решил купить три карточки и три кабеля, чтобы соединить три сервера в 10 гигабитное кольцо, у серверов разные операционные системы, на данный момент я потестил только скорость между freenas и windows? получил 300 мегабайт между ними, на виндовсе собран 5-ый софтовый raid из 5 винчестеров, на фринасе zfs raidz2 из 20 винтов. Думаю что все упирается в виндовый raid позже проведу тесты с линуксом и думаю смогу получить почти 10 гигабит скорости между хранилищами.

Читайте статью перед отправкой.

,,,,,,,,,,,,,,,…

Вот, держите. Кончатся — обращайтесь, у меня еще есть.

Вопросы, пожелания, предложения?

Все кому не жалко скиньте денег на еду:

Яндекс деньги: 41001350134938

wmr: R216907812321

wmz: Z115984864021

Приму в дар хороший фотоаппарат, высокотехнологичное железо для обзоров, интересные штуки(предлагайте сами), тему для обзора или освещения.

Не жалеем карму и плюсы.

Да, есть пожелание. Прочтите правила Хабрахабра.

По просьбе в комментариях прикладываю скрин копирования с тотала(скорость будет выше в тестах на линуксе).

Во-первых, производительность карт меряется в пакетах в секунду, а не в битах. Тем более не в байтах.

Во-вторых, почему в Linux будет быстрее (я-то знаю, но в статье неплохо бы указать)?

+6

По просьбе в комментариях прикладываю скрин копирования с тотала(скорость будет выше в тестах на линуксе).

Пардон, вот это должно было быть цитатой.

+1

Черезчур жестокая критика, нельзя такое в комментарии. Надо было в ЛС, автор бы подправил.

-7

Вы знаете, я свои N голосов в день использую каждый день. Полностью, до нуля. Автор — первый, кому я поставил минус за все время пребывания на Хабре.

И я считаю, что сделал правильно. Потому что лично я ценю Хабрахабр за качественные статьи. Собственно, в этом и состоит принцип саморегуляции Хабра.

И я считаю, что сделал правильно. Потому что лично я ценю Хабрахабр за качественные статьи. Собственно, в этом и состоит принцип саморегуляции Хабра.

+9

Мое мнение может быть неправильным, но в моих глазах вы пришли сюда в топик с флагом в руках творить добро и искоренять зло, аки крестоносец. Если автор в чем-то не прав, надо уведомить его в ЛС, а так вы его демонстративно на глазах у сообщества выставляете в плохом свете. Что для вас хабр? Хорошие топики? То есть каждый должен писать топик и все остальные должны его оценивать, да? А как же коллективное творчество? Вы показали свои знания, да, возьмите печеньку с полки, вы ее заслужили. А теперь пожалуйста хватит так делать, и умничать не надо тем более.

В чем? Разбираю по полочкам весь комментарий:

И, простите, где же упомянутый «принцип саморегуляции»? Блестнули красивым словечком, да? Что же, еще одна печенька ваша.

И кстати, хоть в моем положении это и неуместно писать, но судя по вашему профилю, написали вы очень много полезных топиков, которые безусловно возвышают вас над всеми неугодными необразованными неучами, которых надо публично унижать. С собой не сравниваю, я вообще хуй простой, а вот сравните себя с автором топика — он сделал куда больше для хабры, нежели вы. Не вам судить.

Думайте обо мне что хотите, но так делать нельзя, Ваше Величество.

Собственно, в этом и состоит принцип саморегуляции Хабра.

В чем? Разбираю по полочкам весь комментарий:

Вы знаете, я свои N голосов в день использую каждый день

Автор — первый, кому я поставил минус за все время пребывания на Хабре.

И я считаю, что сделал правильно.

Потому что лично я ценю Хабрахабр за качественные статьи.

И, простите, где же упомянутый «принцип саморегуляции»? Блестнули красивым словечком, да? Что же, еще одна печенька ваша.

И кстати, хоть в моем положении это и неуместно писать, но судя по вашему профилю, написали вы очень много полезных топиков, которые безусловно возвышают вас над всеми неугодными необразованными неучами, которых надо публично унижать. С собой не сравниваю, я вообще хуй простой, а вот сравните себя с автором топика — он сделал куда больше для хабры, нежели вы. Не вам судить.

Думайте обо мне что хотите, но так делать нельзя, Ваше Величество.

0

Накипело.

0

То есть каждый должен писать топик и все остальные должны его оценивать, да? А как же коллективное творчество?

Ну и сморозил же я. Имелось ввиду то, что хабр создан для того, что бы люди делились своими знаниями. Кто-то ошибся? Шепни ему об этом на ушко, а не отчитывай в комментариях. Автор все поправит и топик станет более полезным.

И да, я всего лишь выразил свою точку зрения. Кто не согласен — пожалуйста, укажите мне, в чем я не прав.

0

Извините, а какие знания можно почерпнуть из топика?

То, что красная машина быстрее ездит, и ежу понятно.

То, что красная машина быстрее ездит, и ежу понятно.

0

В том и суть. Идеальные топики — редкость, всегда чего-то не хватает. Все надо делать сообща, кто-то ошибся — скажи ему, объясни, он допилит топик и он станет отличным достоянием хабраобщества.

просьба тухлые яйца бросать сразу мне в хабрапочту.Из вашего топика…

0

Хабрахабр как раз и хорош тем, что в комментариях раскрывается больше, чем в топике :). Хабр — бастион, где есть обмен знаниями и опытом. Главное — «задвинуть тему». Если опять возвращаться к моему топику — я не знал ни одного из предложенных мне в комментариях вариантов решения. Сижу теперь, изучаю.

+2

Мне уже стыдно становится. Нападать так с моей стороны было глупо. Но в целом точка зрения осталась та же — слишком агрессивная критика.

+1

У Вас есть мнение. И Ваше мнение интересно, хоть и не совпадает с моим. Держите плюс.

У автора же есть вроде как статья, в которой 0 полезных данных и куча ошибок. Да еще и с нарушением правил, которые вроде как должны препятствовать появлению некачественных статей. Всё, что оттуда можно узнать — «Красная машина быстрее едет» (простите за повтор). Потому минус.

У автора же есть вроде как статья, в которой 0 полезных данных и куча ошибок. Да еще и с нарушением правил, которые вроде как должны препятствовать появлению некачественных статей. Всё, что оттуда можно узнать — «Красная машина быстрее едет» (простите за повтор). Потому минус.

+1

Честно признаюсь, мне топик понравился. Если судить именно таким образом, каким судите вы, то половина топиков на хабре не имеют смысла.

А понравился мне топик просто тем, что я получил эстетическое наслаждение, да и не только. Теперь я знаю, каких скоростей можно достигнуть на 10гбит сети :) Такой топик можно приравнять к аналогичным в автожурналах — всего-то фотографии и данные о скорости и мощностях, однако людям нравится.

Нарушение правил — это точно. Но я что-то сомневаюсь, что автор их не видел. Мне кажется, что он вынужден был это сделать так как действительно находится в трудном финансовом положении. Какую-то копейку, но все таки я скинул, не жалко.

А понравился мне топик просто тем, что я получил эстетическое наслаждение, да и не только. Теперь я знаю, каких скоростей можно достигнуть на 10гбит сети :) Такой топик можно приравнять к аналогичным в автожурналах — всего-то фотографии и данные о скорости и мощностях, однако людям нравится.

Нарушение правил — это точно. Но я что-то сомневаюсь, что автор их не видел. Мне кажется, что он вынужден был это сделать так как действительно находится в трудном финансовом положении. Какую-то копейку, но все таки я скинул, не жалко.

0

Можно узнать

1) Модели сетевых карт.

2) Поддержку карт в операционных системах(трех).

3) Узнать про существование твинаксиального кабеля(я узнал о нем только с месяц назад).

4) Цены

5) Тест скорости.

1) Модели сетевых карт.

2) Поддержку карт в операционных системах(трех).

3) Узнать про существование твинаксиального кабеля(я узнал о нем только с месяц назад).

4) Цены

5) Тест скорости.

0

Linux-у более родны менее защищенные фотматы, как следствие — более скоростные. Взять ту же samba, где что-то нешифрованно отправить весьма проблематично. В отличие от nfs, например.

-1

Простите… что?

Вы скорость сети форматами мерять будете?

Вообще-то я имел в виду очереди прерываний, smp_affinity, msi-x, interrupt throttle, offload-ы и так далее.

Вы скорость сети форматами мерять будете?

Вообще-то я имел в виду очереди прерываний, smp_affinity, msi-x, interrupt throttle, offload-ы и так далее.

+1

Я имел ввиду, что, как я понял, автор под «Скорость в Linux будет выше» имеет ввиду отсутствие расходов на шифрование\дешифрование, расходуемые на CPU, и вообще всю программную обвязку.

0

Скорость будет выше потому что там будет рейд из большего количества винтов, все уперлось в рейд на винде, а не в пропускную способность.

0

Вы вводите людей в заблуждение. У Вас процессоры резиновые?

0

Почему по вашему что то упрется в процессор?

Пруф, топ с упершегося в процессор?

Опыт показал что рейд жрет совсем немного процессора в самом слабом i7.

Пруф, топ с упершегося в процессор?

Опыт показал что рейд жрет совсем немного процессора в самом слабом i7.

0

При чем тут рейд? Я о сети.

Будет забито interrupt и system.

Будет забито interrupt и system.

0

Вот вам топ с сервера который прокачивает через себя 5 гигабит в обе стороны, в фуле 10 получается.

top — 14:44:15 up 8 days, 9:36, 1 user, load average: 0.00, 0.00, 0.00

Tasks: 139 total, 1 running, 138 sleeping, 0 stopped, 0 zombie

Cpu0: 0.0%us, 0.0%sy, 0.0%ni, 91.3%id, 0.0%wa, 1.3%hi, 7.3%si, 0.0%st

Cpu1: 0.0%us, 0.0%sy, 0.0%ni, 90.0%id, 0.0%wa, 4.7%hi, 5.3%si, 0.0%st

Cpu2: 0.0%us, 0.0%sy, 0.0%ni, 92.3%id, 0.0%wa, 1.3%hi, 6.3%si, 0.0%st

Cpu3: 0.0%us, 0.0%sy, 0.0%ni, 83.8%id, 0.0%wa, 1.3%hi, 14.9%si, 0.0%st

Cpu4: 0.0%us, 0.0%sy, 0.0%ni, 86.0%id, 0.0%wa, 3.3%hi, 10.6%si, 0.0%st

Cpu5: 0.0%us, 0.0%sy, 0.0%ni, 78.0%id, 0.0%wa, 3.3%hi, 18.7%si, 0.0%st

Cpu6: 0.0%us, 0.0%sy, 0.0%ni, 86.3%id, 0.0%wa, 3.7%hi, 10.0%si, 0.0%st

Cpu7: 0.3%us, 0.0%sy, 0.0%ni, 85.7%id, 0.0%wa, 3.3%hi, 10.6%si, 0.0%st

Mem: 4047384k total, 562024k used, 3485360k free, 155504k buffers

Swap: 6094840k total, 0k used, 6094840k free, 295780k cached

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

1 root 15 0 10348 704 588 S 0.0 0.0 0:04.85 init

2 root RT -5 0 0 0 S 0.0 0.0 0:01.44 migration/0

3 root 34 19 0 0 0 S 0.0 0.0 0:01.22 ksoftirqd/0

4 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/0

5 root RT -5 0 0 0 S 0.0 0.0 0:00.21 migration/1

6 root 34 19 0 0 0 S 0.0 0.0 0:00.07 ksoftirqd/1

7 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/1

8 root RT -5 0 0 0 S 0.0 0.0 0:00.20 migration/2

9 root 34 19 0 0 0 S 0.0 0.0 0:00.01 ksoftirqd/2

10 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/2

11 root RT -5 0 0 0 S 0.0 0.0 0:00.82 migration/3

12 root 34 19 0 0 0 S 0.0 0.0 0:00.05 ksoftirqd/3

13 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/3

14 root RT -5 0 0 0 S 0.0 0.0 0:00.10 migration/4

15 root 34 19 0 0 0 S 0.0 0.0 0:00.04 ksoftirqd/4

16 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/4

17 root RT -5 0 0 0 S 0.0 0.0 0:00.11 migration/5

18 root 34 19 0 0 0 S 0.0 0.0 0:00.06 ksoftirqd/5

19 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/5

20 root RT -5 0 0 0 S 0.0 0.0 0:00.34 migration/6

21 root 34 19 0 0 0 S 0.0 0.0 0:00.03 ksoftirqd/6

22 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/6

23 root RT -5 0 0 0 S 0.0 0.0 0:00.21 migration/7

24 root 34 19 0 0 0 S 0.0 0.0 0:00.01 ksoftirqd/7

25 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/7

26 root 10 -5 0 0 0 S 0.0 0.0 0:14.93 events/0

27 root 10 -5 0 0 0 S 0.0 0.0 0:00.00 events/1

28 root 10 -5 0 0 0 S 0.0 0.0 0:00.03 events/2

29 root 10 -5 0 0 0 S 0.0 0.0 0:00.00 events/3

30 root 10 -5 0 0 0 S 0.0 0.0 0:00.01 events/4

31 root 10 -5 0 0 0 S 0.0 0.0 0:00.00 events/5

32 root 10 -5 0 0 0 S 0.0 0.0 0:00.00 events/6

33 root 10 -5 0 0 0 S 0.0 0.0 0:00.01 events/7

34 root 11 -5 0 0 0 S 0.0 0.0 0:00.00 khelper

73 root 10 -5 0 0 0 S 0.0 0.0 0:00.00 kthread

84 root 10 -5 0 0 0 S 0.0 0.0 0:07.79 kblockd/0

85 root 10 -5 0 0 0 S 0.0 0.0 0:00.72 kblockd/1

86 root 10 -5 0 0 0 S 0.0 0.0 0:01.13 kblockd/2

87 root 10 -5 0 0 0 S 0.0 0.0 0:01.22 kblockd/3

88 root 10 -5 0 0 0 S 0.0 0.0 0:01.37 kblockd/4

89 root 10 -5 0 0 0 S 0.0 0.0 0:01.29 kblockd/5

90 root 10 -5 0 0 0 S 0.0 0.0 0:02.34 kblockd/6

91 root 10 -5 0 0 0 S 0.0 0.0 0:03.61 kblockd/7

92 root 20 -5 0 0 0 S 0.0 0.0 0:00.00 kacpid

221 root 20 -5 0 0 0 S 0.0 0.0 0:00.00 cqueue/0

222 root 10 -5 0 0 0 S 0.0 0.0 0:00.00 cqueue/1

top — 14:44:15 up 8 days, 9:36, 1 user, load average: 0.00, 0.00, 0.00

Tasks: 139 total, 1 running, 138 sleeping, 0 stopped, 0 zombie

Cpu0: 0.0%us, 0.0%sy, 0.0%ni, 91.3%id, 0.0%wa, 1.3%hi, 7.3%si, 0.0%st

Cpu1: 0.0%us, 0.0%sy, 0.0%ni, 90.0%id, 0.0%wa, 4.7%hi, 5.3%si, 0.0%st

Cpu2: 0.0%us, 0.0%sy, 0.0%ni, 92.3%id, 0.0%wa, 1.3%hi, 6.3%si, 0.0%st

Cpu3: 0.0%us, 0.0%sy, 0.0%ni, 83.8%id, 0.0%wa, 1.3%hi, 14.9%si, 0.0%st

Cpu4: 0.0%us, 0.0%sy, 0.0%ni, 86.0%id, 0.0%wa, 3.3%hi, 10.6%si, 0.0%st

Cpu5: 0.0%us, 0.0%sy, 0.0%ni, 78.0%id, 0.0%wa, 3.3%hi, 18.7%si, 0.0%st

Cpu6: 0.0%us, 0.0%sy, 0.0%ni, 86.3%id, 0.0%wa, 3.7%hi, 10.0%si, 0.0%st

Cpu7: 0.3%us, 0.0%sy, 0.0%ni, 85.7%id, 0.0%wa, 3.3%hi, 10.6%si, 0.0%st

Mem: 4047384k total, 562024k used, 3485360k free, 155504k buffers

Swap: 6094840k total, 0k used, 6094840k free, 295780k cached

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

1 root 15 0 10348 704 588 S 0.0 0.0 0:04.85 init

2 root RT -5 0 0 0 S 0.0 0.0 0:01.44 migration/0

3 root 34 19 0 0 0 S 0.0 0.0 0:01.22 ksoftirqd/0

4 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/0

5 root RT -5 0 0 0 S 0.0 0.0 0:00.21 migration/1

6 root 34 19 0 0 0 S 0.0 0.0 0:00.07 ksoftirqd/1

7 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/1

8 root RT -5 0 0 0 S 0.0 0.0 0:00.20 migration/2

9 root 34 19 0 0 0 S 0.0 0.0 0:00.01 ksoftirqd/2

10 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/2

11 root RT -5 0 0 0 S 0.0 0.0 0:00.82 migration/3

12 root 34 19 0 0 0 S 0.0 0.0 0:00.05 ksoftirqd/3

13 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/3

14 root RT -5 0 0 0 S 0.0 0.0 0:00.10 migration/4

15 root 34 19 0 0 0 S 0.0 0.0 0:00.04 ksoftirqd/4

16 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/4

17 root RT -5 0 0 0 S 0.0 0.0 0:00.11 migration/5

18 root 34 19 0 0 0 S 0.0 0.0 0:00.06 ksoftirqd/5

19 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/5

20 root RT -5 0 0 0 S 0.0 0.0 0:00.34 migration/6

21 root 34 19 0 0 0 S 0.0 0.0 0:00.03 ksoftirqd/6

22 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/6

23 root RT -5 0 0 0 S 0.0 0.0 0:00.21 migration/7

24 root 34 19 0 0 0 S 0.0 0.0 0:00.01 ksoftirqd/7

25 root RT -5 0 0 0 S 0.0 0.0 0:00.00 watchdog/7

26 root 10 -5 0 0 0 S 0.0 0.0 0:14.93 events/0

27 root 10 -5 0 0 0 S 0.0 0.0 0:00.00 events/1

28 root 10 -5 0 0 0 S 0.0 0.0 0:00.03 events/2

29 root 10 -5 0 0 0 S 0.0 0.0 0:00.00 events/3

30 root 10 -5 0 0 0 S 0.0 0.0 0:00.01 events/4

31 root 10 -5 0 0 0 S 0.0 0.0 0:00.00 events/5

32 root 10 -5 0 0 0 S 0.0 0.0 0:00.00 events/6

33 root 10 -5 0 0 0 S 0.0 0.0 0:00.01 events/7

34 root 11 -5 0 0 0 S 0.0 0.0 0:00.00 khelper

73 root 10 -5 0 0 0 S 0.0 0.0 0:00.00 kthread

84 root 10 -5 0 0 0 S 0.0 0.0 0:07.79 kblockd/0

85 root 10 -5 0 0 0 S 0.0 0.0 0:00.72 kblockd/1

86 root 10 -5 0 0 0 S 0.0 0.0 0:01.13 kblockd/2

87 root 10 -5 0 0 0 S 0.0 0.0 0:01.22 kblockd/3

88 root 10 -5 0 0 0 S 0.0 0.0 0:01.37 kblockd/4

89 root 10 -5 0 0 0 S 0.0 0.0 0:01.29 kblockd/5

90 root 10 -5 0 0 0 S 0.0 0.0 0:02.34 kblockd/6

91 root 10 -5 0 0 0 S 0.0 0.0 0:03.61 kblockd/7

92 root 20 -5 0 0 0 S 0.0 0.0 0:00.00 kacpid

221 root 20 -5 0 0 0 S 0.0 0.0 0:00.00 cqueue/0

222 root 10 -5 0 0 0 S 0.0 0.0 0:00.00 cqueue/1

0

У него «однозадачное» копирование большими блоками в один тред.

Человек убежден, что копирование в тоталкомандере и есть «реальная работа».

Этакий сторадж в виде одного большого флопика.

В этом варианте действительно упираться в процессор не будет.

Человек убежден, что копирование в тоталкомандере и есть «реальная работа».

Этакий сторадж в виде одного большого флопика.

В этом варианте действительно упираться в процессор не будет.

0

Пробовали на ProCurve 2510 и Intel гигабитной делать агрегацию канала средствами FreeBSD, оно довольно сильно жрало процессор.

Да, PPS бы хотелось глянуть. Покупать 10Gb оборудование ради разницы на 10-100 пакетов не выгодно, тк сервер не один. Да и вообще сомнительные достижения этого 10Gb, разве что для iSCSI использовать.

Да, PPS бы хотелось глянуть. Покупать 10Gb оборудование ради разницы на 10-100 пакетов не выгодно, тк сервер не один. Да и вообще сомнительные достижения этого 10Gb, разве что для iSCSI использовать.

0

Просто готовить не умеете :).

Конкретно для FreeBSD не скажу, но для Linux готовлю так:

1. Обязательно драйвер от Intel. Для FreeBSD — драйвер от Яндекса.

2. Обязательно выставить кол-во очередей прерываний равным количеству CPU в SMP (или ядер, или ядер*CPU — ну Вы поняли; дальше буду называть ядрами).

3. Прибить прерывания к ядрам. По умолчанию ОС балансирует прерывания на свободные ядра. Это хорошо для большинства случаев, но не для сети! Переключения контекста из-за балансировки занимают больше времени, чем собственно обработка прерываний. У меня выглядит где-то так:

Парировать tx+rxпо вкусу по обстоятельствам, одну физическую карту желательно вешать на один физический процессор.

4. Interrupt throttle rate — крутить вручную, читать документацию Intel-а. Если кратко, то обычно один пакет = одно прерывание. Это офигенно много прерываний. Intel-овские igb (и другие «матёрые» карты) умеют собирать пакеты в свой буфер и отдавать процессору пачкой, за одно прерывание. В драйвере от Intel по умолчанию стоит автоматическое определение размера (в зависимости от нагрузки) — я так и оставляю.

5. offload-ы по вкусу, но внимательно смотреть на всякие софтовые (вроде GSO) — могут нервов испортить. Вообще, лучше все что можно аппаратное включать.

6. ring buffer. По умолчанию — 256, что очень мало. Ставить 4096.

7. И конечно же, пилить firewall. Присмотритесь — может, можно что-нибудь вынести в отдельные таблицы, а то и вообще сделать дерево (вроде hash filter)?

Конкретно для FreeBSD не скажу, но для Linux готовлю так:

1. Обязательно драйвер от Intel. Для FreeBSD — драйвер от Яндекса.

2. Обязательно выставить кол-во очередей прерываний равным количеству CPU в SMP (или ядер, или ядер*CPU — ну Вы поняли; дальше буду называть ядрами).

3. Прибить прерывания к ядрам. По умолчанию ОС балансирует прерывания на свободные ядра. Это хорошо для большинства случаев, но не для сети! Переключения контекста из-за балансировки занимают больше времени, чем собственно обработка прерываний. У меня выглядит где-то так:

#!/bin/sh

#

# irq2smp -- distribute hardware interrupts from Ethernet devices by CPU cores.

#

# Should be called from /etc/rc.local.

#

/bin/echo 1 > /proc/irq/`cat /proc/interrupts | grep 'eth0-rx-0' | awk -F \: '{printf "%i", $1}'`/smp_affinity

/bin/echo 2 > /proc/irq/`cat /proc/interrupts | grep 'eth0-rx-1' | awk -F \: '{printf "%i", $1}'`/smp_affinity

/bin/echo 4 > /proc/irq/`cat /proc/interrupts | grep 'eth0-rx-2' | awk -F \: '{printf "%i", $1}'`/smp_affinity

/bin/echo 8 > /proc/irq/`cat /proc/interrupts | grep 'eth0-rx-3' | awk -F \: '{printf "%i", $1}'`/smp_affinity

/bin/echo 1 > /proc/irq/`cat /proc/interrupts | grep 'eth0-tx-0' | awk -F \: '{printf "%i", $1}'`/smp_affinity

/bin/echo 2 > /proc/irq/`cat /proc/interrupts | grep 'eth0-tx-1' | awk -F \: '{printf "%i", $1}'`/smp_affinity

/bin/echo 4 > /proc/irq/`cat /proc/interrupts | grep 'eth0-tx-2' | awk -F \: '{printf "%i", $1}'`/smp_affinity

/bin/echo 8 > /proc/irq/`cat /proc/interrupts | grep 'eth0-tx-3' | awk -F \: '{printf "%i", $1}'`/smp_affinity

/bin/echo 1 > /proc/irq/`cat /proc/interrupts | grep 'eth1-rx-0' | awk -F \: '{printf "%i", $1}'`/smp_affinity

/bin/echo 2 > /proc/irq/`cat /proc/interrupts | grep 'eth1-rx-1' | awk -F \: '{printf "%i", $1}'`/smp_affinity

/bin/echo 4 > /proc/irq/`cat /proc/interrupts | grep 'eth1-rx-2' | awk -F \: '{printf "%i", $1}'`/smp_affinity

/bin/echo 8 > /proc/irq/`cat /proc/interrupts | grep 'eth1-rx-3' | awk -F \: '{printf "%i", $1}'`/smp_affinity

/bin/echo 1 > /proc/irq/`cat /proc/interrupts | grep 'eth1-tx-0' | awk -F \: '{printf "%i", $1}'`/smp_affinity

/bin/echo 2 > /proc/irq/`cat /proc/interrupts | grep 'eth1-tx-1' | awk -F \: '{printf "%i", $1}'`/smp_affinity

/bin/echo 4 > /proc/irq/`cat /proc/interrupts | grep 'eth1-tx-2' | awk -F \: '{printf "%i", $1}'`/smp_affinity

/bin/echo 8 > /proc/irq/`cat /proc/interrupts | grep 'eth1-tx-3' | awk -F \: '{printf "%i", $1}'`/smp_affinity

Парировать tx+rx

4. Interrupt throttle rate — крутить вручную, читать документацию Intel-а. Если кратко, то обычно один пакет = одно прерывание. Это офигенно много прерываний. Intel-овские igb (и другие «матёрые» карты) умеют собирать пакеты в свой буфер и отдавать процессору пачкой, за одно прерывание. В драйвере от Intel по умолчанию стоит автоматическое определение размера (в зависимости от нагрузки) — я так и оставляю.

5. offload-ы по вкусу, но внимательно смотреть на всякие софтовые (вроде GSO) — могут нервов испортить. Вообще, лучше все что можно аппаратное включать.

6. ring buffer. По умолчанию — 256, что очень мало. Ставить 4096.

7. И конечно же, пилить firewall. Присмотритесь — может, можно что-нибудь вынести в отдельные таблицы, а то и вообще сделать дерево (вроде hash filter)?

+10

В линуксе знаю как настраивать. Не раз читал, но там FreeBSD, а она не умеет разбрасывать именно по ядрам прерывания как в Linux. Я могу ошибаться, но пока не нашел ничего подобного. net.isr и остальные параметры подобных вещей не дают. Серверы с нагрузкой справляются, просто хотелось бы еще чуть побольше из них выжать, что бы купить что-то более производительное для других целей.

0

У меня так:

loader.conf

sysctl.conf

Не спрашивайте, что все эти цифры и буквы значат. Сам не знаю. Но работает :).

loader.conf

hw.igb.rxd="4096"

hw.igb.txd="4096"

hw.igb.rx_process_limit="400"

net.isr.maxthreads=4sysctl.conf

net.route.netisr_maxqlen=512

net.isr.direct=0Не спрашивайте, что все эти цифры и буквы значат. Сам не знаю. Но работает :).

+1

О, гугл рулит и педалит.

Вот так надо для прерываний:

loader.conf

<source lang=«bash>net.isr.maxthreads=4

net.isr.numthreads=4

net.isr.bindthreads=0

Последнее, как я понял — это прибивание потоков к ядрам. Я бы ставил 1.

Вот так надо для прерываний:

loader.conf

<source lang=«bash>net.isr.maxthreads=4

net.isr.numthreads=4

net.isr.bindthreads=0

Последнее, как я понял — это прибивание потоков к ядрам. Я бы ставил 1.

0

Не раз читал, но там FreeBSD, а она не умеет разбрасывать именно по ядрам прерывания как в Linux

Да ну конечно!

#top -aSCHIP

last pid: 88161; load averages: 1.10, 1.08, 1.07 up 358+05:03:51 17:51:33 205 processes: 7 running, 180 sleeping, 18 waiting CPU 0: 0.0% user, 0.0% nice, 24.4% system, 1.1% interrupt, 74.4% idle CPU 1: 0.0% user, 0.0% nice, 25.6% system, 1.1% interrupt, 73.3% idle CPU 2: 0.0% user, 0.0% nice, 28.2% system, 0.4% interrupt, 71.4% idle CPU 3: 0.0% user, 0.0% nice, 24.1% system, 0.4% interrupt, 75.6% idle Mem: 644M Active, 800M Inact, 463M Wired, 68M Cache, 199M Buf, 26M Free Swap: 8192M Total, 20K Used, 8192M Free PID USERNAME PRI NICE SIZE RES STATE C TIME CPU COMMAND 10 root 171 ki31 0K 8K RUN 3 7457.5 79.59% [idle: cpu3] 11 root 171 ki31 0K 8K RUN 2 7379.3 75.98% [idle: cpu2] 12 root 171 ki31 0K 8K CPU1 1 6679.1 73.19% [idle: cpu1] 13 root 171 ki31 0K 8K RUN 0 6126.0 72.17% [idle: cpu0] 25 root 43 - 0K 8K WAIT 1 1634.6 25.00% [em0_rx0_0] 16298 root 43 - 0K 8K WAIT 0 963.3H 24.37% [em0_rx0_1] 29 root 43 - 0K 8K CPU2 2 1478.4 24.17% [em1_rx0_0] 30 root 43 - 0K 8K RUN 3 1477.9 23.19% [em1_rx0_1] 15 root -32 - 0K 8K WAIT 0 162.0H 1.86% [swi4: clock] 27 root 16 - 0K 8K WAIT 3 88.9H 0.68% [swi16: em1_tx] 23 root 16 - 0K 8K WAIT 1 83.2H 0.68% [swi16: em0_tx] 37 root 8 - 0K 8K pftm 0 73.3H 0.49% [pfpurge]

#pciconf -lv|grep 8257

device = 'Intel Corporation 82573E Gigabit Ethernet Controller (Copper) (82573E)'

device = 'Intel PRO/1000 PL Network Adaptor (82573L)'

#grep -E 'em[0|1]' /var/run/dmesg.boot

em0: <Intel® PRO/1000 Network Connection 7.0.5.Yandex[$Revision: 1.36.2.18 $]> port 0x3000-0x301f mem 0xd0300000-0xd031ffff irq 16 at device 0.0 on pci13 em0: Using MSI interrupt em0: [FILTER] em0: Ethernet address: 00:30:48:64:e9:4a em1: <Intel® PRO/1000 Network Connection 7.0.5.Yandex[$Revision: 1.36.2.18 $]> port 0x4000-0x401f mem 0xd0400000-0xd041ffff irq 17 at device 0.0 on pci15 em1: Using MSI interrupt em1: [FILTER] em1: Ethernet address: 00:30:48:64:e9:4b

#cat /etc/rc.local

# Bind all kernel threads to CPU cores 0,1 sharing common L2-cache ps -axo pid,command | egrep '^ *[0-9]+ \[' | while read pid cmd; do cpuset -l 0,1 -p $pid; done # Bind em0 and em1 threads to different CPU cores ps -axo pid,command | egrep '^ *[0-9]+ \[' | grep em0 | while read pid cmd; do cpuset -l 0,1 -p $pid; done ps -axo pid,command | egrep '^ *[0-9]+ \[' | grep em1 | while read pid cmd; do cpuset -l 2,3 -p $pid; done

0

А в чем суть драйверов? Раньше понятно наверно были какие то слабые дрова на интел в ядре, но с выхода центос 5 проблемы с затыком на интелевых сетевках я не встречал, спокойно прокачивают на родных драйверах 8 гигабитный поток, без фаервола.

0

Как померить искуственно pps?

В линуксе объединение использовал на 8 гигабит, загрузка процессора не более 20 процентов на пиковых трафиках.

В линуксе объединение использовал на 8 гигабит, загрузка процессора не более 20 процентов на пиковых трафиках.

0

1)Драйвера из ядра более чем устраивают, другие драйвера не позволят мне выжать больше 10 гигабит.

2)Два порта там потому что чип разрабатывался с ориентацией на системы виртуализации, а не потому что они там случайно.

3)Правила хабра еду не отменяют.

2)Два порта там потому что чип разрабатывался с ориентацией на системы виртуализации, а не потому что они там случайно.

3)Правила хабра еду не отменяют.

-2

Драйвера из ядра не умеют толком interrupt queues, interrupt throttle, offload-ы и так далее.

0

как проверить наличие этих фич в драйвере?

0

modinfo igb

0

[root@bgp ~]# modinfo igb

filename: /lib/modules/2.6.18-164.el5/kernel/drivers/net/igb/igb.ko

version: 1.3.16-k2

license: GPL

description: Intel® Gigabit Ethernet Network Driver

author: Intel Corporation, <e1000-devel@lists.sourceforge.net>

srcversion: 78555F0A019E05BADBD95AA

alias: pci:v00008086d000010D6sv*sd*bc*sc*i*

alias: pci:v00008086d000010A9sv*sd*bc*sc*i*

alias: pci:v00008086d000010A7sv*sd*bc*sc*i*

alias: pci:v00008086d000010E8sv*sd*bc*sc*i*

alias: pci:v00008086d000010E7sv*sd*bc*sc*i*

alias: pci:v00008086d000010E6sv*sd*bc*sc*i*

alias: pci:v00008086d0000150Asv*sd*bc*sc*i*

alias: pci:v00008086d000010C9sv*sd*bc*sc*i*

depends: 8021q

vermagic: 2.6.18-164.el5 SMP mod_unload gcc-4.1

parm: max_vfs:Maximum number of virtual functions to allocate per physical function (uint)

module_sig: 883f3504a9f766557f09578a977b7e1128d840a0b238193ad8e9b9199cd57e22b8927088256c58209e33f9f9b82ee42e594098e7b7cc695344e394b3

filename: /lib/modules/2.6.18-164.el5/kernel/drivers/net/igb/igb.ko

version: 1.3.16-k2

license: GPL

description: Intel® Gigabit Ethernet Network Driver

author: Intel Corporation, <e1000-devel@lists.sourceforge.net>

srcversion: 78555F0A019E05BADBD95AA

alias: pci:v00008086d000010D6sv*sd*bc*sc*i*

alias: pci:v00008086d000010A9sv*sd*bc*sc*i*

alias: pci:v00008086d000010A7sv*sd*bc*sc*i*

alias: pci:v00008086d000010E8sv*sd*bc*sc*i*

alias: pci:v00008086d000010E7sv*sd*bc*sc*i*

alias: pci:v00008086d000010E6sv*sd*bc*sc*i*

alias: pci:v00008086d0000150Asv*sd*bc*sc*i*

alias: pci:v00008086d000010C9sv*sd*bc*sc*i*

depends: 8021q

vermagic: 2.6.18-164.el5 SMP mod_unload gcc-4.1

parm: max_vfs:Maximum number of virtual functions to allocate per physical function (uint)

module_sig: 883f3504a9f766557f09578a977b7e1128d840a0b238193ad8e9b9199cd57e22b8927088256c58209e33f9f9b82ee42e594098e7b7cc695344e394b3

0

Свежий драйвер от Intel:

filename: /lib/modules/2.6.35-ARCH/kernel/drivers/net/igb/igb.ko

version: 3.0.22

license: GPL

description: Intel® Gigabit Ethernet Network Driver

author: Intel Corporation, <e1000-devel@lists.sourceforge.net>

srcversion: 45B8078075068728A5A5573

alias: pci:v00008086d000010D6sv*sd*bc*sc*i*

alias: pci:v00008086d000010A9sv*sd*bc*sc*i*

alias: pci:v00008086d000010A7sv*sd*bc*sc*i*

alias: pci:v00008086d00001526sv*sd*bc*sc*i*

alias: pci:v00008086d000010E8sv*sd*bc*sc*i*

alias: pci:v00008086d0000150Dsv*sd*bc*sc*i*

alias: pci:v00008086d000010E7sv*sd*bc*sc*i*

alias: pci:v00008086d000010E6sv*sd*bc*sc*i*

alias: pci:v00008086d00001518sv*sd*bc*sc*i*

alias: pci:v00008086d0000150Asv*sd*bc*sc*i*

alias: pci:v00008086d000010C9sv*sd*bc*sc*i*

alias: pci:v00008086d00000440sv*sd*bc*sc*i*

alias: pci:v00008086d0000043Csv*sd*bc*sc*i*

alias: pci:v00008086d0000043Asv*sd*bc*sc*i*

alias: pci:v00008086d00000438sv*sd*bc*sc*i*

alias: pci:v00008086d00001527sv*sd*bc*sc*i*

alias: pci:v00008086d00001516sv*sd*bc*sc*i*

alias: pci:v00008086d00001511sv*sd*bc*sc*i*

alias: pci:v00008086d00001510sv*sd*bc*sc*i*

alias: pci:v00008086d0000150Fsv*sd*bc*sc*i*

alias: pci:v00008086d0000150Esv*sd*bc*sc*i*

alias: pci:v00008086d00001524sv*sd*bc*sc*i*

alias: pci:v00008086d00001523sv*sd*bc*sc*i*

alias: pci:v00008086d00001522sv*sd*bc*sc*i*

alias: pci:v00008086d00001521sv*sd*bc*sc*i*

depends: dca

vermagic: 2.6.35-ARCH SMP preempt mod_unload

parm: InterruptThrottleRate:Maximum interrupts per second, per vector, (max 100000), default 3=adaptive (array of int)

parm: IntMode:Change Interrupt Mode (0=Legacy, 1=MSI, 2=MSI-X), default 2 (array of int)

parm: Node:set the starting node to allocate memory on, default -1 (array of int)

parm: LLIPort:Low Latency Interrupt TCP Port (0-65535), default 0=off (array of int)

parm: LLIPush:Low Latency Interrupt on TCP Push flag (0,1), default 0=off (array of int)

parm: LLISize:Low Latency Interrupt on Packet Size (0-1500), default 0=off (array of int)

parm: RSS:Number of Receive-Side Scaling Descriptor Queues (0-8), default 1=number of cpus (array of int)

parm: VMDQ:Number of Virtual Machine Device Queues: 0-1 = disable, 2-8 enable, default 0 (array of int)

parm: max_vfs:Number of Virtual Functions: 0 = disable, 1-7 enable, default 0 (array of int)

parm: QueuePairs:Enable TX/RX queue pairs for interrupt handling (0,1), default 1=on (array of int)

parm: EEE:Enable/disable on parts that support the feature (array of int)

parm: DMAC:Enable/disable on parts that support the feature (array of int)

parm: debug:Debug level (0=none, ..., 16=all) (int)0

В обзоре (?) не описаны: драйвера, которые использовались (подозреваю igbx?), процессор, с которым это всё работало, как распределялись прерывания, и так далее. Без тюнинга всего этого даже нормальная гигабитная карта — всего лишь офигенно дорогой кусок текстолита и кремния.

Какая разница, какие драйвера использовались? Других-то всё равно нет.

Процессору, с которым это работало, по большей части вообще пофиг, для домашних задач у него нет ни одной ресурсоёмкой сетевой задачи(ни маршрутизации, ни роутинга, знай себе пихай данные в буфер сетевухи большими пакетами), да и на самой сетёвке куча offload'a существует.

«Как распределялись прерывания», holy shit… Их на таких обьёмах PPS вообще не заметно. :)

Насчёт гигабита «не гигабит без тюнинга» не согласен.

Во-первых, производительность карт меряется в пакетах в секунду, а не в битах. Тем более не в байтах.

Вах, не занудничайте. ;) Для домашних пользователей важнее байты в секунду, а профи и так всё знают.

0

Вы не видите этому применения? А зря, ведь оно — есть. И я уже люто загорелся этим, быть может даже запилю топик.

Идея в том, чтобы вынести все винчестера куда-нибудь в другое место. Например, в соседнюю комнату, кладовку — куда угодно, где на их шум было бы наплевать. У меня, например, их 8 штук стоит, и все — WD Black. И их скрежетание периодически бесит (системник охлаждается по большей части пассивно, активное охлаждение только у винтов, собственно).

Дальше от этой самой кладовки кинуть оптику. Если квартира в состоянии ремонта — можно даже заранее развести розетки… пусть будет задел на будущее. В кладовке поднять ISCSI, и поставить на него винду\линукс\что угодно. И загружать это локальной машинкой через pxe preloader. Я уже пробовал сделать это с гигабитной медью — работало, но скорость была ни к черту.

А всех, кто сейчас тыкнет меня носом в SSD, можно смело посылать на яндексмаркет. Потому как мне даже приблизительно страшно представить, сколько будет стоить 16тб «чистого» сториджа на ссд. Реальный же обьем хранилища (с учетом рейдов) — 10Тб, и время доступа к 5Тб из них для меня критично ( виртуальные машины с всевозможными конфигурациями, сервиспаками, версиями и апдейтами винды для тестирования перед запуском софта в продакшн — всего 218 конфигураций ). На остальном же хранятся игрушки, bd-рипы и другая тяжелая фигня.

И да, я понимаю, что моя задача несколько нестандартна. Но полностью бесшумный системник в подобной конфигурации меня будет безумно, люто и бешено радовать, потому как тесты гоняются в основном ночью, а засыпать под скрежетание винтов — не самое большое удовольствие.

Вот.

Идея в том, чтобы вынести все винчестера куда-нибудь в другое место. Например, в соседнюю комнату, кладовку — куда угодно, где на их шум было бы наплевать. У меня, например, их 8 штук стоит, и все — WD Black. И их скрежетание периодически бесит (системник охлаждается по большей части пассивно, активное охлаждение только у винтов, собственно).

Дальше от этой самой кладовки кинуть оптику. Если квартира в состоянии ремонта — можно даже заранее развести розетки… пусть будет задел на будущее. В кладовке поднять ISCSI, и поставить на него винду\линукс\что угодно. И загружать это локальной машинкой через pxe preloader. Я уже пробовал сделать это с гигабитной медью — работало, но скорость была ни к черту.

А всех, кто сейчас тыкнет меня носом в SSD, можно смело посылать на яндексмаркет. Потому как мне даже приблизительно страшно представить, сколько будет стоить 16тб «чистого» сториджа на ссд. Реальный же обьем хранилища (с учетом рейдов) — 10Тб, и время доступа к 5Тб из них для меня критично ( виртуальные машины с всевозможными конфигурациями, сервиспаками, версиями и апдейтами винды для тестирования перед запуском софта в продакшн — всего 218 конфигураций ). На остальном же хранятся игрушки, bd-рипы и другая тяжелая фигня.

И да, я понимаю, что моя задача несколько нестандартна. Но полностью бесшумный системник в подобной конфигурации меня будет безумно, люто и бешено радовать, потому как тесты гоняются в основном ночью, а засыпать под скрежетание винтов — не самое большое удовольствие.

Вот.

+2

Но, согласитесь, не «домашняя» конфигурация. Вернее, не классическая домашняя конфигурация.

0

У меня, например, их 8 штук стоит, и все — WD Black.

8 двухтерабайтных WD Black? Это Сильно. У меня один терабайтный ночью спать мешает.

По сабжу: поищите, может, есть варианты с оптикой кроме iSCSI? Например, какой-нибудь SATA over fiber или что-то такое. А то у Вас с такой конфигурацией процесор будет забит прерываниями сетевой карты. Бегать будет быстро. Но работать — невозможно.

0

По сути сейчас существует 2 стандарта — ISCSI и AoE (ATA over Ethernet) для нормальной работы с удаленным диском. Более ничего не слышал никогда.

Или вы про «подключить диск непосредственно по оптике в мат.плату»? Тоже интересно, но, думаю, решение весьма непопулярно

Или вы про «подключить диск непосредственно по оптике в мат.плату»? Тоже интересно, но, думаю, решение весьма непопулярно

0

Оба не подходят, т.к. сеть будет слишком много жрать. Банально CPU не хватит прерывания молотить и пакеты разворачивать. Плюс, почитайте о DMA & PIO — о первом можете забыть. Становится очень грустно.

Да, я склонен поискать что-то вроде «подключить диск непосредственно по оптике в мат.плату». Или же подключить оптику в какой-нибудь сферический конвертор SATA->оптика (ну и наоборот со второй стороны). Правда, Google молчит, но я верю, что оно есть :).

Да, я склонен поискать что-то вроде «подключить диск непосредственно по оптике в мат.плату». Или же подключить оптику в какой-нибудь сферический конвертор SATA->оптика (ну и наоборот со второй стороны). Правда, Google молчит, но я верю, что оно есть :).

0

В теме про 90TB хранилище была микросхемка в стиле «разветвитель SATA».

Подумайте, ведь все, что вам нужно — упаковать 4 (в SATA же 4, кажется) провода в оптику. Судя по текущим тенденциям, 4 параллельных канала в оптику легко пакуются. Возможно, сами что-то соорудите.

Подумайте, ведь все, что вам нужно — упаковать 4 (в SATA же 4, кажется) провода в оптику. Судя по текущим тенденциям, 4 параллельных канала в оптику легко пакуются. Возможно, сами что-то соорудите.

0

4 параллельных — это уже WDM. На небольших расстояниях дешевле 4 волокна бросить :).

0

Я смотрю, вы хорошо осведомлены о высокоскоростных соедиениях Ethernet, как о меди, так и о не-меди. Можно ли вас попросить кинуть пару «ссылок» на «почитать»? А то у меня, думаю, как и у большинства хабровчан, знания на 1G по CAT5e заканчиваются, и присутствует некий миф про «оптика быстрее, выше, сильнее», мало чем подкрепленный.

0

Уххх. Сложны вопрос.

Так, чтобы популярно — нету вообще; по крайней мере, я не видел. Разве что это: nag.ru/articles/article/19974/kak-my-10gigabit-na-linux-routere-marshrutizirovali.html.

Если в плане высоких скоростей на PC — читать forum.nag.ru/ (хинт: ищите посты nuclearcat и его же вики), отчеты лабораторий Intel и Vyatta.

Так, чтобы популярно — нету вообще; по крайней мере, я не видел. Разве что это: nag.ru/articles/article/19974/kak-my-10gigabit-na-linux-routere-marshrutizirovali.html.

Если в плане высоких скоростей на PC — читать forum.nag.ru/ (хинт: ищите посты nuclearcat и его же вики), отчеты лабораторий Intel и Vyatta.

0

> Подумайте, ведь все, что вам нужно — упаковать 4 (в SATA же 4, кажется) провода в оптику.

Вы так это говорите, будто проще ничего и быть не может, как в чае сахар размешать ;)

Вы так это говорите, будто проще ничего и быть не может, как в чае сахар размешать ;)

+2

FibreChannel

0

А почему просто не расшарить той же самбой или фтп?

0

> По сути сейчас существует 2 стандарта — ISCSI и AoE (ATA over Ethernet) для нормальной работы с удаленным диском. Более ничего не слышал никогда.

А еще FC, FCoE, FCIP, iWARP.

Неужели про Fibre Channel ничег не слышали? Про диковинного кадавра AoE слышали, а про много лет успешно использующийся в этом качестве протокол — не слышали?

А еще FC, FCoE, FCIP, iWARP.

Неужели про Fibre Channel ничег не слышали? Про диковинного кадавра AoE слышали, а про много лет успешно использующийся в этом качестве протокол — не слышали?

0

Разве можно двумя адаптерами HBA FC соединять два ПК напрямую и инкапсулировать пакеты в Ethernet? Не приходилось работать с FCoE, но сколько не читал описания так и не понял про работу напрямую.

0

А это необходимо? Вообще отвечал я человеку, спросившему про «вынос дисков». FCP для «выноса дисков» подходит куда более прямо, чем iSCSI.

Что касается вашего вопроса, т FCP это просто протокол, FC — среда. И там, и там можно много что сделать. Например есть реализация протокола внутри FC, которая передает потоковое видео в кадрах FC.

Строго говоря чем отличается принципиально диск от хоста с точки зрения передачи данных?

Инкапсуляция в Ehernet это обязательное условие? FC в общем и сам себе Ethernet, транспортный уровень там свой.

Что касается вашего вопроса, т FCP это просто протокол, FC — среда. И там, и там можно много что сделать. Например есть реализация протокола внутри FC, которая передает потоковое видео в кадрах FC.

Строго говоря чем отличается принципиально диск от хоста с точки зрения передачи данных?

Инкапсуляция в Ehernet это обязательное условие? FC в общем и сам себе Ethernet, транспортный уровень там свой.

0

Ну просто тогда человеку придетсь, как минимум покупать полку хранения с FC выходом, а это уже выходит за рамки домашнего применения.

Я понимаю что это среда и там можно много чего сделать были бы знания и время, меня как раз интерисует если уже такии готовые варианты, например для такой схемы:

PC--HBA FC ----> HBA FC--PC-NFS-RAID. Инкапсуляция в Ethernet удобна прежде всего огромным колличеством программ работающих с Ethernet. Хотя конечно для высокой производительности неправлиьно городить над одним трансопртным протоколом другой, но в даном случаи я спрашиваю именно про домашнее применение.

Я понимаю что это среда и там можно много чего сделать были бы знания и время, меня как раз интерисует если уже такии готовые варианты, например для такой схемы:

PC--HBA FC ----> HBA FC--PC-NFS-RAID. Инкапсуляция в Ethernet удобна прежде всего огромным колличеством программ работающих с Ethernet. Хотя конечно для высокой производительности неправлиьно городить над одним трансопртным протоколом другой, но в даном случаи я спрашиваю именно про домашнее применение.

0

fc довольно дорог и не для дома. Дома решает езернет по цене.

0

Вообще сами FC HBA достаточно дешевые cgi.ebay.com/QLogic-QLA2460-Single-Port-4Gb-PCI-X-FC-HBA-Adapter-/270724483378?pt=COMP_EN_Networking_Components&hash=item3f086fc932 Можно половить вараинты и гораздо лучше

Просто интерисует возможно ли приведенная мной выше схема для FC.

Просто интерисует возможно ли приведенная мной выше схема для FC.

0

Не обязательно. Можно взять диски FC и подключить их в FC-AL.

> Инкапсуляция в Ethernet удобна прежде всего огромным колличеством программ работающих с Ethernet.

Программы работают не с «Ethernet», а с TCP/IP, а это все же разные вещи :)

«Ethernet» это 1 и 2 уровень OSI, а TCP/IP — 3 и 4.

> Инкапсуляция в Ethernet удобна прежде всего огромным колличеством программ работающих с Ethernet.

Программы работают не с «Ethernet», а с TCP/IP, а это все же разные вещи :)

«Ethernet» это 1 и 2 уровень OSI, а TCP/IP — 3 и 4.

0

«Ethernet» это 1 и 2 уровень OSI, а TCP/IP — 3 и 4.

Да конечно тут вы полностью правы, не совсем правильно выразился, тут конечно разговор про TCP/IP.

Диски с FS интерфейсом дорогии, тут как раз сама идея использовать обычные sata диски, я понимаю что NetApp таким не занимаеться, просто интерисует сам вопрос если такое?

Да конечно тут вы полностью правы, не совсем правильно выразился, тут конечно разговор про TCP/IP.

Диски с FS интерфейсом дорогии, тут как раз сама идея использовать обычные sata диски, я понимаю что NetApp таким не занимаеться, просто интерисует сам вопрос если такое?

0

Раз уж вы сами выше привели ebay, то давайте посмотрим там не только HBA, но и диски.

300GB 10K — 55$

Целая полка, 14 штук 300GB 10K, за 1300$

Там такого много.

300GB 10K — 55$

Целая полка, 14 штук 300GB 10K, за 1300$

Там такого много.

0

Все такии для дома цена за 1,5k зеленых единиц не для домашнего использования, это еще и без дисков. Так то я понимаю что если используешь FC покупай полку, получаеться вариант описанный мной выше, не получиться на FC адаптерах!

0

Нет, вы не разобрались.

PS. Я ничуть не агитирую за FC, я вообще считаю, что FC на сегодня, в 2011 году, это тупиковый путь.

Но хоть Платон (Ethernet) мне друг, но истина мне дороже, и аргументы ваши за него слабы.

PS. Я ничуть не агитирую за FC, я вообще считаю, что FC на сегодня, в 2011 году, это тупиковый путь.

Но хоть Платон (Ethernet) мне друг, но истина мне дороже, и аргументы ваши за него слабы.

0

А в чем думаете будет сила?

Я думаю что все таки езернет победит почти все.

Из конкурентов в этом сегменте знаю только fc и infiniband.

На что будет нетапп ориентироваться?

Я думаю что все таки езернет победит почти все.

Из конкурентов в этом сегменте знаю только fc и infiniband.

На что будет нетапп ориентироваться?

0

Это все бушное, а в плане винтов это не айс и нет гарантии никакой.

0

У вас все равно останется охлаждение видео\процессора

— Если не требуется охлаждения видео\процессору, значит системник не столь мощный, чтобы не вынести его самого в другую комнату

И, да, как думаете, сколько будет стоить такой кабель, например, метров 10? Я сильно сомневаюсь, что 5 метров вам хватит.

— Если не требуется охлаждения видео\процессору, значит системник не столь мощный, чтобы не вынести его самого в другую комнату

И, да, как думаете, сколько будет стоить такой кабель, например, метров 10? Я сильно сомневаюсь, что 5 метров вам хватит.

0

Дальнобойная беспроводная мышка + клавиатура + длинный кабель для монитора.

Как Вам идея?

Как Вам идея?

+1

Позвольте поинтересоваться какой корпус вы используете? Существуют замечательные корпуса в которых HDD крепятся таким образом что не шумят практически. В частности Zalman Z7(специальная корзина для крепления с антивибрационными прокладками). 3 жестких диска разного объема. из низ 1 му уже года 4 второму лет 5. После того как я установил их в этот корпус шум исчез. В итоге самой громкой железякой остается видеокарта.

0

НЛО прилетело и опубликовало эту надпись здесь

Вот тут тоже варианты для размышлений — если надо просто связать 2 компа — то очень даже неплохой вариант: www.colfaxdirect.com/store/pc/viewPrd.asp?idproduct=12&idcategory=6.

+2

на мгновение мне показалось, что сейчас кончу

-3

cat /proc/interrupts |grep eth

покажите пожалуйста, а так же ядро и версию используемого драйвера

покажите пожалуйста, а так же ядро и версию используемого драйвера

0

Смогу выложить только завтра, сейчас карта не в линуксе, а в линуксе собирается рейд и не охото останавливать.

0

ok подождем :)

0

root@snow:~# cat /proc/interrupts |grep eth

56: 73504710 0 0 0 PCI-MSI-edge eth0

67: 59 0 0 0 PCI-MSI-edge eth3-TxRx-0

68: 23 35 0 0 PCI-MSI-edge eth3-TxRx-1

69: 23 0 38 0 PCI-MSI-edge eth3-TxRx-2

70: 23 0 0 31 PCI-MSI-edge eth3-TxRx-3

71: 2 0 0 0 PCI-MSI-edge eth3:lsc

10 гигабитный линк eth2 и eth3

А что вас именно интересует в прерываниях.

56: 73504710 0 0 0 PCI-MSI-edge eth0

67: 59 0 0 0 PCI-MSI-edge eth3-TxRx-0

68: 23 35 0 0 PCI-MSI-edge eth3-TxRx-1

69: 23 0 38 0 PCI-MSI-edge eth3-TxRx-2

70: 23 0 0 31 PCI-MSI-edge eth3-TxRx-3

71: 2 0 0 0 PCI-MSI-edge eth3:lsc

10 гигабитный линк eth2 и eth3

А что вас именно интересует в прерываниях.

0

Кстати я чертовски люблю ваш репозиторий, он мне съэкономил миллион времени.

0

Не боитесь, что собака перегрызет эти дешевые кабеля за 2-3к рублей?)

0

Раз речь о 10 гиг/c, можете измерить скорость сети (без ограничении системы I/O — HDD), если машина позволит (быстрый проц и достаточно памяти).

информация: Как получить и измерить высокоскоростное соединение по TCP

Результаты работы карточки и влияние на нагрузки проца / скорости передачи интересно посмотреть.

информация: Как получить и измерить высокоскоростное соединение по TCP

Результаты работы карточки и влияние на нагрузки проца / скорости передачи интересно посмотреть.

0

Недавно купил такие карты, наткнулся на неприятнейшие грабли, всем для информации:

1. Три попробованных DirectAttach-кабеля от HP (конкретно x240) не заработали с тремя попробованными картами.

2. Интел проверяет тип SFP-модулей в драйверах, если не интеловские SFPшки, драйвер выводит «Unsupported SFP + module» и тупо гасит интерфейс. Либо используйте из HCL либо патчите драйвера. Пользователи Windows и VmWare ESX(i) горько плачут.

1. Три попробованных DirectAttach-кабеля от HP (конкретно x240) не заработали с тремя попробованными картами.

2. Интел проверяет тип SFP-модулей в драйверах, если не интеловские SFPшки, драйвер выводит «Unsupported SFP + module» и тупо гасит интерфейс. Либо используйте из HCL либо патчите драйвера. Пользователи Windows и VmWare ESX(i) горько плачут.

0

Жду недождусь, когда начнут делать Thunderbolt->SFP 10G и Thunderbolt->Eth 10G

вот тогда будет рай на земле))

вот тогда будет рай на земле))

+1

Вот тут, в сентябре 2013 года всё не так плохо как кажется :)

Вариантов есть минимум три (сейчас планирую тестирование, а позже хочу о домашнем 10G пост сделать):

1) mLoginc mLink — половинной длины PCI-E расширитель. — 375$ Amazon

2) OWC Mercury Helios Thunderbolt PCIe Expansion Chassis with Dual Thunderbolt Ports ( — 350$ Amazon

3) Классика: Sonnet Technologies Echo Express SE Thunderbolt Expansion Chassis — 350$ Amazon

2 и 3 вроде полной длинны. (QLogic'а дешевого нет). А для первого вот HCL.

Но взяв карту на ебейе за 200 можно за 550 получить адаптер. И даже при покупке интела за 9500p и за столько же вышеупомянутую карту — получим:

Thunderbolt->2xSFP+ 10G.

Пока что громоздко, но уже доступно (если вам реально нужно дома/на работе 10GBit — эта цена для вас нормальна).

Вариантов есть минимум три (сейчас планирую тестирование, а позже хочу о домашнем 10G пост сделать):

1) mLoginc mLink — половинной длины PCI-E расширитель. — 375$ Amazon

2) OWC Mercury Helios Thunderbolt PCIe Expansion Chassis with Dual Thunderbolt Ports ( — 350$ Amazon

3) Классика: Sonnet Technologies Echo Express SE Thunderbolt Expansion Chassis — 350$ Amazon

2 и 3 вроде полной длинны. (QLogic'а дешевого нет). А для первого вот HCL.

Но взяв карту на ебейе за 200 можно за 550 получить адаптер. И даже при покупке интела за 9500p и за столько же вышеупомянутую карту — получим:

Thunderbolt->2xSFP+ 10G.

Пока что громоздко, но уже доступно (если вам реально нужно дома/на работе 10GBit — эта цена для вас нормальна).

0

Да смысла нет, на ноуте такая скорость нафиг не нужна ну или же проще хранилище напрямую через thunderbolt подключать. Счастья там никакого по моему нет.

0

В случае покупки нескольких MacPro 2013 для монтажа видео (например), через thunderbolt не подключить — там DAS.

0

подключите нас

0

10Gbit нас — как раз через вышепоказанные адаптеры только и подключить. По крайней мере пока Apple не начал продавать адаптеры на 10GBase ;)

+1

мне казалось что как раз в thunderbolt как раз для этого и делался чтобы последовательно подсоединять устройства, а их отсутствие мне кажется только от отсутствия спроса.

0

Последовательно, но с одним хостом. thunderbolt — это фактически PCIe in the cable. То есть 6 устройств в один порт. Но вот два компьютера — нельзя.

+1

Печаль спасибо что разъяснили.

0

Удивительное рядом, похоже на адаптерах TB (этого года только?) можно сделать соединение точка-точка между двумя маками с целью использовать программу migration assistant для переноса данных.

То есть теоретически жить можно, но никаких данных о скорости (кроме мнений на форумах, что очень медленно) нет.

То есть пока что так же как и firewire.

Возможно мифический TB2 (который в новом MacPro) будет что-то уметь…

Но для наших целей — бюджетно NAS подключить, имхо, 100% не подойдёт TB. А DAS'ами я очень доволен WD-ными зеркалами.

То есть теоретически жить можно, но никаких данных о скорости (кроме мнений на форумах, что очень медленно) нет.

То есть пока что так же как и firewire.

Возможно мифический TB2 (который в новом MacPro) будет что-то уметь…

Но для наших целей — бюджетно NAS подключить, имхо, 100% не подойдёт TB. А DAS'ами я очень доволен WD-ными зеркалами.

0

Исправляюсь :) Свитчей нет и не будет, а локальные соединения точка-точка вполне себе работоспособны на современных маках. Про надежность и стабильность пока сказать ничего не могу, но вот тест двух ноутов ретина.

В новом MacPro — 6 портов Thunderbolt'а — теоретически может выступать в качестве внутреннего свитча с портами по 7 гигабит…

В новом MacPro — 6 портов Thunderbolt'а — теоретически может выступать в качестве внутреннего свитча с портами по 7 гигабит…

0

10 гигабитное кольцо — это STP? А какой софт поддерживает?

0

Зарегистрируйтесь на Хабре, чтобы оставить комментарий

10 гигабитный линк дома?