Это 8 Тбит/с (при использовании 80 длин волн с пропускной способностью 100G).

С 2006 года я сдал в эксплуатацию коммутационное оборудование полутора дюжинам банков. И ещё ряду объектов, которые не могу упоминать. Это те самые каналы, где в скорость синхронной репликации нагло и подло вмешивается скорость распространения света в оптоволокне.

Случается, что заказчики сначала строят ЦОДы, а потом задумываются, как связать их при помощи WDM. Аналогию можно привести с транспортными развязками в Москве, когда сначала строят многоэтажные здания а потом понимают, что дорога в две полосы не справляется с транспортным потоком, и строят дорогостоящие трёхуровневые развязки на пяточке земли, хотя куда более логичным было бы заложить место под будущие дороги и развязки, а уже после строить дома.

Ниже я рассказываю о нескольких типовых случаях архитектуры, где очень легко поймать ошибку масштабирования или неверного резервирования. И про магию «работает – не трогай».

Сразу скажу, что специалист, имеющий опыт проектирования оптических сетей, может сделать хороший DWDM-проект. Дьявол, конечно, в деталях, а именно в поиске компромисса между ценой и функциональностью. Наверняка вы примерно представляете, с какой скоростью растут требования к каналу вашего дата-центра. С оптикой история такая же, как с серверами: можно купить точно под текущие потребности и менять всё через полгода, когда выйдет новая версия ERP, а можно взять «на вырост», чётко понимая, как расти дальше.

Что это вообще такое

По мультиплексору-демультиплексору на каждой стороне, оптика в середине. По сравнению с тёмной оптикой для передачи сорока каналов 10G потребовалось бы 40 оптических пар, когда при использовании технологии DWDM потребуется только одно оптическое волокно.

Система WDM кроме решения задач по передаче трафика может решать задачи по резервированию. В ряде случаев достаточно установки всего нескольких дополнительных плат — и мы получаем систему с резервированием «по линии». На приёмной и передающей стороне устанавливаются устройства, которые передают весь трафик по одной паре оптических волокон основного направления. При обрыве в течение не более 50 мс (среднее время в нашей практике – 23 мс) они переключается на резервное направление.

Очень важный момент: если изначально закладывать систему как транспортную сеть с возможностью коммутации оптических линков при помощи ROADM, а не нагромождать существующее оборудование «тёмной оптикой», можно было бы в будущем избежать множество проблем, с которыми сейчас сталкиваются наши заказчики. Это я к вопросу правильного планирования масштабирования.

Обычная ситуация — крупная компания объявляет тендер или конкурс на построение инфраструктуры между своими дата-центрами (или своими ЦОДами и ЦОДами партнёра, либо критичными узлами входа в магистраль). А дальше начинается лютая история с непониманием, как нужно делать. На тендер проходит 5-6 компаний, из которых 2-3 стабильно предлагают цены на порядок ниже. С ними достаточно просто – скорее всего, их проект или не будет работать по спецификации, или же попросту не будет соответствовать требованиям заказчика после приёмки. Эти грабли опытные IT-руководители обходят, но сразу после встают перед другой дилеммой: а как выбрать из трёх оставшихся предложений?

Здесь можно только глубоко копаться в параметрах проекта. К примеру, для банков каждый такой случай – это баланс между бюджетом, надёжностью и производительностью системы. Вопрос в том, насколько грамотно всё спроектировано и насколько правильно подобрано оборудование. Объяснить на пальцах очень и очень сложно, но я попробую привести примеры.

Типовая ситуация

При соединении двух точек просто закладывается два независимых канала. Что будет, если приедет экскаватор и намотает один из каналов на ковш? Среагирует ли оборудование за миллисекунды для построения нового маршрута? Что будет с уже отправленными данными (застрявшими «прямо в ковше»)? Что случится при выходе из строя мультиплексора? Допустим, затопило полностью всю площадку или пожар на площадке. Система должна в автоматическом режиме, с минимальным временем переключить имеющиеся у нее каналы таким образом, чтобы связь не пропала. И время там совершенно не такое, как у человеческой реакции – счёт в тех же банковских транзакциях идёт на миллисекунды.

Экскаваторщик ещё не понял, что сделал, а данные уже делают крюк в 200 километров, обходя нашего героя.

Проекты

За последний год резко выросло количество проектов с распределёнными ЦОДами. Растёт инфраструктура, растёт количество данных, дата-центры увеличиваются в масштабах. Именно один ЦОД, в котором сконцентрированы все бизнес-критичные данные плюс процессы обработки информации, это как-то не очень разумно. Фактически – единая точка отказа, благо примеров даже в банковской сфере было уже достаточно.

И вот в этот момент, когда принимается решение о строительстве распределённого ЦОДа, возникает вопрос со связью. Как делать связки внутри ЦОДа всем понятно – если это Ethernet, вообще не вопрос, если FC — в целом, тоже, Infiniband используется пока редко (это самая молодая технология сейчас, но в перспективе весьма востребованная). А вот то, как правильно построить инфраструктуру для объединения ЦОДов – здесь начинаются грабли.

Простой пример: тёмная оптика и WDM

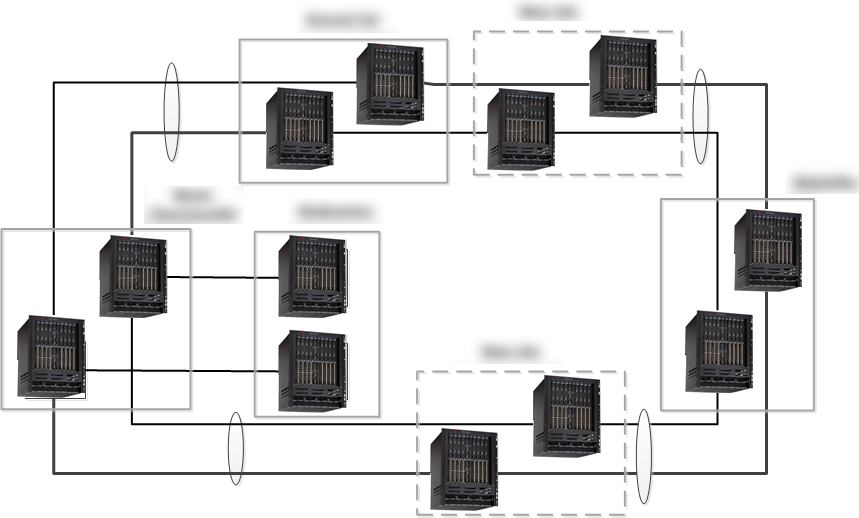

Моя команда в КРОКе создаёт сложную катострофоустойчивую DWDM систему. Планируется связать три дата центра и тестовую площадку заказчика. В целях отказоустойчивости было принято решение о создании двух независимых колец.

Топологическая схема DWDM c использованием двух независимых колец

Изначально заказчик думал о тёмной оптике, поскольку решение получалось достаточно простым архитектурно и, казалось, что дешевым. Тем не менее, для передачи нужного количества трафика пришлось бы задействовать порядка 30 оптических пар на каждое кольцо. Почти все участки колец проходили бы в одном кабеле, и по этому потребовалось бы около 60 пар оптики. Так же расстояние, которое требовалось бы преодолеть по «тёмной оптике» было около восьмидесяти километров, что не позволило бы преодолеть без усиления сигнала. Тогда пришлось бы добавлять два дополнительных сайта которые выполняли роль исключительно ретранслятора.

Топологическая схема без использования DWDM

Таким образом, грамотная постановка задачи (точнее – понимание архитектуры) сделала очевидным, для заказчика, вопрос выбора технологии.

Чуть посложнее: выбор оборудования узла

Решается вопрос выбора оборудования и архитектурного решения сети DWDM. Изначально непонятно какой конкретно и в каких объёмах трафик будет передаваться. Также до конца не была понятна топология сети (она развивалась). Требования заказчика порой менялись в течение двух недель по мере поступления новых аналитических данных и новых планов на развитие. Естественно, заложить в проект систему, которая изначально перекрывала бы все возможные требования заказчика — безумно дорого.

Заказчик активно масштабировался, но не мог предсказывать дальше двух лет. Мы сошлись на том, что сеть строится с узлами, которые имеют резерв в горизонте планирования. Далее при росте трафика сеть могла быть расширена в полтора раза без замены шасси, без применения новых технологий и без принципиального изменения архитектуры. В линию между площадками суммарно передавалось более 200 Гб/с трафика.

Архитектура — 3 плоских кольца, 5 мультиплексоров, линейное резервирование. Нечётное количество мультиплексоров объясняется тем, что один мультиплексор принимал две линии, и исполнял функцию 2 устройств. Такая архитектура позволила не использовать матрицу кросс-коммутации для организации резервирования и обойтись более дешёвыми Optical Line Protection модулями. При этом система только выиграла от такого решения, поскольку по бэкплейну не передавалось никакого трафика.

Если говорить проще, мы умышленно сделали функционал мультиплексоров менее гибким, но при этом увеличили надёжность и снизили стоимость узлов. Разумеется, для точного просчёта нужно было проверять сотни параметров и не один десяток раз пересчитывать проект с инженерной командой.

Третий пример: надёжности не бывает много

Изначально, при построении системы DWDM, основным критерием была отказоустойчивость. Может показаться, что резервирование излишнее, но это не так. Была выбрана система полного резервирования 1+1 и дополнительно заложено резервирование по линии. Для чего это было сделано? Дело в том, что при полном резервировании 1+1 и обрыве оптического кабеля, пропадает трафик в одной из систем до восстановления оптического кабеля. При комбинированном резервировании при обрыве кабеля трафик в одной из систем пропадает только на 50 мс и менее (в нашем случае) после чего происходит переключение, и обе системы работают на полную мощность, что позволяет заказчику передавать экстра трафик через одну из систем. Так же такая система позволяет пережить как однократный обрыв кабеля, так и одновременный выход из строя любого из узлов в случае того же пожара.

Пример одного особо крупного банка

Мы делали связку для трёх ЦОДов банка и двух своих, где у них есть ряд критичных сервисов. Мы, фактически, увязывали две инфраструктуры — собственную инфраструктуру и инфраструктуру заказчика. Связь – оптика с DWDM. Изыскивался оптимальный набор оборудования, отвечающий именно конкретной топологии и именно конкретным задачам. Далее проектировались и настраивались алгоритмы работы данной сетевой структуры (по факту – кольца с двумя рассечками). На каждой точке есть полный каталог сценариев выхода из строя площадок полностью, каждого отдельного узла, канала, физической линии и комбинаций этих факторов – своего рода большие таблицы типовых реакций. Разрабатывался даже сценарий «а если, например, одновременно выходит из строя работа мультиплексора и при этом на совершенно другом участке рвется линия». В теории это маловероятно, но я знаю как минимум два случая у оператора и банка, когда такое происходило с разницей в часы. Законы Мэрфи в магистральной сфере работают как нигде. Ну и злой умысел в сценариях тоже не исключался.

Вот карточка проекта другого банка, всё ещё крупного, но уже не такого крупного:

• Оборудование MSTP 15454E Cisco Systems

• Три площадки (основной ЦОД, резервный ЦОД, операторская), расстояние 5-20 км

• Топология сети – полноценное кольцо

• Клиентские интерфейсы между ЦОДами – 10GE – 8 шт., FC-800 – 8 шт., FC-400 – 4 шт., GE – 16 шт.

• Клиентские интерфейсы от каждого ЦОД до операторской площадки – FE/GE – 8 шт.

• Используется защита клиентского сигнала — в случае одиночного разрыва кольца сигнал переключается на другое направление в течение 50 мс

• Используются мультиплексоры на 40 каналов (длин волн)

• Используются транспондерные платы — клиенты подключаются многомодовой оптикой или медью

• Используется питание 220 В от двух блоков питания

• Площадки ЦОД использовали 5 шасси конструктива M6 (6 слотов под линейные карты), операторская площадка – 2 шасси.

• Типовой комплект оборудования ЦОД занимает 34 RU стоечного пространства

• Работы по развертыванию и запуску системы выполнены силами двух человек в течение месяца

• Оптика под нужды DWDM выделялась поэтапно по мере переноса функционала существующей сети на уже запущенные участки новой транспортной сети

Вот ещё один похожий пример:

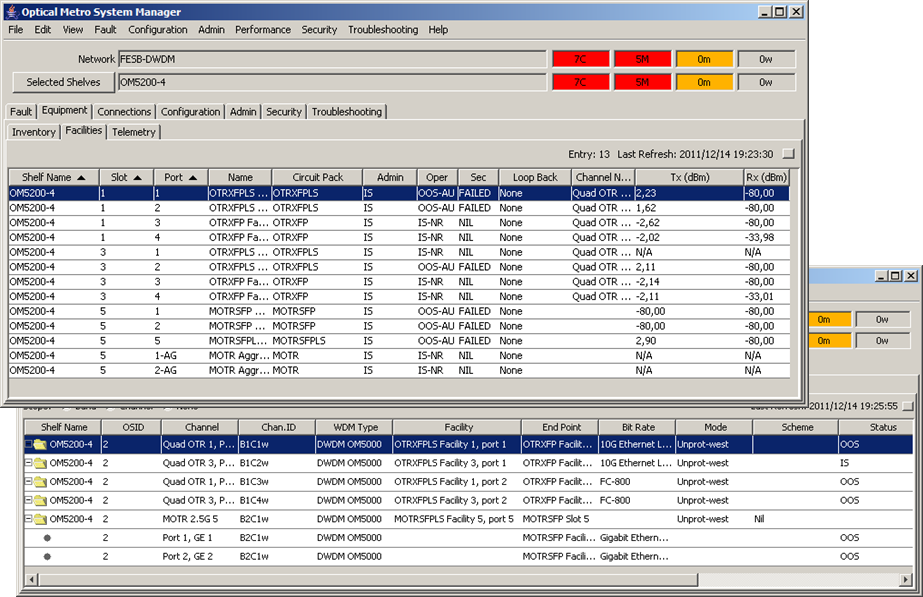

Вот так выглядит само железо:

Интерфейс управления (один из вариантов):

Результат

Как правило, на входе у нас есть банк или другой подобный заказчик с собственной оптической линией, которому требуется новая система передачи данных (точнее, глубокая модернизация старой). Специфика таких каналов в России такова, что пока работает – лучше не трогать. Модернизация происходит тогда и только тогда, когда заказчику требуется расширение по скоростям, а не по факту выхода новых технологий.

В ходе проекта мы строим надёжную DWDM-сеть. Монтаж DWDM открывает возможности для роста без замены оптики.

Несколько общих ликбезовых советов:

- Чаще всего отказывают блоки питания, вентиляторы и клиентская оптика. Нужно держать части в горячем резерве и заранее закупать с запасом. Мы так и делаем, зная показатели поломок за год.

- Поддержка питания от 220 VAC очень удобна на практике (если только вы не сотовый оператор).

- DWDM — это спектральное уплотнение, а не сжатие трафика. Мы работаем с сигналом на физическом уровне. Есть ещё именно оптимизация на уровне протокола и выше, она решает другие задачи — вот детали коллег, которые ей занимаются.

- Защита (Protection Switching/Trunk Switch) может быть реализована как на уровне мультиплексированного сигнала (дешево, но небезопасно), так и для каждой длины волны по отдельности (дорого, но надежно).

- Использование настраиваемых XFP, SFP+ позволяет унифицировать оборудование и уменьшить стоимость ЗИП, но увеличивает стоимость спецификации в 1,5-2 раза по сравнению с фиксированными XFP (10 Gigabit Small Form Factor Pluggable), SFP+ (Enhanced small form-factor pluggable).

- Одна из частых проблем модернизации – попытки незначительной оптимизации. Когда заказчик сам закладывает систему, требующую постоянных донастроек, доустановки оборудования раз в полгода и т.п., возникает феномен как в анекдоте про «солнышко всходит и заходит». Почти все связисты сталкивались с тем, что стоит вам просто потрогать оборудование – и вот проблемы начинают лезть из всех щелей. Можно сколько угодно смеяться над этим, но при реально шаманских самостоятельных решениях, билинг банка может встать на сутки, пока команда разбирает, что же случилось. Такие риски вряд ли кому-то нужны, поэтому правильная архитектура подразумевает и сразу чёткое понимание того, как и где будет модернизироваться узел.

Резюме

За 9 лет наша команда получила очень интересный опыт работы с бывшим Нортелом ныне — Сиеной, Циской, Хуавеем, MRV, Х-террой и другими вендорами. Были и внедрения отечественных производителей. В итоге появилось точное понимание специфики оборудования (повторюсь, в задаче магистрали для оператора специалисты круче на голову есть в самих операторах) — но вот именно в плане построения надёжных сетей, думаю, почти все возможные грабли мы знаем. Если вам вдруг интересно разобрать какой-то нюанс или понять, как правильно проектировать-считать – спрашивайте в комментариях или по почте AFrolov@croc.ru.

И, пользуясь случаем, передаю пламенный привет всем тем, кто копает в городской черте без разрешений на строительство.