Комментарии 62

Имеется ввиду воздействие колебаний напряжения в единой электросети.

Или использовался независимый источник электропитания.

Требуется отметить что средние значения остаются неизменными, меняется функция распределения.

но максимальная сходство функций плотности вероятности неожиданно именно на +369 минуте.Судя по Вашему коду на гитхабе, Вы очень странным образом оцениваете плотности распределения по исходным данным:

- Сначала исходная последовательность количества отсчетов детектора в секунду делится на выборки по koeff=60 (целочисленных) отсчетов;

- Потом для каждой такой выборки строится гистограмма из ko=60 столбиков;

- Далее гистограмма сглаживается.

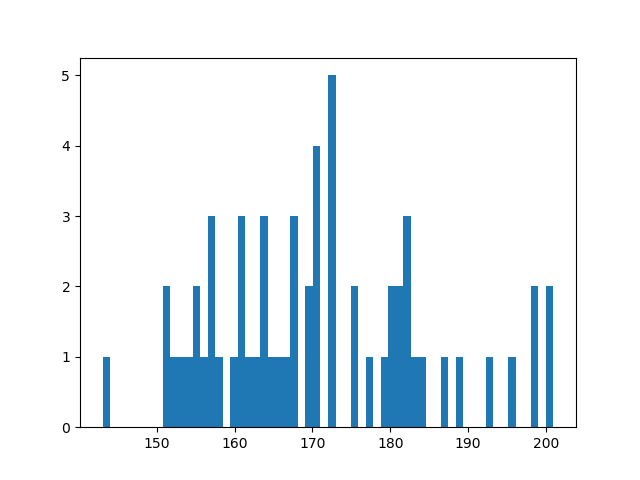

Требование, что число столбиков должно быть много меньше числа отсчетов, очевидно не выполняется. В результате, то, что у Вас получается, гистограммой назвать сложно. Ниже — результат вашей обработки первой 60-секундной выборки из файла 0505.txt:

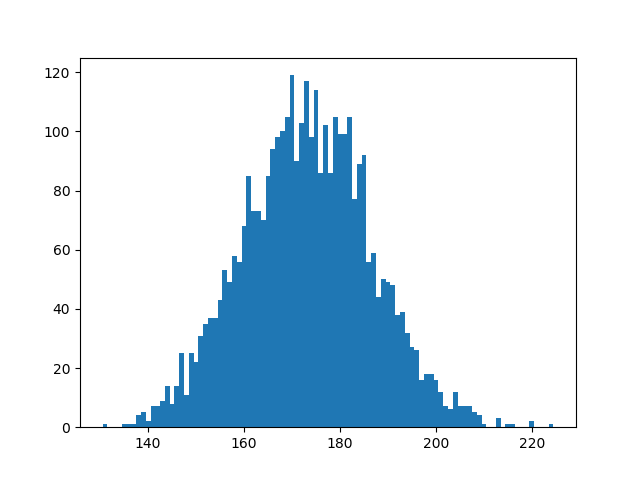

Есть еще одна проблема, которая заключается в том, что измерения целочисленные, и их диапазон для практически каждой выборки не кратен числу столбиков гистограммы. Т.е. если даже взять более длинную выборку, скажем первый час (3600 отсчетов), и повторить построение диаграммы по вашему способу, то можно увидеть вот такое безобразие:

Ну, да, Вы потом эти «зебры» сглаживаете, но где доказательство, что при этом функция распределения не искажается? Ага, хотя бы с использованием критерия Колмогорова-Смирнова. Да еще стоит добавить к сравнению исходное кумулятивное распределение числа отсчетов, до того, как его, возможно, «испортили» описанными выше процедурами.

На всякий случай, «правильная» максимально подробная часовая гистограмма, полученная с помощью

plt.hist(values, bins=numpy.max(values)-numpy.min(values)+1, range=(numpy.min(values)-0.5, numpy.max(values)+0.5))

максимальная сходство функций плотности вероятности неожиданно именно на +369 минуте.Про «неожиданно»… Разве это не означает, что для всех других разностей времен формы «минутных» распределений заметно непохожи друг на друга? Критерий Колмогорова-Смирнова это подтверждает? А иначе получается, что Вы берете ряд типа 1,1,1,1,1,… и утверждаете, что каждое измерение совпадает с плюс десятым в списке.

И в конце небольшой философский вопрос. Почему Вы использовали минутные выборки (по 60 значений)? Природа про минуты, впрочем как и другие шкалы измерения времени, не знает. Т.е., что случится с вашими выводами, если размер выборки изменить? Скажем, на 77? Я, после того, как окончательно пойму, что Ваш код делает, проверю.

Последнее — ничего не должно измениться. При выборке в 2 минуты (по 120 значений). На 718 отсчете будет проявляться звездные сутки.

Для меня было шоком, когда нашелся звездный год. Проверьте его обязательно

Послушайте, ну это просто ненаучно: давайте неправильно обработаем данные и будем искать в них закономерности, это астрология какая-то.

Для меня было шоком, когда нашелся звездный год. Проверьте его обязательноДля того, чтобы проверить, хотелось бы понять, что находится в ваших файлах 0505.txt и 0506.txt? В каждом из них 172800 строк, т.е. по 48 часов наблюдений.

- Один файл — данные типа за первые 48 часов первого года, второй файл — 48 часов второго года?

- Или первые сутки в каждом файле — один год, вторые сутки — другой?

- Или еще как-нибудь иначе?

А то я хоть и сделал ваш код более чем в 10 раз быстрее, но все равно, если статистику собирать, не очень быстро получается.

0506.txt — другой год

days.dat — две недели альфа распад

Но начну я с того, что ваш код, вычисляющий «расстояние» между сглаженными «гистограммами» (строки 182-204 из вашего кода) часто выдает разный результат в зависимости от порядка, в каком ему «выдаются» данные. Например, если рассмотреть 3-ю и 4-ю выборку (индексация, начиная с нуля) из файла 0505.txt, то:

distance between #3 and #4 = 7.98634661639

distance between #4 and #3 = 18.7975453121

Несимметричная мера, это очень серьезная ошибка, то есть теперь все ваши утверждения про наличие всяких циклов длиной в звездный день, год в процессе радиоктивного распада уже можно считать недоказанными. Исправляйте. Ну а я пока в своем анализе буду использовать полусумму (d(x,y)+d(y,x))/2.

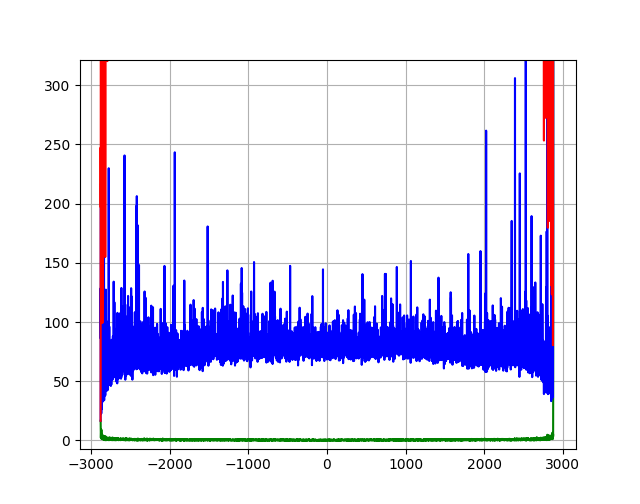

А теперь я приведу результаты анализа, так сказать, кросс-корреляции двух временных рядов. Алгоритм был такой:

- Из первого 48 часового массива отсчетов дектектора (0505.txt) были с использованием Вашего алгоритма получены 2880 «минутных» сглаженных «гистограмм» G1[i];

- Из второго 48 часового массива отсчетов дектектора (0506.txt) были получены 2880 «минутных» сглаженных «гистограмм» G2[i];

- Далее для диапазона временных сдвигов dt от -2880 мин до 2880 мин были получены выборки вида distance(G1[i], G2[i+dt) для максимально возможного диапазона индекса i (чтобы не вылететь за границы массив, т.е. от -2879 до 2879).

- Для каждой такой выборки были посчитаны ее минимум, среднее, максимум и 5%, 50% и 95% квантили;

- Для этих данных были построены графики их зависимостей от dt

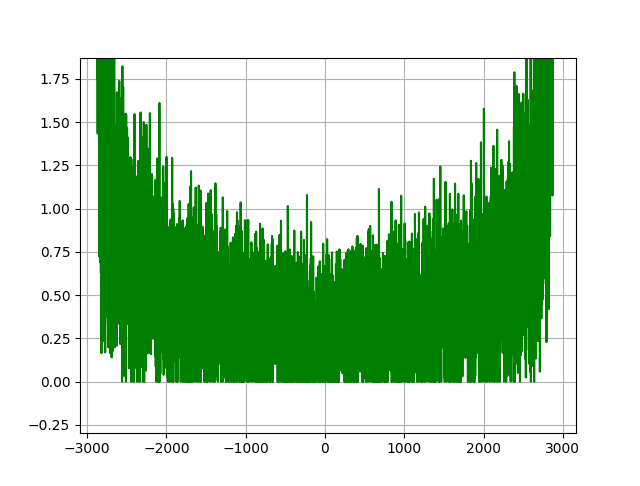

Резюме: с использованием Вашего способа построения «сглаженных гистограмм» и Вашего же (симметризованного, см. выше) способа вычисления «расстояний» между этими «гистограммами» никаких статистически значимых признаков годовой цикличности не выявлено. Подробности — под спойлером.

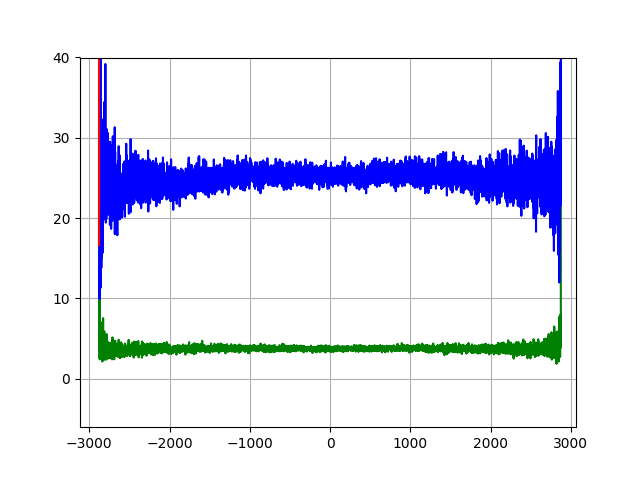

Если поменять шкалу по оси Y, то становится видна зависимость среднего расстояния между гистограммами из разных годов в зависимости от того же сдвига dt (синий цвет). Опять — никаких следов годовой кросс-корреляции.

Если еще увеличить шкалу, то становится видна зависимость минимума между гистограммами. Выборки большие, нулей (идеально похожих гистограмм из разных годов) много, но они равномерно распределены по сдвигу. Может, там и есть ноль на упоминаемых автором обсуждаемой публикации ± 369 минутах, но это ничего не значит. Ну, и понятно, что и минимум по выборке, и максимум имеют статистически сильный разброс, т.е. я и не ожидал тут ничего интересного увидеть, но уж чего бы этот «лес» не показать.

И, наконец последний график — 5% квантиль (зеленый цвет) и медиана. И снова, кроме зависимости разброса от длины выборки, ничего нет. С моей точки зрения плоский график 5% квантиля — это самое сильное доказательство отсутствия периодичности. Т.е. если хотя бы 5% диаграмм из одного года были сильно похожи на гистограммы другого года на периоде, то график бы имел минимум. Но его нет.

И в заключение — Ваш код на гитхабе годовой периодичности процесса бета-распада на ваших же данных не показывает. Это может проверить любой квалифицированный программист, выдрав нужные куски из вашего кода, оптимизировав его (ну, зачем вы в цикле читаете данные из одного и того же файла?) и реализовав мою «внешнюю» обвязку, описанную выше.

Может быть, вас есть «правильный» код? Покажите его, пожалуйста. Или, хотя бы опубликуйте алгоритм, чтобы его можно было повторить. А иначе окажется, что Вы совсем зря здесь опубликовались…

Если Галилей проделает очень много опытов и построит общую гистограмму (по вертикали число опытов, по горизонтали время скатывания), то получит чистый гаусс.Нет. Гаусс получается, когда «работает» центральная предельная теорема. А вашем гипотетическом эксперименте есть некоторый неслучайный (квази)периодический эффект, который вылавливается, например, спектральным анализом временного ряда.

Если бы вместо одной гистограммы он построил бы множество, гистограммы получились бы серьёзно отличные от гауссаИменно. И друг от друга тоже отличные. Все правильно Вы говорите — нужно доказать, что распределения в разные периоды времени — разные. А вот автор обсуждаемой публикации ищет и пытается показать наличие сходства распределений с использованием весьма неестественной метрики, да еще такой, что иногда distance(x,y) != distance(y,x). Вот взял бы он критерий Колмогорова-Смирнова (максимальное различие между кумулятивными распределениями), спорить было бы сложнее. Фокус только в том, что на маленьких выборках большие значения критерия статистически не значимы… Та же фигня творится, кстати, и с точностью оценки/сравнения параметров распределений на малых выборках. Ну, Вы же должны понимать, что это фундаментальная проблема, т.е. как данные не обрабатывай, а точности не будет? Только хуже может стать.

А потому такие «несостоятельные» гистограммы, которые приводит автор статьи, вообще-то говоря имеют полное право на жизнь и представляют отдельный интерес.Вы можете привести хотя бы еще один пример использования такого подхода? Корректного! Я еще раз повторю, что что для дискретных случайных процессов нельзя выбирать границы и число интервалов для построения гистограмм произвольно, как это сделал автор. А последующее 5-кратное сглаживание с использованием прямоугольного окна длиной 4? Эти параметры откуда взялись?

Ну еще про использование гистограмм, построенных из последовательных выборок, Автор использовал серии по 60 измерений. Ну я я сдублировал его файл и отрезал от дубля первые 30 секунд, А потом посмотрел на кросс-корреляцию минутных гистограмм из обоих файлов. Так-вот — пропала корреляция. Как будто сравнивались два совсем разных файла… И хватит на этом.

Если повышается вероятность распада в препарате, то должна повышаться и вероятность распада и в массивных процессах типа реакторов. Неужели никто этого не заметил?

Ок, плотность вероятности.

Но мы ведь говорим о «вероятности распада» очень условно, на самом деле у нас вероятность распада на вероятность ухода осколков именно в объём счётчика, которая есть чистейшая случайность. Получается звёзды знают о его положении тоже? )

Только даёт ли это нам знание о запрещённых\разрешенных состояниях конкретно в нашем отрезке времени, и что мы можем практически с этим знанием сотворить…

… сам в своё время изучал фликершум и ИМХО тут вся беда в интерпретации результатов, требующей широкого физико-математического кругозора, причём и там и там с залётами в фундаменталку

Кому интересно, смотрите вариации кумулятивной дельты от RSI до кластерного анализа.

1. Главная — выборки малые. Закон больших чисел попросту ещё не работает.

Чтобы точно подтвердить, есть что-то или нет, надо измерения проводить, пожалуй, не ограниченными выборками (создание которых может задать вполне определённую периодичность — такую, какую захотим), а запустить непрерывное измерение на длительный срок. Если хотим изучить влияние в течение звёздного года — значит, на весь год. А лучше на несколько. И непрерывно регистрировать сигнал и копить гистограмму. А найти желаемые закономерности в измерениях на ограниченных отрезках можно запросто, т.к. до гауссовой кривой при этом нам совсем далеко.

2. Менее существенно, но в ряде измерений важно — фоновый шум.

Не приводятся записи фонового сигнала, не связанного непосредственно с исследуемым объектом. Где они? Параллельно с интересующим нас измерением нужно вести измерения фонового сигнала. И из разности с поправками на усиления выделять полезный сигнал.

2. Да фоновый шум тоже интересно исследовать. Но при альфа распаде плутония порядка 300 событий распада фиксируется в секунду. Мне кажется фон будет около 0. Я занимаюсь только алгоритмическим расчетов сходности кривых.

Поиск изменений в экспоненциальном радиоактивном закон распада космического корабля Кассини

Немецкие физики ускорили радиоактивный распад

Измерения времени жизни нейтрона, выполненные разными методами, по-прежнему расходятся

Первое-второе: ближе к солнцу мощнее поток нейтрино и других частиц — больше вероятность инициировать процессы, связанные со слабым взаимодействием (как раз бета-распад среди них), а также интенсивнее поток частиц, пробившихся всё-таки через атмосферу (а за пределами земной магнитосферы — и подавно) при особо тонких измерениях может сыграть.

Третье: здесь не радиоактивный распад, а перевод ядра в другое энергетическое состояние. Структура и состав его не изменяются при этом, а заголовок не слишком удачен. Электродинамика + методы математической физики — в волноводе возможный спектр фотонов дискретен, и подбирая геометрию волновода, можно оставить только подходящие для перевода ядра в возбуждённое состояние, убрав остальные.

Четвёртое: ну, с интересом наблюдаю за этой и подобными работами; возможно, сложности сидят в квантовой механике и особенностях измерений на квантовом уровне, возможно — в теории поля и внесении разными методами добавочных воздействий, что на тонком уровне приводит к изменению параметра; мало ли как там физический вакуум «закипает», образно говоря.

3. Химический состав материала(метаматериала) влияет на время распада.

4. Там много расхождений и время жизни нейтрона и гравитационная постоянная и размер ядра. Но это при слабых энергиях. При энергиях порядка 10МэВ-10ГэВ расхождений нет.

1. «Шноль не похож на мошенника». Настоящие мошенники никогда не похожи на мошенников. Посмотрите выступления В. Петрика. Прям хочется ему верить… )))

2. Бывают просто увлекающиеся люди. У нас есть внутренняя конференция, на которой есть раздел «Related problems». Ну и там народ с полпинка объясняет всё — от темной материи до шаровых молний. Причем иногда используют весьма крутую математику для явно завиральных идей.

3. Любые циклические процессы космических масштабов должны хотя бы опосредованно влиять на всё.

4. Неустойчивости и бифуркации могут приводить к очень странным на первый взгляд явлениям.

В любом случае, уверен, что заявленные автором «флуктуации пространства времени, обусловленные неоднородностью гравитационных полей», ежели они и возникают (можно попробовать задачу двух тел в ОТО промоделировать и посмотреть, какие искажения в системе Солнце-Земля), эффекта значимого во все изучаемые процессы внести не могут. Энергия у них великовата, пожалуй. Поскольку любые эффекты в ОТО определяются параметром 8*pi*G / c^4 ~ 10^(-45) (это в СИ,) то они и работают лишь на гигантских масштабах.

Кроме того, совершенно неясно откуда может взяться статическая(!) неоднородность в пространстве-времени, которая приводит к указанному периоду в один звёздный год.

Кстати, в журнале УФН, помимо статей Шноля, была и попытка дискуссии с ним, смягченная и заглаженная редакцией: ufn.ru/ru/articles/2000/2/m

В 2015 г. в том же УФН была опубликована работа по поводу фликкер-шума, показывающая его неприятные особенности, проявляющиеся в процессе статистической обработки массивов данных: ufn.ru/ru/articles/2015/7/d

При всём уважении к работам Шноля по реакциям Белоусова-Жаботинского, в этом направлении имеют место проблемы с неверной обработкой и трактовкой результатов.

В самом УФН же имеют место и другие спорные работы. Например, не так давно там появлялись публикации по холодному термоядерному синтезу, связанному с сонолюминесценцией (работы Талейархана, которого в Штатах признали фальсификатором результатов экспериментов). Потому, увы, аппелировать к признанию чего-либо академической наукой, опираясь только на факты публикации в передовых журналах, не стоит.

Фразы про флуктуации пространства времени обнаруживаемые в домашних экспериментах я просто пропускаю.

Может, о порядке величины умолчу, но если есть градиент замедления времени, то это будет влиять на время жизни частицы. Насколько помню это даже проверили экспериментально для частиц на разной высоте.

Градиент формируется гравитацией солнца и неравномерностью вращения земли вокруг солнца (расстояние меняется на 3% 147,098,291км/152098233км)

Кроме того солнечные нейтрино и какие нить экзотические аксионы.

Я на 90% процентов уверен, что тут плохая постановка эксперимента или обработка или не учет фактора. возможно даже на 99%.

Бозоны Хиггса не очень часто, но уже достаточно для накопления подходящей статистики. Другие события — тем более.

Замедление времени под влиянием массы Солнца вблизи Земли по относительной величине

dt = GM/(R c^2) ~ 10^(-8)

Годичное изменение расстояния даёт поправки к dt порядка 10^(-10).

Слишком ничтожный эффект.

Я не про замедление времени, про градиент замедления времени. Он приводит к декогеренции состояния изменяя скорость распада. Само замедление времени тут не играет роли.

Написанные выше 10^(-10) — это максимальная вариация dt за год. Градиент ещё на 10 порядков меньше, т.к. определяется здесь длиной земной орбиты.

Наконец, как прибор, находясь в одной системе отсчёта с процессом, может вдруг увидеть разницу? Что за такая абсолютная с.о. определяет плотности вероятности.

2. Гравитация способна вызывать декогеренцию больших квантовых систем

В роликах первая ссылка битая, а Гордон долбоящер.

ххх: наша гомеопатия великолепно работает!

ууу: а вы провели двойное слепое тестирование?

ххх: оно работает только на двойных слепых мышах, а наша гомеопатия работает на всех!

Может быть в этом и есть весь секрет. Люди очень любят обманывать себя, или даже мухлевать, во все времена любили, проводить эксперименты и показывать из них, что был какой-то результат. Не хочу никого обидеть, но в советском союзе это часто было на уровне институтов и научных работ, которые с тех пор никто и не проверял, например амизоны и прочие, да, часть из них, вероятно, что-то действительно лечит, но очень часто и эффект незаметен и проверялся на 3-х человеках, и в западной медицине никакого места не имеет и не относится даже к лекарственным средствам, так что даже FDA ими не интересуется

"Время ожидания разряда в RC генераторе на неоновой лампе"

Пожалуй, тот случай, когда каждый может дома… сам...

Какой-то поток сознания...

Время ожидания разряда в RC генераторе на неоновой лампе

и

Шумы в диодах Зенера и других полупроводниковых генераторах шума

выглядят вполне приемлемыми для домашней лаборатории. Особенно первое, поскольку там во-первых сигнал чисто временной (длительность импульсов генератора), во-вторых довольно высокая частота (сотни и тысячи герц), что позволяет рисовать гистограмму каждую секунду, а возможно даже чаще, в третьих в отличии от шумов в полупроводниках, довольно понятная (во всяком случае на пальцах) физика, в четвертых очень дешевые компоненты (неоновые лампы стоят в чипе и дипе от 7 до 40 рублей). В течении 50 лет измерять конечно довольно напряженно, да и в течении года пожалуй тоже. Но в течении недели, почему бы и нет? Суточный ритм оно покажет. К тому же как я понял, если сделать несколько датчиков, гистограммы каждого из них измеренные в одно и то же время должны быть похожи. Не хотите заняться этим? Я например хочу. Сейчас только текущие дела немного раскидаю и попытаюсь это сделать. Кстати может получиться шикарная публикация на хабре.

Чудовищные неточности не покроют даже десятилетия наблюдений. А если бы описанные эффекты имели большее влияние, их бы уже давно заметили.

Так что вперед, делать новую физику.

Кроме того если так, становится непонятным, как работают ускорители. Вакуум там просто ОБЯЗАН быть очень хорошим. Ибо частицы проходят огромный путь. А магнитная фокусировка при приличных энергиях и разумных токах магнитов, налагает достаточно жесткие требования на расходимость. Будь там не слишком хороший вакуум, частицы бы претерпевали множество столкновений с молекулами остаточных газов и до конца пути ускорения не доходило бы почти ничего.

Но потом научились располагать первую сетку очень близко к катоду и крутизна стала получаться приличной при любом вакууме.Проверял и эту байку используя лампу в которой сетка на расстоянии 35 микрон от катода. Все как у всех, откачали и ток исчезает. Нувисторы глубоко откачанные используются на микротоках как малошумящие. У меня на таком есть один прибор на основе новой физики ибо на основе традиционной его быть не может.

Более того, в современные лампы (с 40-х годов) обязательно вводят вещества типа натрия, поглощающие остаточные газы.

Называется это геттер Для поглощения кислорода и азота, а наполняют обычно аргоном. Сам геттер может быть самым различным, есть и на основе тория (радиоактивен).

Лампа (сделанная нормально) это штуковина очень и очень высокочастотная. Я например прекрасно помню времена, когда транзисторы для УКВ отсутствовали как класс, и вся любительская техника на эти диапазоны была ламповой. Если верить Вам, что свойства ламп существенно зависят от остаточного газа, становится непонятным, почему они работают на таких частотах. Ударная ионизация и рекомбинация (особенно второе !) процессы достаточно инерционные. Например RC-генератор на неоновой лампе не работает на частотах выше нескольких килогерц (ещё в институте на эту тему лаба была !). Выше просто не позволяют процессы ионизации и рекомбинации в лампе. Понятно что в электронных лампах давление существенно ниже чем в неоновых. Но всё равно процессы в газе должны не позволять им работать на сотнях мегагерц. А на практике они в этой области прекрасно работают.

транзисторы для УКВ отсутствовали как класс, и вся любительская техника на эти диапазоны была ламповой

Для УКВ использовались специальные лампы, основной особенностью которых являлось малое время пролета от катода до анода. Это достигалось как раз за счет уменьшения межэлектродных расстояний до минимально возможных.

Время ожидания разряда в RC генераторе на неоновой лампе

Как калибровка обработки, выделение зависимости от атмосферного давления, дальше учет

влияния атмосферного давления и попытка найти иные фифекты, иных пока не выявлено,

за исключением колебания интенсивности естестественно рад. фона.

Всё уже украдено до нас.

Шумы в диодах Зенера и других полупроводниковых генераторах шума

Тож самое что и для неоновой лампочки, ибо суть одна и та же. Пробой в конденсаторе.

В конденсаторе? Нет, пробоя диэлектрика конденсатора в релаксационном генераторе не происходит. Пробой происходит в нелинейном элементе, которым и является неоновая лампа, динистор, разрядник, и т.п.

Конечно, можно сделать и такой релаксационный генератор, где пробой происходит именно в конденсаторе. Но это смотря в каком. В бумажном, например, от этого "коза" возникнет. Металлобумажный самовосстановится за счёт испарения металлического напыления вокруг места пробоя — релаксационный генератор продолжит работать, пока не будет израсходовано всё напыление. Ну а конденсатор с воздушным диэлектриком, пожалуй, в таком релаксационном генераторе в этом режиме будет работать нормально и долго.

тож, самое но не в таком явном виде у диодах Зенера, где приложено обратное напряжение, диод закрыт, есть емкость (как у варикапа) и она пробивается.

Космофизические факторы в случайных процессах