Комментарии 58

Закладочная статья однозначно

+1

Тут ведь какая «закавыка», обычно всегда есть магазин-конкурент с демпинговой политикой (по разным причинам). И благодаря этому, он имеет в 4..5 раз больше трафик, а значит и сильно лучшие ПФ, и поэтому в конце концов поисковые системы его еще ранжируют выше.

Сайт у него хуже, корзина назло всем теориям UX/UI реализована плохо, да и кнопка купить «не оранжевая» и тп и тд. И на сео он тратит копейки.

А в поиске он выше.

Вот такая «закавыка»

Сайт у него хуже, корзина назло всем теориям UX/UI реализована плохо, да и кнопка купить «не оранжевая» и тп и тд. И на сео он тратит копейки.

А в поиске он выше.

Вот такая «закавыка»

0

То, что вы написали, это стандартное столкновение «ценность против юзабилити». При прочих равных ценность побеждает.

При этом ценностью может быть не только цена. Может быть еще

— ассортимент

— сервис

— доставка

— скорость реакции на обращения

— официальная гарантия (например, на официальный apple гарантия 2 года, а на серый — год)

Вот например, история, когда магазин отказался демпинговать и получил за это отрицательный отзыв. Но(!) этот отрицательный отзыв ценнее сотни положительный (скрин)

При этом ценностью может быть не только цена. Может быть еще

— ассортимент

— сервис

— доставка

— скорость реакции на обращения

— официальная гарантия (например, на официальный apple гарантия 2 года, а на серый — год)

Вот например, история, когда магазин отказался демпинговать и получил за это отрицательный отзыв. Но(!) этот отрицательный отзыв ценнее сотни положительный (скрин)

+2

Отрицательные отзывы, где клиент конструктивно говорит о своей боли — очень хороши. Как сами по себе, так и как сигнал о возможной проблеме в компании. Неадекватные отрицательные отзывы тоже норм — при условии адекватного ответа компании. Покупатели увидят что негативные отзывы не удаляются, и что компания нормально относиться даже к неадекватным клиентам.

Но чем именно хорош данный отзыв, можете уточнить?

Я прочитав его понял:

— можно приехать в эту компанию и по тестировать оборудование;

— у них есть конкуренты (при чем так же официальные дилеры), и конкуренты готовы демпинговать;

— компания четко дала понять что обсуждать с ними возможные скидки смысла нет.

Я тоже не люблю демпинг. Но бывают такие клиенты. В таком случае лучше не давать скидку, но дать что то другое (полезный подарок из ассортимента магазина, хххх рублей на следующий заказ, расширенную доставку / страховку). Подарок в глазах покупателя выглядит по цене его продажи. Для вас он по цене его закупки. хххх рублем на следующий заказ — аналогично, вы еще и заработаете на следующем заказе (хоть не факт что он вообще будет; и неизвестно через какое время — насколько к тому моменту обесценится рубль). И т.д. и т.п… простые истины.

Но чем именно хорош данный отзыв, можете уточнить?

Я прочитав его понял:

— можно приехать в эту компанию и по тестировать оборудование;

— у них есть конкуренты (при чем так же официальные дилеры), и конкуренты готовы демпинговать;

— компания четко дала понять что обсуждать с ними возможные скидки смысла нет.

Я тоже не люблю демпинг. Но бывают такие клиенты. В таком случае лучше не давать скидку, но дать что то другое (полезный подарок из ассортимента магазина, хххх рублей на следующий заказ, расширенную доставку / страховку). Подарок в глазах покупателя выглядит по цене его продажи. Для вас он по цене его закупки. хххх рублем на следующий заказ — аналогично, вы еще и заработаете на следующем заказе (хоть не факт что он вообще будет; и неизвестно через какое время — насколько к тому моменту обесценится рубль). И т.д. и т.п… простые истины.

0

Тут два важных преимущества

1) Можно получить хорошо организованное бесплатное прослушивание (это бывает не так часто, у демпингующего конкурента может вообще не быть ни оборудованного помещения, ни нужного количества оборудования в наличии)

2) Вся компания от менеджера до руководителя невероятно корректна, вежлива и даже вложившись в организацию прослушивания, ни секунды не изображает обиды за то, что выбрали не их (вроде это и норма, но это очень редкая в нашем мире норма)

1) Можно получить хорошо организованное бесплатное прослушивание (это бывает не так часто, у демпингующего конкурента может вообще не быть ни оборудованного помещения, ни нужного количества оборудования в наличии)

2) Вся компания от менеджера до руководителя невероятно корректна, вежлива и даже вложившись в организацию прослушивания, ни секунды не изображает обиды за то, что выбрали не их (вроде это и норма, но это очень редкая в нашем мире норма)

0

Ну и я говорю. Послушаем тут — купим где дешевле. Небось и кофе еще угостят, и расположение удобное, в центре. Не все, но определенный % так и сделает.

Может быть тут профит и будет. Аудитория я так понял дорогая. Может быть и оценят. Сказать сложно. Это все «может быть». Но первое впечатление у меня негативное. Да и «дорогая аудитория» понятие обманчивое. Поспрашивайте курьеров — чем богаче люди, тем меньше чаевых. Они хорошо считают свои деньги.

Может быть тут профит и будет. Аудитория я так понял дорогая. Может быть и оценят. Сказать сложно. Это все «может быть». Но первое впечатление у меня негативное. Да и «дорогая аудитория» понятие обманчивое. Поспрашивайте курьеров — чем богаче люди, тем меньше чаевых. Они хорошо считают свои деньги.

0

Тут работает вот какая штука: если компания режет свою маржу, то у них нет денег на сервис. И если что-то пойдет не так, то не факт, что они помогут.

Это стоит 4% даже для очень экономных людей (хотя безусловно, не для всех).

Это стоит 4% даже для очень экономных людей (хотя безусловно, не для всех).

0

Думать о разводе, когда женишься. «Нашел дешевле на 4% на Алиэкспресс» — звучит не убедительно. А «официальный дилер» мне нравится. Если гарантия от производителя и отзывы у дилера не самые ужасные — еще круче.

Не знаю, может это я один такой? Мне, например, оставить 10% официанту — непонятное явление. Оставить сдачу с крупной купюры — ок. Но не 10%. Есть страны где непонятно обратное.

Когда я покупаю джинсы — я просто определяюсь с ценовым диапазоном и иду их примерять. Я не буду даже пробовать найти подобную модель в другом месте:

— ценник не тот, чтобы тратить время;

— трудности с поиском конкретной модели.

Когда я выбираю квартиру, которая строится. Мне плевать на 4%. Я хочу надежного застройщика, чтоб не потерять все.

Когда я выбираю ребенку садик, скидкой меня не купишь. Опять же, первое — отсеивание по ценовому диапазону. $2000 в месяц за «немецкий и танцы» 18 месячному пацану — для меня это не вариант. $200 за формат «двадцать детей и в квартире» даже при 100% скидке не интересует. У меня есть определенные требования, и определенный ценовой диапазон. Мне важна репутация компании (в данном случае — да!), мы к ним идем, как с надеюсь, на долгие годы.

Но когда я ищу технику. Мне плевать на компанию. Пришел, купил, ушел. Не продавец ее производит. Мне важно:

— официальная техника;

— цена;

— гарантия.

Все. При чем гарантия на последнем месте. Если тут пылесос за 50000 руб но с гарантией 3 года, я пойду и куплю точно такой же за 48000 руб но с гарантией на 1 год. Если за первый год с ним ничего не случится, вряд ли он поломается за два последующие.

Компания, для которой 4% убьет сервис, не переживет первый же форс-мажор. Если вообще доживет до него. Тут актуальней вопрос «потерять 4%» или «потерять продажу» (а то и клиента)?

Не знаю, может это я один такой? Мне, например, оставить 10% официанту — непонятное явление. Оставить сдачу с крупной купюры — ок. Но не 10%. Есть страны где непонятно обратное.

Когда я покупаю джинсы — я просто определяюсь с ценовым диапазоном и иду их примерять. Я не буду даже пробовать найти подобную модель в другом месте:

— ценник не тот, чтобы тратить время;

— трудности с поиском конкретной модели.

Когда я выбираю квартиру, которая строится. Мне плевать на 4%. Я хочу надежного застройщика, чтоб не потерять все.

Когда я выбираю ребенку садик, скидкой меня не купишь. Опять же, первое — отсеивание по ценовому диапазону. $2000 в месяц за «немецкий и танцы» 18 месячному пацану — для меня это не вариант. $200 за формат «двадцать детей и в квартире» даже при 100% скидке не интересует. У меня есть определенные требования, и определенный ценовой диапазон. Мне важна репутация компании (в данном случае — да!), мы к ним идем, как с надеюсь, на долгие годы.

Но когда я ищу технику. Мне плевать на компанию. Пришел, купил, ушел. Не продавец ее производит. Мне важно:

— официальная техника;

— цена;

— гарантия.

Все. При чем гарантия на последнем месте. Если тут пылесос за 50000 руб но с гарантией 3 года, я пойду и куплю точно такой же за 48000 руб но с гарантией на 1 год. Если за первый год с ним ничего не случится, вряд ли он поломается за два последующие.

Компания, для которой 4% убьет сервис, не переживет первый же форс-мажор. Если вообще доживет до него. Тут актуальней вопрос «потерять 4%» или «потерять продажу» (а то и клиента)?

0

Пожалуйста, покажите исследования или информацию от самих SE о том, что ЧПУ действительно важно для продвижения.

0

К сожалению, сами поисковики такой информации не дают. Приходится опираться на наблюдения сеошников. Вот например, доклад Ашманова, 37-я страница.

0

И? Лично я считаю доклады Ашманова достаточно вредной штукой.

О чем они говорят? Берут выдачу, разные параметры, и пытаются их связать. В итоге получают что чуть ли не 90% сайтов в топ-30 идут с URL «без расширений и параметров». Конечно, когда все SEO-шники из года в год бездумно считают что ЧПУ имеет весомое значение. ЧПУ будет обязательным в любом ТЗ, в любом анализе и просто где угодно. В итоге тяжело встретить продвигаемые сайты, где бы не использовался ЧПУ («человеку», собственно, вообще ни как не помогающий). Вы в H1 всех продвигаемых сайтов ставьте смайлик слоника. И потом заявляйте, что слоник в H1 — поисковый фактор, положительно влияющий на продвижение. Ведь посмотрите — в выдаче куча сайтов со смайликом слона…

Чтобы выявить факторы ранжирования нужно проводить тесты с чистыми сайтами. На один ставим ЧПУ, на другой — нет. Повторяем десятки / сотни раз, делаем выводы. А эти доклады — не более чем «средняя температура по больнице». ИМХО.

Единственным более-менее вменяемым смыслом от ЧПУ можно назвать более привлекательный сниппет. Точнее говоря, можно было бы назвать. Разметка крошек на schema — вот то, что я действительно рекомендовал. И сниппет в сто раз круче, и поисковик лучше понимает структуру сайта. Такое…

О чем они говорят? Берут выдачу, разные параметры, и пытаются их связать. В итоге получают что чуть ли не 90% сайтов в топ-30 идут с URL «без расширений и параметров». Конечно, когда все SEO-шники из года в год бездумно считают что ЧПУ имеет весомое значение. ЧПУ будет обязательным в любом ТЗ, в любом анализе и просто где угодно. В итоге тяжело встретить продвигаемые сайты, где бы не использовался ЧПУ («человеку», собственно, вообще ни как не помогающий). Вы в H1 всех продвигаемых сайтов ставьте смайлик слоника. И потом заявляйте, что слоник в H1 — поисковый фактор, положительно влияющий на продвижение. Ведь посмотрите — в выдаче куча сайтов со смайликом слона…

Чтобы выявить факторы ранжирования нужно проводить тесты с чистыми сайтами. На один ставим ЧПУ, на другой — нет. Повторяем десятки / сотни раз, делаем выводы. А эти доклады — не более чем «средняя температура по больнице». ИМХО.

Единственным более-менее вменяемым смыслом от ЧПУ можно назвать более привлекательный сниппет. Точнее говоря, можно было бы назвать. Разметка крошек на schema — вот то, что я действительно рекомендовал. И сниппет в сто раз круче, и поисковик лучше понимает структуру сайта. Такое…

+1

Да, это очевидный минус статистики. Если «все сеошники так делают», то все оптимизированные сайты будут обладать этим признаком.

Но за неимением чистых «плацебо контролируемых» экспериментов, приходится полагаться на те цифры, что есть.

Более того, эти эксперименты невозможны, тк будет сложно продвигать 200 сайтов с одинаковыми заголовками и текстами. А с разными будет нарушена чистота эксперимента.

Но за неимением чистых «плацебо контролируемых» экспериментов, приходится полагаться на те цифры, что есть.

Более того, эти эксперименты невозможны, тк будет сложно продвигать 200 сайтов с одинаковыми заголовками и текстами. А с разными будет нарушена чистота эксперимента.

+1

А как раз продвигать их не надо — это и будет внешнее воздействие, которое вам нужно максимально изолировать. Сделайте 2 равнозначные странички на одном сайте с выдуманным словом (которого нет ни на одном другом сайте в интернете). С одним лишь отличием (тестом, в данном случае одна — с ЧПУ, одна — без). И смотрите какая страничка вылезет выше. При достаточном количестве итераций можно будет говорить о некой закономерности. Вторым этапом, и это уже интересней, будет определение относительной силы этого фактора.

Из личных наблюдений — впечатление такое, что поисковики воспринимают текст в URL просто как текст сайта, без каких-либо ощутимых привилегий. Единственное что мне непонятно (и что я уже не тестировал) — будет ли какой-то профит от таких безанкорных ссылок (ведь в них самих якобы есть ключевики). Но и тут рационального смысла мне мало видится — в любом случае важен околоссылочный текст.

Из личных наблюдений — впечатление такое, что поисковики воспринимают текст в URL просто как текст сайта, без каких-либо ощутимых привилегий. Единственное что мне непонятно (и что я уже не тестировал) — будет ли какой-то профит от таких безанкорных ссылок (ведь в них самих якобы есть ключевики). Но и тут рационального смысла мне мало видится — в любом случае важен околоссылочный текст.

0

Интересная версия. Но если это одно слово на двух разных страницах одного и того же сайта, то не будет ли страница, проиндексировавшаяся первой, восприниматься как оригинал, а второй — как дубль?

0

Для этого и нужно много итераций — исключить случайности, установить закономерности.

0

если моя теория верна, то такой эксперимент даст на большой выборке случайный результат)

0

Если результат будет случайным — значит это не фактор ранжирования. Проделайте то же самое с h1, title, ссылкой — получите четкий и однозначный результат.

0

title — некорректный пример. По нему отличается дубль от не дубля.

0

А при чем тут дубли? Тестируем со словом «чебуратозаврище». Первая страница title — «Первый тест мутировавшего чебурашки». Вторая страница title — «Второй тест чебуратозаврище».

И получите стабильный результат. Никакого «случайного результата на большой выборке» тут не будет. Т.к. title — фактор ранжирования.

И получите стабильный результат. Никакого «случайного результата на большой выборке» тут не будет. Т.к. title — фактор ранжирования.

0

ЧПУ не так важно для продвижения, как по ЧПУ пользователь должен понимать, что находится на странице. Из таких вот сотен кирпичиков складывается хорошо оптимизированный сайт. Порядок, структура урла, с этим просто удобно работать.

0

А еще такие url проще вводить по памяти

0

ОМГ. Пользователи даже домены ежедневно посещаемых ими сайтов запомнить не могут. Гуглят все «вк» да «мейл». Какой еще «по памяти URL вводить»? Я полагаю, не менее 2/3 не знают что такое «адресная строка». Молчу уже про поколение постарше. У меня отец чтобы открыть сайт с визитки заходит в Гугл и вбивает URL в поиск. Для него Гугл === Интернет.

+1

Поисковики нормально ранжируют страницы сайтов на три уровня вложенности (четыре, но мы не считаем главную).

Раньше делали страницу "Карта сайта", на которую помещали вообще все ссылки, и ссылались на неё с той же домашней страницы. Сейчас этот подход не работает?

0

Сейчас так уже не делают. В числе прочего, поисковикам важно, чтобы навигация была реальной и покупатели ей пользовались.

0

Насколько я понял (Yandex, Google), site map всё ещё используется поисковиками. Т.е., мне не обязательно ставить на каждой странице кросс-ссылки на остальные страницы сайта, чтобы те проиндексировались (если я правильно понял ваш термин "реальная навигация").

Допускаю, что наличие кросс-ссылок сказывается на ранге страницы при формировании результата поиска, но не думаю, что site maps утратили актуальность.

0

Sitemaps используются, но есть свои нюансы. В частности, до 50000 ссылок на 1 файл + ограничения по объему в Мб (создается «карта карт» sitemap.xml, ссылающийся на sitemap1.xml, sitemap2.xml… та чего далеко ходить — https://habr.com/sitemap.xml). На первый взгляд может показаться что это о-го-го сколько. Но для некоторых тематик и 5000000 недостаточно. Во многих крупных проектах Sitemaps даже не будет. Там они будут занимать сотни файлов, и их банально может быть проблематично генерировать (из-за сложной и разношерстной структуры сайта).

Поэтому в принципе лучше придерживаться правила 3 кликов по возможности. Хоть и его я считаю устаревшим и не сильно актуальным. У меня на практике Гугл съедал до 100к страниц в сутки даже при 5 уровне вложенности. Все зависит от проекта (там сайт что то в районе 10 лет, и посещаемый). И краулинговый бюджет тут важен (сэкономили раньше — можете получить больше сейчас). Понятно, что новому домену такое не светит.

Поэтому в принципе лучше придерживаться правила 3 кликов по возможности. Хоть и его я считаю устаревшим и не сильно актуальным. У меня на практике Гугл съедал до 100к страниц в сутки даже при 5 уровне вложенности. Все зависит от проекта (там сайт что то в районе 10 лет, и посещаемый). И краулинговый бюджет тут важен (сэкономили раньше — можете получить больше сейчас). Понятно, что новому домену такое не светит.

+2

О всем, и ни о чем. Конкретики почти нет. Очень многое — спорно. Нового ноль.

-1

Всегда есть категория читателей, для которых то, что ты пишешь, — как азбука. Но есть и те, кто этого не знал и кому оказалось полезно. Это главное.

+3

Я не спорю. Не обязательно писать о чем то новом. Можно написать о старом. Просто лучше.

«Максимально удобный заказ». Или про корзину. И там и там по два абзаца текста в пару предложений каждый. Тут на любую из этих тем едва ли не книгу можно издать. Ну как минимум 2-3 полноценных статьи.

Ваш пример оформления заказа считаете «максимально удобным»? Что это вообще за понятие такое? Для интернет-магазина одежды это будет одна страница. Для магазина покрышек — другая. На одних тематиках шикарно работает выбор «оформить заказ самостоятельно / оформить заказ за вас». На других не очень. На мобильных она же при прочих равных работает лучше, на десктопах — хуже. На десктопах обычно лучше работает раскрытие полей по мере необходимости, на мобильных — нет. В одних случаях стоит показывать корзину, в других — нет. Из столицы лучше работает одна страница, для регионов лучше другой набор. Даже время суток имеет значение. Нюансов миллионы, а вы — «делайте максимально удобным»… — Как?

«Максимально удобный заказ». Или про корзину. И там и там по два абзаца текста в пару предложений каждый. Тут на любую из этих тем едва ли не книгу можно издать. Ну как минимум 2-3 полноценных статьи.

Ваш пример оформления заказа считаете «максимально удобным»? Что это вообще за понятие такое? Для интернет-магазина одежды это будет одна страница. Для магазина покрышек — другая. На одних тематиках шикарно работает выбор «оформить заказ самостоятельно / оформить заказ за вас». На других не очень. На мобильных она же при прочих равных работает лучше, на десктопах — хуже. На десктопах обычно лучше работает раскрытие полей по мере необходимости, на мобильных — нет. В одних случаях стоит показывать корзину, в других — нет. Из столицы лучше работает одна страница, для регионов лучше другой набор. Даже время суток имеет значение. Нюансов миллионы, а вы — «делайте максимально удобным»… — Как?

+1

Субъективно, ценность таких статей не в том, чтобы раскрыть какие-то великие тайны или научить кого-то чему-то, а в простом обмене опытом из личной практики. Не знаю как вам, а мне это всегда очень интересно, даже если в статье нет ничего из ряда вон. И чем типичнее описанный проект, тем больше шанс почерпнуть прикладной опыт для себя.

Так что я не жду от авторов каких-то бесспорных истин или открытия Америки. Полезно бывает найти подтверждение отдельным собственным эмпирическим выводам или лишний раз убедиться, что люди сталкиваются со схожими проблемами. Любая фактическая инфа со стороны полезна. Мы все так или иначе работаем с изрядной долей неопределенности, бывает трудно отличить случайные корреляции от закономерностей. Так что чужой опыт это всегда хорошо (независимо от того, насколько он «правильный»).

Знаю, что многие предпочитают публикации передовых компаний об инновациях, с кучей технических подробностей и всяких крутых решений. Но, на мой взгляд, их опыт как раз трудно масштабировать вниз до уровня локальной студии. Ну то есть оно вдохновляет, конечно, но в 99% случаев проблемы и решения гигантов возникают в абсолютно параллельной вселенной. Грубо говоря, ну читаю я статью ребят из условного Яндекса, которые отлично решили проблему X с помощью 20 программистов и навороченной нейросети. Вау, очень интересно и любопытно. Но при этом у меня тупо нет в работе ни одного проекта, который требовал бы такого уровня автоматизации и где бы внедрение окупилось для клиента :) Так что лично для меня статьи типа этой имеют бОльшую субъективную ценность, даже когда я совершенно ничего нового не узнаю.

К слову, во многом согласен с вашим замечанием о ЧПУ выше (в плане чистой логики). Но спорная информация — это всё-таки сырьё для анализа. Её можно отфильтровать, осмыслить, погонять на тестах и т.п. Хуже, когда анализировать вообще нечего. В этом смысле, доклады волне хороши.

P.S. iarga, спасибо, прочёл с интересом.

Так что я не жду от авторов каких-то бесспорных истин или открытия Америки. Полезно бывает найти подтверждение отдельным собственным эмпирическим выводам или лишний раз убедиться, что люди сталкиваются со схожими проблемами. Любая фактическая инфа со стороны полезна. Мы все так или иначе работаем с изрядной долей неопределенности, бывает трудно отличить случайные корреляции от закономерностей. Так что чужой опыт это всегда хорошо (независимо от того, насколько он «правильный»).

Знаю, что многие предпочитают публикации передовых компаний об инновациях, с кучей технических подробностей и всяких крутых решений. Но, на мой взгляд, их опыт как раз трудно масштабировать вниз до уровня локальной студии. Ну то есть оно вдохновляет, конечно, но в 99% случаев проблемы и решения гигантов возникают в абсолютно параллельной вселенной. Грубо говоря, ну читаю я статью ребят из условного Яндекса, которые отлично решили проблему X с помощью 20 программистов и навороченной нейросети. Вау, очень интересно и любопытно. Но при этом у меня тупо нет в работе ни одного проекта, который требовал бы такого уровня автоматизации и где бы внедрение окупилось для клиента :) Так что лично для меня статьи типа этой имеют бОльшую субъективную ценность, даже когда я совершенно ничего нового не узнаю.

К слову, во многом согласен с вашим замечанием о ЧПУ выше (в плане чистой логики). Но спорная информация — это всё-таки сырьё для анализа. Её можно отфильтровать, осмыслить, погонять на тестах и т.п. Хуже, когда анализировать вообще нечего. В этом смысле, доклады волне хороши.

P.S. iarga, спасибо, прочёл с интересом.

+1

Спасибо!!!

0

Я тоже только за. И полностью согласен с вашим комментарием.

Просто как по мне, повторюсь, вышло «обо всем, но ни о чем», вода. Этот «максимально удобный заказ», корзина и прочее. Сравнение выдачи по 1 запросу, 4 сайтах — и на основании этого что то дальше обсуждать. Рассказы о банальных вещах и о сложном — вперемешку. Слишком широкая тема просто для одной статьи, ее статей на 200 можно разбить и воды не будет. Нужно или писать детальней о конкретных вещах. Или делать публикации в стиле «было / стало — что мы сделали и какой результат получили, выводы, планы» — реальная практика, такое всегда интересно читать.

Все, ухожу, ухожу отсюда! :)

Просто как по мне, повторюсь, вышло «обо всем, но ни о чем», вода. Этот «максимально удобный заказ», корзина и прочее. Сравнение выдачи по 1 запросу, 4 сайтах — и на основании этого что то дальше обсуждать. Рассказы о банальных вещах и о сложном — вперемешку. Слишком широкая тема просто для одной статьи, ее статей на 200 можно разбить и воды не будет. Нужно или писать детальней о конкретных вещах. Или делать публикации в стиле «было / стало — что мы сделали и какой результат получили, выводы, планы» — реальная практика, такое всегда интересно читать.

Все, ухожу, ухожу отсюда! :)

0

Статья актуальная для 2005 года.

Единственное, что действительно сейчас влияет на SEO — это польза от сайта. Все, больше ничего. Стремиться нужно ни к ЧПУ красивым, ни к 3 кликам до товара, ни к сортировкам, а к пользе.

Именно поэтому SEO никак не отделимо от бизнеса, а является его логичным продолжением. Именно поэтому эффективность большинства SEO-шников где-то около 0, потому что единицы готовы вникать в бизнес заказчика.

Если польза — минимальная цена, делаем самую низкую цену и всегда будешь в топе.

Если польза — быстрая доставка, делаем самую быструю доставку и всегда будешь в топе.

Единственное, что действительно сейчас влияет на SEO — это польза от сайта. Все, больше ничего. Стремиться нужно ни к ЧПУ красивым, ни к 3 кликам до товара, ни к сортировкам, а к пользе.

Именно поэтому SEO никак не отделимо от бизнеса, а является его логичным продолжением. Именно поэтому эффективность большинства SEO-шников где-то около 0, потому что единицы готовы вникать в бизнес заказчика.

Если польза — минимальная цена, делаем самую низкую цену и всегда будешь в топе.

Если польза — быстрая доставка, делаем самую быструю доставку и всегда будешь в топе.

+2

Увы, статистика неумолима. См. доклад по коммерческим факторам.

0

Там всё очень плохо. Берут улитку, жирафа и стафилококк и давай выделять общие признаки.

Пример из жизни, чтобы далеко не ходить.

Нужно вам кондиционер поставить. Модель и бренд вы знаете. У всех дилеров на этот кондиционер одинаковая цена, но один из дилеров предлагает бесплатную установку и 5 лет послепродажного обслуживания.

При прочих равных, ответ где совершить покупку очевиден. Зависит решение о покупке от ЧПУ, цвета кнопки корзины, разбиение корзины на шаги, использования H1, написанного по канонам SLA текста, количества баллов в Light House, наличия номера 8-800?

Пример из жизни, чтобы далеко не ходить.

Нужно вам кондиционер поставить. Модель и бренд вы знаете. У всех дилеров на этот кондиционер одинаковая цена, но один из дилеров предлагает бесплатную установку и 5 лет послепродажного обслуживания.

При прочих равных, ответ где совершить покупку очевиден. Зависит решение о покупке от ЧПУ, цвета кнопки корзины, разбиение корзины на шаги, использования H1, написанного по канонам SLA текста, количества баллов в Light House, наличия номера 8-800?

0

Теория неплоха. Но как согласуется она с реальной жизнью?

Вот есть фотосклад, где айфоны на 10к дешевле, чем в iqmac

iqmac умер?

Вот есть фотосклад, где айфоны на 10к дешевле, чем в iqmac

iqmac умер?

0

Вопрос некорректный, на него нельзя ответить. Переформулирую.

Берем группу людей, для которых ценность — минимальная цена Iphone. Прикидываем, как они ищут, предполагаем запрос «iphone купить дешево». Далее смотрим на позиции в выдаче Фотосклада и Iqmac. Только теперь можем что-то с чем-то сравнить.

Но этот случай — яркая иллюстрация того, что SEO-шник должен быть частью бизнеса. Ни один адекватный продвиженец не возьмется за «iphone купить дешево».

Берем группу людей, для которых ценность — минимальная цена Iphone. Прикидываем, как они ищут, предполагаем запрос «iphone купить дешево». Далее смотрим на позиции в выдаче Фотосклада и Iqmac. Только теперь можем что-то с чем-то сравнить.

Но этот случай — яркая иллюстрация того, что SEO-шник должен быть частью бизнеса. Ни один адекватный продвиженец не возьмется за «iphone купить дешево».

0

iqmac умер?Мне они оба незнакомы. Но если сравнивать их напрямую по тому, что видно (посещаемость, трендовость) — по сухими параметрам, да.

Кроме того iqmac нишевый, это важно. И проверив пару позиций, разница в 10к прям не очевидно. «Что-то там, что-то здесь».

Ладно, тематика SEO и интернет-магазинов меня будоражит основательно. На Хабре так редко бывает… Пошел я лучше обедать, а то дел полно, а я тут в камментах завис. На меня не похоже.

0

Единственное, что действительно сейчас влияет на SEO — это польза от сайта.Золотые слова. Если соблюдены все технические требования, то больше ничего уже не влияет на продвижение, акромя интереса к сайту со стороны посетителя и готовность возвращаться на сайт снова и снова.

Но СЕО компании пытаются доказать, что это не так. И в итоге сыпят отчетами скомпилированными на базе google pagespeed insights и отчетов больших сео-компаний. И в итоге, в этих рекомендациях N-й пункт (сократите объем html) в их рекомендациях противоречит (N+10)-му (добавьте на главную страницу популярные товары, да еще и с микроразметкой), в итоге куча воды воды воды… одна вода и имитация бурной деятельности.

Мы вот проводили эксперимент с ЧПУ. Есть два раздела на сайте, по структуре похожие, так как оба справочники, на базе одной и той же БД. Всего около 50т вариантов страниц.

Первый раздел переделали на ЧПУ, второй оставили передачей данных через параметры. Причем и в 1м и во 2м разделе есть на входе фильтр проверяющий порядок и состав параметров, чтобы не было дублей страниц. Эффект от перехода на ЧПУ равнялся практически нулю.

0

Эффект, равный «практически нулю» (например, 1-2%), вы едва ли измерите на одном сайте.

Но когда факторов, дающих такой эффект, задействована сотня, то эффект уже сложно не заметить.

Но когда факторов, дающих такой эффект, задействована сотня, то эффект уже сложно не заметить.

0

Ну о какой сотне факторов может идти речь? Все технические сео-требования давно уже выполнены, скорость отдачи одинаковая, «полезность» страниц для посетителя тоже равноценная. Вся разница в ЧПУ, которые настойчиво требовали сделать. Сделали. Стоим там же, но энтропия выросла, время и труд потрачены. А посетителю глубоко пофиг, чпу там или нет. Он же руками не набирает урлы. Он их по вацапу или по почте пересылает друзьям товарищам.

0

Статья переполнена мифами и ошибками, характерными для технически неграмотных SEO специалистов. Коих большинство.

К сожалению, именно засилье подобной безграмотности и заставляет людей относиться к SEO с пренебрежением. Что очень зря. Область крайне интересная, особенно для тех, кому нравиться заниматься реверс инженирингом.

К сожалению, именно засилье подобной безграмотности и заставляет людей относиться к SEO с пренебрежением. Что очень зря. Область крайне интересная, особенно для тех, кому нравиться заниматься реверс инженирингом.

Под спойлером разбор нескольких тезисов статьи.

Все страницы сайта, будут как скраулены так и ранжированы ботом. Вне зависимости от кликов от главной. Страницы любой вложенности могут стоять в ТОП по любым запросам без ограничений.

За исключением одной ситуации: когда общий обьем страниц проекта существенно превышает крауленговый бюджет выделенный поисковой системой проекту. Обычно это касается проектов с сотнями тысяч страниц.

Естественно, что в случаях когда Поисковая машина выдала проекту бюджет на 100 страниц, а у него их 100 000, то время для краулинга страниц с DFI больше 3 наступить может через месяцы.

Так же естественно, что если страница получает внешний ссылочный профиль, при этом наполнена информацией отвечающей интенту, то вне зависимости от DFI эта страница будет как проиндексирована (в том числе с игнорированием ROBOTS.txt) так и поставлена в топ.

Яндекс, это система где до сих пор полотенце SEO текста как обязательно для страницы, так и может вывести ее в топ.

Алгоритм ранжирования в Яндексе обладает только одним преимуществом — качеством понимания русского текста. Тут ему нет равных. Это правда.

Больше ничего алгоритм Яндекса либо не умеет вообще, либо делает это очень плохо.

Это легко доказывается простыми опытами — вроде размещения изображений, которые никакого отношения к контенту не имеют, но при этом положительно воспринимаемых яндексом. Или изображений с откровенным мусором.

В отличии от Google который не только идентифицирует и ранжирует такие вещи, но и работает с текстами на них, с информацией об опастности изображения в той или иной области (например опасно эпилептикам или нет, содержит ли порнографию или нет и т.д.)

Яндекс поиск сейчас, технически отстал от Google лет на пять.

И чтобы стоять в топе Яндекс поиска, все что нужно — это вливать в сервисы яндекса деньги:

от оплаты их каталогов, маркетов, рекламы до интеграции их сервисов онлайн помощи и оплаты. Любой, сайт получивший право участия в этих сервисах, несмотря на то, что есть сайты намного лучше, будет стоять в топе.

То есть говорить о том, что в Яндексе сейчас существует какой либо адекватный поиск, по крайней мере в областях где есть конкуренция — это не владеть ситуацией.

Ничего подобного в Google давно нет. В топе могут стоять проекты вообще практически без внешнего ссылочного профиля, как и текста — только на качестве контента.

Попробуйте сделать в Яндексе страницу стоящую в выдаче, которая содержит не более 300 символов текста, и под сотню изображений. Можете не стараться, у Вас не получится.

А в Google это возможно, причем абсолютно отвечая запросу посетителя.

Не говоря уже о Видео. Это к вопросу о техническом совершенстве.

В своем докладе Ашманов рассказывает о корреляции сайтов из Топ выдачи, с присутствием той или иной технологии.

Корреляция — это не доказательство использования этого фактора поиском.

Например, все сайты из ТОП выдачи используют JavaScript. 100% корреляция. Значит ли это, что для топа важен JS? Нет не значит. Это просто пища для размышлений.

Я обожаю эту байку распространяемую безграмотными SEO специалистами.

Для Google, отсутствие учета поведенческих факторов, доказано десятком специалистов, на основе очень простых неопровержимых вещей:

1. Чтобы учесть что либо, нужно иметь об этом данные, статистику. В большинстве случаев, поведенческие факторы требуют данных, которые может предоставить только браузер. Что означает — для того чтобы эти данные проанализировать браузер должен отправить эти данные на сервера Google или Yandex.

2. Достаточно снять весь трафик от браузера и проанализировать его, чтобы понять — передается ли хоть что-то из этого на сервера поисковых машин или вообще куда либо.

3. Насколько для серверов подтверждена корректность этих данных: возможно ли подобные данные подделать.

Полный сниффинг трафика бразуера Google Chrome (то есть того, котрырй снйчас представляет 70% рынка и может отправлять на сервера Гугла такие данные), который делается 24 на 7 365 дней в году — не показал отправки подобных данных. Браузер отправляет только обезличенные данные касающиеся того — какие страницы были открыты посетителем. Ни времени, ни тем более движение мышкой не отправляется.

Обычно, на это, технически безграмотные SEO специалисты говорят — а как же статистика в Google Analytics там же есть показатель отказов и т.д.

На что им отвечают, подобная статистика точно так же собирается обезличено, отправляется она JS логикой, что противоречит пунтку 3 вверху. То есть служит только для информирования веб мастера.

Иначе говоря, любой студент с начальными знаниями по JS может поделать эту статистику парой команд и получить в Аналитике уровень отказов 0. но не только получить 0% отказов, а и накрутить себе счетчик посещений в запредельные цифры. Что естественно НИКАК не влияет на позиции сайта. Аналогичная ситуация и с Яндекс аналитикой.

Это может проверить ЛЮБОЙ веб мастер на своем сайте.

Миф (невозможно учесть это время таким образом, чтобы его нельзя было подделать)

Миф (учесть можно, но этот клик не является доказательством эффективности поиска)

Миф (учесть можно, но этот клик не является доказательством эффективности поиска)

Миф (невозможно учесть это время таким образом, чтобы его нельзя было подделать.)

Откуда появился этот миф (поведенчиские) и почему он так живуч.

Если Вы попросите 1000 своих друзей зайти в поиск, набрать нужный Вам запрос и кликнуть именно по Вашему сайту, то подобный опыт действительно приведет к тому, что сайт подрастет. Как и любой другой в этой же выдаче, если человек вернется в поиск и клинет по нему.

С незапамятных времен существовали десятки бирж где можно покупать такие клики.

Это поведение поисковиков было известно с момента появления интереса к тому как продвинуться в поиске. И отчасти, это можно назвать поведенческими факторами. На деле же учитывается просто трафик из поисковой машины к проекту.

На фоне этого стали появляться мифы относительно времени проведенном на сайте, отказах и прочем.

Парадокс существования этих мифов в том, что они элементарно проверяются на своем же проекте, но делают это единицы.

Поисковики нормально ранжируют страницы сайтов на три уровня вложенности (четыре, но мы не считаем главную). То есть, страницы, которые не найти в три клика с главной, останутся не изученными и не займут высоких позиций в выдаче.

Все страницы сайта, будут как скраулены так и ранжированы ботом. Вне зависимости от кликов от главной. Страницы любой вложенности могут стоять в ТОП по любым запросам без ограничений.

За исключением одной ситуации: когда общий обьем страниц проекта существенно превышает крауленговый бюджет выделенный поисковой системой проекту. Обычно это касается проектов с сотнями тысяч страниц.

Естественно, что в случаях когда Поисковая машина выдала проекту бюджет на 100 страниц, а у него их 100 000, то время для краулинга страниц с DFI больше 3 наступить может через месяцы.

Так же естественно, что если страница получает внешний ссылочный профиль, при этом наполнена информацией отвечающей интенту, то вне зависимости от DFI эта страница будет как проиндексирована (в том числе с игнорированием ROBOTS.txt) так и поставлена в топ.

Яндекс ранжирует сайты при помощи алгоритма Матрикснет суть которого в определении общих признаков сайтов, полезных пользователю. Поэтому при проектировании основных страниц (главная, листинг товаров и карточки товара) важно определить, каким запросам они должны соответствовать и какие общие признаки у страниц, занимающих дон выдачи по этим запросам.

Яндекс, это система где до сих пор полотенце SEO текста как обязательно для страницы, так и может вывести ее в топ.

Алгоритм ранжирования в Яндексе обладает только одним преимуществом — качеством понимания русского текста. Тут ему нет равных. Это правда.

Больше ничего алгоритм Яндекса либо не умеет вообще, либо делает это очень плохо.

Это легко доказывается простыми опытами — вроде размещения изображений, которые никакого отношения к контенту не имеют, но при этом положительно воспринимаемых яндексом. Или изображений с откровенным мусором.

В отличии от Google который не только идентифицирует и ранжирует такие вещи, но и работает с текстами на них, с информацией об опастности изображения в той или иной области (например опасно эпилептикам или нет, содержит ли порнографию или нет и т.д.)

Яндекс поиск сейчас, технически отстал от Google лет на пять.

И чтобы стоять в топе Яндекс поиска, все что нужно — это вливать в сервисы яндекса деньги:

от оплаты их каталогов, маркетов, рекламы до интеграции их сервисов онлайн помощи и оплаты. Любой, сайт получивший право участия в этих сервисах, несмотря на то, что есть сайты намного лучше, будет стоять в топе.

То есть говорить о том, что в Яндексе сейчас существует какой либо адекватный поиск, по крайней мере в областях где есть конкуренция — это не владеть ситуацией.

Google в этом вопросе устроен сильно проще: он по-прежнему сильно ориентирован на тексты и ссылки. Так что место под тексты на страницах также важно заложить.

Ничего подобного в Google давно нет. В топе могут стоять проекты вообще практически без внешнего ссылочного профиля, как и текста — только на качестве контента.

Попробуйте сделать в Яндексе страницу стоящую в выдаче, которая содержит не более 300 символов текста, и под сотню изображений. Можете не стараться, у Вас не получится.

А в Google это возможно, причем абсолютно отвечая запросу посетителя.

Не говоря уже о Видео. Это к вопросу о техническом совершенстве.

Всего их более 150 и наиболее подробно о них рассказывается в докладе Ашманова за 2018 год.

В своем докладе Ашманов рассказывает о корреляции сайтов из Топ выдачи, с присутствием той или иной технологии.

Корреляция — это не доказательство использования этого фактора поиском.

Например, все сайты из ТОП выдачи используют JavaScript. 100% корреляция. Значит ли это, что для топа важен JS? Нет не значит. Это просто пища для размышлений.

Поведенческие факторы

Поисковики используют ПФ, чтобы понять, насколько сайт будет полезен посетителю по тому или иному запросу.

Я обожаю эту байку распространяемую безграмотными SEO специалистами.

Для Google, отсутствие учета поведенческих факторов, доказано десятком специалистов, на основе очень простых неопровержимых вещей:

1. Чтобы учесть что либо, нужно иметь об этом данные, статистику. В большинстве случаев, поведенческие факторы требуют данных, которые может предоставить только браузер. Что означает — для того чтобы эти данные проанализировать браузер должен отправить эти данные на сервера Google или Yandex.

2. Достаточно снять весь трафик от браузера и проанализировать его, чтобы понять — передается ли хоть что-то из этого на сервера поисковых машин или вообще куда либо.

3. Насколько для серверов подтверждена корректность этих данных: возможно ли подобные данные подделать.

Полный сниффинг трафика бразуера Google Chrome (то есть того, котрырй снйчас представляет 70% рынка и может отправлять на сервера Гугла такие данные), который делается 24 на 7 365 дней в году — не показал отправки подобных данных. Браузер отправляет только обезличенные данные касающиеся того — какие страницы были открыты посетителем. Ни времени, ни тем более движение мышкой не отправляется.

Обычно, на это, технически безграмотные SEO специалисты говорят — а как же статистика в Google Analytics там же есть показатель отказов и т.д.

На что им отвечают, подобная статистика точно так же собирается обезличено, отправляется она JS логикой, что противоречит пунтку 3 вверху. То есть служит только для информирования веб мастера.

Иначе говоря, любой студент с начальными знаниями по JS может поделать эту статистику парой команд и получить в Аналитике уровень отказов 0. но не только получить 0% отказов, а и накрутить себе счетчик посещений в запредельные цифры. Что естественно НИКАК не влияет на позиции сайта. Аналогичная ситуация и с Яндекс аналитикой.

Это может проверить ЛЮБОЙ веб мастер на своем сайте.

Время, проведенное на сайте.

Миф (невозможно учесть это время таким образом, чтобы его нельзя было подделать)

Последний клик на поиске

Миф (учесть можно, но этот клик не является доказательством эффективности поиска)

Единственный клик на поиске

Миф (учесть можно, но этот клик не является доказательством эффективности поиска)

Отказы

Миф (невозможно учесть это время таким образом, чтобы его нельзя было подделать.)

Откуда появился этот миф (поведенчиские) и почему он так живуч.

Если Вы попросите 1000 своих друзей зайти в поиск, набрать нужный Вам запрос и кликнуть именно по Вашему сайту, то подобный опыт действительно приведет к тому, что сайт подрастет. Как и любой другой в этой же выдаче, если человек вернется в поиск и клинет по нему.

С незапамятных времен существовали десятки бирж где можно покупать такие клики.

Это поведение поисковиков было известно с момента появления интереса к тому как продвинуться в поиске. И отчасти, это можно назвать поведенческими факторами. На деле же учитывается просто трафик из поисковой машины к проекту.

На фоне этого стали появляться мифы относительно времени проведенном на сайте, отказах и прочем.

Парадокс существования этих мифов в том, что они элементарно проверяются на своем же проекте, но делают это единицы.

0

А теперь, разобрав по пунктам ваш ответ, перейдем к его причинам.

У вас в профиле написано «Оптимизация под PageSpeed».

И все последние комментарии — к статьям про pagespeed.

То есть вы ищете публикации по слову «pagespeed» и комментируете их для поиска клиентов.

А тут вдруг попадаюсь я, который утверждает, что pagespeed — синтетический показатель и не имеет отношения к скорости.

Понятен ваш гнев и ваше желание поставить меня на место.

Прошу лишь при этом использовать конкретные факты и наблюдения, а не собственные мифы.

И не натягиватьсову на глобус наблюдение про одни факты на другие, как вы это сделали в вопросе поведенческих факторов, яндекса и гугла.

У вас в профиле написано «Оптимизация под PageSpeed».

И все последние комментарии — к статьям про pagespeed.

То есть вы ищете публикации по слову «pagespeed» и комментируете их для поиска клиентов.

А тут вдруг попадаюсь я, который утверждает, что pagespeed — синтетический показатель и не имеет отношения к скорости.

Понятен ваш гнев и ваше желание поставить меня на место.

Прошу лишь при этом использовать конкретные факты и наблюдения, а не собственные мифы.

И не натягивать

0

Добрый день!

Спасибо за развернутый ответ.

К сожалению, ваш ответ противопоставляет одно изложение другому без малейшей отсылки в фактам и масштабным исследованиям.

Например:

Я пишу про 3 уровня вложенности.

Вы говорите, что это миф и это не важно.

Но при этом не приводите ни единого факта в подтверждение этого.

Это выглядит как попытка опровергнуть «миф при помощи мифа».

Второй пример:

Вот пример рандомного запроса: "гвозди прайс москва". На первом же сайте в топе нет текста.

Так что теперь уже вы занимаетесь устаревшими мифами.

Третий пример

И до тех пор, пока у вас не появится обратного наблюдения (на сопоставимом масштабе), разумно опираться на него при продвижении сайта.

Потому что иначе вы пытаетесь противопоставить «мифу», основанному на наблюдениях, миф, на них не основанный.

Четвертый пример

Однако же, он меряет показатель отказов.

Есть идеи, как именно?

Не аналогичная.

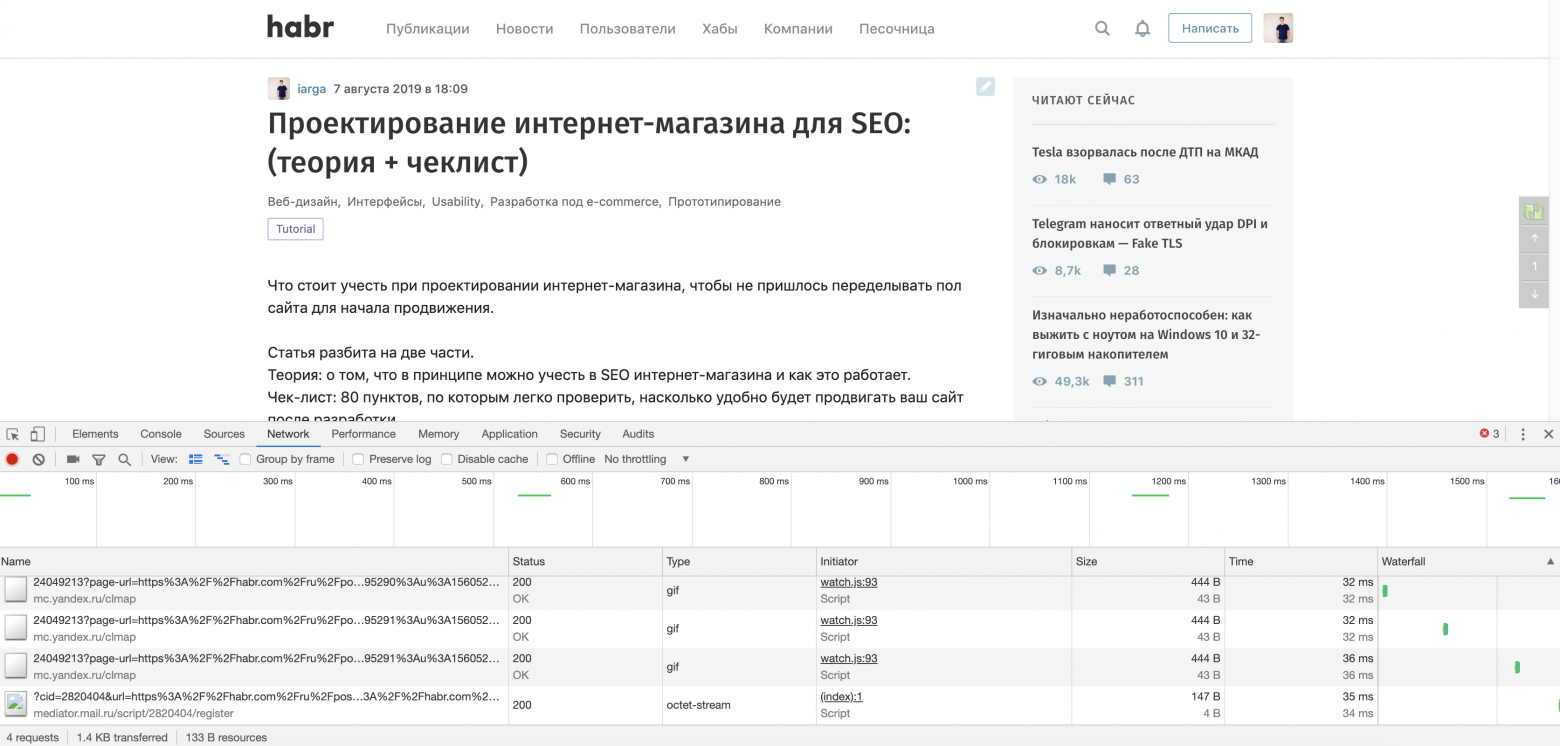

Яндекс отправляет информацию о любом клике по экрану (см скрин).

И яростно банит за накрутку ПФ (которую вы радостно преподносите как метод обмануть поисковик)

И опять вы используете то, что показатель можно подделать, как доказательство своей позиции. Но оно им не является.

Примерно так.

Жду ваших комментариев.

И прошу опираться на примеры и статистику, а не просто накидывать «контрмифы».

Спасибо за развернутый ответ.

К сожалению, ваш ответ противопоставляет одно изложение другому без малейшей отсылки в фактам и масштабным исследованиям.

Например:

Я пишу про 3 уровня вложенности.

Вы говорите, что это миф и это не важно.

Но при этом не приводите ни единого факта в подтверждение этого.

Это выглядит как попытка опровергнуть «миф при помощи мифа».

Второй пример:

Яндекс, это система где до сих пор полотенце SEO текста как обязательно для страницы, так и может вывести ее в топ

Вот пример рандомного запроса: "гвозди прайс москва". На первом же сайте в топе нет текста.

Так что теперь уже вы занимаетесь устаревшими мифами.

Третий пример

Корреляция — это не доказательство использования этого фактора поиском.Однако же это наблюдение.

И до тех пор, пока у вас не появится обратного наблюдения (на сопоставимом масштабе), разумно опираться на него при продвижении сайта.

Потому что иначе вы пытаетесь противопоставить «мифу», основанному на наблюдениях, миф, на них не основанный.

Четвертый пример

Достаточно снять весь трафик от браузера и проанализировать его, чтобы понять — передается ли хоть что-то из этого на сервера поисковых машин или вообще куда либо.

Однако же, он меряет показатель отказов.

Есть идеи, как именно?

Аналогичная ситуация и с Яндекс аналитикой.

Не аналогичная.

Яндекс отправляет информацию о любом клике по экрану (см скрин).

И яростно банит за накрутку ПФ (которую вы радостно преподносите как метод обмануть поисковик)

Миф (невозможно учесть это время таким образом, чтобы его нельзя было подделать.)

И опять вы используете то, что показатель можно подделать, как доказательство своей позиции. Но оно им не является.

Примерно так.

Жду ваших комментариев.

И прошу опираться на примеры и статистику, а не просто накидывать «контрмифы».

0

Зарегистрируйтесь на Хабре, чтобы оставить комментарий

Проектирование интернет-магазина для SEO: (теория + чеклист)