Комментарии 563

Судя по диаграмме, где 4% юзеров доставляют 50% проблем, от них (маководов) уже давно надо было отказаться, как от клиентов

… по-настоящему хорошо знаю я только Windows

Поэтому и 80% проблем с других платформ. ИМХО, автор вообще зря за мультиплатформенностью погнался при таких раскладах. Самое интересное, что, судя по графикам, с поддержкой линукса всё ещё хуже — если он откажется от макоси, то у него будет уже 60% проблем от ~2.5%

Поэтому и 80% проблем с других платформ.

В статье приведён не его график.

Тем временем я убедился, что Cogmind (и другое моё ПО) идеально работает через Wine и подобные ему пакеты.

Учитывая специфику игры (это рогалик) она не особо требовательна к ресурсам и нормально будет работать через эмулятор

будет работать через эмулятор

wine — Wine Is Not Emulator

Caves of Qud у меня, помнится, года два назад прекрасно крашился под вайном. А Tangledeep безбожно лагал. Но у них, справедливости ради, Unity под капотом. У когмайнда — самописный движок на SDL, хоть и значительно более сложный, чем просто консольное окно.

Что-то тут не сходится

Да люди вообще прекрасные, но как клиенты- не очень. Возможно даже от них убытков больше, чем доходов.

ну и у чела нет ни бюджета, ни сил, ни компетенций разбираться с другими платформами

А там чуть не на каждой машине свой вариант пакетного менеджера и библиотек. Да даже тупо на уровне libc вертикальной совместимости ни хрена нет в этой системе, так что и для разных версий Debian/Ubuntu нужно разные сборки делать.

Это крайне нудный монотонный труд, самая настоящая дурная работа. Причём все нововведения, которые позволят хоть немного улучшить ситуацию (вроде snap/AppImage) фанаты Linux неизменно встречают в штыки и поливают помоями.

А там чуть не на каждой машине свой вариант пакетного менеджера и библиотек. Да даже тупо на уровне libc вертикальной совместимости ни хрена нет в этой системе, так что и для разных версий Debian/Ubuntu нужно разные сборки делать.

Патамушта нужны сырцы и дистрибутивы будут сами собирать и никакого монотонного труда, а закрытому коду тут не рады.

Причём все нововведения, которые позволят хоть немного улучшить ситуацию (вроде snap/AppImage) фанаты Linux неизменно встречают в штыки и поливают помоями.

Потому что все кому не лень (а точнее все кому лень или просто почти все) будут паковать библиотеки как в венде и привет расходу ресурсов на копии одной и той-же библиотеки и уязвимостям в библиотеках которые пакетный менеджер быстро латает а ленивые задницы авторов snap/AppImage — нет.

И возвращаемся к тому, что я написал ранее: Linux малопригодна для деплоя приложений без помощи майнтейнеров.

Это фундаментальный архитектурный изъян системы. Если майнтейнеры данного дистрибутива не считают нужным вот прямо сейчас собирать игрушку, значит юзеры будут сидеть без игрушки. Или на её старой версии. И как такое поддерживать вообще? Когда под винду фикс можно выложить мгновенно, и уже через полчаса он будет у всех, а под Linux хз как и хз когда…

Когда речь идёт о продажах, невежество пользователей становится проблемой разработчика.

Для тех, кто ушел чуть дальше от пещер, склонировать репу, прочитать README.md, запустить /.config ,make и make install не составляет никакого труда.

Вот, например, я вот далеко не самый тупой пользователь. Более того, мне несколько раз приходилось читать маны и компилить софт из исходников. Сел, почитал, разобрался, повторил, получилось. Но знаете, я не хочу тратить время на это. Вообще, ни минуты. Это тупая трата времени на рутинное дело, без которого прекрасно обходились даже 35 лет назад во времена MS DOS. Программа должна ставиться установкой галочки «я согласен с лицензией» и нажатием кнопки «установить».

А я хочу, а такие как вы хотят лишить меня этой возможности. Что посоветуете?

В идеале должна быть свобода — свобода выбора. Хочешь — ставь, хочешь — компилируй из исходников.

мир GNU/Linux разнообразен и большинство людей «не очень в компьютерах» используют в данный момент всего два дистрибутива — Ubuntu и Fedora.

разработчики пользовательского ПО могли бы так и писать — мы поддерживаем OS Ubuntu и OS Fedora. но зачем-то пишут «поддерживаем Linux» (они что — на ядре игру написали? ЛОЛ) и получают массу гемороя. А идёт это всё оттуда же — из-за отсутсвия элементарной начитанности по теме. ну и консультаций с профессионалами.

а потом появляются вот такие статьи. это всё нытьё какое-то в духе «у меня нет денег, фу плохой Apple хочет чтобы ему заплатили, прежде чем принят ПО». Если нет денег — просто не поддерживайте платформу. Будет таких людей много — платформа умрёт или изменится.

Только вот мне что-то подсказывает что в Apple отлично просчитали доход как разработчика так и свой, прежде чем вводить свои правила.

А, вот ещё одна история, но наоборот. В начале нулевых, когда Linux начал сильно раскручиваться на дэсктопах, возникла ситуация, когда для новых разработчиков Linux был привлекательнее, потому что средства разработки в нём были «из коробки», тогда как под Windows они стоили как сам компьютер. Хороший, мощный компьютер со всей периферией. Внезапно, правда? То есть порог вхождения был очень высоким. Сначала в M$ на это забивали, а потом осознали, что какая-то маргинальная ОС, место которой на сервере, внезапно может вытеснить их из мира настолок. Как? Да очень просто: новое поколение приходит, учится разрабатывать на доступном инструменте, а это инструмент — внезапно — не под Windows. А поскольку ОС, на которой работает инструмент и, соответственно, пишется ПО, бесплатная, пользователи тоже начнут туда уползать. В общем, они там осознали, кому-то что-то намылили, а что-то наскипидарили и выпустили Express-версию студии, чтобы, значит, молодняк от них не разбегался. Так и удержались. Я как раз в тот период разрабатывал под Windows и в конторе, где я работал, как раз стоял вопрос об обновлении инструментария и его цене.

Это всё к тому, что даже тех, кто работает со звуком и видео это зацепит, хотя и не сразу. Просто перестанут появляться новые производители, а старые вечно держаться не будут. Особенно — в отсутствии конкуренции с молодняком, которые голодный, злой и со свежими идеями. А Джобс, увы, умер и нового не видно. Да и новый-то будет не спасать чужую компанию, а раскрутит свою.

Older perpetual versions of our software were not designed, nor tested, to work on macOS 10.15 and are not supported in any way for use on macOS 10.15.

We do not recommend that customers using old versions of Adobe Software update to macOS 10.15.

Old products use 32-bit licensing components and installers and therefore cannot be installed and activated after upgrading to macOS 10.15. While upgrading to macOS 10.15 with these products installed may allow them to function in some capacity, you will not be able to reinstall or activate the software after the upgrade.

Customers may want to uninstall all these old versions prior to upgrading to macOS 10.15, as the uninstaller will not work after upgrading. The Adobe Cleaner Tool can be used to remove Adobe software on macOS 10.15.

это не совсем Adobe отвалился…

Это скорее — а давай вы все дружно раз такое дело обновите ваш 100 лет тому купленный софт, если что это не мы виноваты, это все вот они.

Пусть лучше пишут debian вместо ubuntu, т.к. то что пойдёт на первом с 99% вероятности пойдёт на втором а вот наоборот не факт. Да и Стим свою ubuntu приносит, так что вариант почти всегда рабочий.

Это тупая трата времени на рутинное дело, без которого прекрасно обходились даже 35 лет назад во времена MS DOS. Программа должна ставиться установкой галочки «я согласен с лицензией» и нажатием кнопки «установить».Не всегда обходились. Когда-то спасал жирный установщик, когда-то можно было наткнутся на ситуацию, когда в установщик не включён условный directx или .net и программа молча падала или не ставилась. Вполне лицензионная программа на вполне лицензионную винду.

Плюс ещё удалить программу со всем тем, что она наставила было либо очень сложно, либо невозможно.

Не всегда обходились.

Любую идею можно реализовать хоть плохо, хоть совсем через задницу, если захотеть :)

нажатием кнопки «установить»

Графическая оболочка в виде инсталлятора с прогрессбаром, скрывающая под собой /.config ,make и make install?

Даже сложный софт, включающий в себя десятки, а то и сотни библиотек, типа CAD-ов и сред разработки собираются на раз-два.Вот даже не знаю, как это назвать. «Дезинформация» как-то слабо звучит.

В центоси ещё проще, один раз написали спеку (или попросили юзеров) и положили в репу, а потом сборка 1 команда, rpmbuild -ba *.spec

А что скажите, к примеру, про msi?

>блин так дело же не в том, что клиенты плохие, а в том что игры разрабатывают под винду,

Я что-то пропустил когда ветка про игры из поста про игры начала скатываться в общее распространение приложений.

И да, в steam как бы есть не только игры

Сложно сказать, ведь steam приносит не только online update+drm но ещё и стабильный набор библиотек и среду исполнения, причём не всегда выходит получить его из дистрибутива.

Современные движки тоже сплошь хорошо умеют в кросс-компиляцию на что угодно, а если самописный то ты и сам знаешь как его собирать.

У меня есть утилитка одна — я майнтейню только PPA для Ubuntu/Debian.

Но пакет уже собрали 3 майнтернера под другие пакетные менеджеры/дистрибутивы. Причем я не просил, собрали мейнтейнеры дистрибутивов по просьбам пользователей.

И все пользуются…

Но моя утилитка не показатель — она на питоне и ставится из исходников без компиляции — только зависимости надо подтянуть (их не много).

Кто будет собирать? Юзеры?

Маинтайнеры

Для массового использования самому собирать и править сырцы перед сборкой? Это ответ почему у линукса такой процент в мире. Ну не для массового использования.

для конечного пользователя ничего не изменится

apt-get install hedgewarsи пошёл играться

А всё остальное требует чуть большей возни и почему-то многие думают, что пользователи линуксов на это не способны. Как по мне, нормальный вариант — просто сделать packages для скачивания.

> apt-get install hedgewars

Без sudo?

В официальных репозиториях, без добавления?

apt, кстати (не apt-get) работает без sudo (вызывает его сам когда надо). Вот только не помню, распростаняется ли это на дебиановский apt или только на LMDE-шный.

➜ ~ apt update

Чтение списков пакетов… Готово

E: Не удалось открыть файл блокировки /var/lib/apt/lists/lock - open (13: Отказано в доступе)

E: Невозможно заблокировать каталог /var/lib/apt/lists/

W: Проблема при удалении файла /var/cache/apt/pkgcache.bin - RemoveCaches (13: Отказано в доступе)

W: Проблема при удалении файла /var/cache/apt/srcpkgcache.bin - RemoveCaches (13: Отказано в доступе)P.S. Проверял на KDE Neon, что по сути Ubuntu 18.04

Ну не сказать, и snap и appimage оба вполне юзабельны, особенно если автор не хочет раскрывать исходники, но хочет предоставить гарантировано рабочую копию для любого дистрибутива.

Лично я предпочту установить spotify или skype в snap нежели обычными пакетами в виду своей проприетарности.

Если напрягает проприетарность, то надо не тащить в систему тонны мусора, а запускать программу в chroot и прочих «изоляторах».

Если напрягает проприетарность, то надо не тащить в систему тонны мусора, а запускать программу в chroot и прочих «изоляторах».

А разве snap не запускает пакеты в chroot?

А разве snap не запускает пакеты в chroot?Даже если и так, то он не изолирован от основной системы и имеет прямой доступ ко всему. Как следствие для изоляции блобов не годится.

Собираем бинарь без зависимостей (или складываем их рядышком), пакуем всё в архив, который следует распаковывать в /opt/ и норм. Кому надо — те перепакуют в *.deb или *.rpm.

Это уродливый костыльный способ. Как мне звук играть, как нотификации показывать или добавлять себя в меню пуск, как получать доступ к OpenGL?

В линуксе должен быть стандартизированный API платформы и стандартизированный способ доставки приложений. Если я когда-либо буду делать приложения для линукс, я ни секунды своего времени не потрачу на поддержку чего-либо, кроме Дебиан. Так как другие нестандартные дистрибутивы это проблема их разработчиков, а не моя. Либо давайте мне стандартную платформу, либо допиливайте мой воображаемый софт под свои нестандартные дистрибутивы сами.

Если я когда-либо буду делать приложения для линукс, я ни секунды своего времени не потрачу на поддержку чего-либо, кроме ДебианКстати, было бы хорошо, если бы все делали приложения хотя бы под один дистрибув. Скажем, если бы все приложения существовали под последнюю LTS Ubuntu, то сделать не-эмулятор (как Wine, но реализующий Убунту) под все остальные дистрибутивы было бы значительно проще.

Поздравляю, вы только что изобрели Steam Runtime.

Вы просто сравниваете тёплое с мягким. Не надо так.

Да даже тупо на уровне libc вертикальной совместимости ни хрена нет в этой системе

Вы так говорите будто между релизами vcredist какая-то совместимость есть.

Тут вроде бы речь о разработке игр, а это обычно Steam со своим рантаймом.

И если у у тебя на втором написано может и не заработать на свежих версиях.

Лично я сталкивался с приложениями, не работающими из-за слишком новой версии fontconfig. Наверняка с другими либами тоже бывают такие проблемы.

Просто решения типа snap/AppImage технически ужасны: тянуть все с собой и ставить бесконечное колличество идинаковых либ — печаль беда.

Насчёт AppImage согласен, а вот snap/flatpak — уже совсем другое дело, они предоставляют шаренные рантаймы и дедуплицируют одинаковые либы внутри пакетов.

Прибивают к версиям т.к. не все библиотеки имеют стабильный ABI, поэтому прописывают версию, а далее идёт совместимость с диапазоном...

Потому что Linux — это не система, а ядро. У ядра строгая обратная совместимость ABI в userspace — Торвальдс бьёт по рукам за даже самые благие попытки её поломать.

А дальше, по сути, каждый дистрибутив следует воспринимать как отдельную систему. У RHEL, например, есть такая же обратная совместимость и по libc, и по базовым библиотекам, если компилять через RHEL devtoolset.

Только ориентированы коммерческие дистрибутивы строго на серверный или embedded рынок. Десктоп под GNU/Linux продвигается исключительно ради разработчиков, т.к. под их привычки потом работодатель выбирает "понятную" серверную ОС.

А там чуть не на каждой машине свой вариант пакетного менеджера и библиотек. Да даже тупо на уровне libc вертикальной совместимости ни хрена нет в этой системе, так что и для разных версий Debian/Ubuntu нужно разные сборки делать.

тут такой же принцип, что и с win/macos/linux: подавляющее большинство сидит на последней стабильной убунте, и по сути таргетить достаточно весьма счетное число дистрибутивов. Часть из которых, кстати, совместимы друг с другом. Да и портировать между дистрибутивами линукса куда проще, чем с винды — создаете N докер контейнеров, в которых будет отличаться только набор установленных пакетов, и в них компилируете.

А вот если пытаться все свои зависимости тащить с собой, как это привычно делать на винде, действительно можно наесться. Собственно, поэтому "(вроде snap/AppImage)" и критикуют — такая модель распространения уменьшает «дурную работу» в краткосрочной перспективе, но преумножает её в долгосрочной.

Посмотрите на это с другой стороны: существует куча софта, которая работает на линуксах, и работает успешно. Скажем, тот же стим явно столкнулся с вашими проблемами и успешно их преодолел.

Делал с помощью Inno Settup и с помощью WiX. В обоих проектах приходилось учитывать разные версии винды. Так что фразу «Это на винде один раз завернул — и с высокой вероятностью оно будет работать везде, от XP до 10.» мой опыт опровергает полностью.

А ещё наша прога имела зависимости от другого софта и сторонних библиотек. И тут мне с грустью вспоминалось apt.

Это потамушта первый уровень игры в linux — сборка ядра;)

как идея snap/flatpack/AppImage — великолепны. реализация пока сильно хромает.

А там чуть не на каждой машине свой вариант пакетного менеджера и библиотек. Да даже тупо на уровне libc вертикальной совместимости ни хрена нет в этой системе, так что и для разных версий Debian/Ubuntu нужно разные сборки делать.Что мешает статически линковать? Тот же firefox скачаный с офсайта прекрасно запускается что на дебиане, что на арче.

1) деплой игрушек на линуксы в большинстве своём идёт через steam, а там уже есть steam runtime.

2) поддержка актуальных lts-дистрибутивов не сложнее поддержки разных версий windows

У винды, как и у центос, срок жизни 10+ лет. ХР больше 10 лет только похоронить пытаются, самой оси за 20 лет уже. Но удивительное дело, до сих пор есть компы с ней. У меня например один комп.

Дебиан — 2 года и привет. Для постоянной разработки это неплохо, но для дома и для проектов которые уже запустили и больше не выделяют денег на «пустые» изменения кода (изменили что-то в дистре — надо фиксить) это ужас. Выпустили LTS, но этого всё-равно мало.

А ещё, поставив ту же 7, я хочу чтобы все обновления не ломали привычный мне интерфейс и прочее. В линях все эти wayland, «плазма больше не падает» и прочее делают больно. А ещё иногда обновление версии ломает видео например. И в итоге проще сидеть на уже устаревшей версии, где всё привычно и работает.

Если считать что «линух для домохозяек» — при таком подходе нужно в корне менять подход, в том числе по времени сопровождения каждой версии. Проблема что многим программистам не понять этого желания стабильности, часто им «нужно же быть новым, модным, молодёжным». За примерами ходить далеко не надо, собирал какие-то гугловые либы под центос 7 пару лет назад, подавай им только последние версии либ и компиляторов. В результате проще найти/написать не такую хипстерскую поделку.

самой оси за 20 лет уже

18, если быть точным, а поддержку закрыли 5 лет назад. Но это для дэсктопов, а я для «встраиваемых» систем вроде банкоматов — только в этом году. Пытались. И продлили ещё на год, потому что в США в следующем году, а много где в госучреждениях до сих пор на хрюне сидят и на Win7, которую тоже должны были закрыть с января, но не получилось.

Позвольте мне объяснить.

Допустим, купило игру 100,000 пользователей.

94% пользователей на Windows -> 94,000.

4% пользователей на OS X -> 4,000.

2% пользователей на Linux -> 2,000.

Если 94% продаж было сделано для Windows, а от их числа в саппорт поступило 20% запросов, то в итоге получается 94% * 20% = 18.8% запросов от общего числа купивших игру -> 18,800 тикетов.

4% продаж для OS X * 50% запросов -> 2% пользователей -> 2,000 тикетов.

В итоге — количество тикетов от пользователей Windows в 10 раз больше, чем от пользователей OS X. Означает ли это, что нужно прекращать поддержку OS X?

Если просто смотреть на сухие цифры: 50% и 30% — то может показаться, что OS X приносит слишком много проблем, однако из этой статистики + описании проблемы мы видим, что проблема не в OS X и 50%, а в том, что:

1. Нет нормальной поддержки для OS X, из-за которого эта цифра выше, чем для Windows (автор признался сам в отсутствии нужных знаний).

2. Слишком мало пользователей играют на OS X (в 20+ раз меньше чем на Windows), что заставляет задуматься — а зачем автор вообще пытался освоить этот рынок самостоятельно, без внешнего инвестирования, если усилия того не стоят? Можно было попробовать профинансироваться через кикстартер/аналоги, или хотя бы просто спросить пользователей, а нужна ли им версия под Мак.

Короче говоря, диаграмма «Support Requests by Platform» не может являться показателем того, что нужно ориентироваться на рынок Windows, а про OS X забыть. Совсем другое дело, если бы количество тикетов было на одном уровне, но для этого и доля рынка OS X должна была бы быть не 4%, а 30%, а это уже будет означать, что автору придётся его осваивать, если он не хочет потерять 30% возможной прибыли.

Блин, я только сейчас всмотрелся и обратил внимание — доля Linux + Windows занимает на графике 50%, при этом визуально у Linux должна быть доля 12.5% (потому что линия под углом 45%, по пикселям видно), а по цифрам — 30%.

Кто-то врёт — или график, или цифры, или и то и другое. Может и у OSX не 50% в итоге, если эмоции из статьи вычесть?

Не ясно, считаются ли %% "от числа купивших" или % от общего числа клиентов

но надо смотреть иначе

Сколько денег приносит средний юзер и сколько денег стоит средняя поддержка этого юзера на той или иной платформе

Автор кстати почему то не пишет про еще одну милую особенность Apple-железа. Из-за который например Elite:Dangerous маки теперь вообще не поддерживает. Сначала OpenGL у Apple стал устаревшим и мол не будем мы обновлять стандарт а потом и вообще — он совсем устаревший, быстро переписали все под Metal (даже не кросс-платформенный Vulkan).

У меня из круга общения еще нередка ситуация когда винда при этом вообще становится основной системой, и на вопрос зачем было покупать мак, человек недоуменно разводит руками.

Зато по функциям, начинке, и возможности выбора этой самой начинки — будет, и в положительную сторону.

P.S Для тех кто верит что Apple свои ноутбуки как то ОЧЕНЬ качественно в отличии от других производителей делает, велком на любой ремонтный форум, либо пообщайтесь с людьми которые занимаются их ремонтом.

Такая же тотальная экономия на всем, что не заметно пользователю, никакого запаса по прочности, все как у всех в общем то в этом ценовом сегменте.

И кончилось это все покупкой таки нескольких девайсов включая эппл )

Вот, сайт dns, брал от минимума, предлагаемого apple

добавляем «сканер отпечатков» и «thunderbolt» и не остается вообще ничего кроме макбуков

железом из 2017-ого, с маком 2019-ого с железом из 2019-ого — там соответствующая разница в проце (8250U vs 8257U)Эм с учетом того, что сейчас поступают в продажу процы 10го поколения. То такое сравнение процов восьмого поколения выглядит никак не в пользу макбука…

Lenovo Yoga 920

тот же проц двухлетней давности. Он кстати, уже в ценовой категории мака.

Кстати говоря трансформеров у apple нет ещё

трансформеры как класс устройств очень нишевый продукт. И они начнут распространяться только когда под них будут сценарии использования с адекватным интерфейсом. Сравните презентацию первого планшетного компьютера от Гейтса в 2001 и от Джобса в 2010.

Ну я и покупал 1,5 года назад

Там слабо эволюционируют процы.

10-20% уже существенная разница. Плюс, новый более энергоэффективен под низкой нагрузкой

а не вот например thunderbolt не нужен, вот совсем.

Не зарекайтесь, thunderbolt удобен и достаточно быстро набирает популярность — с ним нормальный монитор превращается в док-станцию. Разумеется не факт, что года через 3 все коммуникации перейдут на usb-c/thunderbolt, но мне было бы обидно сейчас купить ноутбук и потом испытывать ограничения.

А насчёт нишевый продукт, мне очень нравится, кинцо удобно в самолёте посмотреть.

вот таких юзкейсов мало для повсеместного распространения форм-фактора. Хотя, думаю если apple объединят маки с айпадами (на маках уже можно запускать приложухи с iPadOS), он наберет популярность быстрее

ну в моём ноуте всё таки i7-8550U, а не i5, так что разница в производительности не понятна

если верить geekbench 5, то lenovo yoga 920 i7-8550u(win) сильно уступает MBP 2019 i5-8257u и своей linux конфигурации. Судя по всему, на винде вендор попросту ограничил частоту проца в многопоточке от перегрева.

И тех процесс у обоих 14nm, так что энергоэффективность я считаю одинаковая.

это делеко не единственный критерий же: на 14-нм техпроцессе и ксеоны c 165W tdp, и y-серия с 8W. У 8257u даже банально базовая частота ниже.

куча интерфейсов сгинули в небытиё…

Ну у кого-то конечно и LPT актуален. Скажем так: жить с единственным thunderbolt портом уже сегодня проще, чем с любыми двумя из набора USB-A/HDMI/Display port/jack/ethernet (которого уже в большинстве ультрабуков нет) плюс зарядка.

ну то есть процы i7-8550u и i5-8257u приблизительно равны по производительности.

уточню: процы приблизительно равны. Производительность конкретных конфигураций конкретных ноутбуков — нет

По моему, это самые тонкие и легкие ноутбуки из существующих. Производительность? Пожалуйста: i5, i7. Диагональ? 13, 15, 17. Хороший большой тачпад и очень хорошее время работы от батареи.

предоставят ли мне подменный ноутбук — понятия не имею.

Если продавцу или изготовителю было заявлено требование о ремонте или замене технически сложного товара, то можно потребовать также предоставления Вам аналогичного товара на период ремонта или замены Вашего (этот товар должен быть предоставлен и доставлен в течение трех дней).

Ну вот если бюджет до 150к как у прошек — неплохой ноут от асуса: https://www.dns-shop.ru/product/09b06875649c1b80/156-ultrabuk-asus-zenbook-ux533fd-a8139t-sinij/

Памяти в 2 раза больше, ССД в 4. Есть нормальная дискретная видеокарта, то есть поиграть можно. Экран не 2к а FullHD но для такой диагонали это даже лучше. не 13.3", а 15, если это смертельный недостаток то тогда конечно не подходит. В остальном буквально всем лучше, разве что вес на 300г больше.

Для тех кто верит что Apple свои ноутбуки как то ОЧЕНЬ качественно в отличии от других производителей делает, велком на любой ремонтный форум, либо пообщайтесь с людьми которые занимаются их ремонтом.

Что-что, а уже за ноутбуки Apple вполне нормальные деньги просит.

Полные аналоги от других производителей стоят столько же.

Вот только не надо тут сравнивать только процессор, но «забывать» тачпад или корпус к примеру. Я про то, что если по всей совокупности признаков (кроме ОС, конечно) смотреть аналоги — то вы удивитесь, что конкурирующие модели стоят ровно столько же, что и ноутбуки Apple.

Однако, в контексте разговора — когда нужна именно MacOS разработчику, то тут выбора нет. Даже с Хакинтошами не все гладко.

Вот только не надо тут сравнивать только процессор, но «забывать» тачпад или корпус к примеру.Ну, если подбирать полные аналоги, то тогда можно и MacOS включить, и тогда, разумеется, их не будет.

А вот мне, например, тачпад в ноутбуке вообще не нужен, если есть трекпоинт. Которого у Apple нет. Почему нужно включать именно то, что есть в макбуке, и именно в таком виде, в каком оно там есть? Это получается как тендеры на закупку, которые пишут таким образом, чтобы прошёл только один конкретный продукт.

Просто само собой, что если вы ищете по единственному критерию «ноутбук как МакБук», то наиболее подходящим будет именно МакБук. А если бы критерии были хоть чуть другими, то, возможно, и МакБук бы в них не попал.

Sketchbook Pro продемонстрировал, что тачпад чувствителен к силе нажатия. Этим я чаще баловался, чем использовал для дела, но как-то и иллюстрации подправлял на тачпаде.

Я не проверял, работает ли это где-то еще, но на тачпаде мака можно одним пальцем взять файл (или узел контура) и начать перетаскивать, а если тачпад кончился, то не отпуская, другим пальцем «прокрутить» до нужного места.

Форс тач и реакция на скорость перетаскивания также порядком изменили привычки работы на ноуте. А еще размер на последнем про огромный, куча жестов. И по сравнению с предыдущим тачпад намного проще переносит попадание воды. Просто вытер и все, а раньше нужно было сушить и молиться.

Вот кнопки-бабочки — говно. Приятные, но я через год уже менял по гарантии верхнюю крышку со всеми кнопками, потому что пробел и альт померли.

Что новенького появилось за это время?

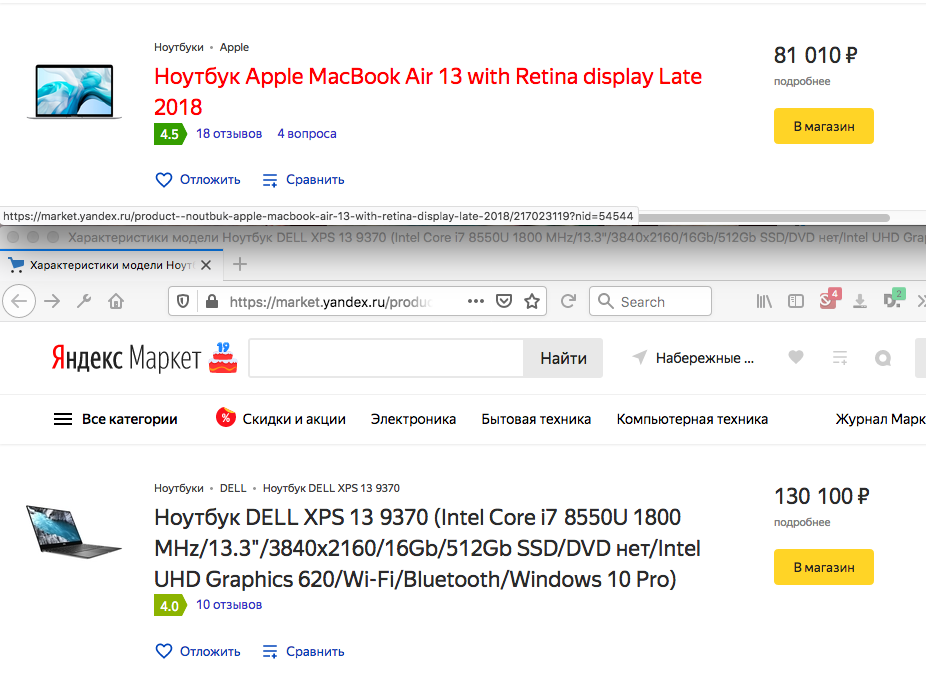

Ну, например вот Apple и вот Dell.

Дальше смотрим (Apple слева):

— i5 против i7;

— 2560x1600 против 3840x2160;

— 1.25 кг против 1.21 кг;

И наконец, 130к против 90.

Вас устроит такой ответ с моделями и ценами?

UPD. Да, ссылка с критериями выбора, а то получаются два ноута сферических в вакууме.

А мне показывает 102 и 117 (Apple и Dell соответственно, по тем же ссылкам). Похоже, по регионам очень сильно варьируются цены.

Ну, например вот Apple и вот Dell.

Дальше смотрим (Apple слева):

— i5 против i7;

— 2560x1600 против 3840x2160;

— 1.25 кг против 1.21 кг;

И наконец, 130к против 90.

i5-8257U (2019) vs i7-8550U (2017). Вообще, для технического ресурса сравнивать процессоры по цифре линейки недостойно.

— 2560x1600 против 3840x2160;

если бы только винда умела нормально в 4к )

А еще один нюанс — dell xps ужасно проблемная линейка. Почитайте хотя бы комментарии по вашей же ссылке. У нас в компании даже проводили опрос по xell xps и 2/3 пользователей сталкивались с различными проблемами. А еще, если верить некоторым обзорам dell xps по толщине не 11.6 мм, а все 15 (для сравнения: заявленная толщина 13" прошки — 12.9мм, с учетом ножек — 14). Где-то даже на хабре была статья про все их проблемы.

i5-8257U (2019)В модели 2018 года?

Может быть, может быть… Только вот беда, у i5-8257U в спецификациях Интела указаны четыре ядра и шесть мегабайт кэша, а у Apple в спецификациях заявлен процессор по цифре линейки, но с двумя ядрами и четырьмя мегабайтами кэша.

Кому верить: вам или Apple?

А еще, если верить некоторым обзорам dell xps по толщине не 11.6 мм, а все 15Я на секундочку напомню тот текст, на который я отвечал.

Основательный ответ — это ответ с моделями и ценами. Сколько на моей памяти ни пытались показать (тут на хабре) аналоги — всё время что-нибудь не то: то i3 вместо i7, то FullHD вместо ретины, то TFT вместо IPS, то 4 килограмма вместо одного, то пластиковый корпус вместо металла.Если вы не заметили, я посмотрел все затребованные автором комментария характеристики (о ужас, он тоже сравнивает процессоры по цифре линейки!) и привел сравнение именно по ним.

Теперь же, оказывается, все недостатки в том, что Dell по некоторым обзорам толще! Пускай легче, зато толще! На целых два миллиметра и одну десятую!..

Вам самому не смешно?

Единственная ваша претензия по делу — это ссылка на комментарии с проблемами. Смотрим на комментарии.

Недостатки:

Экран легко царапается, клавиатура оставляет на экране потёртости

заменили вентиляторы, материнскую плату, теперь скрипит кнопка Enter.

wifi-модулем от компании Killer. Карта отвратительная: скорость загрузки то и дело падала до 100-300кб/с, соединение разрывалось, а при выходе из спящего режима она вообще убивала сеть, приходилось перезагружать роутер.

Адский шум кулераОкей, проблемы налицо. Но давайте сходим в комменты к макбуку?

внезапно начинает шуметь жутко и греться, хотя запущены только ворд и вотсап

Если бы клава не оставляла царапины на экране, то поставил бы 5. Кто нибудь ещё сталкивался с такой проблемой?

— есть такое дело. В области клавиш А(F) — О(J). Царапины появились спустя 2 месяца использования

Сегодня доставят уже третий эир 2018 за вторую неделю… Будем надеяться на чудо ...

Купил для работы попробовать Air 2018, док-станцию, клавиатуру и мышь (ОМГ клавиатура и мышь = 20000 руб!). До этого мой основной ноут — HP Probook G5/450Почитаешь, плюнешь на эти ноутбуки, и пойдешь собирать десктоп из комплектующих. По крайней мере, у него клавиатура экран точно не поцарапает.

Сравниваю с Windows и этим буком:

Винда всегда как нужно засыпает и уходит в гибернацию. Тут чистый бук не уходит в слип надолго, а после шаманства иногда уходит в гибернацию. Вынужден выключать ноут каждый раз. Спросил у коллег — они привыкли к теплому ноуту в сумке…

Жлобский блок питания (благо у меня был от HP БП на 90W type-c). Как за такие деньги можно в комплект давать 35W БП — не представляю!

Веб-камера у HP Probook за 60 тыс руб HD, а тут прям сильно хуже...

Кому верить: вам или Apple?

упс, перепутал MBP и MBA. Я, впрочем, назвал бы вторую линейку неактуальной учитывая смехотворную разницу в мобильности с прошкой и огромную в производительности

Пускай легче, зато толще! На целых два миллиметра и одну десятую!..

Вам самому не смешно?

дело не в том, что он толще мака, а в том, что он толще чем заявил производитель, на почти 30%.

Единственная ваша претензия по делу — это ссылка на комментарии с проблемами. Смотрим на комментарии.

Смотрим комментарии. Да и в целом это «работает» с любой статьей про «dell xps». У маков меньше распространенных проблем, наподобие проблем с клавиатурой, и совершенно иное к ним отношение. Опять же, MBP — самая популярная линейка ноутов, и сравнивать в лоб по числу проблем нельзя из-за «ошибки выжившего».

упс, перепутал MBP и MBA.А, ну это нормально.

А то я уже начал сомневаться в своем умении читать. Но прошка вроде бы еще дороже?

дело не в том, что он толще мака, а в том, что он толще чем заявил производитель, на почти 30%.Обычно я тоже смотрю на относительные числа. Но когда речь идет о первых миллиметрах и бытовой технике… Колбасу резать я не смогу ни Деллом, ни Маком, да они как бы и не для этого. У Делла косяков на самом деле хватает, как бы я нежно к нему не относился: но придираться к трем миллиметрам, это имхо несколько за гранью разумности.

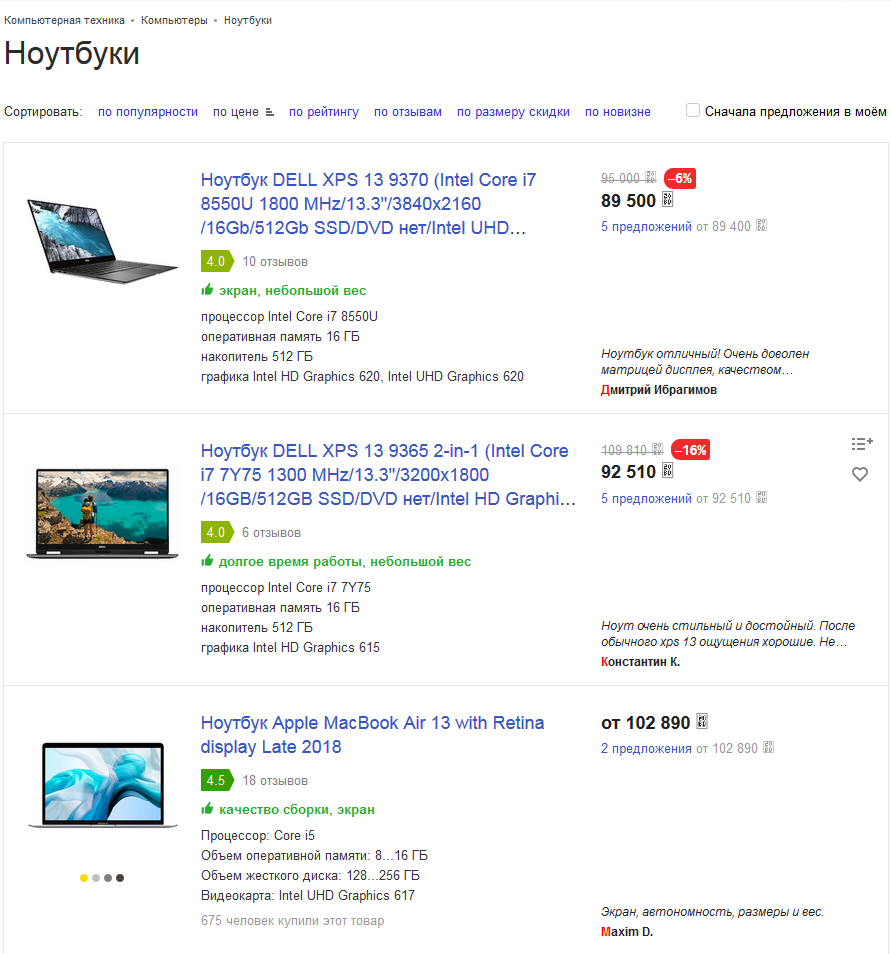

Но в конце концов ладно: не нравится вам Делл, вот вам Леново за 105 килорублей (интересные дела творятся с ценами на яндекс-маркете: утром показывали AIR за 102 тысячи, сейчас при поиске по тем же параметрам минимум за 139, но уже только 2019 года, предыдущая исчезла из выдачи).

Металлический корпус, 1.12 килограмм (в комментах пишут, что зависит от версии, но «легче макбука»; во всяком случае про «четыре килограмма» речи не идет), IPS 3840x2160, Whiskey Lake i7-8565U.

Толщина, правда, подкачала: целых 14.1 миллиметра. Беда…

Леново я не особо люблю, но почему бы и нет?

Рядом примостился целое семейство HP Envy от 93 до 101 тысячи (посмотрим, что будет с ценами на маркете завтра), на 50 граммов тяжелее МакБука. Толщина, правда, целых 15 миллиметров, да…

Так вот, основательно отвечая на вопрос уважаемого oisee, вообще-то выбор есть. И процессоры пошустрее, и экран правильный, и корпус, и весят примерно столько же. И стоят дешевле. А доплачивать по десять килорублей за миллиметр толщины, по моему скромному, как-то кучеряво. Но опять же, дело вкуса.

Объективное имо — за тачпад/макось мака можно и переплатить.Может быть, и можно.

Про тачпад маков рассказывают столько, и с таким восхищением, что создается ощущение, что он еще и кофе варить умеет. Притом, что я всегда почитал тачпады заменой для мыши лишь немного лучшей, чем песок овсу — мне уже некоторое время интересно, что же за магия такая скрыта в маковском тачпаде.

Но это, видимо, выплывет только через некоторый опыт использования, что покамест мне не грозит.

А макось… Это, видимо, на любителя. В виртуалке она у меня есть, любопытства ради: но оценить ее по достоинству я, похоже, пока не могу.

Про тачпад маков рассказывают столько, и с таким восхищением, что создается ощущение, что он еще и кофе варить умеет.

Его достоинства:

а. больше среднего тачпада

б. force touch — не надо выискивать m1/m2 или поднимать палец (рискуя сдвинуть курсор), нажимаешь точно туда, куда навел

в. его жесты полезны и удобны в macos (да, на винде/линухе он теряет массу очков)

г. хорошо откалиброван (мало ложных срабатываний/пропущенных событий, отличная точность позиционирования)

Разумеется, это все еще тачпад: в quake на нем не забожишь. Часть его плюсов есть и в других ноутбуках, но я не встречал чтобы в полной мере. Жесты, разумеется, дублируются горячими клавишами, но они удобнее. Собственно, поэтому юзкейсы а-ля «глянуть что-то держа ноут одной рукой» не создают никаких трудностей.

Притом, что я всегда почитал тачпады заменой для мыши лишь немного лучшей, чем песок овсу

ага, тоже так думал, а спустя пару месяцев на маке отложил клаву с мышкой в сторонку и продолжил работать на тачпаде + клаве ноута

б. force touch — не надо выискивать m1/m2 или поднимать палец (рискуя сдвинуть курсор), нажимаешь точно туда, куда навел

Такое сейчас у многих есть.

в. его жесты полезны и удобны в macos (да, на винде/линухе он теряет массу очков)

В GNOME Shell тоже много удобных multi-touch жестов для тачпада из коробки.

Ни в коем случае не берусь сравнивать тачпады маков и других ноутов (я тоже не фанат тачпадов как таковых), но по моим наблюдениям перечисленные преимущества у других производителей тоже есть.

а. больше среднего тачпадаНа моем рабочем маке у меня регулярно этот тачпад срабатывает когда я что-то печатаю на клавиатуре. Он должен блокироваться в теории, но иногда почему-то нет. Был бы тачпад поменьше как у остальных ноутов — было бы заметно проще на нем работать. Это я к тому что большой тачпад — совсем необязательно плюс.

Это я к тому что большой тачпад — совсем необязательно плюс.

большой тачпад как минимум удобнее для жестов тремя и более пальцами.

На моем рабочем маке у меня регулярно этот тачпад срабатывает когда я что-то печатаю на клавиатуре

хм, не испытываю такой проблемы на своем маке, возможно, вы просто неправильно его держите (хихи).

не испытываю такой проблемы на своем макеНа не-маках, кстати, довольно регулярная проблема. Основания больших пальцев только так ложатся на тачпад. Особенно весело бывает редактировать большой объем текста, с непредсказуемыми перескоками точки ввода.

Я про это, признаться, и забыть успел, ибо на чужих ноутбуках давно не работал, а на своих всегда внешняя мышь, и тачпад отключен.

На не-маках, кстати, довольно регулярная проблема

так на маке же простое касание тачпада ничего не делает, нужно именно кликнуть. Да и сдвинуть курсор основанием большого пальца получится разве что специально

простое касание тачпада ничего не делает, нужно именно кликнутьА (если вам не сложно) как тогда выглядит перемещение курсора мыши? На обычном это коснулся, провел пальцем, отпустил. А на маке?

Может вы когда печатаете кисти держите на корпусе? Это весьма опасно и провдит к тунельному синдрому, кисти должны быть в воздухе при печати.

Последил за собой. Иногда держу на корпусе, иногда в воздухе, в зависимости от продолжительности сеанса печати. Если надо напечатать два слова, а потом подумать над следующими двумя, то на корпусе. Если нужна длинная фраза, или больше одной фразы — то кисти в воздухе.

Но туннельный синдром в наличии, хотя в довольно легкой форме. Шесть лет уже… правда по ощущениям, больше от привычки подпирать рукой подбородок. Пришлось себя переучить на подпирание кулаком.

то TFT вместо IPSТак и хочется сказать «ой, всё!» Может, там ещё и дисплей вместо ЖК, клавиатура вместо «бабочки», и порты вместо USB?

Правда свежий стим клиент на каталину еще не пришел.

С индивидами которые ставят на мак винду тоже знаком. Зачем они это делают я так и не понял. В игрушки которые они играли есть нативные версии и для маков. Возможно нет физически второго ПК.

Ларчик открывался довольно просто. Человеку нужен ноутбук, человек спрашивает, какой ноутбук хороший. То реклама, то добрые люди советуют макбук. После покупки, распаковки и подключения следует минут десять офигелого взгляда с немым вопросом «что это и как с этим работать?», а дальше рука тянется к телефону и набирает номер знакомого эникея. Верните привычную винду!..

У меня imac и я играю. Но в нормальные игры, а не "это"

В андроиде надо всего нажать дружелюбную кнопошку и согласиться с недружелюбным проклятием. В макоси же в страшной консоли пишется заклинание, которое надо еще правильно нагуглить.

Вот тут (парой постов ниже) человек разумный предлагает делать так, как я делаю уже несколько лет, и никаких нецензурных фраз в консоли и прочих танцев с бубном ни разу не требовалось. Но это же не наш метод, да?

Хамить будем дома, ок?

Указывать дома будем, ок? :)

Нет уж чистить комментарии, давайте разберемся.

Я написал комментарий с точкой зрения, которая была неверной, и я ниже это признал, поскольку мне на это несколько раз указали. Вежливо указали, заметьте. А вот эти вот "привычка с Windows" и "не наш метод" — это хамство, так не говорят с незнакомыми людьми. При том, что я в ответ не хамил.

Печально, что когда я поставил человека на место, меня заминусовали — это значит, что часть аудитории хабра не считает хамство в комментариях чем-то постыдным.

Да есть еще адекватные люди в мире кторые для для запуска долбаного ранера, под сборку 1ОС приложений не покупают мак за 3к баксоф, а юзают более адекватные и технологичные решения, не смотря на обмазывание епла лицензиями, воплями про авторские права и всовыванием палок в колеса разработчикам на каждом шаге.

> мак за 3к баксоф

Самый дешёвый MacBook стоит чуть меньше 3k$ — примерно раза в три. И это новый-официальный. Если поискать на том же Авито, то можно взять за 30-40кР модель прошлых-позапрошлых годов, которая будет обновляться до последних версий ОС ещё очень долго.

Пункта «Anywhere» вроде как нет в разделе «Allow apps downloaded from:», доступны только «App Store» и «App Store bad identified developers». Нужно руками через терминал включать этот пункт.

Не нужно его включать. Первый раз запускаете программу «ABC Super Soft» скачанную из интернета, появляется в настройках пункт «Разрешить запуск „ABC Super Soft“»

При запуске от неидентифицированного разработчика оно сначала отправляет в пеший поход с эротическим уклоном, сразу после идём в «System Preferences»/«Security & Privacy»/«General» и видим там кнопку «Всё равно запустить это опасное приложение от неизвестного разработчика». Жмём её и запускаем повторно.

Процедура для каждого ПО однократная, дальше macOS запоминает Ваше решение и по мозгам в этом месте уже не ездит :)

Да, и автор прав, унизительная практика «ручного устаревания» всего и вся, не многим нравится.

Претензии понятны, но суть сводятся к вашим же словам о том, что вы не потянули как финансово, так и физически вести данный проект в одиночку на разные платформы, когда требуется ещё и поддержка клиентов.

Нынешние ОС настолько «утяжелились» лишним, что их спасёт либо жёсткое, частичное выпиливание менее актуального кода, либо переписывание с нуля.А что с ними такого что их вообще нужно спасать? Если вам нужна система на тостер (хоть метафорически, хоть буквально), где нет ни места ни мощностей, то вам все равно придется искать или допиливать что-то отдельно. Но на абсолютном большинстве пользовательских машин которые продаются сейчас никакой проблемы поставить тяжелую винду с обратной совместимостью нет. Более того, за последние годы системные требования винды практически не выросли — то есть все большее количество железа может ее без проблем запускать. Так есть ли проблема которую вы хотите решить? В теории есть конечно, но что насчет практики? А вот проблема с ПО которое отвалится на макоси — совершенно реальна и с ней столкнутся множество людей.

Ключевая проблема производительности десятки и восмерки не в совместимости, а в нагромождении телеметрий и желании пропускать все через свои сервисы. Если закостылить, то система начинает намного свободнее дышать.

Ключевая проблема производительности десятки и восмерки не в совместимости, а в нагромождении телеметрий и желании пропускать все через свои сервисы. Если закостылить, то система начинает намного свободнее дышать.

Позвольте с вами не согласиться:

Практика использования Windows Vista/7/8/10 на том же железе не подтверждает этого факта.

Напротив — именно Windows 10 заметно отзывчивее поколения Windows Vista/7

Что до телеметрии — то отправляющиеся в фоне данные не влияют на производительность.

Проверить про торможения из-за сервисов MS, «на которые все завязано», не могу — по причине того, что штатным образом (нажатием двух кнопок при установке) отказался от их подключения.

Поделитель, как вы отказались при установке? Тот же рантайм брокер через который много чего работает (даже дефолтное приложение для просмотра фоточек!) может намертво вешать систему если у вас много картинок в системной «картиночно» папке, во всяком случае так это было у меня на среднем ноутбуке несколько лет назад.

для решения было принято решение перевести это безобразие на ссд и накатить чистую 10 с последующим ручным отключением ништяков от МС

как итог бук летает и больше такой фигней не занимается

ЗЫ да хватило бы просто чистой винды и оптимизации, но для большего комфорта было принято решение воткнуть ссд

Увы, нормальная культура разработки в гражданке невозможна — она просто не выдержит конкуренции. Пока вы будете выводить идеальный код, конкурент займёт весь рынок поделием из палок и вам просто не будет места.

Пока вы будете выводить идеальный код, конкурент займёт весь рынок поделием из палок и вам просто не будет места.

Причем к тому моменту когда вы будете готовы запустить релиз свой идеальной программы — конкурент выкатит уже 2 или 3 версию с доработками, новыми фичами и поправленными дефектами и ваша идеальная программа будет не так уж сильно выигрывать на фоне популярной.

Куда проще нанять быдлокодеров, продать продукт, получить доход и заняться чем-то новым. Или новой версией, которую тоже скорее монетизировать.

Это NVMe накопитель (примерно 3Гб/сек), 64Гб ОЗУ и 8Гб видеопамяти. 2015/2016-й год по железу.

Но этого мне хватит аж до 2022-го.

При этом на оптимизацию я не забиваю. Просто у меня такая работа, что чем больше я сожру памяти и процессора, тем как раз выше она самая (оптимизация)… надо умудриться утилизировать как можно больше мощности ради увеличения скорости работы ПО (железо должно работать по максимум).

Скажем где-то софт будет использовать предельное сжатие всех ресурсов и места будет кушать на диске минимально-возможно (еще и не будет тащить с собой даже самых критически важных компонентов, рассчитывая на их уже наличие в ОС).

Однако во-первых оно может даже не запуститься, во-вторых будет вечно жрать ресурсы ЦП на всевозможную декомпрессию по 100500 раз.

Взять те же современные игры, размер которых перевалил далеко за 50Гб. Да, это одна из самых лучших оптимизаций — мы теперь не едим мощности на компрессию-декомпрессию ресурсов. А в сыром виде их кормим видеокарте.

Или моя ситуация — софт будет кушать столько памяти сколько найдет. И это будет исключительно правильно. Такая заточка у него.

Хотя коллеги по общему IT цеху от такого бывали в ужасе (когда рассказывал). А то, что время исполнения снизилось радикально в десятки раз — это они почему-то (сарказм) считали само собой разумеющимся.

Задача то не любоваться десятками гигабайт памяти и тонной потоков-ядер, а получить выхлоп как можно скорее. Соот-но чтобы приблизить выдачу результата надо как можно более сильно распараллеливание вычислений. Желательно еще и так, чтобы даже если упадет, то остальных не затронуло — значит всюду тонны дублирования, память расходуем камазами. Но никакой в этом трагедии нет. Железо обязано работать.

пусть даже с играми, но тоже спорно

Ничего спорного в упор не вижу. Зато вижу тот же FarCry 5, который просто идеально летает благодаря подобному подходу.

Если у кого-то не хватает головы правильно использовать концепцию — тут концепция не виновата.

Что это за бред?

А я откуда знаю — мне этого приписывать не нужно. Про это я ничего не говорил.

какая демагогия

И где тут демагогия тоже не понимаю. Я рассказал про то, как кто-то не понимает зачем в определенных ситуациях нужно всепоглащение ресурсов. И что это и есть оптимизация.

*У меня есть еще один пример перед глазами — Cities Skyline… эта игра у меня сжирает 25-30Гб оперативной и 24 видеопамяти (8 своей + еще 16 отбирается из общей).

И это просто прекрасно! Игра изумительно плавная, позволяет строить целые агломерации, а не пресные кварталики, как в SimCity 2013. Чувствуется исполинский размах.

И лагов нет — вся игра в память целиком.

И где тут демагогия тоже не понимаю. Я рассказал про то, как кто-то не понимает зачем в определенных ситуациях нужно всепоглащение ресурсов. И что это и есть оптимизация.

Оптимизация — это максимально эффективное использование ресурсов компьютера, где используют подходы что экономят и память, и процессор. Far Cry 5 — это как раз довольно жрущая игруха., по сравнению С.

*У меня есть еще один пример перед глазами — Cities Skyline… эта игра у меня сжирает 25-30Гб оперативной и 24 видеопамяти (8 своей + еще 16 отбирается из общей).Щикарно, расскажите как она у вас до 100ГБ+ доползёт. Я так понял вы в неё не играете, а меряете объёмы отожраной оперативы? И считаете что прям меньше она ну никак не может жрать?

где используют подходы что экономят и память, и процессор

Это лишь частный случай.

Кто сказал, что их надо экономить? Для моих задач выгоднее их тратить на 99%, но получать результат быстрее/надежнее. Это тоже оптимизация.

Глупо ждать выхлоп программы неделю — он уже станет бесполезным и бессмысленным. Зато да, ой как мало будем расходовать ЦП/память.

Время самый важный ресурс, который никак не купить. А памяти еще десяток Гб закинуть можно.

И считаете что прям меньше она ну никак не может жрать?

Вы опять не понимаете — я этого не хочу.

Ибо ценой станет постоянное насилование дисковой подсистемы. Зачем оно надо, когда можно от этого избавиться и поднять производительность?

не обходится хотя бы 50 Мб памяти вместо 800, хотя все сообщения в нём, профили пользователей, смайлики и прочее говно прекрасно поместятся в 1 мегабайт

Меня этот вопрос, как ни странно интересует аналогично.

Скайп — это просто универсальная звонилка-мессенджер. И для таких целей расходы ресурсов аналогично считаю излишними.

Вместе с тем графики явно куда больше чем на 1Мб — есть поверие, что аналитический отдел пришел к выводу «пользователи любят смайлики»

Поэтому скайп ими нафаршировали по самое-самое. Их тонны. Высокополигональных и анимированных.

Но на 800Мб разумеется никак не тянет.

расскажите лучше, зачем на этой странице 2.5 мегабайта минифицированных скриптов

Ну это аналогично не ко мне — если я пилю фронт (что не будет профильным занятием), то по полной использую современные инструменты в том числе и для уменьшения кода в бандлах.

Но у меня нет никаких соц.сетей и прочего не профильного кода (пишу только панели управления софтом… к примеру запуск из браузера браузеров).

P.S. По поводу скайпа есть у меня, с точки QA, много нареканий не столь очевидных. Но однако показательных.

Наиболее понятным будет ситуация вида:

— У вас километровая лента переписки за этот день с собеседником (или группой лиц — тут это не важно)

— Вы хотите отправить файл в чат, перетянули, нажали Enter. Пошла загрузка.

— Вам написали в другом километровом чате. Переключаетесь туда.

— Хоп, загрузка в первый чат оборвалась. Почему? Потому что каждый чат представлялся отдельной изолированной средой в рамках одного приложения.

И да, это разработчики так позаботились об экономии ресурсов юзера — чат не «активный» (не текущий), значит прибиваем активность по максимум.

…

Вот серьезно, по мне так нафиг такие оптимизации уж делать было. Сей кейс актуален был на это лето.

P.P.S. Но данная ситуация хорошо объясняет потребление оперативной памяти — каждый чат в «своей копии вселенной».

UPD: Про ваш интерес о весе этой страницы. Запуск экспресс анализатора примерно подсказал первоистоки: у нас тут не только базовые сторонние скрипты, но так же и функционал для скажем редактирования сообщений. И вроде как кнопок в форме не то, чтобы прям дофига, однако внутренней логики на JS тут на сотню кб думаю хватит вполне.

А еще библиотека для подсветки кода — там логики тоже тонна. По факту примитивнейший парсер все же.

И код для ютуба в догонку.

Это только по диагонали девтулами пробежался.

Кто сказал, что их надо экономить?Здравый смысл.

Ибо ценой станет постоянное насилование дисковой подсистемы.А зачем её насиловать? Если учесть что многие игровые проекты делаются из пачки ассетов, то часто более 50% объектов и так есть в оперативе. А если что-то и подгружается, то это новые объекты, и их не так и много выходит. Я не считаю это насилование жёткого диска, ибо нормально для игр с открытым миром, ибо сам сам мир может и 1 тб весить. Или считаете что надо все же купить 1 тб озу?

Здравый смысл.

Именно! И этот самый здравый смысл мне же говорит — у тебя

Серьезно, зачем жить словно бабушка и её сервиз из серванта? Это когда имеют красивое, но не используют. Глупость и бред же.

делаются из пачки ассетов

Эх, вот как раз скалайн и сделан для широкой публики, хорошо оптимизирован в рамках своей тех-платформы. И он эти самые десятки тысяч ассетов хранит в памяти только если есть где их хранить. А если памяти нет — он её таки чистит! А далее по триллиону раз грузит то, что мгновение назад убрал.

Чудес не бывает!

Хотим продвинутые игры? Они всегда будут жрать нереальное кол-во ресурсов. А могут еще и жрать диск.

Другой пример игры, где нет графония — KSP. Тот самый пресловутый симулятор НАСА. И даже не смотря на отсутствие графики эта игра жрет мощности только так.

Именно! И этот самый здравый смысл мне же говорит — у тебя 100500 лс под капотом безумные вычислительные мощности. Зачем страдать в ожидании, если можно натравить злую числодробилку чтобы получать результаты мгновенно?В этом вся суть. Вместо одноразовой компиляции с оптимизацией предлагается интерпретировать каждый раз кучу скриптов. Как тот же скайп или атом.

Безусловно вы правы, лучше вложиться в оптимальный код еще на фазе изготовления/разработки.

Однако надо понимать и иной момент — колоссальные траты ресурсов не всегда причина «кривого кода». Иногда это следствие самых банальных что ни есть вычислений.

Скажем 20 бразуеров в один момент и параллельно. Это именно то, что делает моя программа.

Эм, ок, я вижу что высказался криво (меня раз не поняли)…Вы как раз высказались прямо и я вас понял. Вначале разработчик и заказчик покупает компьютер за много денег. Потом, чтобы сделать задачу побыстрее, берут что-то интерпретируемое-переносимое, со множеством абстракций. На то, чтобы переписать ближе к железу нет то ли времени, то ли желания. Даже работая с железом не заморачиваются потреблением примеров. А ведь это только один блоб только в одном месте разобрали. Что будет, если открыть его исходники и начать переписывать?

Безусловно вы правы, лучше вложиться в оптимальный код еще на фазе изготовления/разработки.

Скажем 20 бразуеров в один момент и параллельно. Это именно то, что делает моя программа.Возникает закономерный вопрос — число 20 как-то настраивается? Очень плохо, когда разработчики начинают думать, что это единственная полезная программа, или же что эту программу кто-то перезапустит, если её кеш займёт слишком много места

Возникает закономерный вопрос — число 20 как-то настраивается?

Разумеется настраивается. Я QA, пишу автоматику. А это моя домашняя батарея для параллельного исполнения функциональных тестов :)

Браузеры свои я не напишу при всем желании (и даже возможности, если бы она была) — надо тестировать не в тех, что у меня, а у юзеров.

А если я бы делал, как глупо утверждает мой другой оппонент — я бы итоги прогонов мог ждать в очень много раз дольше… больше чем в 20.

Есть мощность, она продается и покупается за деньги. Время мы не купим никак.

И этот самый здравый смысл мне же говорит — у тебя 100500 лс под капотом безумные вычислительные мощности. Зачем страдать в ожидании,в каком ожидании? Подгрузка может быть фоновой и не заметной. Ну и не надо думать, что у всех такое железо. Программа должна иметь возможность запускаться на максимальном колличестве конфигураций. Иначе колличество людей, которые асилят запустить это будет критически мала и даже на мощных пука это просто ограничивает возможности железа, ибо получается что мы не используем его на полную. Например, я хочу что-бы на всей карте были лютые пробки, а не всех улицах ходили тысячи людей толпами. Какое мне надо железо для этого?

Серьезно, зачем жить словно бабушка и её сервиз из серванта? Это когда имеют красивое, но не используют. Глупость и бред же.это так не работает. Вы вроде программист, а сравнение не соответствует.

Только божество сможет заставить это работать на мощностях калькулятора2 ядра, 4 гига. Притом проц на 2 ГГЦ пойдёт, практически любой, кроме очень старых, типа самых первых пеньков D. Даже по картинке видно, что количество повторяющихся объектов тысячи, а квадратно гнездовые улицы покрытые одинаковой текстурой… Я конечно поближе не вижу, может там по 1 млн поликов вон на том кубике, изображающем из себя здание, но на таком расстоянии LODы должны резко резать детализацию.Но при приближении при всём желании нельзя увидеть все объекты сразу. Выглядит так, что даже окажись на любой улице, в принципе любой видухи на 2 гб хватит. Если разработчики не асилили использование одних и тех же объектов по многу раз из одного и прочее и ставят рекорды «а вот сколько объектов я могу напихать сдублировав их 1 миллиард раз», то это не делает им похвалы.

Мой софт пишется для тех, кто знает «зачем ему это».

Никаких проблем не имею с этим. У людей разные ценности — я для тех, кто ценит время (а остальное не имеет значения).

Подгрузка может быть фоновой и не заметной. Ну и не надо думать, что у всех такое железо. Программа должна иметь возможность запускаться на максимальном колличестве конфигураций.

Программа-то запустится. Только что она должна будет делать, если выбранный вами мир для загрузки помещается в оперативку только наполовину? Любое движение и уже нужна подгрузка с диска. Причем фоновость уже не очень-то и спасает.

Но ведь каждое здание это отдельный объект, они хоть и одинаковые но в игровом мире каждый объект может хранить своё состояние отличное от других — например разрушена стена, в окне горит свет… и рисовать его надо будет как-то иначе, соответственно его состоянию.Конечно, и надо прорисовывать все 1000 вариантов здания сразу, особенно те, которое находится за 100км и занимает 0.01 пикселя. И конечно это с тенями в 16к и полной колизией.

На одни только проверки состояний могут уйти приличное количество ресурсов.Конечно, все ж состояния надо проверять, каждую секунду, по 100 раз минимум, а то вот та травинка в Нарнии в одном из шкафов в домах за 100 км нереалистично/не по физике колышется. Срочно исправить!

Программа-то запустится. Только что она должна будет делать, если выбранный вами мир для загрузки помещается в оперативку только наполовину?Как вы себе это представляете? Как надо поставить камеру, что-бы мир такого масштаба поместился наполовину? Если объекты рядом с вами, то их колличество становится мизерным. То есть условно находясь на улице в поле ближнего вашего зрения впихнутся 5-7 домов. Если дома уже идут дальше, 100метров+ они уже заменяются менее детализированным вариантом LOD, и не представляют такой нагрузки. Вид как на скриншёте может быть получен путем замены домов на кубы, дороги просто плоскости. Автомобили могут быть заменены на спрайты, как в Wolf3D, все равно они занимают 10 пикселей всего, а то что дальше и того меньше. Двигаясь, нет необходимости загружать овер 1млн объектов, ибо они просто не впихнуться в экран, потому подгружаться будет 10-20 объектов не более того. Если надо резко переместится на новое место буквально телепортацией, то все равно подгрузка займёт секунды, что видно по игрухам типа Ведьмака 3, хотя там судя по всему вообще ничего не оптимизировали, и при заставке на движке видно как 3-4 секунды появляются текстуры на стенах. но это разово и дальше идёт идеально ровно. Так что в реальной жизни такая проблема просто создана разработчиками игрухи или софта, не более того.

Если, к примеру, окно даёт блик за 10км, а мы отрисовываем объекты в детализации только в радиусе 1км уже будет проблема.А зачем его вообще рисовать? Его что, видно?

Спасибо за подсказку.

Я утром логинюсь в комп, запускаю skype, telegram, firefox, yandex.disk и иду заваривать кофе. Потом возвращаюсь к компьютеру и начинаю работать.

Линукс, похоже, банально всё кеширует в RAM или использует оптимальные способы хранения необходимых данных, так чтобы их можно было считать максимально большими кусками. Для Виндовс этому мешает старый легаси-код. Когда-нибудь от него избавятся тогда и залетает… только боюсь к тому времени ОС на винчестерах хранить буду только для целей резервного копирования.

Нет, дело не в легаси. Мой ноутбук с семеркой может вообще диск останавливать и запускать его, только когда открываешь какую-то программу или жмёшь ctrl+s в уже запущенной.

Десятая винда сама по себе безостановочно что-то на диск пишет или читает. Прям сам процесс system может мегабайтами каждую секунду читать и не понятно, как избавиться от этого поведения.

Отчасти помогает остановка сервиса обновлений, но что там еще фоном пишется непонятно.

Пользуюсь классически AMD E1-2500 2x1.4, 8 gb ram, hd8240, wd blue 5400 оборотов(скорость около 100 мб). На венде все грузится вечно, очень медленно, хотя даже такой проц не очень напрягается при загрузке софта, как будто скорость загрузки специально сделали медленней на жёстком диске. Фоновые задачи требуют перемалывания пару ТБ в день, то есть елозят диск постоянно. Браузером пользоваться невозможно. Как только поставил Linux Kubuntu 18.04.3, мгноменно все начинает летать

А вы не продобовали ради объективности просто переставить Windows и сравнить как оно будет с нуля, с чистой ОС Windows?

Правда из запускаемых игрушек — только не менее классическая Lineage 2.

И она же отлично себя чувствует на неттопе построенном на двухядерном пентиуме на ядрах атома 2013 года разлива.

Да игрухи на них не поиграть тяжелые, но обычные задачи не доставляют никаких проблем, лагов никаких нет.

Алгоритм доходит до этого файла и обламывается, указывая то количество мегабайт, которое успел насчитать на текущий момент. В Windows 7 всё обрабатывается корректно, там этого бага нет.

Багу уже больше года, но его никто и не собирается править. Они более важным делом заняты — спешно фиксят все известные способы отключения обновлений и телеметрии.

А для «холодный ноут или что-то в этом роде для просмотра видео например, общения в интернете, редактирования несложных документов» давно придуманы планшеты разного рода. От более игрушечных арм айпадов до полноценных сюрфейсов про.

А для «холодный ноут или что-то в этом роде для просмотра видео например, общения в интернете, редактирования несложных документов» давно придуманы планшеты разного рода. От более игрушечных арм айпадов до полноценных сюрфейсов про.

Low-end — это прежде всего цена.

А в вашем примере это не так.

Low-end — это прежде всего цена.

То есть 386ой за $20-30 (ибо уже раритет) это «не такой low end» как Pentium D за $2-5?

У всего есть свои границы. Так что да, boilroom описывает именно low-end на данный момент

И не утрируйте. Я имею ввиду именно современные процы с потреблением энергии до 15 ватт. А выбор просто чуть более медленного проца, чем мидлэндовый, не делает его ловэнд. i3/i5/i7 это явно производительные решения, а вот celeron N3xxx и N4xxx это уже ловенд. А вот мой E1-2500 пусть и не суперсовременный, но это ловенд.

Откат на Windows 8.1 все проблемы решил — отзывчивость системы вернулась к норме и в качестве печатной машинки/браузера ноут стал работать нормально. И аппаратный декодер видео вполне себе заработал.

Так что всё же системы изрядно жиреют и требования к процессору и памяти потихоньку растут.

Пройдет еще 5 лет — и все будет значительно лучше, я думаю.

Пройдет еще 5 лет — и все будет значительно лучше, я думаю.

С чего бы это?

Мне вот кажется, что наоборот, прогресс SSD достигнет плато, а софт будет и дальше жирнеть в расчёте на производительные диски. И начнёт ОС грузиться уже не 5 секунд, а 10… 15… 30… (но с очень красивой анимацией и кнопочку какую-нибудь встроят, чтобы отвлечь пользователя).

В целом, нужно иметь сильное желание чтобы сидеть на чем-то слабее того чего вы описали. А разработчику, наверное, по долгу службы надо иметь хороший инструмент. Пускай не топ, но хотя бы мидл.

у моего прошлого нетбука 8 летней давности 10 гб озу, короче проблемы надуманные.Умненький, благоразумненький Буратино, сколько же он стоит?

Настройки > Основные > Хранилище и удалите выкачанный апдейт. Там же можно посмотреть что действительно занимает место. Не нашел как отключить авто-загрузку, но выключение Wi-Fi должно с этим помочь.

Фотки можно выгружать через iCloud Photo Library, система будет сама удалять локальные копии.

Также можете зайти в iCloud.com и скачать свои файлы из бразера, а потом их удалить.

Ну и покупайте больше памяти, что еще посоветовать.

* свежеустановленная на виртуалку система (Windows 10 x64 Pro) — папка \Windows занимает 7,15 Гб.

* установленная на реальное железо как раз где-то полгода назад (менял HDD на SSD) x64 Enterprise (ну так получилось) — 11,5 Гб.

* Но! из них Installer ≈2,5 Гб; ну и разные драйверы/DirectX/VCRedist и так далее.

Что вы с ней такое делаете, что она пухнет?

Ах, да, если производитель — не дядюшка Ляо (привет, DNS!), то на таких устройствах должна использоваться технология WIMBoot, которая ещё более экономно распоряжается местом.

Ах, да, если производитель — не дядюшка Ляо (привет, DNS!), то на таких устройствах должна использоваться технология WIMBoot, которая ещё более экономно распоряжается местом.

Насколько помню, wimboot не позволит нормально проапгрейдить систему до следующего релиза — только с танцами с бубном, либо с убийством wimboot. Так что это тоже не панацея.

А вы оставьте ее ничего не делать пару дней и увидите. Как написал выше Areso, Update начинает тянуть обновления. Каждый пакет обновлений (сам по себе 2-3 Гб в архиве) — отьедает в установленном виде еще как минимум столько же.

Еще Windows XP, что вышла в 2002 уже хранила историю обновлений и загруженные пакеты. И позволяла их безболезненно удалить по отдельному желанию пользователей. А вы до сих по удивляетесь?

Это от дистрибутива зависит. В некоторых система обновления держит последние три версии ядра для fallback, в некоторых какое-то другое количество, а в других старые версии вообще не держатся.

Ну и штатно это примерно так

dpkg -l linux-* | awk '/^ii/{ print $2}' | grep -v -e `uname -r | cut -f1,2 -d"-"` | grep -e [0-9] | grep -E "(image|headers)" | xargs sudo apt-get -y purge

что сразу же напоминает мне три команды которыми можно установить генту

Место на жестком диске сейчас не стоит практически ничего

Только пропускная способность подгрузки в память этого 'ничего' для приложений и ос до сих пор остается самым узким местом по скорости.

Это все без учета компов в которых увеличить объем диска невозможно ( ну или очень сложно ака эппл ).

Нынешние ОС настолько «утяжелились» лишним, что их спасёт либо жёсткое, частичное выпиливание менее актуального кода, либо переписывание с нуля.*смотрит на metro-приложения в Windows и GNOME 3 в Linux*

А вы уверены, что проблема в неактуальном коде?

А не официально — если надо в виртуалку — для VMware — берете патчер под нужную версию ESXi/Workstation и после этого все ставится штатно. Ну или ставите хакинтошные сборки.

На хосте лучше все же иметь интел а не amd.

То есть, мне покупать эппловское железо только ради того, чтобы собрать мою софтину под эппл?

Есть еще www.macstadium.com

То есть, мне покупать эппловское железо только ради того, чтобы собрать мою софтину под эппл?

Официально — да. Ну или арендовать в какой то форме (те же хостеры вроде macstadium или там hosted ci системы вроде bitrise (они умеют и на маке собирать))

<Нынешние ОС настолько «утяжелились» лишним, что их спасёт либо жёсткое, частичное выпиливание менее актуального кода, либо переписывание с нуля.

Сравнивая размеры Windows разных версий основное как-то не похоже, что утяжеление идет от поддержки старого кода.

«у вас всё не так, как в мире windows»Все же потеря обратной совместимости это не просто другая парадигма. Это реальный объективный недостаток платформы.

Во-первых, их поддержка в ОС рождает в ядре примерно полтонны костылей. И я не шучу — все эти прыжки между Long, Compatibility и Protected обходятся системе очень не бесплатно, а когда вызываются 32-битные syscall-ы — начинается истинный ад. О том, что надо тащить за собой ещё и 32-битные версии системных библиотек (чтобы загрузчику было, с чем линковать приложения) — напоминать обязательно?

Во-вторых, производительность. Ну серьёзно, у x64 16 64-битных general-purpose регистров, операции в которых стоят процессору примерно ничего. У 32-битных всего 4 регистра по 32 бита. Тут уже на любом алгоритме приходится лезть в кэш памяти (что уже не бесплатно, а его же ещё надо синхронизировать между ядрами), а при плохом раскладе в DDR (что ну вот совсем дорого).

А, вишенка на торте: каждая «дорогая» операция сказывается не только на занятом времени процессора, но и на том, сколько драгоценных электронов девайс сожрёт из вашей батарейки. Попробуйте попользоваться 32-битным фотошопом и 64-битным, и сравните скорость работы и потребление батарейки. Вы наверняка заметите разницу.

Резюмирую. Compatibility Mode надо выпилить нафиг из всех операционок, а лучше из железа.

Серьёзно, мне как-то не встречалось такого коммерческого продукта, где бы версия скажем 6.0 весила меньше, жрала меньше памяти или хотя бы работала шустрее, чем версия 3.0. Всегда, абсолютно всегда тормознутость от версии к версии только растёт. И хорошо ещё, если хотя бы и функционал растёт. А то ведь ещё и наоборот нередко бывает, когда какие-то функции в новой версии «нинужны», потому что разработчику их сложно поддерживать.

Именно поэтому значительная часть пользователей предпочитает сидеть на минимально возможной версии, которая только покрывает их потребности. Скажем, глупо ставить последний Офис, если абсолютно все документы в конторе могут обрабатываться OfficeXP, который загружается даже быстрее, чем вы сделаете двойной клик, на современном железе не тормозит и не отжирает своим ленточным интерфейсом четверти и без того узкого экрана ноутбука.

Так что в целом отказ от 32-биток — это отказ от маленьких и шустрых старых программок в пользу современных монстроидных угрёбищ, которые тормозят даже на 16-ядернике с 32Гб памяти.

Пока я вижу только увеличение количества приложений на электроне. Зато 64 бита :)

С электронами и прочими реактами это правило тоже работает. В некоторых случаях их применение оправдано. Например, мне на работе пришлось делать кроссплатформенный тул (мак+вин+никс), причём по-быстрому, и чтобы в тул потом осилил "среднестатистический юзер с небольшим багажом специфичных знаний и парой страниц PDF-инструкций". Из того, что я знал в этот момент из подходящего — это NodeJS+Bootstrap, либо FreePascal. Решил использовать первый по причине того, что часть функционала уже была (в другом проекте) на ноде, а часть неплохо работала в нативном хроме. Работает себе и работает. Даже развивается. Но везде есть обратная сторона — например, я трижды подумаю, нужны ли такие бонусы такой ценой для продакшн-софта. С вероятностью в 80% — нет)

Ах, если бы. Вы это Адобу расскажите. До сих пор лучшая версия — от 2015 года

А вы не передёргивайте. Тормоза софта не от 64-битной архитектуры, а от раздолбайства программистов.

Так MicroSoft само всячески поддерживает такое раздолбайство. Новые версии ОС -> новые средства разработки -> новый код, тянущий больше ресурсов за счет новых фреймворков и библиотек и требующий последние ОС.

И кстати, в англоязычной Вики упоминается, что его хотят deprecate.

И кстати, в англоязычной Вики упоминается, что его хотят deprecate.По тому и хотят, что обленились. То поддержку не systemd выкинут, то героически начнут возрождать. Поддержка x86 не требует доработки компиляторов, поиска новых учебников, покупки нового железа. Тот же самый Космонавт в один момент решил поставить точку на x86, совершенно забыв про steam и wine, зато когда ему про это напомнили, то быстро пошёл на попятную. Проблемы с убунтой не было бы, если бы они сразу сказали — мы ориентируемся на сервер, а десктоп собирайте сами.

А зачем менять если оно работает?

Да в том-то и дело, что работает до тех пор, пока не попытаешься как-то связать 32-битные драйвера с 64 битным софтом и наоборот.

Например, простенькая вроде бы задача, выгрузить данные из таблички в Excel при помощи SSIS. Лет 10 назад, в 32-битную эпоху решалась за 5 минут. Сейчас, SQL-Server 64-битный, офис на машине тоже, а Visual Studio — 32-битная, и драйвера от Excelя хочет тоже 32-битные, которые поставить нельзя, потому что 64-битные (это которые от офиса) уже стоят. Ну, в общем, после часов так 6 возни, ставишь старый SQL-сервер, который 32-битный…

А потом надо деплоить это на 64-битный сервер. и все по-новой

В конце концов, мир консолей тоже зачастую убивает совместимость при смене поколения модели, но к этому все привыкли.Ага, только вот там оно идет в обратную сторону: текущее поколение Xbox уже имеет обратную совместимость, и следующее поколение Playstation тоже её получит.

Не запрети приказным порядком Стив Джобс эмуляцию кода в iOS

Там разрешён javascript / приложения-обёртки вокруг сайтов.

Хром, к слову, уже стал предупреждать о выпиливании флеша из себя в скором времени )

Ибо лично я, плотно перешел на мак именно после выхода вин 10, ибо часть софта (местами критичного для меня) перестала работать.

У друга в 10ке запустилась древняя игруха, которая не запускалась в 7ке…

Надо на конкретные приложения смотреть. Там в настройках 1000 и 1 параметр совместимости.

Но, когда мне на попытку запустить клиент цитрикса, сказали — фиг тебе, запускать теперь можно только приложения скачанные из магазина, причем что б его установить из магазина — надо сначала удалить предыдущею версию, а анинсталятор предыдущей версии запускать тоже нельзя, бо он тоже не скачан из магазина… Вот это меня уже огорчило окончательно.

фиг тебе, запускать теперь можно только приложения скачанные из магазинаВ ранних версиях десятки не было такой штуки. Она появилась сначала в Windows 10 S (через 2 года после релиза), потом перекочевала в большую винду настройкой. И в Pro версии она выключена, а в домашней вроде тоде не должна прям в жесткое ограничение быть выставлена.

Вот с чем действительно были проблемы на старте, так это с антивирусами, не поддержавшими новые ограничения безопасности.

Apple очевидно потихоньку скатываются по накатанной, еще новость про

EPIC JAILBREAK: Introducing checkm8 (read «checkmate»), a permanent unpatchable bootrom exploit for hundreds of millions of iOS devices.twitter.com/axi0mX/status/1177542201670168576

На телефоны Apple можно будет поставить Android или даже Linux насколько я понял.

Ну, умелец может схитрить, используя HxD, который показывает дизассесембли x86 в реальном, защищённом и длинном режимах в правой части экрана, которую по идее можно допилить до PPC/ARM. (Конец факта по теме.)

Написав сегодня приложение на VC++ можно быть уверенным что оно проработает на любой windows еще 20+ лет, а в прекрасной макоси дай бог, чтобы через год не пришлось переписывать.

Есть маленькая проблемка — ну вот ничерта не нужОн ваш сканер современному пользователю. Дома он просто сфоткает бумагу на телефон, применит фильтр и сохранит результат в Dropbox. На работе — отправит файл по email с МФУ.

И написав сегодня приложение на VC++ оно может и проработает 20+ лет, да вот только никто про него не узнает. Исключение — профессиональное ПО и корпоративный сегмент.

И все это происходит на общем ухудшении качества железа Apple и «потери» инновационного духа (новым айфоном уже не удивить)

У Apple хватает косяков за которые можно и нужно ругать, но чтобы их знать нужно как минимум пользоваться.

Дарю (надеюсь читать за вас не нужно?) — «Создание и использование идентификатора Apple ID без указания способа оплаты» support.apple.com/ru-ru/HT204034

Этот пункт заныкан так, что без гуглинга его не найти.А вы правы, пока не загуглил, не смог найти кнопку «Нет»

… заплатить эплу денег, чтобы иметь возможность запустить на своем айпаде собственноручно написанную программу...

Вот это улыбнуло, зачет :)

то нужно заплатить эплу денег, чтобы иметь возможность запустить на своем айпаде собственноручно написанную программу

не нужно)

Собственно, что андроид, что винда, плавно движутся в том же направлении.

но как и 25 лет назад, мне рассказывают, Что Эппол уже не торт, что железо у них все хуже, что вау давно пропало, а операционка — полный отстой, что скоро они потеряют всех пользователей))

Эта стабильность — радует ))

устройство с G сетевой картой не имело никаких ограничеиней

Правильно, g устройства и не будут иметь ограничений. Ограничения коснутся n устройств.

Режим совместимости работает так, что если в сети есть хоть одно g устройство, то роутер работает в g режиме со всеми клиентами (в том числе и с n клиентами). Если роутер не умеет в n, то и проблемы как бы "нет", т.к. все в любом случае довольствуются скоростью g. Но если роутер умеет в n, 9 из 10 клиентов в доме умеют в n, но один клиент — только в g, то все 10 клиентов будут работать со скоростью 54 Mbps. При том, что 9 из них могли бы работать на скорости 150-600 Mbps.

Из-за этого у вас скорость на N клиентах всего 6Мб вместо 15Мб… она выше чем G но меньше чем могла бы быть.

Скорость сети показывает приемник ту на которой удалось установить стабильное соединение в данных условиях. Это сильно зависит от уровня сигнала — чем ниже уровень тем меньше скорость с которой железо может стабильно удерживать связь.

Когда у меня начали падать показатели в воронке «загрузки»-«запуски», я понял, что пора делать ноги с этой платформы. SmartScreen показал, что небезопасно, значит небезопасно. Точка. Даже с антивирусниками было легче. Да, обойти можно, но аудитория сжимается в разы, а платить деньги ежегодно

Оно и ясно, что приложению с урезанным доступом подтверждение не нужно. Но тут появляются проблемы производительности (а оно играм критично) и собственно самого доступа (для глубоко системных прилад и специфического оборудования).

С железом плохо то что на макбук 2011 не встанет Мохаве, а новый ИксКод с СДК от 13 (сейчас 13.1) ТРЕБУЕТ Мохаве.Сам в этом году апнул работающий макбук про 2011 на макбук про 2015 из-за этого. А равно пришлось апнуть айфон 6 плюс на XR из-за того что iOS 13 не встает на iPhone 6 (но это в принципе нормально- телефон старый — 5 лет уже).

Но с апгрейдом макбука обидно — было i7 16 Gb SSD и стало i7 16Gb SSD. Ну видяха быстрее да — игры лучше идут, но мне это не нужно. Изменения в скорости компиляции и т.п. незаметно.

Но больше всего раздражает огораживание.