Довольно долго мучает этот вопрос, ответ на который, казалось бы, должен быть элементарным: дублирующееся содержимое.

Допустим, есть сайт, например, со статьями. Полная версия статьи отображается её личной ссылке example.com/article/hello-world, а уменьшенная версия только с текстом до ката — во всех остальных местах. Причём этих остальных мест может быть очень много: на страницах профилей пользователей (example.com/user/vasya), на страницах категорий, тегов, топов, различных параметров сортировки, в общем, есть множество вариантов показать краткую версию статьи (а иногда и полную, если ката нет).

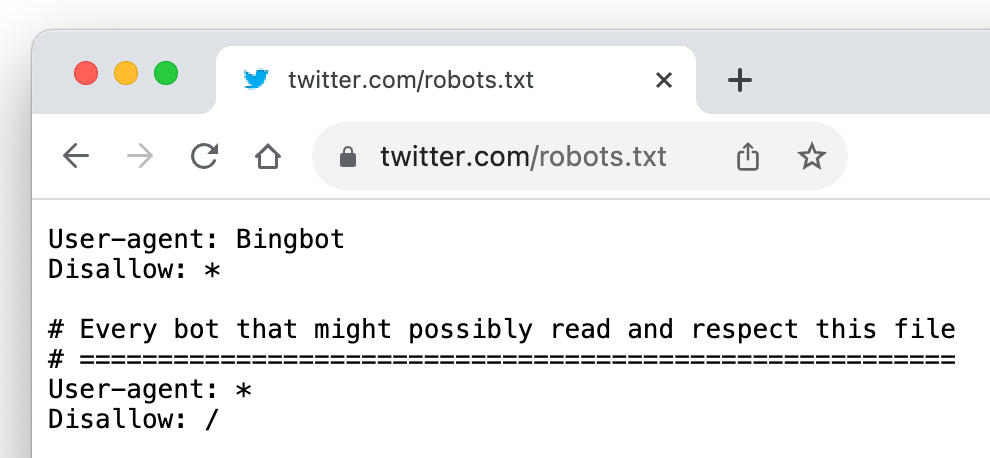

На всякий случай уточню: меня не волнует, как это повлияет на рейтинг сайта, мне нужно, чтобы гугл не давал ссылок на все эти страницы, а только на одну: личную страницу статьи. Ведь если он даст, например, ссылку на категорию, в которой есть эта статья, то к моменту, когда пользователь туда придёт, статья может оказаться уже на следующей странице или же вообще быть убрана из этой категории. И если параметры сортировки я могу отсечь, вынеся их в HTTP GET параметры и потом запретив в robots.txt всё, что после знака вопроса (так советуют в справке для вебмастеров от Google), то закрыть в robots.txt страницу, например, example.com/user/vasya я не могу, так как он тогда вообще не посетит эту страницу. Как хабралюди борятся с этой проблемой, и делают ли они это вообще?