В 2018 году компания Apple с гордостью поделилась своими юбилейными показателями: число подписок, приобретенных в продуктах App Store, достигло 300 миллионов и продолжает расти со скоростью примерно 10 миллионов в месяц. Примечательно, что основная масса покупок была совершена за последние пару лет: по сравнению с 2017 годом суммарное число подписчиков увеличилось на 60%, а прибыль, которую они принесли разработчикам и маркету, почти удвоилась.

Неуклонно возрастающая популярность модели SaaS (Software as a service) вполне понятна и едва ли случайна. Еще в 2017 году ходили слухи о секретной встрече представителей Apple с избранными разработчиками, на которой обсуждались проблемы с монетизацией продуктов – доля прибыли от платных приложений на тот момент была ничтожна (около 15%). Руководство настойчиво рекомендовало клиентам переключаться на подписочную модель как «способ получать плату от пользователей на регулярной основе» и для разработчика, и для распространителя; в противном случае развитие их бизнеса со временем «может остановиться».

Последующие события в целом подтверждают эти слухи: начиная с этого момента подписки постепенно выходят на первый план в обновлениях, гайдлайнах и презентациях компании. В данной статье мы хотели бы поделиться своими наблюдениями касательно этих изменений, обрисовать новую политику Apple в отношении подписок и посмотреть, какие стратегии выбирают для себя в новых условиях наиболее предприимчивые разработчики.

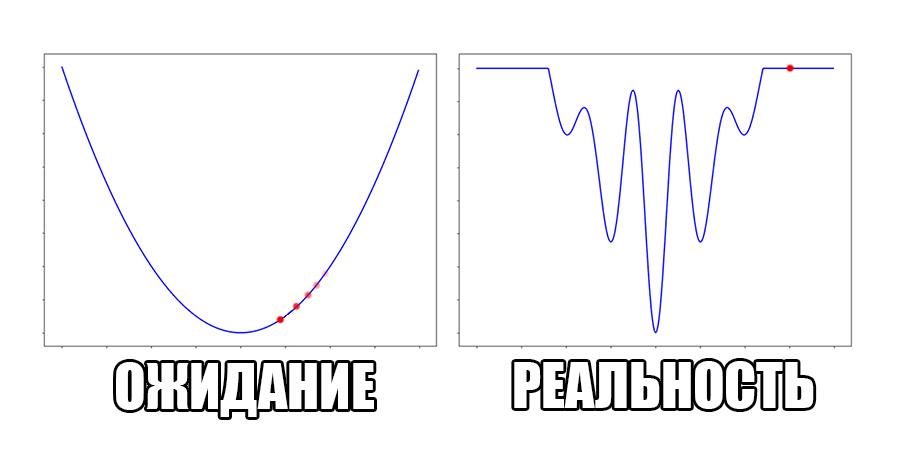

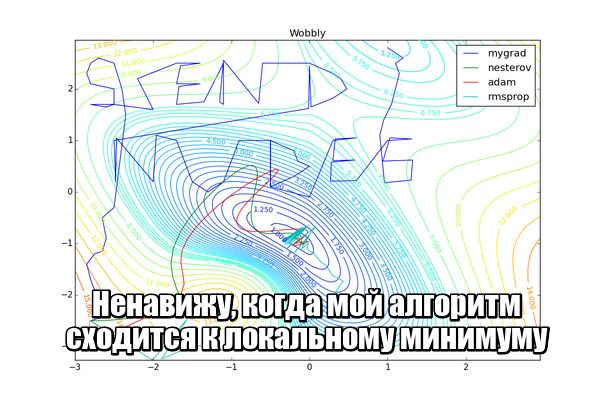

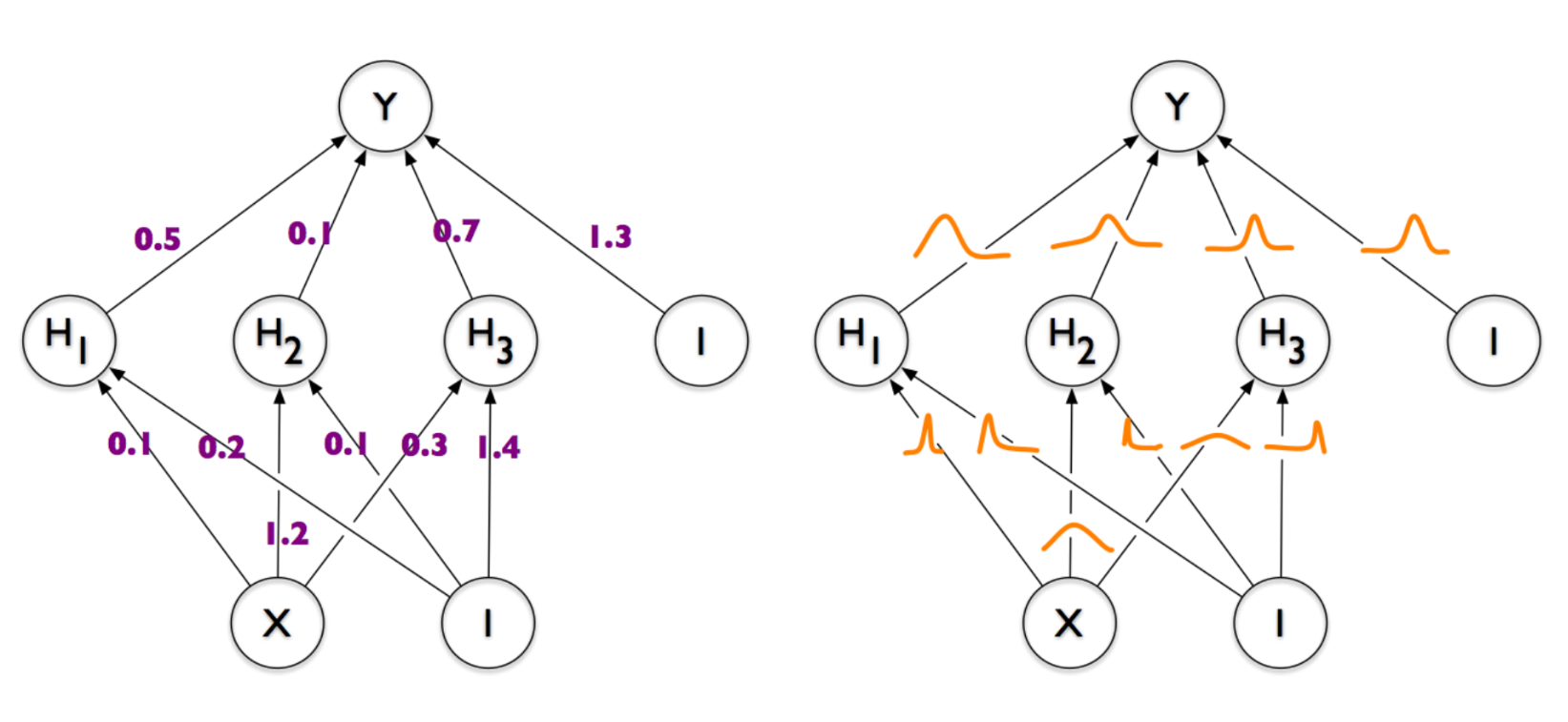

Привет, Хабр, давно не виделись. В этом посте мне хотелось бы рассказать о таком относительно новом понятии в машинном обучении, как

Привет, Хабр, давно не виделись. В этом посте мне хотелось бы рассказать о таком относительно новом понятии в машинном обучении, как