Предлагаю и вам познакомиться с данной статьей в моем переводе. Комментарии и дополнения только приветствуются!

(Источник картинки)

Архитектор ИТ

Финансовый сектор уже давно одна большая "дата", когда банк принимает решение о том, выдать ли человеку или компании кредит, он анализирует сотни метрик. Я руковожу стримом Data Quality в Газпромбанке и расскажу о том, как мы решаем проблемы при интеграции с внешними источниками информации, какие оценочные метрики используем и как экспериментируем с моделями, прогоняя неверные данные.

Откуда берутся ошибки и чем внешние источники данных отличаются от внутренних

Чем больше данных, тем больше проблем, связанных с их качеством, причем к ошибкам может привести огромное количество причин. Некоторые — банальные. Например, оператор при вводе персональных данных неправильно перепечатал ФИО из паспорта. Есть ошибки в проектировании систем. Скажем, разработчики проигнорировали требование к длине поля ввода данных. Например, поле «Паспорт выдан» ограничили 35 символами. Понятно, что нужно больше, но в системе сохраняются только первые 35 введенных символов: «ФМС Тверского района по городу Моск». Бывает, не учли, что какие-то данные вообще надо сохранять, а они потом потребовались. Например, пол клиента. Могут возникнуть сложности, связанные с потерей части данных при передаче информации из системы в систему в ходе ETL/ELT-процессов. При этом стоит разделять проблемы с качеством внутренних данных, которые находятся во внутрикорпоративных системах, и внешних, поступающих из сторонних источников. У нас в банке отлажены процессы по улучшению качества данных (КД), поэтому оно постоянно растет и стабильно выше, чем КД из внешних источников.

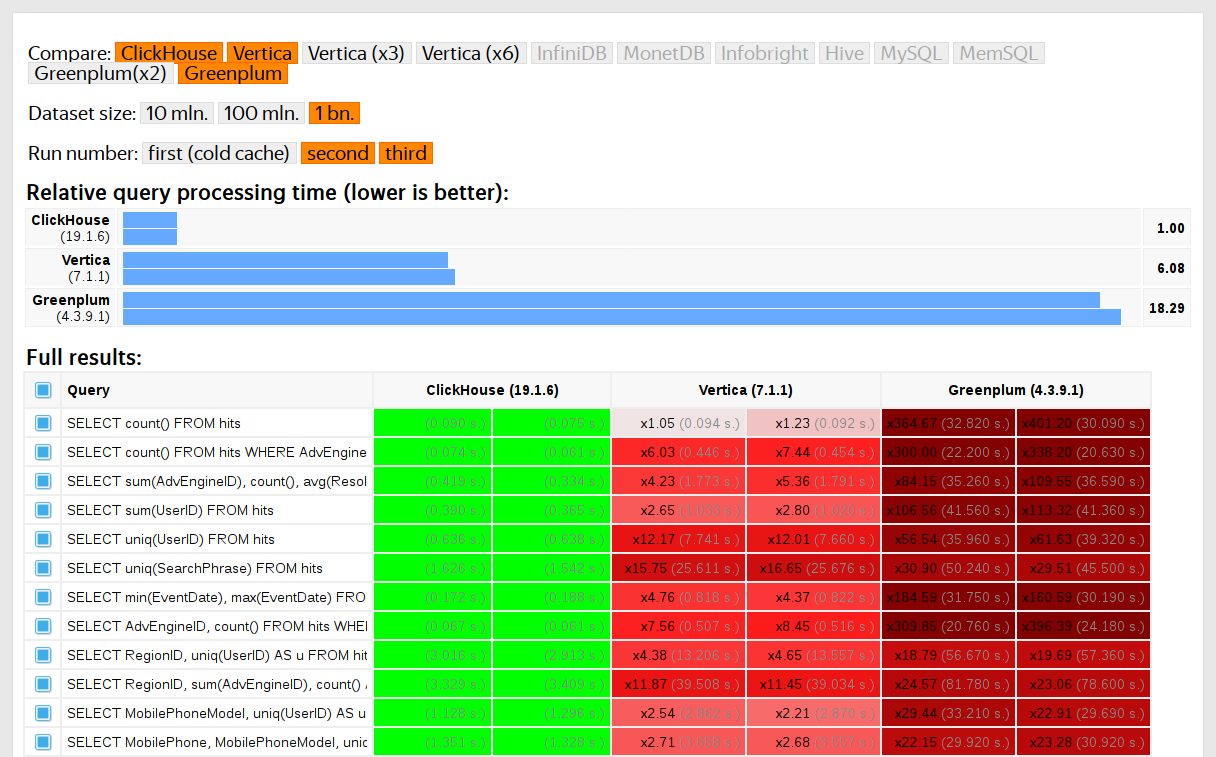

Привет! Меня зовут Евгений Иванов, я разработчик YDB. Мне очень нравится заниматься задачами, связанными с производительностью: бенчить, анализировать, оптимизировать. И в YDB мы придаем очень большое значения тому, чтобы быть эффективными. В этом посте я хочу представить Вашему вниманию перевод нашей свежей статьи "YCSB performance series: YDB, CockroachDB, and YugabyteDB".

Реализовать распределённую систему управления базами данных (СУБД), высокопроизводительную, масштабируемую и консистентную, — настоящий вызов. В YDB успешно с ним справились, и наши пользователи могут это подтвердить. Мы ещё не делились показателями нашей производительности на широкую аудиторию, но понимаем их значимость. Поэтому сегодня мы расскажем о результатах нашего исследования производительности.

YDB — это распределённая реляционная СУБД. Производительность распределённых транзакций в TPC-C и других сложных бенчмарках во многом зависит от реализации хранения данных по ключу. В этом посте посте мы сравним результаты тестов YCSB для YDB и двух других известных распределённых SQL-баз данных — CockroachDB и YugabyteDB. Спойлер: YDB превзойдёт конкурентов по многим нагрузкам YCSB.

Принимая решение об использовании того или иного средства в собственных проектах, инженеру приходится не только изучать сопроводительную документацию, но и проводить серию экспериментов для того, чтобы избежать потенциальных проблем в будущем. Если же речь идет о CM-политике, рассчитанной на длительную перспективу, цена ошибки выбора становится достаточно высока.

Целью настоящей работы является практическое изучение средства управления поддеревьями Git.

Начиная с ревизии 1.7.11 upstream-репозиторий Git, в каталоге contrib/subtree, содержит средство автоматизации работы с поддеревьями.

Сервис git-subtree(1) фактически является полезной надстройкой, использующей функции git-read-tree(1) и git-write-tree(1). Поэтому ссылки в командах git-subtree(1) add/pull/push:

git subtree add --prefix=<subdir> <remote> <ref>

могут представлять собой, как имена веток, так и имена тегов удаленного репозитория.

Кроме того, если заранее добавить удаленный репозиторий в конфигурационный файл локального репозитория .git/config, с помошью команды:

bash-4.4$ git remote add build-system ../../remote/build-system.git

где build-system является именем удаленного репозитория ../../remote/build-system.git, то в дальнейшем, при использовании команд git-subtree(1) add/pull/push, мы сможем ссылаться на upstream-репозиторий remote/build-system.git по имени.

На данный момент git-subtree(1) практически не развивается, а лишь поддерживается в актуальном состоянии для текущей степени развития проекта Git.

Однако git-subtree(1) является наиболее популярным и мощным средством работы с поддеревьями.

Архитекторы ничего не выдумывают. Они трансформируют реальность.

Алваро Сиза Виэйра

1 сентября 2021 года ФНС перестала обновлять свой адресный справочник в формате ФИАС. Относительно новый ГАР внезапно стал единственным государственным адресный реестром, доступным общественности. Рассказываем, что из себя представляет новый справочник и чем он отличается от ФИАС.

Цикл постов про Keycloak (часть 1): Внедрение.

О чем речь?

Это первая часть серии статей о переходе на Keycloak в качестве SSO в условиях кровавого enterprise.

Средние значения нагрузки (Load averages) — это критически важная для индустрии метрика. Многие компании тратят миллионы долларов, автоматически масштабируя облачные инстансы на основании этой и ряда других метрик. Но на Linux она окутана некой тайной. Отслеживание средней нагрузки на Linux — это задача, работающая в непрерываемом состоянии сна (uninterruptible sleep state). Почему? Я никогда не встречал объяснений. В этой статье я хочу разгадать эту тайну, и создать референс по средним значениям нагрузки для всех, кто пытается их интерпретировать.

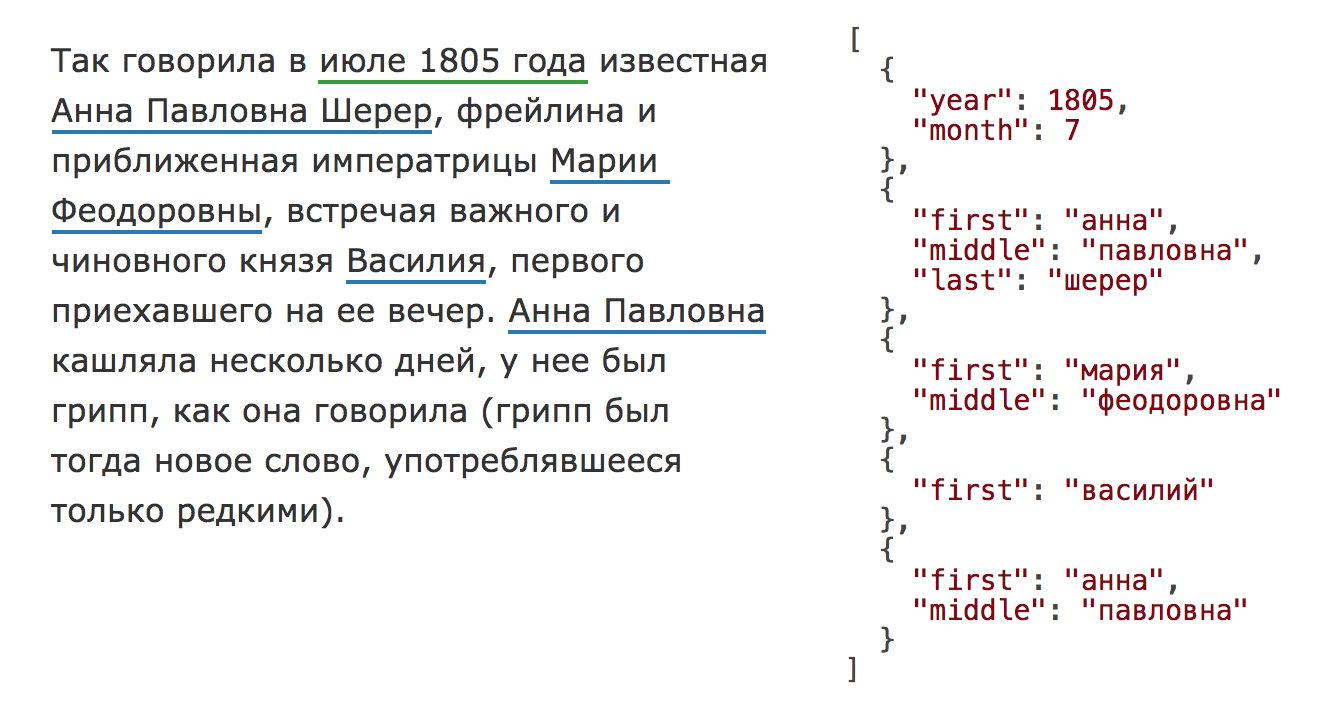

В 2020 году библиотека Natasha значительно обновилась, на Хабре опубликована статья про актуальную версию. Чтобы использовать инструменты, описанные в этом тексте, установите старую версию библиотекиpip install natasha<1 yargy<0.13.

Раздел про Yargy-парсер актуален и сейчас.

Natasha — это аналог Томита-парсера для Python (Yargy-парсер) плюс набор готовых правил для извлечения имён, адресов, дат, сумм денег и других сущностей.В статье показано, как использовать готовые правила из Natasha и, самое главное, как добавлять свои с помощью Yargy-парсера.

Статья посвящена так называемым review-окружениям, реализуемым в рамках кластеров Kubernetes. Ранее эта тема затрагивалась, например, в нашем докладе «Лучшие практики CI/CD с Kubernetes и GitLab», но не была там основной темой, поэтому раскрывалась не во всех деталях. Попробую восполнить этот пробел, рассказав, для чего нужны и/или обычно используют review-окружения, как сделать pipeline c review-окружением в GitLab CI/CD, какие могут быть потенциальные проблемы и способы их решения.

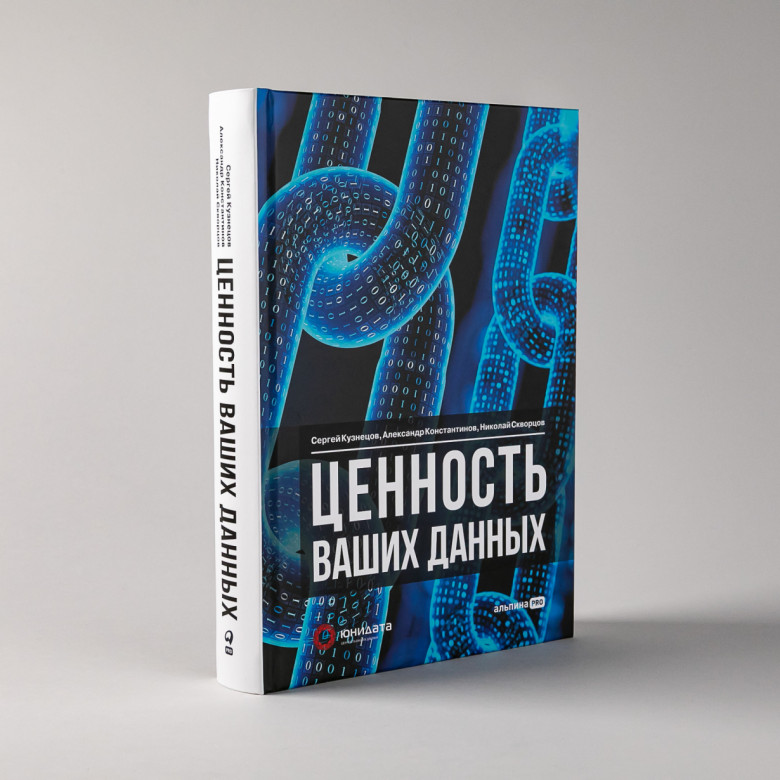

Замысел

Несколько лет назад наша компания «Юнидата» стала научным руководителем и де-факто переводчиком российского издания DAMA-DMBOK. Уже тогда, продираясь через сложность терминологии, выверяя до миллиметра формулировки, облачая сухой текст в одежду российских языковых эквивалентов, мы стали задумываться о том, чтобы написать свою книгу. Еще бы: DMBOK умопомрачительно хороша, но далека от идеала. Во-первых, многих отпугивает объем и обилие терминов. Во-вторых, при всех своих размерах, она не охватывает все области, связанный с управлением данных. В-третьих, отсутствует российская специфика. Все это (и многое другое) и сформировало желание пойти дальше.

Какое-то время после выхода этой книги мы приходили в себя и переводили дух. Но идея росла и крепла. Тем более, что анализ «отечественных аналогов» или хотя бы книг, толково рассказывающих о данных, показал немыслимое: в нашей стране вообще нет хороших книг о данных. Удивительное дело!

Сначала мы хотели выдать внутреннюю брошюру, страниц на 250, которая бы прослеживала основной лейтмотив по управлению данными. Мы намеривались распространять ее среди сотрудников компании, формируя единый понятийный аппарат и понимание проблематики. Все это было нужно, чтобы говорить на одном языке. Однако быстро поняли, что книга начинает жить своей жизнь, многократно превосходя изначальный замысел.

Сообразно сменилась и концепция – теперь мы хотели уже научпоп, который бы растолковал «даже домохозяйкам» все премудрости управления данными. Какое-то время мы жили в этой концепции, стремясь упростить и несколько примитивизировать научные постулаты. Еще одним вариантом было создать «DMBOKдля чайников», но мы быстро (и совершенно оправданно) ушли от этого.

feature freeze версии PostgreSQL 11 — читатели рассылки hackers, сжимая в левой пакет с чипсами, следили за триллером MERGE. Режиссер триллера, глава компании 2ndQuadrant Саймон Риггс (Simon Riggs), с впечатляющей настойчивостью и изобретательностью пытался протащить в версию патч, реализующий синтаксис команды MERGE. Риггс комитер с 2009 года, а со статусом комитера можно самому утверждать патчи. Ему противостояли не менее уважаемые комитеры и ветераны PostgreSQL. Страсти кипели явно и подспудно, до прямых оскорблений все же не дошло — факт удивительный для завсегдатаев многих отечественных форумов. Однако некоторое напряжение осталось до сих пор, когда вопрос утрясли, и спорить уже не о чем.

Разбор: почему ВВП — не главный показатель состояния экономики, и как правильно оценивать рынок ресурсов. Этот текст про наше народное хозяйство, написал его с целью повышения финансовой грамотности. К сожалению, большинство людей не знает многого из написанного, хотя, по моим убеждениям, такие базовые знания должны преподносить ещё в школе.

1 Почему JavaScript отстой

• 1.1 Плохая конструкция

• 1.2 Система типов

• 1.3 Плохие функции

• 1.4 Отсутствующие функции

• 1.5 DOM

2 Почему Lua отстой

3 Почему PHP отстой

• 3.1 Исправлено в поддерживаемых в настоящее время версиях

4 Почему Perl 5 отстой

5 Почему Python отстой

• 5.1 Исправлено в Python 3

6 Почему Ruby отстой

7 Почему Flex/ActionScript отстой

8 Почему скриптовые языки отстой

9 Почему C отстой

10 Почему C++ отстой

11 Почему .NET отстой

12 Почему C# отстой

13 Почему VB.NET отстой

15 Почему Objective-C отстой

16 Почему Java отстой

• 16.1 Синтаксис

• 16.2 Исправлено в Java 7 (2011)

• 16.3 Модель

• 16.4 Библиотека

• 16.5 Обсуждение

17 Почему Backbase отстой

18 Почему XML отстой

19 Почему отстой XSLT/XPath

20 Почему CSS отстой

• 20.1 Исправлено в CSS3

21 Почему Scala отстой

22 Почему Haskell отстой

23 Почему Closure отстой

24 Почему Go отстой

• 24.1 Базовые средства программирования (базовый язык)

• 24.2 Взаимосовместимость

• 24.3 Стандартная библиотека

• 24.4 Набор инструментальных средств

• 24.5 Сообщество

25 Почему Rust отстой

• 25.1 Безопасность

• 25.2 Синтаксис

• 25.3 Конструкция API и система типов

• 25.4 Сообщество

• 25.5 Набор инструментальных средств

XMLHttpRequest

HTMLHRElement| К написанию сей заметки меня сподвигло то, что я устал делать развёрнутые замечания на эту тему в комментариях к статьям, где в качестве части инструкции по сборке и настройке чего-либо для конкретного дистра предлагают выполнить make install. |

Суть сводится к тому, что эту команду в виде «make install» или «sudo make install» использовать в современных дистрибутивах нельзя.

Суть сводится к тому, что эту команду в виде «make install» или «sudo make install» использовать в современных дистрибутивах нельзя.