Я даже не про face detection, а просто про решение задачи оптимизации, "4.1. SDM on analytic scalar functions". Странно, что они говорят, например, "SDM converges with the same number of iteration as Newton method

but each iteration is faster", но не подтверждают последнее цифрами. Ну да ладно…

Ну… я пробежал статью глазами за 4 минуты, увидел, что вместо классических методов 2-го порядка предлагается что-то еще. Увидел сравнения по качеству решения задачи face detection. А про время работы ничего… Конечно, это вовсе не значит, что метод не полезен, но наверняка про время работы умолчали не просто так.

Что-то как-то статья умалчивает временную сложность предлагаемого подхода. И на страничке, где можно код скачать, по ссылке из статьи, – "IntraFace is no longer available to download nor supported." :)

Могу предположить, что люди не согласны с некоторыми вещами. Например, с демагогией про Бойда, оптимизацию и теорему Ферма. Может, нам выключить все GPU и забыть про нейронки, раз «задача оптимизации нерешаема»? И надо ли про все это знать человеку, который перешел по ссылке, что вспомнить, что такое градиент и как максимизировать правдоподобие?

Ваш гнев, возможно, и справедлив, но не по адресу. Конспекты, которые Вы так подробно проанализировали — это сопровождение специализации Яндекса и МФТИ «Машинное обучение и анализ данных», а мы сослались на них просто как на дополнительный источник для быстрого повторения математики.

Новый запуск – 1 октября 2018 г., на английском. Подробности – тут.

Новый запуск – 1 октября 2018 г., на английском. Подробности – тут.

Новый запуск – 1 октября 2018 г., на английском. Подробности – тут.

Новый запуск – 1 октября 2018 г., на английском. Подробности – тут.

Новый запуск – 1 октября 2018 г., на английском. Подробности – тут.

Новый запуск – 1 октября 2018 г., на английском. Подробности – тут.

Новый запуск – 1 октября 2018 г., на английском. Подробности – тут.

Понятно, конечно, что основной мотив публикации – между "Привет, Хабр!" и КДПВ, но не лучше ли это хотя бы в конец статьи убрать?

отсюда

Не очень понятно, зачем этот перевод, когда на хабре же есть вот это. Не говоря уже о недавнем релизе 0.4.0, делающем статью еще менее актуальной.

svboobnov лучше просто игнорить :)

Я даже не про face detection, а просто про решение задачи оптимизации, "4.1. SDM on analytic scalar functions". Странно, что они говорят, например, "SDM converges with the same number of iteration as Newton method

but each iteration is faster", но не подтверждают последнее цифрами. Ну да ладно…

Ну… я пробежал статью глазами за 4 минуты, увидел, что вместо классических методов 2-го порядка предлагается что-то еще. Увидел сравнения по качеству решения задачи face detection. А про время работы ничего… Конечно, это вовсе не значит, что метод не полезен, но наверняка про время работы умолчали не просто так.

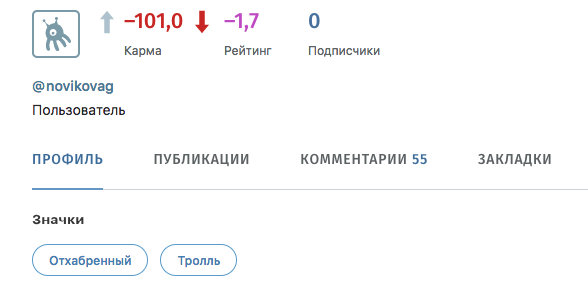

Дмитрий Петрович, это тролль, его лучше не кормить.

Что-то как-то статья умалчивает временную сложность предлагаемого подхода. И на страничке, где можно код скачать, по ссылке из статьи, – "IntraFace is no longer available to download nor supported." :)

продолжение скоро будет.

Я не Дмитрий Петрович, но спрошу: зачем псевдообратную матрицу искать с помощью глубинного обучения?

Дальше и так

dropnaделаетсяА за неточности в материалах спасибо, но их, правда, лучше указать организаторам специализации, контакты их легко найти.

Могу предположить, что люди не согласны с некоторыми вещами. Например, с демагогией про Бойда, оптимизацию и теорему Ферма. Может, нам выключить все GPU и забыть про нейронки, раз «задача оптимизации нерешаема»? И надо ли про все это знать человеку, который перешел по ссылке, что вспомнить, что такое градиент и как максимизировать правдоподобие?

Ваш гнев, возможно, и справедлив, но не по адресу. Конспекты, которые Вы так подробно проанализировали — это сопровождение специализации Яндекса и МФТИ «Машинное обучение и анализ данных», а мы сослались на них просто как на дополнительный источник для быстрого повторения математики.