Сегодня мы решили рассказать вам о нескольких необычных дата-центрах, построенных в самых разных уголках планеты. Как обеспечить работу ЦОД в суровых условиях Антарктиды? И почему дата-центры Yahoo похожи на курятники? Об этом далее.

/ фото Krishna CC

По меркам нынешних дата-центров, Ice Cube Lab не самый крупный и не самый мощный. В распоряжении ЦОДа 1,2 тыс. вычислительных ядер и хранилище данных на три петабайта. Однако одна особенность выделяет его на фоне других — он расположен в Антарктике на станции «Амундсен — Скотт».

Дата-центр подключен к нейтринному детектору обсерватории IceCube, состоящему из массивов оптических сенсоров, погруженных в лед на километровую глубину. Система помогает ученым регистрировать вспышки нейтрино, вызванные различными астрономическими явлениями, это нужно для изучения темной материи.

Штат ИТ-специалистов Ice Cube состоит всего из нескольких человек, большая часть из которых приезжает только в летний период для проведения запланированных работ. Остальная поддержка осуществляется удаленно. Для большинства коммуникаций с центром используется сеть спутников «Иридиум», хотя скорость передачи данных всего 2400 бит/с.

При такой низкой скорости команде приходится идти на ряд ухищрений: ужимать почтовые вложения, прибегать к мультиплексированию, даже использовать беспроводные сервера, чтобы подключать полевые станции. Однако не все так плохо. Восемь часов в день спутник Nasa GOES-3 (который ранее был метеоспутником) все же обеспечивает станцию мегабитным каналом связи.

Управляя работой ЦОДа в условиях Антарктиды, нужно учитывать ряд особенностей. Одной из основных проблем является практически нулевая влажность. Из-за этого сотрудники, находясь рядом с серверами, вынуждены носить антистатические жилеты и следить, чтобы выполнялись все требования по заземлению.

К тому же низкая влажность выводи�� из строя использующиеся для хранения и переноса данных магнитные кассеты, которые в буквальном смысле начинают крошиться. Инженерам даже приходится их слегка увлажнять. Для этого кассеты периодически помещаются в теплицу. Сотрудники станции даже хотели поместить в серверную увлажнитель, однако из-за возможных проблем с конденсатом от этой идеи решили отказаться.

Еще одной трудной задачей является охлаждение дата-центра. Казалось бы, можно просто «открыть дверь» и позволить холоду решить проблему. Однако температура снаружи может достигать -70 градусов по Цельсию, что в короткое время выведет из строя всю технику. В таких условиях для контроля над температурой воздуха используется специальная система вентиляции (без кондиционирования воздуха), управляющая потоками холодного воздуха снаружи. Однако как говорят сотрудники станции, случается, что в экстремальных условиях замерзает и она.

Несмотря на все трудности, члены команды гордятся тем, что могут поддерживать работу 150 серверов Ice Cube Lab вблизи Южного полюса, обеспечивая доступность на уровне большем, чем 99,5%.

Команда Ice Cube Lab в прошлом году опубликовала небольшое видео, в котором провела экскурсию по дата-центру. Посмотреть его вы можете по ссылке.

LEED — это частная программа сертификации «зеленого строительства», которая была запущена еще в 1998 году. Компании, здания которых выполняют нормы LEED, экономят до 25% больше энергии, а также могут получать налоговые льготы от государства.

На сегодняшний день около 25 дата-центров во всем мире имеют платиновый статус LEED — наивысший статус в этой программе. Одним из первых его получил занимающий 2 гектара Citi Data Center во Франкфурте еще в 2009 году.

Citi Data Center использует сразу несколько энергосберегающих технологий. Сам центр спроектирован таким образом, чтобы 65% времени в основе системы охлаждения выступал свежий воздух снаружи. За счет процесса обратного осмоса уменьшается осадок в градирнях, используемых для охлаждения воды. Для полива зеленых насаждений на территории ЦОД дополнительно применяют дождевую воду.

Весь операционный мусор направляется на переработку. При этом «экологичность» дата-центра соблюдалась еще при постройке. Весь строительный мусор был вывезен за пределы городской свалки, а грамотная проектировка ЦОДа позволила уменьшить длину всех необходимых кабелей на 250 километров.

/ фото Open Grid Scheduler CC

Когда мы говорим о дата-центрах, чаще всего в голове возникает образ огромного помещения, набитого серверными стойками и оборудованием. Однако существует более компактная альтернатива — модульный дата-центр. Такие ЦОДы чаще всего представлены в виде блоков с собственной системой охлаждения, с помощью которых можно быстро развернуть ИТ-инфраструктуру в необходимом объеме.

Например, транспортная компания Ecotality, используя модульные дата-центры Instant, смогла за 8 недель переехать в новый офис, при этом сэкономив 120 тыс. долларов на пространстве под ЦОД и снизив стоимость расходов на охлаждение на 65%.

Бывает, что компании (например, IBM и Elliptical), «пакуют» серверы и другое вспомогательное оборудование в морские контейнеры. В таком виде модули ЦОДа удобно перевозить с помощью фур или кораблей в короткие сроки на дальние расстояния.

Плюсом «портативных» дата-центров является возможность размещать и�� ближе к своим клиентам или источникам информации. Одним из примеров является проект Nautilus, создатели которого расположили оборудование на баржах. Такая концепция позволяет не только использовать воду для охлаждения центров, но и значительно повысить их мобильность.

Новый проект дата-центров от Yahoo называется Yahoo Compute Coop («Вычислительный курятник Yahoo»). Однако это не шутка и не маркетинговый ход. ЦОДы действительно похожи на курятники, но дело тут не только во внешнем сходстве. Продолговатая форма курятников вместе с дополнительной секцией крыши используется для создания естественной вентиляции, благодаря которой теплый воздух поднимается и выводится наружу через специальные отверстия.

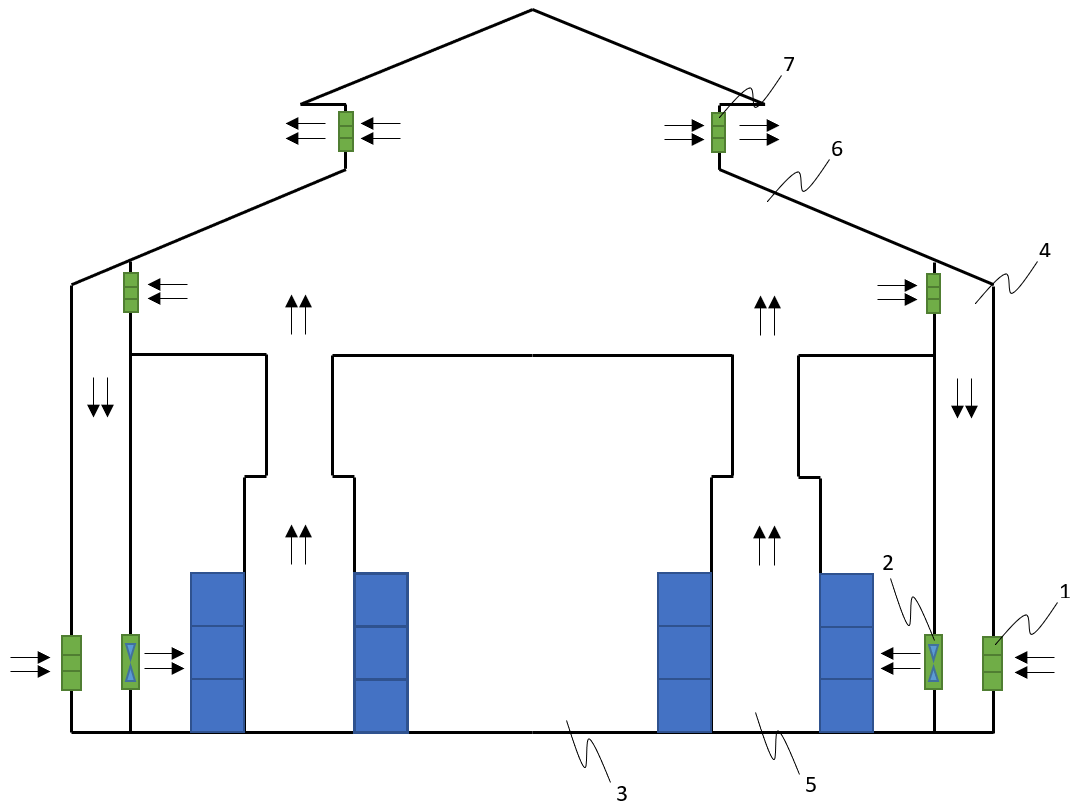

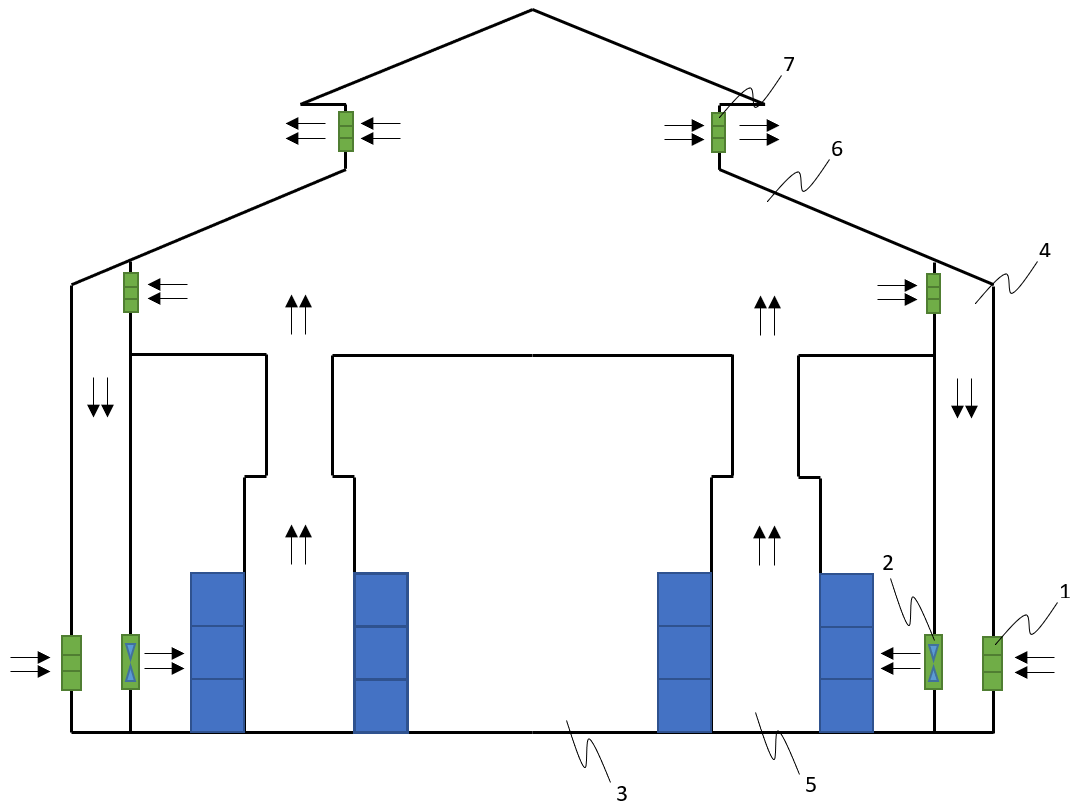

Этот дата-центр Yahoo может охлаждаться простым воздухом с улицы. В последнем случае воздух снаружи температурой от 21 до 29 градусов Цельсия попадает в дата-центр через регулируемые жалюзи (1), расположенные на стенах здания. Затем он с помощью вентиляционной установки (2) направляется в серверный зал (3) через смесительную камеру (4). В этом случае воздух не охлаждается дополнительно, а лишь фильтруется.

Вентиляторы, установленные на стойках с серверами, выдувают уже теплый воздух во внутренний коридор (5), откуда он, посредством естественной конвекции, поднимается на «чердак» (6). Затем он выводится наружу через регулируемые жалюзи наверху (7).

Если же температура воздуха на улице оказывается выше 29 градусов, то сначала он охлаждается в смесительной камере. А если ниже 21 градуса, то часть горячего воздуха, уже прошедшего через серверный зал, направляется в смесительную камеру для разогрева.

К такому дизайну в Yahoo пришли не сразу. Компания начала строить собственные дата-центры еще в 2007 году, однако они ничем не выделялись — обычные помещения с активным воздушным охлаждением. Следующий проект назывался YTC (Yahoo Thermal Cooling). Горячий воздух в таких ЦОДах выдувался вентиляторами серверов в специальное закрытое помещение, откуда с помощью интеркулера вы��еснялся наружу.

Проект «дата-центров-курятников» является третьей итерацией проекта Yahoo по оптимизации систем охлаждения в крупных предприятиях с десятками тысяч вычислительных машин. Компания уже построила несколько ЦОДов по новому плану. Один из первых был открыт в Локпорте, Нью-Йорк. При этом его коэффициент эффективности использования энергии (PUE) составляет 1,08 балла, что сравнимо с европейскими дата-центрами, использующими для охлаждения стоек особенности холодного климата.

К тому же корпорация зарегистрировала около 3 тыс. патентов, и намерена продавать технологию другим крупным фирмам.

P.S. О чем еще мы пишем в Первом блоге о корпоративном IaaS:

P.P.S. Несколько свежих материалов из нашего блога на Хабре:

/ фото Krishna CC

Самый «холодный» ЦОД на планете

По меркам нынешних дата-центров, Ice Cube Lab не самый крупный и не самый мощный. В распоряжении ЦОДа 1,2 тыс. вычислительных ядер и хранилище данных на три петабайта. Однако одна особенность выделяет его на фоне других — он расположен в Антарктике на станции «Амундсен — Скотт».

Дата-центр подключен к нейтринному детектору обсерватории IceCube, состоящему из массивов оптических сенсоров, погруженных в лед на километровую глубину. Система помогает ученым регистрировать вспышки нейтрино, вызванные различными астрономическими явлениями, это нужно для изучения темной материи.

Штат ИТ-специалистов Ice Cube состоит всего из нескольких человек, большая часть из которых приезжает только в летний период для проведения запланированных работ. Остальная поддержка осуществляется удаленно. Для большинства коммуникаций с центром используется сеть спутников «Иридиум», хотя скорость передачи данных всего 2400 бит/с.

При такой низкой скорости команде приходится идти на ряд ухищрений: ужимать почтовые вложения, прибегать к мультиплексированию, даже использовать беспроводные сервера, чтобы подключать полевые станции. Однако не все так плохо. Восемь часов в день спутник Nasa GOES-3 (который ранее был метеоспутником) все же обеспечивает станцию мегабитным каналом связи.

Управляя работой ЦОДа в условиях Антарктиды, нужно учитывать ряд особенностей. Одной из основных проблем является практически нулевая влажность. Из-за этого сотрудники, находясь рядом с серверами, вынуждены носить антистатические жилеты и следить, чтобы выполнялись все требования по заземлению.

К тому же низкая влажность выводи�� из строя использующиеся для хранения и переноса данных магнитные кассеты, которые в буквальном смысле начинают крошиться. Инженерам даже приходится их слегка увлажнять. Для этого кассеты периодически помещаются в теплицу. Сотрудники станции даже хотели поместить в серверную увлажнитель, однако из-за возможных проблем с конденсатом от этой идеи решили отказаться.

Еще одной трудной задачей является охлаждение дата-центра. Казалось бы, можно просто «открыть дверь» и позволить холоду решить проблему. Однако температура снаружи может достигать -70 градусов по Цельсию, что в короткое время выведет из строя всю технику. В таких условиях для контроля над температурой воздуха используется специальная система вентиляции (без кондиционирования воздуха), управляющая потоками холодного воздуха снаружи. Однако как говорят сотрудники станции, случается, что в экстремальных условиях замерзает и она.

Несмотря на все трудности, члены команды гордятся тем, что могут поддерживать работу 150 серверов Ice Cube Lab вблизи Южного полюса, обеспечивая доступность на уровне большем, чем 99,5%.

Команда Ice Cube Lab в прошлом году опубликовала небольшое видео, в котором провела экскурсию по дата-центру. Посмотреть его вы можете по ссылке.

Один из самых «зеленых» ЦОД

LEED — это частная программа сертификации «зеленого строительства», которая была запущена еще в 1998 году. Компании, здания которых выполняют нормы LEED, экономят до 25% больше энергии, а также могут получать налоговые льготы от государства.

На сегодняшний день около 25 дата-центров во всем мире имеют платиновый статус LEED — наивысший статус в этой программе. Одним из первых его получил занимающий 2 гектара Citi Data Center во Франкфурте еще в 2009 году.

Citi Data Center использует сразу несколько энергосберегающих технологий. Сам центр спроектирован таким образом, чтобы 65% времени в основе системы охлаждения выступал свежий воздух снаружи. За счет процесса обратного осмоса уменьшается осадок в градирнях, используемых для охлаждения воды. Для полива зеленых насаждений на территории ЦОД дополнительно применяют дождевую воду.

Весь операционный мусор направляется на переработку. При этом «экологичность» дата-центра соблюдалась еще при постройке. Весь строительный мусор был вывезен за пределы городской свалки, а грамотная проектировка ЦОДа позволила уменьшить длину всех необходимых кабелей на 250 километров.

/ фото Open Grid Scheduler CC

Дата-центры из кубиков

Когда мы говорим о дата-центрах, чаще всего в голове возникает образ огромного помещения, набитого серверными стойками и оборудованием. Однако существует более компактная альтернатива — модульный дата-центр. Такие ЦОДы чаще всего представлены в виде блоков с собственной системой охлаждения, с помощью которых можно быстро развернуть ИТ-инфраструктуру в необходимом объеме.

Например, транспортная компания Ecotality, используя модульные дата-центры Instant, смогла за 8 недель переехать в новый офис, при этом сэкономив 120 тыс. долларов на пространстве под ЦОД и снизив стоимость расходов на охлаждение на 65%.

Бывает, что компании (например, IBM и Elliptical), «пакуют» серверы и другое вспомогательное оборудование в морские контейнеры. В таком виде модули ЦОДа удобно перевозить с помощью фур или кораблей в короткие сроки на дальние расстояния.

Плюсом «портативных» дата-центров является возможность размещать и�� ближе к своим клиентам или источникам информации. Одним из примеров является проект Nautilus, создатели которого расположили оборудование на баржах. Такая концепция позволяет не только использовать воду для охлаждения центров, но и значительно повысить их мобильность.

Курятники Yahoo

Новый проект дата-центров от Yahoo называется Yahoo Compute Coop («Вычислительный курятник Yahoo»). Однако это не шутка и не маркетинговый ход. ЦОДы действительно похожи на курятники, но дело тут не только во внешнем сходстве. Продолговатая форма курятников вместе с дополнительной секцией крыши используется для создания естественной вентиляции, благодаря которой теплый воздух поднимается и выводится наружу через специальные отверстия.

Этот дата-центр Yahoo может охлаждаться простым воздухом с улицы. В последнем случае воздух снаружи температурой от 21 до 29 градусов Цельсия попадает в дата-центр через регулируемые жалюзи (1), расположенные на стенах здания. Затем он с помощью вентиляционной установки (2) направляется в серверный зал (3) через смесительную камеру (4). В этом случае воздух не охлаждается дополнительно, а лишь фильтруется.

Вентиляторы, установленные на стойках с серверами, выдувают уже теплый воздух во внутренний коридор (5), откуда он, посредством естественной конвекции, поднимается на «чердак» (6). Затем он выводится наружу через регулируемые жалюзи наверху (7).

Если же температура воздуха на улице оказывается выше 29 градусов, то сначала он охлаждается в смесительной камере. А если ниже 21 градуса, то часть горячего воздуха, уже прошедшего через серверный зал, направляется в смесительную камеру для разогрева.

К такому дизайну в Yahoo пришли не сразу. Компания начала строить собственные дата-центры еще в 2007 году, однако они ничем не выделялись — обычные помещения с активным воздушным охлаждением. Следующий проект назывался YTC (Yahoo Thermal Cooling). Горячий воздух в таких ЦОДах выдувался вентиляторами серверов в специальное закрытое помещение, откуда с помощью интеркулера вы��еснялся наружу.

Проект «дата-центров-курятников» является третьей итерацией проекта Yahoo по оптимизации систем охлаждения в крупных предприятиях с десятками тысяч вычислительных машин. Компания уже построила несколько ЦОДов по новому плану. Один из первых был открыт в Локпорте, Нью-Йорк. При этом его коэффициент эффективности использования энергии (PUE) составляет 1,08 балла, что сравнимо с европейскими дата-центрами, использующими для охлаждения стоек особенности холодного климата.

К тому же корпорация зарегистрировала около 3 тыс. патентов, и намерена продавать технологию другим крупным фирмам.

P.S. О чем еще мы пишем в Первом блоге о корпоративном IaaS:

- Unboxing блейд-сервера Cisco UCS B480 M5

- Почему хороший IaaS-провайдер не должен иметь собственный ЦОД

- Облачные сервисы: опыт использования IaaS российскими компаниями

P.P.S. Несколько свежих материалов из нашего блога на Хабре: