Обучение с подкреплением (RL) — одна из самых перспективных техник машинного обучения, которая сейчас активно развивается. Здесь агент ИИ получает положительное вознаграждение за правильные действия, и отрицательное — за неправильные. Такой метод кнута и пряника прост и универсален. С его помощью DeepMind научила алгоритм DQN играть в старые видеоигры Atari, а AlphaGoZero — в древнюю игру Go. Так OpenAI обучила алгоритм OpenAI-Five играть в современную видеоигру Dota, а Google научила роботизированные руки захватывать новые объекты. Несмотря на успехи RL, до сих пор есть много проблем, которые снижают эффективность этой техники.

Алгоритмам RL трудно работать в среде, где агент редко получает обратную связь. Но это типично для реального мира. В качестве примера, представьте себе поиск любимого сыра в большом лабиринте, как супермаркет. Вы ищете и ищете отдел с сырами, но никак не находите. Если на каждом шагу не получать ни «кнута», ни «пряника», то невозможно сказать, в правильном ли направлении вы движетесь. В отсутствие награды что мешает вам вечно бродить по кругу? Ничего, кроме, возможно, вашего любопытства. Оно мотивирует перейти в продуктовый отдел, который выглядит незнакомым.

Научная работа «Эпизодическое любопытство через достижимость» — результат сотрудничества между командой Google Brain, DeepMind и Швейцарской высшей технической школой Цюриха. Мы предлагаем новую эпизодическую модель вознаграждения RL на основе памяти. Она похожа на любопытство, которое позволяет исследовать окружение. Поскольку агент должен не только изучать окружение, но и решать исходную задачу, то наша модель добавляет бонус к первоначально разреженному вознаграждению. Комбинированная награда больше не разрежена, что позволяет стандартным алгоритмам RL учиться на ней. Таким образом, наш метод любопытства расширяет набор задач, решаемых с помощью RL.

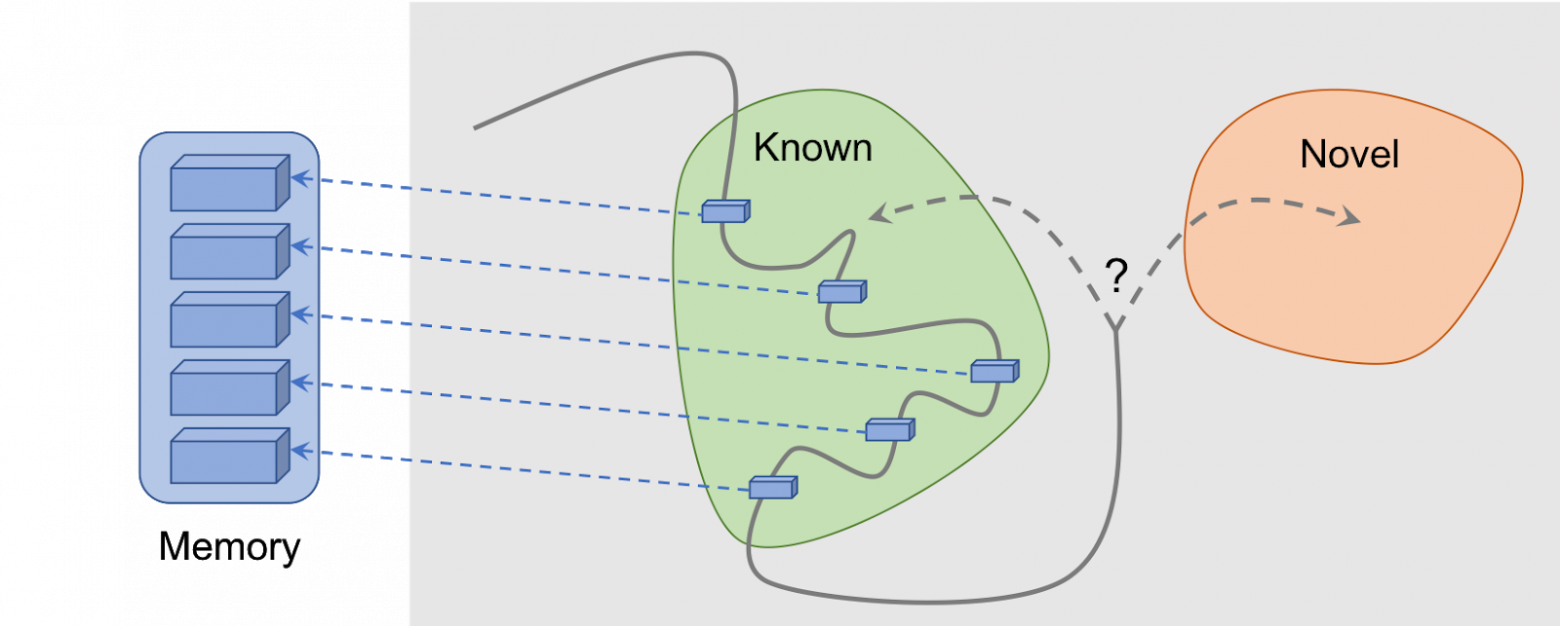

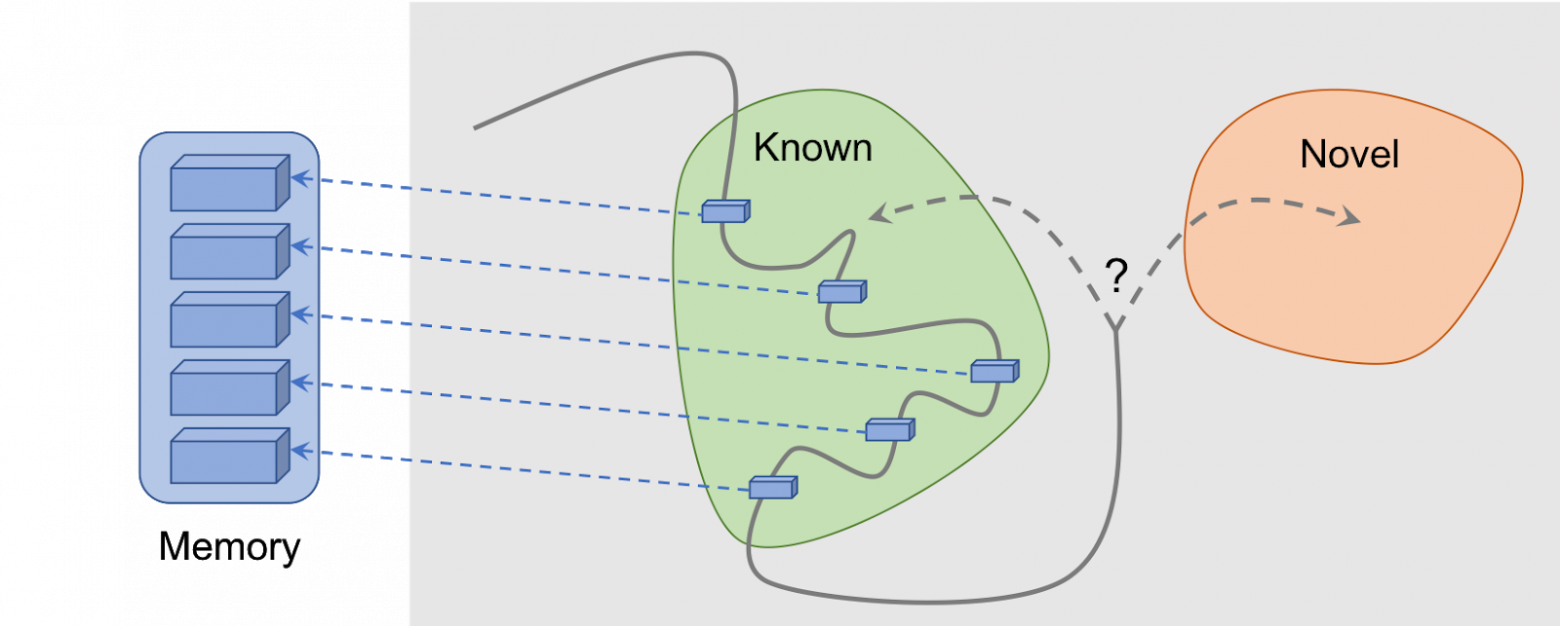

Эпизодическое любопытство через достижимость: данные наблюдений добавляются в память, награда вычисляется на основании того, насколько далеко текущее наблюдение от аналогичных наблюдений в памяти. Агент получает бóльшую награду за наблюдения, которые ещё не представлены в памяти

Основная идея метода в том, чтобы хранить наблюдения агента за окружающей средой в эпизодической памяти, а также вознаграждать агента за просмотр наблюдений, ещё не представленных в памяти. «Отсутствие в памяти» — это определение новизны в нашем методе. Поиск таких наблюдений означает поиск незнакомого. Такая тяга к поиску незнакомого приведёт агента ИИ в новые локации, тем самым предотвратив блуждание по кругу, и в конечном итоге поможет ему наткнуться на цель. Как мы обсудим позже, наша формулировка может удержать агента от нежелательного поведения, которому подвержены некоторые другие формулировки. К нашему большому удивлению, такое поведение имеет некоторое сходство с тем, что неспециалист назвал бы «прокрастинацией».

Хотя в прошлом было много попыток сформулировать любопытство[1][2][3][4], в этой статье мы сосредоточимся на одном естественном и очень популярном подходе: любопытство через удивление на основе прогнозирования. Эта техника описана в недавней статье «Исследование среды с помощью любопытства путём прогнозирования под самостоятельным контролем» (обычно этот метод именуют ICM). Чтобы проиллюстрировать связь удивления с любопытством, снова используем аналогию поиска сыра в супермаркете.

Иллюстрация Индиры Пасько, по лицензии CC BY-NC-ND 4.0

Блуждая по магазину, вы пытаетесь предсказать будущее («Сейчас я нахожусь в мясном отделе, поэтому я думаю, что отдел за углом — это отдел рыбы, они обычно рядом в этой сети супермаркетов»). Если прогноз неверен, вы удивляетесь («На самом деле тут отдел овощей. Я этого не ожидал!») — и таким образом получаете вознаграждение. Это повышает мотивацию в будущем опять посмотреть за угол, исследуя новые места только для проверки, что ваши ожидания соответствуют реальности (и, возможно, наткнуться на сыр).

Аналогично, метод ICM строит прогностическую модель динамики мира и даёт агенту вознаграждение, если у модели не получается сделать хорошие прогнозы — маркер неожиданности или новизны. Обратите внимание, что изучение новых мест напрямую не формулируется в любопытстве ICM. Для метода ICM их посещение — только способ получить больше «сюрпризов» и, таким образом, максимизировать общее вознаграждение. Как выясняется, в некоторых средах могут быть иные способы вызвать у себя удивление, что приводит к непредвиденным результатам.

Агент с системой любопытства на основе удивления зависает при встрече с телевизором. Анимация из видео Дипака Патака, используется по лицензии CC BY 2.0

В статье «Крупномасштабное исследование обучения на основе любопытства» авторы метода ICM вместе с исследователями из OpenAI показывают скрытую опасность максимизации удивления: агенты могут научиться предаваться прокрастинации вместо того, чтобы делать что-то полезное для поставленной задачи. Чтобы понять, почему так происходит, рассмотрим мысленный эксперимент, который авторы называют «проблемой телевизионного шума». Здесь агент помещается в лабиринт с задачей найти очень полезный предмет (вроде «сыра» в нашем примере). В среде есть телевизор, а у агента имеется пульт дистанционного управления. Существует ограниченное количество каналов (на каждом отдельная передача), а каждое нажатие на пульте переключает ТВ на случайный канал. Как агент будет действовать в такой среде?

Если любопытство формируется на основе удивления, то смена каналов даст больше вознаграждения, поскольку каждое изменение непредсказуемо и неожиданно. Важно отметить, что даже после циклического просмотра всех доступных каналов случайный выбор канала гарантирует, что каждое новое изменение всё равно окажется неожиданным — агент делает прогноз, что покажет ТВ после переключения канала, и, скорее всего, прогноз окажется неправильным, что вызовет удивление. Важно отметить, что даже если агент уже видел каждую передачу на каждом канале, изменение по-прежнему непредсказуемо. Из-за этого агент вместо того, чтобы искать очень полезный предмет, в конечном итоге останется перед телевизором — похоже на прокрастинацию. Как же изменить формулировку любопытства, чтобы предотвратить такое поведение?

В статье «Эпизодическое любопытство через достижимость» мы исследуем эпизодическую модель любопытства, основанную на памяти, которая менее склонна к получению мгновенных удовольствий. Почему так? Если взять пример выше, то через некоторое время переключения каналов все передачи в конечном итоге окажутся в памяти. Таким образом, телевизор утратит свою привлекательность: даже если порядок появления передач на экране случайный и непредсказуемый, все они уже в памяти! Это главное отличие от метода, основанного на удивлении: наш метод даже не пытается прогнозировать будущее, его предсказать трудно (или даже невозможно). Вместо этого агент изучает прошлое и проверяет, есть ли в памяти наблюдения, подобные текущему. Таким образом, наш агент не склонен к мгновенному удовольствиям, которые даёт «телевизионный шум». Агенту придётся идти и исследовать мир за пределами телевизора, чтобы получить больше вознаграждения.

Но как мы решаем, видит ли агент то же самое, что хранится в памяти? Проверка точного соответствия бессмысленна: в реальной среде агент редко увидит дважды одно и то же. Например, даже если агент вернётся в ту же самую комнату, он всё равно увидит эту комнату под другим углом.

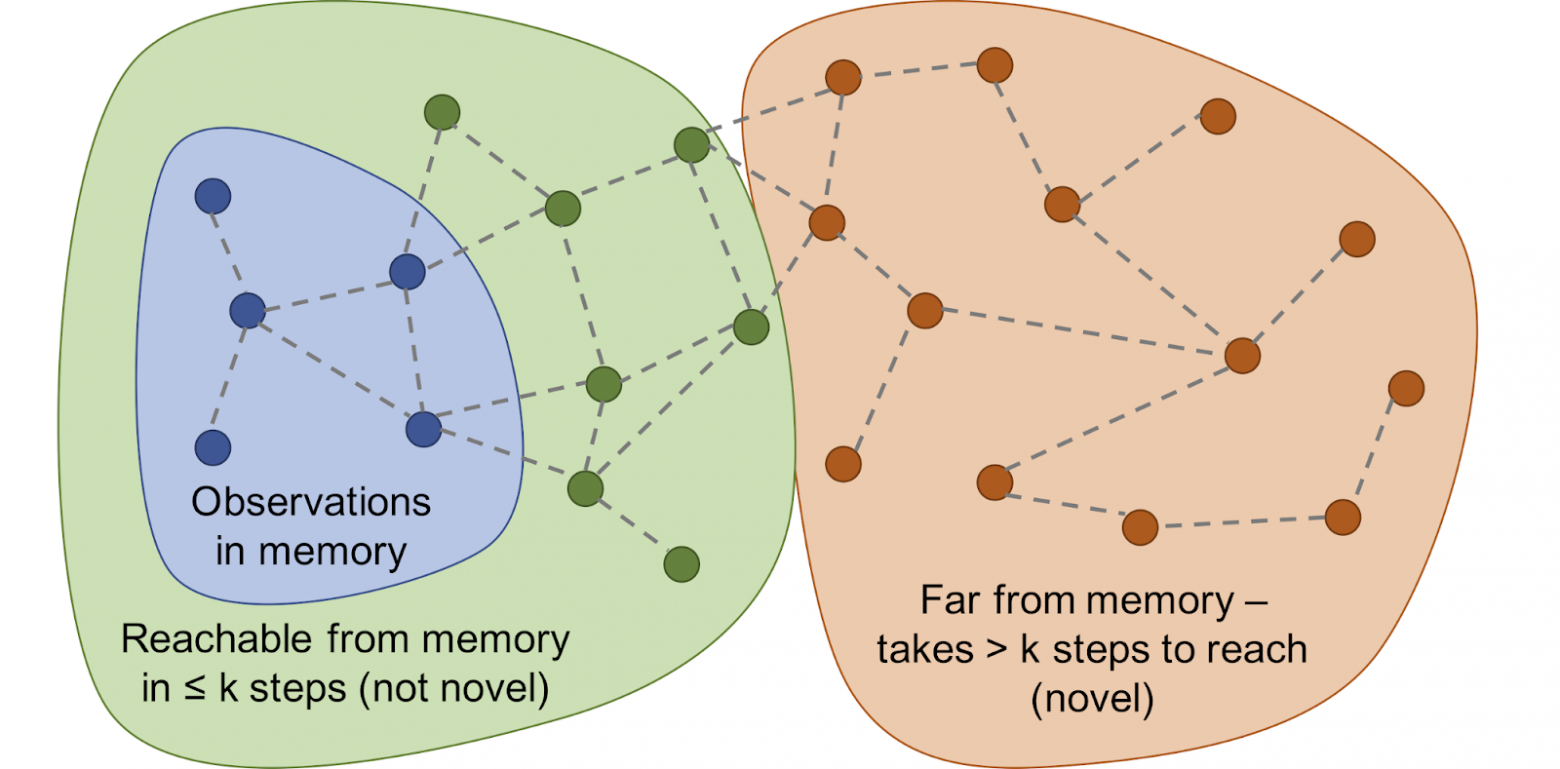

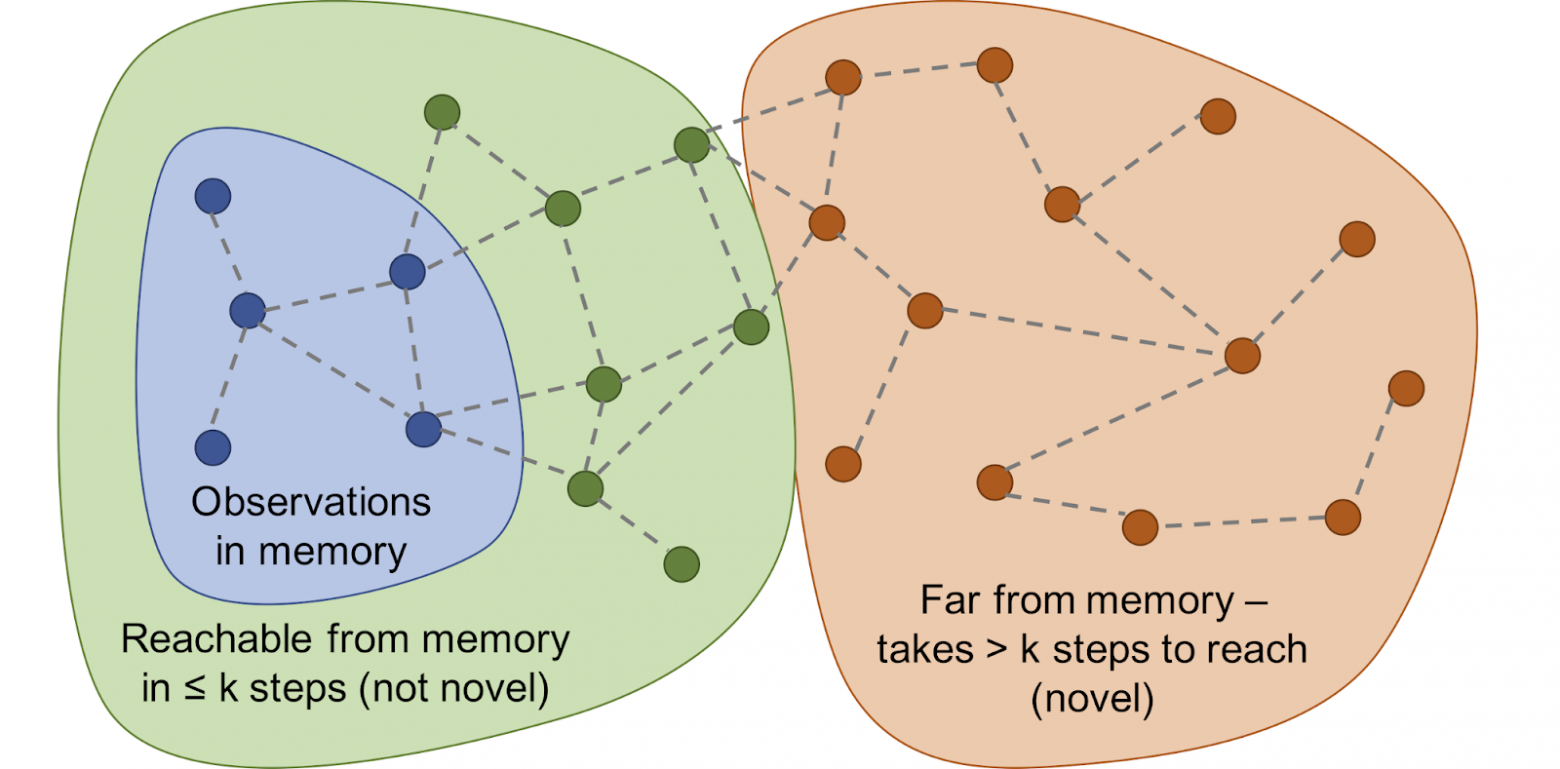

Вместо проверки точного совпадения, мы используем глубокую нейронную сеть, которая обучена измерять, насколько похожи два опыта. Чтобы обучить эту сеть, мы должны угадать, насколько близко по времени произошли наблюдения. Близость по времени — хороший показатель того, следует ли считать два наблюдения частью одного и того же. Такое обучение приводит к общей концепции новизны через достижимость, которая проиллюстрирована ниже.

Граф достижимостей определяет новизну. На практике этот граф недоступен — поэтому мы обучаем нейросетевой аппроксиматор оценивать количество шагов между наблюдениями

Чтобы сравнить производительность различных подходов к описанию любопытства, мы протестировали их в двух визуально богатых 3D-средах: ViZDoom и DMLab. В этих условиях перед агентом ставились различные задачи, такие как поиск цели в лабиринте, сбор хороших объектов и уклонение от плохих. В среде DMLab агент по умолчанию экипирован фантастическим гаджетом вроде лазера, но если гаджет не нужен для конкретной задачи, агент может свободно им не пользоваться. Интересно, что агент ICM на основе удивления на самом деле очень часто использовал лазер, даже если тот был бесполезен для выполнения поставленной задачи! Как и в случае с телевизором, вместо поиска ценного предмета в лабиринте он предпочёл тратить время на стрельбу по стенам, потому что это давало много награды в виде удивления. Теоретически, результат пальбы по стенам должен быть предсказуем, но на практике предсказать его слишком сложно. Вероятно, для этого требуется более глубокое знание физики, чем доступно стандартному агенту ИИ.

Агент ICM на основе удивления постоянно палит в стену вместо того, чтобы исследовать лабиринт

В отличие от него, наш агент освоил разумное поведение по исследованию среды. Это произошло, потому что он не пытается предсказать результат своих действий, а скорее ищет наблюдения, которые «дальше» от тех, что находятся в эпизодической памяти. Другими словами, агент неявно преследует цели, которые требуют больше усилий, чем простой выстрел в стену.

Наш метод демонстрирует разумное поведение по исследованию среды

Интересно наблюдать, как наш подход к вознаграждению наказывает агента, бегущего по кругу, потому что после завершения первого круга агент не сталкивается с новыми наблюдениями и, таким образом, не получает никакой награды:

Визуализация награды: красный соответствует негативному вознаграждению, Зелёный — положительному. Слева направо: карта с наградами, карта с местоположениями в памяти, вид от первого лица

В то же время наш метод способствует хорошему исследованию среды:

Визуализация награды: красный соответствует негативному вознаграждению, Зелёный — положительному. Слева направо: карта с наградами, карта с местоположениями в памяти, вид от первого лица

Надеемся, что наша работа способствует новой волне исследований, которые выйдут за рамки техники удивления, чтобы обучить агентов более интеллектуальному поведению. Для углублённого анализа нашего метода, пожалуйста, взгляните на препринт научной работы.

Этот проект является результатом сотрудничества между командой Google Brain, DeepMind и Швейцарской высшей технической школой Цюриха. Основная исследовательская группа: Николай Савинов, Антон Райчук, Рафаэль Маринье, Дэмиен Винсент, Марк Поллефейс, Тимоти Лилликрап и Сильвен Жели. Мы хотели поблагодарить Оливье Пьеткина, Карлоса Рикельме, Чарльза Бланделла и Сергея Левайна за обсуждение этого документа. Мы благодарны Индире Паско за помощь с иллюстрациями.

[1] «Изучение среды на основе подсчёта с моделями нейронной плотности», Георг Островский, Марк Г. Беллемар, Аарон Ван ден Оорд, Реми Муньос

[2] «Изучение среды на основе подсчёта для глубокого обучения с подкреплением», Хаоран Тан, Рейн Хутхуфт, Дэвис Фут, Адам Стук, Си Чен, Янь Дуань, Джон Шульман, Филип де Турк, Питер Аббель

[3] «Обучение без учителя местонахождению целей для внутренне мотивированного исследования», Александр Пере, Себастьен Форестье, Оливье Сиго, Пьер-Ив Удейе

[4] «VIME: разведка с максимизацией изменения информации», Рейн Хутхуфт, Си Чэнь, Янь Дуань, Джон Шульман, Филипп де Турк, Питер Аббель

Алгоритмам RL трудно работать в среде, где агент редко получает обратную связь. Но это типично для реального мира. В качестве примера, представьте себе поиск любимого сыра в большом лабиринте, как супермаркет. Вы ищете и ищете отдел с сырами, но никак не находите. Если на каждом шагу не получать ни «кнута», ни «пряника», то невозможно сказать, в правильном ли направлении вы движетесь. В отсутствие награды что мешает вам вечно бродить по кругу? Ничего, кроме, возможно, вашего любопытства. Оно мотивирует перейти в продуктовый отдел, который выглядит незнакомым.

Научная работа «Эпизодическое любопытство через достижимость» — результат сотрудничества между командой Google Brain, DeepMind и Швейцарской высшей технической школой Цюриха. Мы предлагаем новую эпизодическую модель вознаграждения RL на основе памяти. Она похожа на любопытство, которое позволяет исследовать окружение. Поскольку агент должен не только изучать окружение, но и решать исходную задачу, то наша модель добавляет бонус к первоначально разреженному вознаграждению. Комбинированная награда больше не разрежена, что позволяет стандартным алгоритмам RL учиться на ней. Таким образом, наш метод любопытства расширяет набор задач, решаемых с помощью RL.

Эпизодическое любопытство через достижимость: данные наблюдений добавляются в память, награда вычисляется на основании того, насколько далеко текущее наблюдение от аналогичных наблюдений в памяти. Агент получает бóльшую награду за наблюдения, которые ещё не представлены в памяти

Основная идея метода в том, чтобы хранить наблюдения агента за окружающей средой в эпизодической памяти, а также вознаграждать агента за просмотр наблюдений, ещё не представленных в памяти. «Отсутствие в памяти» — это определение новизны в нашем методе. Поиск таких наблюдений означает поиск незнакомого. Такая тяга к поиску незнакомого приведёт агента ИИ в новые локации, тем самым предотвратив блуждание по кругу, и в конечном итоге поможет ему наткнуться на цель. Как мы обсудим позже, наша формулировка может удержать агента от нежелательного поведения, которому подвержены некоторые другие формулировки. К нашему большому удивлению, такое поведение имеет некоторое сходство с тем, что неспециалист назвал бы «прокрастинацией».

Предыдущие формулировки любопытства

Хотя в прошлом было много попыток сформулировать любопытство[1][2][3][4], в этой статье мы сосредоточимся на одном естественном и очень популярном подходе: любопытство через удивление на основе прогнозирования. Эта техника описана в недавней статье «Исследование среды с помощью любопытства путём прогнозирования под самостоятельным контролем» (обычно этот метод именуют ICM). Чтобы проиллюстрировать связь удивления с любопытством, снова используем аналогию поиска сыра в супермаркете.

Иллюстрация Индиры Пасько, по лицензии CC BY-NC-ND 4.0

Блуждая по магазину, вы пытаетесь предсказать будущее («Сейчас я нахожусь в мясном отделе, поэтому я думаю, что отдел за углом — это отдел рыбы, они обычно рядом в этой сети супермаркетов»). Если прогноз неверен, вы удивляетесь («На самом деле тут отдел овощей. Я этого не ожидал!») — и таким образом получаете вознаграждение. Это повышает мотивацию в будущем опять посмотреть за угол, исследуя новые места только для проверки, что ваши ожидания соответствуют реальности (и, возможно, наткнуться на сыр).

Аналогично, метод ICM строит прогностическую модель динамики мира и даёт агенту вознаграждение, если у модели не получается сделать хорошие прогнозы — маркер неожиданности или новизны. Обратите внимание, что изучение новых мест напрямую не формулируется в любопытстве ICM. Для метода ICM их посещение — только способ получить больше «сюрпризов» и, таким образом, максимизировать общее вознаграждение. Как выясняется, в некоторых средах могут быть иные способы вызвать у себя удивление, что приводит к непредвиденным результатам.

Агент с системой любопытства на основе удивления зависает при встрече с телевизором. Анимация из видео Дипака Патака, используется по лицензии CC BY 2.0

Опасность «прокрастинации»

В статье «Крупномасштабное исследование обучения на основе любопытства» авторы метода ICM вместе с исследователями из OpenAI показывают скрытую опасность максимизации удивления: агенты могут научиться предаваться прокрастинации вместо того, чтобы делать что-то полезное для поставленной задачи. Чтобы понять, почему так происходит, рассмотрим мысленный эксперимент, который авторы называют «проблемой телевизионного шума». Здесь агент помещается в лабиринт с задачей найти очень полезный предмет (вроде «сыра» в нашем примере). В среде есть телевизор, а у агента имеется пульт дистанционного управления. Существует ограниченное количество каналов (на каждом отдельная передача), а каждое нажатие на пульте переключает ТВ на случайный канал. Как агент будет действовать в такой среде?

Если любопытство формируется на основе удивления, то смена каналов даст больше вознаграждения, поскольку каждое изменение непредсказуемо и неожиданно. Важно отметить, что даже после циклического просмотра всех доступных каналов случайный выбор канала гарантирует, что каждое новое изменение всё равно окажется неожиданным — агент делает прогноз, что покажет ТВ после переключения канала, и, скорее всего, прогноз окажется неправильным, что вызовет удивление. Важно отметить, что даже если агент уже видел каждую передачу на каждом канале, изменение по-прежнему непредсказуемо. Из-за этого агент вместо того, чтобы искать очень полезный предмет, в конечном итоге останется перед телевизором — похоже на прокрастинацию. Как же изменить формулировку любопытства, чтобы предотвратить такое поведение?

Эпизодическое любопытство

В статье «Эпизодическое любопытство через достижимость» мы исследуем эпизодическую модель любопытства, основанную на памяти, которая менее склонна к получению мгновенных удовольствий. Почему так? Если взять пример выше, то через некоторое время переключения каналов все передачи в конечном итоге окажутся в памяти. Таким образом, телевизор утратит свою привлекательность: даже если порядок появления передач на экране случайный и непредсказуемый, все они уже в памяти! Это главное отличие от метода, основанного на удивлении: наш метод даже не пытается прогнозировать будущее, его предсказать трудно (или даже невозможно). Вместо этого агент изучает прошлое и проверяет, есть ли в памяти наблюдения, подобные текущему. Таким образом, наш агент не склонен к мгновенному удовольствиям, которые даёт «телевизионный шум». Агенту придётся идти и исследовать мир за пределами телевизора, чтобы получить больше вознаграждения.

Но как мы решаем, видит ли агент то же самое, что хранится в памяти? Проверка точного соответствия бессмысленна: в реальной среде агент редко увидит дважды одно и то же. Например, даже если агент вернётся в ту же самую комнату, он всё равно увидит эту комнату под другим углом.

Вместо проверки точного совпадения, мы используем глубокую нейронную сеть, которая обучена измерять, насколько похожи два опыта. Чтобы обучить эту сеть, мы должны угадать, насколько близко по времени произошли наблюдения. Близость по времени — хороший показатель того, следует ли считать два наблюдения частью одного и того же. Такое обучение приводит к общей концепции новизны через достижимость, которая проиллюстрирована ниже.

Граф достижимостей определяет новизну. На практике этот граф недоступен — поэтому мы обучаем нейросетевой аппроксиматор оценивать количество шагов между наблюдениями

Экспериментальные результаты

Чтобы сравнить производительность различных подходов к описанию любопытства, мы протестировали их в двух визуально богатых 3D-средах: ViZDoom и DMLab. В этих условиях перед агентом ставились различные задачи, такие как поиск цели в лабиринте, сбор хороших объектов и уклонение от плохих. В среде DMLab агент по умолчанию экипирован фантастическим гаджетом вроде лазера, но если гаджет не нужен для конкретной задачи, агент может свободно им не пользоваться. Интересно, что агент ICM на основе удивления на самом деле очень часто использовал лазер, даже если тот был бесполезен для выполнения поставленной задачи! Как и в случае с телевизором, вместо поиска ценного предмета в лабиринте он предпочёл тратить время на стрельбу по стенам, потому что это давало много награды в виде удивления. Теоретически, результат пальбы по стенам должен быть предсказуем, но на практике предсказать его слишком сложно. Вероятно, для этого требуется более глубокое знание физики, чем доступно стандартному агенту ИИ.

Агент ICM на основе удивления постоянно палит в стену вместо того, чтобы исследовать лабиринт

В отличие от него, наш агент освоил разумное поведение по исследованию среды. Это произошло, потому что он не пытается предсказать результат своих действий, а скорее ищет наблюдения, которые «дальше» от тех, что находятся в эпизодической памяти. Другими словами, агент неявно преследует цели, которые требуют больше усилий, чем простой выстрел в стену.

Наш метод демонстрирует разумное поведение по исследованию среды

Интересно наблюдать, как наш подход к вознаграждению наказывает агента, бегущего по кругу, потому что после завершения первого круга агент не сталкивается с новыми наблюдениями и, таким образом, не получает никакой награды:

Визуализация награды: красный соответствует негативному вознаграждению, Зелёный — положительному. Слева направо: карта с наградами, карта с местоположениями в памяти, вид от первого лица

В то же время наш метод способствует хорошему исследованию среды:

Визуализация награды: красный соответствует негативному вознаграждению, Зелёный — положительному. Слева направо: карта с наградами, карта с местоположениями в памяти, вид от первого лица

Надеемся, что наша работа способствует новой волне исследований, которые выйдут за рамки техники удивления, чтобы обучить агентов более интеллектуальному поведению. Для углублённого анализа нашего метода, пожалуйста, взгляните на препринт научной работы.

Благодарности:

Этот проект является результатом сотрудничества между командой Google Brain, DeepMind и Швейцарской высшей технической школой Цюриха. Основная исследовательская группа: Николай Савинов, Антон Райчук, Рафаэль Маринье, Дэмиен Винсент, Марк Поллефейс, Тимоти Лилликрап и Сильвен Жели. Мы хотели поблагодарить Оливье Пьеткина, Карлоса Рикельме, Чарльза Бланделла и Сергея Левайна за обсуждение этого документа. Мы благодарны Индире Паско за помощь с иллюстрациями.

Ссылки на литературу:

[1] «Изучение среды на основе подсчёта с моделями нейронной плотности», Георг Островский, Марк Г. Беллемар, Аарон Ван ден Оорд, Реми Муньос

[2] «Изучение среды на основе подсчёта для глубокого обучения с подкреплением», Хаоран Тан, Рейн Хутхуфт, Дэвис Фут, Адам Стук, Си Чен, Янь Дуань, Джон Шульман, Филип де Турк, Питер Аббель

[3] «Обучение без учителя местонахождению целей для внутренне мотивированного исследования», Александр Пере, Себастьен Форестье, Оливье Сиго, Пьер-Ив Удейе

[4] «VIME: разведка с максимизацией изменения информации», Рейн Хутхуфт, Си Чэнь, Янь Дуань, Джон Шульман, Филипп де Турк, Питер Аббель