Один из парадоксов современных интернет-платформ выражается в том, что, хотя они и в существенной степени автоматизированы и контент, которые видят конечные пользователи, показывается без какой-либо человеческой модерации, тем не менее, они полностью зависят от человеческого поведения, потому что на самом деле они лишь наблюдают, получают информацию и делают заключения на основе действий сотен миллионов или миллиардов людей.

У истоков этого принципа стоял PageRank. Вместо того, чтобы полагаться на вручную созданные правила, которые обеспечивали бы понимание смысла каждой отдельной страницы, или работать с изначальным текстом, PageRank наблюдает за тем, что именно люди сделали или сказали о такой странице. Кто каким-либо образом связан с ней, какой текст они использовали, и кто связан с людьми, связанными с этой страницей? В то же время, Google дает каждому пользователю возможность ранжировать (индексировать, оценивать) каждую набор результатов поиска вручную: вам дается 10 голубых ссылок, а вы просто говорите Google, какая из них подходящая. То же самое относительно Facebook: Facebook на самом деле ведь не знает, кто вы такой или что вам интересно или о чем тот или иной контент. Зато он знает, на кого вы подписаны, что вы лайкаете, кто ещё кроме вас этой лайкнул и что ещё они лайкнули и на что подписались. Facebook — это PageRank, ориентированный на человека. Вообще, то же самое применимо и к YouTube: он никогда не знал, о чем было конкретное видео, а только лишь, что написали под ним люди и что ещё они посмотрели и лайкнули.

По своей сути эти системы — это огромные “механические турки”. Ведь они абсолютно не понимают содержание контента, с которым работают, они только лишь пытаются создать, зафиксировать и передать человеческие настроения относительного этого контента. Они являются огромными распределенными вычислительными системами, в которых в качестве процессоров выступают люди, а сама платформа представляет из себя совокупность роутеров и взаимосвязей. (Это немного напоминает мне об идее из книги “Автостопом по Галактике” о том, что вся Земля на самом деле является огромным компьютером, выполняющим определенные функции, а наша ежедневная деятельность это часть вычислений).

Это значит, что многое в дизайне системы завязано на нахождении оптимальных точек приложения человеческих ресурсов в работе с автоматизированной системой. Вы фиксируете то, что уже происходит? Вот Google начал использовать ссылки, которые уже существовали. А необходимо ли вам стимулировать активность, чтобы выявить её ценность? Facebook пришлось самим создавать деятельность прежде, чем они смогли получить от неё хоть какую-нибудь пользу. Может вы в крайней степени полагаетесь на человеческие ресурсы? Такой подход используется в Apple Music, с их вручную отобранными плейлистами, которые автоматически выдаются десяткам миллионов пользователей. Или же вам приходится платить людям, чтобы они делали вообще всё?

Изначально каталог Интернет-ресурсов Yahoo был попыткой применить подход под названием “плати людям, чтобы они делали всё” — Yahoo платили людям, чтобы те каталогизировали весь Интернет. В начале это казалось достижимым, но так как интернет рос слишком быстро, скоро это оказалось непосильно огромной задачей, и когда Yahoo сдался, размер их каталога уже превысил 3 миллиона страниц. PageRank решил эту проблему. Напротив, Google Maps использует большое количество машин с камерами, которые управляются людьми(пока что) и ездят практически по всем улицам в мире и ещё множество людей отсматривают эти фотографии, и это не непосильно огромная задача — она просто очень дорого обходится. Google Maps — это такой частный “механический турок”. Сейчас мы исследуем точно такой же вопрос, говоря о модерации контента людьми — сколько десятков тысяч человек вам понадобится, чтобы просмотреть каждый пост и насколько можно автоматизировать эту задачу? Непосильно ли огромная эта задача или её реализация просто очень дорого стоит?

Если вы посмотрите на эти платформы, как на использующие миллиарды людей, чтобы производить реальные вычисления, это должно вызвать два интересных вопроса: какие уязвимости имеются в таких платформах и как машинное обучение может изменить эту область?

В прошлом, когда мы думали о взломе компьютерных систем, нам в голову приходили различные уязвимости технического характера — украденные или слабые пароли, незакрытые уязвимости в системах, баги, переполнение буфера, SQL инъекции. Мы представляли “хакеров”, ищущих дыры в программном обеспечении. Но, если представить, что YouTube или Facebook являются распределенными компьютерными системами, в которых роутерами выступает привычный софт, а вот роль процессоров выполняют люди, то любой злоумышленник сразу подумает о поиске уязвимостей не только в программном обеспечении, но и в людях. Типичные когнитивные искажения начинают играть такую же роль, как типичные дефекты в ПО.

То есть на самом деле есть ведь два способа ограбить банк — вы можете обойти сигнализацию и подобрать отмычку к сейфу или же вы можете подкупить сотрудника банка. В каждом из этих примеров система дала сбой, а ведь теперь одна из систем — это мы с вами. Следовательно, как я уже писал в этой статье о недавней смене курса Facebook в сторону приватности и безопасности пользователей, модерация контента живыми людьми на таких платформах по своей сути подобна работе антивирусов, которые начали бурно развиваться в ответ на появление вредоносного ПО на Windows два десятилетия назад. Одна часть компьютера смотрит не делает ли другая его часть чего-то, что она делать не должна.

Даже если не говорить об умышленном взломе систем, существуют и другие проблемы возникающие при попытке анализировать деятельность одного человека при помощи другого человека. Так, когда вы начинаете использовать компьютер для анализа другого компьютера, вы рискуете создать циклы обратной связи. Это отражено в таких концептах, как “пузырь фильтров”, “радикализация YouTube” или же поисковый спам. В то же время, одна из проблем, с которой столкнулся Facebook заключается в том, что иногда наличие и производство большого объема данных нивелирует ценность этих данных. Назовем это проблемой перегрузки ленты новостей: к примеру, у вас есть 50 или 150 друзей и вы публикуете 5 или 10 записей каждый день, или вроде того, но ведь точно также делают все ваши друзья и вот в ваше ленте уже 1500 записей каждый день. Число Данбара + Закон Цукерберга = перегрузка … что приводит нас к Закону Гудхарта.

«Любая наблюдаемая статистическая закономерность склонна к разрушению, как только на неё оказывается давление с целью управления.» — Чарльз Гудхарт

И всё же как машинное обучение может изменить ситуацию? Чуть раньше я уже говорил, что основная трудность заключается в том, как именно задействовать человеческие ресурсы в работе с ПО наиболее оптимальным образом, хотя ведь есть и другой вариант — просто дать компьютеру сделать всю работу. До совсем недавнего времени те трудности и причины, по которым такие системы существовали, в первую очередь заключались в наличии большого класса задач, которые компьютеры не могли решить, хотя люди решали их моментально. Мы называли это ‘задачи, легкие для человека, но трудные для компьютера’, но на самом деле это были задачи, легкие для человека, но которые человек практически не способен описать компьютеру. Прорывная особенность машинного обучения заключается в том, что оно позволяет самим компьютерам выработать необходимое описание.

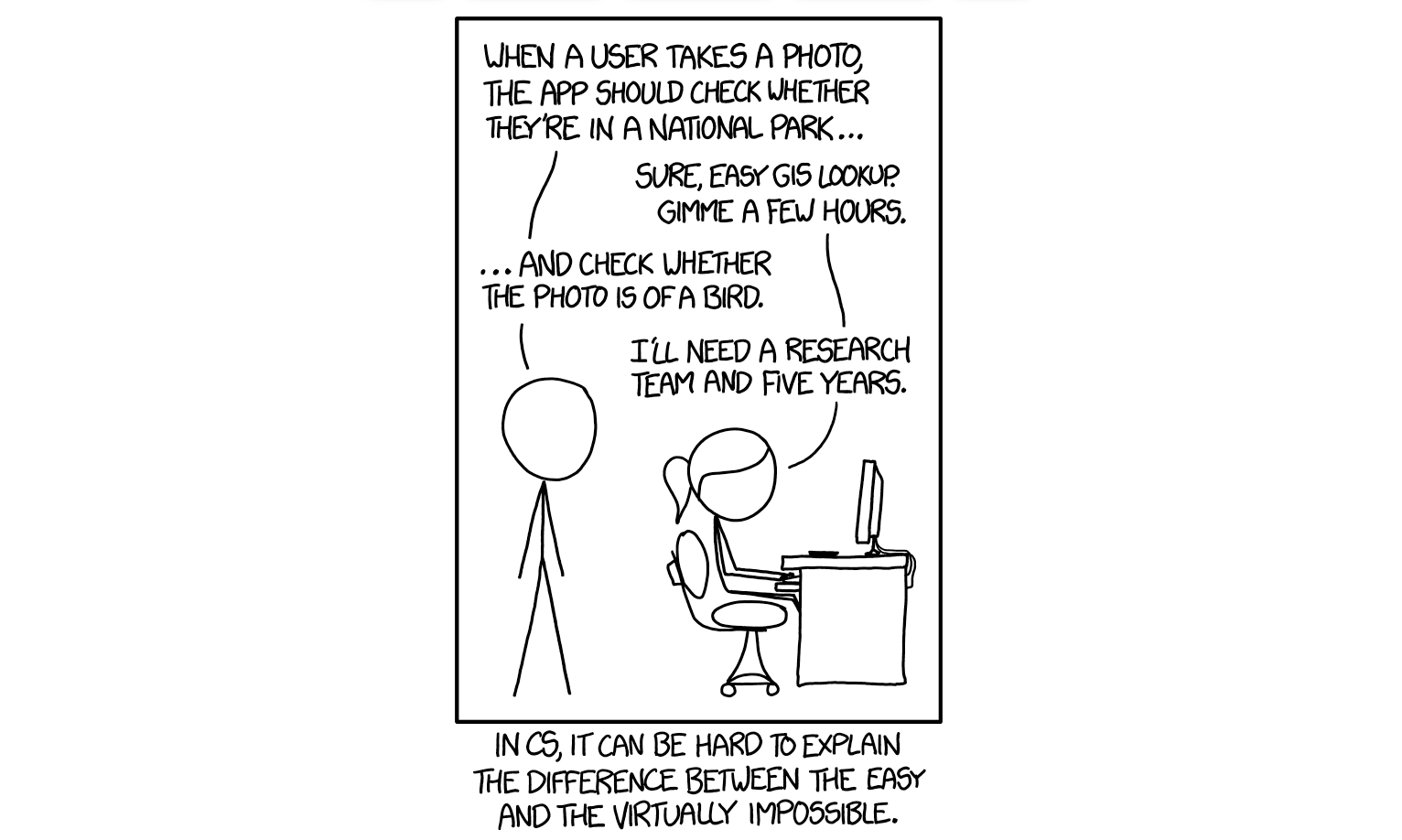

Комикс ниже (прямиком из 2014 года, как раз когда системы машинного обучения и компьютерного зрения начали бурно развиваться) отлично иллюстрирует эти изменения. Первая задача была легко выполнима, в отличие от второй — по крайней мере до прихода машинного обучения.

Старый способ решить эту задачу — это найти людей, которые бы классифицировали изображение — прибегнуть к своего рода краудсорсингу. Другими словами, использовать “механического турка”. Но на сегодняшний день, нам, возможно, уже и не понадобится, чтобы кто-либо смотрел на это изображение, ведь при помощи машинного обучения мы очень часто можем автоматизировать решение именно этой проблемы.

Так вот: какое количество задач вы могли бы раньше решить не иначе как при помощи анализа действий миллионов или сотен миллионов людей, которые сейчас вы можете решить при помощи машинного обучения и вообще без необходимости вовлекать пользователей?

Конечно, в этом есть некоторое противоречие, ведь в машинном обучении вам всегда необходим большой объем данных. Очевидно, в этом случае кто-нибудь мог бы сказать, что если у вас имеется большая платформа, у вас автоматически имеется много данных, следовательно, процесс машинного обучения тоже будет идти проще. Это, определенно, так, как минимум по-началу, однако я думаю, не лишним будет спросить, сколько именно задач могли бы быть решены только лишь при помощи имеющихся пользователей. В прошлом, если у вас было фото кошки, оно могло бы быть помечено как “кошка”, только если у вас было достаточно пользователей, и кто-нибудь из них бы посмотрел на это конкретное фото и пометил бы его. Сегодня же вам вообще не нужны реальные пользователи, чтобы обработать это конкретное изображение кошки — вам всего лишь нужно, чтобы были какие-либо другие пользователи, где-либо в мире, в какой-либо момент в прошлом, которые уже классифицировали достаточно других изображений с кошками, чтобы сгенерировать необходимую модель распознавания.

Это просто ещё один способ оптимального использования человеческих ресурсов: вам в любом случае нужны люди, чтобы классифицировать предметы (и чтобы писать правила по, которым люди будут их классифицировать). Но тут мы уже смещаем рычаг и, возможно, в корне меняем необходимое количество людей и, таким образом, в некоторой степени меняются правила игры, обусловленные эффектом “победитель получает всё”. В конце концов, все эти масштабные соцсети платформы это просто огромные коллекции вручную классифицированных данных, так как в итоге получается, стакан у них наполовину полон или наполовину пуст? С одной стороны, наполовину полон: у них в распоряжении имеется самая большая коллекция вручную классифицированных данных (в их конкретной сфере деятельности). С другой, стакан наполовину пуст: эти данные были отобраны и классифицированы вручную.

Даже там, где данные могли бы сформировать одну из таких платформ (чего, скорее всего, этого не произойдет — наверняка не произойдет — как я уже писал вот тут), они бы всё равно стали, ну, платформой. Как в случае с AWS, которая обеспечила развитие стартапов, которым больше не нужны были миллионы пользователей, чтобы на их инфраструктуру начал действовать эффект масштаба, создание подобных инструментов будет означать, что вам больше не нужны будут миллионы или миллиарды пользователей, чтобы распознать кошку. Вы сможете автоматизировать процесс.

Перевод: Александр Трегубов

Редактура: Алексей Иванов

Сообщество: @ponchiknews