На протяжении своей истории, от первых рассказов Азимова про роботов до AlphaGo, у ИИ были взлёты и падения. Но на самом деле его история только начинается.

Искусственный интеллект пока ещё очень молод. Однако в этой области произошло уже много значимых событий. Некоторые из них привлекли внимание культуры, другие породили взрывную волну, воспринятую только учёными. Вот некоторые ключевые моменты, наиболее сильно повлиявшие на развитие ИИ.

1. Айзек Азимов впервые упомянул "Три закона робототехники" (1942)

Рассказ Азимова "Хоровод" отмечает первое появление в историях этого знаменитого фантаста «трёх законов робототехники»:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

В рассказе «Хоровод» робот Спиди ставится в положение, в котором третий закон входит в противоречие с первыми двумя. Рассказы Азимова про роботов заставили задуматься любителей НФ, среди которых были и учёные, о возможности появления думающих машин. По сей день люди занимаются интеллектуальными упражнениями, применяя законы Азимова к современным ИИ.

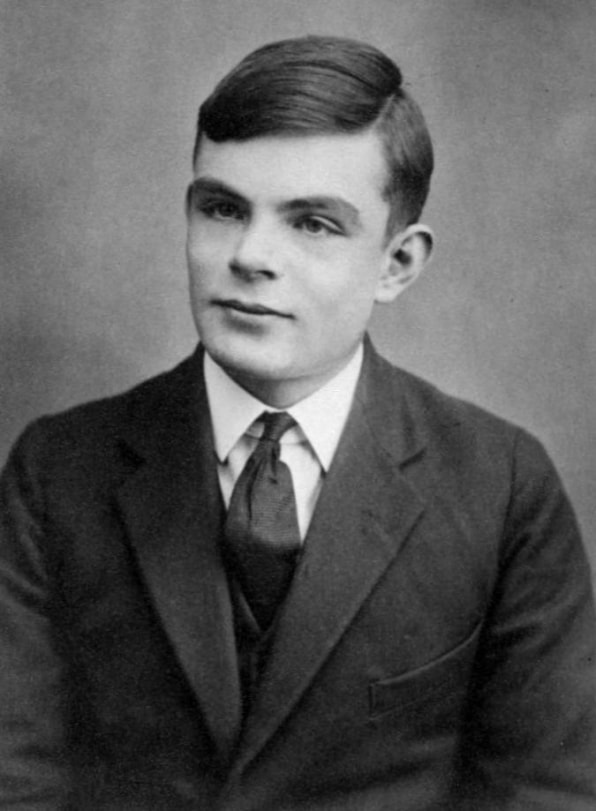

2. Алан Тьюринг предложил свою «Игру в имитацию» (1950)

Алан Тьюринг описал первый принцип измерения степени разумности машины в 1950-м.

Предлагаю рассмотреть вопрос «Могут ли машины думать?» Так начиналась влиятельная исследовательская работа Тьюринга 1950 года, разработавшая систему взглядов для рассуждения о машинном разуме. Он задал вопрос о том, можно ли считать машину разумной, если она может имитировать разумное поведение человека.

Этот теоретический вопрос породил знаменитую «Игру в имитацию» [её позже назовут "Тестом Тьюринга" / прим. перев.], упражнение, в котором исследователь-человек должен определить, с кем он переписывается – с компьютером или человеком. Во времена Тьюринга не существовало машин, способных пройти этот тест, нет их и сегодня. Однако его тест дал простой способ определить наличие разума у машины. Также он помог сформировать философию ИИ.

3. Конференция по ИИ в Дартмуте (1956)

К 1955 году учёные всего мира уже сформировали такие концепции, как нейросети и естественный язык, однако ещё не существовал объединяющих концепций, охватывающих различные разновидности машинного интеллекта. Профессор математики из Дартмутского колледжа, Джон Маккарти, придумал термин «искусственный интеллект», объединяющий их все.

Маккарти руководил группой, подавшей заявку на грант для организации конференции по ИИ в 1956. В Дартмут-холл летом 1956 были приглашены многие ведущие исследователи того времени. Учёные обсуждали различные потенциальные области изучения ИИ, включая обучение и поиск, зрение, логические рассуждения, язык и разум, игры (в частности, шахматы), взаимодействия человека с такими разумными машинами, как личные роботы.

Общим консенсусом тех обсуждений стало то, что у ИИ есть огромный потенциал для того, чтобы принести пользу людям. Было очерчено общее поле исследовательских областей, на развитие которых может повлиять машинный интеллект. Конференция организовала и вдохновила исследования в области ИИ на многие годы.

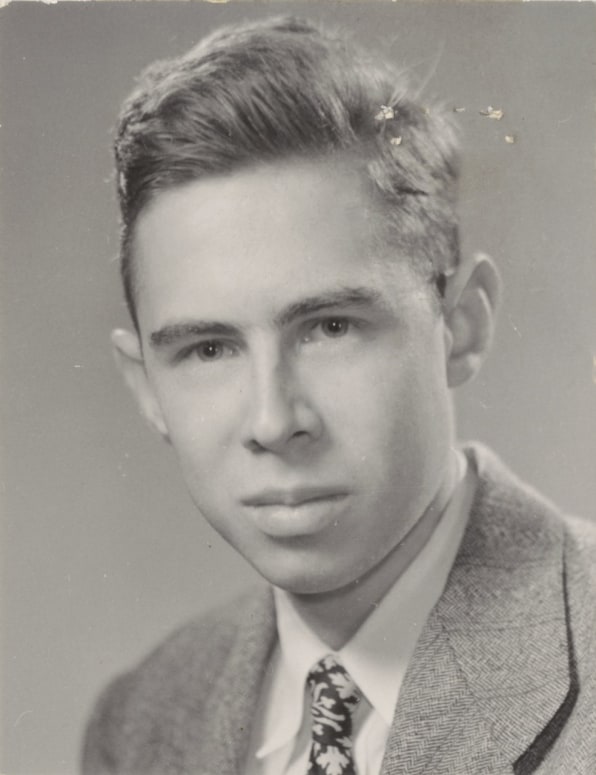

4. Фрэнк Розенблатт создаёт перцептрон (1957)

Фрэнк Розенблатт создал механическую нейросеть в Корнеллской лаборатории аэронавтики в 1957

Базовый компонент нейросети называется "перцептроном" [это лишь самый первый и примитивный тип искусственного нейрона / прим. перев.]. Набор входящих данных попадает в узел, подсчитывающий выходное значение, и выдающий классификацию и уровень уверенности. К примеру, входные данные могут анализировать различные аспекты изображения на основании входных данных и «голосовать» (с определённым уровнем уверенности) за то, есть ли на нём лицо. Затем узел подсчитывает все «голоса» и уровень уверенности, и выдаёт консенсус. В нейросетях сегодняшнего дня, работающих на мощных компьютерах, работают миллиарды подобных структур, связанных между собой.

Однако перцептроны существовали ещё до появления мощных компьютеров. В конце 1950-х молодой психолог-исследователь Фрэнк Розенблатт создал электромеханическую модель перцептрона под названием Mark I Perceptron, хранящуюся сегодня в Смитсоновском институте. Это была аналоговая нейросеть, состоявшая из сетки светочувствительных элементов, соединённых проводами с банками узлов, содержащих электромоторы и поворотные резисторы. Розенблатт разработал «перцептронный алгоритм», управлявший сетью, которая постепенно подстраивала силу входных сигналов так, чтобы в итоге правильно идентифицировать объекты – по сути, обучалась.

Учёные спорили о значимости этой машины вплоть до 1980-х. Она сыграла важную роль по созданию физического воплощения нейросети, которая до тех пор существовала в основном только в виде научной концепции.

5. ИИ сталкивается со своей первой зимой (1970-е)

Большую часть своей истории ИИ существовал только в исследованиях. Большую половину 1960-х правительственные агентства, в частности, DARPA, вливали деньги в исследования и практически не требовали отчёта по инвестициям. Исследователи ИИ часто преувеличивали потенциал своей работы, чтобы продолжать получать финансирование. Всё изменилось в конце 1960-х и начале 1970-х. Два отчёта – один от рекомендательного совета по автоматической обработке языка (ALPAC) для правительства США 1966 года, второй от Лайтхилла для правительства Британии 1973 года – прагматически оценили прогресс в исследованиях ИИ и выдали весьма пессимистичный прогноз о потенциале данной технологии. В обоих отчётах ставилось под вопрос наличие ощутимого прогресса в различных областях исследований ИИ. Лайтхилл в своём отчёте утверждал, что ИИ для задач распознавания речи будет крайне сложно масштабировать до размеров, которые смогут быть полезными правительству или военным.

В итоге правительства США и Британии начали урезать финансирование исследований ИИ для университетов. DARPA, без проблем финансировавшее исследования ИИ в 1960-х, стало требовать от проектов чётких временных рамок и подробного описания предполагаемых результатов. В итоге стало казаться, что ИИ не оправдал ожиданий, и никогда уже не сможет достичь уровня человеческих возможностей. Первая «зима» ИИ продлилась все 1970-е и 80-е.

6. Приход второй зимы ИИ (1987)

1980-е начались с разработки и первых успехов "экспертных систем", хранивших большие объёмы данных и эмулировавшие процесс принятия решений людьми. Технологию изначально разработали в университете Карнеги-Меллона для компании Digital Equipment Corporation, а затем другие корпорации начали быстро внедрять её. Однако экспертные системы требовали дорогого спеиализированного оборудования, и это стало проблемой, когда начали появляться сходные по мощности и более дешёвые рабочие станции от Sun Microsystems а также персональные компьютеры от Apple и IBM. Рынок экспертных компьютерных систем рухнул в 1987, когда с него ушли основные производители оборудования.

Успех экспертных систем в начале 80-х вдохновил DARPA на увеличение финансирования исследований ИИ, но вскоре это вновь поменялось, и агентство урезало большую часть этого финансирования, оставив всего несколько программ. И снова термин «искусственный интеллект» в исследовательском сообществе стал почти запретным. Чтобы их не воспринимали, как непрактичных мечтателей в поисках финансирования, исследователи начали использовать другие названия для работы, связанной с СС – «информатика», «машинное обучение» и «аналитика». Эта, вторая зима ИИ продолжалась вплоть до 2000-х.

7. IBM Deep Blue побеждает Каспарова (1997)

IBM Deep Blue победила лучшего шахматиста мира, Гарри Каспарова, в 1997.

Общественное представление об ИИ улучшилось в 1997 году, когда шахматный компьютер Deep Blue от IBM победил тогдашнего чемпиона мира Гарри Каспарова. Из шести игр, проводившихся в телестудии, Deep Blue выиграла в двух, Каспаров в одной, а три окончились вничью. Ранее в том году Каспаров победил предыдущую версию Deep Blue.

У компьютера Deep Blue было достаточно вычислительных мощностей, и он использовал «метод грубой силы», или полный перебор, оценивая 200 млн возможных ходов в секунду и подбирая наилучший. Возможности людей ограничиваются оценкой лишь порядка 50 ходов после каждого хода. Работа Deep Blue была похожа на работу ИИ, но компьютер не размышлял о стратегиях и не учился игре, как смогут делать последовавшие за ним системы.

И всё же победа Deep Blue над Каспаровым впечатляющим образом вернула ИИ в круг общественного внимания. Некоторые люди были очарованы. Другим не понравилось, что машина обыграла эксперта в шахматах. Инвесторы были впечатлены: победа Deep Blue на $10 подняла стоимость акций IBM, выведя их на максимум того времени.

8. Нейросеть видит кошек (2011)

К 2011 году учёные из университетов всего мира говорили о нейросетях и создавали их. В том году программист Джефф Дин из Google познакомился с профессором информатики из Стэнфорда Эндрю Ыном. Вдвоём они замыслили создание большой нейросети, обеспеченной огромной вычислительной энергией серверов Google, которой можно будет скормить огромный набор изображений.

Созданная ими нейросеть работала на 16 000 серверных процессорах. Они скормили ей 10 млн случайных и неразмеченных кадров с видеороликов YouTube. Дин и Ын не просили нейросеть выдать какую-то конкретную информацию или разметить эти изображения. Когда нейросеть работает таким образом, обучаясь без учителя, она естественным образом пытается найти закономерности в данных и формирует классификации.

Нейросеть обрабатывала изображения три дня. Затем она выдала три размытых изображения, обозначающих визуальные образы, которые она снова и снова встречала в обучающих данных – лицо человека, тело человека и кота. Это исследование стало серьёзным прорывом в использовании нейросетей и обучении без учителя в компьютерном зрении. Также оно отметило начало проекта Google Brain.

9. Джоффри Хинтон спустил с поводка глубокие нейросети (2012)

Исследование Джоффри Хинтона помогло возродить интерес к глубокому обучению

Через год после прорыва Дина и Ына профессор Торонтского университета Джоффри Хинтон с двумя своими студентами создали нейросеть для компьютерного зрения AlexNet для участия в соревновании по распознаванию изображений ImageNet. Участники должны были использовать свои системы для обработки миллионов тестовых изображений и определять их с наивысшей возможной точностью. AlexNet выиграла соревнование с процентом ошибок в два с лишним раза меньшим, чем у ближайшего конкурента. В пяти вариантах подписи к изображению, данных нейросетью, только в 15,3% случаев не было правильного варианта. Предыдущим рекордом было 26% ошибок.

Эта победа убедительно показала, что глубокие нейросети, работающие на графических процессорах, куда как лучше других систем могут точно определять и классифицировать изображения. Это событие, возможно, сильнее остальных повлияло на возрождение интереса к глубоким нейросетям, и заслужило Хинтону прозвище «крёстный отец глубокого обучения». Вместе с другими гуру в области ИИ, Йошуа Бенджио и Яном Лекуном, Хинтон получил долгожданную премию Тьюринга в 2018.

10. AlphaGo обыгрывает чемпиона мира по го (2016)

В 2013 году исследователи британского стартапа DeepMind опубликовали работу, где было описано, как нейросеть научилась играть и выигрывать в 50 старых игр от Atari. Под впечатлением от этого компанию купила Google – как говорят, за $400 млн. Однако главная слава DeepMind была ещё впереди.

Через несколько лет учёные из DeepMind, теперь уже в рамках Google, перешли от игр Atari к одной из самых старых задач ИИ – японской настольной игре го. Они разработали нейросеть AlphaGo, способную играть в го и обучаться во время игры. Программа провела тысячи партий против других версий AlphaGo, обучаясь на основе проигрышей и выигрышей.

И это сработало. AlphaGo обыграла величайшего игрока в го в мире, Ли Седоля, со счётом 4:1 в серии игр в марте 2016. Процесс снимали для документального фильма. При его просмотре трудно не заметить грусть, с которой Седоль воспринял проигрыш. Казалось, что проиграли все люди, а не только один человек.

Последние продвижения в области глубоких нейросетей настолько сильно изменили область ИИ, что реальная его история, возможно, только лишь начинается. Нас ждёт много надежд, шумихи и нетерпения, но сейчас уже ясно, что ИИ повлияет на все аспекты жизни XXI века – и возможно даже сильнее, чем в своё время это сделал интернет.