Какое у вас любимое мороженое? Шоколадное, ванильное, фисташки, крем-брюле? Вы легко дадите ответ. Но если вас спросят, почему именно этот конкретный вкус, тут уже дать конкретный ответ станет гораздо сложнее. Большинство максимум придумают, что так у них устроены вкусовые рецепторы. Но почему они устроены именно так, и почему тогда нам иногда хочется пробовать другие виды мороженого?

Если бы мы подвергали анализу такие повседневные вещи в своей жизни, мы скоро бы поняли, что часто не можем точно понять причины своих предпочтений, эмоций или желаний. Не можем разобраться с тем, что на самом деле происходит у нас в мозгу. А что тогда с ИИ? В него заложены конкретные программы и алгоритмы, значит, мы можем определить, чем конкретно он руководствуется при принятии тех или иных решений, правда? Или хотя бы примерно предсказать, какими они будут?

На самом деле, с ИИ всё обстоит еще хуже. Чем дальше развиваются технологии, тем чаще мы вообще не можем понять, что происходит там внутри. А значит, и не можем быть уверены, стоит ли нам доверять таким решениям. Исследователи всё чаще предупреждают, чтобы при разработке моделей ИИ мы уделяли больше внимания тому, как и почему они выдают определенные результаты, а не тому, как точно и быстро они могут их выдавать.

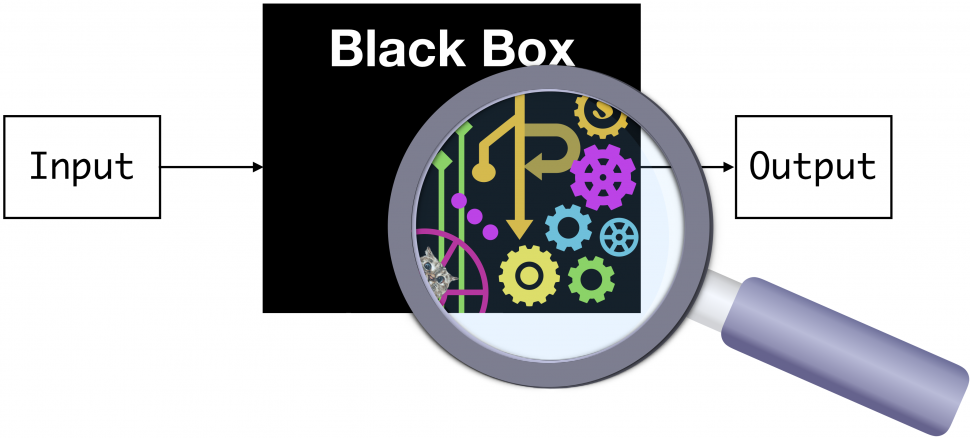

Черный ящик

У людей, которые разрабатывают ИИ, все чаще возникают проблемы с объяснением того, как он работает, и пониманием, почему он дает те результаты, которые дает. Глубокие нейронные сети, имитирующие работу нейронных сетей нашего мозга, часто, кажется, отражают не только человеческий интеллект, но и необъяснимость глубин человеческого сознания.

Большинство систем ИИ представляют собой классические модели черного ящика. То есть, эти системы рассматриваются только с точки зрения того, что у них на входе, и того, что на выходе. Разработчики просто получают результаты, и сравнивают их с теми, которые хотели бы получить. Они не пытаются «расшифровать черный ящик» или понять те непрозрачные процессы, которые выполняет система, пока занимается поиском результата.

Например, если предоставить этому «черному ящику» данные о каждом вкусе мороженого, а потом о вашем экономическом состоянии, социальном положении, возрасте, образе жизни и так далее — он, вероятно, сможет догадаться, какой вкус мороженого вам нравится больше всего. А если система выдаст неверный результат, всегда можно «скормить» ей еще больше данных, привязать разные коэффициенты, и делать это, пока результат совпадет. Причем не только для вас, а и для 100 случайно выбранных людей. После этого можно выходить с научной работой, запускать сервис, идти к инвесторам, выходить на компании по продажам мороженого. И говорить, что у вас есть система, которая работает.

Но правда ли она работает? Какие факторы она учитывает, как приходит к своим выводам? Не будет ли такого, что, однажды, обработав другой набор данных, та же модель решит, что нужно рекомендовать всем людям мороженое с насекомыми или со вкусом пиццы?

В конце концов, уже есть несколько долго и успешно работавших ИИ, которые провалились. Например, в США большой скандал вызвали системы автоматического одобрения онлайн-заявлений на ипотеку. Они работают уже несколько лет, упрощая работу крупнейших ипотечных кредиторов страны, и вполне успешно повышая их прибыль. Но потом оказалось, что для этого они автоматически отклоняли 80% заявлений от темнокожих заявителей. Используя обширные базы данных, они определили, что люди с такими фамилиями и именами в целом живут в более дешевых домах, а значит, запросы от похожих людей в целом проще отменять.

Похожие «факапы» уже случились с приглашениями школьников в университеты и даже с рекрутингом. Опять же, всё в лучших традициях Германии тридцатых годов: если у вас «не такая» фамилия, нужно будет очень много аргументов, чтобы система всё-таки решила рассмотреть вашу кандидатуру. Когда такие ИИ внедряли, казалось, они позволят навсегда отказаться от расизма в университетах, при покупках домов и при приеме на работу. Но оказалось, что на деле они только привязались к текущим тенденциям, успешно нашли эти паттерны, и дополнительно их усилили.

Но в США хотя бы есть четкий маркер, позволяющий быстро определять такой провальный ИИ. «Тест по темнокожему». А что делать с теми ИИ, которых нельзя прогнать через такой тест? Или теми, которые разработаны в странах, где просто нет такой выборки? По каким еще параметрам они полностью проваливаются, но мы просто этого не замечаем?

По мере того, как системы ИИ становятся все более сложными, мы все меньше способны их понимать. Поэтому исследователи ИИ и предупреждают разработчиков, чтобы они уделяли больше внимания тому, почему система дает определенные результаты, и встроили в свои системы механизмы, помогающие определить причины тех или иных решений внутри «черного ящика».

Роман Ямпольский, профессор компьютерных наук Университета Луисвилля, в своей работе «Необъяснимость и Непостижимость искусственного интеллекта», пишет:

Если все, что у нас есть, — это «черный ящик», то невозможно понять причины сбоев и повысить безопасность системы. Кроме того, если мы привыкнем принимать ответы ИИ без объяснения причин, мы не сможем определять, если он начнет давать неправильные или манипулятивные ответы. Это чрезвычайно опасная дорога, на которую мы ступаем.

Модели «черного ящика» могут быть очень мощными, и быстро выдавать то, ��то нужно их разработчикам. Именно поэтому они используются для разработки беспилотных автомобилей, чат-ботов и даже диагностики заболеваний. При этом некоторые задачи они уже способны выполнять лучше, чем люди. Но опасность в том, что невозможно понять, в каких случаях может произойти ошибка, и даже определить, когда она станет системной.

Скажем, если через десять лет модель диагностики заболеваний начнет на 5% чаще говорить, что у человека рак, и массово отправлять тысячи здоровых людей на химиотерапию, никто не сможет засечь этот момент. Разве что кто-то заранее додумается встроить в неё механизм определения подобных сбоев. Всё в соответствии со словами Джеффа Голдблюма из «Парка Юрского периода»: «Ученые были так озабочены тем, смогут ли они это сделать, что даже не задумались над тем, стоит ли им это делать».

Во многих случаях в принципе невозможно создать осмысленную нейронную сеть, потому что входные данные просто не содержат достаточного количества информации. Но мы этого не знаем, и такая система может стать главным «принимателем решений», как произошло в случае с системами, выдававшими кредиты, и одобрявшими заявки абитуриентов. Потом нам тяжело аргументированно вмешаться в работу системы и спорить с её выводами, потому что мы не понимаем принципов принятия этих решений. Поэтому мы думаем, что всё идет отлично, пока как лемминги шагаем к краю обрыва.

Ни одного из этих людей не существует

В новаторском, оказавшем потом огромное влияние на работы с ИИ, исследовании 2018 года Джой Буоламвини и Тимнит Гебру первыми обнаружили, что все популярные системы распознавания лиц точнее всего определяют мужчин со светлой кожей (2,4% ошибок). И чаще всего ошибаются при обнаружении женщин с более темной кожей (61% ошибок). Причины, видимо, там было три: фотографий темнокожих женщин меньше всего в базах данных; разработчики таких систем сами преимущественно являются белыми мужчинами; датчики камер хуже распознают детали в темных цветах.

Несмотря на это, такие системы до сих пор используются во многих сферах, а главное — в работе полиции. В том числе и в России, и в Китае. Доказано, что если вы — одно из расовых меньшинств в такой стране, эта система будет чаще определять в вас преступника. Просто потому, что преступление совершил кто-то с «похожим на вас» лицом. Из-за таких ошибок (когда сначала ошибается ИИ, а потом ещё и попадается свидетель с плохой памятью на лица) в тюрьмах сидят сотни невинных людей. И их постепенно будет становиться больше.

Плюс к этому темнокожие пациенты, азиаты и женщины чаще получают ошибочный диагноз от автоматизированных систем, анализирующих медицинские изображения. А еще системы искусственного интеллекта могут c невероятной точностью угадывать расу людей на основе рентгеновских снимков и компьютерной томографии. Здесь ученые вообще понятия не имеют, как это происходит, потому что никаких данных для этого в снимках вроде бы нет.

Все эти проблемы теперь, особенно после 2018 года, широко известны. Но где искать решения — пока не ясно. Некоторые эксперты говорят, что переход к открытым и интерпретируемым моделям ИИ просто приведет к тому, что системы станут менее эффективными. Так что лучше пусть несколько сотен людей посидят в тюрьмах, а другим повыписывают неверные диагнозы. Может, потом ИИ научится на своих ошибках, и всё станет лучше, правда? Тем более, альтернативы у нас всё равно пока нет.

Или есть?

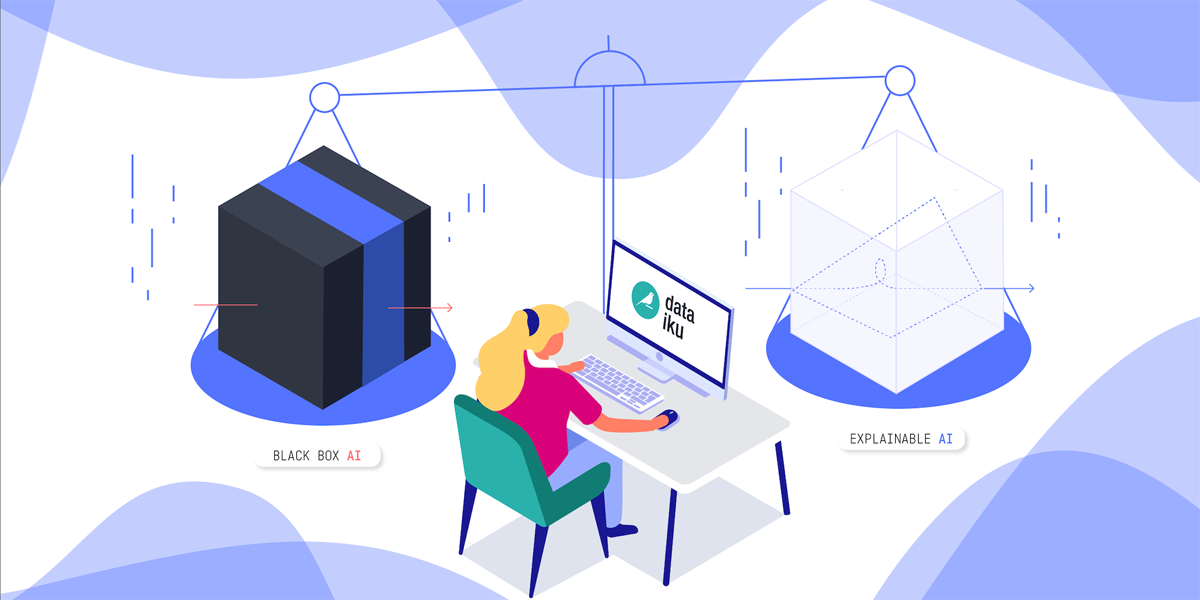

Белый ящик

В последние годы некоторые представители отрасли предприняли небольшой, но реальный толчок к разработке «моделей белого ящика», которые являются более прозрачными для человека, и результаты поведения которых можно объяснить.

Подробнее можно почитать в этом посте на Medium (или здесь). Если вкратце, предлагается разбивать систему на модули, каждый из которых может быть интерпретирован человеком. Или изначально строить модели хотя бы с локальной прозрачностью, чтобы человек не терял контроль над ситуацией. Для определения сложности каждого модуля предлагается использовать количество работающих в ней правил — размерность Вапника-Червоненкиса (комбинаторную размерность).

Пока что «белый ящик» — это довольно нишевая идея, и «черный ящик», как мы знаем, является доминирующим методом обучения всех моделей ИИ, от Alpha Zero до GPT-3. Это просто самый быстрый метод достижения результата. Дал машине массив данных, показал, что ты от неё хочешь, настроил несколько конкурирующих моделей, и посмотрел, какая даст результат. Разбираться в мелочах мышления ИИ — тут можно зависнуть на годы. А поскольку каждая компания волнуется о том, чтобы не обанкротиться, и каждая команда внутри пытается доказать свою эффективность, мало кто ищет такие более сложные пути достижения той же цели.

А это значит — пока в дело не вступят регуляторы, «черный ящик» неизбежно будет доминировать. Пока публично не будет доказано, что это опасный метод, и на этот способ разработки ИИ не наложат, скажем, финансовые ограничения, делающие «белый ящик» сравнительно более выгодным.

Один из «белых» ИИ научился делать фото мультяшными

Как мы знаем, и как не раз нам доказывали и американские, и российские власти, регуляторы технологии понимают крайне слабо, так что на ближайшие десятилетия, наверное, можно не волноваться. Но в то же время первые звоночки уже есть. Так, в статье 2021 года, написанной учеными из Пало-Алто, которые были потом уволены из Google за эту публикацию, авторы почти напрямую выступают за введение ограничений.

Так, они утверждают, что если обучать модели ИИ с помощью больших данных, встроенные в них расовые и другие предубеждения — неизбежность. Например, есть такой простой факт, что у некоторых групп населения просто меньше доступа к Интернету. В результате чего «больших данных» о них собирается гораздо меньше, и ИИ считает их «менее людьми», а их интересы — не такими релевантными.

Жители деревень и дальнобойщики в Сети встречаются реже, чем программисты и сисадмины. Но это не значит, что в целом их меньше.

Машины, натренированные на больших данных, неизбежно будут «забывать» о широких группах населения. И станут представлять интересы в первую очередь более молодых и продвинутых пользователей. Это, конечно, может быть хорошо для нас, читающих эту статью на Хабре и хорошо представленных в Интернете. Но в целом для страны и для мира — не очень.

В своей статье ученые пишут:

Если мы ориентируемся на большие данные, то всегда будем отдавать предпочтение тем, у кого есть ресурсы, чтобы публиковать свои изображения, видео, пользоваться платными сервисами, демонстрировать свое публичное мнение. Мы разделяем людей на тех, кто активно пользуется интернетом, и тех, кто только изредка в него заходит. В этом есть что-то фундаментальное и недемократичное. Мы должны стараться делать жизнь людей лучше, а не ещё сильнее разобщать общество.

Если мы не участвуем в разговорах, о том, в каких условиях и для кого сейчас разрабатывается ИИ, значит, как человечество мы проиграли. Следующий самый мощный разрабатываемый инструмент будет служить только людям, обладающим властью, и интересоваться только их перспективой. В дальнейшем, если мы не изменим нашу методику обучения ИИ, такое преимущество будет только нарастать, пока не приведет к социальному взрыву или другим серьезным последствиям.

Строительство «хорошего» ИИ

Устранение предвзятости наборов данных, на которых обучаются системы ИИ, практически невозможно в обществе, где сам Интернет является предвзятым. Решения тут два: или использовать сравнительно небольшие наборы данных, где разработчики контролируют, что в них появляется. Или проектировать систему изначально с учетом наличия в ней предвзятости, с пониманием того, что данные не идеальны, а не симулировать беспристрастность и потом бегать в панике, когда разошелся скандал.

Как писали ученые в своей статье, поскольку сокращать объемы данных пока не хочет никто, на настоящий момент наилучший (хоть и далеко не идеальный) подход — второй. Обучение с подкреплением путем обратной связи с людьми. Мы не видим, что происходит внутри черного ящика, но, тем не менее, можем активно пытаться улучшить контент внутри. Сделать так, чтобы система научилась понимать наши ценности.

Это значит, что если ИИ не делает то, что нам нравится, мы даем ему отрицательную обратную связь. Он на ней учится и пытается снова. Мы повторяем этот процесс до тех пор, пока он не выдает что-то, что мы одобряем. Система использует обучение методом проб и ошибок, с учетом человеческого элемента.

Такой подход, конечно, годится далеко не для каждого ИИ: не везде можно поставить человека на выходе, следящего за результатом. Изначально нерепрезентативная выборка данных тоже никуда не девается. Но пока что это лучшее из того, что мы точно научились делать.

Сейчас этот подход внедрили и YouTube, и Facebook, запустив свои алгоритмы, на которые могут прямо влиять пользователи — скажем, массово дизлайкая, ставя флаги или быстро скрывая видео, что дает понять системе, что с ним что-то не так. Финальное слово в итоге тоже часто остается за человеком: нанятый оператор определяет, банить или не банить канал, удалять или оставлять пользователя на платформе. По мере того, как контент черного ящика улучшается, а система всё точнее подстраивается под наши ценности, человеческого влияния требуется меньше и меньше. Но поскольку наши ценности тоже склонны меняться, полностью от операторов такие платформы не смогут отказаться никогда.

Сейчас для большинства задач подходы черного ящика показывают себя лучше, чем интерпретируемые модели. И даже в тех случаях, когда интерпретируемые модели дают неплохой результат, обычно приходится идти на компромисс между их возможностями и тем, насколько точно мы можем их понимать. Судя по всему, подобный разрыв будет существовать ещё долго. Чем меньше мы понимаем о внутренней логике конкретной модели ИИ — тем более ценными для нас потенциально могут быть результаты её работы.

Но в таком случае наделять машины возможностями «Скайнета» пока еще рано. И даже давать им принимать решения по поводу того, каких людей нанимать на работу или кому давать кредиты — возможно, преждевременно.

Предложения от самых передовых компаний в РФ и за рубежом — в телеграм-боте getmatch. Тысячи вакансий, зарплаты до 450 тысяч рублей. США, Грузия, Армения, Кипр, Европа. Указываете желаемую зарплату, и бот выдает вам лучшие предложения, и помогает пройти интервью. Всё бесплатно.

Что ещё почитать

- Теория мертвой Сети. Возможно ли, что весь интернет — это ИИ?

- Скорость света ближе, чем казалось: ученые создали первый пузырь Алькубьерре

- Падение Сан-Франциско. Почему город перестает быть хабом для IT-сотрудников

- Страны Юго-Восточной Азии запускают визы для цифровых кочевников

- Ученые нашли упражнение, позволяющее худеть, сидя по 10 часов в день